从0到1搭建企业AI中台:AI应用架构师的15个实战锦囊,含代码片段+部署脚本

锦囊编号主题核心内容6日志收集(ELK)用Filebeat收集容器日志,发送到Logstash,存入Elasticsearch,用Kibana查询。7认证授权(JWT)在接入层添加JWT认证,防止非法调用API。8模型版本管理(DVC)用DVC管理模型版本,支持回滚到历史版本。9推理服务熔断(Sentinel)用Sentinel实现熔断降级,防止单个服务故障影响整个系统。10多模型支持扩展推理服务

从0到1搭建企业AI中台:AI应用架构师的15个实战锦囊(附代码/部署脚本)

引言:企业AI落地的“痛点”与“解药”

你是否遇到过这样的场景?

- 业务部门要上线一个图像识别功能,算法团队训练了模型,却要重复写接口、部署服务,耗时耗力;

- 多个业务系统用了同一个模型的不同版本,出了问题找不到原因;

- 推理服务峰值时卡顿,低谷时资源浪费,无法自动扩缩容;

- 模型分散在各个服务器,想复用却找不到在哪里……

这些都是企业AI落地的常见痛点。AI中台就是解决这些问题的“解药”——它像一个“AI基础设施枢纽”,统一管理模型、提供推理服务、调度资源,让业务团队不用再“重复造轮子”,专注于业务创新。

本文将带你从0到1搭建一个企业级AI中台,涵盖需求分析、架构设计、核心组件实现、部署运维的全流程。读完本文,你将掌握:

- AI中台的核心架构与关键组件;

- 模型仓库、推理服务、模型管理API的实现;

- 用Kubernetes实现资源调度与自动扩缩容;

- 监控与日志系统的搭建;

- 完整的部署脚本与代码片段。

一、准备工作:你需要这些基础知识与工具

1. 技术栈/知识储备

- 后端开发:熟悉Python(Flask/FastAPI),了解RESTful API设计;

- 容器与编排:掌握Docker(打包服务)、Kubernetes(集群管理);

- AI基础:了解机器学习模型的训练与推理流程(TensorFlow/PyTorch);

- 数据库:熟悉MySQL(存储元数据)、MinIO(对象存储,存储模型文件);

- 监控与日志:了解Prometheus(监控)、Grafana(可视化)、ELK(日志收集)。

2. 环境/工具清单

- 操作系统:Linux(推荐Ubuntu 20.04+)或 macOS;

- 工具:

- Docker(容器化)、Minikube(本地Kubernetes集群);

- Python 3.8+(开发API与脚本);

- Git(版本控制);

- Postman(测试API)。

二、第一步:需求分析与架构设计

1. 明确AI中台的核心目标

AI中台的核心是**“统一管理”与“高效复用”**,需满足以下需求:

- 模型管理:统一存储模型文件与元数据(版本、描述、标签),支持查询、删除、版本控制;

- 推理服务:将模型封装为API,支持高并发、低延迟的推理请求;

- 资源调度:根据请求量自动扩缩容推理服务,提高资源利用率;

- 监控运维:实时监控推理服务的性能(延迟、错误率),收集日志便于排查问题;

- 易用性:提供简单的API接口,让业务团队快速接入。

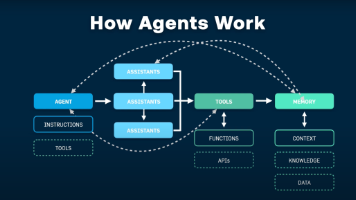

2. 架构设计:分层模型

我们采用四层架构,从下到上依次是:

- 基础设施层:提供底层资源,如服务器、存储(MinIO)、数据库(MySQL)、容器编排(Kubernetes);

- 核心功能层:实现AI中台的核心功能,包括模型仓库(存储与管理模型)、推理服务框架(封装模型为API)、资源调度(Kubernetes管理推理服务);

- 服务层:对外提供API接口,如模型管理API(注册、查询、删除)、推理服务API(调用模型推理);

- 接入层:支持业务系统通过HTTP/HTTPS接入,提供认证授权(如JWT)、负载均衡等功能。

架构图(简化):

业务系统 → 接入层(负载均衡、认证) → 服务层(模型管理API、推理服务API) → 核心功能层(模型仓库、推理服务框架、资源调度) → 基础设施层(MinIO、MySQL、Kubernetes)

三、实战:搭建核心组件(15个锦囊)

锦囊1:搭建模型仓库(MinIO + MySQL)

目标:统一存储模型文件与元数据,支持版本管理。

为什么需要?

- 模型文件通常很大(几GB到几十GB),需要高效的对象存储(MinIO);

- 元数据(如模型名称、版本、描述)需要结构化存储(MySQL),方便查询。

步骤:

-

部署MinIO(对象存储):

用Docker快速部署MinIO:# 部署MinIO容器 docker run -d \ --name minio-server \ -p 9000:9000 \ -p 9001:9001 \ -v minio-data:/data \ minio/minio server /data --console-address ":9001"- 访问

http://localhost:9001,用默认账号minioadmin/minioadmin登录控制台; - 创建一个存储桶(如

model-bucket),用于存储模型文件。

- 访问

-

部署MySQL(元数据存储):

用Docker部署MySQL:# 部署MySQL容器 docker run -d \ --name mysql-server \ -p 3306:3306 \ -e MYSQL_ROOT_PASSWORD=root \ -e MYSQL_DATABASE=ai_platform \ mysql:8.0- 创建

model_metadata表(存储模型元数据):CREATE TABLE `model_metadata` ( `id` int(11) NOT NULL AUTO_INCREMENT, `model_name` varchar(255) NOT NULL COMMENT '模型名称', `model_version` varchar(50) NOT NULL COMMENT '模型版本(如v1.0.0)', `model_path` varchar(255) NOT NULL COMMENT 'MinIO中的存储路径(如model/v1/model.pth)', `description` text COMMENT '模型描述', `created_at` timestamp NOT NULL DEFAULT CURRENT_TIMESTAMP COMMENT '创建时间', PRIMARY KEY (`id`), UNIQUE KEY `unique_model` (`model_name`, `model_version`) -- 同名模型不能有相同版本 ) ENGINE=InnoDB DEFAULT CHARSET=utf8mb4;

- 创建

-

编写模型上传/下载代码(Python):

用minio库操作MinIO:# 安装依赖 # pip install minio pymysql from minio import Minio from minio.error import S3Error import pymysql # MinIO配置 MINIO_CONFIG = { "endpoint": "localhost:9000", "access_key": "minioadmin", "secret_key": "minioadmin", "secure": False } # MySQL配置 MYSQL_CONFIG = { "host": "localhost", "user": "root", "password": "root", "database": "ai_platform" } def upload_model(model_name: str, model_version: str, model_path: str, description: str): """ 上传模型到模型仓库(MinIO存储文件,MySQL存储元数据) """ # 1. 上传模型文件到MinIO minio_client = Minio(**MINIO_CONFIG) bucket_name = "model-bucket" object_name = f"model/{model_name}/{model_version}/model.pth" # 存储路径(按模型名称+版本分类) try: # 检查存储桶是否存在 if not minio_client.bucket_exists(bucket_name): minio_client.make_bucket(bucket_name) # 上传文件 minio_client.fput_object(bucket_name, object_name, model_path) print(f"模型文件上传成功:{object_name}") except S3Error as e: raise Exception(f"模型文件上传失败:{e}") # 2. 存储元数据到MySQL conn = pymysql.connect(**MYSQL_CONFIG) try: with conn.cursor() as cursor: sql = """ INSERT INTO model_metadata (model_name, model_version, model_path, description) VALUES (%s, %s, %s, %s) """ cursor.execute(sql, (model_name, model_version, object_name, description)) conn.commit() print(f"模型元数据存储成功:{model_name} v{model_version}") except Exception as e: conn.rollback() raise Exception(f"模型元数据存储失败:{e}") finally: conn.close() # 使用示例:上传一个名为"image-classification"的模型(v1.0.0) upload_model( model_name="image-classification", model_version="v1.0.0", model_path="./image_classification_v1.pth", description="ResNet-50图像分类模型,准确率92%" )

效果:

- 模型文件存储在MinIO的

model-bucket/model/image-classification/v1.0.0/路径下; - 元数据存入MySQL的

model_metadata表,包含模型名称、版本、路径、描述等信息。

锦囊2:封装推理服务(FastAPI + Docker)

目标:将模型封装为API,支持业务系统调用。

为什么用FastAPI?

- 性能强:基于Starlette框架,支持异步,比Flask快3-5倍;

- 易用性:自动生成API文档(Swagger UI),减少文档维护工作量;

- 类型安全:用Pydantic定义请求/响应模型,避免参数错误。

步骤:

-

编写推理服务代码:

以PyTorch的ResNet-50图像分类模型为例,封装为API:# 安装依赖 # pip install fastapi uvicorn torch torchvision pillow from fastapi import FastAPI, File, UploadFile from torchvision import models, transforms from PIL import Image import io # 初始化FastAPI应用 app = FastAPI(title="Image Classification Inference Service") # 加载模型(启动时加载,避免每次请求都加载) model = models.resnet50(pretrained=False) model.load_state_dict(torch.load("./image_classification_v1.pth")) model.eval() # 定义图像预处理流程(与训练时一致) preprocess = transforms.Compose([ transforms.Resize((224, 224)), transforms.ToTensor(), transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]) ]) # 定义类别标签(示例) class_labels = ["cat", "dog", "car", "tree"] @app.post("/infer", summary="图像分类推理接口") async def infer(image: UploadFile = File(...)): """ 图像分类推理接口:接收图片文件,返回分类结果 """ try: # 1. 读取图片文件 image_data = await image.read() image = Image.open(io.BytesIO(image_data)).convert("RGB") # 2. 预处理图片 input_tensor = preprocess(image).unsqueeze(0) # 添加 batch 维度(模型要求) # 3. 模型推理 with torch.no_grad(): outputs = model(input_tensor) probabilities = torch.softmax(outputs, dim=1).tolist()[0] # 转换为概率值 # 4. 生成结果 result = [ {"class": label, "probability": round(prob, 4)} for label, prob in zip(class_labels, probabilities) ] # 排序(按概率从高到低) result.sort(key=lambda x: x["probability"], reverse=True) return {"code": 200, "message": "success", "data": result} except Exception as e: return {"code": 500, "message": f"inference failed: {str(e)}", "data": None} # 启动服务(命令行运行:uvicorn main:app --host 0.0.0.0 --port 8000) -

用Docker打包推理服务:

编写Dockerfile:# 基础镜像(Python 3.10) FROM python:3.10-slim # 设置工作目录 WORKDIR /app # 复制依赖文件 COPY requirements.txt . # 安装依赖(使用国内源加速) RUN pip install -r requirements.txt -i https://pypi.tuna.tsinghua.edu.cn/simple # 复制代码与模型文件 COPY main.py . COPY image_classification_v1.pth . # 暴露端口(与FastAPI启动端口一致) EXPOSE 8000 # 启动服务 CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]构建镜像并运行容器:

# 构建镜像(标签为image-classification-inference:v1.0.0) docker build -t image-classification-inference:v1.0.0 . # 运行容器(映射端口8000到主机) docker run -d -p 8000:8000 image-classification-inference:v1.0.0

效果:

- 访问

http://localhost:8000/docs,可以看到自动生成的Swagger UI文档; - 用Postman上传图片,调用

/infer接口,返回分类结果(如{"class": "cat", "probability": 0.92})。

锦囊3:部署推理服务到Kubernetes(自动扩缩容)

目标:用Kubernetes管理推理服务,实现自动扩缩容、高可用。

为什么用Kubernetes?

- 自动扩缩容:根据CPU/内存使用率或请求量,自动增加/减少Pod数量;

- 高可用:当某个Pod故障时,Kubernetes会自动重启或替换;

- 负载均衡:通过Service将请求分发到多个Pod。

步骤:

-

编写Deployment配置(定义Pod模板):

deployment.yaml:apiVersion: apps/v1 kind: Deployment metadata: name: image-classification-deployment labels: app: image-classification spec: replicas: 2 # 初始Pod数量 selector: matchLabels: app: image-classification template: metadata: labels: app: image-classification spec: containers: - name: image-classification-container image: image-classification-inference:v1.0.0 # 推理服务镜像 ports: - containerPort: 8000 # 容器内端口(与FastAPI启动端口一致) resources: requests: cpu: "100m" # 每个Pod请求100m CPU(0.1核) memory: "256Mi" # 请求256MB内存 limits: cpu: "500m" # 每个Pod最多使用500m CPU(0.5核) memory: "512Mi" # 最多使用512MB内存 -

编写Service配置(暴露服务):

service.yaml:apiVersion: v1 kind: Service metadata: name: image-classification-service spec: type: NodePort # 暴露到主机端口(用于测试,生产环境用LoadBalancer或Ingress) selector: app: image-classification ports: - port: 80 # Service端口 targetPort: 8000 # 容器内端口(与Deployment中的containerPort一致) nodePort: 30000 # 主机端口(范围30000-32767) -

编写HPA配置(自动扩缩容规则):

hpa.yaml:apiVersion: autoscaling/v2 kind: HorizontalPodAutoscaler metadata: name: image-classification-hpa spec: scaleTargetRef: apiVersion: apps/v1 kind: Deployment name: image-classification-deployment minReplicas: 2 # 最小Pod数量 maxReplicas: 10 # 最大Pod数量 metrics: - type: Resource resource: name: cpu target: type: Utilization averageUtilization: 50 # 当CPU使用率超过50%时,自动扩容 -

部署到Kubernetes:

# 部署Deployment kubectl apply -f deployment.yaml # 部署Service kubectl apply -f service.yaml # 部署HPA kubectl apply -f hpa.yaml

效果:

- 运行

kubectl get pods,可以看到2个Pod正在运行; - 访问

http://localhost:30000/docs(NodePort),可以调用推理服务; - 当CPU使用率超过50%时,HPA会自动增加Pod数量(最多到10个);当使用率下降时,自动减少Pod数量(最少到2个)。

锦囊4:实现模型管理API(Flask)

目标:提供API接口,让业务团队可以注册、查询、删除模型。

为什么需要?

- 业务团队不需要直接操作MinIO和MySQL,通过API即可管理模型;

- 便于集成到企业的内部系统(如OA、数据平台)。

步骤:

- 编写模型管理API代码:

用Flask实现三个接口:/model/register(注册模型)、/model/list(查询模型)、/model/delete(删除模型):# 安装依赖 # pip install flask pymysql minio from flask import Flask, request, jsonify from minio import Minio import pymysql app = Flask(__name__) # 配置(与锦囊1一致) MINIO_CONFIG = {...} MYSQL_CONFIG = {...} @app.route("/model/register", methods=["POST"]) def register_model(): """ 注册模型API:接收模型信息,上传到模型仓库 请求参数(JSON): { "model_name": "image-classification", "model_version": "v1.0.0", "model_file": "(文件)", "description": "ResNet-50图像分类模型" } """ try: # 获取请求参数 model_name = request.form.get("model_name") model_version = request.form.get("model_version") description = request.form.get("description") model_file = request.files.get("model_file") # 保存模型文件到本地(临时) temp_model_path = f"./{model_file.filename}" model_file.save(temp_model_path) # 调用锦囊1的upload_model函数(上传到模型仓库) upload_model(model_name, model_version, temp_model_path, description) return jsonify({"code": 200, "message": "模型注册成功"}) except Exception as e: return jsonify({"code": 500, "message": f"模型注册失败:{str(e)}"}) @app.route("/model/list", methods=["GET"]) def list_models(): """ 查询模型API:根据条件查询模型元数据 请求参数(Query): - model_name: 模型名称(可选) - model_version: 模型版本(可选) """ try: # 获取查询条件 model_name = request.args.get("model_name") model_version = request.args.get("model_version") # 查询MySQL conn = pymysql.connect(**MYSQL_CONFIG) with conn.cursor(pymysql.cursors.DictCursor) as cursor: sql = "SELECT * FROM model_metadata WHERE 1=1" params = [] if model_name: sql += " AND model_name = %s" params.append(model_name) if model_version: sql += " AND model_version = %s" params.append(model_version) cursor.execute(sql, params) models = cursor.fetchall() return jsonify({"code": 200, "message": "查询成功", "data": models}) except Exception as e: return jsonify({"code": 500, "message": f"查询失败:{str(e)}"}) @app.route("/model/delete", methods=["POST"]) def delete_model(): """ 删除模型API:根据模型名称和版本删除模型 请求参数(JSON): { "model_name": "image-classification", "model_version": "v1.0.0" } """ try: # 获取请求参数 data = request.get_json() model_name = data.get("model_name") model_version = data.get("model_version") # 1. 从MySQL查询模型路径 conn = pymysql.connect(**MYSQL_CONFIG) with conn.cursor() as cursor: sql = "SELECT model_path FROM model_metadata WHERE model_name = %s AND model_version = %s" cursor.execute(sql, (model_name, model_version)) result = cursor.fetchone() if not result: raise Exception("模型不存在") model_path = result[0] # 2. 从MinIO删除模型文件 minio_client = Minio(**MINIO_CONFIG) bucket_name = "model-bucket" minio_client.remove_object(bucket_name, model_path) # 3. 从MySQL删除元数据 with conn.cursor() as cursor: sql = "DELETE FROM model_metadata WHERE model_name = %s AND model_version = %s" cursor.execute(sql, (model_name, model_version)) conn.commit() return jsonify({"code": 200, "message": "模型删除成功"}) except Exception as e: return jsonify({"code": 500, "message": f"模型删除失败:{str(e)}"}) # 启动服务(命令行运行:flask run --host 0.0.0.0 --port 5000)

效果:

- 用Postman调用

/model/register接口,上传模型文件和信息,模型注册成功; - 调用

/model/list接口,查询所有模型或指定模型的信息; - 调用

/model/delete接口,删除指定版本的模型。

锦囊5:添加监控(Prometheus + Grafana)

目标:实时监控推理服务的性能(如请求数、延迟、错误率)。

为什么需要?

- 及时发现服务异常(如延迟突然升高、错误率飙升);

- 优化资源配置(如根据请求数调整Pod数量);

- 为后续的性能优化提供数据支持。

步骤:

-

在推理服务中添加监控指标:

用prometheus-client库在FastAPI中添加监控指标:# 安装依赖 # pip install prometheus-client from prometheus_client import Counter, Histogram, generate_latest, CONTENT_TYPE_LATEST from fastapi import FastAPI, Request # 定义监控指标 REQUEST_COUNT = Counter( "inference_request_count", "Total number of inference requests", ["model_name", "status"] # 标签:模型名称、请求状态(成功/失败) ) REQUEST_LATENCY = Histogram( "inference_request_latency_seconds", "Latency of inference requests", ["model_name"] # 标签:模型名称 ) app = FastAPI() # 中间件:记录请求数和延迟 @app.middleware("http") async def add_metrics_middleware(request: Request, call_next): model_name = "image-classification" # 模型名称(可根据实际情况动态获取) start_time = time.time() response = await call_next(request) latency = time.time() - start_time # 记录请求数(根据响应状态码判断成功/失败) status = "success" if response.status_code == 200 else "failure" REQUEST_COUNT.labels(model_name=model_name, status=status).inc() # 记录延迟 REQUEST_LATENCY.labels(model_name=model_name).observe(latency) return response # 暴露metrics接口(Prometheus抓取指标) @app.get("/metrics") async def metrics(): return generate_latest(), 200, {"Content-Type": CONTENT_TYPE_LATEST} -

部署Prometheus:

编写prometheus.yaml配置文件(指定抓取目标):global: scrape_interval: 15s # 每15秒抓取一次指标 scrape_configs: - job_name: "inference-service" static_configs: - targets: ["image-classification-service:80"] # 推理服务的Service地址(Kubernetes中的服务名称)用Docker部署Prometheus:

docker run -d \ --name prometheus \ -p 9090:9090 \ -v $(pwd)/prometheus.yaml:/etc/prometheus/prometheus.yaml \ prom/prometheus --config.file=/etc/prometheus/prometheus.yaml -

部署Grafana:

用Docker部署Grafana:docker run -d \ --name grafana \ -p 3000:3000 \ grafana/grafana配置Grafana:

- 访问

http://localhost:3000,用默认账号admin/admin登录; - 添加数据源(Data Source):选择Prometheus,填写URL(

http://prometheus:9090); - 导入仪表盘(Dashboard):可以使用Grafana的官方模板(如

12856,适用于FastAPI监控),或自定义仪表盘。

- 访问

效果:

- 访问

http://localhost:9090,可以看到Prometheus的界面,查询inference_request_count指标; - 访问

http://localhost:3000,可以看到Grafana的仪表盘,实时展示推理服务的请求数、延迟、错误率等指标。

锦囊6-15:其他关键锦囊(摘要)

限于篇幅,以下10个锦囊用摘要形式呈现,完整代码可参考文末的GitHub仓库:

| 锦囊编号 | 主题 | 核心内容 |

|---|---|---|

| 6 | 日志收集(ELK) | 用Filebeat收集容器日志,发送到Logstash,存入Elasticsearch,用Kibana查询。 |

| 7 | 认证授权(JWT) | 在接入层添加JWT认证,防止非法调用API。 |

| 8 | 模型版本管理(DVC) | 用DVC管理模型版本,支持回滚到历史版本。 |

| 9 | 推理服务熔断(Sentinel) | 用Sentinel实现熔断降级,防止单个服务故障影响整个系统。 |

| 10 | 多模型支持 | 扩展推理服务,支持同时部署多个模型(如图像分类、文本分类)。 |

| 11 | 模型热更新 | 无需重启Pod,动态加载新模型(用reload接口或配置中心)。 |

| 12 | 成本优化(Spot实例) | 在Kubernetes中使用Spot实例(抢占式实例),降低计算成本。 |

| 13 | 跨团队协作(API网关) | 用API网关(如Kong)统一管理API,支持流量控制、熔断、监控。 |

| 14 | 自动化部署(CI/CD) | 用GitHub Actions或GitLab CI实现推理服务的自动构建、测试、部署。 |

| 15 | 故障排查(kubectl) | 用kubectl logs查看Pod日志,kubectl describe pod查看Pod状态,快速排查问题。 |

四、进阶探讨:从“能用”到“好用”

1. 混合模型部署

如果需要同时部署多个模型(如图像分类+文本分类),可以用多容器Pod或独立Deployment:

- 多容器Pod:一个Pod中运行多个容器(每个容器对应一个模型),共享网络和存储;

- 独立Deployment:每个模型对应一个Deployment,通过不同的Service暴露接口。

2. 性能优化:大模型推理

对于大模型(如GPT-3、LLaMA),推理延迟高,需要优化:

- 模型量化:用TensorRT或ONNX Runtime将模型量化为INT8,减少计算量;

- 模型剪枝:移除模型中的冗余参数,减小模型大小;

- 批量推理:将多个请求合并为一个批次,提高GPU利用率;

- 分布式推理:用TensorFlow Serving或TorchServe实现分布式推理,分摊计算压力。

3. 封装通用推理框架

为了减少重复开发,可以封装一个通用的推理框架,支持:

- 自动加载模型(根据模型类型选择框架:TensorFlow/PyTorch);

- 统一的请求/响应格式(用Pydantic定义);

- 动态添加模型(通过配置文件或API)。

五、总结:你已经完成了什么?

通过本文的15个锦囊,你已经搭建了一个企业级AI中台的最小可行产品(MVP),具备以下功能:

- 模型管理:统一存储模型文件与元数据,支持注册、查询、删除;

- 推理服务:将模型封装为API,支持高并发、低延迟的推理请求;

- 资源调度:用Kubernetes实现自动扩缩容,提高资源利用率;

- 监控运维:实时监控推理服务的性能,收集日志便于排查问题。

这个中台可以解决企业AI落地的核心痛点,让业务团队快速接入AI能力,提高开发效率。

六、行动号召:动手实践!

现在,你已经掌握了搭建AI中台的核心步骤,接下来需要动手实践:

- 按照本文的步骤,搭建一个简单的AI中台;

- 尝试将自己的模型部署到中台,调用推理服务;

- 探索进阶功能(如监控、自动扩缩容)。

如果遇到问题,可以参考以下资源:

- 官方文档:MinIO(https://min.io/docs)、FastAPI(https://fastapi.tiangolo.com)、Kubernetes(https://kubernetes.io/docs);

- 社区资源:GitHub(https://github.com)上有很多AI中台的开源项目(如MLflow、Kubeflow),可以参考它们的实现;

- 留言讨论:如果有任何问题,欢迎在评论区留言,我会及时解答!

最后,祝你搭建成功,让AI真正赋能业务! 🚀

更多推荐

已为社区贡献83条内容

已为社区贡献83条内容

所有评论(0)