AI Agent的多轮对话能力增强

在当今数字化时代,AI Agent在各个领域的应用越来越广泛,如智能客服、虚拟助手等。然而,现有的AI Agent在多轮对话方面还存在诸多不足,例如不能很好地理解上下文、对话连贯性差等问题。本文章的目的就是深入探讨如何增强AI Agent的多轮对话能力,提升其在实际应用中的表现。范围涵盖了多轮对话的核心概念、算法原理、数学模型、项目实战以及实际应用场景等多个方面。本文首先介绍背景知识,让读者了解提

AI Agent的多轮对话能力增强

关键词:AI Agent、多轮对话能力、对话管理、上下文理解、对话策略

摘要:本文围绕AI Agent的多轮对话能力增强展开深入探讨。首先介绍了提升AI Agent多轮对话能力的背景和重要性,包括其目的、适用读者、文档结构以及相关术语。接着阐述了核心概念,如多轮对话的原理和架构,并通过Mermaid流程图直观呈现。详细讲解了核心算法原理和具体操作步骤,结合Python源代码进行说明。还介绍了相关数学模型和公式,并举例分析。通过项目实战展示了代码实现和解读。探讨了AI Agent多轮对话能力增强在多个实际场景中的应用,推荐了学习资源、开发工具框架和相关论文著作。最后总结了未来发展趋势与挑战,并给出常见问题解答和扩展阅读参考资料。

1. 背景介绍

1.1 目的和范围

在当今数字化时代,AI Agent在各个领域的应用越来越广泛,如智能客服、虚拟助手等。然而,现有的AI Agent在多轮对话方面还存在诸多不足,例如不能很好地理解上下文、对话连贯性差等问题。本文章的目的就是深入探讨如何增强AI Agent的多轮对话能力,提升其在实际应用中的表现。范围涵盖了多轮对话的核心概念、算法原理、数学模型、项目实战以及实际应用场景等多个方面。

1.2 预期读者

本文预期读者包括人工智能领域的研究人员、开发者、软件架构师以及对AI Agent多轮对话技术感兴趣的爱好者。对于研究人员,本文可以提供新的研究思路和方向;对于开发者,有助于他们在实际项目中提升AI Agent的多轮对话性能;对于软件架构师,能为其设计更高效的多轮对话系统提供参考;对于爱好者,可以帮助他们深入了解这一技术的原理和实现。

1.3 文档结构概述

本文首先介绍背景知识,让读者了解提升AI Agent多轮对话能力的重要性和相关基础信息。接着阐述核心概念和联系,使读者对多轮对话的原理和架构有清晰的认识。然后详细讲解核心算法原理和具体操作步骤,并结合Python代码进行说明。之后介绍数学模型和公式,通过实际例子加深读者的理解。项目实战部分展示如何在实际开发中实现增强多轮对话能力的AI Agent。再探讨实际应用场景,让读者了解该技术的实际用途。随后推荐学习资源、开发工具框架和相关论文著作,为读者提供进一步学习的途径。最后总结未来发展趋势与挑战,给出常见问题解答和扩展阅读参考资料。

1.4 术语表

1.4.1 核心术语定义

- AI Agent:人工智能代理,是一种能够感知环境、进行决策并采取行动以实现特定目标的智能实体。

- 多轮对话能力:指AI Agent在与用户进行多次交互的过程中,能够理解上下文、保持对话连贯性并有效回应的能力。

- 对话管理:负责协调和控制AI Agent在多轮对话中的交互流程,包括对话状态的维护、回复的生成等。

- 上下文理解:AI Agent对对话历史信息的理解和处理,以便更好地适应当前对话的语境。

1.4.2 相关概念解释

- 对话状态:表示对话在某一时刻的状态,包括用户的意图、历史对话内容等信息。

- 回复策略:AI Agent根据对话状态选择合适回复的规则和方法。

- 知识图谱:一种结构化的知识表示方法,用于存储和管理与对话相关的知识,帮助AI Agent更好地理解和回答问题。

1.4.3 缩略词列表

- NLP:Natural Language Processing,自然语言处理

- RNN:Recurrent Neural Network,循环神经网络

- LSTM:Long Short-Term Memory,长短期记忆网络

- GRU:Gated Recurrent Unit,门控循环单元

2. 核心概念与联系

核心概念原理

AI Agent的多轮对话能力增强主要基于对对话上下文的理解和管理。在多轮对话中,每一轮对话都不是孤立的,而是与之前的对话内容相关联。AI Agent需要通过一定的机制来存储和处理这些历史对话信息,以便更好地理解用户当前的意图。

对话管理是实现多轮对话能力的关键环节。它负责维护对话状态,根据用户的输入更新状态,并根据当前状态选择合适的回复策略。对话状态可以用多种方式表示,如有限状态机、基于槽位填充的方法等。

上下文理解则是通过自然语言处理技术对对话历史进行分析和处理。例如,使用词法分析、句法分析、语义分析等方法来理解用户的话语,并提取有用的信息。同时,还可以利用知识图谱等技术来补充和扩展对话中的知识,提高AI Agent的回答质量。

架构的文本示意图

以下是一个简单的AI Agent多轮对话系统架构示意图:

用户输入 -> 输入处理模块(词法分析、句法分析等) -> 对话状态管理模块(维护对话状态) -> 回复生成模块(根据对话状态和回复策略生成回复) -> 输出处理模块(将回复转换为合适的形式输出) -> 用户输出

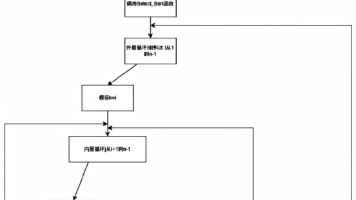

Mermaid流程图

这个流程图展示了AI Agent多轮对话的基本流程。用户输入首先经过输入处理模块进行处理,然后对话状态管理模块根据处理后的输入更新对话状态。回复生成模块根据对话状态和知识图谱生成合适的回复,最后经过输出处理模块将回复呈现给用户。

3. 核心算法原理 & 具体操作步骤

核心算法原理

在增强AI Agent的多轮对话能力中,循环神经网络(RNN)及其变体(如LSTM和GRU)是常用的算法。这些算法能够处理序列数据,非常适合处理对话这种具有时间顺序的文本数据。

以LSTM为例,它通过门控机制来解决传统RNN中的梯度消失问题,能够更好地捕捉长期依赖关系。LSTM单元包含输入门、遗忘门和输出门,这些门控制着信息的流入、流出和保留。

输入门决定了新输入信息中有多少会被添加到细胞状态中;遗忘门决定了细胞状态中哪些信息会被遗忘;输出门决定了细胞状态中有多少信息会被输出。

具体操作步骤

步骤1:数据预处理

首先,需要对对话数据进行预处理。这包括将文本数据转换为数字表示,如使用词嵌入(Word Embedding)技术将每个单词映射为一个向量。可以使用预训练的词向量模型,如Word2Vec、GloVe等。

以下是一个简单的Python代码示例,使用torchtext库进行数据预处理:

import torch

from torchtext.data.utils import get_tokenizer

from torchtext.vocab import build_vocab_from_iterator

# 定义分词器

tokenizer = get_tokenizer('basic_english')

# 示例对话数据

dialogue_data = [

"Hello, how are you?",

"I'm fine, thank you. And you?",

"I'm also fine. What's the weather like today?"

]

# 分词

tokenized_data = [tokenizer(sentence) for sentence in dialogue_data]

# 构建词汇表

vocab = build_vocab_from_iterator(tokenized_data)

# 将文本转换为数字序列

numericalized_data = []

for tokens in tokenized_data:

numericalized_data.append([vocab[token] for token in tokens])

# 打印结果

print(numericalized_data)

步骤2:构建LSTM模型

接下来,构建一个LSTM模型。以下是一个简单的LSTM模型示例:

import torch.nn as nn

class LSTMModel(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim):

super(LSTMModel, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

embedded = self.embedding(x)

output, (hidden, cell) = self.lstm(embedded)

output = self.fc(hidden.squeeze(0))

return output

# 定义模型参数

vocab_size = len(vocab)

embedding_dim = 100

hidden_dim = 256

output_dim = 10 # 假设输出类别数为10

# 初始化模型

model = LSTMModel(vocab_size, embedding_dim, hidden_dim, output_dim)

步骤3:训练模型

使用预处理后的数据对模型进行训练。以下是一个简单的训练代码示例:

import torch.optim as optim

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 模拟训练数据

train_data = torch.tensor(numericalized_data, dtype=torch.long)

labels = torch.randint(0, output_dim, (len(train_data),))

# 训练模型

num_epochs = 10

for epoch in range(num_epochs):

optimizer.zero_grad()

outputs = model(train_data)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}/{num_epochs}, Loss: {loss.item()}')

步骤4:生成回复

在训练好模型后,可以使用模型来生成回复。根据用户的输入,将其转换为数字序列,输入到模型中,得到输出结果,再将输出结果转换为文本回复。

# 模拟用户输入

user_input = "Hello"

tokenized_input = tokenizer(user_input)

numericalized_input = torch.tensor([vocab[token] for token in tokenized_input], dtype=torch.long).unsqueeze(0)

# 生成回复

with torch.no_grad():

output = model(numericalized_input)

predicted_label = torch.argmax(output, dim=1).item()

# 这里简单假设根据标签生成回复

responses = ["Hi!", "Hello there!", "Nice to meet you!"]

reply = responses[predicted_label]

print(reply)

4. 数学模型和公式 & 详细讲解 & 举例说明

数学模型和公式

LSTM单元的数学公式

LSTM单元的核心是细胞状态 CtC_tCt 和隐藏状态 hth_tht。以下是LSTM单元的主要数学公式:

遗忘门 ftf_tft:

ft=σ(Wf[ht−1,xt]+bf)f_t = \sigma(W_f[h_{t-1}, x_t] + b_f)ft=σ(Wf[ht−1,xt]+bf)

输入门 iti_tit:

it=σ(Wi[ht−1,xt]+bi)i_t = \sigma(W_i[h_{t-1}, x_t] + b_i)it=σ(Wi[ht−1,xt]+bi)

候选细胞状态 C~t\tilde{C}_tC~t:

C~t=tanh(WC[ht−1,xt]+bC)\tilde{C}_t = \tanh(W_C[h_{t-1}, x_t] + b_C)C~t=tanh(WC[ht−1,xt]+bC)

更新细胞状态 CtC_tCt:

Ct=ft⊙Ct−1+it⊙C~tC_t = f_t \odot C_{t-1} + i_t \odot \tilde{C}_tCt=ft⊙Ct−1+it⊙C~t

输出门 oto_tot:

ot=σ(Wo[ht−1,xt]+bo)o_t = \sigma(W_o[h_{t-1}, x_t] + b_o)ot=σ(Wo[ht−1,xt]+bo)

隐藏状态 hth_tht:

ht=ot⊙tanh(Ct)h_t = o_t \odot \tanh(C_t)ht=ot⊙tanh(Ct)

其中,σ\sigmaσ 是 sigmoid 函数,tanh\tanhtanh 是双曲正切函数,WWW 是权重矩阵,bbb 是偏置向量,⊙\odot⊙ 表示逐元素相乘。

详细讲解

- 遗忘门 ftf_tft:决定了上一时刻的细胞状态 Ct−1C_{t-1}Ct−1 中有多少信息需要被遗忘。它通过 sigmoid 函数将输入 [ht−1,xt][h_{t-1}, x_t][ht−1,xt] 映射到 [0,1][0, 1][0,1] 之间,值越接近 0 表示遗忘的信息越多。

- 输入门 iti_tit:决定了新输入信息中有多少会被添加到细胞状态中。同样使用 sigmoid 函数进行映射。

- 候选细胞状态 C~t\tilde{C}_tC~t:通过双曲正切函数将输入 [ht−1,xt][h_{t-1}, x_t][ht−1,xt] 映射到 [−1,1][-1, 1][−1,1] 之间,得到候选的细胞状态。

- 更新细胞状态 CtC_tCt:将上一时刻的细胞状态 Ct−1C_{t-1}Ct−1 经过遗忘门处理后,加上新输入信息经过输入门处理后的结果,得到当前时刻的细胞状态。

- 输出门 oto_tot:决定了细胞状态 CtC_tCt 中有多少信息会被输出到隐藏状态 hth_tht 中。

- 隐藏状态 hth_tht:通过输出门对细胞状态 CtC_tCt 进行筛选,得到当前时刻的隐藏状态。

举例说明

假设我们有一个简单的对话场景,用户输入 “I want to book a hotel”。经过预处理后,将其转换为数字序列输入到LSTM模型中。

在第一个时间步,输入 x1x_1x1 是 “I” 的词向量,上一时刻的隐藏状态 h0h_0h0 初始化为零向量。通过遗忘门、输入门、候选细胞状态的计算,更新细胞状态 C1C_1C1 和隐藏状态 h1h_1h1。

在第二个时间步,输入 x2x_2x2 是 “want” 的词向量,此时使用 h1h_1h1 和 x2x_2x2 作为输入,再次计算遗忘门、输入门等,更新细胞状态 C2C_2C2 和隐藏状态 h2h_2h2。

以此类推,经过多个时间步的计算,模型可以捕捉到整个输入序列的信息,从而更好地理解用户的意图。

5. 项目实战:代码实际案例和详细解释说明

5.1 开发环境搭建

安装Python

首先,确保你已经安装了Python 3.x 版本。可以从Python官方网站(https://www.python.org/downloads/) 下载并安装。

安装必要的库

使用以下命令安装必要的库:

pip install torch torchtext numpy

5.2 源代码详细实现和代码解读

以下是一个完整的AI Agent多轮对话项目的代码示例:

import torch

import torch.nn as nn

import torch.optim as optim

from torchtext.data.utils import get_tokenizer

from torchtext.vocab import build_vocab_from_iterator

# 定义分词器

tokenizer = get_tokenizer('basic_english')

# 示例对话数据

dialogue_data = [

"Hello, how are you?",

"I'm fine, thank you. And you?",

"I'm also fine. What's the weather like today?",

"I don't know. You can check the weather app."

]

# 分词

tokenized_data = [tokenizer(sentence) for sentence in dialogue_data]

# 构建词汇表

vocab = build_vocab_from_iterator(tokenized_data)

# 将文本转换为数字序列

numericalized_data = []

for tokens in tokenized_data:

numericalized_data.append([vocab[token] for token in tokens])

# 定义LSTM模型

class LSTMModel(nn.Module):

def __init__(self, vocab_size, embedding_dim, hidden_dim, output_dim):

super(LSTMModel, self).__init__()

self.embedding = nn.Embedding(vocab_size, embedding_dim)

self.lstm = nn.LSTM(embedding_dim, hidden_dim, batch_first=True)

self.fc = nn.Linear(hidden_dim, output_dim)

def forward(self, x):

embedded = self.embedding(x)

output, (hidden, cell) = self.lstm(embedded)

output = self.fc(hidden.squeeze(0))

return output

# 定义模型参数

vocab_size = len(vocab)

embedding_dim = 100

hidden_dim = 256

output_dim = 10 # 假设输出类别数为10

# 初始化模型

model = LSTMModel(vocab_size, embedding_dim, hidden_dim, output_dim)

# 定义损失函数和优化器

criterion = nn.CrossEntropyLoss()

optimizer = optim.Adam(model.parameters(), lr=0.001)

# 模拟训练数据

train_data = torch.tensor(numericalized_data, dtype=torch.long)

labels = torch.randint(0, output_dim, (len(train_data),))

# 训练模型

num_epochs = 10

for epoch in range(num_epochs):

optimizer.zero_grad()

outputs = model(train_data)

loss = criterion(outputs, labels)

loss.backward()

optimizer.step()

print(f'Epoch {epoch+1}/{num_epochs}, Loss: {loss.item()}')

# 模拟用户输入

user_input = "Hello"

tokenized_input = tokenizer(user_input)

numericalized_input = torch.tensor([vocab[token] for token in tokenized_input], dtype=torch.long).unsqueeze(0)

# 生成回复

with torch.no_grad():

output = model(numericalized_input)

predicted_label = torch.argmax(output, dim=1).item()

# 这里简单假设根据标签生成回复

responses = ["Hi!", "Hello there!", "Nice to meet you!"]

reply = responses[predicted_label]

print(f"User: {user_input}")

print(f"AI Agent: {reply}")

代码解读与分析

数据预处理部分

tokenizer:使用torchtext库的get_tokenizer函数定义分词器,将文本分割成单词。tokenized_data:对对话数据进行分词处理。vocab:使用build_vocab_from_iterator函数构建词汇表,将单词映射为数字。numericalized_data:将分词后的文本转换为数字序列。

模型定义部分

LSTMModel:定义了一个LSTM模型,包括嵌入层、LSTM层和全连接层。embedding:将输入的数字序列转换为词向量。lstm:使用LSTM单元处理序列数据。fc:将LSTM的输出映射到输出类别。

训练部分

criterion:使用交叉熵损失函数计算损失。optimizer:使用Adam优化器更新模型参数。train_data和labels:模拟训练数据和标签。- 通过多个 epoch 的训练,不断更新模型参数,降低损失。

回复生成部分

- 将用户输入进行分词和数字转换,输入到模型中。

- 使用

torch.argmax函数获取预测的标签。 - 根据标签从回复列表中选择合适的回复。

6. 实际应用场景

智能客服

在智能客服场景中,AI Agent的多轮对话能力可以显著提高服务效率和质量。用户可能会提出一系列相关问题,如产品的功能、价格、售后服务等。AI Agent需要通过多轮对话来理解用户的完整需求,并提供准确的回答。例如,用户可能先询问某款手机的价格,接着询问该手机的电池续航能力,AI Agent需要根据上下文理解用户的意图,依次回答问题。

虚拟助手

虚拟助手如苹果的Siri、亚马逊的Alexa等,需要具备良好的多轮对话能力。用户可以通过与虚拟助手进行多轮交互来完成各种任务,如设置提醒、查询信息、控制智能家居设备等。例如,用户可以先让虚拟助手查询明天的天气,然后根据天气情况让虚拟助手推荐合适的穿着,虚拟助手需要在多轮对话中保持上下文的连贯性。

智能教育

在智能教育领域,AI Agent可以作为学习伙伴与学生进行多轮对话。学生可以提出学习中的问题,AI Agent可以通过多轮引导帮助学生理解知识点。例如,学生在学习数学时遇到难题,AI Agent可以通过多轮对话逐步引导学生分析问题、找到解题思路。

智能金融

在金融领域,AI Agent可以为客户提供投资建议、解答金融知识等服务。客户可能会在多轮对话中询问不同的投资产品、风险评估等问题,AI Agent需要根据上下文理解客户的需求,提供个性化的服务。

7. 工具和资源推荐

7.1 学习资源推荐

7.1.1 书籍推荐

- 《深度学习》(Deep Learning):由Ian Goodfellow、Yoshua Bengio和Aaron Courville合著,是深度学习领域的经典教材,涵盖了神经网络、优化算法等基础知识,对理解AI Agent的核心算法有很大帮助。

- 《自然语言处理入门》:作者何晗,本书系统介绍了自然语言处理的基本概念、算法和应用,适合初学者快速入门。

- 《Python自然语言处理》(Natural Language Processing with Python):由Steven Bird、Ewan Klein和Edward Loper编写,通过Python代码示例详细介绍了自然语言处理的各种技术。

7.1.2 在线课程

- Coursera上的“深度学习专项课程”(Deep Learning Specialization):由Andrew Ng教授授课,包括神经网络、卷积神经网络、循环神经网络等内容,是学习深度学习的优质课程。

- edX上的“自然语言处理基础”(Foundations of Natural Language Processing):提供了自然语言处理的基础知识和实践经验。

- 哔哩哔哩(Bilibili)上有很多关于人工智能和自然语言处理的教学视频,适合不同层次的学习者。

7.1.3 技术博客和网站

- Medium:上面有很多人工智能领域的优秀博客文章,作者来自世界各地的专业人士。

- Towards Data Science:专注于数据科学和人工智能领域的技术文章,内容丰富且具有深度。

- 机器之心:提供人工智能领域的最新技术动态、研究成果和应用案例。

7.2 开发工具框架推荐

7.2.1 IDE和编辑器

- PyCharm:是一款专业的Python集成开发环境,具有代码自动补全、调试、版本控制等功能,非常适合Python开发。

- Jupyter Notebook:可以将代码、文本、图表等整合在一起,方便进行数据分析和模型实验。

- Visual Studio Code:轻量级的代码编辑器,支持多种编程语言和插件扩展,适合快速开发和调试。

7.2.2 调试和性能分析工具

- PyTorch Profiler:可以帮助开发者分析PyTorch模型的性能瓶颈,如计算时间、内存使用等。

- TensorBoard:是TensorFlow的可视化工具,也可以用于PyTorch模型的可视化分析,方便查看模型的训练过程和性能指标。

- cProfile:Python自带的性能分析工具,可以分析代码的执行时间和函数调用次数。

7.2.3 相关框架和库

- PyTorch:是一个开源的深度学习框架,具有动态图机制,方便模型的开发和调试。

- TensorFlow:是Google开发的深度学习框架,具有强大的分布式训练和部署能力。

- Hugging Face Transformers:提供了丰富的预训练模型和工具,方便进行自然语言处理任务,如文本分类、情感分析等。

7.3 相关论文著作推荐

7.3.1 经典论文

- “Long Short-Term Memory”:由Sepp Hochreiter和Jürgen Schmidhuber发表,介绍了LSTM的原理和应用,是循环神经网络领域的经典论文。

- “Attention Is All You Need”:提出了Transformer架构,是自然语言处理领域的重大突破,推动了预训练模型的发展。

- “Sequence to Sequence Learning with Neural Networks”:介绍了序列到序列(Seq2Seq)模型,在机器翻译、对话系统等领域有广泛应用。

7.3.2 最新研究成果

- 可以关注顶级学术会议如ACL(Association for Computational Linguistics)、EMNLP(Conference on Empirical Methods in Natural Language Processing)等的论文,了解自然语言处理领域的最新研究动态。

- arXiv.org是一个预印本平台,上面有很多最新的人工智能研究论文。

7.3.3 应用案例分析

- 可以参考一些实际应用案例的研究报告,如智能客服系统、虚拟助手等的开发和优化案例,了解如何在实际项目中应用AI Agent的多轮对话技术。

8. 总结:未来发展趋势与挑战

未来发展趋势

更强的上下文理解能力

未来的AI Agent将能够更好地理解对话的上下文,不仅包括文本信息,还能考虑到用户的情感、意图和历史交互等因素。例如,能够根据用户的语气和用词判断用户的情绪状态,并做出相应的回应。

多模态融合

除了文本对话,AI Agent将逐渐融合语音、图像、视频等多模态信息,提供更加丰富和自然的交互体验。例如,在对话过程中可以展示相关的图片或视频,帮助用户更好地理解信息。

个性化服务

根据用户的偏好、历史行为等信息,AI Agent将提供更加个性化的服务。例如,在智能客服场景中,能够根据用户的购买历史和使用习惯,提供针对性的产品推荐和解决方案。

与外部知识源的深度整合

AI Agent将能够更深入地整合外部知识源,如知识图谱、互联网信息等,以提供更准确和全面的回答。例如,在回答用户问题时,可以实时查询互联网上的最新信息。

挑战

数据质量和数量

提升AI Agent的多轮对话能力需要大量高质量的数据进行训练。然而,获取和标注这些数据是一项具有挑战性的任务,需要耗费大量的人力和物力。

计算资源需求

复杂的模型和算法对计算资源的需求较高,尤其是在处理大规模数据和进行实时交互时。如何在有限的计算资源下实现高效的模型训练和推理是一个亟待解决的问题。

语义理解的局限性

虽然自然语言处理技术取得了很大的进展,但在语义理解方面仍然存在局限性。例如,对于一些模糊、隐喻、歧义的表达,AI Agent可能无法准确理解其含义。

伦理和安全问题

随着AI Agent的广泛应用,伦理和安全问题也日益凸显。例如,如何确保AI Agent的回答符合道德和法律规范,如何防止AI Agent被恶意利用等。

9. 附录:常见问题与解答

问题1:如何选择合适的模型来增强AI Agent的多轮对话能力?

解答:选择合适的模型需要考虑多个因素,如数据规模、任务复杂度、计算资源等。如果数据规模较小,可以选择一些简单的模型,如基于规则的模型或浅层神经网络。如果数据规模较大,可以考虑使用深度学习模型,如LSTM、GRU、Transformer等。同时,还可以根据任务的特点选择合适的模型架构,如在需要处理长序列时,LSTM和GRU可能更合适;在处理大规模文本数据时,Transformer架构表现较好。

问题2:如何处理对话中的歧义问题?

解答:处理对话中的歧义问题可以采用多种方法。一种方法是利用上下文信息,通过分析对话历史来消除歧义。例如,根据之前的对话内容判断用户当前话语的具体含义。另一种方法是使用知识图谱,将对话中的词汇和概念与知识图谱中的信息进行关联,从而更准确地理解其含义。此外,还可以采用多轮对话的方式,通过进一步询问用户来澄清歧义。

问题3:如何评估AI Agent的多轮对话能力?

解答:评估AI Agent的多轮对话能力可以从多个方面进行。可以使用自动评估指标,如准确率、召回率、F1值等,来评估AI Agent的回答是否准确。还可以使用人工评估的方法,邀请人类评估者对AI Agent的对话表现进行打分,评估指标包括对话的连贯性、上下文理解能力、回答的质量等。此外,还可以通过用户反馈来评估AI Agent的性能,了解用户对对话体验的满意度。

问题4:如何提高AI Agent的实时响应能力?

解答:提高AI Agent的实时响应能力可以从多个方面入手。首先,可以优化模型的结构和算法,减少计算复杂度。例如,使用轻量级的模型或进行模型压缩。其次,可以采用异步处理和并行计算的方法,提高系统的处理效率。此外,还可以使用缓存技术,将常用的结果进行缓存,减少重复计算。最后,合理配置计算资源,确保系统具有足够的处理能力。

10. 扩展阅读 & 参考资料

扩展阅读

- 《人工智能:现代方法》(Artificial Intelligence: A Modern Approach):全面介绍了人工智能的各个领域,包括搜索算法、机器学习、自然语言处理等,适合深入学习人工智能的读者。

- 《自然语言处理实战:基于Python和深度学习》:通过实际案例详细介绍了自然语言处理的各种技术和应用,对提升实践能力有很大帮助。

- 《深度学习实战:基于TensorFlow和Keras》:结合TensorFlow和Keras框架,介绍了深度学习的实际应用,包括图像识别、语音识别、自然语言处理等。

参考资料

- 相关学术论文和研究报告可以在ACM Digital Library、IEEE Xplore等学术数据库中查找。

- 开源代码和项目可以在GitHub等代码托管平台上查找,例如Hugging Face的Transformers库、PyTorch官方代码库等。

- 官方文档和教程是学习各种工具和框架的重要参考资料,如PyTorch官方文档、TensorFlow官方教程等。

更多推荐

已为社区贡献102条内容

已为社区贡献102条内容

所有评论(0)