5分钟极速部署:手把手教你本地运行语言模型——Ollama平台安装指南

windows平台快速安装Ollama

Ollama工具用途:作为LLM模型服务器

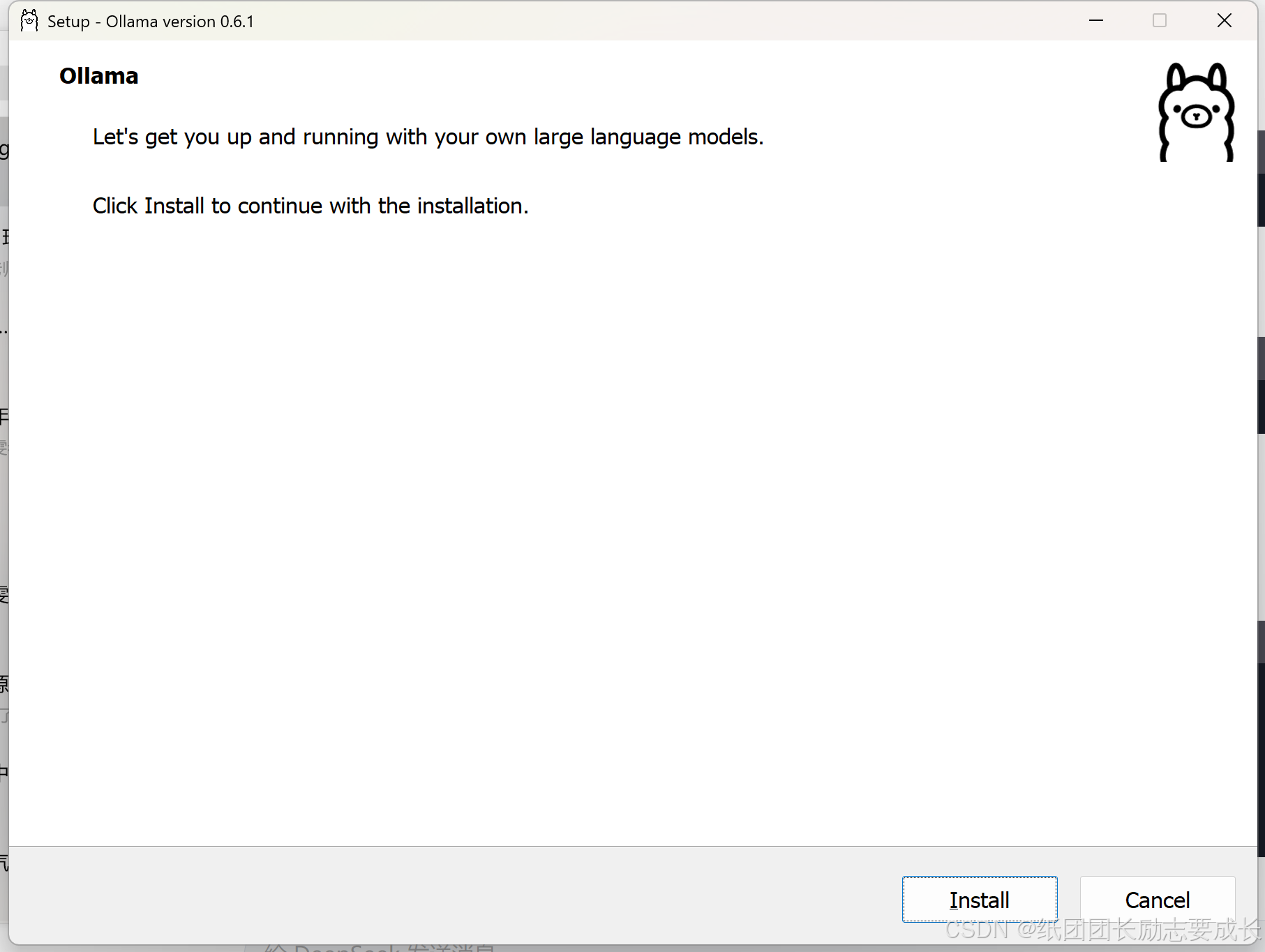

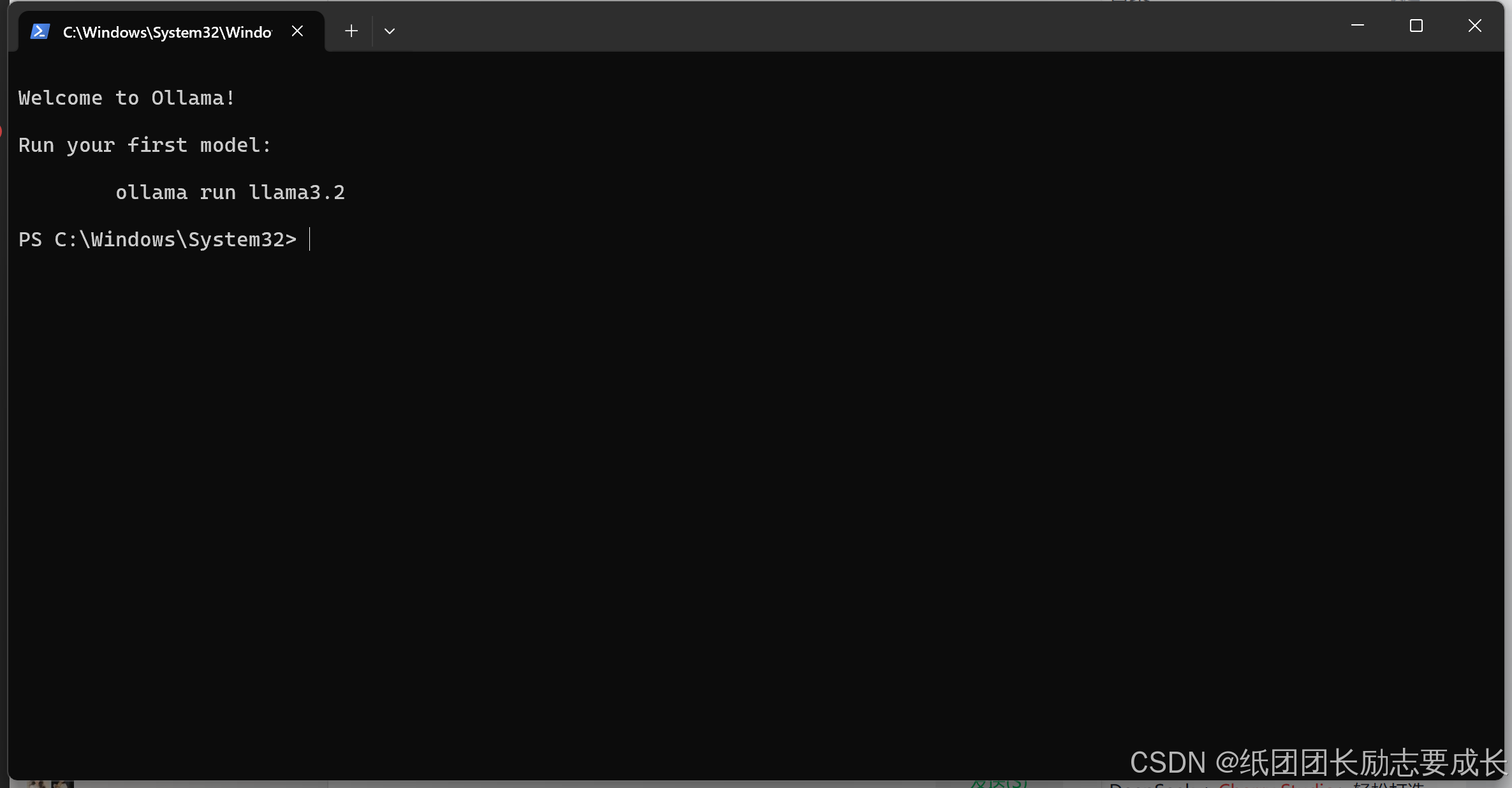

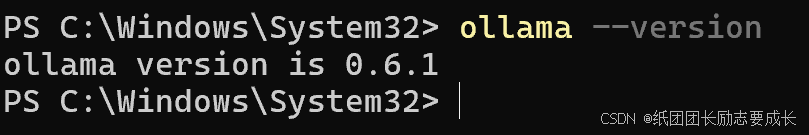

1.点击“install”之后,执行自动安装。安装后进入命令窗口,输入:ollama --version ,显示版本号即安装成功。安装后根目录默认在C盘。

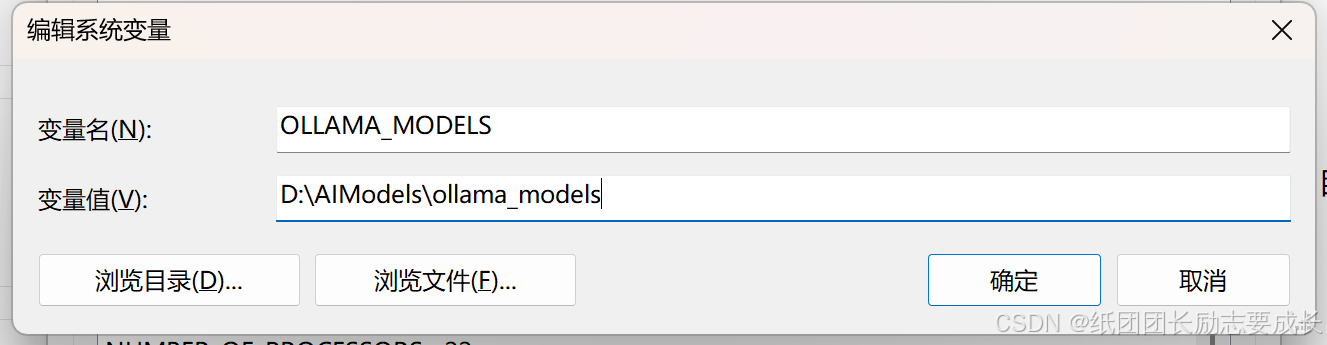

2.更改模型存储盘到D盘,我打算修改根目录到D盘实现模型存储路径的修改,目前系统变量名称:OLLAMA_MODELS,值:C:\JZDSLx\ollama_models,修改值为:D:\AIModels\ollama_models。

*在Windows系统中,Ollama默认将模型存储在C:\Users\<用户名>\.ollama\models目录下。

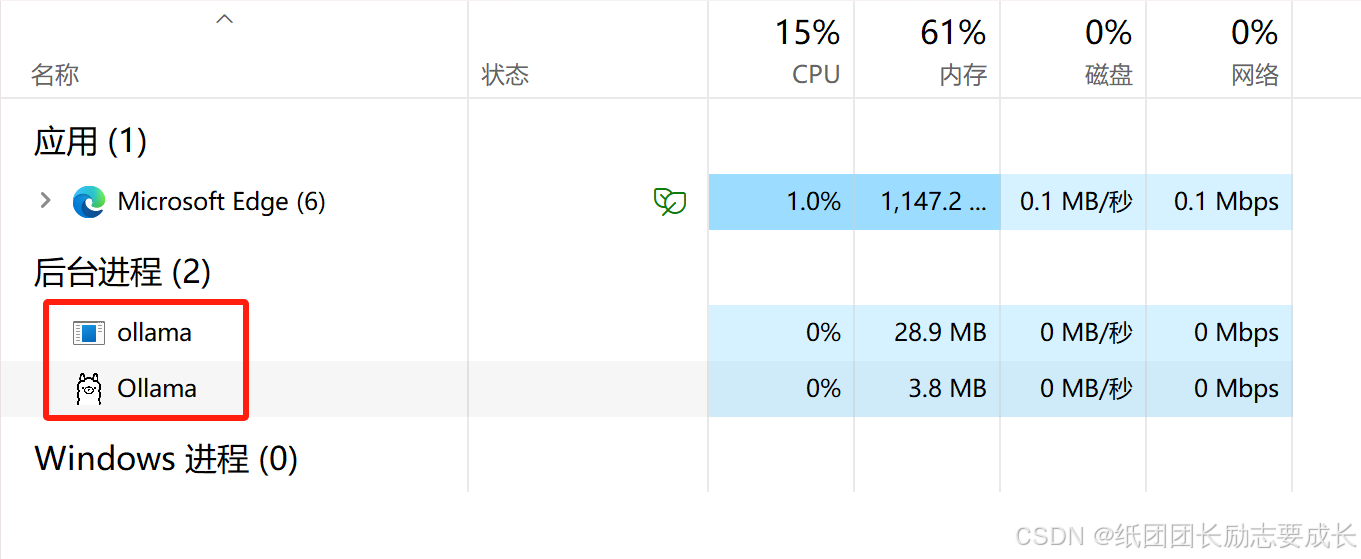

重启ollama服务:命令重启或终止进程:

1)终止服务:

注意,先结束Ollama app.exe,再结束Ollama.exe。

2)启动服务:

(1)双击程序启动图标

- 点击屏幕左下角的 Windows图标(或按键盘上的 Win 键)

- 在搜索栏输入 “PowerShell”

(2)命令启动

- ollama serve

- ollama serve --host 0.0.0.0 --port 11434

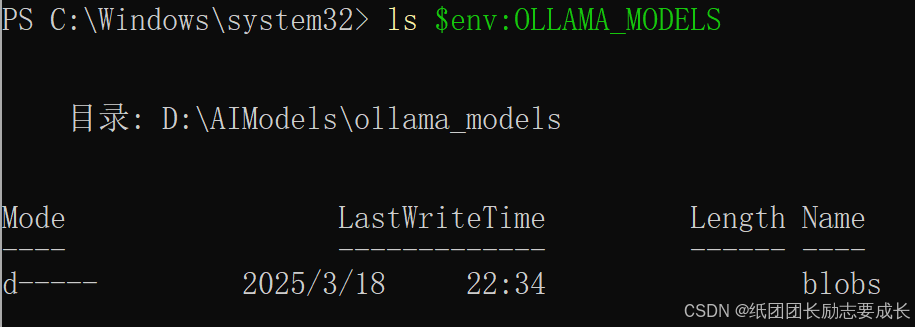

3.输入命令,检查存储路径修改是否成功: ls $env:OLLAMA_MODELS

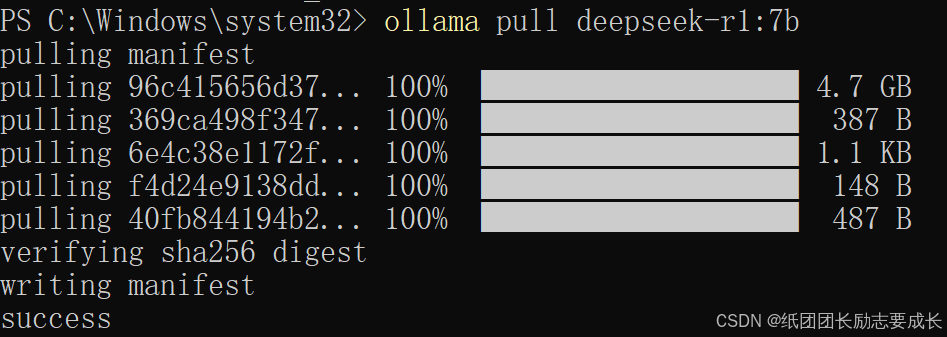

4.拉取模型:输入ollama pull 【模型名称,如llama3】 ,我这里下载deepseek14b和7b:

*Ollama官方维护的模型库,是权威的版本查询途径,实时更新支持的模型及版本信息:https://ollama.com/library/deepseek-r1。

ollama pull deepseek-r1:7b、ollama pull deepseek-r1:14b

![]()

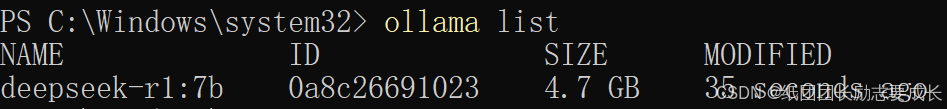

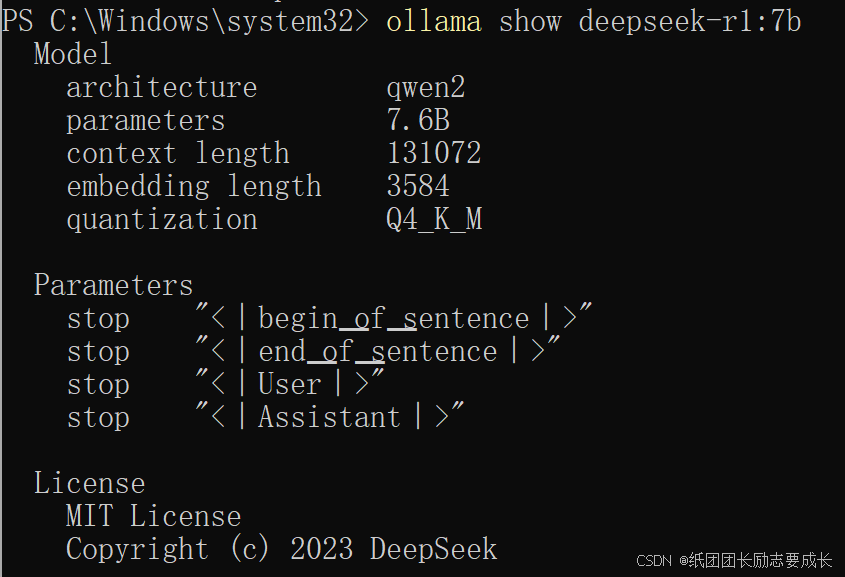

5.检查模型安装:

- 查看本地已安装的模型列表: ollama list

- 查看指定模型的详细信息(含版本标识) :ollama show <model_name>

6.启动模型:ollama run <model_name>

注意:服务默认运行在 http://localhost:11434

![]()

7.验证服务:打开浏览器或 PowerShell,发送测试请求,若返回 JSON 响应(含生成文本),则服务正常。

# 使用 curl 测试

curl http://localhost:11434/api/generate -d '{

"model": "deepseek-r1-distill-qwen-14b:4bit-gguf",

"prompt": "你好",

"stream": false

}'

其他常用命令:

# 查看11434端口是否被Ollama占用 :Get-NetTCPConnection -LocalPort 11434 | Where-Object{ $_.OwningProcess -eq (Get-Process ollama).Id }

# 检查D盘是否生成文件 dir D:\ollama_models

# 查看D盘存储占用 Get-Volume -DriveLetter D | Select-Object SizeRemaining

# 列出所有模型 ollama list

# 删除指定模型 ollama rm deepseek-7b

# 压缩备份模型目录 Compress-Archive -Path D:\ollama_models -DestinationPath D:\backup\ollama_models_$(Get-Date -Format yyyyMMdd).zip

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)