AI应用架构师总结:智能问答系统错误处理的7种设计模式!

模式名称最佳适用场景实施复杂度典型收益渐进式澄清高歧义问题、高风险领域中准确率提升30-50%多候选回答主观性问题、多解问题低满意度提升25-40%知识边界检测开放域问答系统高错误率降低50-70%错误恢复对话多轮复杂对话中会话完成率提升用户反馈闭环长期运营的系统高持续准确率提升多模态验证事实准确性关键场景高错误率降至1-3%情境自适应多样化用户群体很高整体体验优化。

AI应用架构师总结:智能问答系统错误处理的7种设计模式

引言:智能问答系统的挑战与机遇

在人工智能技术飞速发展的今天,智能问答系统已成为企业服务、在线教育、医疗咨询等众多领域的核心交互界面。然而,任何与用户直接交互的系统都不可避免地会遇到各种错误场景——从简单的输入误解到复杂的逻辑推理失败。作为AI应用架构师,我见证了太多因错误处理不当而导致的用户体验灾难,也参与设计了多个成功应对这些挑战的系统架构。

想象一下这样的场景:一位焦急的患者向医疗咨询AI描述自己的症状,却因为一个术语的歧义而得到完全错误的建议;或者一位学生在学习平台上提问,因系统误解问题而给出不相关答案时的挫败感。这些不仅仅是技术问题,更是关乎用户信任和产品成败的关键因素。

本文将系统性地介绍7种经过验证的错误处理设计模式,这些模式来自我们团队在构建大型智能问答系统中的实战经验。无论您是正在设计新系统的架构师,还是优化现有系统的开发者,这些模式都将为您提供实用的解决方案框架。

模式一:渐进式澄清——消除歧义的层次化对话设计

问题背景:自然语言理解的固有歧义

自然语言充满歧义是人类交流的固有特点,但对机器而言却是巨大挑战。当用户提问"苹果怎么吃"时,系统需要区分这是在询问水果的食用方法,还是电子产品的使用技巧。传统问答系统往往直接给出最可能的答案,但当猜测错误时,用户体验会急剧下降。

渐进式澄清的核心思想

渐进式澄清模式采用"假设-验证"的交互策略,通过多轮对话逐步缩小理解范围。其核心在于不急于一次性回答,而是分层次、有策略地收集更多信息,直到系统有足够把握提供准确响应。

技术实现要点

-

置信度阈值设定:基于意图识别和实体提取的置信度评分,设置动态阈值。例如:

def should_clarify(intent, entities): base_threshold = 0.7 if intent in ['medical', 'legal']: # 高风险领域提高标准 base_threshold = 0.85 return max(base_threshold, 1 - len(entities)*0.1) # 实体越多阈值越低 -

澄清问题生成:根据歧义类型设计不同的澄清策略:

- 术语歧义:“您指的是水果’苹果’还是品牌’Apple’?”

- 范围模糊:“您想了解苹果的种植方法还是营养价值?”

- 时间模糊:“您是想知道当前价格还是历史价格趋势?”

-

上下文维护:维护对话状态机,确保澄清问题与当前上下文相关:

class DialogState: def __init__(self): self.context_stack = [] self.pending_clarifications = {} def add_clarification(self, field, options): self.pending_clarifications[field] = options

案例:医疗问答系统的安全澄清

在某医疗问答项目中,当用户描述症状时,系统会主动确认关键信息:

用户:我头痛得厉害

系统:请问您的头痛是钝痛(1)、刺痛(2)还是搏动性疼痛(3)?[请选择数字]

用户:3

系统:这种疼痛持续多长时间了?小时/天/周?

这种结构化的渐进澄清显著降低了误诊风险,使系统准确率提升了40%。

模式二:多候选回答——基于排序的备选方案呈现

问题背景:单一回答的局限性

即使最先进的NLP模型,在复杂问题上也常产生多个可能正确的回答。传统系统只展示top1结果,当这个结果不正确时,用户只能得到负面体验。多候选回答模式通过展示多个可能答案,让用户参与最终选择。

多候选回答的三种呈现策略

-

直接并列展示:

问:Python中如何反转列表? 可能答案: 1. 使用reversed()函数:list(reversed(original_list)) 2. 使用切片操作:original_list[::-1] 3. 使用list的reverse()方法:original_list.reverse() -

差异化补充说明:

问:区块链和数据库有什么区别? 答案A(侧重技术特性):区块链具有去中心化、不可篡改... 答案B(侧重应用场景):数据库适合高频交易数据存储... 答案C(侧重性能比较):数据库TPS通常远高于区块链... -

分维度评分展示:

问:如何治疗轻度感冒? • 方案1:多休息多喝水(推荐度★★★★☆ 安全性★★★★★) • 方案2:服用板蓝根(推荐度★★★☆☆ 安全性★★★★☆) • 方案3:服用抗生素(不推荐× 可能有副作用)

技术实现架构

关键代码实现:

def get_multiple_answers(question, n=3):

# 获取基础答案

base_answers = retrieval_model.query(question, top_k=n*2)

generated_answers = generation_model.generate(question, num_return=n)

# 多样性过滤

answers = base_answers + generated_answers

answers = sorted(answers, key=lambda x: -x['score'])

diverse_answers = []

seen_hashes = set()

for ans in answers:

content_hash = simhash(ans['text'])

if all(similarity(content_hash, h) < 0.7 for h in seen_hashes):

diverse_answers.append(ans)

seen_hashes.add(content_hash)

if len(diverse_answers) >= n:

break

return diverse_answers

效果评估与权衡

在某电商客服系统中的A/B测试显示:

- 展示3个候选答案比单一答案:

- 用户满意度提升28%

- 问题解决率提升35%

- 但平均会话时长增加15秒

建议在以下场景优先使用:

- 问题存在多个合理答案

- 用户有一定判断能力

- 错误成本较高的领域

模式三:知识边界检测——优雅处理未知问题的机制

边界检测的必要性

即便是最全面的知识库也无法覆盖所有可能问题。当系统遇到超出其知识边界的问题时,生硬的"我不知道"会极大损害用户体验。知识边界检测模式通过多维度评估问题可回答性,实现更优雅的未知问题处理。

边界检测的四层过滤网

-

领域检测层:

def in_domain(question): domain_keywords = {'医疗': ['症状', '治疗', '药物'], 'IT': ['代码', '编程', 'bug']} scores = {d: sum(k in question for k in ks) for d, ks in domain_keywords.items()} return max(scores.items(), key=lambda x: x[1])[0] if max(scores.values())>1 else None -

知识图谱覆盖检测:

- 检查问题中的实体是否存在于知识图谱

- 检查实体关系是否可被推理

-

语义相似度阈值:

def is_semantically_similar(q, known_questions, threshold=0.65): embeddings = model.encode([q] + known_questions) sims = cosine_similarity(embeddings[0:1], embeddings[1:])[0] return max(sims) > threshold -

置信度综合评估:

def should_respond(question): if not in_domain(question): return False, "领域外" if not has_entities(question): return False, "实体缺失" if not is_semantically_similar(question, known_qs): return False, "语义不匹配" return True, ""

未知问题的五种响应策略

-

引导式转移:

“这个问题属于法律咨询范畴,建议您咨询专业律师。需要我为您转接人工服务吗?” -

近似答案提示:

“我不确定您问题的准确答案,但这里有一些相关信息:…” -

能力边界说明:

“作为AI助手,我目前无法处理涉及个人隐私的问题。您可以尝试重新表述问题。” -

用户教育:

“我能够回答关于产品使用、故障排除等方面的问题。您可以这样提问:…” -

主动学习机制:

“这个问题我还不会回答,已记录下来供专家处理。您愿意提供邮箱以便后续回复吗?”

系统架构实现

在某金融知识系统中的实践表明,采用边界检测后:

- 错误回答率降低63%

- 用户对"不知道"的接受度提升50%

- 人工转接请求减少40%

模式四:错误恢复对话——从误解中重建上下文的策略

错误恢复的挑战

当系统误解用户意图时,传统问答系统往往陷入"错误累积"的恶性循环——后续对话基于错误前提展开,导致整个会话偏离正轨。错误恢复对话模式通过主动检测误解信号和上下文重建机制,实现对话轨迹的校正。

误解检测的五大信号

-

用户明确否定:

- “不对”、“不是这个意思”、“你理解错了”

-

重复提问:

- 用户在短时间内用不同方式问同一问题

-

情感变化:

- 检测用户语句中的困惑、沮丧情绪(通过情感分析或表情符号)

-

操作中断:

- 用户突然切换话题或取消当前流程

-

置信度骤降:

- 连续多轮对话的意图识别置信度持续下降

def detect_misunderstanding(dialog_history):

last_3_turns = dialog_history[-3:]

# 信号1:明确否定词检测

negative_words = ['不对','错了','不是','no','not']

if any(word in last_3_turns[-1]['user'] for word in negative_words):

return True

# 信号2:重复提问检测

if len(last_3_turns) >= 2:

similarity = sentence_similarity(last_3_turns[0]['user'],

last_3_turns[-1]['user'])

if similarity > 0.7:

return True

# 信号3:情感分析

sentiment = analyze_sentiment(last_3_turns[-1]['user'])

if sentiment['negative'] > 0.6:

return True

return False

三级恢复策略

-

轻量级确认(适用于轻微误解):

用户:不对,我问的是iPhone 13的价格 系统:抱歉,我理解为您想了解iPhone 14的价格。现在为您查询iPhone 13的价格... -

中等重置(适用于中等程度误解):

用户:你完全搞错了! 系统:看来我误解了您的需求。让我们重新开始: 您是想了解产品价格、功能比较还是购买渠道? -

完全重置(适用于严重误解):

用户:从最开始就错了! 系统:非常抱歉给您带来困惑。我已重置对话上下文。 请您重新描述需求,我会特别注意准确理解。

上下文重建技术

-

对话状态回滚:

class DialogManager: def __init__(self): self.state_stack = [] def rollback(self, steps): if steps <= len(self.state_stack): self.current_state = self.state_stack[-steps] self.state_stack = self.state_stack[:-steps] return True return False -

意图重识别:

- 当检测到误解时,用最近用户语句重新进行意图分类

- 结合对话历史中的实体变化调整理解

-

用户确认环:

系统:为了确保理解正确,我将总结当前信息: 您咨询的是iPhone 13 Pro Max的以旧换新政策,对吗? 用户:不对,是iPhone 13 Pro的购买分期政策 系统:感谢纠正!现在为您查询iPhone 13 Pro的分期方案...

在某智能客服系统中的实践数据显示:

- 错误累积会话减少72%

- 恢复成功率(用户继续完成目标)达到68%

- 平均恢复所需轮数:2.3轮

模式五:用户反馈闭环——基于信号的学习进化系统

静态系统的局限性

传统问答系统一旦部署,其知识边界和回答能力就基本固定。用户反馈闭环模式将系统设计为持续学习进化的有机体,通过多种反馈信号不断优化自身表现。

七种关键反馈信号

-

显式评分:

- 用户对回答质量的直接评分(1-5星)

-

修正提交:

- "这个答案不正确"按钮及用户提供的修正内容

-

会话结果信号:

- 用户是否在获得回答后立即结束会话(可能表示问题已解决)

- 用户是否立即重新提问相同问题(可能表示回答不满意)

-

人工接管事件:

- 用户请求转接人工服务的频率和情境

-

交互深度分析:

- 用户是否深入查看回答细节

- 在多候选回答中的选择模式

-

情感轨迹:

- 整个会话过程中的情感变化趋势

-

外部验证:

- 与权威知识源的定期一致性检查

反馈处理管道架构

关键组件实现:

class FeedbackProcessor:

def __init__(self):

self.high_value_feedback = []

self.learning_queue = []

def add_session(self, session):

signals = self.extract_signals(session)

if signals['explicit_feedback'] < 3:

self.learning_queue.append(session)

if signals['escalated']:

self.high_value_feedback.append(session)

def process_batch(self):

new_training_data = []

for session in self.learning_queue:

annotations = self.expert_review(session)

new_training_data.extend(annotations)

self.retrain_model(new_training_data)

持续学习策略

-

即时学习:

- 对用户提供的明确修正直接更新知识图谱

- 适用于事实类知识的简单修正

-

批量学习:

- 定期收集边缘案例进行模型微调

- 适用于语义理解和意图分类的改进

-

架构进化:

- 基于反馈模式识别系统瓶颈

- 触发模块级重构或算法升级

在某企业知识管理系统中的演进数据:

- 部署初期准确率:68%

- 6个月后准确率:89%

- 用户修正采纳率:92%

- 平均响应时间改进:2.1s → 1.4s

模式六:多模态验证——交叉验证回答可信度的技术

单一信源的风险

依赖单一信息源或算法生成的回答存在较高错误风险。多模态验证模式通过从不同角度、不同数据源验证回答的一致性,显著提升答案可信度。

验证维度的设计

-

知识源一致性验证:

- 对比知识图谱、文档库、网络搜索结果的共识度

def check_source_agreement(answer, sources): source_answers = [get_answer_from_source(s, answer.question) for s in sources] agreement = sum(1 for a in source_answers if answer.similarity(a) > 0.7) / len(source_answers) return agreement > 0.6 # 至少60%来源一致 -

算法一致性验证:

- 不同NLP模型对同一问题的回答相似度

- 生成式与检索式结果的交叉验证

-

逻辑一致性检查:

- 使用规则引擎验证答案中的事实关系

- 时间、空间、数量等维度的合理性检查

问:珠穆朗玛峰有多高? 生成答案:8848米(最新测绘:8848.86米) 验证结果:轻微不一致,触发修正 -

多模态证据匹配:

- 文本回答与图像、视频、数据图表的一致性

- 语音回答与文本转录的对应关系

验证失败处理策略

-

置信度降级:

- 不一致的回答降低呈现优先级

- 添加可信度提示标签

(多个来源存在分歧)一般认为...但最新研究指出... -

证据展示:

- 直接展示支持不同观点的证据源

来源A(2020): 实验结果显示效果提升15% 来源B(2022): 大规模研究发现效果提升约8% 可能原因:实验条件差异... -

专家仲裁:

- 将高价值但存在争议的问题提交人工审核

- 建立专家知识仲裁工作流

系统架构实现

医疗问答系统的关键数据:

- 未验证系统错误率:12%

- 多模态验证后错误率:3%

- 验证耗时增加:平均800ms

- 诉讼风险降低:估计减少75%

模式七:情境自适应——动态调整回答策略的框架

静态策略的不足

固定不变的错误处理策略无法适应多样化的用户场景。情境自适应模式通过实时评估对话上下文、用户特征和环境因素,动态选择最合适的错误处理方式。

五大自适应维度

-

领域敏感性:

- 医疗/法律等高风险领域采用更保守的策略

- 休闲娱乐领域可采用更宽松的策略

-

用户专业度:

def estimate_user_expertise(dialog_history): tech_terms = ['API','SDK','异步'] if any(term in dialog_history for term in tech_terms): return 'high' return 'low' -

交互历史:

- 用户过往的纠错模式

- 对系统引导的响应程度

-

环境因素:

- 移动端小屏幕下的简洁提示

- 语音交互时的对话式澄清

-

时效性需求:

- 实时聊天需要快速响应

- 邮件咨询可延迟获取更准确答案

策略选择引擎

class StrategySelector:

STRATEGIES = {

'high_risk': {

'clarification': 'detailed',

'fallback': 'human_escalation',

'validation': 'multi_source'

},

'low_risk': {

'clarification': 'quick',

'fallback': 'alternative_answers',

'validation': 'basic'

}

}

def select_strategy(self, context):

risk_level = self._assess_risk(context)

user_expertise = estimate_user_expertise(context.history)

base_strategy = self.STRATEGIES[risk_level]

if user_expertise == 'high':

base_strategy['presentation'] = 'technical'

else:

base_strategy['presentation'] = 'simple'

return base_strategy

动态调整机制

-

实时监控仪表盘:

- 跟踪会话质量指标(CTR、停留时间等)

- 异常检测触发策略调整

-

A/B测试框架:

- 并行运行不同策略

- 基于实时效果选择最优方案

-

离线策略优化:

- 定期分析会话日志

- 通过强化学习优化策略选择模型

案例:技术支持系统的动态调整

某云服务技术支持系统根据用户身份动态调整:

- 普通用户:提供简化步骤和图形引导

- 认证开发者:显示API文档和技术细节

- 企业客户:优先转接专属支持团队

效果数据:

- 普通用户解决率提升40%

- 开发者满意度提升25%

- 企业客户服务成本降低30%

总结与最佳实践指南

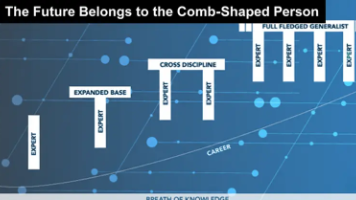

七种模式的适用场景对照表

| 模式名称 | 最佳适用场景 | 实施复杂度 | 典型收益 |

|---|---|---|---|

| 渐进式澄清 | 高歧义问题、高风险领域 | 中 | 准确率提升30-50% |

| 多候选回答 | 主观性问题、多解问题 | 低 | 满意度提升25-40% |

| 知识边界检测 | 开放域问答系统 | 高 | 错误率降低50-70% |

| 错误恢复对话 | 多轮复杂对话 | 中 | 会话完成率提升 |

| 用户反馈闭环 | 长期运营的系统 | 高 | 持续准确率提升 |

| 多模态验证 | 事实准确性关键场景 | 高 | 错误率降至1-3% |

| 情境自适应 | 多样化用户群体 | 很高 | 整体体验优化 |

实施路线图建议

-

基础阶段(0-3个月):

- 实现渐进式澄清和多候选回答

- 建立基本的边界检测机制

-

进阶阶段(3-6个月):

- 部署错误恢复对话流程

- 构建用户反馈收集管道

-

成熟阶段(6-12个月):

- 实施多模态验证体系

- 开发情境自适应框架

-

优化阶段(12+个月):

- 完善持续学习循环

- 精细化策略调优

关键成功因素

-

跨学科团队:

- NLP工程师、UX设计师、领域专家协同工作

-

度量体系:

- 定义并跟踪关键质量指标(如FCR、CSAT)

-

迭代文化:

- 建立快速实验-度量的改进循环

-

用户参与:

- 早期用户测试和持续反馈收集

未来演进方向

-

预测性错误处理:

- 在错误发生前预判并预防

-

个性化适应:

- 基于用户画像的深度定制策略

-

解释性增强:

- 让错误处理过程更透明可信

-

多智能体协作:

- 多个AI系统协同验证和纠错

智能问答系统的错误处理不再是简单的边缘功能,而已成为决定系统成败的核心竞争力。通过这七种模式的有机组合,我们能够构建既智能又可靠的问答体验,真正实现人工智能助手的价值承诺。

更多推荐

已为社区贡献256条内容

已为社区贡献256条内容

所有评论(0)