文档即木马:AI 助手技能平台遭供应链投毒

OpenClaw 事件不是终点,而是起点。当能力被包装成『即插即用』的文档时,注册表就成了应用商店,而应用商店必然会被攻陷。真正的解决方案不是堵死 AI 代理,而是承认我们缺失了一层「信任基建」。来源可验证:技能包必须绑定开发者身份权限最小化:默认禁止 Shell 执行,沙箱隔离敏感资源行为可审计:每次工具调用都记录在案,可追溯别把 AI 代理装在有重要数据的设备上。正如安全博客的警告——「如果你

一个看似普通的「技能集市」,正在成为针对开发者的数字武器库。最近,AI 助手开发平台 ClawHub 上最热门的技能包,被发现是一条伪装成文档的完整恶意软件供应链——从诱导点击到最终执行,整个过程被包装成「安装前置条件」,而用户甚至不会多看一眼。

这就是 AI 代理时代的新型攻击面:当帮助文档本身变成了可执行代码。

文档即安装程序

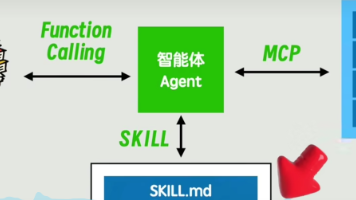

OpenClaw 这类桌面 AI 代理的核心价值,是打破软件间的隔阂。它能读取你的本地文件、控制浏览器、访问终端、记住你的开发习惯。这些能力让它能真正帮你「做事」——自动查资料、改代码、发推文。但问题恰恰出在这里:这些「技能」本质上是一堆 Markdown 文件,里面写着「先运行这个命令」、「再安装那个依赖」。

安全研究者发现,攻击者利用了最朴素的信任链条。一个名为「Twitter 工具」的技能包,在页面顶部写着:「需要先装 openclaw-core,Windows 用户点 这里,macOS 用户复制 这个链接 的命令运行」。两个链接都指向恶意服务器,点击后会执行一串经过 Base64 混淆的 Shell 指令,最终下载的是一个 macOS 信息窃取木马(VirusTotal 检测报告)。

这个木马的恐怖之处在于它不破坏系统,而是精确掠夺——浏览器 Cookie、保存的密码、SSH 密钥、云服务的 API 令牌。换句话说,它专偷开发者的数字资产。

当安全协议撞上「用户习惯」

有人辩解说,行业正在推广 Model Context Protocol(MCP),它能限制工具调用、要求用户授权。但问题在于:恶意技能根本不走 MCP。它直接调用系统命令,就像你手动在终端里输入一样。MCP 的门再坚固,也防不住别人走后院翻墙。

更扎心的是,攻击者利用了开发者最顽固的两个习惯:

- 「热门=靠谱」 :这个技能包是下载量第一,用户默认它经过「社区验证」

- 「设置向导=安全」 :人们对「安装前必读」的警惕性几乎为零

攻击者甚至贴心地为 macOS 用户考虑:自动移除苹果 Gatekeeper 隔离属性,避免触发系统扫描。这不是偶发事件,而是成体系、有策略的供应链投毒。据 Cyberinsider 报道,已有超过 300 个 ClawHub 技能卷入类似攻击,手法完全相同。

AI 写 AI 危机,让信任雪上加霜

这件事的讽刺之处在于,1Password 的安全博客文章本身是用 AI 写的。作者在评论区承认,「主要是为了快速披露风险,并删除危险链接」。结果一石激起千层浪——Hacker News 上最激烈的讨论不是关于恶意软件,而是为什么 AI 文章读起来让人本能地不信任。

读者逐句拆解,发现文中充斥着「这不是 X,这是 Y」的固定句式:

「Markdown 不是内容,它是安装器」

「这不是孤立事件,这是一场战役」

「答案不是停止构建,答案是构建信任层」

这些排比句在 LinkedIn 上常见,但出现在技术分析中,让读者产生「有人在用模板敷衍我」的生理反感。正如一位评论者所说:「如果我看到作者的真心话被 AI 稀释,我凭什么相信他说的『恶意软件』不是幻觉?」

这场争论暴露了一个深层焦虑:当 AI 既能写攻击代码,又能写安全警告时,普通人如何分辨谁在说实话?

权限悖论:能干的代理就是不安全的代理

讨论中最扎心的共识是——OpenClaw 的安全问题不是 Bug,而是根本设计矛盾。

整个平台的价值建立在「代理需要上帝权限」之上。你希望它能替你发邮件、改代码、管服务器,它就得能访问你的浏览器、文件系统、密钥链。但一个能自动执行终端命令的工具,本质上就是把 curl | sudo bash 变成了永久性的后台服务。

有人打了个比方:传统软件是「一次性的火」,危险但可控;AI 代理是「永远在燃烧的篝火」,你随手往里扔指令,却不知道会烧到哪里。

操作系统层面的隔离机制在此失灵。macOS 会弹窗问「是否允许访问文档文件夹」,但用户训练有素地点「允许」。企业 IT 最害怕的场景出现了:员工在公司设备上装 OpenClaw,等于把生产环境的钥匙交给了一个会听任何人指令的机器人。

社区反应:从嘲讽到自救

Hacker News 上的反应呈现两极分化:

嘲讽派认为这完全是「vibe coding」文化的咎由自取——「先开枪再瞄准,安全是别人的问题」。有人吐槽说:「想参与这场疯狂,你得停止读书,只看 YouTube 短视频,把人际关系都搞砸。」

实干派则开始动手解决。网络安全研究员 Don Hopkins 发布了一个叫 skill-snitch 的开源工具,用静态分析+运行时监控的方式扫描技能包。它能检测「声明只用文件读写但实际调用了 Shell」的行为不一致。但作者自己也承认,这个扫描器面对供应链投毒无能为力——如果恶意代码藏在依赖包里,且依赖是「日后才变坏」的,grep 也救不了你。

另一位评论者催生了「Willison 定律」(以提示注入攻击发现者 Simon Willison 命名):「即使给 LLM 足够多的眼睛,提示注入还是提示注入。」意思是,别指望用 AI 检测 AI 生成的恶意代码,攻击者总能用新指令让 AI「忽略之前的判断」。

历史总是押韵

这场灾难让人想起 npm、PyPy 等开源包管理器的供应链攻击史。但 AI 技能包更危险:传统包起码还要伪装成代码,技能包直接伪装成『帮助文档』。用户对代码仓库有戒心,却对「安装教程」毫无防备。

也有人联想到加密币早期的黑暗森林——承诺革新,结果成了黑市和恶意软件的温床。但评论者指出关键区别:区块链至少需要用户主动转账,AI 代理会在你喝咖啡时自动把家里钥匙交给陌生人。

更深层的担忧是,我们正在用 AI 加速瓦解来之不易的技术素养。智能手机让普通人远离文件系统,AI 代理则可能让开发者也忘记「执行未知代码」的风险。一位亲历者感叹:「感觉像回到 Windows XP 时代,亲戚乱装工具栏把 IE 搞成圣诞树,只是这次没有截图可以发,因为整个系统都被偷走了。」

结语:在篝火旁建护栏

OpenClaw 事件不是终点,而是起点。它暴露了 AI 代理生态最脆弱的一环:当能力被包装成『即插即用』的文档时,注册表就成了应用商店,而应用商店必然会被攻陷。

真正的解决方案不是堵死 AI 代理,而是承认我们缺失了一层「信任基建」。就像 HTTPS 需要证书颁发机构,Docker 需要镜像签名,未来 AI 技能需要:

- 来源可验证:技能包必须绑定开发者身份

- 权限最小化:默认禁止 Shell 执行,沙箱隔离敏感资源

- 行为可审计:每次工具调用都记录在案,可追溯

在那之前,普通用户能做的只有一件事:别把 AI 代理装在有重要数据的设备上。正如安全博客的警告——「如果你已经在公司电脑上装了 OpenClaw,请立刻视为安全事件处理」。

这场攻防战的残酷在于,攻击者只需要找到 一个 松懈的用户,防御者却需要保护 所有人。当篝火燃起时,要么我们集体学习如何安全地围坐,要么等着有人被烧成灰。

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)