AIGC 在研发场景的真实价值:从提效到提质的落地路径

AIGC 研发要产生真实价值,必须从“个人提效”升级为“体系提质”:用指标定义价值,用工程化把 AI 嵌入关键关口,用治理把风险前置并闭环,最终提升交付可靠性与组织韧性。

B2B 软件研发的难点,从来不在写代码够不够快,而在需求波动、系统复杂度、合规安全与跨团队协同带来的系统性摩擦。AIGC 研发要产生真实价值,必须从“个人提效”升级为“体系提质”:用指标定义价值,用工程化把 AI 嵌入关键关口,用治理把风险前置并闭环,最终提升交付可靠性与组织韧性。

关键结论速览(便于复盘与对齐)

-

一句话定义真实价值:AIGC 研发的价值不是“代码更多”,而是吞吐提升 + 稳定性不降(最好双升)。

-

落地最短路径:场景优先 → 能力工程 → 流程嵌入 → 治理度量闭环(四步路径)。

-

最常见失败原因:只做“个人提效”,不做“质量门与指标口径”,导致缺陷更快流入生产。

-

最该前置的红线:数据权限、合规边界、安全门禁(DoD-AI)。

-

最可复制的抓手:场景筛选矩阵、DoD-AI 清单、指标仪表盘、试点复盘四问。

B2B 软件行业的典型管理挑战

在企业软件里,我经常提醒团队一句话:交付的敌人不是慢,而是不确定。 不确定来自四个方向的叠加:

-

需求的不确定:客户差异化、交付现场反馈、销售承诺与竞品压力,会把需求推向“边做边变”。

-

系统的复杂度:多产品线、多租户、权限模型、历史包袱并存,瓶颈往往在集成验证、环境一致性与发布链路,而不是“写代码的速度”。

-

质量与合规的硬约束:SLA、审计、数据边界、安全基线决定了“快”必须服务于“稳”。

-

组织协同的隐性成本:产品、研发、测试、运维、交付、支持之间的信息不对称,让等待和返工成为最昂贵的浪费。

当团队说“我们要上 AIGC 研发”时,我通常先问:你要解决的,是编码效率,还是交付系统的不确定性?因为在真实组织里,AI 更像“放大器”:流程健康、数据干净、责任清晰的团队,会被放大优势;反之,会被放大混乱与风险。

与其把 AIGC 当“工具升级”,不如把它当一次“研发体系升级”的机会:把经验资产化,把流程门禁前移,把度量闭环做扎实。这也是我看到一些研发管理平台在做的方向——强调“透明、负责、可控”,并把日志追踪与权限边界作为 AI 能力的前置条件。

先把“真实价值”说清楚:从个人提效到组织提质的价值链

1)定义与边界:什么是 AIGC 研发?

本文讨论的 AIGC 研发(也常被称为生成式AI/GenAI 在研发中的应用、AI 辅助开发)主要覆盖三类能力:

-

生成:代码/测试/文档/变更摘要/Runbook 草稿

-

理解:需求澄清、缺陷复现、日志归因、影响面分析

-

治理:风险提示、门禁检查、知识沉淀、审计可追溯

注意:AIGC 研发不是把“写代码”外包给 AI,而是把高频重复劳动与信息不对称用机器方式降低,让人更专注在关键决策上。

当 AIGC 能直接在研发协作系统里创建工作项、生成文档草稿、汇总项目数据洞察,并且做到输出可追踪、权限可控、需要人工复核时,它才更容易从“个人效率工具”变成“组织协作能力”。以 ONES AI 的 Copilot/Autopilot 思路为例,强调日志追踪、责任归属与权限控制,本质上就是在为规模化使用设边界。

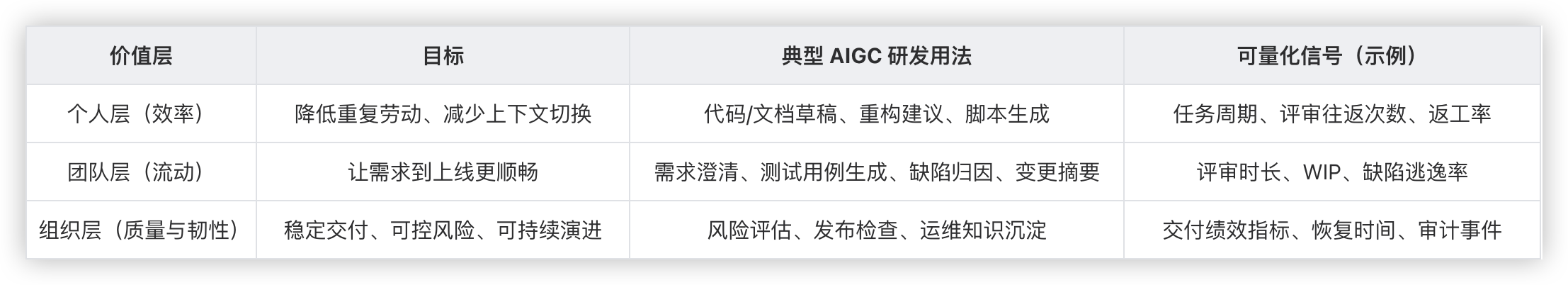

2)三层价值链:效率、流动、韧性(可直接对齐指标)

很多团队谈 AIGC 研发,第一反应是代码写得更快。但在企业级交付里,“更快写完”不等于“更快稳定交付”。我更建议用“三层价值链”统一口径:

判断真实价值的一句话:AIGC 研发要么让交付更快,要么让交付更稳;最好是“两者同时变好”,否则只是把风险前移或后移。

3)我通常会先问的“三个价值问题”

当团队说“我们要上 AI”时,我会要求先回答三问——答不上来,八成会走向“看起来很忙、结果不稳”。

-

它改善的是哪个关键决策?(是否接需求、是否合并、是否发布、是否回滚)

-

它减少的是哪类关键风险?(缺陷逃逸、权限误配、审计不可追溯、知识断层)

-

它避免的是哪种关键成本?(返工发布、线上事故、跨团队扯皮、支持疲劳)

方法论:VP 视角的「四步落地路径」

四步路径(可复用定义)

-

场景优先:先选 ROI 高且可度量的场景;

-

能力工程:把知识、模板、集成、评测做成底座;

-

流程嵌入:把 AI 放进 SDLC 关键关口,前移质量门;

-

治理度量闭环:用指标和红线保证规模化可控。

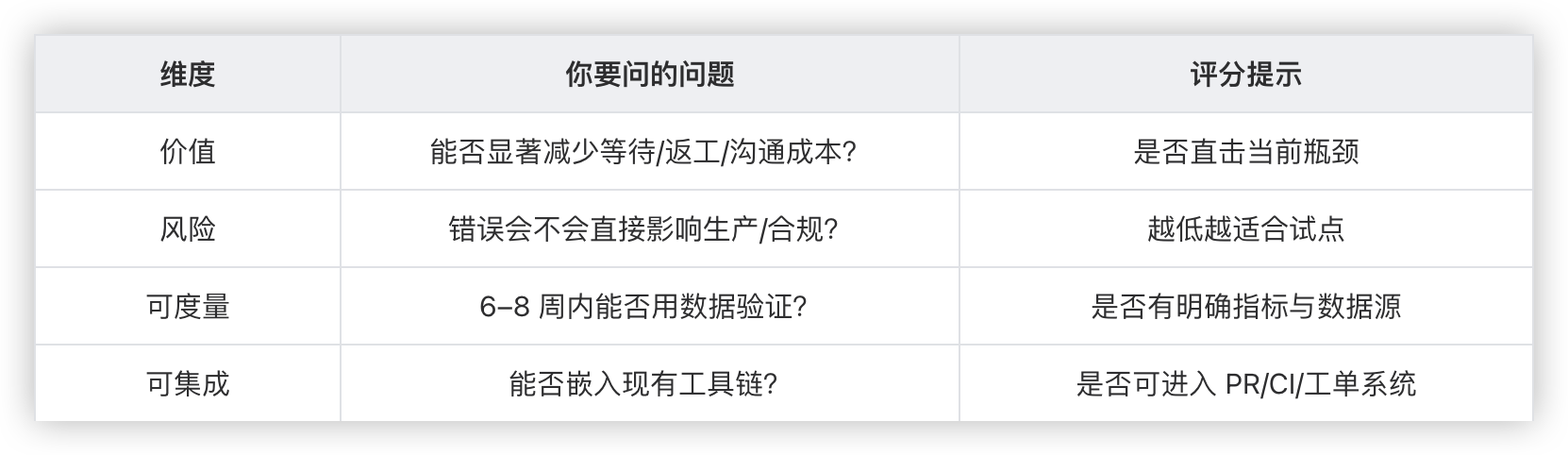

1)场景优先:用“价值×风险×可度量×可集成”筛选试点

场景筛选矩阵(模板):每项 1–5 分,建议优先选择总分高且风险可控的场景:

建议的“三高一低”优先序

-

高频:每天都发生(评审、测试、缺陷复现、工单处理)

-

高耗时:人力时间成本高(澄清、整理、查找、对齐)

-

高标准化:可模板化(Checklist、规范、契约、SOP)

-

低风险:不会因一次错误造成重大事故

2)能力工程:把“会用 AI”变成“可复制的工程能力”

把这句话翻译成研发落地,就是:你不能只教大家怎么用,而要把“用法”工程化成组织资产。 我把能力工程拆成四个可交付件(能落到 Backlog):

2.1 权威知识源(Context):让 AI“有据可依”

-

ADR(架构决策记录)、编码规范、API 契约、发布检查清单、故障 Runbook

-

要点:可检索、可追溯、可版本化

实践上,如果你的知识库与工作项系统是打通的,AI 才更容易基于“真实上下文”生成可靠草稿。比如 ONES MCP Server 的思路,就是让 AI Agent 能以个人身份授权、结构化地访问/写入 ONES 的项目与知识库数据,从而把“上下文”从聊天窗口搬回工作流。

2.2 Prompt/模板资产化(Prompt as Asset)

-

需求澄清模板、测试用例模板、PR Review 模板、复盘模板

-

版本化管理、可审计、可回滚

2.3 工具链集成(AI in the Flow):少一次切换,多一次闭环

AI 必须“出现在工作流里”,而不是“额外开一个窗口”。典型集成点:

-

PR/MR:变更摘要、影响面提示、Review 要点

-

CI:测试建议、失败归因提示、门禁总结

-

工单/缺陷:复现步骤结构化、相似缺陷聚类、处置建议草稿

这里有一个很务实的判断标准:AI 输出能否直接落到你的“记录系统”里(工作项、Wiki、工单),并留下可追踪的痕迹。ONES MCP Server 提供了面向项目管理与知识沉淀的一组工具,支持在 IDE/AI Agent 环境里直接完成“查询—生成—写入—关联”的闭环,这是把 AI 放进工作流的典型路径之一。

2.4 评测与校准(Evaluation)

-

对不同任务定义最低可接受标准:正确性、可读性、可维护性、安全基线

-

建立抽检与回归:模板更新前后对比、输出一致性检查

3)流程嵌入:把 AI 放到 SDLC 的“关键关口”

3.1 需求关口:从“写 PRD”到“写清验收”

-

AI 先产出:澄清问题清单、边界条件、验收标准草案

-

人做裁决:不清楚的需求不进入开发;有争议的边界必须落到验收标准

如果你的组织已经在用统一的需求/任务系统与知识库,那么“澄清—定稿—留痕”会更容易形成习惯。例如 ONES MCP Server 的产品经理场景中,AI 可以整合需求与知识库信息输出 PRD 初稿并保存到 Wiki,这类做法的价值在于“信息被结构化沉淀并可追溯”。

3.2 设计关口:从“拍脑袋”到“可追溯决策”

-

AI 辅助输出 ADR 草稿、备选方案对比、风险清单

-

评审通过后进入知识库并版本化:未来维护与审计才有抓手

3.3 变更关口:从“能合就合”到“变更有解释”

-

PR 自动生成:变更摘要、影响面、回滚建议、测试建议

-

评审从“逐行挑错”转向“审契约与风险”

3.4 发布关口:从“上线祈祷”到“可控发布”

-

发布前由 AI 汇总检查清单与风险提示

-

但上线决策永远由人承担:让 AI 参与流程,不让 AI 替你背责任

4)治理与度量:用一套仪表盘把“提效”升级为“提质”

研发治理要先保证“可度量、可追溯、可审计”,再谈规模化。

DoD-AI:AI 参与产出进入主干/生产前的最低门槛(清单)

-

✅ 关键逻辑必须有对应的自动化测试(单元/契约/回归之一)

-

✅ 静态扫描/依赖风险/许可证检查通过(按企业基线)

-

✅ 密钥/敏感信息泄漏检查通过

-

✅ 变更摘要与影响面说明齐备(便于评审与审计)

-

✅ 回滚方案与发布检查清单齐备

-

✅ 高风险模块必须人工评审 + 关键用例验证(不可完全自动化)

治理落地时,我建议把“透明、负责、可控”写进制度与系统行为,而不是停在宣导层。比如 ONES AI 在原则层面强调:输出可追踪、责任归属必须由人类复核、权限需遵循所有者设定——这些都是把 AI 规模化使用“工程化”的典型表述。

把 AIGC 研发变成“组织能力”,而不是一轮工具热潮

我对 AIGC 研发的判断很简单:它的价值不在于让团队写更多代码,而在于让组织更稳定、更可控、更持续地交付客户价值。

如果你是 CTO/VP/PMO,我建议抓住三件事:

-

用同一套指标定义成功:把“提效”与“提质”放在同一张仪表盘上,避免被局部效率误导。

-

用能力工程穿透流程:知识权威化、模板资产化、工具链集成、评测门槛化,让 AI 成为工作流的一部分。

-

用治理机制守住底线:数据与权限红线、DoD-AI 质量门、复盘闭环,把规模化建立在可控之上。

实践上,如果你的平台在 AI 能力设计上已强调“透明、负责、可控”,并支持日志追踪与权限控制,会更利于把治理要求落到系统行为里,而不只停留在口号。当这三件事做到位,AIGC 研发就会成为组织的工程韧性、战略执行力与数字化领导力的一部分——这才是企业软件真正值得追求的“长期复利”。

附:术语对照与检索意图映射

-

AIGC 研发:生成式AI在研发/GenAI in R&D/AI辅助开发/AI-assisted software development

-

提效:研发效率/开发者效率/工程生产力(Engineering Productivity)

-

提质:软件质量/交付可靠性/稳定性/缺陷逃逸率下降

-

持续交付:CI/CD/DevOps/发布治理/变更管理

-

治理:AI 风险治理/数据治理/安全门禁/审计可追溯

-

关键抓手:场景筛选矩阵、DoD-AI、指标口径与数据源表、试点复盘四问

-

工作流集成示例:MCP Server/AI Agent 与项目与知识库的结构化读写集成(以 ONES MCP 为例)

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)