Vibe Coding 使用指南

再比如让AI模型拉取Github代码,分支合并,提交Issue,发起PR,以前没有IDE的时候,需要用户手动git pull, merge,commit,push,IDE出现以后,用户只需手动点击commit,pull,branch即可完成命令操作,MCP的出现可以直接让AI模型操作这些命令,帮你完成这些工作。所以Context7 MCP就提供拉取官方文档的能力,将新的文档和用户Prompt一起输

GLM4.7 使用指南

GLM Coding Plan 使用指南

GLM4.7 Coding Plan计划

接入编程工具

Claude code

Claude Code是 Authropic开发终端原生工具,并没有与IDE(集成开发环境Cursor,VScode,Trae,JetBrains全家桶)结合,只能在终端中使用,不像是Cursor,Copilot有chatbot对话窗口

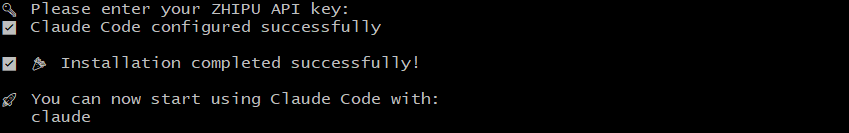

成功配置套餐后,默认为Claude Sonnet模型映射,即您界面上看到的是 Claude 模型但实际是 GLM 模型。

1.安装Claude Code

前提条件:需要安装Node.js 18或更新版本;2.Windows用户需要安装Git for Windows

使用命令行安装

npm install -g @anthropic-ai/claude-code

# 运行如下命令,查看安装结果,若显示版本号则表示安装成功

claude --version

2.配置GLM Coding Plan

2.1配置环境变量

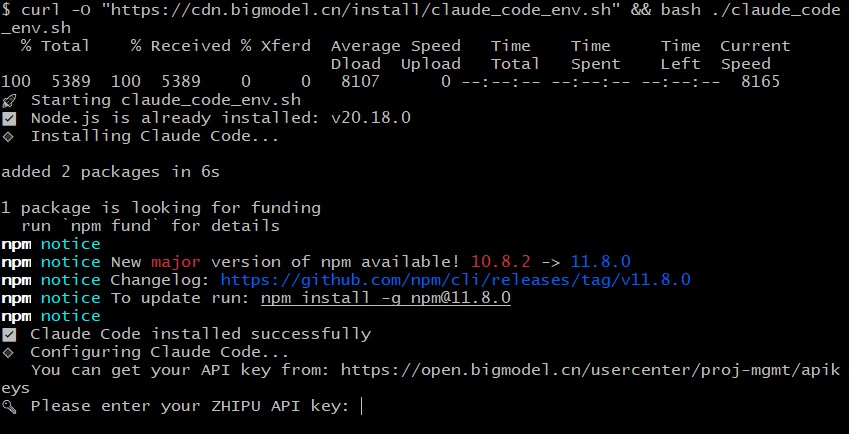

脚本自动配置

仅支持 MacOS Linux 环境,在终端或 IDE 中运行以下命令即可,⚠️注意此方式不支持 Windows CMD/PowerShell,Windows用户只能只用Git Bash终端运行以下命令

注意Git Bash 粘贴命令为 Shift+Insert

curl -O "https://cdn.bigmodel.cn/install/claude_code_env.sh" && bash ./claude_code_env.sh

安装脚本首先会检查Node.js是否安装,然后安装Claude Code,配置apiKeys

脚本会自动通过修改 ~/.claude/settings.json 来配置如下环境变量(您无需手动修改):

{

"env": {

"ANTHROPIC_AUTH_TOKEN": "your_zhipu_api_key",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1

}

}

脚本会自动在 Linux/Unix目录~/.claude.json Windows用户目录:C:\user\添加

{

"hasCompletedOnboarding": true

}

Shift+Insert 后API key并不会在终端中显示,实际上已经粘贴,Enter提示安装成功

之后在您的工程项目文件夹内运行Claude,尽情想用GLM4.7

Claude

2.2 手动配置

使用配置文件配置

支持 MacOS & Linux & Windows, 注意不同系统配置文件路径不一样。注意需保证修改的 JSON 文件格式正确性(比如多或少,)。

编辑或新增

settings.json文件MacOS & Linux 为

~/.claude/settings.jsonWindows 为

用户目录/.claude/settings.json新增或修改里面的 env 字段

注意替换里面的

your_zhipu_api_key为您上一步获取到的 API Key

"env": {

"ANTHROPIC_AUTH_TOKEN": "your_zhipu_api_key",

"ANTHROPIC_BASE_URL": "https://open.bigmodel.cn/api/anthropic",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1

}

}

# 再编辑或新增 `.claude.json` 文件

# MacOS & Linux 为 `~/.claude.json`

# Windows 为`用户目录/.claude.json`

# 新增 `hasCompletedOnboarding` 参数

{

"hasCompletedOnboarding": true

}

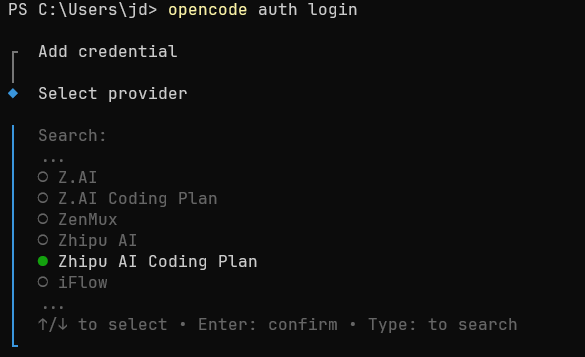

如何切换使用模型

Claude Code 内部模型环境变量与 GLM 模型对应关系,默认配置如下:

ANTHROPIC_DEFAULT_OPUS_MODEL:GLM-4.7ANTHROPIC_DEFAULT_SONNET_MODEL:GLM-4.7ANTHROPIC_DEFAULT_HAIKU_MODEL:GLM-4.5-Air

如有调整诉求,可直接通过调整配置文件的方式(位于 ~/.claude/settings.json)来调整到其他模型

一般不建议您手动调整模型映射,因为硬编码模型映射后,当 GLM Coding Plan 的模型更新升级时,不方便您自动更新到最新模型。

若您想使用最新默认映射(针对老用户已配置旧模型映射的情况),删除

settings.json中的模型映射配置即可,Claude Code 会自动使用最新的默认模型。

- 手动修改配置文件 Linux/Unix:

~/.claude/settings.jsonWindows:%UserProfile%/.claude/settings.json,添加或替换如下环境变量参数:

{

"env": {

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "glm-4.5-air",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "glm-4.7",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "glm-4.7"

}

}

- 启动一个新的命令行窗口,运行

claude启动 Claude Code,在 Claude Code 中输入/status确认模型状态:

3.Claude使用命令

介绍几个Claude常用命令

claude

# 在当前终端所在目录创建.claude目录,其中settings.local.json文件中Claude会配置允许执行命令

# 以下是在与Claude交互时,涉及到某些命令权限,Claude提示用户选择的选项,如果用户同意Claude会写进配置文件,下次直接执行,不在提醒用户是否确定执行。

{

"permissions": {

"allow": [

"Bash(mkdir:*)",

"Bash(dir:*)",

"Bash(cat:*)",

"Bash(mvn clean compile:*)",

"Bash(mvn spring-boot:run:*)",

"Bash(mvn compile:*)"

]

}

}

claude init

# 初始化项目,初始化一个新的CLAUDE.md文件(可以理解为Claude memory文件,Claude.md文件中可以配置Claude每次需要做的安排,比如编译测试前后端项目

claude -c

# 继续当前目录的上一次对话

claude --resume

# 恢复上一次对话历史

slash 命令

在Claude启动之后执行,上面命令式直接在终端中可以执行

/add-dir #添加一个新的工作目录

/init #使用代码库文档初始化一个新的CLAUDE.md文件,强烈建议使用

/clear #清除对话历史并释放上下文,重新开始

/resume #恢复一个对话 如果不指定任何内容 会打开还会话管理器,选择之前的历史对话

/resume [session-id or title] # 按 ID 或名称恢复对话

/compact #清除对话历史记录,但保留上下文中的摘要,会话过长时压缩

/exit #或者quite,退出REPL,退出Claude Code命令行模型

/export #将当前对话导出到文件或剪贴板

/mcp #管理MCP服务器

/memory #编辑Claude Code的记忆文件

/model #为Claude Code设置AI模型

/vim #在Vim模式和普通编辑模式之间切换

# 其他配置帮助信息

/config #打开配置面板,查看Claude Code的具体配置

/context #查看当前上下文使用情况,并以彩色网格的形式进行可视化

/cost #显示当前会话的总成本和持续时间

/doctor #诊断并验证您的Claude Code安装和设置

/help #显示帮助信息和可用命令

/status #显示Claude Code状态,包括版本、模型、账户、API连接和工具状态

# Github相关

/review #代码审查,智能分析审阅一个拉取请求

/pr-comments #从GitHub拉取请求中获取评论

/install-github-app #为存储库设置 Claude GitHub Actions

/security-review #对当前分支上待处理的更改进行安全审查

/agents #agent配置管理,可以创建智能体

/bashes #列出并管理后台Bash Shell脚本

/hooks #管理工具事件的钩子配置

# 不常用命令

/upgrade #升级至最高级别,官方Key可以尝试,非Claude模型不要进行升级,以获得更高的速率限制和更多Opus功能

/statusline #设置Claude Code的状态行用户界面

/output-style #直接设置输出样式或从选择菜单中设置

/output-style:new #创建自定义输出样式

4.FAQ

1.手工修改配置不生效

若您手动修改了 ~/.claude/settings.json 配置文件,但发现配置没有生效,参考如下排查。

- 关闭所有 Claude Code 窗口,重新打开一个新的命令行窗口,再次运行

claude启动。 - 如果问题仍然存在,您可以尝试删除

~/.claude/settings.json文件,然后重新配置环境变量,Claude Code 会自动生成一个新的配置文件。 - 确认配置文件的 JSON 格式是否正确,检查变量名称和不能少逗号或多逗号,可以使用在线 JSON 校验工具进行检查。

OpenCode

OpenCode 是为了解决Claude Code在众多限制区域无法使用的问题,同时在国内使用容易封号,尤其价格比较昂贵。所以OpenCode 横空出世,开源一周狂揽上万Star,截止2026年1月29日Starred数量已经超过91K。

OpenCode 是一款开源的 AI 编程助手,提供终端界面、桌面应用和 IDE 扩展。支持 75+AI 主流模型提供商:包括 Claude、OpenAI、Google 等国外模型,以及 GLM-4.7、MiniMax 2.1 等国产免费模型

1.安装OpenCode

由于国内无法访问Github,需要挂代理,切换opencode的安装地址,所以采用npm安装方式

没有npm的请提前安装nodejs

npm i -g opencode-ai

PS C:\Users\administrator> npm i -g opencode-ai

added 3 packages in 48s

npm notice

npm notice New major version of npm available! 10.8.1 -> 11.8.0

npm notice Changelog: https://github.com/npm/cli/releases/tag/v11.8.0

npm notice To update run: npm install -g npm@11.8.0

npm notice

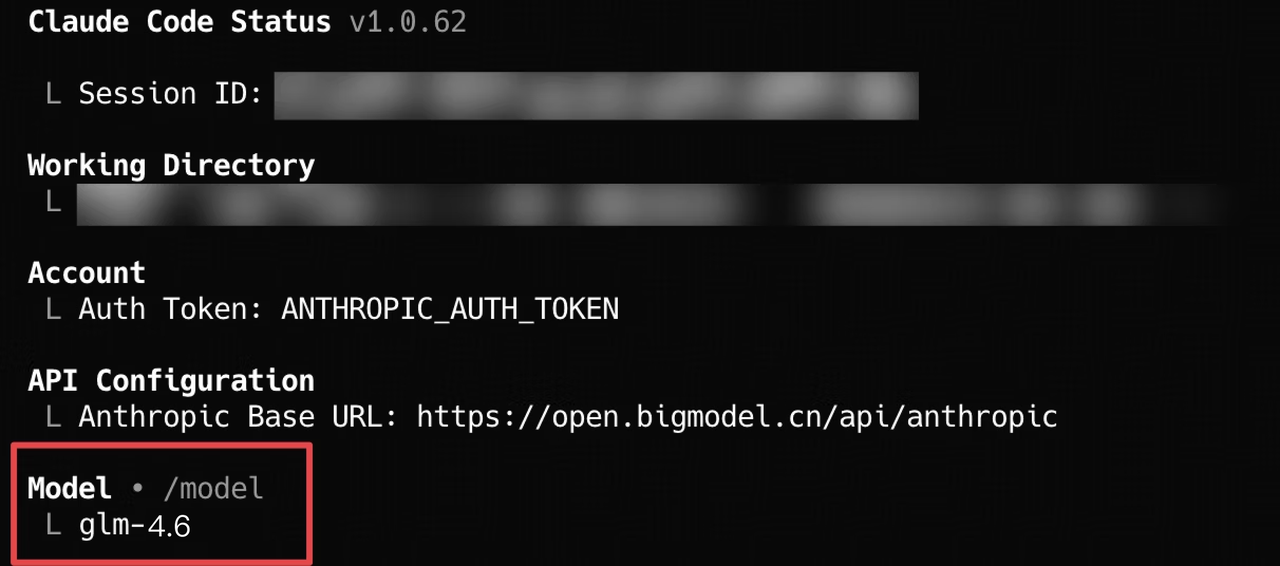

2.配置GLM model

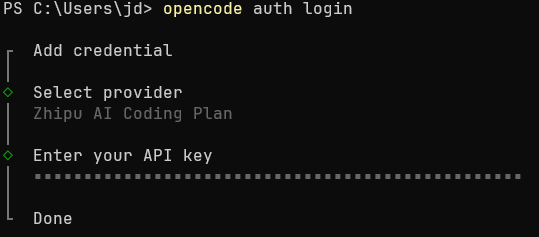

运行 opencode auth login 并选择 Zhipu AI Coding Plan

位置比较靠后,注意选择Zhipu AI Coding Plan,Zhipu AI 是之前2025年12月25日 GLM4.7 发布之前 GLM4.6 及以前版本的提供接口

3.粘贴GLM4.7 API key

4.运行opencode启动OpenCode

opencode

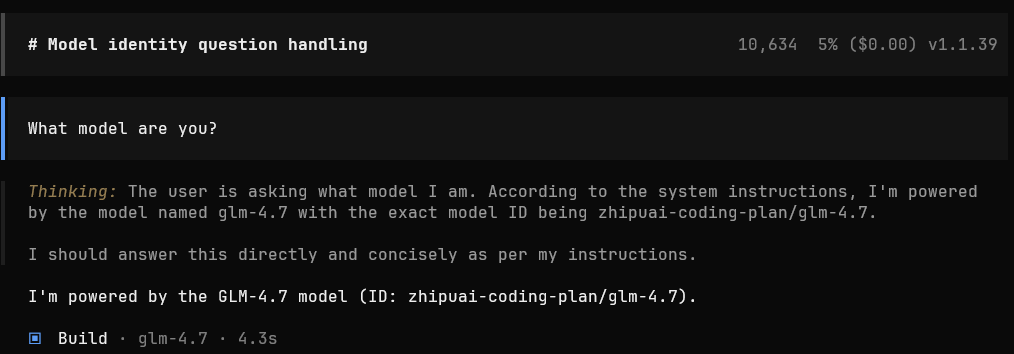

# What model are you?

# 输入提示词,验证opencode所使用的模型

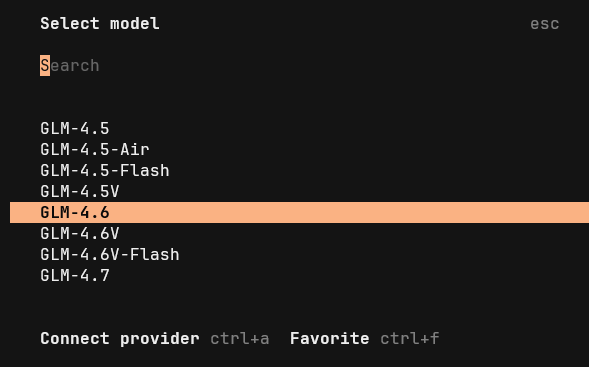

使用 /models 命令来选择模型,例如 GLM-4.7

/models

FAQ

如果之前OpenCode配置过 GLM 4.5,GLM 4.6模型,可能出现配置过GLM4.7 model之前用的还是GLM4.5的配置,此时

可以采取配置文件的方式配置GLM Coding Plan Api key

解决方法一:

配置目录:

MacOS/Linux:~/.config/opencode/opencode.jsonc

Windows: %UserProfile%\.config\opencode\opencode.jsonc

jsonc是一种可以在json字符串中添加注释的文件格式,以.json结尾的文件扩展标志符,文件内容不支持#注释

配置内容填写

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"ZhipiAI": {

"npm": "@ai-sdk/openai-compatible",

"name": "ZhipuAI",

"options": {

"baseURL": "https://open.bigmodel.cn/api/paas/v4/",

"apiKey": "your_zhipu_api_key"

},

"models": {

"zai-org/glm-4.7": {

"name": "GLM-4.7"

}

}

}

}

}

解决方法二:

配置模型提供商和API key

在 ~/.config/opencode/opencode.json 中配置:

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"zhipuai": {

"api": "https://open.bigmodel.cn/api/coding/paas/v4"

}

}

}

凭证存储在 ~/.local/share/opencode/auth.json Windows用户:C:\Users\%userprofile%\.local\share\opencode

{

"zhipuai-coding-plan": {

"type": "api",

"key": "your_zhipu_api_key"

}

}

Oh-my-opencode

Oh-my-opencode插件作者投入了约24000美金的Token成本进行架构打磨, 创造了一个 Agent 集群,其中分工十分明确:

Oh My OpenCode 包含 7 个专业子智能体,各自负责不同任务:

| 智能体名称 | 角色 | 核心职责 | 调用方式 |

|---|---|---|---|

| Sisyphus | 主协调器 | 负责整体任务规划、工作分派和结果整合 | 默认激活 |

| Oracle | 架构师 | 架构设计、代码审查、策略分析 | @oracle |

| Librarian | 研究员 | 文档检索、代码研究和实现示例 | @librarian |

| Explore | 探索者 | 快速代码库探索和模式匹配 | @explore |

| Frontend UI/UX Engineer | 前端工程师 | 前端开发与 UI/UX 设计 | 自动调用 |

| Document Writer | 文档撰写者 | 生成 README、API 文档及技术指南 | 自动调用 |

| Multimodal Looker | 多模态分析师 | PDF、图像及图表分析 | 自动调用 |

主 Agent 会按需指挥和调动它们,并且很多任务可以在后台并行跑。

还兼容了slash command、 Skill、MCP 等机制,自带精选过的 MCP,并支持完整的 LSP(Language Server Protocol)

安装方式

bunx oh-my-opencode install

# 如果 bunx 不工作,可以使用 npx

npx oh-my-opencode install

MCP使用

MCP全称模型上下文协议(Model Context Protocol)用于向提供AI模型连接各种数据源和工具

比如让模型调用数据库DML语句,创建数据库,执行CRUD命令;让模型能够调用浏览器搜索网页实时文章,分析网页HTML代码,CSS样式等;

再比如让AI模型拉取Github代码,分支合并,提交Issue,发起PR,以前没有IDE的时候,需要用户手动git pull, merge,commit,push,IDE出现以后,用户只需手动点击commit,pull,branch即可完成命令操作,MCP的出现可以直接让AI模型操作这些命令,帮你完成这些工作。除了经常使用的github,还有其他使用场景,比如前端的一些的样例代码,API使用,模型的训练数据并没有包含这些内容,虽然模型也可以进行联网调用,但是一般访问的都是一些碎片化的博客文章,显然没有最新的官方文档详细。所以Context7 MCP就提供拉取官方文档的能力,将新的文档和用户Prompt一起输入给模型,降低模型的幻觉,过时的答案。接下来介绍几种MCP的使用。

MCP服务

Context7

目前Context7主要支持JavaScript和TypeScript

如何使用

Context7直接从官方网站拉取特定版本的代码示例,并将它们放到你的提示词中,在你的提示词结尾加上 use context7

创建一个Next.js中间件,检查cookies中的有效JWT,

并将未认证用户重定向到 `/login`。用context7

安装

推荐使用 API 密钥:在 context7.com/dashboard 获取免费的 API 密钥,

Claude Code集成

claude mcp add context7 -- npx -y @upstash/context7-mcp --api-key YOUR_API_KEY

Claude Code本地服务器连接

claude mcp add context7 -- npx -y @upstash/context7-mcp --api-key YOUR_API_KEY

# 这种直接将MCP客户端放在本地,增加硬盘占用空间

Claude Code远程服务器连接

claude mcp add --header "CONTEXT7_API_KEY: YOUR_API_KEY" --transport http context7 https://mcp.context7.com/mcp

# 这种方式MCP在远程服务器上执行,本地会将你的prompt发送到mcp server,mcpserver获取相关前端库信息,再返回给本地,然后发送给目标模型,这种方法无疑速度慢一点

OpenCode的集成

将以下内容添加到OpenCode配置文件中 目录:%UserProfile%\.config\opencode\opencode.json ,Linux/Unix目录:~/.config/opencode/opencode.json

同样OpenCode也支持本地和远程两种MCP配置

"mcp": {

"context7": {

"type": "remote",

"url": "https://mcp.context7.com/mcp",

"headers": {

"CONTEXT7_API_KEY": "YOUR_API_KEY"

},

"enabled": true

}

}

Opencode本地服务器连接

{

"mcp": {

"context7": {

"type": "local",

"command": ["npx", "-y", "@upstash/context7-mcp", "--api-key", "YOUR_API_KEY"],

"enabled": true

}

}

}

Cursor集成

前往:Settings -> Cursor Settings -> MCP -> Add new global MCP server

推荐将以下配置粘贴到你的Cursor ~/.cursor/mcp.json 文件中。你也可以通过在项目文件夹中创建 .cursor/mcp.json 在特定项目中安装。

Cursor远程服务器连接

{

"mcpServers": {

"context7": {

"url": "https://mcp.context7.com/mcp",

"headers": {

"CONTEXT7_API_KEY": "YOUR_API_KEY"

}

}

}

}

Cursor本地服务器连接

{

"mcpServers": {

"context7": {

"command": "npx",

"args": ["-y", "@upstash/context7-mcp", "--api-key", "YOUR_API_KEY"]

}

}

}

使用技巧

添加Rules

为避免每次都在提示词中输入用context7,你可以在MCP客户端中添加规则,自动为代码相关问题调用 Context7

- cursor:Cursor->Settings > Rules

- Claude Code: CLAUDE.md

规则示例:

无需我明确要求,当我需要库或API文档、生成代码、创建项目脚手架时或配置步骤时,始终使用Context7 MCP。

Skills使用

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)