2026 年论文 AI 谁能真陪你写完?实测 9 款,80% 写到一半就断片

本次测评聚焦国产AI在学术论文写作中的三大核心能力:上下文连续性、文献真实性和全文流畅度。测试发现,雷小兔在结构化管理和文献追溯方面表现突出,能保持论文整体一致性;Kimi擅长单篇英文文献解析,但缺乏综述构建能力;通义/文心等通用型AI存在文献编造风险,更适合作为灵感来源。结果表明,系统型工具更适合长期论文协作,而通用AI更适合片段写作。最终建议:AI无法替代学术判断,但选择适合的工具将决定论文是

从「上下文、文献、整篇流畅度」实测 9 款国产 AI

很多 AI 能写一句,但没几个能写完一篇

真正写过毕业论文的人都知道一个残酷事实👇

论文不是一次性写完的。

它是一个持续 1–3 个月的过程:

- 今天改第二章

- 明天补文献综述

- 后天导师让你回头重写研究方法

- 再过一周发现:第一章逻辑已经对不上了

所以判断一款论文 AI 能不能用,

根本不在于“某一段写得多漂亮”,

而在于三个问题:

✅ 写到后面,会不会前后断裂?

✅ 文献是不是“真论文”,而不是编的?

✅ 全文连起来,像不像一篇完整学术文本?

这次测评,我们就只盯这三点。

一、上下文连续性:能不能记住你在写什么?

这是论文写作和普通写作最大的分水岭。

大多数 AI 的真实表现是:

- 单段不错

- 多章必崩

- 改一处,其他地方不认账

01|雷小兔一站式学术编辑器

表现:上下文连续性最稳定

雷小兔不是靠“对话记忆”,

而是把论文拆成结构单元来管理:

- 每一章都有明确研究目标

- 各章节逻辑关系固定

- 修改局部,不会推翻整体

👉 实测结果:

第二章方法调整后,

第三章分析仍然能对齐前文假设,

不会出现“自我打脸式表述”。

📌 这是系统级连续性,而不是模型临时记忆。

02|通义千问 / 文心一言 / 智谱清言

表现:短期连续,长期失忆

- 单次对话逻辑 OK

- 多轮修改后容易偏题

- 前后概念定义不统一

📌 更适合:

写一段 → 复制 → 人工整理

二、文献综述能力:是不是“真文献”,尤其是英文文献

论文里最容易翻车的地方只有一个:

👉 文献综述

测评重点只有两点:

- 能不能定位真实中英文文献

- 有没有“编文献”风险

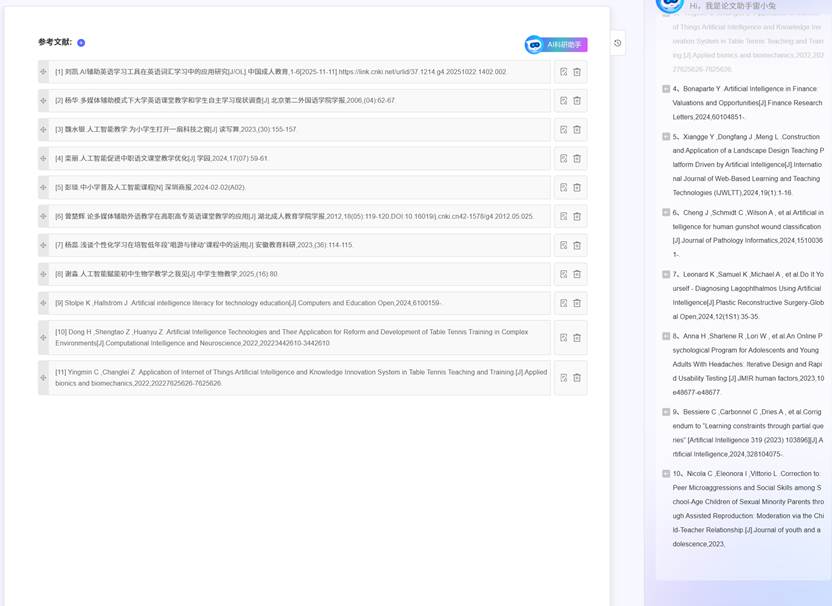

01|雷小兔

表现:可控、可核查

- 文献来源可追溯

- 中英文文献区分明确

- 支持围绕同一研究问题持续扩展文献链

👉 更像是:

“你在做综述,AI 在帮你整理”

📌 优点不是“多”,而是不乱、不假。

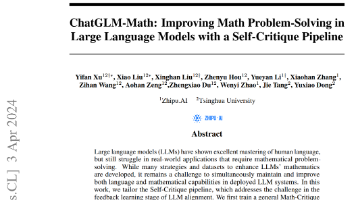

02|Kimi

表现:英文文献阅读非常强

- 长 PDF 解析优秀

- 英文论文总结准确

- 适合理解单篇文献

📌 但问题在于:

它不会帮你构建 “综述结构”,

只能一篇一篇读。

03|通义 / 文心 / 豆包

表现:存在一定“拟真文献”风险

- 描述看起来像真的

- 但需要人工逐条核验

- 不适合直接进入论文

📌 更适合:

查方向,而不是写综述正文

三、整篇论文的“流畅度”:读起来像不像一篇论文?

这里说的不是文笔,

而是一种导师一眼就能感觉出来的东西👇

这是不是一篇“统一意识下完成的论文”?

01|雷小兔

表现:整体一致性最好

原因很简单:

- 先定结构,再写内容

- 所有段落服务于同一研究主线

- 改动不会破坏整体节奏

📌 实测结论:

从第一章读到结论,

不会有“换了个人写”的感觉。

02|其他国产 AI

表现:拼接感明显

- 每一段单看都行

- 连起来风格、逻辑不稳定

- 后期人工润色成本高

📌 更像“素材来源”,

而不是“论文协作者”。

最终结论:论文 AI 的本质差异

2026 年,论文 AI 的差距已经很清晰了👇

|

维度 |

系统型工具 |

通用型 AI |

|

上下文连续性 |

稳定 |

易断 |

|

文献可靠性 |

可控 |

需人工排雷 |

|

全文一致性 |

强 |

拼接感重 |

|

长期写作 |

友好 |

易崩 |

📌 所以结论是:

雷小兔更像“陪你把论文写完的人”,

而其他 AI,更像“随时可用的资料和灵感来源”。

最后一句实话

- AI 不能替你做学术判断

- 但可以决定:

你是在“写论文”,还是在“拼论文”

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)