【大模型技术报告】ChatGLM-Math

大型语言模型(LLM)已展现出对人类语言的出色掌握能力,但在需要数学问题解决能力的现实应用中仍面临困难。尽管目前已开发出多种提升LLM数学能力的策略与数据集,如何在已部署的LLM系统中同步保持并提升语言与数学能力仍具挑战。本研究针对LLM对齐过程中的反馈学习阶段,定制了Self-Critique流程框架。我们首先基于LLM自身训练通用Math-Critique模型以提供反馈信号,随后依次采用拒绝式

ChatGLM-Math:通过自批判管道提升大语言模型的数学问题解决能力

摘要

大型语言模型(LLM)已展现出对人类语言的出色掌握能力,但在需要数学问题解决能力的现实应用中仍面临困难。尽管目前已开发出多种提升LLM数学能力的策略与数据集,如何在已部署的LLM系统中同步保持并提升语言与数学能力仍具挑战。本研究针对LLM对齐过程中的反馈学习阶段,定制了Self-Critique流程框架。我们首先基于LLM自身训练通用Math-Critique模型以提供反馈信号,随后依次采用拒绝式微调与直接偏好优化方法对LLM自身生成数据进行收集。基于ChatGLM3-32B模型,我们在学术数据集及新构建的高难度数据集MATHUSEREVAL上开展系列实验。结果表明,该流程在持续提升模型语言能力的同时,显著增强了LLM的数学问题求解能力,其表现可超越两倍参数规模的LLM。相关技术已应用于在线服务模型ChatGLM1。完整评估数据集与代码已在https://github.com/THUDM/ChatGLM-Math开源。

1.引言

大型语言模型(LLM)[8; 10; 20; 40; 44; 61; 1] 因其在文本摘要[18; 47; 33; 26]、问答[16; 24; 7]及角色扮演对话[46; 67; 41]等多种语言任务中的卓越能力而受到广泛关注。此外,其在解决需要数学推理的复杂问题上的潜力[57; 48; 31],进一步拓展了其在现实世界任务中的适用性[30; 5]。

尽管取得这些进展,如何优化大语言模型使其在语言理解与数学问题求解方面同时保持卓越性能,仍是一个显著挑战。当前主流的人类反馈强化学习(RLHF)方法主要通过反映人类偏好的奖励模型来增强文本生成能力[44; 35; 45]。虽然该方法提升了生成文本的质量,却常忽视数学问题求解所必需的精确性与逻辑一致性,导致在数学推理任务中产生被称为“对齐税”的性能差距[2](参见表1)。另一方面,试图增强大语言模型数学能力的尝试通常涉及监督微调(SFT),但这往往会无意中削弱其语言多样性,给大语言模型系统的实际应用带来两难困境[43; 57; 31; 60]。

流程:自我批判。本文提出一种旨在同时提升大语言模型语言与数学能力且不偏废任何一方的新方法。我们的策略有别于传统RLHF,引入了一个源自大语言模型自身的数学批判模型,用于评估其数学输出。这种自我批判机制使模型能够从针对数学内容专门生成的AI反馈中学习[4; 25]。我们的方法包含两个主要阶段:

- 阶段一:拒绝式微调[58]采用拒绝抽样技术,未达到数学批判标准的结果将被舍弃,其余结果则进行进一步微调。此阶段旨在提升模型数学回答的准确性与一致性,同时确保所选答案的多样性。

- 阶段二:直接偏好优化[38]通过直接学习由数学批判进一步筛选的正确与错误答案对,来扩展改进过程,其重点关注前一阶段最具挑战性的问题。

基准测试:MATHUSEREVAL。为准确评估大型语言模型解决现实世界数学问题的能力,我们构建了MATHUSEREVAL数据集。该数据集涵盖多样化的题型,不仅包括传统数学练习题,更延伸至实际应用场景,从而相比传统学术数学数据集[64;50;11]能更好地反映用户需求。我们同时采用GPT-4-turbo与自研的Math-Critique模型进行综合评分。

综上所述,我们的贡献包括:

• 提出自我批判框架,该创新性流程通过模型自生成的反馈机制,在无需外部监督模型和人工标注的情况下,显著提升大语言模型的数学与语言能力。该方法已在ChatGLM3-32B模型上得到验证,在MATHUSEREVAL、Ape210k[64]、MATH[16]等数学数据集及AlignBench[29]的语言任务中均取得了突破性性能表现。

• 构建MATHUSEREVAL评估基准,该基准专门针对现实场景中复杂开放式的数学问题进行设计,为评估实际数学推理能力设立了新标准。

• 深入剖析自我批判框架提升数学能力的关键因素,为未来模型自主优化方向提供了重要见解。

2.相关工作

大型语言模型在数学解题中的应用。为提升语言模型的数学问题解决能力,研究者已探索多种方法。以思维链提示[51]为开端的提示方法不断演进,通过引导模型进行细致推理得到优化,其中[55; 6; 53]的研究显著提升了模型在数学与推理任务上的表现。然而,这些方法的局限性在于模型固有能力,因其并未修改模型本身。监督微调与强化学习同样具有关键作用。[31; 58; 9; 57; 60; 62] 等研究提供的高质量监督数据旨在直接提升模型能力。强化学习在通用领域的潜力已通过 [34; 44; 12] 得以证实,并借助 OpenAI 的过程奖励模型 [27] 与 PPO 算法应用 [31; 48] 实现了数学能力的增强,尽管 DPO 算法 [38] 在数学任务中的应用仍面临挑战。解码策略与外部工具的使用提供了额外的改进途径。Self-Consistency [49] 与 MATH-SHEPHERD [48] 探索了通过采样策略增强问题求解能力的方法,而 Mammoth [60] 和 Tora [15] 等工作中采用的代码插入技术则绕过了计算限制。

数学能力评估。复杂的推理任务(如数学)历来是评估语言模型能力的关键指标之一[22; 37; 17; 14]。解决数学问题涉及语义理解、问题分解、符号推理和数值计算,这使其成为评估大语言模型认知推理能力的绝佳选择。GSM8k [11] 和 MATH [17] 数据集已成为使用最广泛的基准。GSM8K 数据集侧重于基础算术的多步骤推理,展现了小学阶段数学固有的复杂性和语言多样性。MATH 基准则进一步涵盖了多个科目和难度级别,有助于对模型的问题解决能力进行细致考察。

3.Math-Critique:一个通用的数学批判模型

定义: 我们工作的第一部分是构建一个精确且稳健的评估模型。我们提出了 Math-Critique,其灵感来源于利用大模型进行评价的相关研究[21; 65]。该方法根据问题和参考答案,对模型生成的数学回答进行评分,输出包括解释性分析和一个介于1到10之间的分数。与传统的奖励模型相比,此方法利用了语言模型的上下文理解能力。通过整合参考答案以实现更精准的判断。采用解析性分析与评分相结合的方式亦受到思维链概念的启发,在提高评分准确性的同时增强了可解释性。 在指令中,Math-Critique 必须将回答归类为四个类别:完全错误、方法部分正确但结果错误、结论正确但方法部分存在缺陷、以及完全正确。这些类别分别对应1-2分、3-5分、6-8分和9-10分的评分区间。

因此,数学批判模型可定义为:

此处,“问题”与“参考答案”分别为原始题目与标准答案,“模型答案”则是被评估模型给出的答案。我们采用两种基于数学评判(math-critique)的评估方法:平均分评估与硬性分割评估。平均分评估计算模型在一组问题上所有答案得分的平均值。而硬性分割评估则依据预设的正确阈值,将每个模型答案划分为“通过”或“未通过”。若某答案的评判分数超过该阈值,则视为正确;否则视为错误。整体得分以正确答案占题目总数的比例计算。

数据收集。我们的构建方法包含以下步骤:

• 我们重新设计了数学回答的评分规则与区间,使模型能够根据结果和过程的正确性进行评分。

• 我们从训练数据中筛选出一个数据集,其中包含数学问题及其参考答案与模型回答,主要来源于初中至大学阶段的试题。我们使用了包括不同版本ChatGLM及其他模型在内的多来源模型采样答案。

• 我们采用CritiqueLLM[21]和ORM对数据集进行标注,选取这些模型中代表最优和最差评分极端的标注,并直接使用这些伪标签进行训练。此步骤共生成10k条标注数据。

• 对于得分处于中间范围的结果,我们选取部分进行四分类人工标注,并将这些结果映射到10分制评分。我们还从训练数据集中划分出测试集,并采用相同方法进行四分类标注。此步骤为训练集生成5k条标注数据,为测试集生成800条标注数据。

4.自我批判流水线

概述。基于Math-Critique的构建方法,本节介绍SelfCritique流程。该流程是一种弱监督的迭代训练方法,用于从单一模型出发增强数学能力。首先,我们使用基础模型训练一个Math-Critique模型,并同时使用基础的SFT数据集训练一个基础对话模型。随后,我们通过拒绝采样,利用Math-Critique模型监督对话模型的微调。此步骤的结果可作为新的基础模型,用以更新Math-Critique模型以及拒绝采样监督微调模型。基于上述步骤,我们的最终操作是利用最新的Math-Critique模型采样对比数据,继而进行DPO训练。

在这些步骤中,Math-critique-base的数据构建涉及少量人工标注。然而,这批标注是一次性工作,因为仅需此批标注数据作为后续迭代的引导。此后,推理和自动模型筛选即可完成所有剩余步骤。

用推理替代人工标注,能够显著减少从基础模型到最终对话模型每次迭代所需的时间。这避免了一个棘手的情况:经过数周人工标注后,基础模型可能已通过进一步预训练而能力增强,导致数周前采样的数据是否仍然准确,或与当前模型存在显著分布差异变得难以判断。

4.1 阶段一:拒绝式微调

我们采用了基于Math-Critique的拒绝采样方法。我们对RFT的实现进行了重新审视与设计,发现采样范围与模型均会影响拒绝采样的结果。具体而言,我们设计了如下采样原则:

• 预去重:对训练集中的问题嵌入进行聚类,并均匀按类别采样,确保问题多样且不重复。

• 采样后去重:在基于Math-Critique结果进行5-10轮采样迭代后,我们进行了筛选。在完成必要去重的基础上,对于同一问题同时存在正确与错误回答的情况,我们仅选取完全正确的回答。

根据上述流程,我们获得了Critique-RFT数据集:

D R F T = { ( q i , a i j ) ∣ 1 n ∑ x MathCritique ( a i x ) < 1 a n d MathCritique ( a i j ) > correct-bound } D_{\mathrm{RFT}}=\left\{\left(q_i,a_{ij}\right)|\frac{1}{n}\sum_x\text{MathCritique}(a_{ix})<1\mathrm{~and~}\text{MathCritique}(a_{ij})>\text{correct-bound}\right\} DRFT={(qi,aij)∣n1x∑MathCritique(aix)<1 and MathCritique(aij)>correct-bound}

在该数据集中, q i q_i qi 表示第 i 个采样问题,每个问题均进行 n 次采样。 a i j a_{ij} aij 代表第 i 个问题的第 j 个回答。MathCritique 指代数学批判评分。‘correct bound’ 表示正确答案可接受的最低分数阈值,通常设定为 0.7。

4.2 第二阶段:直接偏好优化

我们采用DPO方法在Critique RFT后进一步优化模型能力。该方法主要优势在于数据流构建的简洁性、训练稳定性与速度。DPO方法直接对同一问题的正确与错误答案进行对比。在我们的实现中,两个答案均从经过RFT后的模型中采样获得,这一设计被证实具有关键重要性。训练过程中,我们还整合了DPO正例的sft损失作为正则化项的近似替代。我们的DPO数据筛选流程与Critique RFT类似,核心差异仅在于DPO训练对的构建方式。针对DPO配对的选择,在确保至少存在一正一负答案的前提下,我们选取Math-Critique评分结果差异最显著的数据对。

遵循上述流程,我们已获得Critique-DPO数据集。

D D P O = { ( q i , a c h o s e n , a r e j e c t e d ) ∣ 1 n ∑ x MathCritique ( a i x ) < 1 , MathCritique ( a c h o s e n ) > correct-bound, MathCritique ( a r e j e c t e d ) < rejected-bound } D_{\mathrm{DPO}}=\left\{(q_{i},a_{\mathrm{chosen}},a_{\mathrm{rejected}})\left|\begin{array}{l}\frac{1}{n}\sum_{x}\text{MathCritique}(a_{ix})<1,\\\text{MathCritique}(a_{\mathrm{chosen}})>\text{correct-bound,}\\\text{MathCritique}(a_{\mathrm{rejected}})<\text{rejected-bound}\end{array}\right.\right\} DDPO=⎩ ⎨ ⎧(qi,achosen,arejected) n1∑xMathCritique(aix)<1,MathCritique(achosen)>correct-bound,MathCritique(arejected)<rejected-bound⎭ ⎬ ⎫

在该数据集中,每个元素均为一个元组,其中 q i q_i qi表示第i个采样问题。对于每个问题 q i q_i qi,采样了n个回答,每个回答记作 a i x a_{ix} aix。计算每个回答 a i x a_{ix} aix的数学批判评分,且这些评分的平均值必须小于1。每个问题的选定答案 a i − c h o s e n a_{i-chosen} ai−chosen需超过“正确边界”——即预设的表示合格正确度的阈值,通常设定在特定数值以上。相反地, a i − r e j e c t e d a_{i-rejected} ai−rejected指代低于“拒绝边界”的答案,该边界是判定答案为错误或不达标的阈值下限。

4.3 训练

4.3.1 数学批判性思维训练

我们采用ChatGLM3-32B [61;13]的基础模型作为初始的数学批判基础模型。在每轮迭代后,当前通过监督微调或批判性强化学习精炼的模型将被用作基础模型。在60亿和320亿参数规模上,我们均使用3e-6的学习率和128的批次大小。

4.3.2 拒绝采样微调批判训练

在批判性RFT阶段,我们的每次微调迭代都包含经过去重处理的先前阶段数据集,其中也包括初始的SFT数据集。我们将 D R F T D_{RFT} DRFT与 D S F T D_{SFT} DSFT进行合并。

D = D R F T ∪ D S F T D=D_{\mathrm{RFT}}\cup D_{\mathrm{SFT}} D=DRFT∪DSFT

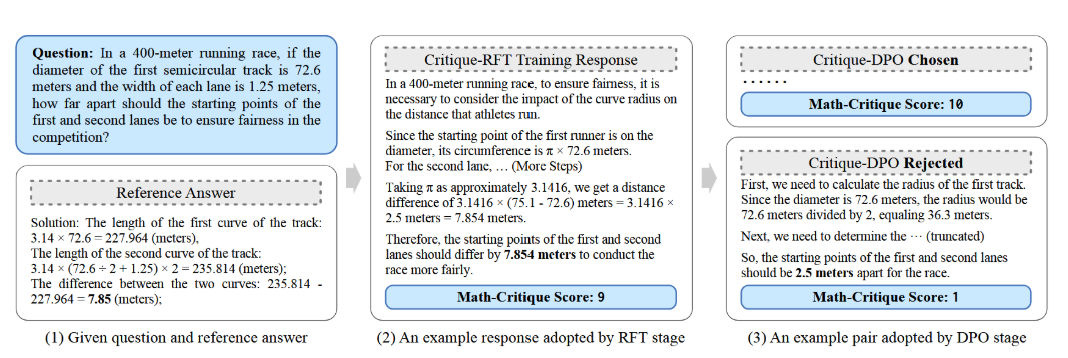

图3:训练数据集示例。我们生成的训练数据分为两类,源自现有数据集中的问题与参考文献。我们分别构建了RFT训练数据与配对的DPO训练数据。

D S F T D_{SFT} DSFT数据集包含大量常规任务,可用开源指令微调数据集替代。为消除该数据集对最终结果的潜在干扰,我们在消融实验中对比了包含与排除SFT数据的影响。我们通过标准最大对数似然损失对基础大语言模型 π θ π_θ πθ进行微调:

L ( π θ ) = − E ( q i , a i j ) ∼ D [ log ( π θ ( a i j ∣ q i ) ) ] \mathcal{L}(\pi_\theta)=-\mathbb{E}_{(q_i,a_{ij})\thicksim\mathcal{D}}\left[\log\left(\pi_\theta(a_{ij}|q_i)\right)\right] L(πθ)=−E(qi,aij)∼D[log(πθ(aij∣qi))]

在此阶段,我们使用2e-5的学习率,以64的批次大小微调8000步。

4.3.3 批判直接偏好优化训练

在Critique-DPO阶段,我们观察到直接使用DPO损失会导致训练过程不稳定。为此,我们在总损失中引入了一个针对所选答案的交叉熵损失作为正则化项,以缓解该问题。此项增加的目的是增强模型训练的稳定性。训练数据集使用了先前构建并标记为DDPO的DPO数据集。我们使用的损失函数如下:

L D P O ( π θ ; π r e f ) = − E ( q i , a i − c h o , a i − r e j ) ∼ D D P O [ log σ ( β log π θ ( a i − c h o ∣ q i ) π r e f ( a i − c h o ∣ q i ) − β log π θ ( a i − r e j ∣ q i ) π r e f ( a i − r e j ∣ q i ) ) ] \mathcal{L}_{\mathrm{DPO}}(\pi_\theta;\pi_{ref})=-\mathbb{E}_{(q_i,a_{\mathrm{i-cho}},a_{\mathrm{i-rej}})\thicksim\mathcal{D}_{\mathrm{DPO}}}\left[\log\sigma\left(\beta\log\frac{\pi_\theta(a_{\mathrm{i-cho}}|q_i)}{\pi_{ref}(a_{\mathrm{i-cho}}|q_i)}-\beta\log\frac{\pi_\theta(a_{\mathrm{i-rej}}|q_i)}{\pi_{ref}(a_{\mathrm{i-rej}}|q_i)}\right)\right] LDPO(πθ;πref)=−E(qi,ai−cho,ai−rej)∼DDPO[logσ(βlogπref(ai−cho∣qi)πθ(ai−cho∣qi)−βlogπref(ai−rej∣qi)πθ(ai−rej∣qi))]

L C E ( π θ ; π r e f ) = − E ( q i , a i − c h o ) ∼ D [ log ( π θ ( a i − c h o ∣ q i ) ) ] \mathcal{L}_{\mathrm{CE}}(\pi_\theta;\pi_{ref})=-\mathbb{E}_{(q_i,a_\mathrm{i-cho})\thicksim\mathcal{D}}\left[\log\left(\pi_\theta(a_\mathrm{i-cho}|q_i)\right)\right] LCE(πθ;πref)=−E(qi,ai−cho)∼D[log(πθ(ai−cho∣qi))]

L m e r g e = λ ⋅ L D P O + L C E \mathcal{L}_{\mathrm{merge}}=\lambda\cdot\mathcal{L}_{\mathrm{DPO}}+\mathcal{L}_{\mathrm{CE}} Lmerge=λ⋅LDPO+LCE

在此设定中,λ代表总损失中选定答案的交叉熵损失系数。通常,我们尝试的取值为 { 0.5 , 1 , 1.5 } \{0.5, 1, 1.5\} {0.5,1,1.5}。另一个关键系数是β,它衡量了DPO对错误答案的惩罚强度。由于添加了正则化项,该系数的值高于标准DPO,我们的测试范围为 { 0.5 , 1 , 2 } \{0.5, 1, 2\} {0.5,1,2}。除此之外,整体学习率设置为1e-6。实验部分将报告这些系数设定下的最佳结果。本阶段我们以64的批次大小训练500步。

5.MATHUSEREVAL:大型语言模型应用场景数学推理基准评测

MATHUSEREVAL是一个面向真实使用场景的测试集,旨在针对用户关注的问题和更具挑战性的数学难题展开评估。我们的部分数据来源于大学试题,另一部分则来自模拟对话。对于后者,我们安排了一系列标注人员,根据他们在日常使用大模型时的经验和观察,向系统提出了数学相关的问题。

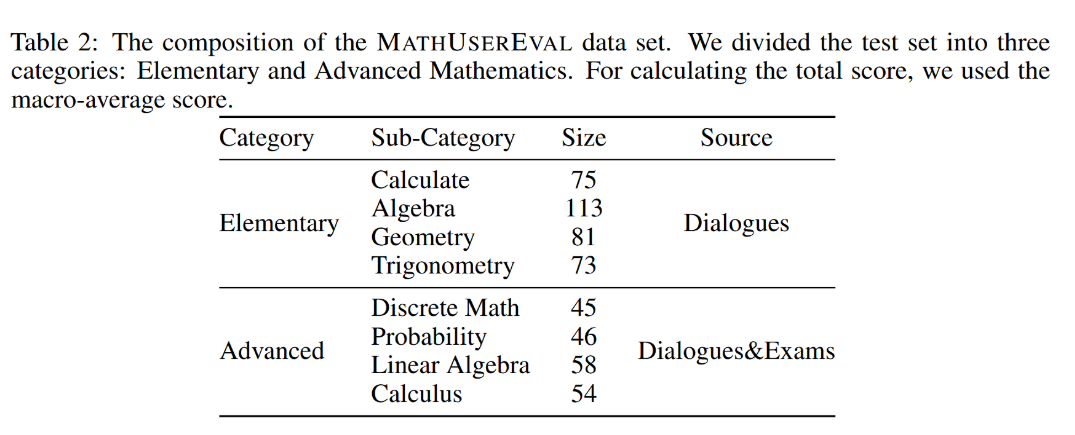

根据所收集数据的分布情况,我们将测试集划分为基础与进阶两大类别,并进一步细分为八个子类别。鉴于计算应用类题目难度较低,且与既往公开数据集的范畴高度重合,我们从该类别中选取了较少题目。各类别的具体题目数量如表2所示。所有题目均采用开放式提问形式,答案可能为单一数值、多个数值或数学表达式。

表2:MATHUSEREVAL数据集的构成。我们将测试集划分为两类:基础数学与高等数学。总分计算采用宏平均分。

我们提供两种评估方法:GPT-4-1106-Preview [34; 29; 65] 评估与 Math-Critique 评估。前者采用 alignbench [29] 的评估方法,以提供更准确、公平且易于使用的评估途径;后者则与上文介绍的 Math-Critique 使用方式相同。相应地,我们也将报告两类分数:平均分数(avg-score)与困难部分分数(hard-split)。

6.实验

6.1 数据收集

我们收集数据的主要来源可分为以下两类:公开数据集的训练集以及公开可用的中学与大学考试试题。我们选取了GSM8k [11]和MATH [17]训练集中的全部提示作为英文数据的问题集,并采用原数据集中的回答作为标准答案。针对公开的中学与大学考试试题,我们直接以考卷附带的答案格式作为通用答案,未作进一步处理。

6.2 评估设置

6.2.1 数据集

在我们的研究中,我们主要测试了MATHUSEREVAL数据集,该数据集来源于模拟对话记录和真实考试试卷。与学术数据集相比,该数据集的问题风格更为多样,且更贴近实际使用场景。此外,我们还测试了以下学术数据集:1. 英文学术数据集:GSM8k [11] 和 MATH [17]。这两个数据集包含初高中及竞赛级别的英文数学问题。2. 中文学术数据集:ape210k [64] 和 cmath [52]。这些数据集中的问题同样源自初高中级别。我们还采用了匈牙利国家考试 [36] 作为分布外测试集。需要说明的是,在所有测试集中,我们仅使用了GSM8k和MATH的训练集作为数据生成的种子数据。

为评估通用语言能力,我们选取了AlignBench[29]的中文部分及完整的MT-Bench[65]进行测试。

6.2.2 基线

鉴于我们的工作主要使用中文进行,我们选取了以下三类基线:开源数学专用模型、开源中文模型以及领先的专有模型。

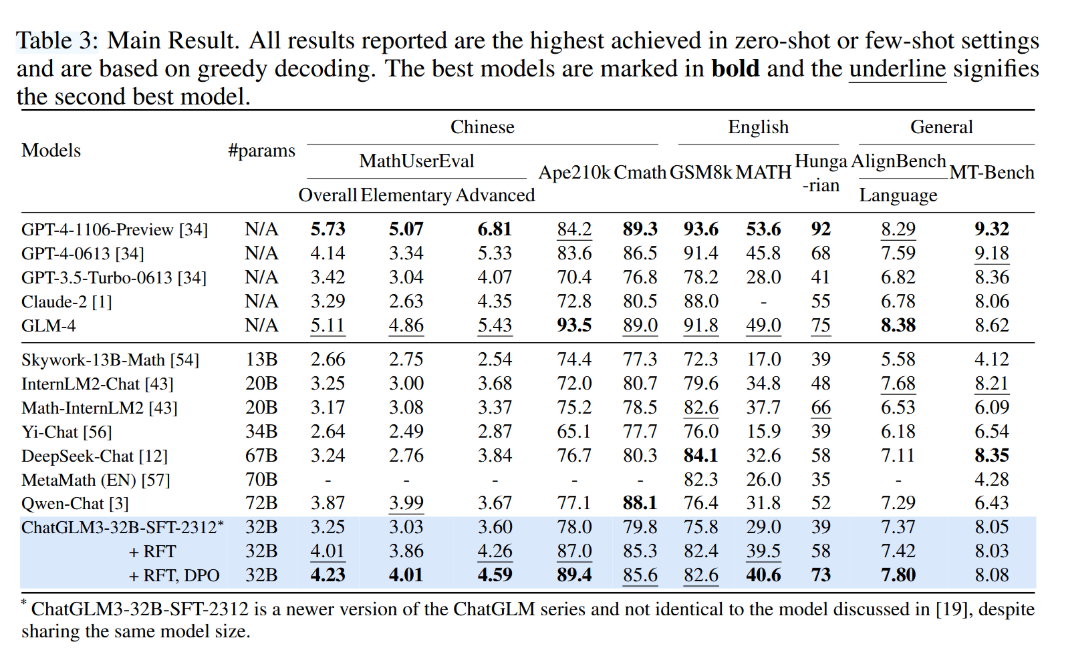

表3:主要结果。所有报告结果均为零样本或少样本设置下的最高性能,基于贪心解码策略。最佳模型以粗体标示,下划线表示次优模型。

针对开源数学模型,我们选择SkyMath [54]、MetaMath [57]和Internlm2Math [43]作为基线。为有效对比最佳中文模型,我们选取了Qwen-Chat [3]、Yi-Chat [56]、DeepSeek-Chat [12]及InternLM2 [43]。此外,我们还报告了GPT-4-1106-Preview(即GPT4-Turbo)、GPT-4-0613、GPT-3.5-Turbo [34]和Claude-2 [1]的结果。

6.2.3 度量指标

对于所有数据集,我们均采用单次贪婪推理的结果。关于学术数据集,我们报告了对应模型自行申报的结果,以及OpenCompass与MATHUSEREVAL网站上公布的零样本/少样本最佳结果。对于AlignBench的数学子集[29]及我们提出的MATHUSEREVAL测试集,我们报告了GPT-4Turbo的评分结果以及Math-Critique生成的分数。更多评估设置相关信息可参见附录C。

6.3 主要结果

表3展示了我们的主要结果。在参数量超过100亿的模型中,我们的模型在MATHUSEREVAL上取得了4.23分,在ape210k[64]上取得89.4分,在MATH[16]上取得40.6分,超越了所有已公布参数量的模型,并在Cmath和GSM8k上达到了接近顶尖的性能。我们的模型在匈牙利测试[36]中也取得了73分的成绩,在所有已知参数量模型中位列第一。

我们以ChatGLM3-32B-SFT-2312版本作为基线。我们的RFT阶段在所有数学数据集上均有显著提升。相比之下,DPO阶段的改进主要集中在开放式数学问题上,包括MATHUSEREVAL、匈牙利考试以及通用评估基准AlignBench。尽管我们在MT-bench[65]上的提升并不显著,但考虑到我们超过90%的训练数据为中文,我们认为保持性能持平实质上证明了我们的方法保留了模型原有的英语通用及多轮对话能力。

与专有模型(尤其是OpenAI的GPT系列)相比,GLM-4在特定领域展现出具有竞争力乃至更优的性能。例如,GPT-4-1106-Preview在多数任务中表现最佳,其在中英文基准测试中均获得最高分,突显了其在各类数学问题解决场景中的高效性。然而,GLM-4在Ape210k和AlignBench基准测试中超越了前者,这表明其在数学推理及跨语言泛化方面具有特殊优势。

6.4 消融实验

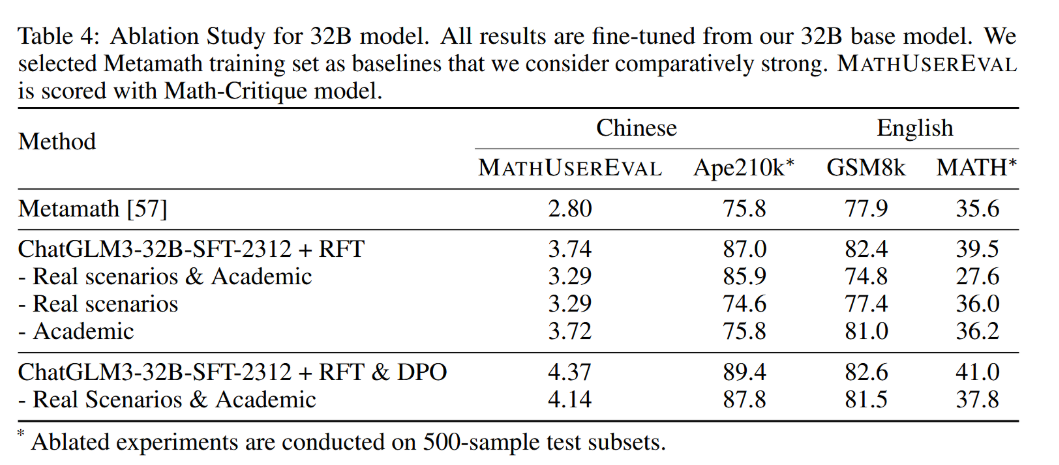

数据构成的影响。表4展示了消融实验的结果。我们选用Metamath[57]训练集作为我们认为相对较强的基线。应用Critique-RFT后,我们发现仅使用学术数据集构建RFT数据,在实际场景导向的MATHUSEREVAL和学术测试集上的表现,均逊于引入实际场景数据后的结果。此外,引入英文数据能显著提升在英文数据集上的性能,同时不会对中文能力产生明显影响。

表4:32B模型消融研究结果。所有结果均基于我们的32B基础模型微调得到。我们选择Metamath训练集作为我们认为相对较强的基线。MATHUSEREVAL分数使用Math-Critique模型进行评定。

在Critique-DPO阶段进行的消融实验表明,相较于使用通用DPO数据,增加数学专项DPO数据能显著提升数学能力。我们不再分别测试Real场景数据和Academic数据对能力的影响。这是因为在前序阶段中,已移除模型能正确解答的问题,导致无法确保两个数据集仍具备足够规模以支持完整的训练周期。

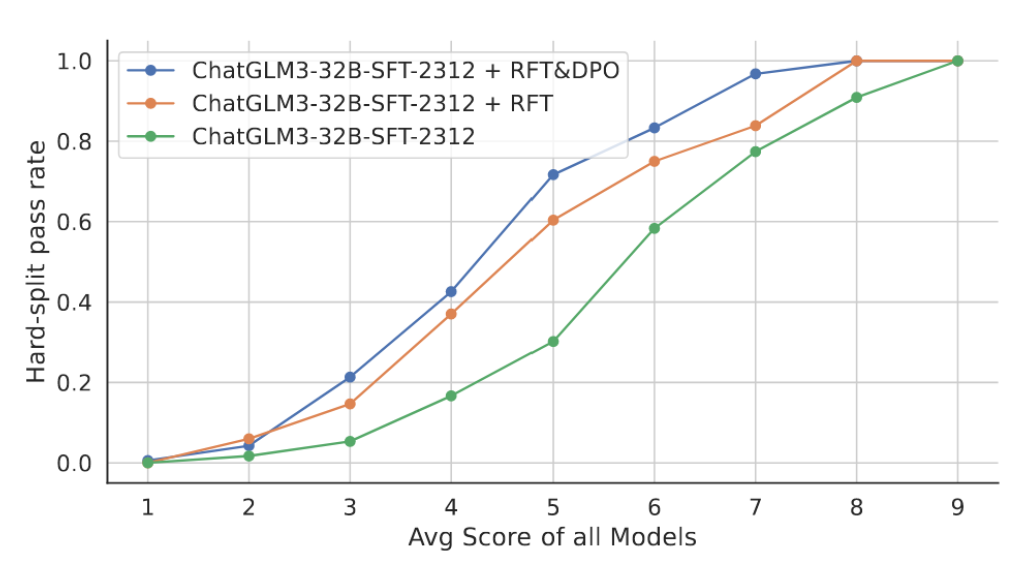

不同提升方法与问题难度之间的关系。

图4展示了MATHUSEREVAL中每个问题在所有24个测试模型(包括部分中间模型)上的平均准确率与四个GLM系列模型的硬分割分数之间的关系。所有测试模型的平均准确率被视为问题难度水平的反映。可以观察到,RFT步骤在几乎所有难度级别上均能提升性能,但最显著的改进来自平均分数在4至6之间的问题。DPO步骤主要提升平均分数在平均分在5到7分之间。这表明,我们分两步提升数学能力的方法可被视为使模型更贴近现实条件,且在中等难度问题上效果提升最为显著。

图4:不同增强方法与问题难度之关系。横轴展示了24个模型在MATHUSEREVAL上的平均得分(由GPT-41106-Preview评分),我们将其视作问题难度的表征。纵轴则表示这些模型在对应题目上的困难划分得分。

对通用能力的影响。鉴于我们的目标并非开发专门针对排行榜爬升的专用数学模型,而是构建具备强大数学能力的通用模型,我们采用中文通用开放式问答数据集Alignbench[29]对结果进行了测试。表3数据显示,在中文语言能力方面,我们的模型超越了未引入专业数学数据的同类基线模型的训练成果,同时相较于其他开源中文数学/通用模型也表现出色。针对英文通用能力,我们使用MT-Bench[65]作为测试集进行评估。考虑到训练数据中超过90%为中文语料,而训练过程中MT-Bench[65]的测试结果保持稳定,这表明模型的英语语言能力未受到显著影响。

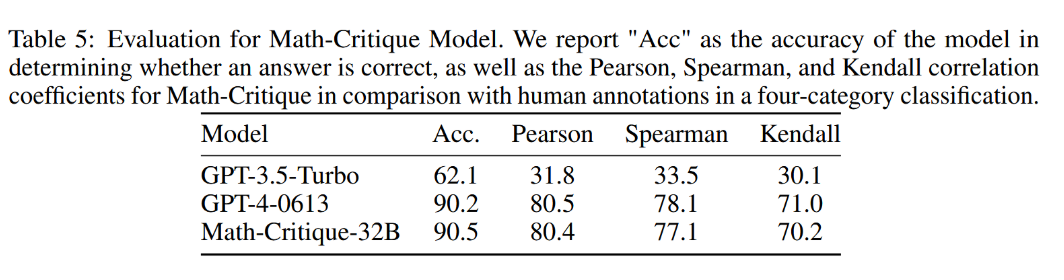

Math-Critique有效性验证。在人工标注过程中,我们收集了800道测试题,全部经人工标注答案与解题过程正确性,由此形成四分类测试集;Math-Critique的输出结果根据指令要求映射至这四种类别。我们通过实证实验验证了Math-Critique本身的有效性,设立两种评估方式:直接判断对错的准确率,以及判断我们定义的四分类的准确率。测试集提取自中国初高中考题与MATHUSEREVAL,并由专家标注正确判断。

表5结果显示,我们的Math-Critique-32B模型在判断准确率和与人工标注的相关系数上均显著超越GPT3.5-Turbo,且与GPT-4-0613基本持平。

表5:数学批判模型的评估结果。我们汇报了模型判断答案正确与否的准确率"Acc",以及数学批判模型在四分类任务中与人工标注相比的皮尔逊、斯皮尔曼和肯德尔相关系数。

分布外测试。遵循Grok-1的方法,为测试模型在分布外数据集上的性能,我们选取了匈牙利国家毕业考试[36]作为测试集。该数据集包含33道试题且无对应训练集,其优势在于能够在完全分布外环境中评估模型的数学能力。如图1所示,通过人工专家评估,我们发现模型规模为320亿参数时,我们的RFT模型得分为57分,而DPO模型得分为73分。但需特别指出,由于我们的模型主要语言为中文,若模型以中文正确作答,我们仍会正常计分。我们计划在后续模型中解决此问题。

7.研究局限与未来工作

我们在数学模型中观察到以下问题,并留待未来工作解决:

图形思维与绘制能力。由于纯语言模型的局限性,我们的模型在处理需要绘图的问题时存在不足。例如,在匈牙利测试中有一道要求将六个数字作为彼此的除数进行连接的问题,我们的模型能正确列出不同数字的连接拓扑结构,却无法准确绘制该图形。此外,作为语言模型,它在处理需要理解图像的问题时也难以给出正确答案。

一种潜在的解决方案是集成多模态输入与输出组件,这也是我们计划深入探索的领域。

数值计算精度问题。我们观察到,在模型错误回答的问题中,若题目涉及三位及以上小数的乘、除或乘方运算,模型的计算偏差可能高达5%。这一现象与未集成代码解释器的GPT-4模型观测结果一致。该问题可能是纯语言模型的根本性局限,通过扩大模型规模或许能缓解但无法完全解决。使用外部计算工具或直接通过代码解释器执行代码可以彻底解决此问题。然而,本文的讨论聚焦于提升纯语言模型的数学能力,我们将在后续工作中着力解决这些问题。

8.总结

本文提出了一种评估数学问题正确性的数学批判方法,并基于该方法进一步提出了自批判方法,旨在无需外部监督模型和人工标注的情况下增强语言模型的数学能力。我们在中英文环境下进行了实验,一个320亿参数的模型在多个数据集上取得了开源语言模型中的最优性能。此外,在我们提出的MATHUSEREVAL测试集上,其表现超越了包括GPT-4-0613在内的多个知名闭源模型。该方法在GLM-4开发过程中被作为提升数学能力的组件应用,除GPT-4-Turbo外,在MATHUSEREVAL、ape210k、GSM8k以及匈牙利测试等数据集上均取得了最佳结果。

参考文献

- [1] Anthropic. Introducing claude, 2023.

- [2] A. Askell, Y. Bai, A. Chen, D. Drain, D. Ganguli, T. Henighan, A. Jones, N. Joseph, B. Mann, N. DasSarma, N. Elhage, Z. Hatfield-Dodds, D. Hernandez, J. Kernion, K. Ndousse, C. Olsson, D. Amodei, T. Brown, J. Clark, S. McCandlish, C. Olah, and J. Kaplan. A general language assistant as a laboratory for alignment, 2021.

- [3] J. Bai, S. Bai, et al. Qwen technical report, 2023.

- [4] Y. Bai, S. Kadavath, S. Kundu, A. Askell, J. Kernion, A. Jones, A. Chen, A. Goldie, A. Mirhoseini, C. McKinnon, C. Chen, C. Olsson, C. Olah, D. Hernandez, D. Drain, D. Ganguli, D. Li, E. Tran-Johnson, E. Perez, J. Kerr, J. Mueller, J. Ladish, J. Landau, K. Ndousse, K. Lukosuite, L. Lovitt, M. Sellitto, N. Elhage, N. Schiefer, N. Mercado, N. DasSarma, R. Lasenby, R. Larson, S. Ringer, S. Johnston, S. Kravec, S. E. Showk, S. Fort, T. Lanham, T. Telleen-Lawton, T. Conerly, T. Henighan, T. Hume, S. R. Bowman, Z. Hatfield-Dodds, B. Mann, D. Amodei, N. Joseph, S. McCandlish, T. Brown, and J. Kaplan. Constitutional ai: Harmlessness from ai feedback, 2022.

- [5] Y. Bai, X. Lv, J. Zhang, H. Lyu, J. Tang, Z. Huang, Z. Du, X. Liu, A. Zeng, L. Hou, et al. Longbench: A bilingual, multitask benchmark for long context understanding. arXiv preprint arXiv:2308.14508, 2023.

- [6] M. Besta, N. Blach, A. Kubicek, R. Gerstenberger, L. Gianinazzi, J. Gajda, T. Lehmann, M. Podstawski, H. Niewiadomski, P. Nyczyk, et al. Graph of thoughts: Solving elaborate problems with large language models. arXiv preprint arXiv:2308.09687, 2023. [7] Y. Bisk, R. Zellers, R. Le bras, J. Gao, and Y. Choi. Piqa: Reasoning about physical commonsense in natural language. Proceedings of the AAAI Conference on Artificial Intelligence, 34(05):7432–7439, Apr. 2020.

- [8] T. Brown, B. Mann, N. Ryder, M. Subbiah, J. D. Kaplan, P. Dhariwal, A. Neelakantan, P. Shyam, G. Sastry, A. Askell, et al. Language models are few-shot learners. Advances in neural information processing systems, 33:1877–1901, 2020.

- [9] E. Chern, H. Zou, X. Li, J. Hu, K. Feng, J. Li, and P. Liu. Generative ai for math: Abel. https://github.com/GAIR-NLP/abel, 2023. [10] A. Chowdhery, S. Narang, J. Devlin, M. Bosma, G. Mishra, A. Roberts, P. Barham, H. W. Chung, C. Sutton, S. Gehrmann, et al. Palm: Scaling language modeling with pathways. arXiv preprint arXiv:2204.02311, 2022.

- [11] K. Cobbe, V. Kosaraju, M. Bavarian, M. Chen, H. Jun, L. Kaiser, M. Plappert, J. Tworek, J. Hilton, R. Nakano, C. Hesse, and J. Schulman. Training verifiers to solve math word problems, 2021.

- [12] DeepSeek-AI, :, X. Bi, D. Chen, G. Chen, S. Chen, D. Dai, C. Deng, H. Ding, K. Dong, Q. Du, Z. Fu, H. Gao, K. Gao, W. Gao, R. Ge, K. Guan, D. Guo, J. Guo, G. Hao, Z. Hao, Y. He, W. Hu, P. Huang, E. Li, G. Li, J. Li, Y. Li, Y. K. Li, W. Liang, F. Lin, A. X. Liu, B. Liu, W. Liu, X. Liu, X. Liu, Y. Liu, H. Lu, S. Lu, F. Luo, S. Ma, X. Nie, T. Pei, Y. Piao, J. Qiu, H. Qu, T. Ren, Z. Ren, C. Ruan, Z. Sha, Z. Shao, J. Song, X. Su, J. Sun, Y. Sun, M. Tang, B. Wang, P. Wang, S. Wang, Y. Wang, Y. Wang, T. Wu, Y. Wu, X. Xie, Z. Xie, Z. Xie, Y. Xiong, H. Xu, R. X. Xu, Y. Xu, D. Yang, Y. You, S. Yu, X. Yu, B. Zhang, H. Zhang, L. Zhang, L. Zhang, M. Zhang, M. Zhang, W. Zhang, Y. Zhang, C. Zhao, Y. Zhao, S. Zhou, S. Zhou, Q. Zhu, and Y. Zou. Deepseek llm: Scaling open-source language models with longtermism, 2024.

- [13] Z. Du, Y. Qian, X. Liu, M. Ding, J. Qiu, Z. Yang, and J. Tang. Glm: General language model pretraining with autoregressive blank infilling. In Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pages 320–335, 2022.

- [14] Y. Fu, L. Ou, M. Chen, Y. Wan, H. Peng, and T. Khot. Chain-of-thought hub: A continuous effort to measure large language models’ reasoning performance. arXiv preprint arXiv:2305.17306, 2023.

- [15] Z. Gou, Z. Shao, Y. Gong, Y. Shen, Y. Yang, M. Huang, N. Duan, and W. Chen. Tora: A tool-integrated reasoning agent for mathematical problem solving, 2023.

- [16] D. Hendrycks, C. Burns, S. Basart, A. Zou, M. Mazeika, D. Song, and J. Steinhardt. Measuring massive multitask language understanding. Proceedings of the International Conference on Learning Representations (ICLR), 2021.

- [17] D. Hendrycks, C. Burns, S. Kadavath, A. Arora, S. Basart, E. Tang, D. Song, and J. Steinhardt. Measuring mathematical problem solving with the math dataset. arXiv preprint arXiv:2103.03874, 2021.

- [18] K. M. Hermann, T. Kocisky, E. Grefenstette, L. Espeholt, W. Kay, M. Suleyman, and P. Blunsom. Teaching machines to read and comprehend. In C. Cortes, N. Lawrence, D. Lee, M. Sugiyama, and R. Garnett, editors, Advances in Neural Information Processing Systems, volume 28. Curran Associates, Inc., 2015.

- [19] Z. Hou, Y. Niu, Z. Du, X. Zhang, X. Liu, A. Zeng, Q. Zheng, M. Huang, H. Wang, J. Tang, and Y. Dong. Chatglm-rlhf: Practices of aligning large language models with human feedback, 2024.

- [20] J. Kaplan, S. McCandlish, T. Henighan, T. B. Brown, B. Chess, R. Child, S. Gray, A. Radford, J. Wu, and D. Amodei. Scaling laws for neural language models. arXiv preprint arXiv:2001.08361, 2020.

- [21] P. Ke, B. Wen, Z. Feng, X. Liu, X. Lei, J. Cheng, S. Wang, A. Zeng, Y. Dong, H. Wang, et al. Critiquellm: Scaling llm-as-critic for effective and explainable evaluation of large language model generation. arXiv preprint arXiv:2311.18702, 2023.

- [22] R. Koncel-Kedziorski, S. Roy, A. Amini, N. Kushman, and H. Hajishirzi. Mawps: A math word problem repository. In Proceedings of the 2016 conference of the north american chapter of the association for computational linguistics: human language technologies, pages 1152–1157, 2016.

- [23] V. Kumar, R. Maheshwary, and V. Pudi. Adversarial examples for evaluating math word problem solvers. In Findings of the Association for Computational Linguistics: EMNLP 2021, pages 2705–2712, 2021.

- [24] T. Kwiatkowski, J. Palomaki, O. Redfield, M. Collins, A. Parikh, C. Alberti, D. Epstein, I. Polosukhin, J. Devlin, K. Lee, et al. Natural questions: a benchmark for question answering research. Transactions of the Association for Computational Linguistics, 7:453–466, 2019.

- [25] H. Lee, S. Phatale, H. Mansoor, T. Mesnard, J. Ferret, K. Lu, C. Bishop, E. Hall, V. Carbune, A. Rastogi, and S. Prakash. Rlaif: Scaling reinforcement learning from human feedback with ai feedback, 2023.

- [26] Y. Li, Y. Zhang, Z. Zhao, L. Shen, W. Liu, W. Mao, and H. Zhang. CSL: A large-scale Chinese scientific literature dataset. In Proceedings of the 29th International Conference on Computational Linguistics, pages 3917–3923. International Committee on Computational Linguistics, Oct. 2022.

- [27] H. Lightman, V. Kosaraju, Y. Burda, H. Edwards, B. Baker, T. Lee, J. Leike, J. Schulman, I. Sutskever, and K. Cobbe. Let’s verify step by step, 2023.

- [28] W. Ling, D. Yogatama, C. Dyer, and P. Blunsom. Program induction by rationale generation: Learning to solve and explain algebraic word problems. In Proceedings of the 55th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pages 158–167, 2017.

- [29] X. Liu, X. Lei, S. Wang, Y. Huang, Z. Feng, B. Wen, J. Cheng, P. Ke, Y. Xu, W. L. Tam, et al. Alignbench: Benchmarking chinese alignment of large language models. arXiv preprint arXiv:2311.18743, 2023.

- [30] X. Liu, H. Yu, H. Zhang, Y. Xu, X. Lei, H. Lai, Y. Gu, H. Ding, K. Men, K. Yang, et al. Agentbench: Evaluating llms as agents. arXiv preprint arXiv:2308.03688, 2023.

- [31] H. Luo, Q. Sun, C. Xu, P. Zhao, J. Lou, C. Tao, X. Geng, Q. Lin, S. Chen, and D. Zhang. Wizardmath: Empowering mathematical reasoning for large language models via reinforced evol-instruct. arXiv preprint arXiv:2308.09583, 2023.

- [32] S. Mishra, A. Mitra, N. Varshney, B. Sachdeva, P. Clark, C. Baral, and A. Kalyan. Numglue: A suite of fundamental yet challenging mathematical reasoning tasks. In Proceedings of the 60th Annual Meeting of the Association for Computational Linguistics (Volume 1: Long Papers), pages 3505–3523, 2022.

- [33] S. Narayan, S. B. Cohen, and M. Lapata. Don’t give me the details, just the summary! Topicaware convolutional neural networks for extreme summarization. In Proceedings of the 2018 Conference on Empirical Methods in Natural Language Processing, Brussels, Belgium, 2018.

- [34] OpenAI. Gpt-4 technical report, 2023.

- [35] L. Ouyang, J. Wu, X. Jiang, D. Almeida, C. Wainwright, P. Mishkin, C. Zhang, S. Agarwal, K. Slama, A. Ray, et al. Training language models to follow instructions with human feedback. Advances in Neural Information Processing Systems, 35:27730–27744, 2022.

- [36] K. Paster. Testing language models on a held-out high school national finals exam. https: //huggingface.co/datasets/keirp/hungarian_national_hs_finals_exam, 2023.

- [37] S. Polu and I. Sutskever. Generative language modeling for automated theorem proving. arXiv preprint arXiv:2009.03393, 2020.

- [38] R. Rafailov, A. Sharma, E. Mitchell, S. Ermon, C. D. Manning, and C. Finn. Direct preference optimization: Your language model is secretly a reward model, 2023.

- [39] D. Saxton, E. Grefenstette, F. Hill, and P. Kohli. Analysing mathematical reasoning abilities of neural models. arXiv preprint arXiv:1904.01557, 2019.

- [40] T. L. Scao, A. Fan, C. Akiki, E. Pavlick, S. Ili ́c, D. Hesslow, R. Castagné, A. S. Luccioni, F. Yvon, M. Gallé, et al. Bloom: A 176b-parameter open-access multilingual language model. arXiv preprint arXiv:2211.05100, 2022.

- [41] Y. Shao, L. Li, J. Dai, and X. Qiu. Character-llm: A trainable agent for role-playing, 2023.

- [42] M. Suzgun, N. Scales, N. Schärli, S. Gehrmann, Y. Tay, H. W. Chung, A. Chowdhery, Q. V. Le, E. H. Chi, D. Zhou, et al. Challenging big-bench tasks and whether chain-of-thought can solve them. arXiv preprint arXiv:2210.09261, 2022.

- [43] I. Team. Internlm: A multilingual language model with progressively enhanced capabilities. https://github.com/InternLM/InternLM, 2023.

- [44] H. Touvron, T. Lavril, G. Izacard, X. Martinet, M.-A. Lachaux, T. Lacroix, B. Rozière, N. Goyal, E. Hambro, F. Azhar, et al. Llama: Open and efficient foundation language models. arXiv preprint arXiv:2302.13971, 2023.

- [45] H. Touvron, L. Martin, K. Stone, P. Albert, A. Almahairi, Y. Babaei, N. Bashlykov, S. Batra, P. Bhargava, S. Bhosale, D. Bikel, L. Blecher, C. C. Ferrer, M. Chen, G. Cucurull, D. Esiobu, J. Fernandes, J. Fu, W. Fu, B. Fuller, C. Gao, V. Goswami, N. Goyal, A. Hartshorn, S. Hosseini, R. Hou, H. Inan, M. Kardas, V. Kerkez, M. Khabsa, I. Kloumann, A. Korenev, P. S. Koura, M.-A. Lachaux, T. Lavril, J. Lee, D. Liskovich, Y. Lu, Y. Mao, X. Martinet, T. Mihaylov, P. Mishra, I. Molybog, Y. Nie, A. Poulton, J. Reizenstein, R. Rungta, K. Saladi, A. Schelten, R. Silva, E. M. Smith, R. Subramanian, X. E. Tan, B. Tang, R. Taylor, A. Williams, J. X. Kuan, P. Xu, Z. Yan, I. Zarov, Y. Zhang, A. Fan, M. Kambadur, S. Narang, A. Rodriguez, R. Stojnic, S. Edunov, and T. Scialom. Llama 2: Open foundation and fine-tuned chat models, 2023.

- [46] Q. Tu, S. Fan, Z. Tian, and R. Yan. Charactereval: A chinese benchmark for role-playing conversational agent evaluation, 2024.

- [47] M. Völske, M. Potthast, S. Syed, and B. Stein. TL;DR: Mining Reddit to learn automatic summarization. In L. Wang, J. C. K. Cheung, G. Carenini, and F. Liu, editors, Proceedings of the Workshop on New Frontiers in Summarization, pages 59–63, Copenhagen, Denmark, Sept. 2017. Association for Computational Linguistics.

- [48] P. Wang, L. Li, Z. Shao, R. X. Xu, D. Dai, Y. Li, D. Chen, Y. Wu, and Z. Sui. Math-shepherd: Verify and reinforce llms step-by-step without human annotations, 2023.

- [49] X. Wang, J. Wei, D. Schuurmans, Q. Le, E. Chi, S. Narang, A. Chowdhery, and D. Zhou. Self-consistency improves chain of thought reasoning in language models, 2023.

- [50] Y. Wang, X. Liu, and S. Shi. Deep neural solver for math word problems. In M. Palmer, R. Hwa, and S. Riedel, editors, Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing, pages 845–854, Copenhagen, Denmark, Sept. 2017. Association for Computational Linguistics.

- [51] J. Wei, X. Wang, D. Schuurmans, M. Bosma, B. Ichter, F. Xia, E. Chi, Q. Le, and D. Zhou. Chain-of-thought prompting elicits reasoning in large language models, 2023.

- [52] T. Wei, J. Luan, W. Liu, S. Dong, and B. Wang. Cmath: Can your language model pass chinese elementary school math test?, 2023.

- [53] C. Yang, X. Wang, Y. Lu, H. Liu, Q. V. Le, D. Zhou, and X. Chen. Large language models as optimizers. arXiv preprint arXiv:2309.03409, 2023.

- [54] L. Yang, H. Yang, W. Cheng, L. Lin, C. Li, Y. Chen, L. Liu, J. Pan, T. Wei, B. Li, L. Zhao, L. Wang, B. Zhu, G. Li, X. Wu, X. Luo, and R. Hu. Skymath: Technical report, 2023.

- [55] S. Yao, D. Yu, J. Zhao, I. Shafran, T. L. Griffiths, Y. Cao, and K. Narasimhan. Tree of thoughts: Deliberate problem solving with large language models. arXiv preprint arXiv:2305.10601, 2023.

- [56] Yi. A series of large language models trained from scratch by developers at 01-ai. https: //github.com/01-ai/Yi, 2023.

- [57] L. Yu, W. Jiang, H. Shi, J. Yu, Z. Liu, Y. Zhang, J. T. Kwok, Z. Li, A. Weller, and W. Liu. Metamath: Bootstrap your own mathematical questions for large language models. arXiv preprint arXiv:2309.12284, 2023.

- [58] Z. Yuan, H. Yuan, C. Li, G. Dong, K. Lu, C. Tan, C. Zhou, and J. Zhou. Scaling relationship on learning mathematical reasoning with large language models, 2023.

- [59] Z. Yuan, H. Yuan, C. Tan, W. Wang, and S. Huang. How well do large language models perform in arithmetic tasks?, 2023.

- [60] X. Yue, X. Qu, G. Zhang, Y. Fu, W. Huang, H. Sun, Y. Su, and W. Chen. Mammoth: Building math generalist models through hybrid instruction tuning. arXiv preprint arXiv:2309.05653, 2023.

- [61] A. Zeng, X. Liu, Z. Du, Z. Wang, H. Lai, M. Ding, Z. Yang, Y. Xu, W. Zheng, X. Xia, et al. Glm-130b: An open bilingual pre-trained model. arXiv preprint arXiv:2210.02414, 2022.

- [62] D. Zhang, Z. Hu, S. Zhoubian, Z. Du, K. Yang, Z. Wang, Y. Yue, Y. Dong, and J. Tang. Sciglm: Training scientific language models with self-reflective instruction annotation and tuning, 2024.

- [63] X. Zhang, C. Li, Y. Zong, Z. Ying, L. He, and X. Qiu. Evaluating the performance of large language models on gaokao benchmark. 2023.

- [64] W. Zhao, M. Shang, Y. Liu, L. Wang, and J. Liu. Ape210k: A large-scale and template-rich dataset of math word problems, 2020.

- [65] L. Zheng, W.-L. Chiang, Y. Sheng, S. Zhuang, Z. Wu, Y. Zhuang, Z. Lin, Z. Li, D. Li, E. P. Xing, H. Zhang, J. E. Gonzalez, and I. Stoica. Judging llm-as-a-judge with mt-bench and chatbot arena, 2023.

- [66] W. Zhong, R. Cui, Y. Guo, Y. Liang, S. Lu, Y. Wang, A. Saied, W. Chen, and N. Duan. Agieval: A human-centric benchmark for evaluating foundation models, 2023.

- [67] J. Zhou, Z. Chen, D. Wan, B. Wen, Y. Song, J. Yu, Y. Huang, L. Peng, J. Yang, X. Xiao, et al. Characterglm: Customizing chinese conversational ai characters with large language models. arXiv preprint arXiv:2311.16832, 2023.

- [68] Z. Zhou, Q. Wang, M. Jin, J. Yao, J. Ye, W. Liu, W. Wang, X. Huang, and K. Huang. Mathattack: Attacking large language models towards math solving ability. arXiv preprint arXiv:2309.01686, 2023.

附录

A.案例研究

A.1 数学批判性案例分析

我们提供了若干Math-Critique的评分示例。从表6和表7的案例中,我们观察到模型给出了正确答案,但其答案格式与标准答案存在差异,主要体现在分数表达形式和未知变量选用方面。这些差异在数学上是等价的,而传统评估方法难以准确评判。然而,Math-Critique对这两个示例均给出了正确评分,并提供了合理评估。在表8的示例中,模型在计算过程中出现了错误。Math-Critique准确定位了错误所在位置,由于模型正确解决了部分问题,最终给出了3分评分。

表6:数学批判示例(1)

问题(翻译)

1/x + x^3 的原函数是什么。

参考答案:首先,我们可以将1/x + x³重写为x⁻¹ + x³,然后利用幂函数和多项式函数的微分原理求其原函数。具体可得:

∫ ( x − 1 + x 3 ) d x = ∫ x − 1 d x + ∫ x 3 d x = ln ∣ x ∣ + 1 4 x 4 + C , \int(x^{-1}+x^3)\mathrm{d}x=\int x^{-1}\mathrm{d}x+\int x^3\mathrm{d}x=\ln|x|+\frac{1}{4}x^4+C, ∫(x−1+x3)dx=∫x−1dx+∫x3dx=ln∣x∣+41x4+C,

其中C为不定积分常数。因此,1/x + x³的原函数是ln |x| + 1/4 x⁴ + C。

GLM4 标准答案

为求函数 f(x) = 1/x + x^3 的原函数(不定积分),我们需要分别对这两项进行积分。对于 1/x,其原函数为 ln|x|(自然对数)。对于 x^3,我们可以使用幂函数的积分法则,即对于 x^n(其中 n ≠ −1),其原函数为 x(n+1)/(n+1)。因此,x3 的原函数为 x^4/4。将这两项的原函数相加,我们得到 f(x) 的原函数:

∫ ( 1 x + x 3 ) d x = ln ∣ x ∣ + x 4 4 + C \int\left(\frac{1}{x}+x^3\right)dx=\ln|x|+\frac{x^4}{4}+C ∫(x1+x3)dx=ln∣x∣+4x4+C

批判结果(译文)

AI助手的回答非常准确且详尽,它正确解释了如何求解给定函数的原函数。AI助手先将函数的两部分分别积分,再将结果相加得到原函数。此外,AI助手还注意到在x=0处原函数不连续,这是一个重要的观察。总体而言,AI助手的回答与参考答案非常接近,无明显不足之处。因此,我会给予其高分。评分: [ 9 ] [9] [9]

表7:数学批判示例(2)

问题:三阶矩阵A有三个特征值0、3和5,对应的特征向量分别为u、v和w。线性方程组Ax = v + w的通解是什么?

参考答案:已知矩阵 A 的特征值为 0、3 和 5,对应的特征向量分别为 u、v 和 w。对于线性方程组 Ax = v + w,我们可以写出 Au = 0 * u,Av = 3 * v,以及 Aw = 5 * w。因此 A(1/3*v)=v,A(1/5*w)=w,将左右两边相加可得 A(1/3*v+1/5*w)= v + w。由于 Ax = v + w,故 1/3 * v + 1/5 * w 是 Ax = v + w 的一个特解。因为 Au = 0,所以 u 是 Au = 0 的基础解系,因此方程 Ax = v + w 的通解为 x = ku + 1/3 * v + 1/5 * w。

模型回答:已知三阶矩阵A的三个特征值为0、3、5,对应的特征向量分别为u、v、w。为求解线性方程组Ax = v + w的通解,可利用特征值与特征向量的性质。首先,由已知条件有Av = 3v及Aw = 5w,即v和w分别为属于特征值3和5的特征向量。原方程组Ax = v + w可改写为Ax − v − w = 0。设x表示为x = pu + qv + rw,其中p、q、r为待定系数。将x代入方程Ax − v − w = 0可得:

A ( p u + q v + r w ) − v − w = 0 A(pu+qv+rw)-v-w=0 A(pu+qv+rw)−v−w=0

因此,方程 Ax = v + w 的通解为:

x = p u + 1 3 v + 1 5 w x=pu+\frac{1}{3}v+\frac{1}{5}w x=pu+31v+51w

其中 p 为任意实数。因此,通解具有如下形式:

x = p u + 1 3 v + 1 5 w x=p\mathbf{u}+\frac{1}{3}\mathbf{v}+\frac{1}{5}\mathbf{w} x=pu+31v+51w

向量u是特征值0对应的特征向量,v和w则分别是特征值3和特征值5对应的特征向量。p为任意实数,可取任意值。

批判结果:人工智能助手的回答非常详细。它首先解释了如何利用特征值和特征向量的性质来解决这个问题,接着逐步展开详细步骤,包括重写方程、将x写成待定系数形式,然后将这些系数代入方程,最后求解系数。这个回答不仅准确,而且深入,提供了详细的解释和步骤,使读者能够理解问题的求解过程。与参考答案相比,人工智能助手的回答更为详尽和深入,因此我认为人工智能助手的回答质量非常高。评分: [ [ 9 ] ] [[9]] [[9]]。

B.提示模板

在图5中,我们展示了Math-Critique所使用的提示词中文版本示例及其对应的英文翻译。在实际应用中,我们对所有查询均使用提示词的中文版本。

数学批判提示模板

[Instruction] 请你扮演一名评审,对人工智能助手对数学问题生成的回答进行评分。你的评价需要优先考虑最终答案的正确性,其次关 注解题步骤每一步的正确性,并严格按照下面的评分标准进行评分: 1)分数:1~2, 标准:最终答案完全错误,并且解答过程中错误出现很早,即解答刚开始便出现明显错误。 2)分数:3~5, 标准:最终答案错误,且解题过程前半部分正确,但后半部分中出现错误。 3)分数:6~8, 标准:最终答案正确,但中间步骤出现部分错误。 4)分数:9~10, 标准:最终答案完全正确,且解题步骤完全正确。 我会提供一段参考答案和人工智能助手的答案,请你以参考答案为基础对人工智能助手的答案尽可能客观地评价。请你输 出 1) 首先提供一段简短的解释,用来评价人工智能助手回答的质量,如有最终答案错误或者步骤错误,请指出并简单解 释;2) 然后给出评估分数,必须严格按照以下格式进行评分:“[[rating]]”,例如:“评分:[[4]]”. [Question] 设 X 服从泊松分布 P(λ),且 E[(X-1)(X-2)]=1,则 λ 等于? [The Start of Reference Answer] 首先我们需要知道泊松分布的期望是 λ,方差是 λ。由题意,E[(X-1)(X-2)]=1,所以 E[(X-1)(X-2)]=E[X^2]-3E[X]+2=1 DX=EX2-EX2 EX2=λ+λ2 解这个方程我们可以得到 λ=1 [The End of Reference Answer] [The Start of Assistant’s Answer] 设随机变量 X 服从泊松分布 P(λ),我们知道泊松分布的期望值 E[X]等于 λ,方差 Var[X]也等于 λ。 根据题目条件,我们有: E[(X-1)(X-2)] = 1 因为 X 服从泊松分布,我们可以利用二项式定理展开 (X-1)(X-2),然后将其与期望值相乘以找到 λ。 (X-1)(X-2) = X^2 - 3X + 2 展开后得到: E[X^2 - 3X + 2] = 1 我们知道 E[X^2] = Var[X] + (E[X])^2,且 E[X] = λ。因此,我们可以将 E[X^2]替换为 λ^2 + λ,并且知道 E[X] = λ。 所以,我们有: λ^2 + λ - 3λ + 2 = 1 解这个方程得到 λ = 1。 所以,λ 的值为 1。 [The End of Assistant’s Answer]

图5:数学批判模型的提示模板及示例。

C 评估设置

C.1 学术数据集评估设置

鉴于我们专注于评估零样本能力,传统答案验证方法无法提供准确评估。因此,我们调整了评估方法如下:

-

提取响应最后一句(以双换行符为界)或提示模型以"因此,答案是"为开头生成内容。

-

对于数值类标准答案,响应内容经过以下识别流程:LaTeX格式的分数或小数,以及常规分数、小数或整数。我们会计算数值结果并与标准答案比对。差异小于(1e-6)即判定为正确。

-

对于字符串类标准答案(仅限MATH数据集):识别“xxx是”或等号后的内容,或boxed{}内的内容。评估时以规范化后的字符串是否匹配为准。

对于英文数据集GSM8k和MATH,我们选取结果的原则如下:

- 若模型本身报告了这两个数据集的结果,则选取其零样本或少样本结果中较高者。

- 若模型未报告自身结果,则采用OpenCompass报告的结果,同样选取零样本或少样本中较高的数值。此原则适用于GPT-4-0613、GPT-3.5-Turbo-0613、Yi-6B-Chat及Qwen-Chat-7B等模型。若上述来源均未涵盖,则不予报告结果。

对于匈牙利考试结果,我们依据评分标准(参考自文献[36])由标注者进行评分。需说明的是,所报告的结果实际为所有题目得分之和,因此总分实为117分。为与已报告结果保持一致,我们亦采用此计分方式。

为确保可复现性,我们所有实验结果均在采样温度为0、最大序列长度设为4096的条件下获得。

C.2 2023年匈牙利全国高中数学决赛评估设置

在匈牙利国家高中数学决赛中,我们将模型的答案提交给标注员进行评分。对于未在文献[36]中列出的模型结果,我们依据[36]提供的答案按得分点进行评分。我们汇总所有题目的得分以呈现总分。所有标注均由两名标注员完成;若出现不一致,则由第三名标注员裁定。考虑到多模型的普遍情况,我们未限制语言模型答题所使用的语言。任何用于正确答题的语言均视为有效。此外,由于大多数题目未限制答案形式,我们规定只要答案保留至少一位小数精度或以分数形式提供,即被视为正确。

D 补充结果

D.1 MathUserEval 子类别结果

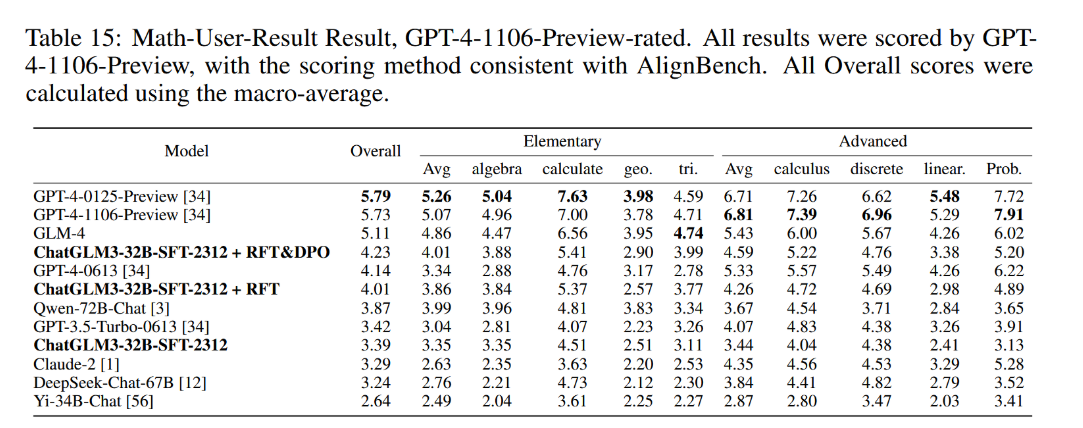

在表15中,我们展示了MathUserEval所有子集的评估结果。所报告的结果均由GPT-4-1106-Preview进行评估,评估方法与AlignBench保持一致。值得注意的是,GPT-4-0125-Preview和GPT-4-1106-Preview仍占据领先位置。除概率论外,GLM4模型的总分及各分项得分均超越了GPT-4-0613。我们的GLM-Math-32B w/ DPO模型在初等数学类别表现尤为突出,超过了GPT-4-0613,但在高等数学领域仍存在显著差距。我们的自我批判训练方法在MathUserEval上取得了显著进展,整体性能提升了24%。

表15:数学用户结果评估(GPT-4-1106-Preview评分)。所有结果均由GPT4-1106-Preview评分,评分方法与AlignBench保持一致。所有综合分数均通过宏平均计算得出。

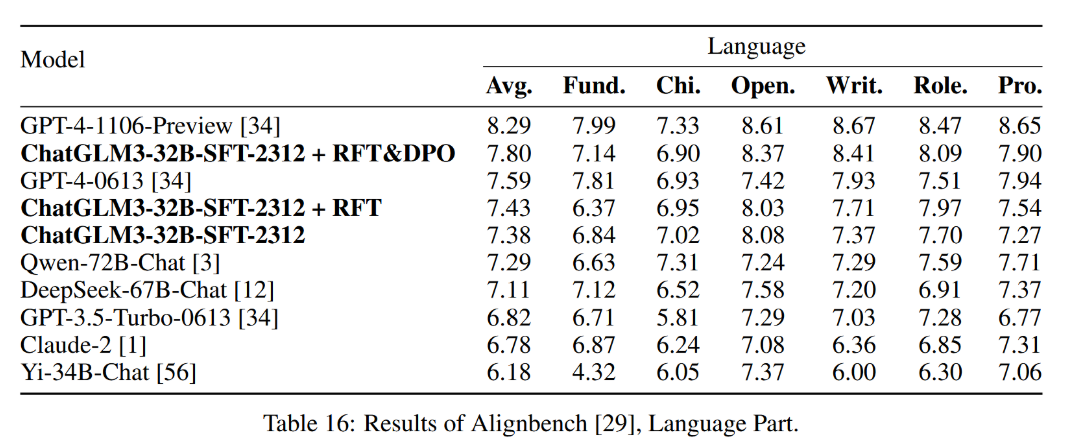

D.2 Alignbench 子类别评估结果 [29]

表16呈现了AlignBench语言能力子项的详细评估结果。其中,我们展示了所开发的四个模型的得分,并对Qwen-72B-Chat [3]、Claude-2 [1]和Yi-34B-Chat [56]进行了结果测试。其余结果引自AlignBench论文,而DeepSeek的结果则取自其技术报告[12]。

表 16:Alignbench [29] 语言部分评测结果。

ChatGLM3-32B-SFT-2312 是 ChatGLM 系列的新版本,尽管模型规模相同,但其与文献[19]中讨论的模型并不一致。

更多推荐

已为社区贡献20条内容

已为社区贡献20条内容

所有评论(0)