程序员福音!RAG系统6大幻觉全攻略+文生图黑科技,小白也能秒懂!

文章介绍了RAG系统的6类幻觉问题及4个缓解策略,包括过度自信、过时性等类型,以及预检索查询优化、后检索参考识别等阶段;同时探讨了科研文生图方案,对比了直接画像素与先写代码再生成图两种方法,介绍了"科学画图考试题库"(SciGenBench)。研究显示,代码生成的图像精准度更高,直接画像素的视觉效果更优,使用高质量图像训练大模型可显著提升其解题能力。

继续看技术,看几个点。

关于RAG幻觉的内容,我们讲过很多,这次再回顾下,温故知新,看一个技术总结。

另一个是看看文生科学图【教材这种学科图】这块的点,对比下已有方案,有一些设计思路。

技术总是有趣的,从基本问题出发,多总结,多归纳,**多从底层实现分析逻辑,**会有收获。

一、RAG系统的6个幻觉问题及4个缓解阶段策略总结

来看RAG的的幻觉问题,其实RAG本身通过融合外部知识库提升事实依据,输出可信度与可解释性,但检索器与生成器的复杂交互引入新幻觉(如检索过时/无关信息导致误导)。

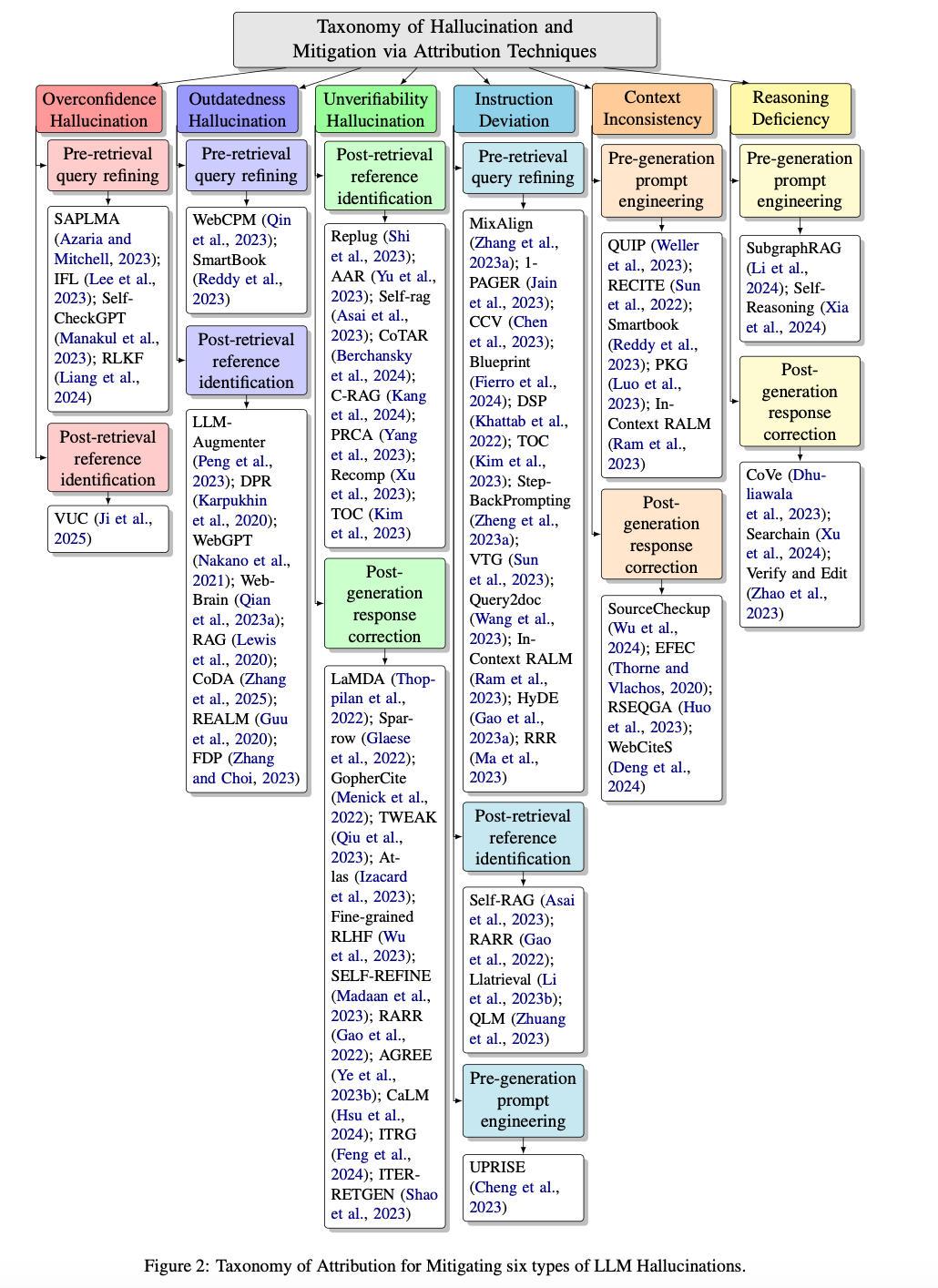

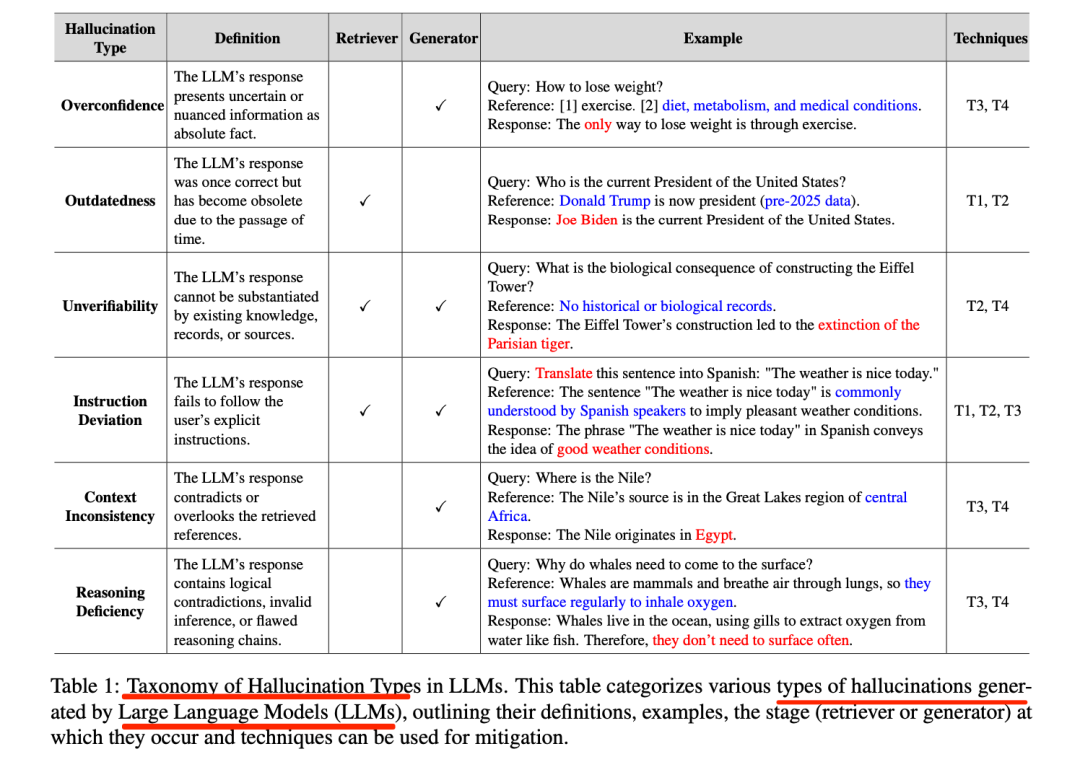

所以,针对这个问题,可以再搞了包含查询优化(T1)、参考识别(T2)、提示工程(T3)、响应修正(T4)的归因流水线,具体工作在《Attribution Techniques for Mitigating Hallucinated Information in RAG Systems: A Survey》(https://arxiv.org/pdf/2601.19927),还定了个涵盖过度自信、过时性、不可验证性、指令偏离、上下文不一致、推理缺陷的6类RAG特有幻觉分类体系,是一个不错的索引,如下图所示:

我们总结性看幻觉类型体系以及对应的缓解策略

1、RAG系统的6个幻觉类型

RAG系统特有6类幻觉,核心区别在于定义与发生阶段,核心依据是幻觉源于检索器(证据质量问题)还是生成器(内容生成问题),具体分为如下几个:

一个是过度自信(生成器阶段,不确定信息绝对化)。缓解方案有包括T3(VUC添加模糊词)、T4(RLKF校准置信度、SelfCheckGPT多响应一致性校验)。

一个是过时性(检索器阶段,信息因时间失效)。缓解方案有包括T1(添加时间关键词)、T2(DPR评估时效性、WebGPT实时检索)

一个是不可验证性(检索器+生成器阶段,缺乏足够参考支持)。缓解方案有包括T2(REPLUG重排参考)、T4(Self-Refine补充证据、AGREE检测未验证内容)。

一个是指令偏离(检索器+生成器阶段,未遵循用户指令)。缓解方案有包括T1(MixAlign澄清模糊查询)、T2(Self-RAG语义对齐重排)、T3(UPRISE匹配提示模板)。

一个是上下文不一致(生成器阶段,与检索参考矛盾)。缓解方案有包括T3(RECITE引导引用参考)、T4(SourceCheckup语句级一致性校验)

一个是推理缺陷(生成器阶段,逻辑矛盾或推理链断裂)。缓解方案有包括T3(SubgraphRAG结构化推理提示)、T4(SearChain修正推理链)

2、缓解幻觉的四个模块T1至T4

4个模块按“检索前-检索后-生成前-生成后”流程,其中:

检索器导向(T1、T2) 聚焦生成前的证据质量优化,提升检索内容的相关性、时效性、可验证性;**生成器导向(T3、T4)**聚焦生成过程与结果的校准,规范生成逻辑、修正事实错误、校准置信度。

具体的:

预检索查询优化(T1)阶段,优化原始查询,提升检索相关性与时效性,将原始查询q优化为q’,提升检索相关性与时效性。

代表性的有SmartBook(添加时间关键词)、WebCPM(同义词替换/释义)

后检索参考识别(T2)阶段,筛选核心参考内容,解决不可验证性、过时性幻觉,从检索结果R’中筛选核心参考R_final。

代表方案有:DPR(稠密检索)、CoDA(优先时效性参考)、SELF-RAG(重排参考)

预生成提示工程(T3)阶段,构建结构化提示,引导生成器接地,缓解过度自信、推理缺陷等;

代表方案有VUC(添加模糊限制词)、UPRISE(动态选择提示模板)、SubgraphRAG(知识图谱结构化提示)

后生成响应修正(T4)阶段,校验并修正生成结果,修正上下文不一致、不可验证性等残留幻觉。

代表方案有:A_gen RLKF(奖励模型惩罚虚假自信)、Self-Refine(自我批判修正)、CoVe(验证链修正)

二、再看科研文生图方案及评估思路

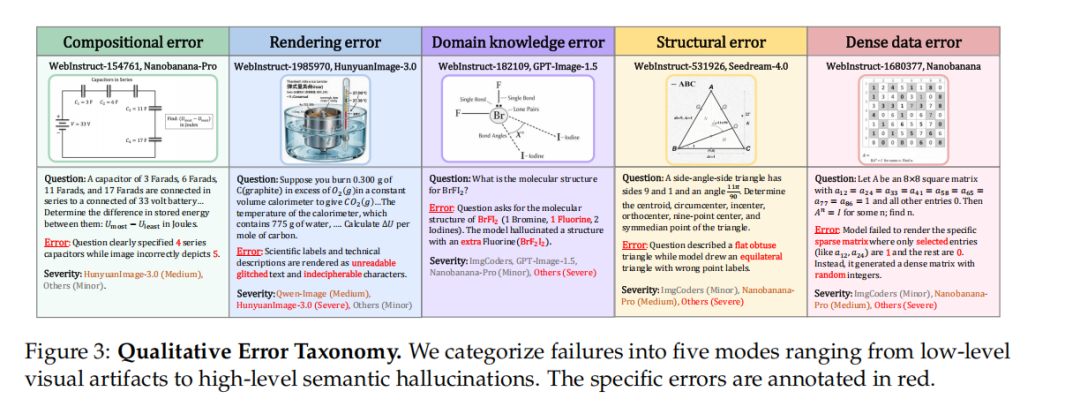

接着看科研文生图方案及评估进展,讲的故事是现有AI画图(比如画物理受力图、化学分子结构)看着像那么回事,但经常犯科学错误,比如把三角形角度画错、分子键数不对,这就是“看着对、逻辑错”。

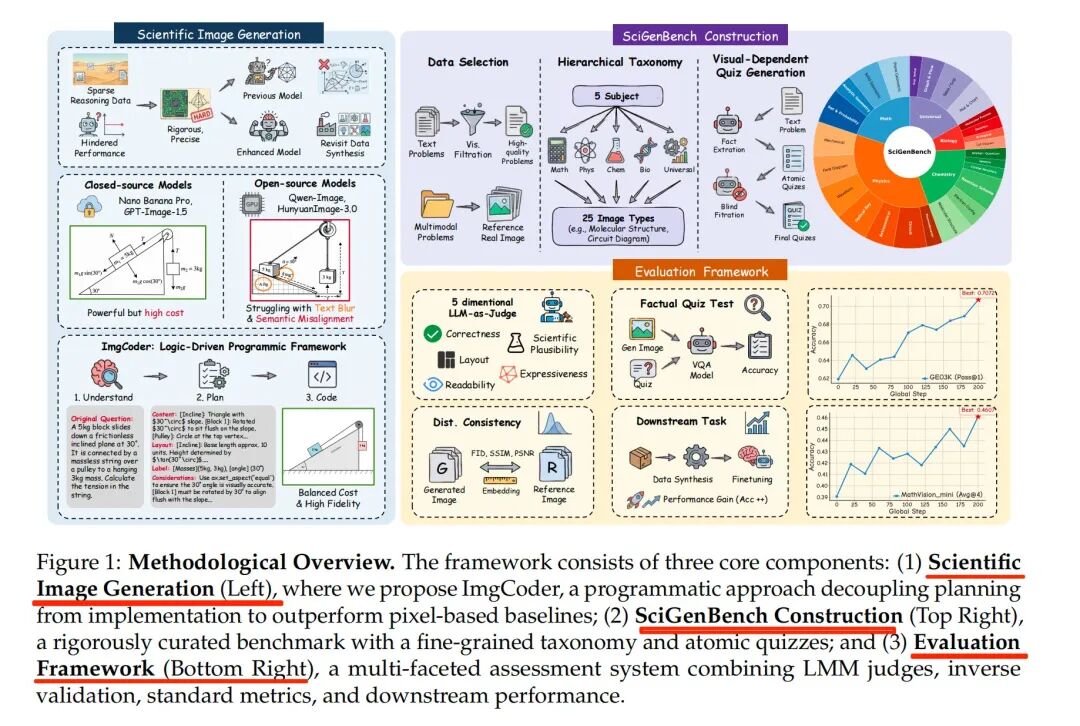

所以,就搞点故事,工作在《Scientific Image Synthesis: Benchmarking, Methodologies, and Downstream Utility》,https://SciGenbench.github.io,https://arxiv.org/pdf/2601.17027,做个比对实验,搞个数据,然后对比下。

具体看:

1、两种画图思路对比

一种是直接画像素(比如常见的AI画图工具) 【端到端将文本描述转换为像素图像,闭源:Nanobanana-Pro、GPT-Image-1.5、Flux2-flex,开源:HunyuanImage-3.0、Qwen-Image】,优点是画得好看逼真,缺点是容易出错;

另一种是先写代码再生成图(他们叫ImgCoder) 【理解(提取实体与关系)→规划(定义内容、布局、标签、约束)→编码(生成可执行代码),如ImgCoder(Qwen3-ImgCoder、Gemini3-Pro-ImgCoder等变体)】,比如用Python代码定义好坐标、角度再画图,优点是绝对精准,缺点是样式比较单一,不够生动;

2、建专门的“科学画图考试题库”(SciGenBench)

数据集上,包含数学、物理、化学、生物等5个学科,25种图(比如电路图、分子结构、几何图形),共1400道题,专门用来测试AI画的图“科不科学”,而不是只看“好不好看”;

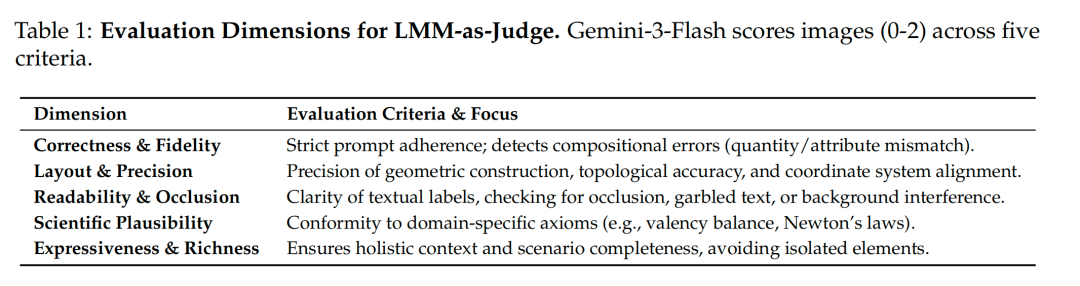

然后,效果评估方面,使用Gemini3-Flash评分(0-2分),评5项指标:正确性与保真度、布局与精度、可读性与遮挡、科学合理性、表现力与丰富度【这是维度设计】

结论方面,用代码画图的ImgCoder在精准度上更高,比如画函数曲线不会错),直接画像素的AI在视觉效果上更优;

用这些画得又对又好的图去训练大模型【使用合成图像微调Qwen3-VL-8B-Instruct】,能让大模型做科学题(比如几何证明、物理计算)的能力变强【绝对提升3.7分】,数据越多效果越好。

。## 学AI大模型的正确顺序,千万不要搞错了

🤔2026年AI风口已来!各行各业的AI渗透肉眼可见,超多公司要么转型做AI相关产品,要么高薪挖AI技术人才,机遇直接摆在眼前!

有往AI方向发展,或者本身有后端编程基础的朋友,直接冲AI大模型应用开发转岗超合适!

就算暂时不打算转岗,了解大模型、RAG、Prompt、Agent这些热门概念,能上手做简单项目,也绝对是求职加分王🔋

📝给大家整理了超全最新的AI大模型应用开发学习清单和资料,手把手帮你快速入门!👇👇

学习路线:

✅大模型基础认知—大模型核心原理、发展历程、主流模型(GPT、文心一言等)特点解析

✅核心技术模块—RAG检索增强生成、Prompt工程实战、Agent智能体开发逻辑

✅开发基础能力—Python进阶、API接口调用、大模型开发框架(LangChain等)实操

✅应用场景开发—智能问答系统、企业知识库、AIGC内容生成工具、行业定制化大模型应用

✅项目落地流程—需求拆解、技术选型、模型调优、测试上线、运维迭代

✅面试求职冲刺—岗位JD解析、简历AI项目包装、高频面试题汇总、模拟面经

以上6大模块,看似清晰好上手,实则每个部分都有扎实的核心内容需要吃透!

我把大模型的学习全流程已经整理📚好了!抓住AI时代风口,轻松解锁职业新可能,希望大家都能把握机遇,实现薪资/职业跃迁~

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献611条内容

已为社区贡献611条内容

所有评论(0)