一块显卡卖到几十万:大模型时代,显存为什么比黄金还珍贵

摘要: 显存(VRAM)已成为大模型训练的关键瓶颈,远超内存(RAM)的重要性。7B参数的模型仅权重就需约28GB显存,而训练中的梯度、优化器状态和激活值进一步加剧消耗。FP16、INT8等精度优化及QLoRA技术可降低需求,但激活值仍占显存大头。H100显卡因80GB HBM3显存和3.35TB/s带宽成为首选,但其高昂价格促使团队转向云端租赁。理解显存机制对资源规划至关重要,开发者需权衡精度、

那个让无数开发者失眠的夜晚

"CUDA out of memory. Tried to allocate 2.50 GiB. GPU 0 has 24.00 GiB total."

深夜十一点,某AI创业公司的技术负责人张工看着屏幕上的报错信息,陷入了深深的绝望。为了跑通这个7B参数的微调实验,他已经连续加班三天,尝试了各种优化手段,结果还是卡在显存不足这道鬼门关上。

"24GB显存不够?那我再加一块,总共48GB总该够了吧?"

答案是:不够。哪怕是两块RTX 4090组在一起,64GB的显存对于某些训练任务来说依然是杯水车薪。张工不是第一个被显存问题折磨的开发者,也不会是最后一个。在大模型时代,显存已经成为了比黄金还稀缺的资源,一块H100显卡被炒到几十万的价格,背后正是这个残酷的现实。

为什么显存这么重要?它到底装了什么?为什么总是不够用?本文将从硬件原理到软件消耗,全面解析显存背后的秘密,帮助你理解这个制约大模型发展的关键瓶颈。

显存与内存:一对经常被混淆的概念

在讨论显存之前,我们需要先厘清两个经常被混淆的概念:显存(VRAM,Video RAM)和内存(RAM,Random Access Memory)。

简单来说,内存是CPU和系统之间的"中转站",负责临时存储CPU正在处理的数据和指令,速度快但容量有限;显存则是GPU专用的"工作台",专门用来存放GPU需要处理的数据和计算结果,速度极快但价格昂贵。

两者的差异体现在多个层面。首先是带宽——GDDR6X显存的带宽可以达到1TB/s以上,而DDR5内存的带宽只有100GB/s左右。这意味着GPU可以在极短的时间内读取和写入大量数据,这是它能够高效处理并行计算的关键。其次是容量——消费级显卡通常配备8GB到24GB显存,而服务器内存动辄就是几百GB。容量的差距,决定了两者适合处理的任务类型完全不同。

在大模型场景下,显存的重要性被无限放大。因为大模型的参数规模太大了——一个7B参数的模型,如果用FP32精度存储,仅仅模型权重就需要约28GB的显存。这已经超过了大多数消费级显卡的容量上限。更不用说训练过程中还需要存储梯度、优化器状态、激活值等中间结果。

模型权重:显存消耗的"冰山一角"

很多初学者会有一个误解:显存就是用来存放模型权重的。这个理解只对了一半。模型权重确实是显存消耗的重要组成部分,但它只是冰山一角。

如果你的目标是减少显存占用,不能只盯着模型权重这一个因素。优化器选择、训练精度、batch size、模型结构等都会显著影响显存消耗。

精度之争:FP32、FP16、INT8、INT4意味着什么

在讨论显存计算时,精度是一个绕不开的话题。不同的精度格式,模型占用的显存相差巨大。

FP32(32位浮点数)是传统的标准精度。每个参数占用4字节,精度最高,但显存消耗也最大。现在的模型训练和推理中,FP32已经很少使用。

FP16(16位浮点数)是目前最主流的训练精度。每个参数只占用2字节,显存消耗减半,同时大多数任务的精度损失可以忽略不计。在A100、H100等高端GPU上,FP16的训练效率甚至比FP32更高。

INT8和INT4是量化后的低精度格式。INT8每个参数占用1字节,INT4只占用0.5字节。量化可以大幅降低显存和计算需求,但会带来一定的精度损失。量化推理已经非常成熟,但量化训练(尤其是INT4训练)仍是研究前沿。

QLoRA等技术的出现,使得在消费级显卡上微调大模型成为可能。QLoRA的核心思想是:将模型量化到4位精度进行存储,在训练时将权重反量化为16位进行计算,同时使用LoRA适配器来更新低秩矩阵。这种方法将7B模型的全量微调显存需求降低到了16GB左右,让RTX 4090也能跑起来。

激活值:被忽视的显存"黑洞"

在模型权重、梯度、优化器状态之外,激活值(Activations)是另一个显存消耗大户,却经常被忽视。

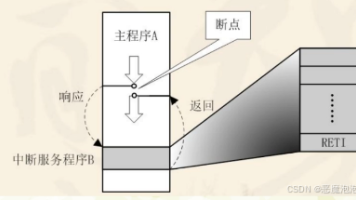

激活值是神经网络各层计算产生的中间结果。在前向传播过程中,每一层都会产生新的激活值,这些值需要保留到反向传播时用于计算梯度。对于深层网络或长序列输入,激活值的显存占用可能超过模型本身。

以LLaMA-2 7B为例,其网络层数为32层。如果处理长度为2048的序列,batch size为1,单是激活值就可能占用10GB以上的显存。如果增大batch size到8,激活值占用可能飙升到80GB。

一些实用的激活值优化策略包括:

梯度检查点(Gradient Checkpointing)是一种常用的技术。原理很简单:不是保存所有层的激活值,而是在前向传播时只保存部分关键节点的激活值,其他节点在反向传播时重新计算。这种方法可以将激活值的显存占用减少到原来的30%左右,代价是增加约20%的计算时间。

序列分块(Sequence Chunking)也是有效的策略。将长序列分成多个较短的块分别处理,可以显著降低峰值激活值占用。但这种方法会增加计算步骤,需要权衡利弊使用。

为什么H100比RTX 4090贵那么多

理解了显存的消耗构成后,我们再来回答一个困扰很多开发者的问题:为什么H100显卡的价格是RTX 4090的十倍以上?它们之间到底有什么区别?

H100和RTX 4090虽然都采用NVIDIA的架构,但定位完全不同。RTX 4090是面向消费者的游戏显卡,配备24GB GDDR6X显存;H100是面向数据中心的训练卡,配备80GB HBM3显存。

HBM3显存是H100的核心优势。这种堆叠式设计的显存,不仅容量大(80GB),而且带宽极高(3.35TB/s),能够支撑大规模并行训练的数据吞吐需求。对于需要微调大模型的团队来说,H100的效率优势可以显著缩短训练周期,降低时间成本。

对于资源有限的团队来说,租赁云端GPU资源是一种务实的选择。[LLaMA-Factory Online](https://www.llamafactory.com.cn/register?utm_source=jslt_csdn_ldd)平台提供了多种GPU资源配置,包括A100、H800等高端显卡,支持按需付费模式。相比自建机房的高昂投入和运维成本,云端租赁可以让你专注于模型和数据本身,而不必为硬件问题头疼。

显存是大模型时代的稀缺资源。理解它的工作原理和消耗规律,是进行有效资源规划的前提。希望这篇文章能够帮助你在面对显存问题时做出更明智的决策,也期待你在实践中不断积累经验,找到最适合自己的解决方案。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)