AI大模型部署大模型 -为什么要部署这么多大模型-前言篇

本文针对公司大模型部署需求,用通俗易懂的比喻解释了多组件协同部署的必要性。将Ollama比作"预装AI大脑"用于快速测试,Xinference比作"企业服务器"提供生产级服务,Dify比作"可视化组装平台"整合应用。通过"AI工厂"的类比,说明不同云平台的分工策略:腾讯云部署前端(贵但稳定),AutoDL运行核心模型(

·

公司要做很多大模型部署,很多同事都有点蒙,为了更好的工作,我先了解了一下

为什么要部署这么多组件?——给运维兄弟的明白话指南

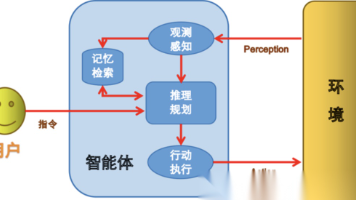

一、先看我们要搭建的“AI工厂”国内主要的几个大模型

【腾讯云】 【AutoDL 1号机房】 【AutoDL 2号机房】

│ │ │

▼ ▼ ▼

Dify平台 Ollama服务 Xinference服务

(组装车间) (主生产线) (辅生产线)

│ │ │

└──────────────────┼──────────────────────────┘

│

↓ 协同工作 ↓

【完整的AI应用系统】

二、每个组件都是干什么的?(给运维的直白解释)

1. Ollama(AutoDL上)—— “预装好的AI大脑”

- 是什么:一键启动大模型的工具包

- 好比:买了个“预装了Windows的电脑”,开机就能用

- 部署它干啥用:

- 测试不同模型(DeepSeek、Qwen等)哪个适合我们

- 给开发人员快速验证想法用

- 运维价值:不用自己配CUDA、不用编译,省了80%的部署时间

2. Xinference(AutoDL上)—— “正规的AI服务器”

- 是什么:能同时运行多个模型的生产级服务

- 好比:从“个人电脑”升级到“企业服务器”

- 部署它干啥用:

- Embedding模型:把文档转换成“数学指纹”,方便搜索

- Rerank模型:给搜索结果排序,把最相关的放前面

- 支持多用户同时访问,有API、有监控

- 运维价值:这才是能上生产环境的东西,有日志、能扩容

3. Dify(腾讯云上)—— “拖拉拽的AI应用组装平台”

- 是什么:不用写代码就能搭建AI应用的可视化工具

- 好比:用PPT做演示 vs 用Word写代码

- 部署它干啥用:

- 把前面部署的模型能力“连线”成一个完整应用

- 让产品经理也能配置AI流程,不用事事找开发

- 管理知识库、监控使用情况、控制权限

- 运维价值:统一入口,好维护,有界面,出问题好排查

三、那为什么非要分三个地方部署?

成本最优策略

腾讯云(稳定但贵):放Dify和前端

↓ 调用

AutoDL GPU机(便宜但可能断):放Ollama跑大模型

↓ 配合

AutoDL 另一个机(专门做向量计算):放Xinference跑Embedding

- 就像开工厂:

- 办公室租在市中心(腾讯云)——接待客户、谈生意

- 生产线设在郊区(AutoDL)——便宜,干重活

- 仓库设在物流园(另一个AutoDL)——专门做仓储

技术分工策略

- Ollama:快速实验 → “试产线”

- Xinference:稳定服务 → “正式生产线”

- Dify:组装应用 → “总装车间”

四、部署完了到底能干啥?(主要应用场景)

1. 基于RAG构建的“私有知识库智能大脑”

解决的问题

咱们公司现在最头疼的问题:知识散落在各个角落

- 产品文档在Confluence

- 客户案例在销售PPT里

- 技术方案在工程师脑子里

- 合同模板在法务电脑上

- 新员工来了半年还找不到北

2. 基于Agent的“运维智能体”

解决的问题

IT运维部门现在的痛点:

- 半夜告警:运维小哥爬起来处理,影响白天效率

- 重复操作:每天重复的巡检、备份、检查

- 故障排查:出问题多方查日志,像侦探破案

- 知识断层:老运维走了,新来的不会处理老系统

部署后能干啥

相当于给运维部门配了个“24小时数字副手”

实际应用场景

- 日常巡检:Agent每天自动查100台服务器,生成健康报告

- 变更管理:发布新版本,Agent自动监控关键指标,异常自动回滚

- 容量预测:分析历史数据,提前预警“下个月存储要不够了”

- 知识传承:每次故障处理,Agent学习记录,新员工问Agent就能学会

价值亮点

- 人力解放:减少50%重复性运维工作

- 故障MTTR:平均修复时间从小时级→分钟级

- 风险降低:标准化操作,减少人为失误

- 7×24值守:不增加人力成本实现全天候监控

3. 基于Workflow的“工作流客服助手”

解决的问题

客服部门现在的困扰:

- 重复问题:80%问题都是类似的,但每次都要人工答

- 流程复杂:一个投诉要转3-4个部门,客户等得急

- 信息孤岛:客服不知道库存、不知道物流状态、不知道技术细节

- 培训成本:新客服上岗要培训1个月

部署后能干啥

相当于给客服配了个“全知全能的工作流引擎”

场景:客户投诉“订单没收到,很急用!”

传统客服:

├─ 安抚情绪(标准话术)

├─ 查订单系统(切屏,慢)

├─ 查物流系统(再切屏)

├─ 发现物流异常,转接物流专员(客户等)

├─ 物流查完,可能还要转技术(客户更急)

└─ 最后给方案(可能已过1小时)

Workflow客服助手:

客户刚说“订单没收到”

↓

系统自动触发工作流:

【第一步:信息收集】

├─ 自动识别订单号(从聊天记录)

├─ 调用订单API查状态(1秒)

├─ 调用物流API查位置(1秒)

├─ 调用库存API查是否有货(1秒)

【第二步:智能分析】

├─ 判断:物流显示“配送异常”

├─ 分析:同区域有库存,可重新发货

├─ 计算:预计新发货到达时间

【第三步:方案生成】

├─ 自动生成回复话术:

“抱歉让您久等!您的订单因XX原因延迟,

我们已经从最近仓库重新发货,预计今天下午4点前送达,

附上20元优惠券表歉意。”

├─ 同时后台自动:

- 创建新发货单

- 锁定库存

- 发放优惠券

- 通知仓库发货

【第四步:客服审核】

客服只需:看一眼方案 → 点击“确认发送”

总耗时:30秒 vs 1小时

五、RAG图书管理员能干啥(以快递为例)

四步走,像快递站

【第一步:入库】

文档 → 拆成小包裹 → 贴二维码(向量化) → 上架(存向量数据库)

【第二步:接单】

用户提问 → 把问题也贴二维码

【第三步:找货】

用二维码匹配 → 找出最相关的几个包裹

【第四步:打包】

把几个包裹的内容整理好 → 让AI生成最终回答 → 发货

三个关键模型的分工

Embedding模型:生成“二维码”的机器

Rerank模型:负责“这几个包裹哪个更相关”的质检员

LLM模型:最后“写快递单+打包”的打包员

六、Agent(智能体)能干啥?

如果RAG是“智能文档检索”,那么Agent就是“AI员工”。

现实中的Agent应用

1. 数据分析Agent

- 你:“分析下上个月为啥销量跌了”

- Agent自动:查数据库 → 拉竞品数据 → 做图表 → 写分析报告

- 代替了:数据分析师3天的工作

2. 运维巡检Agent

- 定时:检查服务器状态 → 发现异常 → 尝试修复 → 修复不了就告警

- 代替了:运维半夜爬起来查监控

3. 代码开发Agent

- 你:“加个用户登录功能,要短信验证”

- Agent:写后端API → 写前端页面 → 写数据库迁移 → 写测试用例

- 代替了:初级程序员一周的工作

七、总结

【投入】 【产出】

├─ 腾讯云+Dify → 统一管理平台

├─ AutoDL+Ollama → 多种AI能力

├─ AutoDL+Xinference → 专业向量服务

└─ 咱们的部署时间 → ↓

【公司级AI能力】

├─ 知识问答系统

├─ 智能客服

├─ 代码助手

└─ 数据洞察

RAG系统三组件架构总览表

| 维度 | Ollama | Xinference | Dify | 协同关系 |

|---|---|---|---|---|

| 功能定位 | 大模型推理引擎 | 向量检索服务 | 应用组装平台 | 大脑 + 记忆 + 手脚 |

| 核心功能 | LLM推理 | Embedding + Rerank | 工作流 + 界面 | 覆盖AI全链路 |

| 具体模型 | DeepSeek/Qwen | BGE系列 | (平台集成) | 提供完整AI能力 |

| 技术栈 | Go + C++ | Python + Rust | Python + React | 技术互补 |

| 部署平台 | AutoDL | AutoDL | 腾讯云 | 计算分离,云地协同 |

| 厂商/开源 | Ollama.ai | Xorbits.ai | LangGen | 均为开源方案 |

| 是否必需 | ✓ 必需 | ✓ 必需 | ✓ 必需 | 最小可行架构 |

| 缺少影响 | 无对话能力 | 无法检索增强 | 无产品界面 | 无法形成闭环 |

| 扩展功能 | 模型管理、流式输出 | 批量推理、多模型管理 | 知识库管理、团队协作 | 满足企业级需求 |

| 与Docker关系 | 可容器化部署 | 可容器化部署 | 容器化部署平台 | Docker统一封装 |

| 与其他组件关系 | 提供推理能力 | 提供检索能力 | 整合所有能力 | Dify调用Ollama和Xinference |

云平台与组件关系表

| 关系维度 | 腾讯云 + Dify | AutoDL + Ollama/Xinference | 协同方式 |

|---|---|---|---|

| 分工关系 | 前端交互、用户界面 | AI计算、模型推理 | 业务分离 |

| 网络关系 | 公网访问、域名服务 | 内网服务、API端点 | 内网穿透/API网关 |

| 成本关系 | 稳定可靠、成本较高 | 按需计费、成本较低 | 成本优化组合 |

| 部署关系 | Docker容器化部署 | Docker容器化部署 | 统一容器管理 |

核心价值总结表

| 价值点 | 说明 |

|---|---|

| 完整性 | 覆盖从数据处理→智能推理→应用交付的完整RAG流程 |

| 经济性 | 重计算放低价AutoDL,核心服务放稳定腾讯云,最优成本 |

| 可扩展性 | 每个组件均可独立替换升级,不影响整体架构 |

| 易用性 | Dify提供可视化界面,降低AI应用开发门槛 |

| 国产化 | 全部采用国产开源方案,自主可控 |

最终结论:Ollama + Xinference + Dify 构成 最小可行、完整闭环、成本最优 的RAG产品架构,可快速部署并投入商用。

更多推荐

已为社区贡献21条内容

已为社区贡献21条内容

所有评论(0)