大模型训练算法演进:从DPO到GRPO/DAPO/GSPO/SAPO,一文读懂所有改进!

本文详细介绍了DPO之后大模型训练算法的发展路线,包括GRPO、DAPO、GSPO和SAPO四种算法。GRPO采用组采样方式降低显存占用;DAPO引入归一化系数、非对称裁剪等改进提升训练效率;GSPO改变重要性采样方式,适用于MoE模型;SAPO采用token级软信任区域和非对称温度设计。这些算法在PPO基础上不断优化,使大模型训练更高效稳定。

简介

本文详细介绍了DPO之后大模型训练算法的发展路线,包括GRPO、DAPO、GSPO和SAPO四种算法。GRPO采用组采样方式降低显存占用;DAPO引入归一化系数、非对称裁剪等改进提升训练效率;GSPO改变重要性采样方式,适用于MoE模型;SAPO采用token级软信任区域和非对称温度设计。这些算法在PPO基础上不断优化,使大模型训练更高效稳定。

在DPO(Direct Policy Optimizatio)之后,后续的典型工作发展路线为:GRPO -> DAPO -> GSPO -> SAPO,在有PPO的理论推导基础后,这些论文的理论推导过程就会容易很多。

- GRPO 相比PPO的改进有哪些?

====================

首先PPO的优化目标为:

GRPO的优化目标:

其中

其采用组采样的方式和基于规则的reward函数,也能够像DPO仅加载两份模型,即Actor和参考文献 Model,从而在训练参数量比较大的模型时,有效降低显存的占用,好坏样本的覆盖程度则依赖于Rollout过程,当Rollout采样的过程足够多时,可以假设它能够覆盖大部分情况。

从上述角度来讲,想要覆盖大部分case的数据组织成本,要比DPO小很多,个人猜测是目前GRPO系列方法比较流行的一个原因,该方法的核心在于组采样。但在实际训练时,比较耗费时间的为Rollout阶段。

- DAPO 相比GRPO的改进有哪些?

=====================

其优化目标如下:

其中 和前面保持一致,其不同地方则用红色显示,如下为DAPO的具体改进点:

归一化系数(对应论文中的Token-Level Policy Gradient Loss): 这里采用全局token系数进行归一化,使得在处理组内长度回复差异较大时,梯度会更稳定点。

非对称裁剪(对应论文中的Clip-Higher): 更精细地控制策略的更新程度。

Dynamic Sampling: 直接丢弃掉采样后奖励值为0或1的样本, 当组内所有采样结果相同时,此时按照上式计算得到的优势为0,即不能带来有效梯度更新。刚开始训练时,会有较大可能出现组内奖励值全0的情况,训练阶段后期,则会有较大可能出现组内奖励值全1的情况,为了提升Rollout阶段的采样效率,直接选择丢弃奖励值为0或1的样本。

Overlong Reward Shaping: 该改进并没有在DAPO的优化目标中体现,在GRPO训练时可能会出现当Rollout输出达到预先设置的最大长度时,仍没有输出有效结果,此时计算的奖励值为0。为了降低模型输出时的思考长度,则在输出长度方面,增加一个对应软惩罚:

- GSPO 相比GRPO有哪些改进?

====================

优化目标如下:

其中

该优化目标相比GRPO,仅改变了重要性采样的系数,其相比GRPO采样系数用的是整条句子的概率情况,而不是单token概率,这点对于MoE模型RL训练十分有帮助。

对于单token概率,可能存在Rollout Engine和 Model Engine选择的专家路由差异,因此往往需要通过Routing Reply机制来确保两种Engine在同样的样本选择的路由保持一致。

一个稍微有意思的点,在LLM进行预训练时,需要观察模型在训练预料的PPL(文本困惑度)是否呈现出下降趋势,PPL的公式与上述公式极为相似,对于一个序列

其困惑度的定义如下:

将PPL的定义带入 则有 ,对于正样本,希望 较大,即对应到 减小, 增大。

- SAPO 相比GRPO和GSPO有哪些改进?

=========================

其优化目标如下:

其中

其相比GRPO将clip操作替换为上述软控制,其具有如下特点:

- • token级别的软信任区域,token级别具有更细的控制力度。

- • 非对称温度设计,对于正负token则采取不同的操作。

说真的,这两年看着身边一个个搞Java、C++、前端、数据、架构的开始卷大模型,挺唏嘘的。大家最开始都是写接口、搞Spring Boot、连数据库、配Redis,稳稳当当过日子。

结果GPT、DeepSeek火了之后,整条线上的人都开始有点慌了,大家都在想:“我是不是要学大模型,不然这饭碗还能保多久?”

我先给出最直接的答案:一定要把现有的技术和大模型结合起来,而不是抛弃你们现有技术!掌握AI能力的Java工程师比纯Java岗要吃香的多。

即使现在裁员、降薪、团队解散的比比皆是……但后续的趋势一定是AI应用落地!大模型方向才是实现职业升级、提升薪资待遇的绝佳机遇!

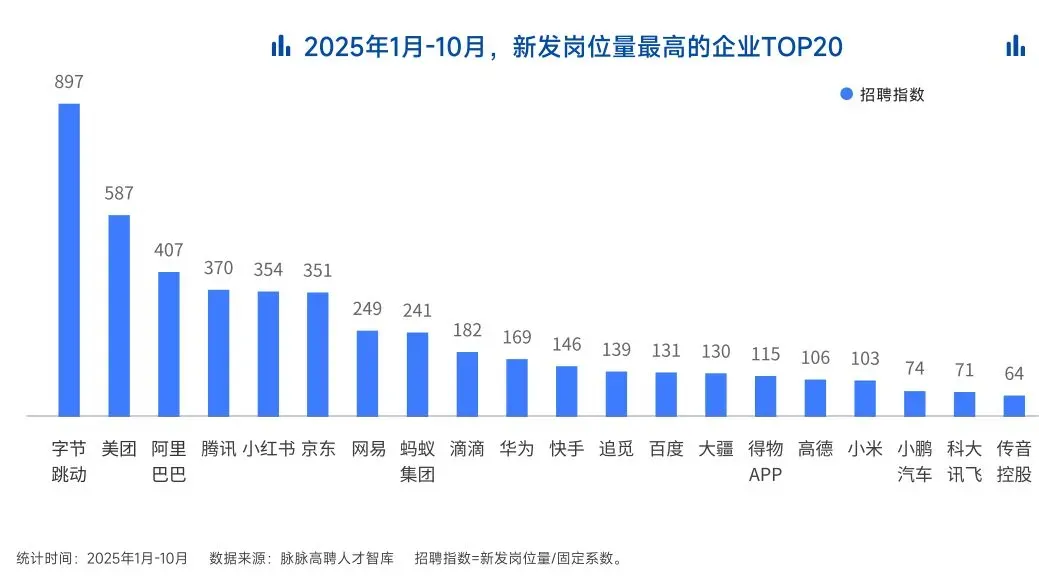

这绝非空谈。数据说话

2025年的最后一个月,脉脉高聘发布了《2025年度人才迁徙报告》,披露了2025年前10个月的招聘市场现状。

AI领域的人才需求呈现出极为迫切的“井喷”态势

2025年前10个月,新发AI岗位量同比增长543%,9月单月同比增幅超11倍。同时,在薪资方面,AI领域也显著领先。其中,月薪排名前20的高薪岗位平均月薪均超过6万元,而这些席位大部分被AI研发岗占据。

与此相对应,市场为AI人才支付了显著的溢价:算法工程师中,专攻AIGC方向的岗位平均薪资较普通算法工程师高出近18%;产品经理岗位中,AI方向的产品经理薪资也领先约20%。

当你意识到“技术+AI”是个人突围的最佳路径时,整个就业市场的数据也印证了同一个事实:AI大模型正成为高薪机会的最大源头。

最后

我在一线科技企业深耕十二载,见证过太多因技术卡位而跃迁的案例。那些率先拥抱 AI 的同事,早已在效率与薪资上形成代际优势,我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在大模型的学习中的很多困惑。

我整理出这套 AI 大模型突围资料包【允许白嫖】:

-

✅从入门到精通的全套视频教程

-

✅AI大模型学习路线图(0基础到项目实战仅需90天)

-

✅大模型书籍与技术文档PDF

-

✅各大厂大模型面试题目详解

-

✅640套AI大模型报告合集

-

✅大模型入门实战训练

这份完整版的大模型 AI 学习和面试资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

①从入门到精通的全套视频教程

包含提示词工程、RAG、Agent等技术点

② AI大模型学习路线图(0基础到项目实战仅需90天)

全过程AI大模型学习路线

③学习电子书籍和技术文档

市面上的大模型书籍确实太多了,这些是我精选出来的

④各大厂大模型面试题目详解

⑤640套AI大模型报告合集

⑥大模型入门实战训练

👉获取方式:

有需要的小伙伴,可以保存图片到wx扫描二v码免费领取【保证100%免费】🆓

更多推荐

已为社区贡献473条内容

已为社区贡献473条内容

所有评论(0)