大模型调教指南:如何通过人工智能让AI更懂你的业务?

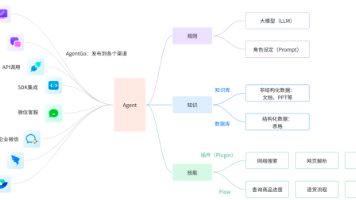

大语言模型(LLM)本质上是一个概率训练生成系统。它的记忆来源于训练数据剪裁日期。你问它的股市,它可能在胡思乱想。它是通过概率预测下一个字,逻辑推理(尤其是数学和复杂业务逻辑)很容易翻车。每个企业都有自己的“黑话”和原生数据。通用模型不懂你们公司的区域、设置架构,也不懂一些罕见病的临床表现。它会一本正经地胡说八道,生成场景合理但实际错误的内容。调优(Fine-tuning)就是训练解决这些问题的核

一、引言:大模型模型,为什么是落地必经之路?

大语言模型(LLM)本质上是一个概率训练生成系统。虽然它在预阶段“读取”互联网上的海量数据,但在实际业务中,它仍然面临以下“四大致命伤”:

-

知识时效性:它的记忆来源于训练数据剪裁日期。你问它的股市,它可能在胡思乱想。

-

推理限制:它是通过概率预测下一个字,逻辑推理(尤其是数学和复杂业务逻辑)很容易翻车。

-

垂直领域盲区:每个企业都有自己的“黑话”和原生数据。通用模型不懂你们公司的区域、设置架构,也不懂一些罕见病的临床表现。

-

幻觉现象(Hallucination):它会一本正经地胡说八道,生成场景合理但实际错误的内容。

调优(Fine-tuning)就是训练解决这些问题的核心手段。它通过在特定任务的数据集上进行二次,让模型从“什么都懂一点的杂家”变成“精通你家业务的专家”。

二、技术原理:拆解大模型进化的底层逻辑

2.1 什么是模型参数?

简单类比:预训练是九年义务教育提高高等教育,让具备模型基本常识和语言能力;然后进行岗前培训,使学会特定岗位的技能。

2.2 核心账户方式分类

我们可以根据“更新参数的多少”和“训练目标”将调节分为几个流派:

2.2.1 按训练目标分类

-

有模型(SFT, Supervised Fine-Tuning): 这是目前最主流的玩法。你给模型准备好“问答”对。

-

典型数据格式:

JSON[ { "instruction": "作为一名资深Java架构师,请解释什么是线程池的饱和策略。", "input": "", "output": "线程池的饱和策略(RejectedExecutionHandler)是指当任务队列已满且工作线程数达到最大值时,系统该如何处理新来的任务..." } ] -

-

指令指令(Instruction Tuning): 旨在提升模型对指令的理解力。通过指令,模型不再只是续写文本,而是学会“听话”。

-

视觉方法(RLHF / DPO): 让模型的价值观与人类视觉相结合。

-

RLHF(人类反馈强化学习):成本高,步骤复杂。

-

DPO(直接偏好优化):目前建立更推崇,通过让模型在“好答案”和“坏答案”之间做选择题,直接优化偏好。

-

2.2.2 按参数更新策略分类(省钱省资源的秘籍)

-

全参数(Full Fine-Tuning): 修改模型的每一个参数。优点是最高,缺点是贵!需要极高的显着存储和计算资源。

-

参数高效参数(PEFT): 这是大多数开发者的信念。我们不再动模型的原始权重,而是引入少量的额外参数。

-

LoRA(低等级装备):

-

原理:在原始权重矩阵旁边增加两个小训练矩阵(A和B)。此时,原始权重新冻结,只更新A和B。

-

公式表达:

$$W = W_0 + \Delta W = W_0 + BA$$ -

优点:显存占用极低,训练出来的“插件”只有几十MB。

-

-

Adapter 结构: 在模型层与层之间插入小型神经网络块。

-

三、实践步骤:手部教你如何“炼丹”

我们将以目前国内最火的LLaMA-Factory-online框架为例进行讲解。它集成了几乎所有主流驱动技术,操作带宽极低。

3.1环境准备

建议使用Linux环境(如Ubuntu 22.04),并安装好的NVIDIA显卡驱动和CUDA环境。

# 1. 克隆框架

git clone https://github.com/hiyouga/LLaMA-Factory.git

cd LLaMA-Factory

# 2. 安装依赖

pip install -e .[metrics,bitsandbytes,qlora]

3.2 数据集构建

菩提的精髓利用数据。你需要将业务数据转化为SFT格式。

-

量级建议:至少 500-1000 条高质量数据才能看到明显效果。

-

质量要求:答案必须精准、专业,避免废话。

3.3 启动Web UI进行傻瓜式配置

LLaMA-Factory 提供了非常友好的界面。执行以下命令:

llamafactory-cli webui

在浏览器中打开localhost:7860:

-

模型路径:选择你下载的基础模型(如 Llama-3-8B 或 DeepSeek-V3)。

-

警告方法:强烈建议初学者选择

lora。 -

超参数设置: *

Learning Rate: 建议5e-5。-

Epochs: 3-5次即可,次数太多会导致“过分”。

-

模型记得你给出了所有标准答案,但失去了泛化能力。当你问它一个稍微改变一点的问题时,它就傻眼了。

3.4 监控训练流程

训练时,你需要关注Loss(损失函数)曲线。

-

理想状态:曲线下降,最终趋于平缓。

-

异常状态:如果Loss突然激增,可能是学习率设置过大;如果Loss很快降到0,很大概率是数据量太少导致模型死记硬背。

四、效果评估:如何验证你的模型变聪明了?

模型练完了,千万别急着上线。

4.1 自动化游戏(基准)

使用通用的测试集(如 MMLU、C-Eval)跑一遍,确保后期模型的基础智商不衰退。

4.2 垂直领域测试

准备100个模型未见过的业务问题,进行推理测试。

-

比对法:找5个业务专家,对“原版模型”和“账户版模型”给出的答案进行盲测打分(AB Test)。

-

GPT-4 辅助足球:如果人工太贵,可以让 GPT-4 作为,裁判给两个模型的回答打分。

4.3 灾难性遗忘检查

强大有时会让模型完成“学了新知识,忘记旧逻辑”。比如练了法律知识后,发现它连1+1都算了。这就需要你在较大数据中加入10%的通用对话数据进行均衡。

五、总结与展望

权限不是万能的,但它是让AI从“玩具”变为“生产力工具”的关键跳跃。

-

什么时候选择输出?当你需要特定的格式、专业的行业术语或严格的语气控制时。

-

什么选RAG(搜索增强)?当你需要处理海量动态更新的文档、追求实时性且预算有限的时候。

在实际实践中,如果只是停留在“了解大模型原理”,其实很难真正感受到模型能力的差异。

我个人比较推荐直接上手做一次微调,比如用 LLaMA-Factory Online 这种低门槛大模型微调平台,把自己的数据真正“喂”进模型里,生产出属于自己的专属模型。

即使没有代码基础,也能轻松跑完微调流程,在实践中理解怎么让模型“更像你想要的样子”。

下期预告: 很多同学反应LoRA训练后的模型权重合并(Merge)容易出问题,下一篇我会详细讲讲模型量化(Quantization)与高效推理部署的避坑指南。

互动时间

您目前在较大模型时,遇到的最大挑战是什么?

-

A. 缺乏高质量的数据集

-

B.显卡配置太低,跑不动

-

C. 训练出来的模型“变笨了”

-

D.各种框架安装报错,环境配不通

欢迎在评论区留言,我会在下一期详细解答精选的问题! 您需要我推荐一个特定的数据集清理工具来帮助您开始数据准备步骤吗?

更多推荐

已为社区贡献17条内容

已为社区贡献17条内容

所有评论(0)