实测华为 ModelEngine:从零搭建我们公司的知识问答智能体

AI 应用的真正价值,不在于算法创新,而在于让更多人能用得上。过去我们构建一个智能问答系统要靠算法、数据库和接口开发,现在只需几次拖拽就能完成。

前言:互联网公司的知识“断层”问题

在我所在的互联网公司,我们有几十个业务线、几百份产品文档、数不清的接口说明、还有那些从不更新的 Wiki 页面。

每个新同事入职时都会经历同样的循环:

- “我去哪里找这个流程?”

- “这个接口是谁维护的?”

- “这段代码的逻辑在哪个模块?”

虽然公司内部早就搭了知识库和检索系统,但信息依然分散在各种角落。最常见的情况是:

- 产品在 Confluence;

- 技术文档在 GitLab;

- 培训资料在飞书;

- 而运营 FAQ 又是一份 Excel。

结果就是——知识存在,但无法高效被访问。

尤其是新员工,面对上百页的文档根本不知道从哪看起。

我们很早就想做一个内部智能问答助手,类似 ChatGPT 但只懂公司自己的知识。

可传统方案(LangChain + 向量库 + LLM API)搭建成本太高,不仅需要算力和工程资源,还要维护知识索引、更新模型。

于是乎偶然的一次机会我发现了一个ModelEngine的智能体平台,不用投入大量工程资源搭建底层架构、就像搭积木一样,短短几分钟就可以实现一个智能问答系统…

平台初识:ModelEngine 的定位与优势

第一次打开 ModelEngine 官网 时,我以为这又是一个模型托管平台。

但深入研究后才发现,ModelEngine 的定位要更系统化,它其实是一个“AI 应用生产线”。

传统的大模型开发链条是:

- 数据 → 预处理 → 模型微调 → 推理部署 → 前端集成

而 ModelEngine 直接把这些步骤整合成一个可视化平台。

它有三大亮点让我印象特别深:

- 低代码编排:所有步骤都能通过拖拽节点完成,连 Prompt 都能直接在界面配置。

- 多模型兼容:除了华为昇腾系模型,还能用 DeepSeek、ChatGLM、LLaMA 等主流模型。

- 一键RAG支持:平台内置了检索增强(RAG)组件,无需自己搭建向量库。

对于企业知识问答这种典型场景,它的设计正好契合需求。

我们不关心模型底层推理细节,只想要一个能“理解文档并回答问题”的系统。

ModelEngine 的底层采用流式编程框架(Pipeline Flow),每个节点既可以是算子(Operator),也可以是微服务接口(Service Node)。

它能自动调度资源、缓存中间结果,这意味着我们可以在浏览器端低代码编排完整流程。

相比我以前手工搭 LangChain、写 Pinecone 向量库接口、再部署 Flask API,这次真的是降维体验。

那一刻我理解了它的宣传语——“AI 开发不再写代码,而是编排逻辑”。

从注册到创建智能体:5分钟完成初始框架

整个上手流程出乎意料地顺畅。

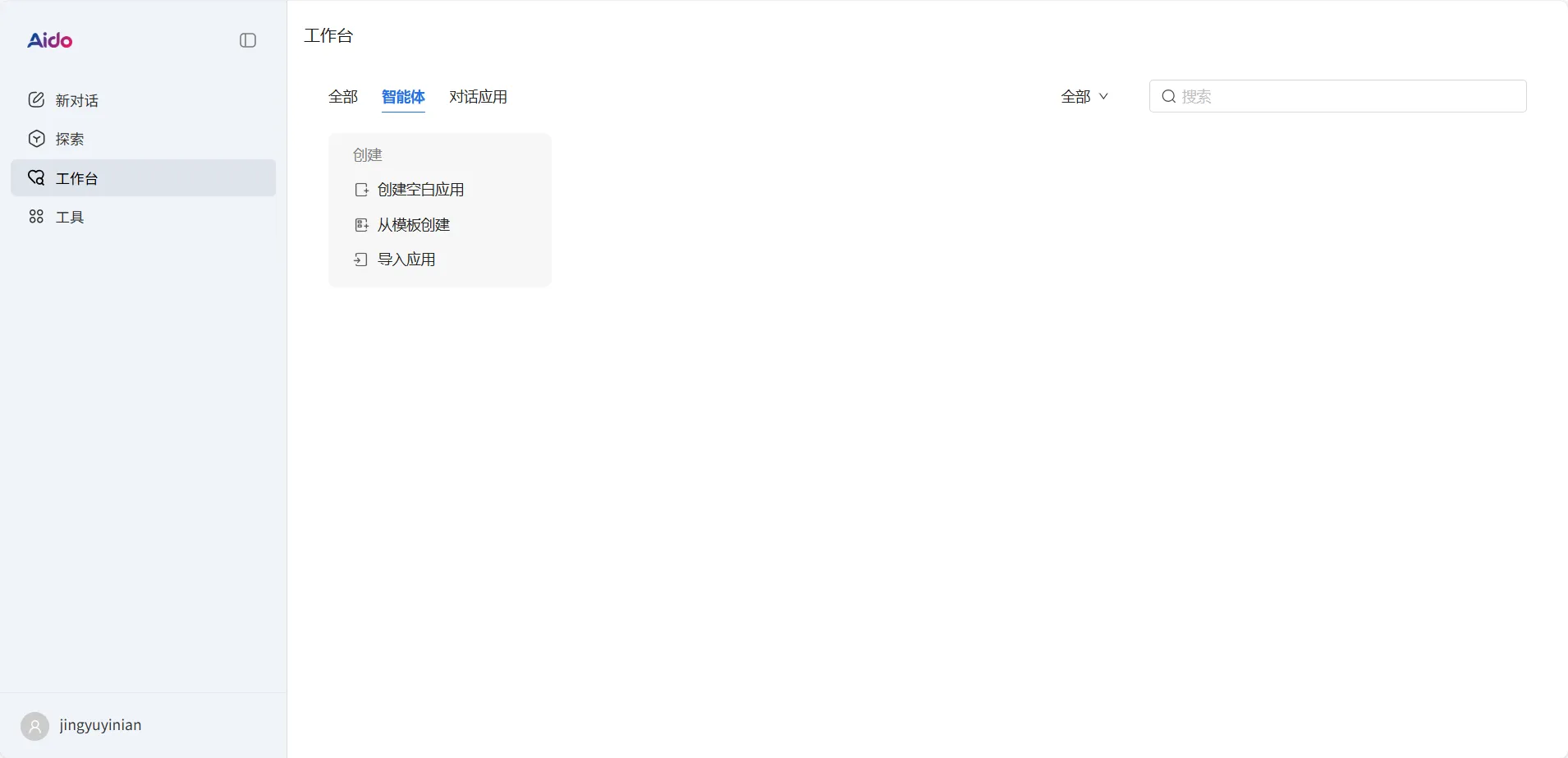

我直接访问官网,邮箱密码就能简单注册,登录后自动跳转到控制台界面。

界面风格非常简洁、稳重、逻辑清晰。

创建智能体

点击「创建空白应用」,系统弹出如下窗口。

这里有两个选项:

- 智能体(适合知识问答、智能助手等场景);

- 对话应用(更偏向开放式聊天机器人)。

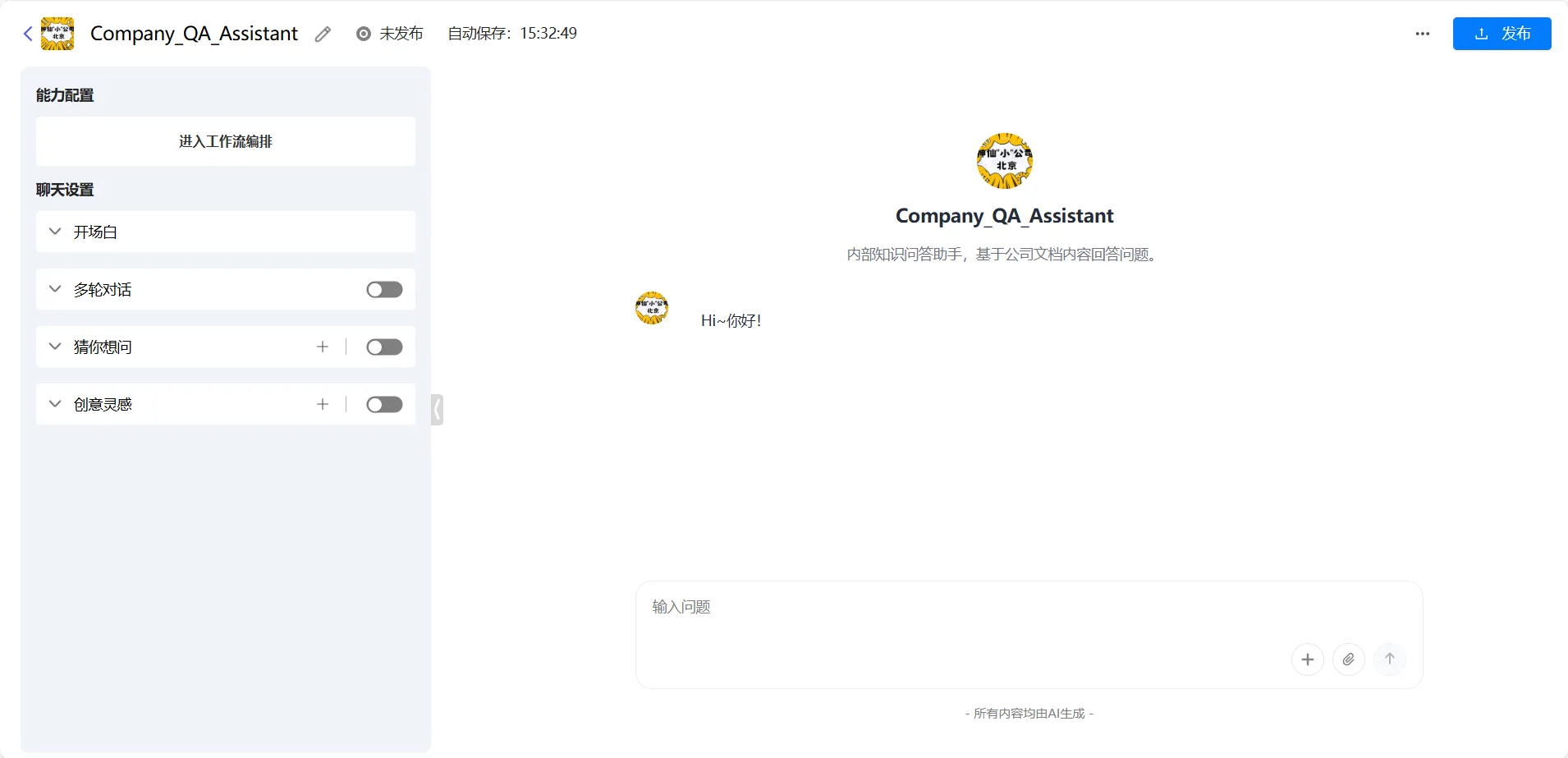

我们选择「智能体」,然后填写:

- 名称:Company_QA_Assistant

- 分类:知识问答

- 简介:内部知识问答助手,基于公司文档内容回答问题。

点击【创建】,平台会自动生成一个智能体工程。

构建知识问答逻辑:从配置到流程编排

创建好项目后,系统自动进入智能体的主界面。左侧是核心设置项,右侧是即时测试窗口。整个过程并不复杂,关键在于如何让智能体真正理解我们的企业资料。

我先为智能体配置了基础参数。多轮对话保持开启,让它能够理解上下文逻辑;

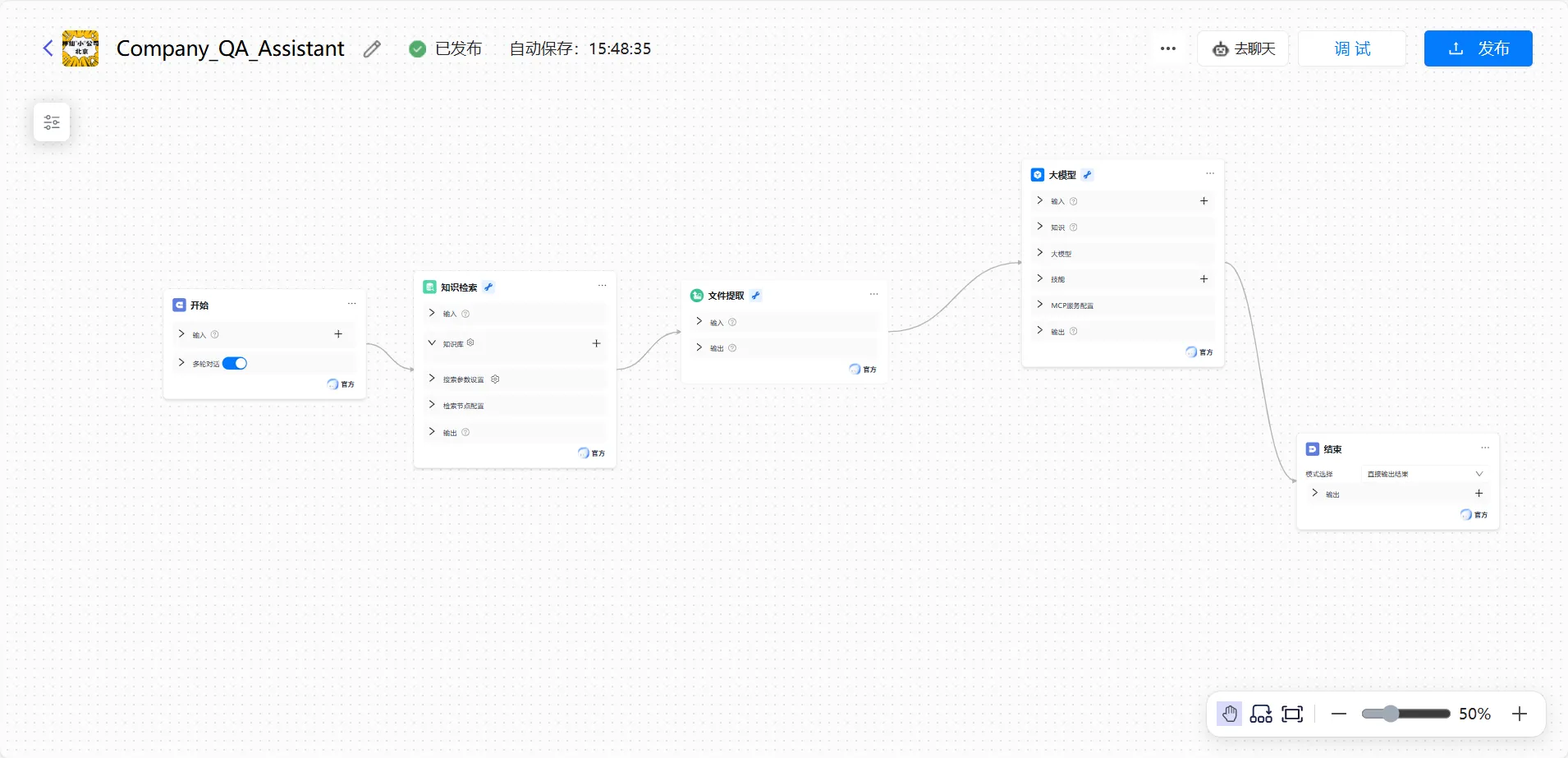

配置完成后,我进入工作流编排环节。这一步可以理解为“给智能体装上大脑”。系统提供了低代码画布,每个模块都是一个功能节点,像在搭积木一样,把输入、检索、生成、输出这些关键步骤连起来。

我依次添加了开始、知识检索、文件提取、大模型和结束节点。

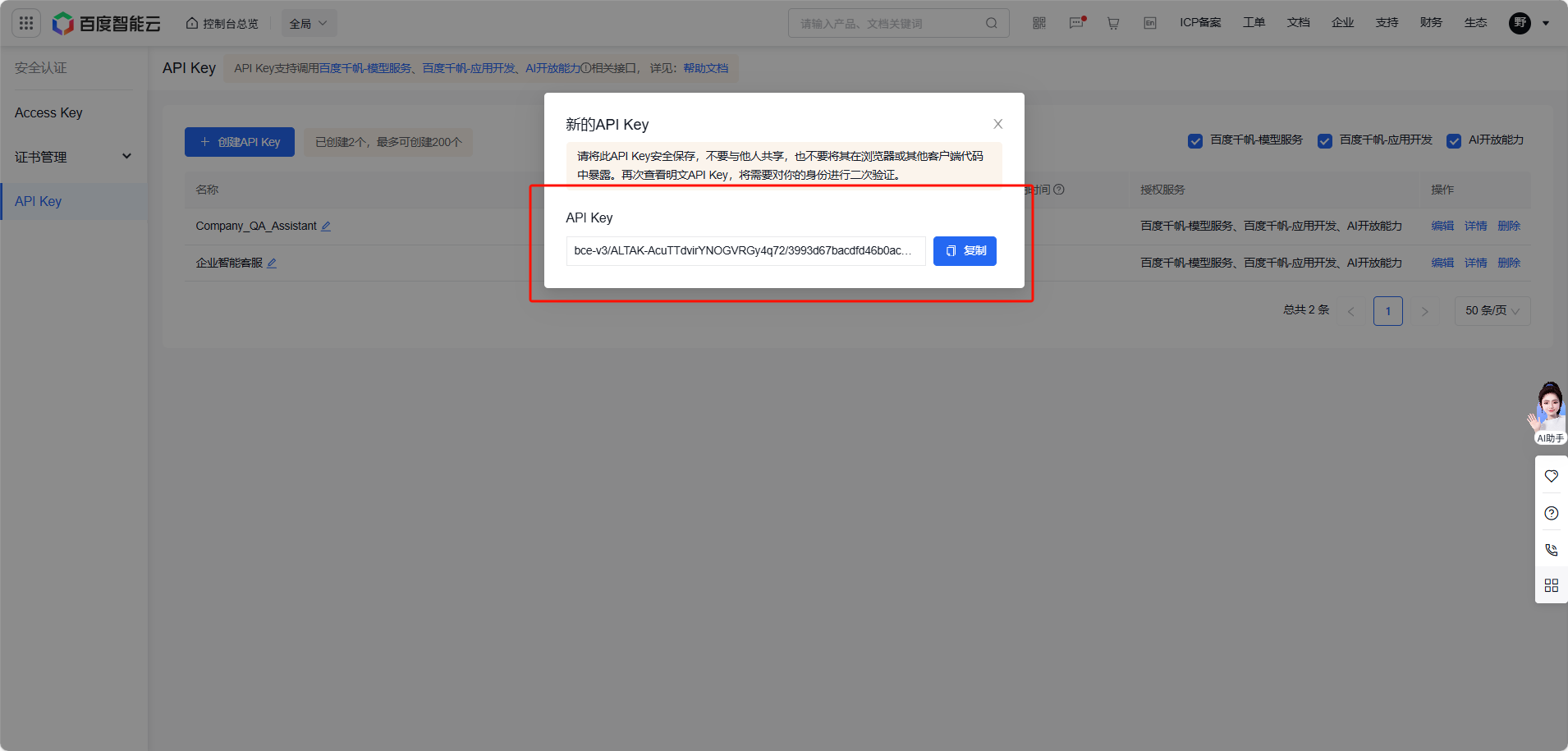

对于知识库配置我们可以参考百度千帆教程,然后复制好的API Key填入此处即可:

开始节点接收用户提问;知识检索从上传的企业文档中查找匹配内容;文件提取负责解析用户上传的文件内容;大模型负责生成语义化回答;结束节点输出结果并控制格式。

整个逻辑链路十分清晰:

用户问题进入 → 系统检索知识 → 模型生成回答 → 输出到界面。

编排完成后保存即可。整个操作没有写一行代码,纯拖拽式逻辑设计,非常直观。

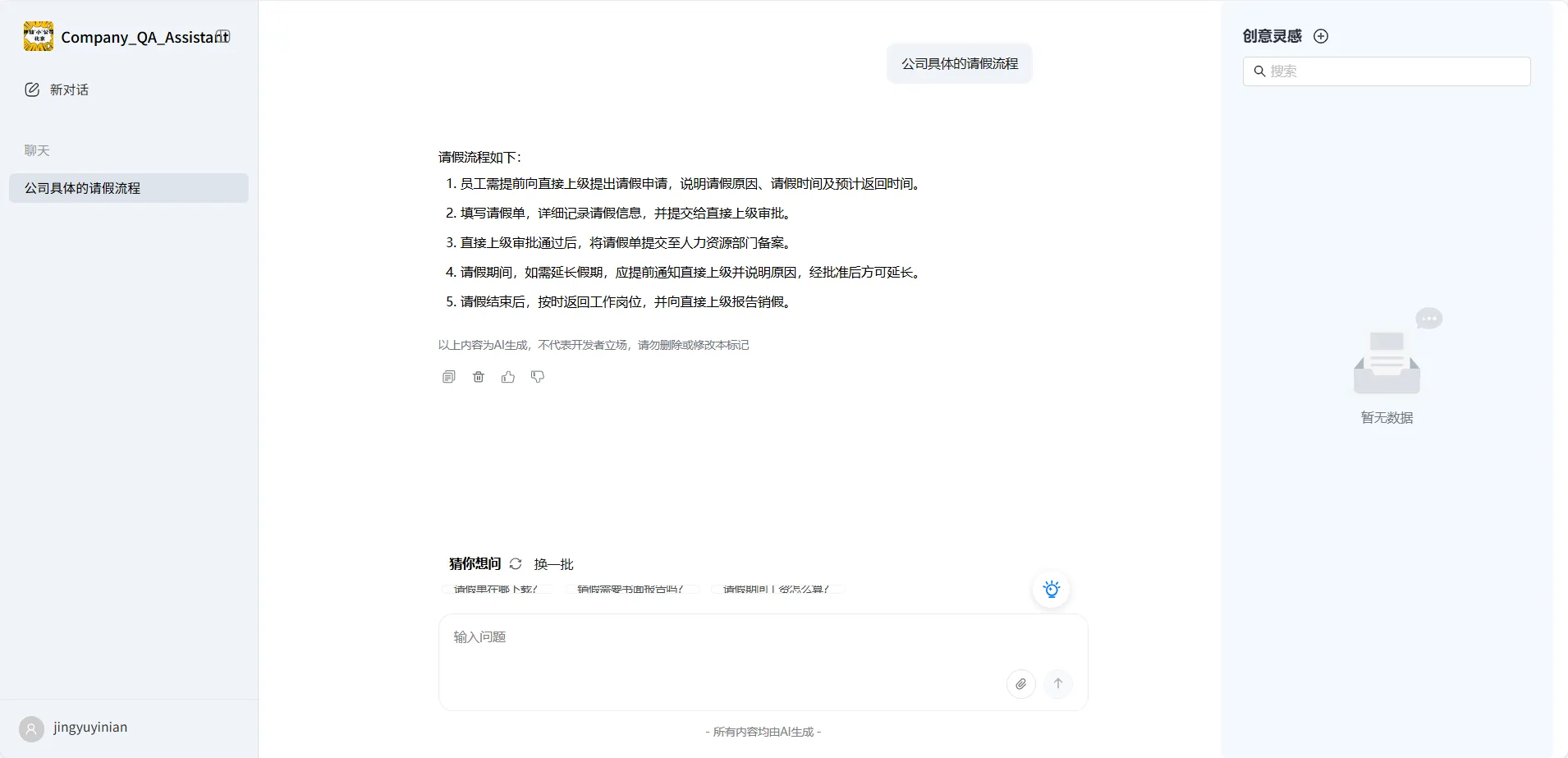

然后我们就可以点击右上角调试进行测试,完成后没有问题即可发布。

体验总结与实践思考

这次完整体验让我对 ModelEngine 的平台设计有了更直观的认识。它的核心不是让人去“训练模型”,而是让企业去“编排智能”。

传统 AI 应用往往停留在技术层面,开发成本高,难以落地。

而 ModelEngine 通过可视化流程,把模型能力抽象成节点,把知识检索和生成逻辑封装成模块,从根本上降低了使用门槛。

在使用过程中,我最深的感受有三点:

- 上手速度快:从注册到能运行问答,只用了不到两个小时。

- 可靠性高:基于知识检索的回答准确率明显优于纯对话模型。

- 扩展性强:每个节点都可以单独调整参数或添加自定义逻辑,适合后续集成更多功能。

当然,它也有改进空间:

- 文档索引希望能支持增量更新;

- 调试界面可以加入批量测试功能;

- 知识库如果能接入在线存储(如飞书文档或企业网盘)会更方便。

但瑕不掩瑜。对于希望快速落地企业内部 AI 助手的团队来说,ModelEngine 已经提供了一个极具性价比的方案。

写在最后

AI 应用的真正价值,不在于算法创新,而在于让更多人能用得上。

过去我们构建一个智能问答系统要靠算法、数据库和接口开发,现在只需几次拖拽就能完成。

这意味着 AI 正在从“专家工具”变成“团队生产力”。

ModelEngine 给我的最大启发是:

未来企业里的每个岗位,都会拥有自己的智能体。

研发有代码助手,运营有数据分析智能体,人事有流程答疑智能体。

这种“个体智能化”的趋势,正在重新定义企业效率。

对于想尝试 AI 应用但不想陷入算法细节的团队,ModelEngine 是一个值得尝试的平台。

它让人真正感受到一句话的力量——

不用懂 AI,也能用好 AI。

更多推荐

已为社区贡献33条内容

已为社区贡献33条内容

所有评论(0)