收藏备用!AI Agent四大部署架构全解析:从技术落地到商业价值变现(附代码/案例/学习资源)

当AI技术冲破实验室的藩篱,在产业场景中规模化落地时,AI Agent的部署策略已然成为连接技术原型与商业价值的核心枢纽。不同于传统软件“一次部署、静态运行”的固化模式,具备自主推理、动态决策能力的AI Agent,其部署方案直接决定了系统的响应速度、资源成本、数据安全性,更直接影响最终的用户体验与商业变现效率。。

当AI技术冲破实验室的藩篱,在产业场景中规模化落地时,AI Agent的部署策略已然成为连接技术原型与商业价值的核心枢纽。不同于传统软件“一次部署、静态运行”的固化模式,具备自主推理、动态决策能力的AI Agent,其部署方案直接决定了系统的响应速度、资源成本、数据安全性,更直接影响最终的用户体验与商业变现效率。

本文专为CSDN的程序员与大模型初学者量身打造,系统拆解批处理、流处理、实时部署、边缘部署四大主流架构,结合金融、医疗、工业等真实产业案例,附上可直接复用的技术栈选型与代码片段,最后还整理了大模型零基础学习路径与实战资源包,帮你快速掌握AI Agent落地方法论,轻松构建适配业务场景的部署体系。

一、批处理部署:海量数据高效处理的“幕后支柱”

核心逻辑

批处理部署以定时触发+集中计算为核心,AI Agent在预设时间窗口内(如凌晨低峰期)批量处理累积的海量数据。其典型架构包含三层:任务调度层(负责触发与监控)、数据存储层(承接原始数据与结果存储)、Agent计算层(执行模型推理与数据处理),形成“数据归集→批量计算→结果输出”的闭环流程,尤其适用于非实时性、高数据量的场景。

典型应用场景与实践案例

1. 金融行业反欺诈分析

- 案例背景:某国有银行需每日核查全球分支机构前24小时的交易数据,识别潜在洗钱、盗刷等风险行为

- 执行流程:

- 每日凌晨1点,通过ETL工具从分布式交易数据库抽取1.5TB原始数据,同步至Snowflake数据仓库

- AI Agent调用轻量化反欺诈模型(基于XGBoost+规则引擎),对1.2亿笔交易进行批量特征提取与风险评分

- 自动生成风险报告,对评分超过阈值的300+可疑账户触发冻结流程,并推送至风控部门复核

- 技术栈:Apache Airflow(任务调度)+ LangChain Batch(Agent框架)+ MinIO(对象存储)

- 核心指标:单批次处理耗时<3小时,风险识别准确率98.7%,误报率控制在0.25%以内

2. 医疗影像批量诊断

- 案例背景:某区域医疗中心需夜间处理日间积累的500+例CT影像,辅助放射科医生生成初步诊断报告

- 技术实现:

- 护士端通过DICOM协议将影像自动上传至本地对象存储,触发夜间2点的批处理任务

- 多模态AI Agent(融合视觉模型ResNet50与医疗专用LLM)并行处理影像,提取病灶特征并匹配临床知识库

- 生成结构化诊断报告(含病灶位置、大小、疑似病症),次日8点前推送至医生工作站

- 优化手段:采用Ray分布式计算框架实现10机并行处理,结合FP16混合精度计算,GPU资源占用率降低42%,处理效率提升2倍

技术栈选型推荐

| 组件类别 | 推荐工具 | 核心优势 |

|---|---|---|

| 任务调度 | Apache Airflow、Prefect | 支持可视化DAG编排,内置重试与告警 |

| 数据存储 | Amazon S3、Snowflake | 弹性扩容,支持PB级数据存储 |

| Agent开发框架 | LangChain Batch、LlamaIndex | 原生支持批量上下文管理,工具链丰富 |

| 资源编排 | Kubernetes + KubeFlow | 实现计算资源动态分配与隔离 |

核心挑战与解决方案

- 数据倾斜问题:按交易地域/影像类型进行动态分区,基于数据哈希值均匀分配任务,避免单节点过载

- 资源争用冲突:建立任务优先级队列,将风控、医疗等核心任务设为高优先级,支持抢占式调度

- 故障恢复机制:实现Checkpoint断点续算,每处理10%数据自动保存中间结果,故障重启后无需从头执行

二、流处理部署:实时数据流的“智能中枢”

架构设计

流处理部署基于事件驱动架构(EDA) 构建,AI Agent作为流处理管道的核心节点,持续消费Kafka、Pulsar等消息队列中的实时数据流,通过状态管理模块维护历史处理上下文,实现“数据产生→实时处理→即时响应”的低延迟闭环,适用于对时效性要求极高的场景。

行业应用深度解析

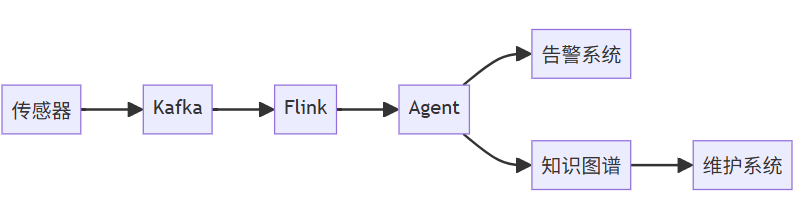

1. 工业物联网设备预测性维护

- 场景背景:某半导体晶圆厂需实时监控100+台光刻机的运行状态,提前预警设备故障,避免生产线停工(每停工1小时损失超50万元)

- 数据流架构:

- AI Agent核心能力:

- 实时接入10万+个传感器数据流(温度、振动、电压等),采样频率达100Hz

- 结合设备历史故障知识图谱(含500+故障案例),通过时序模型(LSTM)分析数据趋势

- 提前72小时预测潜在故障(如轴承磨损、电路老化),自动推送维修工单至设备管理系统

- 性能表现:端到端数据处理延迟<500ms,故障预测准确率92%,设备停机率降低35%

2. 品牌舆情实时监控

- 案例背景:某快消品牌需实时追踪全球社交媒体(Twitter、Instagram等)中产品相关言论,及时响应负面舆情

- 技术实现:

- 通过API接入各平台实时数据流,经Kafka集群进行消息分发

- 多语言AI Agent(支持28种语言,基于BERT+GPT-3.5微调)进行情感分析与关键词提取

- 当负面言论占比超过15%时,自动触发公关响应流程(如生成声明模板、推送至品牌公关团队)

- 工具组合:Apache Kafka(消息队列)+ Apache Flink(流处理引擎)+ Custom Agent(自定义情感分析模块)

关键技术实现(附伪代码)

流处理Agent的核心在于实时数据消费、状态管理与动态决策,以下为基于Python的核心逻辑示例:

class IndustrialStreamingAgent:

def __init__(self):

# 初始化Kafka消费者(订阅传感器主题)

self.kafka_consumer = KafkaConsumer(

'sensor_data_topic',

bootstrap_servers=['kafka-node1:9092', 'kafka-node2:9092'],

group_id='predictive-maintenance-group'

)

# 初始化Redis状态存储(保存设备历史数据)

self.state_store = RedisStateBackend(host='redis-cluster', port=6379)

# 加载预训练预测模型

self.predict_model = torch.load('lstm_fault_prediction.pth')

self.llm = OpenAI(model="gpt-4-turbo", temperature=0.3)

def process_real_time_data(self):

for message in self.kafka_consumer:

# 解析设备ID与实时数据

device_id = message.key.decode('utf-8')

real_time_data = json.loads(message.value.decode('utf-8'))

# 从状态存储获取设备历史上下文(近1小时数据)

history_context = self.state_store.get(device_id, default=[])

combined_data = history_context + [real_time_data]

# 模型推理:预测设备健康度

fault_prob = self.predict_model(torch.tensor(combined_data).float())

if fault_prob > 0.7: # 故障概率阈值

# 调用LLM生成故障分析报告

report = self.llm.predict(

f"设备ID: {device_id}\n实时数据: {real_time_data}\n历史趋势: {history_context}\n"

"请分析可能的故障类型、原因及维修建议(精简至300字内)"

)

# 触发告警与工单系统

self.trigger_alert(device_id, fault_prob, report)

# 更新状态存储(保留近1小时数据,避免内存溢出)

self.state_store.update(device_id, combined_data[-3600:]) # 100Hz采样,1小时=3600条

优化策略

- 背压控制:基于Kafka消费者组的分区分配机制,动态调节消费速率,当下游处理能力不足时,自动降低拉取频率,避免数据堆积

- 状态管理优化:采用RocksDB实现本地状态缓存,热点设备的历史数据优先从本地读取,减少Redis访问次数,延迟降低30%

- 容错保障:基于Chandy-Lamport算法实现“精确一次(Exactly-Once)”处理语义,确保数据不重复、不丢失,满足工业级可靠性要求

三、实时部署:交互式服务的“即时响应引擎”

系统架构

实时部署采用微服务架构,将AI Agent封装为REST/gRPC API服务,通过负载均衡器(如Nginx、Envoy)实现请求分发,配合多级缓存(本地缓存+分布式缓存)与推理加速技术(TensorRT、ONNX Runtime),实现亚秒级响应,核心支撑用户交互式场景。

核心应用场景

1. 智能客服对话系统

- 案例背景:某航空公司需为官网/APP用户提供24小时订票咨询、航班查询、退票改签等服务,替代传统人工客服(日均咨询量10万+次)

- 交互流程:

用户发起查询 → API网关(鉴权/路由) → 负载均衡 → AI Agent集群 → [意图识别(BERT)+ 知识库检索(FAISS)] → 多轮对话管理 → 响应生成 → 返回用户 - 技术亮点:

- 采用FAISS向量数据库存储10万+条航空知识库数据,检索延迟<100ms

- 对话上下文通过Redis集群共享,支持跨节点会话续接

- 基于用户画像动态调整响应风格(如对商务用户提供简洁信息,对老年用户提供详细指引)

- 性能指标:支持5000 QPS并发,P99响应延迟<800ms,用户问题解决率从65%提升至85%

2. 游戏NPC智能交互

- 案例背景:某开放世界游戏需实现NPC与玩家的自然对话交互,动态生成剧情分支,提升游戏沉浸感

- 技术突破:

- 将AI Agent服务通过gRPC协议集成至Unreal Engine游戏引擎,支持实时调用

- NPC根据玩家对话内容、行为记录(如完成任务、攻击NPC)动态调整性格与对话逻辑

- 采用模型蒸馏技术,将13B参数的LLM压缩至2B参数,推理速度提升3倍,满足游戏实时性要求

- 架构优势:

- 在全球部署32个边缘计算节点,玩家就近接入,网络延迟降低至50ms以内

- 通过WebRTC协议实现NPC语音实时合成与播放,避免音频卡顿

- 支持动态扩容,游戏峰值时段(如新版本上线)自动增加Agent实例

技术实现细节(附Go语言示例)

以下为基于Go语言的AI Agent服务端核心代码,实现用户查询处理与上下文管理:

// AgentServer 实现gRPC服务接口

type AgentServer struct {

pb.UnimplementedAgentServiceServer

redisClient *redis.Client // 分布式缓存客户端

llmClient *llm.Client // LLM推理客户端

localCache *caffeine.Cache // 本地热点缓存(Caffeine)

}

// HandleQuery 处理用户查询请求

func (s *AgentServer) HandleQuery(ctx context.Context, req *pb.QueryRequest) (*pb.QueryResponse, error) {

userID := req.GetUserID()

query := req.GetQuery()

// 1. 优先从本地缓存获取用户上下文(热点用户)

cacheKey := fmt.Sprintf("context:%s", userID)

contextVal, exists := s.localCache.Get(cacheKey)

if !exists {

// 本地缓存未命中,从Redis获取

redisVal, err := s.redisClient.Get(ctx, cacheKey).Result()

if err != nil && err != redis.Nil {

return nil, fmt.Errorf("failed to get context from redis: %v", err)

}

contextVal = redisVal

// 将非空上下文写入本地缓存(过期时间5分钟)

if redisVal != "" {

s.localCache.Set(cacheKey, redisVal, 5*time.Minute)

}

}

// 2. 构造LLM推理请求(结合上下文)

prompt := fmt.Sprintf("用户上下文:%s\n用户当前查询:%s\n请以简洁、友好的语气回答,避免使用专业术语", contextVal, query)

llmReq := &llm.Request{

Prompt: prompt,

MaxTokens: 500,

Temperature: 0.7, // 控制回答随机性

}

llmResp, err := s.llmClient.Complete(ctx, llmReq)

if err != nil {

return nil, fmt.Errorf("llm inference failed: %v", err)

}

// 3. 异步更新对话历史(上下文+当前查询+回答)

newContext := fmt.Sprintf("%s\n用户:%s\nAI:%s", contextVal, query, llmResp.Text)

go func() {

ctx := context.Background()

// 更新Redis(过期时间24小时)

if err := s.redisClient.Set(ctx, cacheKey, newContext, 24*time.Hour).Err(); err != nil {

log.Printf("failed to update redis context: %v", err)

}

// 更新本地缓存

s.localCache.Set(cacheKey, newContext, 5*time.Minute)

}()

// 4. 返回结果

return &pb.QueryResponse{Answer: llmResp.Text}, nil

}

高可用设计

- 多级缓存架构:采用“本地缓存(Caffeine)+ 分布式缓存(Redis)+ CDN(静态资源)”,热点数据命中率提升至95%,减少后端请求压力

- 服务熔断降级:集成Hystrix组件,当LLM服务响应超时(>1s)或错误率超过5%时,自动切换至预设回答(如“当前咨询量较大,请稍后再试”),避免服务雪崩

- 弹性伸缩机制:基于Kubernetes HPA(Horizontal Pod Autoscaler),根据CPU使用率(阈值70%)、内存使用率(阈值80%)及请求队列深度(阈值100)自动扩缩容,资源利用率提升40%

四、边缘部署:隐私优先的“端侧智能”

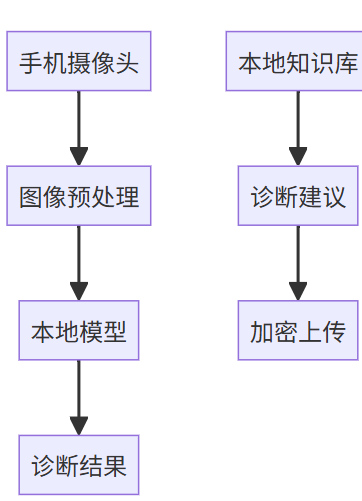

技术架构

边缘部署将AI Agent直接嵌入终端设备(如手机、工业传感器、车载系统),通过模型压缩(量化、剪枝、蒸馏)、本地知识库存储与轻量级推理引擎,实现“设备端自主决策”,无需依赖云端服务,核心优势在于数据隐私保护与低延迟响应。

典型应用场景

1. 移动医疗诊断工具

- 案例背景:某医疗科技公司开发糖尿病视网膜病变筛查APP,面向偏远地区医疗机构,需在无网络环境下实现影像分析

- 端侧实现方案:

- 模型优化:采用MobileNetV3作为基础视觉模型,结合知识蒸馏技术,将模型体积从200MB压缩至12MB,支持手机端本地加载

- 处理流程:

- 隐私保障:原始眼底影像仅在手机端处理,不上传至任何云端服务器,分析结果(如病变等级、建议)本地存储或通过加密蓝牙传输至医院系统

- 性能表现:单张影像分析耗时<3秒,在中端安卓手机上准确率达89%,与云端模型性能差距仅3%

2. 车载语音交互系统

- 案例背景:某车企需为新能源汽车开发离线语音助手,支持导航、音乐控制、空调调节等功能,避免依赖车联网信号

- 技术方案:

- 部署位置:集成于车载娱乐系统(基于Android Automotive OS),占用系统内存<200MB

- 核心技术:

- 推理加速:采用TensorRT对语音识别模型(Whisper Tiny)进行优化,推理速度提升2倍,响应延迟<300ms

- 本地语义理解:集成轻量级NLU引擎Rasa,支持200+条离线命令(如“打开空调24度”“导航到最近的充电桩”),意图识别准确率95%

- 数据安全:行车记录、语音指令等数据仅存储于车载本地存储(加密分区),用户可手动清除,避免数据泄露风险

- 用户体验优化:支持断网状态下的连续对话,通过本地词库动态学习用户习惯(如常用目的地、偏好音乐风格),交互个性化程度提升40%

边缘优化技术栈选型

| 技术方向 | 解决方案 | 效果提升 |

|---|---|---|

| 模型压缩 | INT8量化(TensorFlow Lite)+知识蒸馏 | 模型体积缩小70%,推理速度提升2-3倍 |

| 端侧推理引擎 | TensorRT(车载)、Core ML(iOS)、NNAPI(Android) | 适配不同硬件平台,硬件算力利用率提升50% |

| 本地数据存储 | SQLite(结构化数据)、Realm(NoSQL) | 本地知识库检索延迟<50ms,支持离线读写 |

| 跨设备兼容性 | ONNX通用模型格式+硬件加速指令集 | 模型跨手机/车载/工业设备复用率达90% |

实施挑战与应对方案

- 设备异构性:采用MLIR(多级别中间表示)编译器,自动生成适配不同芯片(如高通骁龙、华为麒麟、瑞萨车载芯片)的目标代码,避免为单一设备重复开发

- 资源限制:设计动态模型加载机制,仅在使用特定功能时激活对应模型模块(如语音交互时加载NLU引擎,影像分析时加载视觉模型),空闲时释放内存,系统占用率降低30%

- 版本同步:采用差分更新技术,当模型需要迭代时,仅推送增量更新包(通常<5MB),而非完整模型,减少OTA流量消耗,更新时间缩短至1分钟内

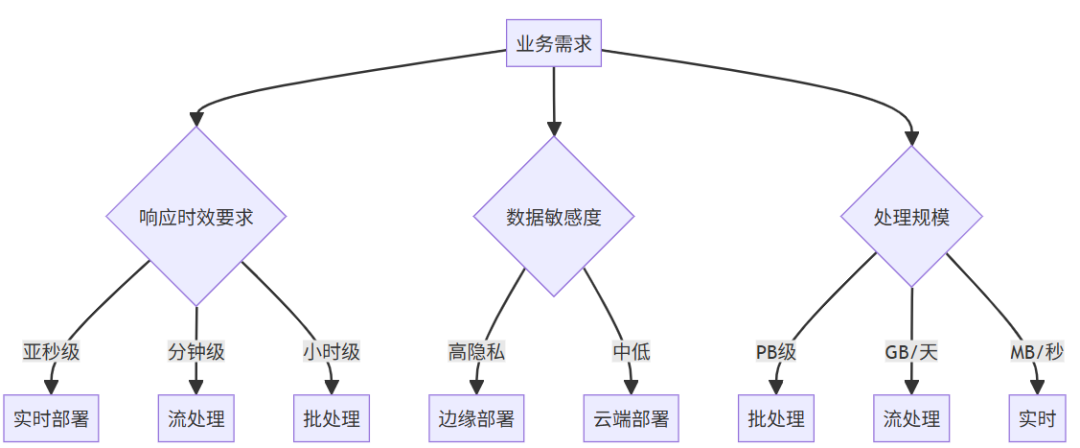

五、部署策略决策框架:从业务需求到技术选型

关键决策维度

企业选择AI Agent部署模式时,需围绕业务时效性、数据规模、隐私要求、成本预算四大核心维度评估,具体决策逻辑如下:

- 时效性要求:

- 实时响应(如智能客服、游戏交互)→ 优先选择实时部署

- 近实时处理(如工业故障预警、舆情监控)→ 采用流处理部署

- 非实时批量处理(如金融风控、医疗影像夜间分析)→ 选用批处理部署

- 数据隐私敏感度:

- 高敏感数据(医疗影像、个人生物信息、车载隐私数据)→ 强制采用边缘部署

- 低敏感公开数据(如公开舆情、通用知识库查询)→ 可选择云端部署(实时/流处理/批处理)

- 数据规模与成本:

- 超大规模数据(TB/PB级,如用户行为分析)→ 批处理部署(成本最低)

- 中等规模实时数据流(如传感器数据、订单数据)→ 流处理部署(平衡成本与时效性)

- 小批量交互式请求(如客服查询、语音指令)→ 实时部署(优先保障体验)

成本效益分析模型

不同部署模式的投入产出比差异显著,企业需结合ROI周期制定预算规划:

| 部署模式 | 基础设施成本(相对值) | 运维复杂度(星级) | 典型ROI周期 | 核心成本优化方向 |

|---|---|---|---|---|

| 批处理 | $(仅需定时计算资源) | ★★☆(调度配置简单) | 6-12个月 | 错峰使用低价云资源(如AWS Spot实例) |

| 流处理 | $$(需持续运行消息队列/流引擎) | ★★★☆(需维护状态一致性) | 3-6个月 | 动态调整流处理节点数量,闲置时缩容 |

| 实时 | $(微服务架构,按需扩容) | ★★★★(需保障高可用/低延迟) | 1-3个月 | 多级缓存降低后端请求量,减少推理节点 |

| 边缘 | $$(终端硬件升级+模型优化) | ★★★★★(跨设备适配复杂) | 12-24个月 | 复用现有终端硬件,采用轻量化模型降低硬件要求 |

混合部署最佳实践

单一部署模式难以满足复杂业务需求,混合部署已成为主流趋势。以某头部电商平台“618大促”场景为例,其部署架构如下:

- 边缘层:用户手机端部署轻量化推荐Agent,基于本地浏览记录生成个性化商品列表(保护用户隐私,减少云端请求)

- 实时层:云端部署库存查询Agent,用户点击商品时实时返回库存状态(保障数据新鲜度,避免超卖)

- 流处理层:实时消费订单数据流,Agent分析订单地域/品类分布,动态调整仓库发货优先级(提升物流效率)

- 批处理层:每日凌晨批量处理用户行为数据(浏览/加购/下单),更新用户画像与推荐算法模型(优化次日推荐效果)

通过混合部署,该平台实现“隐私保护+体验保障+成本可控”的三重目标,大促期间订单处理效率提升50%,用户投诉率下降30%。

六、未来演进趋势:AI Agent部署的下一代技术方向

1. Serverless Agent:按需付费的弹性部署

- 核心逻辑:将AI Agent封装为Serverless函数(如AWS Lambda、阿里云函数计算),无需预置服务器,仅在有请求时触发执行,按调用次数与计算时长计费

- 典型场景:突发流量处理(如电商秒杀、节日客服高峰)、低频任务(如每周用户行为报告生成)

- 优势:资源利用率提升80%,避免闲置资源浪费;自动扩容应对流量峰值,无需人工干预

2. 联邦学习驱动的分布式部署

- 核心逻辑:多终端设备(如医院、银行分支机构)在本地训练AI Agent模型,仅上传模型参数至联邦服务器,聚合后生成全局模型,再下发至各终端更新

- 典型场景:跨医院医疗诊断(保护患者隐私,同时聚合多院数据提升模型准确率)、跨区域金融风控(避免客户数据跨机构传输)

- 技术突破:基于同态加密、差分隐私技术,解决模型参数传输中的安全问题,联邦训练精度已接近集中式训练

3. 量子-经典混合部署

- 核心逻辑:将AI Agent的复杂计算任务(如分子结构推理、大规模优化问题)交由量子计算机处理,简单任务(如数据预处理、结果展示)由经典设备执行,形成“量子加速+经典适配”的协同架构

- 应用前景:药物研发Agent(量子计算加速分子对接模拟)、金融量化交易Agent(量子优化算法提升投资组合收益)

- 当前进展:IBM、阿里云等已推出量子计算云服务,部分场景下量子-经典混合部署的效率比纯经典部署提升10-100倍

4. 自愈式智能部署

- 核心逻辑:AI Agent内置“部署监控+异常修复”模块,通过Chaos Engineering(混沌工程)模拟硬件故障、网络中断、数据异常等场景,自动学习修复策略,实现“故障自检测、问题自定位、系统自恢复”

- 关键技术:结合可观测性工具(如Prometheus、Grafana)实时监控部署状态,通过强化学习训练故障修复模型

- 价值:运维人力成本降低60%,系统可用性从99.9%提升至99.999%(每年 downtime 从8.76小时降至5.25分钟)

如何学习大模型 AI ?

由于新岗位的生产效率,要优于被取代岗位的生产效率,所以实际上整个社会的生产效率是提升的。

但是具体到个人,只能说是:

“最先掌握AI的人,将会比较晚掌握AI的人有竞争优势”。

这句话,放在计算机、互联网、移动互联网的开局时期,都是一样的道理。

我在一线互联网企业工作十余年里,指导过不少同行后辈。帮助很多人得到了学习和成长。

我意识到有很多经验和知识值得分享给大家,也可以通过我们的能力和经验解答大家在人工智能学习中的很多困惑,所以在工作繁忙的情况下还是坚持各种整理和分享。但苦于知识传播途径有限,很多互联网行业朋友无法获得正确的资料得到学习提升,故此将并将重要的AI大模型资料包括AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频免费分享出来。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

为什么要学习大模型?

我国在A大模型领域面临人才短缺,数量与质量均落后于发达国家。2023年,人才缺口已超百万,凸显培养不足。随着AI技术飞速发展,预计到2025年,这一缺口将急剧扩大至400万,严重制约我国AI产业的创新步伐。加强人才培养,优化教育体系,国际合作并进是破解困局、推动AI发展的关键。

大模型入门到实战全套学习大礼包

1、大模型系统化学习路线

作为学习AI大模型技术的新手,方向至关重要。 正确的学习路线可以为你节省时间,少走弯路;方向不对,努力白费。这里我给大家准备了一份最科学最系统的学习成长路线图和学习规划,带你从零基础入门到精通!

2、大模型学习书籍&文档

学习AI大模型离不开书籍文档,我精选了一系列大模型技术的书籍和学习文档(电子版),它们由领域内的顶尖专家撰写,内容全面、深入、详尽,为你学习大模型提供坚实的理论基础。

3、AI大模型最新行业报告

2025最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

4、大模型项目实战&配套源码

学以致用,在项目实战中检验和巩固你所学到的知识,同时为你找工作就业和职业发展打下坚实的基础。

5、大模型大厂面试真题

面试不仅是技术的较量,更需要充分的准备。在你已经掌握了大模型技术之后,就需要开始准备面试,我精心整理了一份大模型面试题库,涵盖当前面试中可能遇到的各种技术问题,让你在面试中游刃有余。

适用人群

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

- 硬件选型

- 带你了解全球大模型

- 使用国产大模型服务

- 搭建 OpenAI 代理

- 热身:基于阿里云 PAI 部署 Stable Diffusion

- 在本地计算机运行大模型

- 大模型的私有化部署

- 基于 vLLM 部署大模型

- 案例:如何优雅地在阿里云私有部署开源大模型

- 部署一套开源 LLM 项目

- 内容安全

- 互联网信息服务算法备案

- …

学习是一个过程,只要学习就会有挑战。天道酬勤,你越努力,就会成为越优秀的自己。

如果你能在15天内完成所有的任务,那你堪称天才。然而,如果你能完成 60-70% 的内容,你就已经开始具备成为一名大模型 AI 的正确特征了。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献353条内容

已为社区贡献353条内容

所有评论(0)