3 分钟部署分布式 TTS 系统!IndexTTS2 一键启动,GPU 成本省七成

IndexTTS2分布式语音合成系统为企业级应用提供高效解决方案,解决传统TTS面临的三大痛点:商业API成本高、本地部署复杂、资源利用率低。该系统基于RabbitMQ实现弹性分布式架构,支持动态扩容和智能资源管理,通过Docker实现一键部署。核心优势包括:情感丰富的语音合成能力、自动开关机节省成本、消息队列稳定处理高并发任务。适用于视频配音、数字人等场景,开发者可通过简单命令快速搭建私有语音工

告别昂贵 API!用 IndexTTS2 搭建你的私有化、情感丰富的分布式语音工厂

作为一名 AI 开发者或内容创作者,你是否陷入过这样的**「语音合成困境」**?

- 商业 API 太贵:按字符计费,跑一本有声书或批量生成视频配音,钱包根本顶不住。

- 本地部署太难:开源模型效果好,但光是配环境(CUDA、PyTorch 版本打架)就花一天,还得自己写接口。

- 资源利用率低:租了台昂贵的 GPU 服务器,结果半夜没事干也在烧钱;或者突发大量任务时,单机跑不动,排队排到天荒地老。

今天我要按头安利一个完美的破局方案——IndexTTS2 分布式语音合成系统。

它不仅仅是一个 TTS 模型,更是一套基于 RabbitMQ 的企业级分布式架构。它既能让个人开发者用 Docker 一键跑起高质量的情感语音,又能帮企业实现「按需开关机」的极致成本控制。

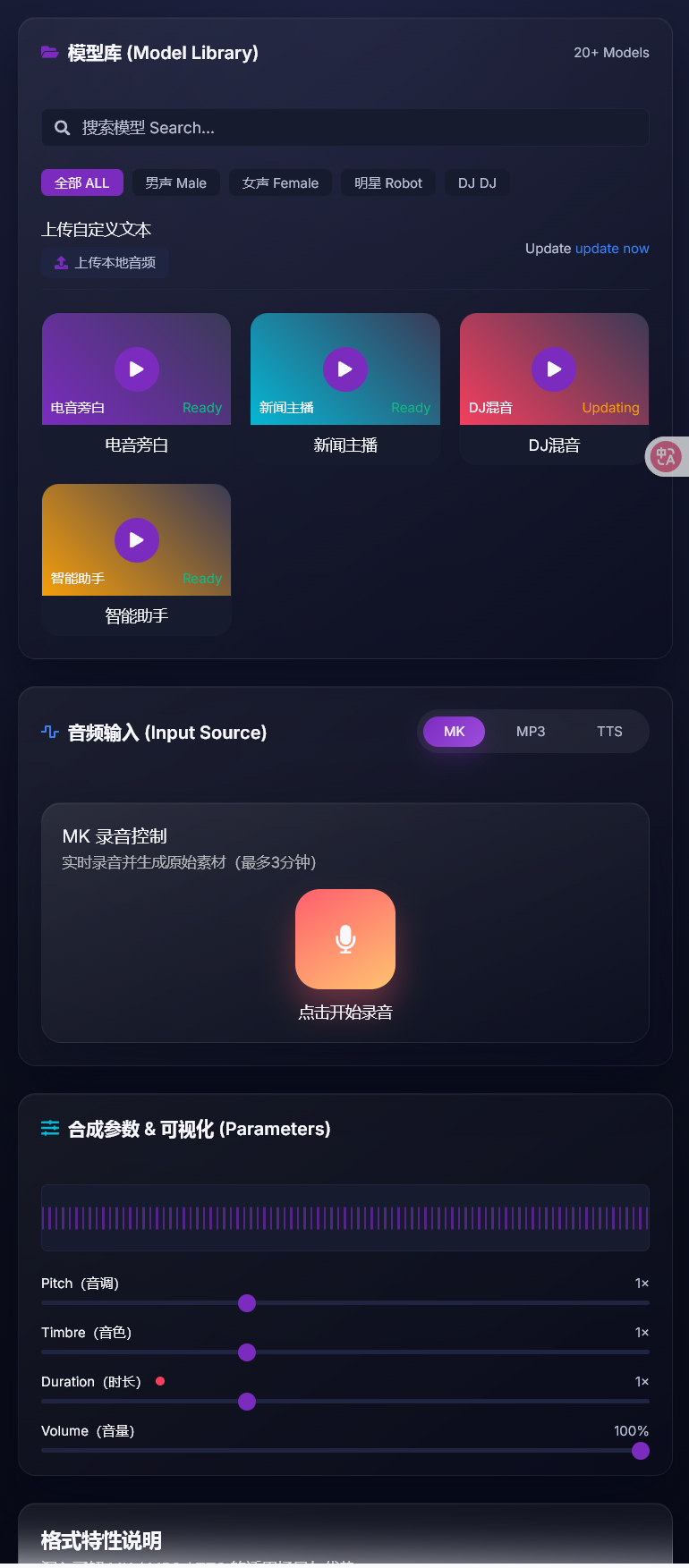

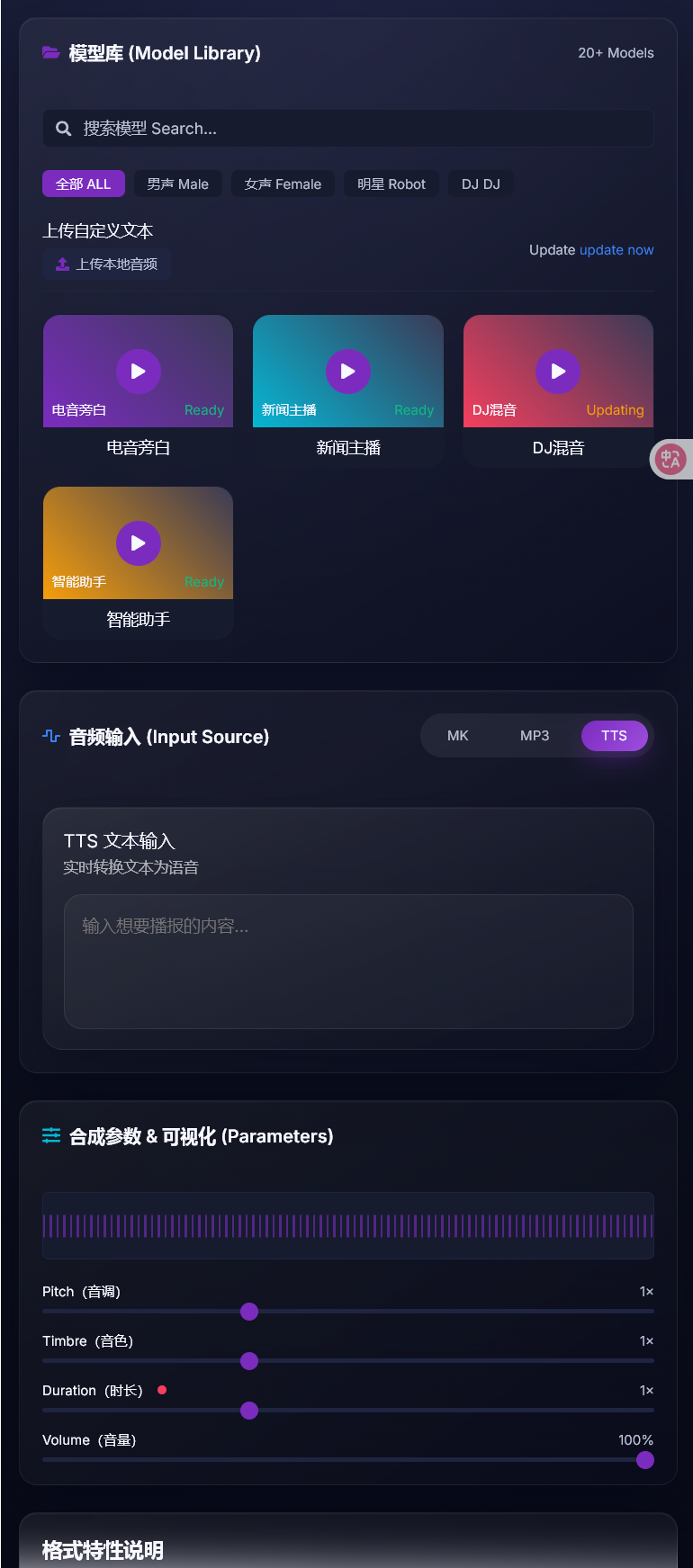

UI展示

为什么 IndexTTS2 值得你立刻上手?

1. 它是“有灵魂”的语音合成

首先,回归 TTS 的本质:好听。

IndexTTS2 内置的高性能模型支持情感控制。你需要“悲伤”的旁白?还是“开心”的解说?它都能通过参数精准控制。相比那些冷冰冰的机械音,它生成的语音更有感染力,且支持时长控制,完美适配视频配音的时间轴。

2. “真”分布式架构,专治各种并发焦虑

很多开源项目只是个 Python 脚本,而 IndexTTS2 设计之初就是为了生产环境:

- RabbitMQ 坐镇核心:采用消息队列实现任务调度。你可以瞬间扔进一万条文本,系统会稳稳接住,绝不崩溃。

- 弹性扩容:任务太多处理不过来?简单!结合 Docker,你可以在多台机器上横向扩展 Worker,算力瞬间翻倍。

3. 极致的“抠门”艺术:自动开关机 (Auto-Scaling)

这是我最喜欢的功能,没有之一!

在云端跑 GPU 最怕什么?怕忘了关机。

IndexTTS2 引入了智能资源管理模块:

- 有任务时:系统检测到队列有消息,自动调用阿里云 API 启动 ECS GPU 实例。

- 没任务时:Worker 处理完任务空闲一段时间(TTL),系统自动关机。

这直接实现了 Serverless 般的体验——你只为真正合成语音的那几分钟付费,彻底告别资源空转浪费!

4. Docker 化部署,拒绝“环境地狱”

如果你受够了 Python 依赖冲突,IndexTTS2 的 Docker 支持会让你感动。

- 一键启动:通过 Docker 封装了所有系统库和 Python 包,配合 NVIDIA Container Toolkit,直接打通 GPU。

- 内网加速:你可以先在本地调试好模型,上传到 OSS,云端实例启动时通过内网秒级加载。本地调试 -> 云端量产,这套工作流极其丝滑。

适用场景:谁最需要它?

- 自媒体/UP主:搭建自己的配音流水线,批量生产视频旁白,不用再买配音软件会员。

- AI 应用开发者:需要为自己的数字人、客服系统接入低延迟、高并发的 TTS 能力。

- 架构师/运维:想学习如何设计一个基于消息队列的异步任务系统,这绝对是教科书级的开源案例。

快速开始

项目非常贴心地提供了一键安装脚本(支持 uv 包管理器,速度飞快)。

- 拉取代码并安装依赖:

git clone [项目地址]

pip install uv && uv sync

- 启动 RabbitMQ(Docker 一行命令搞定):

docker run -d -p 5672:5672 rabbitmq:3-management

- 运行 Worker:

配置好你的模型路径,启动rabbitmq_worker.py,你的语音工厂就开始运转了!

总结

IndexTTS2 展示了 AI 工程化的最佳实践:用 Docker 解决交付,用 RabbitMQ 解决调度,用自动开关机解决成本,用优秀模型解决质量。

如果你想拥有一个私有、便宜、强大且可无限扩展的语音合成系统,IndexTTS2 绝对是目前的最佳选择之一。

👉 项目传送门: https://github.com/ylong52/aliyun-indextts2

👉 详细手册: https://www.yuque.com/u33692715/simxeb/argsytnkl41qawrv?singleDoc# 《3 分钟部署分布式 TTS 系统!IndexTTS2 一键启动,GPU 成本省七成》

哪怕你暂时用不上,把它的架构图保存下来,下次面试被问到“如何设计高并发任务处理系统”时,这也就是满分答案。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)