从 0 到 1 玩转大模型:新手入门 + 老手速查指南

作为 AI 技术布道师,经常被问 “大模型到底是什么?”“新手该从哪开始学?”“老手如何快速落地项目?这篇博客就像一本 “大模型实用手册”,既用大白话带新手入门,也为老手整理了核心技术和工具速查,让你既能懂原理,又能上手用。

作为 AI 技术布道师,经常被问 “大模型到底是什么?”“新手该从哪开始学?”“老手如何快速落地项目?”。这篇博客就像一本 “大模型实用手册”,既用大白话带新手入门,也为老手整理了核心技术和工具速查,让你既能懂原理,又能上手用。

一、核心概念:先搞懂 “大模型到底是什么”

1. 模型:会 “找规律” 的超级加工厂

简单说,模型是从海量数据中学习规律的 “数学程序”。就像给它看无数组 “输入→输出” 示例,它会自己摸索规则,再遇到类似输入时就能给出结果。比如输入[1,2,3]输出2、输入[5,10,15]输出10,模型会学到 “输出是中间数” 的规律,再输入[8,9,10]时就会给出9。

2. 大语言模型(LLM):懂语言、有知识的 “超级大脑”

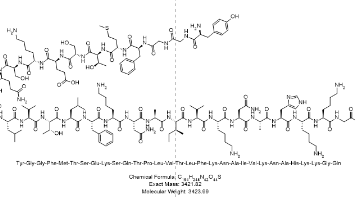

大语言模型是参数规模达数十亿至万亿级的语言模型,核心是用 “神经网络” 模仿人脑工作,通过 “自监督学习” 从海量文本中掌握语言规律、积累知识。

- 关键特点:

- ✅ 通用性强:不用专门训练,就能做聊天、翻译、写代码、解数学题等多种任务;

- ✅ 交互自然:像和人说话一样发指令(Prompt),就能得到结果;

- ✅ 知识渊博:学习了互联网海量文本,涵盖常识、专业知识等。

进阶提示:参数规模是 LLM 能力的重要指标,但不是唯一标准。相同参数下,训练数据质量、模型架构(如 Transformer)、优化策略都会影响性能,比如 DeepSeek R1(开源)在逻辑推理任务中,性能接近闭源的 GPT-4o。

3. 关键术语速解(新手必看)

- 神经网络:模仿人脑神经元工作的 “决策流水线”,无数个 “虚拟神经元” 协同处理信息;

- 自监督学习:模型自己给自己 “出题”(比如遮盖文本中的词猜答案),从无标注数据中自学;

- 提示词(Prompt):给模型的指令,好的提示词能让模型精准输出想要的结果;

- 嵌入模型(Embedding):把文字、图片等转换成计算机能理解的 “数字向量”,核心用于语义搜索、推荐等场景。

深度解析:自监督学习是 LLM 规模化的核心。传统模型需要人工标注海量数据(比如给图片标 “是猫”“不是猫”),而自监督学习让模型从互联网原生文本中自学,效率提升百倍,这也是大模型能快速发展的关键。

二、学习路径:新手→老手的进阶路线

1. 新手阶段(0-3 个月):从 “体验” 到 “简单调用”

- 先体验主流模型:用 ChatGPT、DeepSeek、文心一言等客户端,尝试聊天、写文案、解难题,感受大模型的能力边界;

- 理解核心概念:搞懂 “模型、Prompt、API” 等基础术语,明白 “输入→模型处理→输出” 的基本流程;

- 动手做简单调用:用 Python 的

requests库调用 DeepSeek 或 OpenAI 的 API,实现 “发送消息→接收回复” 的简单功能(参考下文工具部分的示例)。

2. 进阶阶段(3-6 个月):从 “会用” 到 “用好”

- 精通提示工程:学习 CO-STAR 框架、思维链(CoT)等技巧,让模型输出更精准、更符合需求;

- 掌握嵌入与 RAG:了解嵌入模型的作用,尝试用 RAG(检索增强生成)解决 “模型知识过时”“不会私有数据” 的问题;

- 尝试本地部署:用 Ollama 一键部署开源模型(如 DeepSeek-R1、Qwen),体验私有化部署的流程。

3. 老手阶段(6 个月 +):从 “用好” 到 “落地”

- 模型微调:针对特定场景(如行业知识库问答),用自有数据微调模型,提升任务准确率;

- 构建复杂应用:结合 LangChain 框架,开发 RAG 客服机器人、AI 写作助手、数据分析工具等;

- 优化性能与成本:平衡模型效果、响应速度、调用成本,比如小场景用轻量化模型,复杂任务用大模型。

三、关键技术:核心能力落地必备

1. 提示工程:让模型 “听懂” 你的需求

这是最基础也最核心的技术,不用改代码,就能大幅提升模型输出质量。

- 核心技巧:

- ✅ 清晰具体:明确任务、背景、输出格式

- 比如不说 “写个旅行计划”,而说 “写一份周末北京旅行计划,含 3 个景点、交通方式和 500 元预算”;

- ✅ CO-STAR 框架:从 Context(背景)、Objective(目标)、Steps(步骤)、Tone(风格)、Audience(受众)、Response(输出格式)6 个维度设计提示词;

- ✅ 思维链(CoT):复杂问题让模型 “一步步推理”,比如数学题、逻辑题,在提示词末尾加 “请一步步推理并得出结论”。

示例:用思维链解决数学题提示词:“食堂总共有 23 个苹果,用掉 20 个后又买了 6 个,现在有多少个?请一步步推理并得出结论。”模型输出:“食堂起初有 23 个苹果,用掉 20 个后剩余 3 个,再买 6 个,总共 3+6=9 个,答案是 9 个。”

2. 嵌入模型与 RAG:解决模型 “知识短板”

大模型有两个天然短板:知识有截止日期(比如不知道 2025 年的新政策)、不懂私有数据(比如公司内部文档),RAG 技术能完美解决这两个问题。

- 核心逻辑:

- 用嵌入模型把私有知识库(如公司文档)转换成 “数字向量”,存入向量数据库;

- 用户提问时,先从向量数据库中检索出相关的知识库内容;

- 把 “用户问题 + 检索到的知识库内容” 一起发给大模型,让模型基于这些信息生成答案。

深度解析:RAG 的关键是 “检索精准度”。向量数据库的选择很重要:小项目用 Chroma(轻量易部署),大项目用 Milvus(高吞吐量、支持大规模数据);嵌入模型优先选开源的 Qwen3-Embedding-8B(支持 32K 长文本)或闭源的 text-embedding-3-large(精度高)。

3. 模型接入方式:3 种主流方案对比

| 接入方式 | 核心特点 | 适用场景 |

|---|---|---|

| API 远程调用 | 开箱即用,无需维护硬件,按调用量付费 | 快速开发、小规模应用、无技术运维团队 |

| 开源模型本地部署 | 数据私有可控,无调用成本,需 GPU 硬件 | 数据敏感场景、大规模应用、有运维能力 |

| SDK 接入 | 封装 HTTP 请求,代码更简洁,本质是 API 调用 | 开发效率优先、需要嵌入自有程序 |

新手推荐:先从 API 调用入手,用 Python 的

requests库或官方 SDK,几行代码就能实现调用(示例见下文工具部分);老手提示:本地部署优先用 Ollama(一键拉取模型),生产环境用 vLLM(高吞吐量推理框架)提升性能。

四、常用工具:提高效率的 “神兵利器”

1. 基础工具:快速上手必备

- API 平台:OpenAI(GPT 系列)、DeepSeek(逻辑推理强)、百度千帆(文心一言)、阿里通义千问(企业级场景);

- 本地部署工具:Ollama(一键部署开源模型,支持 DeepSeek-R1、Qwen)、LM Studio(图形化界面,适合新手);

- 开发库:requests(发送 HTTP 请求)、openai/deepseek-sdk(官方 SDK)、transformers(加载开源模型)。

API 调用示例(Python):

import requests

api_key = "你的API密钥"

url = "https://api.deepseek.com/chat/completions"

headers = {"Content-Type": "application/json", "Authorization": f"Bearer {api_key}"}

data = {"model": "deepseek-chat", "messages": [{"role": "user", "content": "写一段关于春天的短诗"}]}

response = requests.post(url, headers=headers, json=data)

print(response.json()["choices"][0]["message"]["content"])

2. 开发框架:构建复杂应用

- LangChain:大模型应用开发 “瑞士军刀”,统一 API 对接各种模型、向量数据库,支持 RAG、Agent 等复杂场景;

- LlamaIndex:专注于 RAG 场景,简化知识库构建、检索流程,适合快速开发问答类应用。

3. 向量数据库:存储 “数字向量”

- Chroma:轻量级、易部署,适合原型开发和小规模数据;

- Milvus:高性能、支持大规模数据,适合生产环境;

- Pinecone:云原生向量数据库,无需本地部署,按使用量付费。

五、核心术语表(速查版)

| 术语 | 简洁解释 |

|---|---|

| LLM | 大语言模型,参数数十亿至万亿级,精通语言和知识任务 |

| Prompt | 给模型的指令,决定模型输出方向和质量 |

| 思维链(CoT) | 让模型分步推理,提升复杂问题准确率 |

| RAG | 检索增强生成,结合知识库和大模型,解决知识过时问题 |

| 嵌入模型 | 将文本 / 图片转换为数字向量,用于语义搜索、推荐 |

| 自监督学习 | 模型从无标注数据中自学,无需人工标注 |

| SDK | 封装好的开发工具库,简化 API 调用流程 |

六、进一步学习资源推荐

1. 官方文档

- OpenAI API 文档:https://platform.openai.com/docs

- DeepSeek 开发者文档:https://platform.deepseek.com/docs

- LangChain 官方指南:https://python.langchain.com/docs

2. 课程与社区

- Hugging Face:开源模型和工具聚集地,https://huggingface.co/;

- 魔搭社区:国内开源模型平台,https://www.modelscope.cn/。

3. 实践项目

- 新手:实现一个 “API 调用聊天机器人”“简单 RAG 知识库问答”;

- 老手:开发 “AI 客服机器人”“文档自动摘要工具”“多模态内容生成器”。

大模型的学习核心是 “先体验、再理解、后落地”,新手不用害怕复杂概念,先动手调用一次 API,就能感受到它的强大;老手可以聚焦提示工程、RAG、本地部署等核心技术,快速落地实际项目。如果遇到具体问题,欢迎在评论区交流,我们一起玩转大模型!

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)