免费薅羊毛!AI Ping 上线 GLM-4.7 与 MiniMax M2.1,保姆级使用教程

本文介绍了国内领先的大模型服务评测与聚合平台 AI Ping 最新上线的两款旗舰模型——GLM-4.7 与 MiniMax M2.1。GLM-4.7 智谱出品,侧重复杂工程任务的一次性交付与 Agentic Coding 场景;MiniMax M2.1 则面向长链 Agent 执行,强化多语言工程能力与持续运行效率。两款模型均可在 AI Ping 平台免费体验,支持统一 OpenAI 兼容接口调用

目录

摘要

本文介绍了国内领先的大模型服务评测与聚合平台 AI Ping 最新上线的两款旗舰模型——GLM-4.7 与 MiniMax M2.1。GLM-4.7 智谱出品,侧重复杂工程任务的一次性交付与 Agentic Coding 场景;MiniMax M2.1 则面向长链 Agent 执行,强化多语言工程能力与持续运行效率。两款模型均可在 AI Ping 平台免费体验,支持统一 OpenAI 兼容接口调用。本文还将详细介绍如何通过 Claude Code 和 Coze 等工具接入使用这两款强力模型。

呼朋唤友薅羊毛,Token白给不限量!

邀请好友体验 AI Ping (aiping.cn),https://aiping.cn/#?channel_partner_code=GQCOZLGJ (注册登录立享30元算力金),所有模型及供应商全场通用!邀一个赚一个,上不封顶!快点动动发财的小手来抢福利吧~~

AI Ping

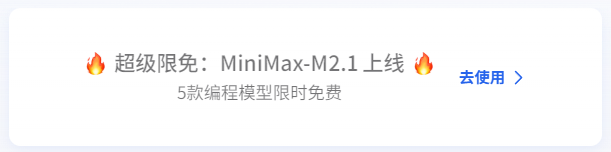

AI Ping(aiping.cn)是国内领先的大模型服务评测与聚合平台,致力于为开发者提供全面、客观、真实的模型性能数据和统一调用入口。平台已接入智谱、MiniMax、DeepSeek、通义千问等主流厂商,覆盖95+模型,涵盖文本生成、视觉理解、图像生成、Embedding、Reranker 等多种类型。

平台核心优势包括:多供应商统一调用——一套接口切换不同供应商;性能数据可视化——实时展示吞吐、延迟、价格、可靠性等关键指标;智能路由——高峰时段自动选择最优供应商保障稳定性。目前 GLM-4.7、MiniMax-M2.1、DeepSeek-V3.2 等旗舰模型可免费体验,更有邀请好友双方各得20元算力点的活动,上不封顶。进入AI Ping 首页

GLM-4.7 与 MiniMax M2.1 分别代表了当前国产模型在工程交付能力 与 Agent 长期运行效率 上的两种成熟路线: 前者通过可控推理与工具协同,强化复杂工程任务的一次性交付; 后者依托高效 MoE 架构与多语言优化,面向 AI-native 组织的持续 Agent 工作流。 两者都不再以单轮生成质量为核心,而是直指真实复杂工程场景中的长期稳定工作能力。可以看到两大强力模型已经上线并且免费!

模型库

AI Ping 模型库概览,大部分的模型都是免费使用~

- NEW - 新上线:GLM-4.7、MiniMax-M2.1、MiMo-V2-Flash、Ring-1T 等

- FREE - 免费:DeepSeek-V3.2、GLM-4.7、MiniMax-M2.1、Doubao-Seedream-4.5 等

- HOT - 热门:GLM-4.6、MiniMax-M2、DeepSeek系列等

模型系列分类

|

系列 |

厂商 |

代表模型 |

|

GLM |

智谱 |

GLM-4.7(NEW)、GLM-4.6、GLM-4.5、GLM-Z1系列 |

|

MiniMax |

MiniMax |

MiniMax-M2.1(NEW)、MiniMax-M2、MiniMax-M1-80k |

|

DeepSeek |

深度求索 |

DeepSeek-V3.2(FREE)、DeepSeek-R1系列、DeepSeek-V3系列 |

|

Qwen |

阿里通义 |

Qwen3系列、Qwen2.5系列、Qwen-Coder、Qwen-VL |

|

Kimi |

月之暗面 |

Kimi-K2-Thinking、Kimi-K2-Instruct |

|

Doubao |

字节跳动 |

Doubao-Seedream-4.5(FREE)、Doubao-Seedream-4.0 |

|

Hunyuan |

腾讯混元 |

Hunyuan-A13B、HunyuanImage-3.0 |

|

Ernie |

百度文心 |

ERNIE-4.5系列 |

|

Ling/Ring |

百灵 |

Ling-1T、Ring-1T |

|

Kolors |

快手 |

Kolors |

|

Kling |

可灵 |

Kling-V1/V1.5/V2/V2.1 |

|

即梦 |

字节 |

即梦图片生成、即梦文生图 |

|

Wan |

通义万相 |

Wan2.5系列 |

|

BGE |

BAAI |

bge-reranker系列 |

|

MiMo |

小米 |

MiMo-V2-Flash(NEW) |

模型类型覆盖

|

类型 |

说明 |

|

文本生成 |

通用对话、推理、编码 |

|

视觉理解 |

图像/视频理解、OCR |

|

图像生成 |

文生图、图生图、图像编辑 |

|

Embedding |

文本向量化 |

|

Reranker |

检索重排序 |

价格范围

|

类型 |

输入价格 |

输出价格 |

|

免费模型 |

¥0/M |

¥0/M |

|

付费模型 |

¥0.1~¥15/M |

¥0.1~¥60/M |

上下文长度

|

范围 |

模型示例 |

|

16K 以下 |

部分小参数模型、专用模型 |

|

16-64K |

Qwen2.5系列、GLM-4系列部分版本 |

|

64K 以上 |

GLM-4.7(200K)、MiniMax-M2.1(200K)、DeepSeek-R1(144K)、Kimi-K2(256K) |

AI Ping 平台通过统一接口聚合了多家供应商的模型服务,用户可以按模型系列、模型类型、输入/输出格式、上下文长度、价格等多维度筛选,快速找到最适合的模型。

GLM-4.7

GLM-4.7简介

GLM-4.7 是智谱最新旗舰模型,GLM-4.7 面向 Agentic Coding 场景强化了编码能力、长程任务规划与工具协同,并在可控推理机制支撑下实现了复杂工程任务的稳定交付。通用能力全面提升,回复更简洁自然,写作更具沉浸感。在执行复杂智能体任务时,指令遵循能力更强,Artifacts 与 Agentic Coding 的前端美感和长程任务完成效率进一步提升。

与 MiniMax M2.1 的对比:

- GLM-4.7:侧重一次性工程交付,适合复杂编码任务 + Artifacts 前端生成

- MiniMax M2.1:侧重长期稳定运行,适合长链 Agent + 多语言后端工程

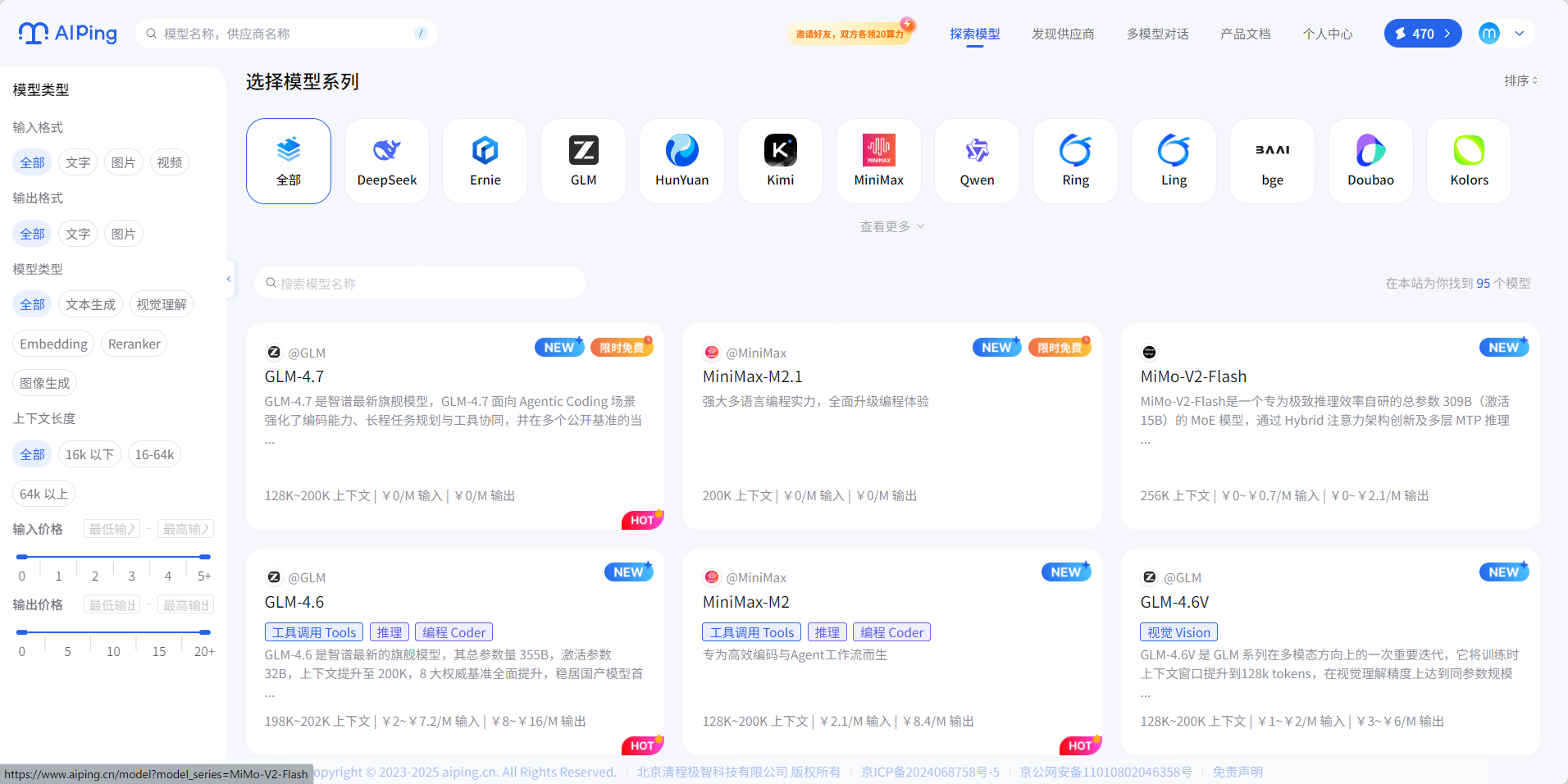

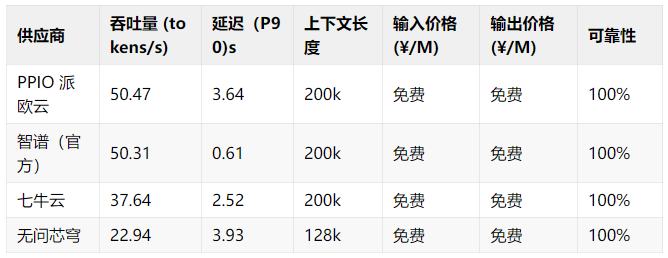

GLM-4.7实测数据

AI Ping 平台测试数据(数据截至 2025 年 12 月 23 日 18:00)

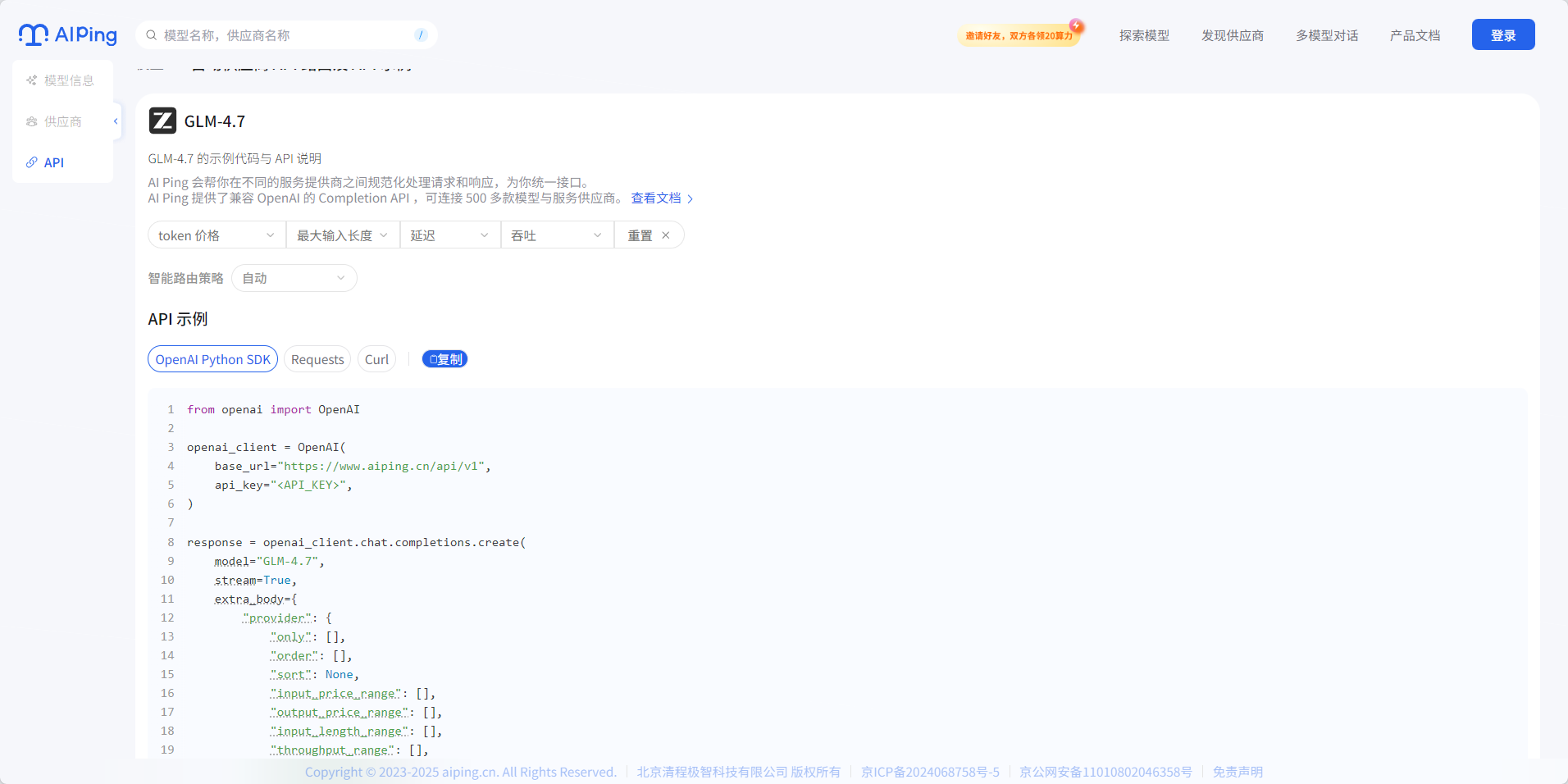

GLM-4.7调用方式

AI Ping还提供了详细的调用方式:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***",

)

response = openai_client.chat.completions.create(

model="GLM-4.7",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

MiniMax-M2.1

MiniMax-M2.1简介

MiniMax M2.1 是 MiniMax 最新旗舰模型,MiniMax M2.1 面向长链 Agent 执行场景强化了多语言工程能力、持续运行效率与收敛推理路径,并在高效 MoE 架构支撑下实现了吞吐与稳定性的出色平衡。多语言工程能力强化,对 Rust / Go / Java / C++ 等生产级代码支持更完善。在执行长时间 Agent 工作流时,推理路径更收敛、工具调用更高效,凭借低激活参数与 200k 长上下文优势,连续编码与持续运行吞吐进一步提升。

与 GLM-4.7 的对比:

- GLM-4.7:侧重一次性工程交付,适合复杂编码任务 + Artifacts 前端生成

- MiniMax M2.1:侧重长期稳定运行,适合长链 Agent + 多语言后端工程

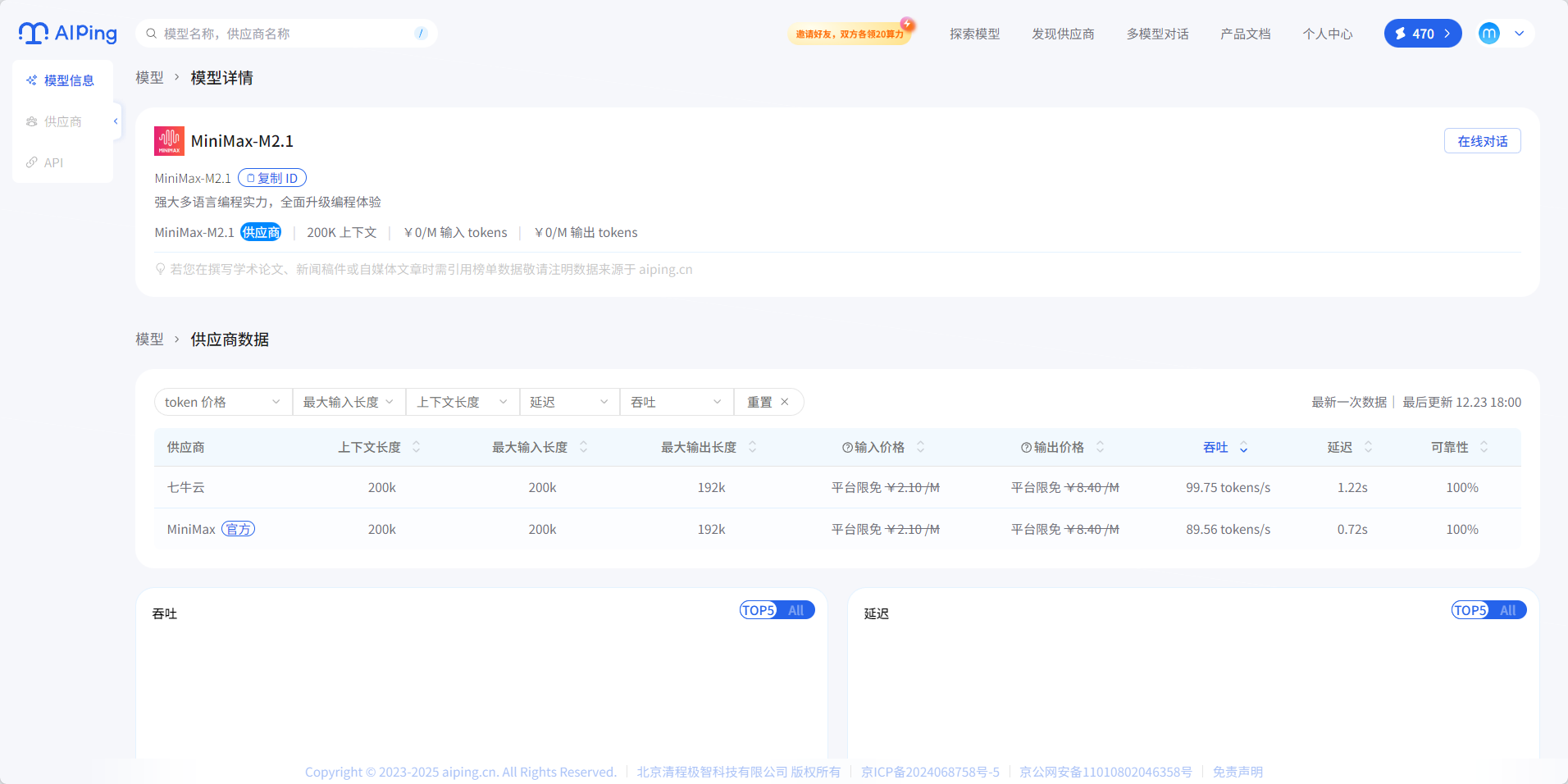

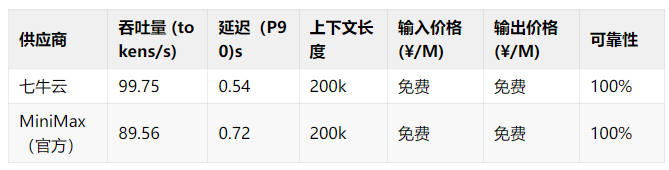

MiniMax-M2.1实测数据

AI Ping 平台测试数据(数据截至 2025 年 12 月 23 日 18:00)

MiniMax-M2.1调用方式

AI Ping还提供了详细的调用方式:

from openai import OpenAI

openai_client = OpenAI(

base_url="https://www.aiping.cn/api/v1",

api_key="***",

)

response = openai_client.chat.completions.create(

model="MiniMax-M2.1",

stream=True,

extra_body={

"provider": {

"only": [],

"order": [],

"sort": None,

"input_price_range": [],

"output_price_range": [],

"input_length_range": [],

"throughput_range": [],

"latency_range": []

}

},

messages=[

{"role": "user", "content": "Hello"}

]

)

for chunk in response:

if not getattr(chunk, "choices", None):

continue

reasoning_content = getattr(chunk.choices[0].delta, "reasoning_content", None)

if reasoning_content:

print(reasoning_content, end="", flush=True)

content = getattr(chunk.choices[0].delta, "content", None)

if content:

print(content, end="", flush=True)

如何选择模型?

GLM-4.7 与 MiniMax M2.1 虽然都是旗舰级模型,但定位和适用场景有明显差异。根据你的具体需求,可参考以下选型指南:

核心差异对比

|

维度 |

GLM-4.7 |

MiniMax M2.1 |

|

技术路线 |

可控推理 + 工具协同 |

高效 MoE 架构 |

|

核心优势 |

一次性工程交付能力 |

长期稳定运行效率 |

|

语言专长 |

Python、前端全栈 |

Rust、Go、Java、C++ 等多语言后端 |

|

上下文长度 |

200K |

200K |

|

最佳场景 |

Agentic Coding、Artifacts 前端生成 |

长链 Agent 工作流、持续编码 |

|

推理风格 |

路径可控、指令遵循强 |

路径收敛、工具调用高效 |

场景选型决策表

|

你的需求场景 |

推荐模型 |

理由 |

|

前端开发 + UI 生成 |

GLM-4.7 |

Artifacts 能力强,前端代码美观度更高 |

|

需要快速生成完整项目 |

GLM-4.7 |

一次性交付能力强,适合从零到一构建 |

|

后端多语言开发 |

MiniMax M2.1 |

对 Rust/Go/Java/C++ 支持更完善 |

|

构建 AI Agent 系统 |

MiniMax M2.1 |

长链工作流稳定,推理路径收敛 |

|

需要长时间运行的编码任务 |

MiniMax M2.1 |

持续运行吞吐更高,稳定性更好 |

|

复杂任务规划与执行 |

GLM-4.7 |

指令遵循能力强,长程任务规划更可控 |

|

多轮对话式开发 |

MiniMax M2.1 |

在持续交互中表现更稳定 |

|

单次生成质量要求高 |

GLM-4.7 |

可控推理机制保证输出质量 |

快速决策流程图

是否需要生成前端/UI?

├── 是 → GLM-4.7

└── 否 → 是否涉及 Rust/Go/Java/C++ 等后端语言?

├── 是 → MiniMax M2.1

└── 否 → 任务是否需要长时间持续运行?

├── 是 → MiniMax M2.1

└── 否 → 是否需要一次性完成复杂工程交付?

├── 是 → GLM-4.7

└── 否 → 两者均可,按个人偏好选择组合使用建议

对于大型项目,可以考虑组合使用两款模型:

- GLM-4.7:负责项目初始化、核心架构设计、前端界面生成

- MiniMax M2.1:负责后端逻辑实现、长链业务流程、持续迭代优化

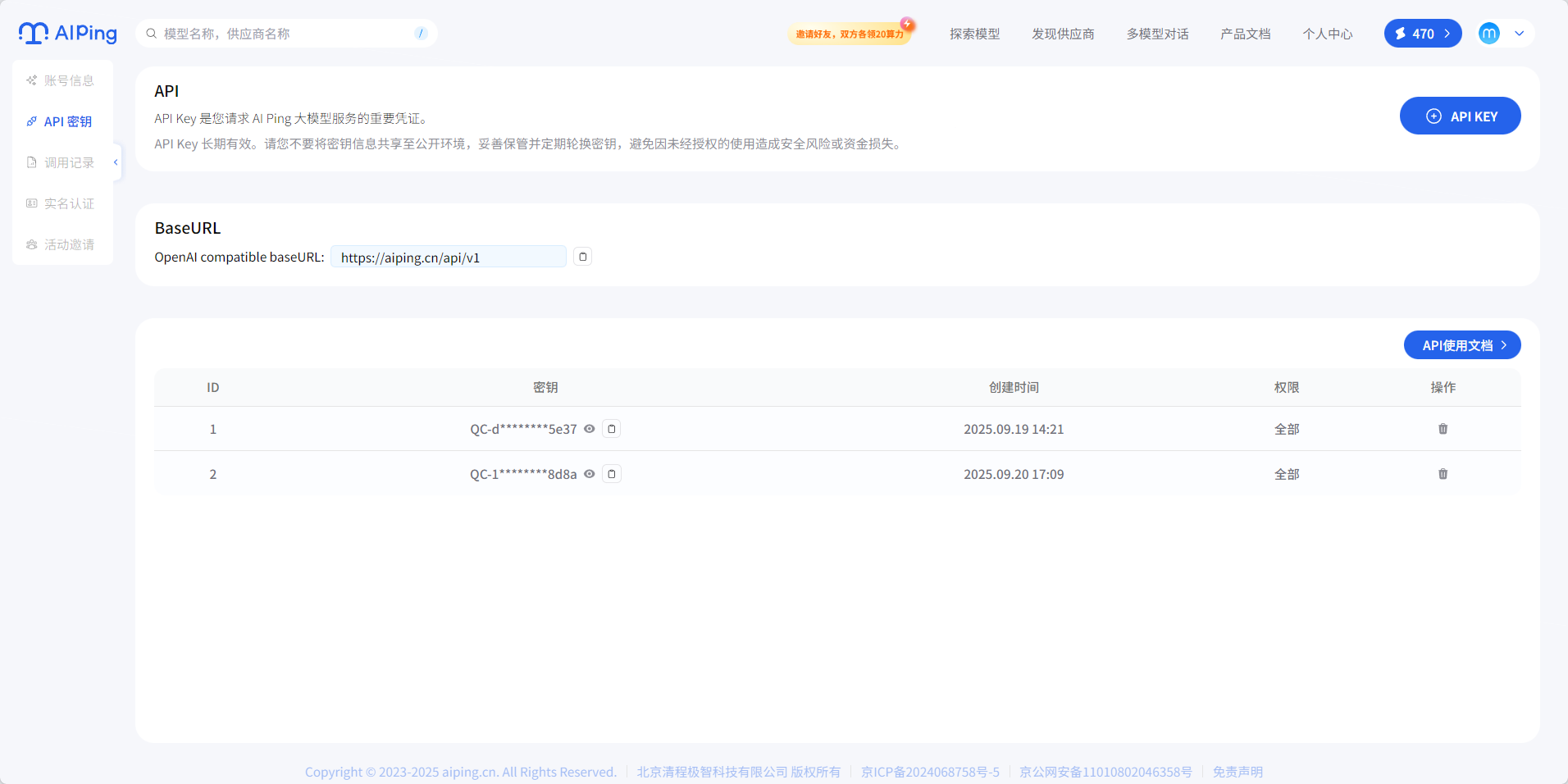

获取API KEY

如何使用AI Ping?

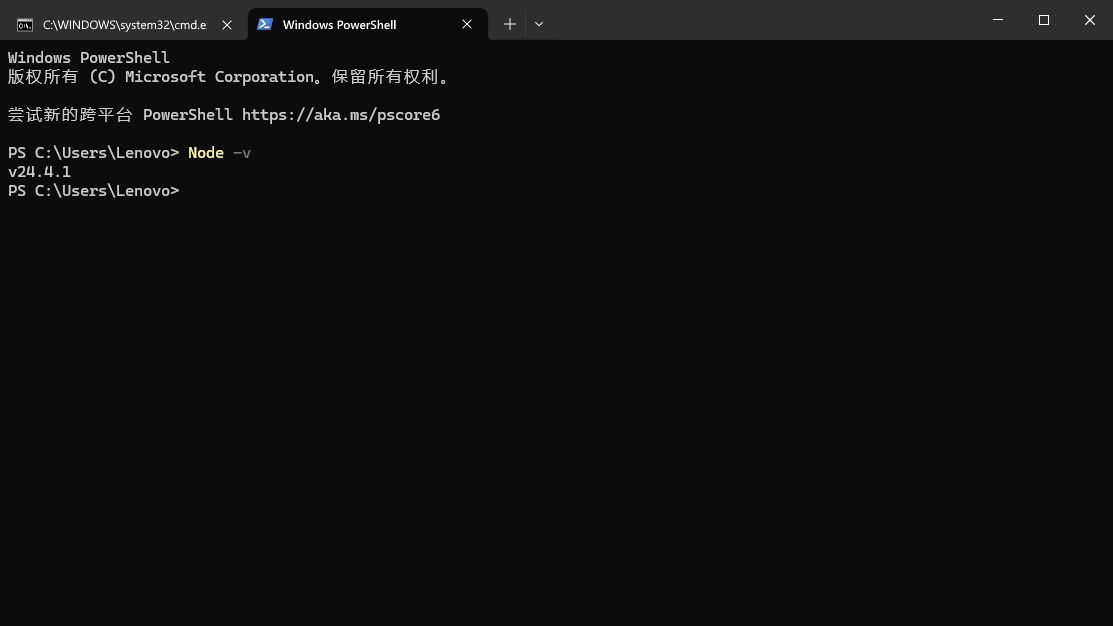

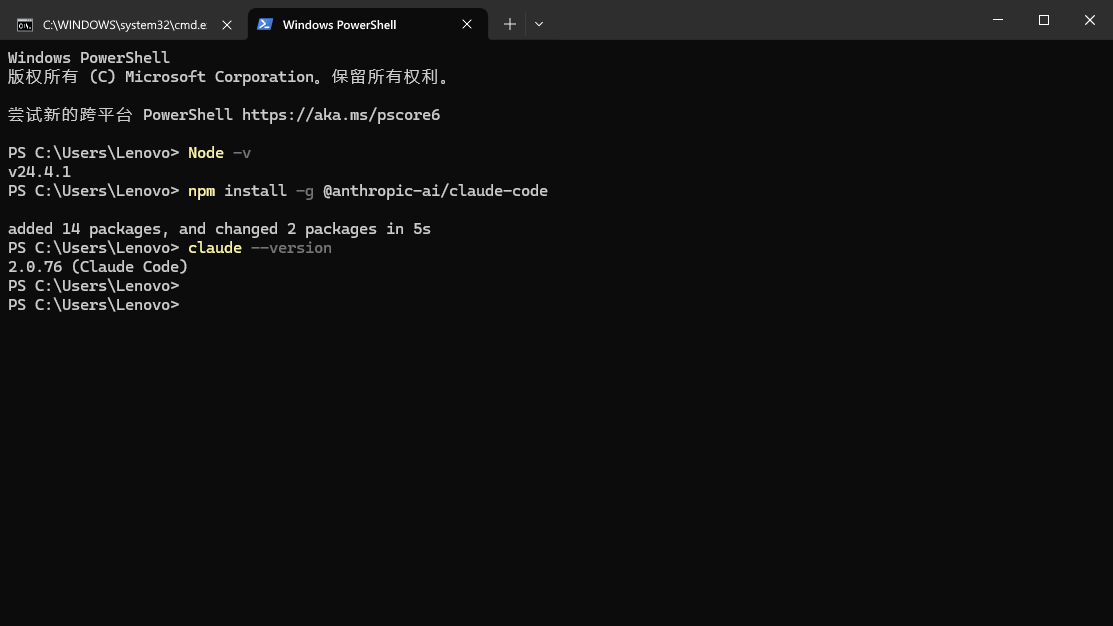

Claude Code中使用GLM-4.7

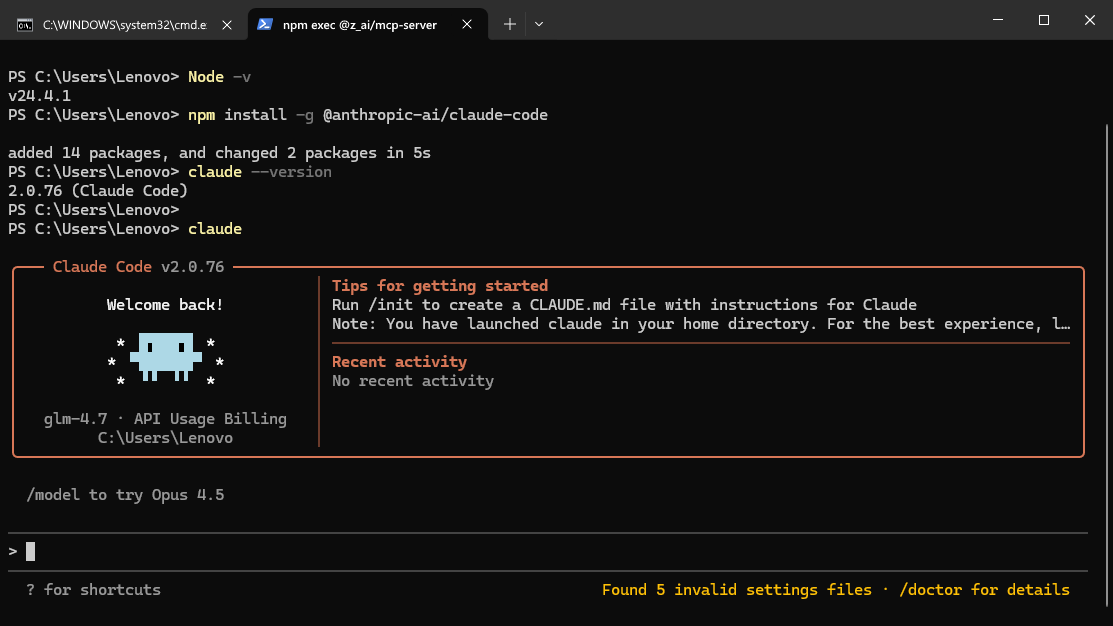

首先需要Nodejs环境,我这里是v24.4.1

安装claude code

npm install -g @anthropic-ai/claude-code

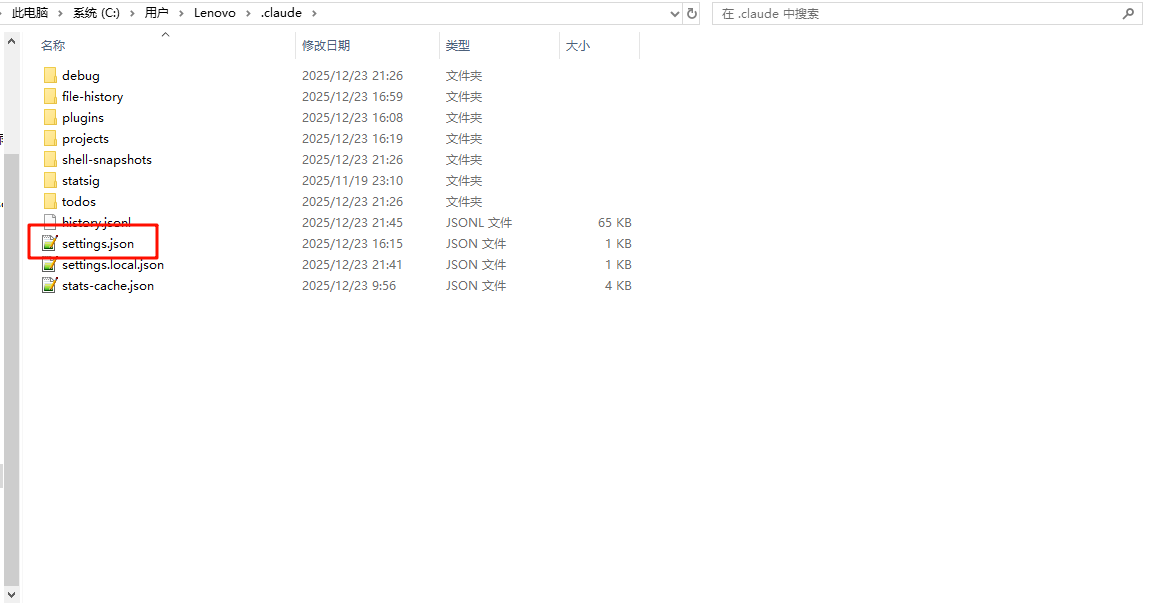

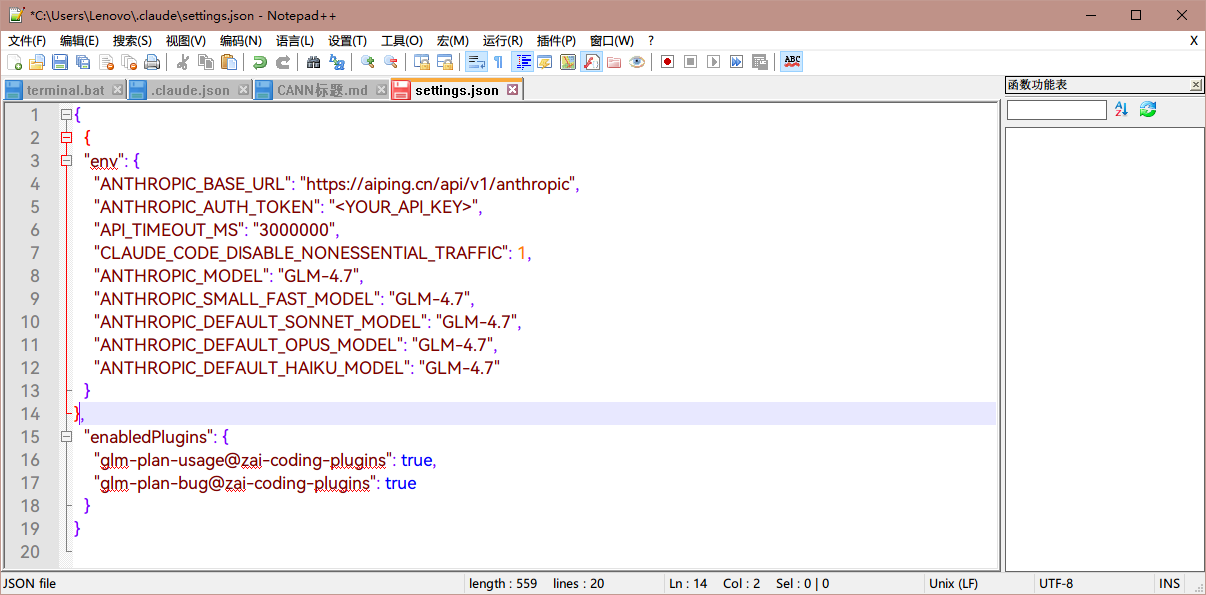

在~/.claude/settings.json中找到这个配置文件

将下方的内容替换到其中

{

"env": {

"ANTHROPIC_BASE_URL": "https://aiping.cn/api/v1/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<YOUR_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "GLM-4.7",

"ANTHROPIC_SMALL_FAST_MODEL": "GLM-4.7",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "GLM-4.7",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "GLM-4.7",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "GLM-4.7"

}

}

然后终端输入claude启动

Coze中使用MiniMax-M2.1

Coze(扣子)是字节跳动推出的 AI Bot 开发平台,支持通过插件方式调用 AI Ping 的模型服务。以下是在 Coze 中集成 MiniMax-M2.1 的完整步骤:

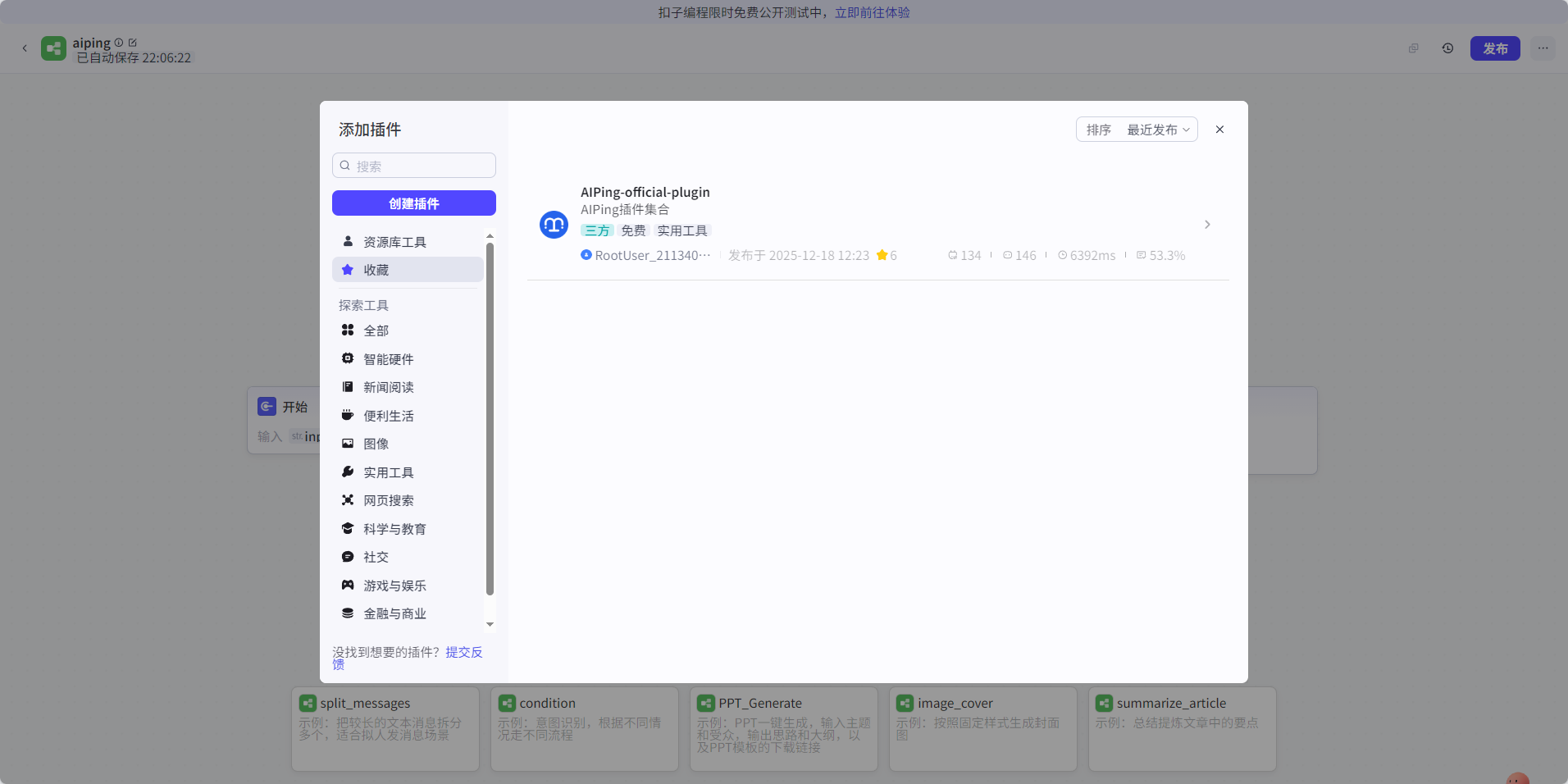

步骤一:安装 AI Ping 插件

- 登录 Coze 官网,进入左侧插件市场

- 在搜索框中输入

AIPing-official-plugin进行搜索 - 点击插件详情页,点击右上角的收藏按钮(方便后续快速找到)

图:Coze 插件市场搜索 AI Ping 官方插件

步骤二:创建智能体和工作流

- 回到 Coze 首页,点击创建智能体,填写名称和描述

- 在智能体编辑页面中,点击工作流标签页

- 点击+ 添加新工作流,选择从空白创建

图:创建新的智能体

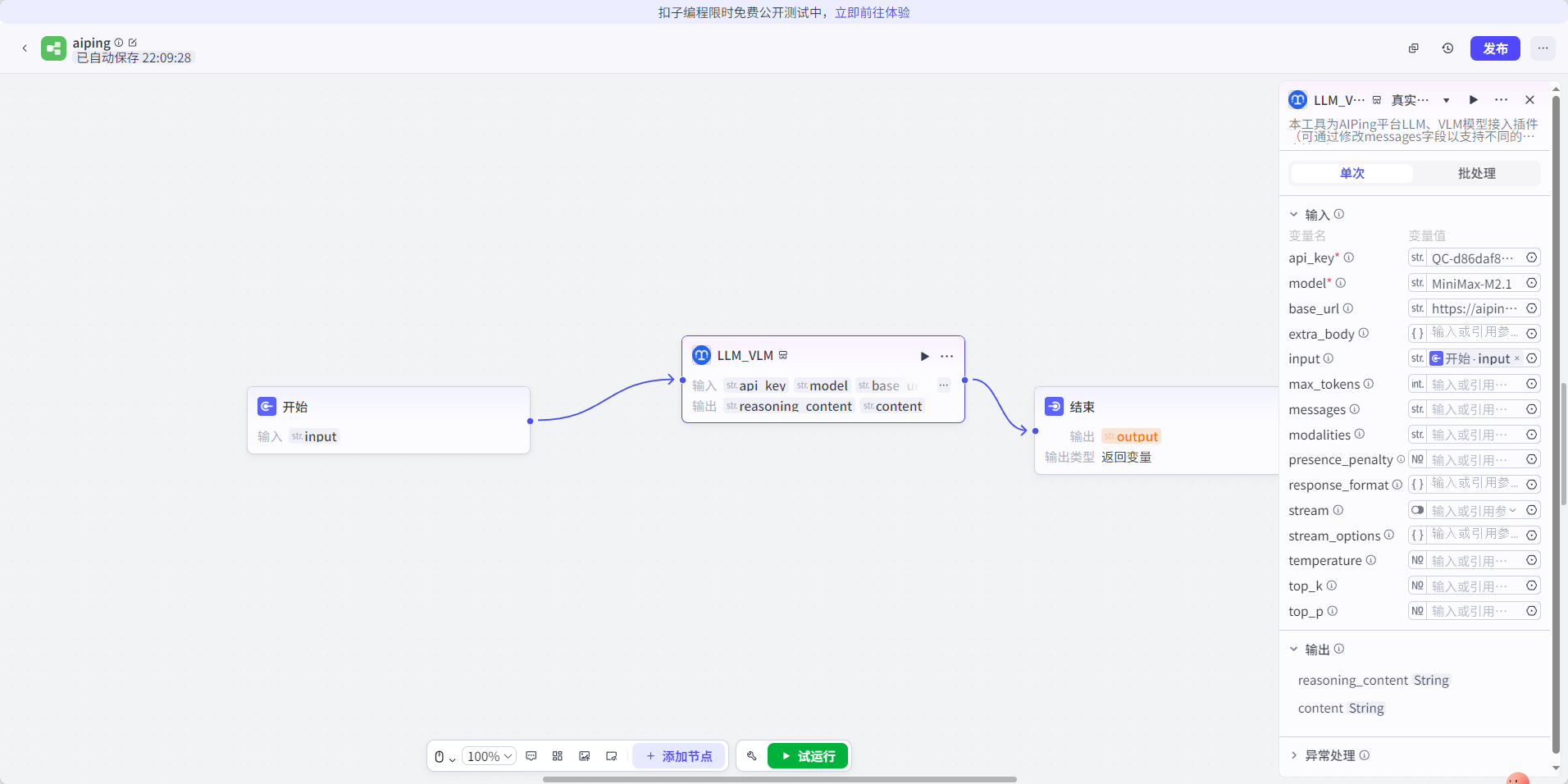

步骤三:配置 AI Ping 插件节点

- 在工作流编辑器中,点击+ 添加节点

- 在节点类型中选择插件,然后从我的收藏中找到

AIPing-official-plugin - 点击插件卡片将其添加到工作流中

图:在工作流中选择 AI Ping 插件

步骤四:配置插件参数

- 点击 AI Ping 插件节点,配置以下参数:

-

- model: 模型名称,填写

MiniMax-M2.1 - messages: 对话消息列表,按 JSON 格式配置

- stream: 是否流式输出,可选

true或false - temperature: 温度参数,控制输出随机性(0-1)

- max_tokens: 最大生成 token 数

- model: 模型名称,填写

图:配置 AI Ping 插件参数

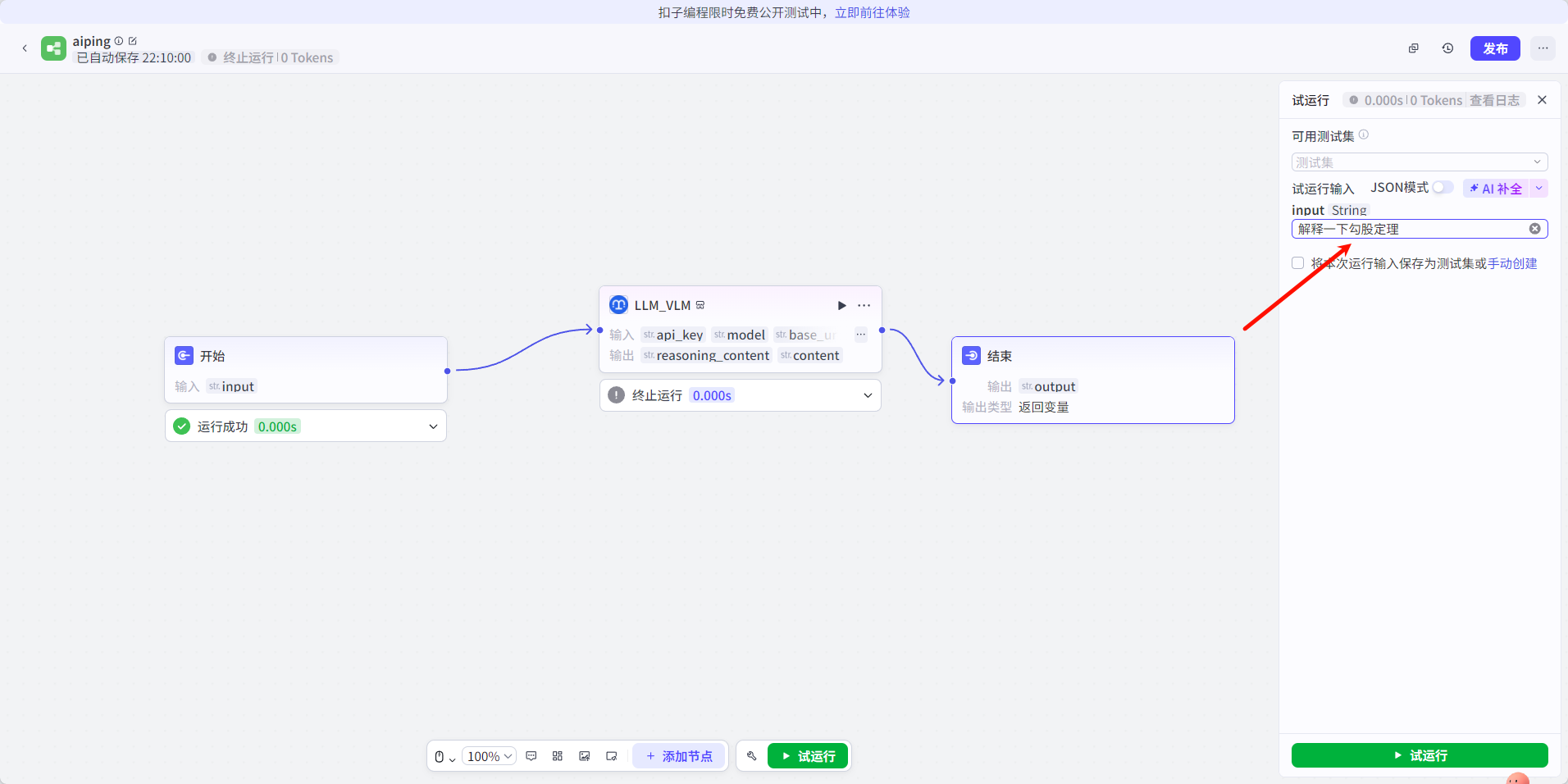

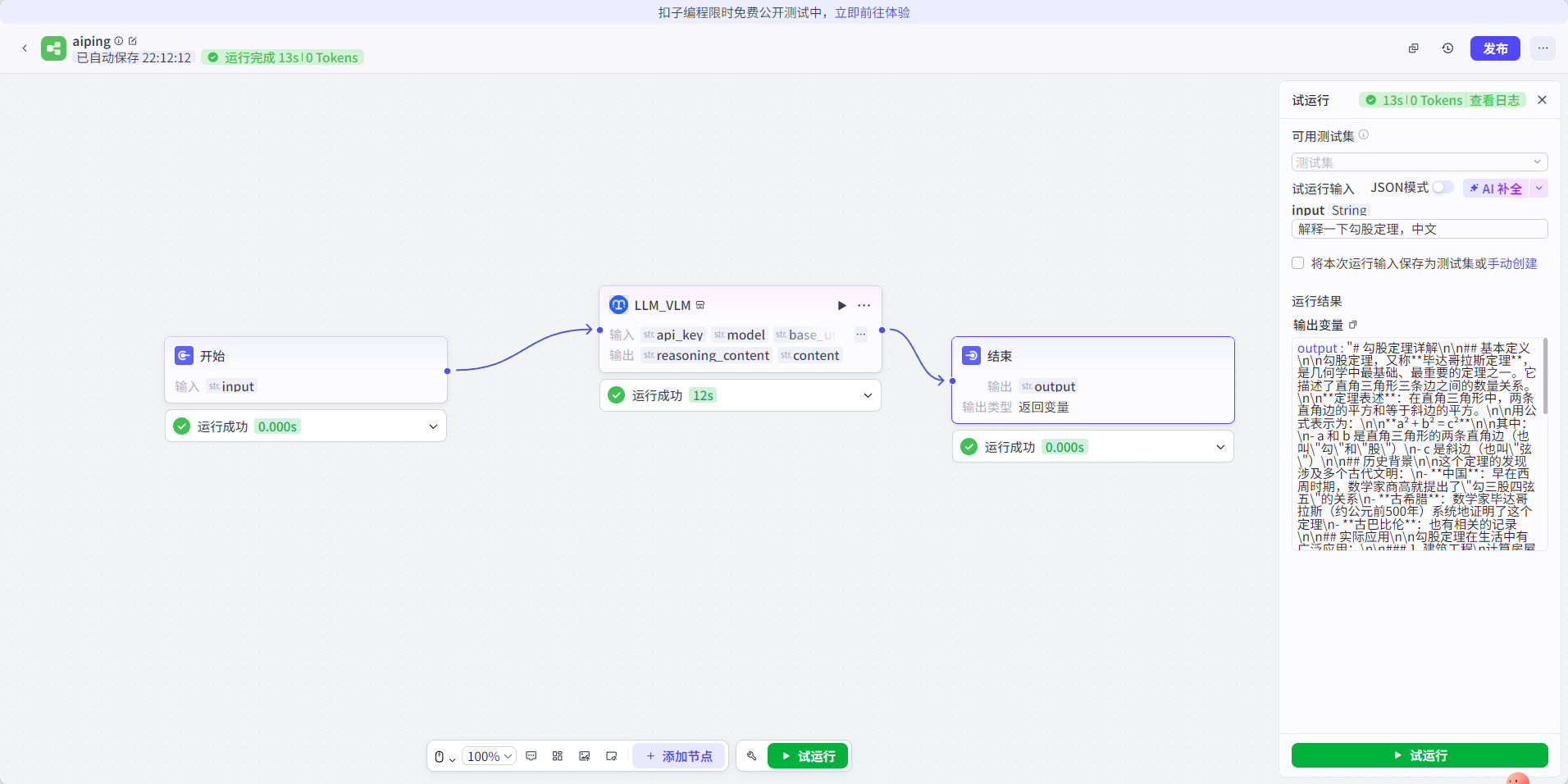

步骤五:测试与发布

- 点击右上角试运行按钮,输入测试消息验证插件是否正常工作

- 查看运行结果,确认模型返回符合预期

图:试运行工作流

- 测试通过后,点击发布按钮,即可在对话中使用配置好的智能体

图:查看运行结果

提示:AI Ping 插件支持所有平台接入的模型,你可以将 model 参数替换为 GLM-4.7 或其他模型名称,灵活切换使用。

总结

AI Ping 作为国内领先的大模型聚合平台,本次上线的 GLM-4.7 与 MiniMax M2.1 两款旗舰模型各有侧重,为开发者提供了丰富的选择:

|

模型 |

核心优势 |

适用场景 |

|

GLM-4.7 |

可控推理、工具协同、Artifacts 前端生成 |

复杂编码任务、一次性工程交付 |

|

MiniMax M2.1 |

高效 MoE 架构、多语言工程、长上下文 |

长链 Agent 工作流、持续稳定运行 |

平台亮点:

- 95+ 模型全覆盖,支持文本生成、视觉理解、图像生成等多种类型

- 统一 OpenAI 兼容接口,零成本切换模型

- 实时性能数据可视化(吞吐、延迟、价格、可靠性)

- 智能路由自动选择最优供应商

- 邀请好友双方各得 20 元算力点,上不封顶

无论是需要快速完成复杂编码任务,还是构建长期稳定运行的 AI Agent,AI Ping 都能提供合适的模型选择。赶快注册体验,薅取这波免费算力羊毛吧!

更多推荐

已为社区贡献39条内容

已为社区贡献39条内容

所有评论(0)