免费薅国产旗舰 LLM!GLM-4.7+MiniMax-M2.1

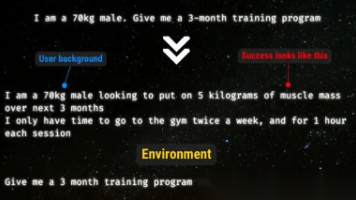

引言:国产大模型的“工程落地元年”已至

在大语言模型(LLM)落地应用中,“AI Ping” 早已不是单纯的网络连通性检测 —— 而是衡量模型响应效率、内容质量、资源消耗的综合探测体系!现在 AI Ping 平台重磅上新两款国产旗舰模型,全程免费调用,无任何隐藏限制:智谱 AI GLM-4.7 与 MiniMax-M2.1!

不用跨平台注册、不用反复申请密钥,仅需在 AI Ping 注册 1 个 API Key,指定模型名就能直接调用两款模型核心能力,注册还送 30 元算力金(专属通道:https://aiping.cn/#?channel_partner_code=GQCOZLGJ)!

一:模型差异

1.1 GLM-4.7

GLM-4.7是智谱的工程化旗舰款,最厉害的地方就是“思考清晰、可控性强”,做复杂任务靠谱

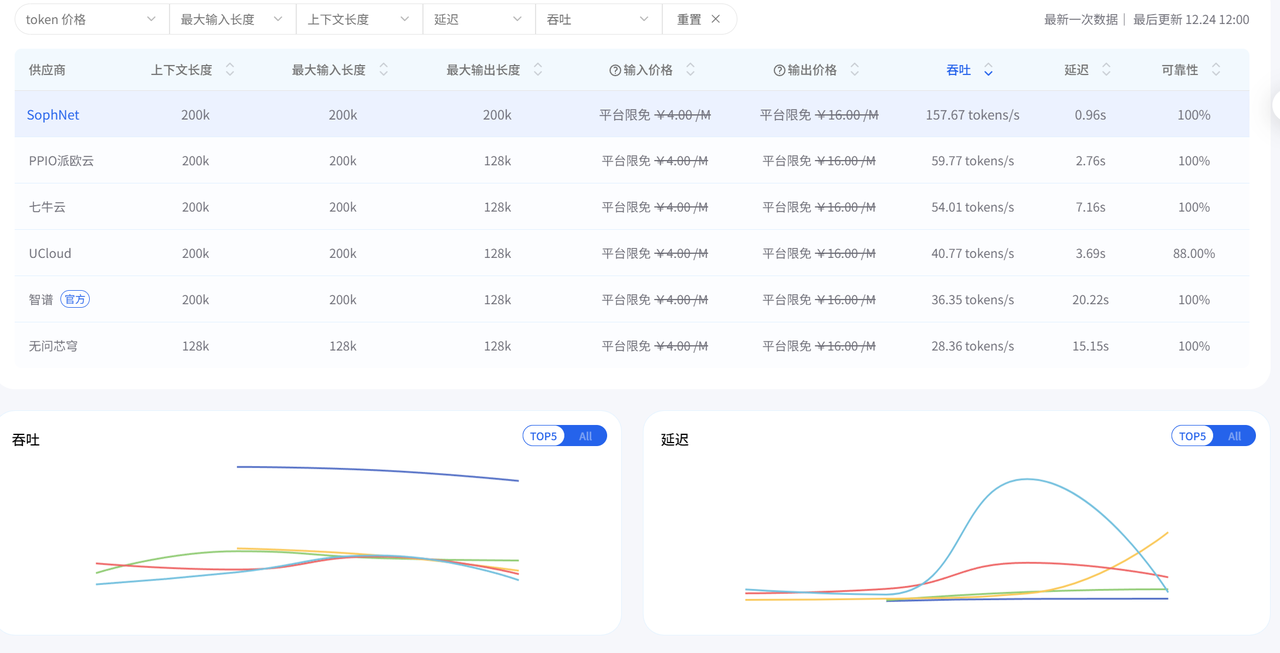

| 供应商 | 吞吐量 (tokens/s) | 延迟(P90)s | 上下文长度 | 输入价格 (¥/M) | 输出价格 (¥/M) | 可靠性 |

| PPIO 派欧云 | 50.47 | 3.64 | 200k | 免费 | 免费 | 100% |

| 智谱(官方) | 50.31 | 0.61 | 200k | 免费 | 免费 | 100% |

| 七牛云 | 37.64 | 2.52 | 200k | 免费 | 免费 | 100% |

| 无问芯穹 | 22.94 | 3.93 | 128k | 免费 | 免费 | 100% |

1.2 MiniMax M2.1

MiniMax M2.1主打“打破速度、智能、成本的不可能三角”,简单说就是:快、又聪明、便宜!

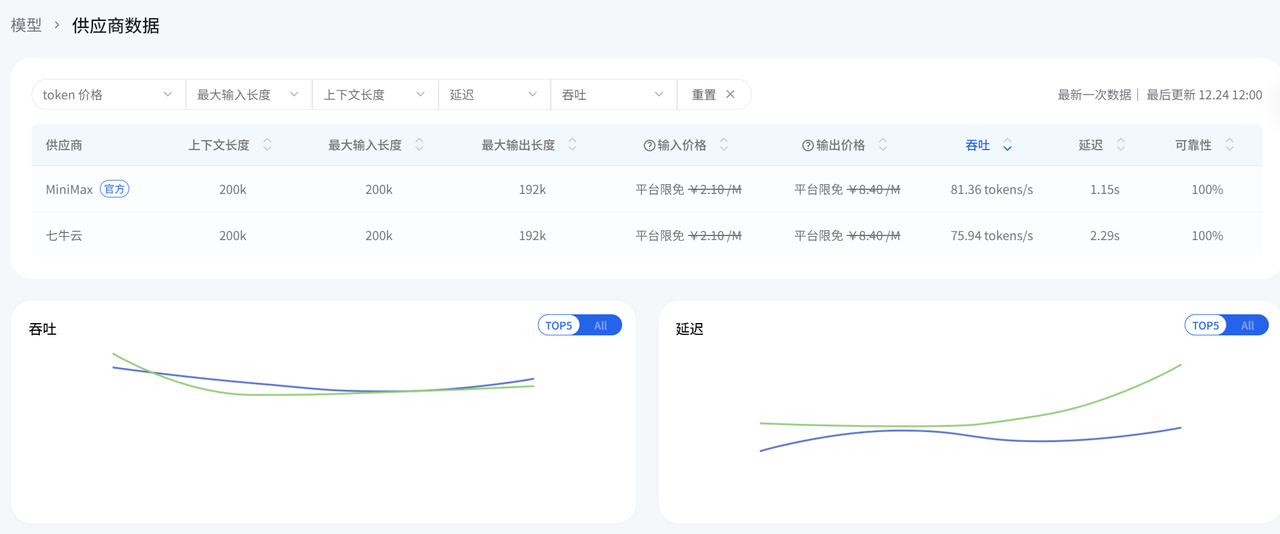

| 供应商 | 吞吐量 (tokens/s) | 延迟(P90)s | 上下文长度 | 输入价格 (¥/M) | 输出价格 (¥/M) | 可靠性 |

| 七牛云 | 99.75 | 0.54 | 200k | 免费 | 免费 | 100% |

| MiniMax(官方) | 89.56 | 0.72 | 200k | 免费 | 免费 | 100% |

二:AI Ping快速上手

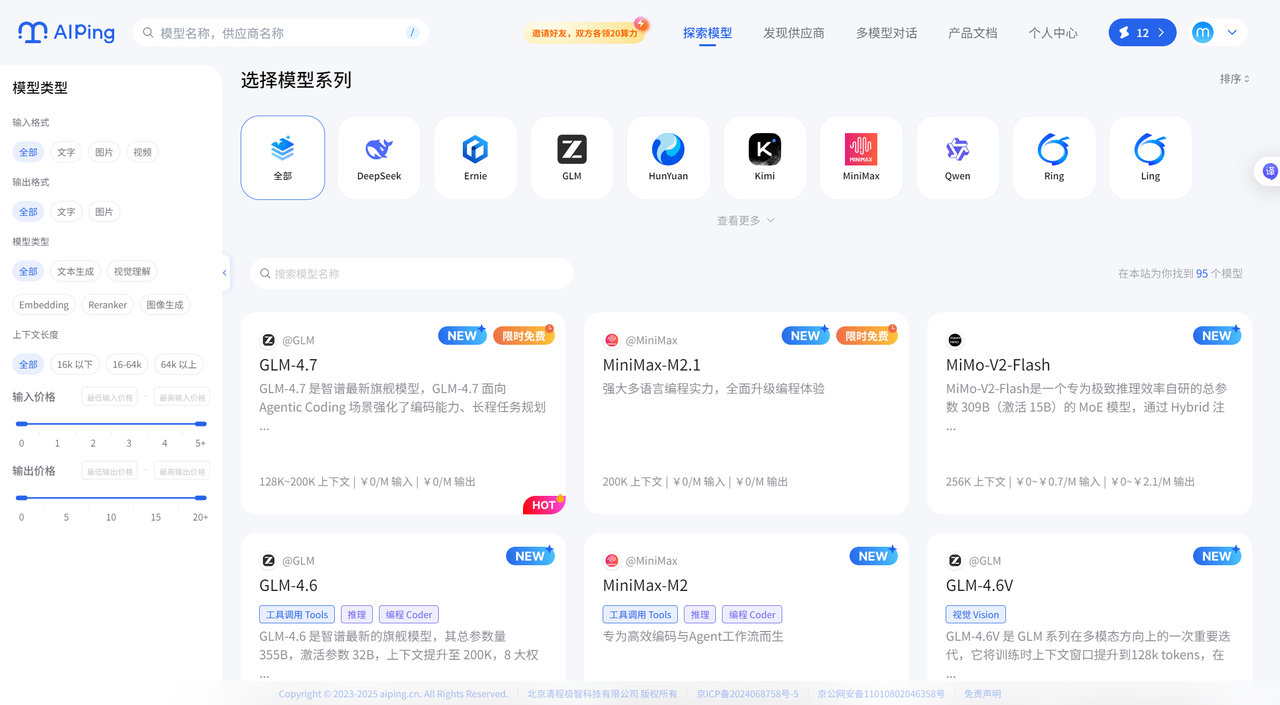

1. 注册登录:打开AI Ping首页,点击右上角“登录”,支持手机验证码免注册登录或账号密码登录

2. 选择模型:点击首页导航栏“探索模型”,可通过搜索栏、模型系列筛选找到GLM-4.7或MiniMax M2.1,点击模型卡片进入详情页;

3. 调用API服务:模型详情页底部有现成示例代码(支持OpenAI Python SDK、Requests、Curl等方式),选对应方式复制代码即可调用;AI Ping会自动用智能路由转发请求(默认平衡成本与性能,失败自动切换供应商),且默认生成API密钥,复制代码时会自动填充,无需单独创建!

更多操作,可在平台内查看对应指南

三:API Key 管理与使用指南

-

验证方式:API请求采用Bearer令牌验证,可直接通过curl或OpenAI SDK与AI Ping交互;

-

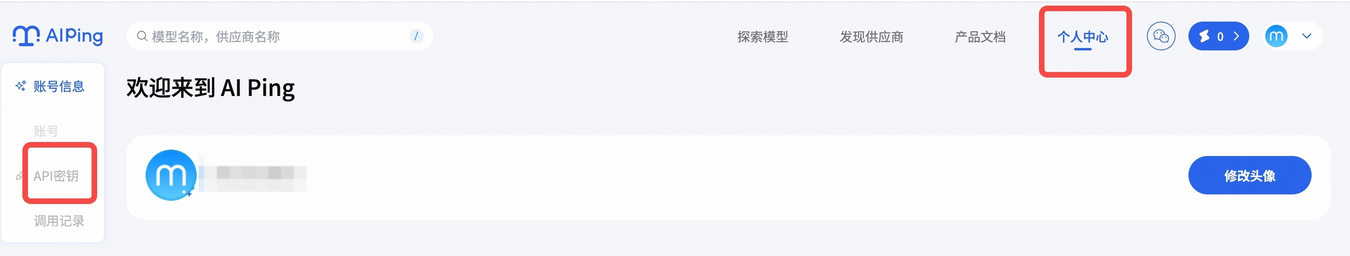

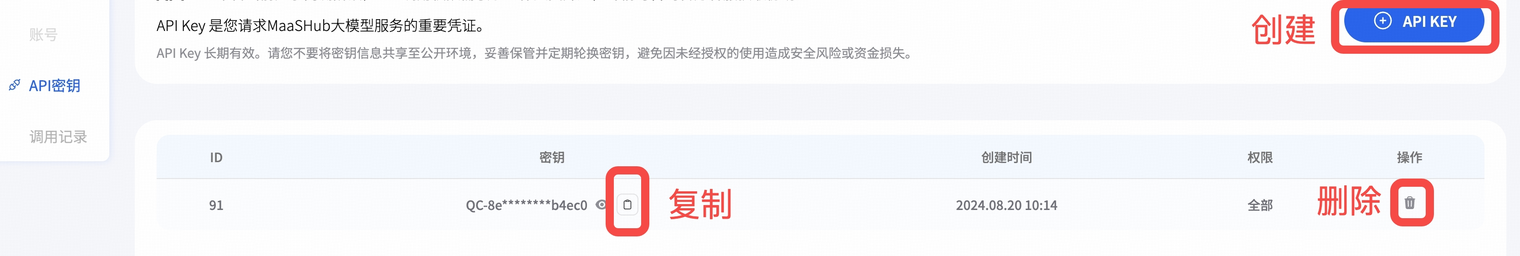

管理API Key:登录后在顶部导航栏进入“个人中心”,点击左侧“API 密钥”即可进入管理页面。注册时系统会默认创建1个API Key,需新增可点击右上角“API KEY”按钮,密钥请妥善保管,避免泄露,可随时删除;

-

使用方法:调用API时,将代码中的<API_KEY>替换为个人API Key即可(示例代码已展示核心请求格式,替换密钥后可直接测试)。

import requests

headers = {

'Authorization': '<API_KEY>',

'Content-Type': 'application/json',

}

response = requests.post('https://aiping.cn/api/v1/chat/completions', headers=headers, json={

'model': 'DeepSeek-R1-0528',

'messages': [

{

'role': 'user',

'content': 'What is the meaning of life?'

}

]

}

})

response.encoding = 'utf-8'

print(response.text)四:OpenCode 配置 AI Ping API 指南

前提:

安装:通过 curl 或者 npm 安装(官网链接:https://opencode.ai/docs/providers/#custom-provider)

-

curl 安装:

curl -fsSL https://opencode.ai/install | bash-

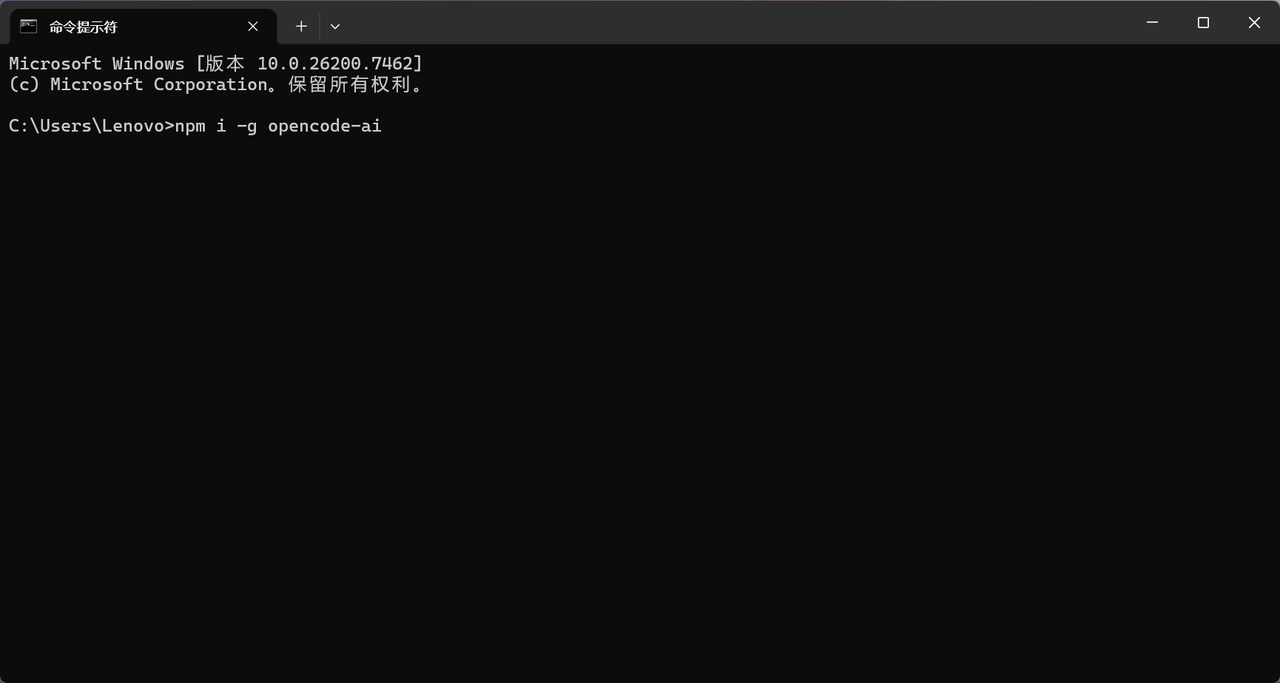

npm 安装:

npm i -g opencode-ai

1. 编辑配置文件:两种路径可选——①编辑路径为 ~/.config/opencode/opencode.json 的文件;②在当前项目文件夹下新建 opencode.json 文件,将指定配置内容添加进去,记得把配置中的<AIPING_API_KEY>替换为个人AI Ping API Key(配置中已默认关联MiniMax-M2模型);

{

"$schema": "https://opencode.ai/config.json",

"provider": {

"AIPing": {

"npm": "@ai-sdk/openai-compatible",

"name": "AIPing",

"options": {

"baseURL": "https://aiping.cn/api/v1",

"apiKey": "<AIPING_API_KEY>"

},

"models": {

"MiniMax-M2": {

"name": "MiniMax-M2"

}

}

}

}

}

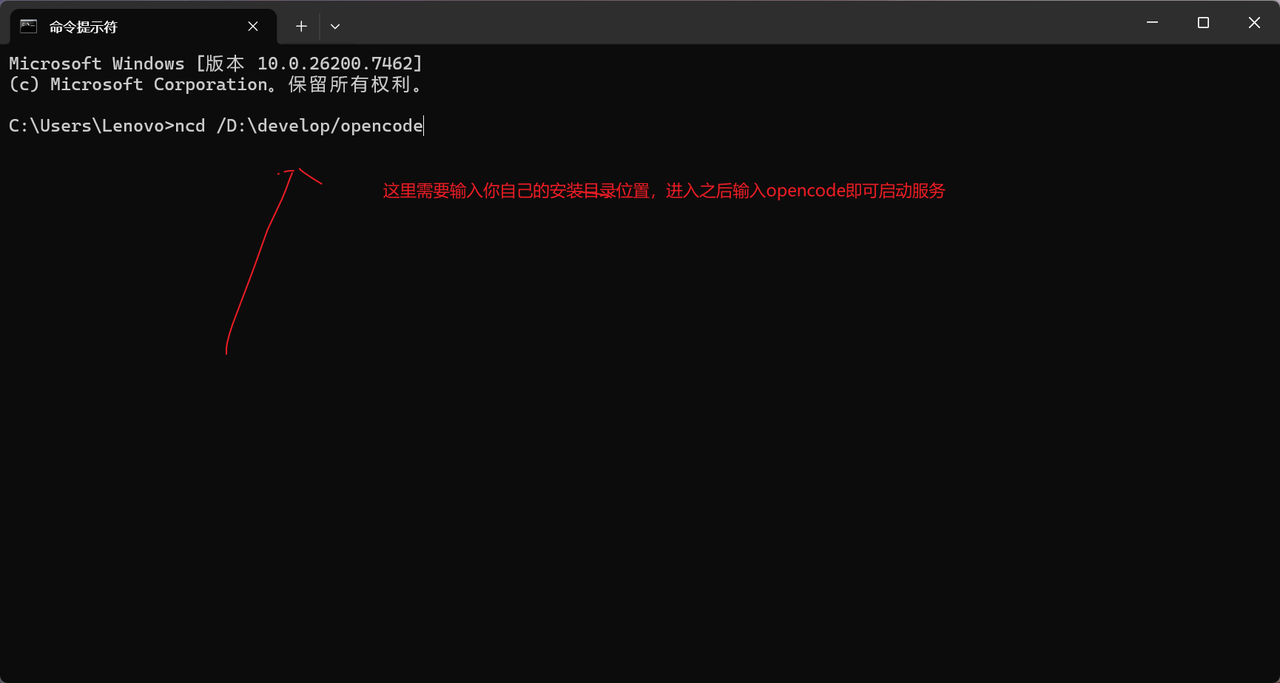

2. 启动服务:进入项目目录(执行命令 cd /path/to/your/project),输入 opencode 命令即可启动服务;

cd /path/to/your/projectopencode

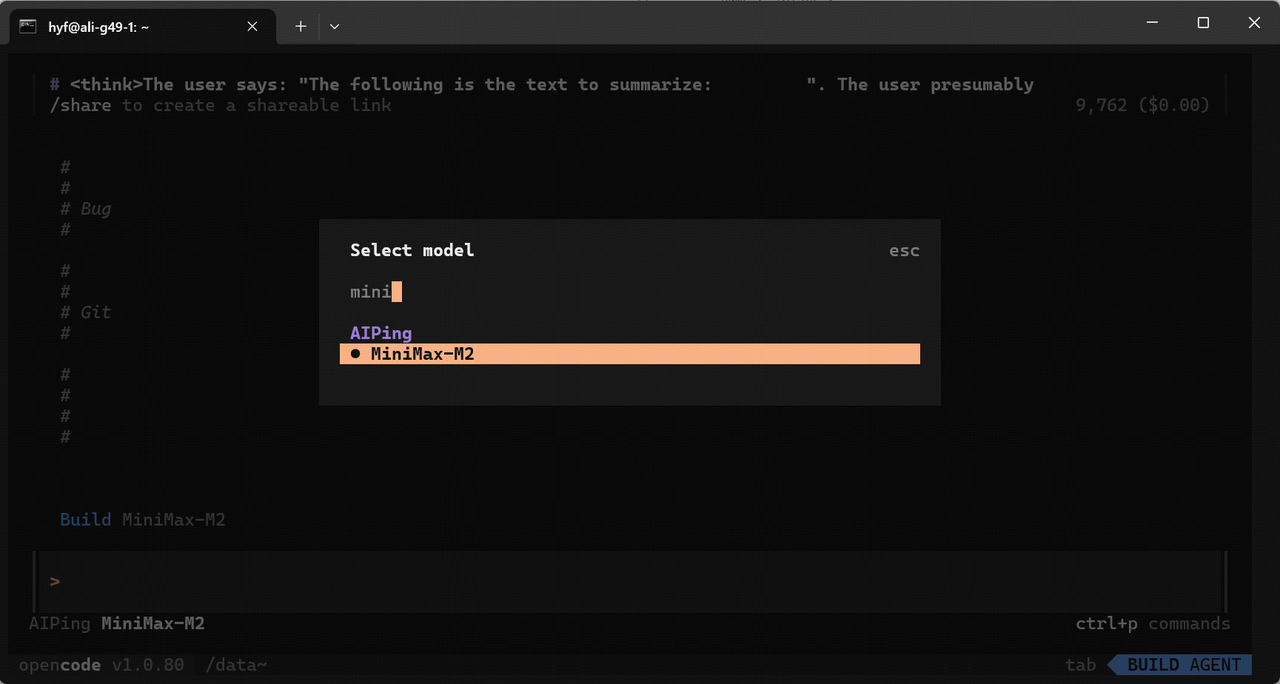

3. 选择模型:在输入框手动输入“/models”,选择配置文件中已配置的模型(如MiniMax-M2),即可完成配置并使用。

4.展示:

五:总结

GLM-4.7的稳定推理适合做复杂任务,MiniMax M2.1的高效低成本适合高并发场景,两款各有优势,而AI Ping就是连接技术和业务的快车道!

别等了,现在就开启你的AI落地之旅:

-

登录AI Ping官网(aiping.cn),注册就能获取API Key;

-

直接用免费算力测试两款模型,根据自己的业务场景选适配方案;

-

快速落地AI应用,体验国产大模型的实力!

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)