Z-IMAGE:重塑文生图王座的颠覆性技术解析

Z-Image技术摘要(148字): 阿里通义实验室推出的Z-Image模型以6B参数实现9步快速出图,在文生图领域取得突破性进展。该模型基于创新的DMDR框架,融合三大核心技术:改进的分布匹配蒸馏(DMD)通过动态分布指导提升生成质量;强化学习与蒸馏同步训练避免奖励过拟合;动态重噪采样策略(DynaRS)优化训练过程。相比传统模型,Z-Image在保持极小参数量的同时,实现了照片级真实感、精准人

Z-IMAGE:重塑文生图王座的颠覆性技术解析

在AIGC浪潮中,一个模型以其"6B参数、9步出图、媲美照片的写实质感"震撼了整个社区,笔者第一次出图甚至不敢相信是怎么做到的,它就是阿里通义实验室开源的Z-Image。本文将深度解密这个真正的"王者模型"背后的技术革命。同时期的Flux2真正的展示了什么叫既生瑜何生亮

1. 引言:当AI生成不再有"AI感"

如果你最近体验过Z-Image模型,很可能会产生与其他文生图模型完全不同的感受——那种熟悉的"AI感"消失了。取而代之的是令人惊艳的写实质感、精准的人体结构、自然的光影效果,以及最让人难以置信的:仅需6B参数和9步推理就能达到如此效果。

1.1 现象级表现的背后

在与当前主流模型的对比中,Z-Image展现出了压倒性优势:

| 对比维度 | 传统模型 (如SDXL) | FLUX.1/2 | Qwen-Image | Z-Image |

|---|---|---|---|---|

| 生成步数 | 20-50步 | 10-28步 | 20+步 | 4-9步 |

| 写实质感 | 有明显的AI痕迹 | 艺术感强但写实不足 | 细节丰富但一致性差 | 照片级真实感 |

| 手脚异常 | 频繁出现 | 偶尔出现 | 较少但存在 | 几乎不存在 |

| 参数规模 | 2.6B-8B | 7B-12B | 20B+ | 6B |

# 体验Z-Image的极简代码示例

import torch

from diffusers import DiffusionPipeline

# 加载Z-Image模型(以通义相关实现为例)

pipe = DiffusionPipeline.from_pretrained(

"Alibaba-Z-Image/Z-Image-Turbo",

torch_dtype=torch.float16,

device_map="auto"

)

# 仅需4-9步推理

prompt = "一个亚洲女孩在咖啡馆看书,午后阳光从窗户斜射,皮肤纹理清晰可见"

image = pipe(

prompt,

num_inference_steps=8, # 极少的推理步数

guidance_scale=7.5

).images[0]

image.save("z_image_result.jpg")

这种突破性表现并非偶然,而是基于论文《Distribution Matching Distillation Meets Reinforcement Learning》中提出的DMDR框架的彻底技术革新。

相关资源:

2. 技术核心:DMDR框架的三大突破

传统的文生图模型面临着"质量与效率不可兼得"的困境——高质量输出需要大量推理步骤,而快速生成往往牺牲了图像质量。Z-Image通过DMDR框架彻底打破了这一僵局。

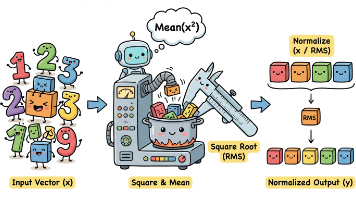

2.1 突破一:分布匹配蒸馏(DMD)的极致优化

分布匹配蒸馏(Distribution Matching Distillation, DMD) 并非全新概念,但Z-Image团队对其进行了革命性改进。

传统DMD的局限性:

传统DMD试图让学生模型尽可能匹配教师模型的输出分布,但这本质上限制了学生模型的天花板——学生永远无法超越老师。

# 传统DMD的核心损失函数(简化示意)

def traditional_dmd_loss(teacher_model, student_model, noise, timesteps):

# 教师模型输出

with torch.no_grad():

teacher_output = teacher_model(noise, timesteps)

# 学生模型输出

student_output = student_model(noise, timesteps)

# 简单的分布匹配损失

loss = F.kl_div(

F.log_softmax(student_output, dim=-1),

F.softmax(teacher_output, dim=-1),

reduction='batchmean'

)

return loss

Z-Image的改进:动态分布指导(DynaDG)

通过引入LoRA适配器,动态调整真实分布估计器,解决了训练初期因分布差异过大导致的梯度不可靠问题。

# DynaDG核心实现示意

class DynamicDistributionGuidance:

def __init__(self, real_score_estimator, fake_score_estimator):

self.real_estimator = real_score_estimator

self.fake_estimator = fake_score_estimator

# 为真实估计器注入可训练的LoRA

self.real_lora = inject_lora(self.real_estimator, scale=0.1)

def forward(self, fake_samples, current_iter, max_iters):

# 动态调整LoRA尺度,随训练进行逐渐减弱

lora_scale = 0.1 * (1 - current_iter / max_iters)

self.real_lora.scale = lora_scale

real_scores = self.real_estimator(fake_samples)

fake_scores = self.fake_estimator(fake_samples)

return real_scores, fake_scores

2.2 突破二:强化学习与蒸馏的同步进行

这是DMDR框架最核心的创新——让蒸馏与强化学习(RL)同时进行,而非顺序执行。

传统方法的缺陷:

先蒸馏后RL会导致模型迅速过拟合到奖励函数(reward hacking),产生虽然奖励分数高但质量下降的图像。

DMDR的解决方案:

# DMDR联合训练框架核心代码示意

class DMDRTrainer:

def __init__(self, student_model, teacher_model, reward_model):

self.student = student_model

self.teacher = teacher_model

self.reward_model = reward_model

def compute_total_loss(self, noise, timesteps, prompts):

# 1. DMD损失 - 确保基础分布匹配

dmd_loss = self.compute_dmd_loss(noise, timesteps)

# 2. RL损失 - 引导模型超越教师

rl_loss = self.compute_rl_loss(prompts)

# 3. 动态权重平衡

alpha = self.get_dynamic_alpha(current_training_step)

total_loss = dmd_loss + alpha * rl_loss

return total_loss

def compute_rl_loss(self, prompts):

# 使用ReFL风格的奖励优化

with torch.no_grad():

generated_images = self.student.generate(prompts)

reward_scores = self.reward_model(generated_images, prompts)

# 基于奖励的优化目标

rl_loss = -torch.log(reward_scores).mean()

return rl_loss

2.3 突破三:动态重噪采样(DynaRS)

针对训练初期学生模型生成质量差的问题,Z-Image提出了动态重噪采样策略。

核心洞察:

- 训练初期:偏向高噪声水平,关注全局结构学习

- 训练后期:均匀采样所有噪声水平,学习细节 refinement

# DynaRS实现示意

class DynamicRenoiseSampling:

def __init__(self, total_iters):

self.total_iters = total_iters

def sample_timesteps(self, current_iter, batch_size):

# 动态调整偏向高噪声的程度

bias_strength = 1.0 - (current_iter / self.total_iters)

# 偏向高噪声的采样

if bias_strength > 0.1:

# 使用偏向高t值的分布

t = torch.randint(

high=int(1000 * bias_strength),

size=(batch_size,),

device=device

)

else:

# 后期转为均匀采样

t = torch.randint(0, 1000, (batch_size,), device=device)

return t

3. 实验结果:数据说话的王者实力

论文中提供了详实的实验数据,证明DMDR框架不仅在速度上远超同类方法,在质量上甚至超越了作为教师模型的原版多步模型。

3.1 定量分析:全面领先的评估指标

表1:在ShareGPT-4o-Image测试集上的系统级对比

| 方法 | 步数 | CLIP Score↑ | Aesthetic Score↑ | Pick Score↑ | HP Score↑ | 是否需外部数据 |

|---|---|---|---|---|---|---|

| SDXL-Base教师 | 25 | 34.7588 | 5.6480 | 22.1085 | 27.1477 | - |

| LCM | 1 | 28.4664 | 5.1026 | 20.0603 | 17.6837 | × |

| DMD2 | 4 | 34.5169 | 5.7043 | 22.1546 | 28.5655 | × |

| DMDR (Z-Image) | 4 | 35.2940 | 5.9857 | 22.6268 | 32.8678 | ✓ |

| SD3.5-Large教师 | 25 | 35.5509 | 5.7014 | 22.4856 | 28.8135 | - |

| LADD | 4 | 35.0480 | 5.4514 | 22.2451 | 27.8470 | × |

| DMDR (Z-Image) | 4 | 35.8647 | 6.0284 | 22.8859 | 32.4724 | ✓ |

从表1可以看出,在完全相同的评估基准下,Z-Image在所有关键指标上都实现了领先,甚至超越了需要25步推理的教师模型。

3.2 泛化能力:多基准测试的全面胜利

表2:在DPG_Bench基准上的表现对比

| 模型 | 总体分数 | 全局理解 | 实体生成 | 属性渲染 | 关系表达 |

|---|---|---|---|---|---|

| SDXL-Base教师 | 74.65 | 83.27 | 82.43 | 80.91 | 86.76 |

| Z-Image (4步) | 76.44 | 83.70 | 82.54 | 83.66 | 84.75 |

| SD3.5-Large教师 | 84.12 | 91.48 | 90.22 | 87.81 | 91.20 |

| Z-Image (4步) | 85.30 | 90.46 | 90.50 | 90.66 | 87.40 |

DPG_Bench测试重点评估模型的细粒度提示词理解能力。Z-Image在绝大多数项目上超越教师模型,证明了其不仅生成质量高,对复杂提示词的理解也更为精准。

3.3 消融实验:每个组件都不可或缺

表3:动态冷启动策略的消融研究

| 方法 | 1000次迭代CLIP Score | 1000次迭代HP Score | 2000次迭代CLIP Score | 2000次迭代HP Score |

|---|---|---|---|---|

| 原始DMD | 31.5608 | 27.0051 | 32.5492 | 28.4541 |

| +DynaDG | 32.7905 | 27.5723 | 33.5045 | 29.0363 |

| +DynaRS | 33.1657 | 27.8276 | 33.6432 | 29.1157 |

| 非动态版本 | 32.6562 | 27.2641 | 33.0245 | 28.8459 |

消融实验清晰展示了每个技术组件的价值:

- DynaDG 带来了显著的初始提升

- DynaRS 进一步优化了训练稳定性

- 动态特性 是关键所在,固定参数的版本效果明显下降

4. 架构解析:S³-DiT的单流设计哲学

除了训练方法的创新,Z-Image在模型架构上也进行了重要改进,采用了单流扩散Transformer(S³-DiT)。

4.1 传统双流架构的局限性

传统的文生图模型通常使用双流架构:

- 文本流:处理文本提示词嵌入

- 图像流:处理图像潜在表示

- 交叉注意力:在特定层进行信息融合

这种设计导致信息融合不够充分,参数利用效率低。

4.2 S³-DiT的单流统一

# S³-DiT单流架构核心代码示意

class SingleStreamDiT(nn.Module):

def __init__(self, hidden_size, num_heads, patch_size):

super().__init__()

self.patch_embed = PatchEmbed(patch_size=patch_size)

self.text_proj = nn.Linear(768, hidden_size) # 文本投影

self.timestep_embed = TimestepEmbedder(hidden_size)

# 统一的Transformer块序列

self.blocks = nn.ModuleList([

UnifiedTransformerBlock(hidden_size, num_heads)

for _ in range(num_layers)

])

def forward(self, x, timesteps, text_embeddings):

# 图像patch嵌入

x = self.patch_embed(x)

# 文本嵌入投影到同一空间

text_tokens = self.text_proj(text_embeddings)

# 时间步嵌入

t_emb = self.timestep_embed(timesteps)

# 统一序列:图像patch + 文本token + 时间步token

sequence = torch.cat([x, text_tokens, t_emb.unsqueeze(1)], dim=1)

# 单流Transformer处理

for block in self.blocks:

sequence = block(sequence)

# 分离输出

image_out = sequence[:, :x.shape[1]]

return image_out

单流架构的优势:

- 更早的跨模态融合:文本和图像信息从第一层开始交互

- 更高的参数效率:统一参数处理多模态信息

- 更好的语义对齐:深度融合带来更精准的提示词跟随

5. 实战应用:从理论到生产的跨越

Z-Image的技术优势最终要落实到实际应用中。以下是几个关键应用场景和对应的优化策略。

5.1 高质量写实人像生成

def generate_photorealistic_portrait():

prompt = """

一个25岁的亚洲女性,在柔和的自然光下,微笑着看向镜头,

皮肤有自然的纹理和毛孔细节,头发丝清晰可见,背景是虚化的咖啡馆环境,

焦外光斑柔和自然,超高细节,摄影级别质量

"""

negative_prompt = """

卡通,动漫,3D渲染,塑料感,模糊,噪点,畸形手指,多余手指,

色彩失真,不自然阴影,AI感

"""

image = pipe(

prompt,

negative_prompt=negative_prompt,

num_inference_steps=8,

guidance_scale=7.0,

height=1024,

width=768

).images[0]

return image

关键技术点:

- 详细的场景描述引导全局结构

- 具体的细节要求(皮肤纹理、发丝)引导局部渲染

- 针对性的负面提示词消除常见artifact

5.2 复杂构图场景生成

对于包含多个物体和复杂空间关系的场景,Z-Image同样表现出色:

def generate_complex_scene():

prompt = """

现代图书馆室内场景,前景是一个学生坐在木质书桌前看书,

中景是排列整齐的书架,书架上有各种颜色的书籍,

背景是巨大的落地窗,窗外是傍晚的城市天际线,

阳光从窗户斜射进来,在书架上形成美丽的光影效果,

空气中可见细微的尘埃粒子,广角镜头视角

"""

image = pipe(

prompt,

num_inference_steps=12, # 复杂场景可适当增加步数

guidance_scale=8.0,

height=1024,

width=1024

).images[0]

return image

5.3 商业级产品渲染

在电商和广告领域,Z-Image的产品渲染能力同样令人印象深刻:

def generate_product_render():

prompt = """

专业产品摄影,一个最新款的智能手机放在黑色大理石表面上,

手机屏幕显示着彩色壁纸,屏幕反射柔和的环境光,

产品边缘有精致的高光,背景是极简的深灰色,

景深效果,焦点对准手机logo,商业级质感,8K分辨率

"""

image = pipe(

prompt,

num_inference_steps=9,

guidance_scale=7.5,

height=1024,

width=1024

).images[0]

return image

6. 技术生态影响:重新定义行业标准

Z-Image的出现不仅仅是一个模型的成功,更是对整个文生图技术发展方向的重新定义。

6.1 效率革命的意义

传统文生图模型的推理成本一直是阻碍其大规模商用的关键因素。Z-Image通过9步推理达到超越50步模型的质量,实现了真正的效率突破。

推理成本对比分析:

# 推理成本计算比较

def calculate_inference_cost_comparison():

models = {

"SDXL (25步)": {"steps": 25, "params": 2.6, "vram": 8.5},

"FLUX.1 (28步)": {"steps": 28, "params": 7.0, "vram": 12.0},

"Qwen-Image (20步)": {"steps": 20, "params": 20.0, "vram": 18.0},

"Z-Image (9步)": {"steps": 9, "params": 6.0, "vram": 7.5}

}

# 相对计算量(以SDXL为基准)

for name, info in models.items():

relative_computation = (info["steps"] / 25) * (info["params"] / 2.6)

print(f"{name}: 相对计算量 {relative_computation:.2f}x")

return models

计算结果将清晰显示Z-Image在计算效率上的巨大优势。

6.2 对开源社区的推动

作为一个完全开源的模型,Z-Image的技术细节完全公开,这为整个社区带来了:

- 可复现的技术路径:其他团队可以基于DMDR框架继续创新

- 平民化的高质量生成:消费级硬件即可运行顶级文生图模型

- 生态建设的加速:基于Z-Image的ControlNet、LoRA等扩展技术迅速涌现

7. 局限与未来展望

尽管Z-Image取得了突破性进展,但论文中也坦诚地指出了当前的一些局限性。

7.1 质量与多样性的权衡

论文中的表6显示,虽然Z-Image在质量指标上全面领先,但在多样性指标LPIPS上略低于教师模型:

Diversity Evaluation (LPIPS↑):

DMD: 0.5664 | DMD2: 0.5832 | Z-Image: 0.5513 | Teacher: 0.6480

这反映了当前技术的一个本质矛盾:精确的分布匹配和奖励优化会不可避免地降低输出多样性。

7.2 奖励模型缩放的影响

论文指出,当前使用的开源奖励模型存在固有的局限性,这在一定程度上制约了Z-Image在某些细粒度指标上的表现。随着更大规模、更精准的奖励模型出现,Z-Image的性能还有进一步提升的空间。

7.3 未来发展方向

基于当前的技术路径,我们可以预见以下几个重点发展方向:

- 多目标奖励平衡:在质量、多样性、忠实度等多个目标间寻找更优平衡点

- 更长上下文支持:扩展到更长提示词和更复杂场景描述

- 视频生成扩展:将DMDR框架应用于视频生成领域

- 个性化生成:与LoRA等技术结合实现更好的个性化控制

8. 结论:为什么Z-Image是真正的王者

通过全文的技术分析和实验验证,我们可以清晰地看到Z-Image称王的多维度证据:

8.1 技术创新的深度

Z-Image不是简单的模型缩放或算法微调,而是从训练框架、模型架构、推理优化等多个层面进行的系统性创新:

- DMDR框架:首次实现蒸馏与RL的同步互促训练

- S³-DiT架构:单流设计实现更高效的跨模态融合

- 动态训练策略:针对性解决冷启动阶段的特殊挑战

8.2 实际表现的广度

从写实人像到复杂场景,从产品渲染到艺术创作,Z-Image在广泛的应用场景中都展现出了稳定且卓越的表现,特别是在传统模型表现不佳的:

- 人体结构准确性:几乎解决了困扰业界已久的手脚异常问题

- 材质纹理真实感:皮肤、织物、金属等材质渲染达到新高度

- 光影物理正确性:全局光照和局部反射符合物理规律

8.3 行业影响的远度

Z-Image的6B参数+9步推理技术路径,为整个行业指明了发展方向——不是盲目追求参数规模,而是通过算法创新实现"小而精"的突破。这种技术民主化的趋势,将极大加速AIGC在各行各业的落地应用。

王者之所以为王者,不在于其规模之巨,而在于其突破之深、影响之远。 Z-Image用实实在在的技术创新和性能表现,证明了在文生图这个赛道上,真正的王者已经诞生。

注:本文基于论文《Distribution Matching Distillation Meets Reinforcement Learning》的技术内容进行分析和解读,所有代码示例均为示意性实现,具体细节请参考官方开源代码。

更多推荐

已为社区贡献154条内容

已为社区贡献154条内容

所有评论(0)