国内最强编程模型 GLM-4.6,上手实测!终于告别改 bug 的精神内耗

国产大模型GLM-4.6在编程领域表现出色,与GPT-5、Claude 4.5并列全球第一。作者通过实际测试验证了其能力:1)基于静态图成功开发出TCP连接可视化交互网页;2)准确找出并修复了AI Agent项目的3个隐蔽Bug;3)在海外开发者社区也获得认可,被赞"Token高效"且遵循指令能力强。作者建议采用"双核驱动"开发模式,将GLM-4.6作为主力

咱们今天不聊虚的,先说个最近让我特别恼火的事。

上周二晚上我正写着一个支付模块的鉴权逻辑,思路正如泉涌,那个花了我不少银子充值的 Claude 中转站账号,啪的一下,封了。

屏幕上那行冷冰冰的 Access Denied 简直像是在嘲笑我。

这已经不是第一次了。为了用上所谓的顶级模型。我们要么得忍受动不动就断连的网络,要么得忍受随时可能跑路的中转商,关键是每个月还得像交供奉一样掏几十美金。

我当时就在想,咱们国内的模型,到底还要多久才能真正支棱起来?能不能让我不再为了写几行代码,还得操心账号会不会炸?

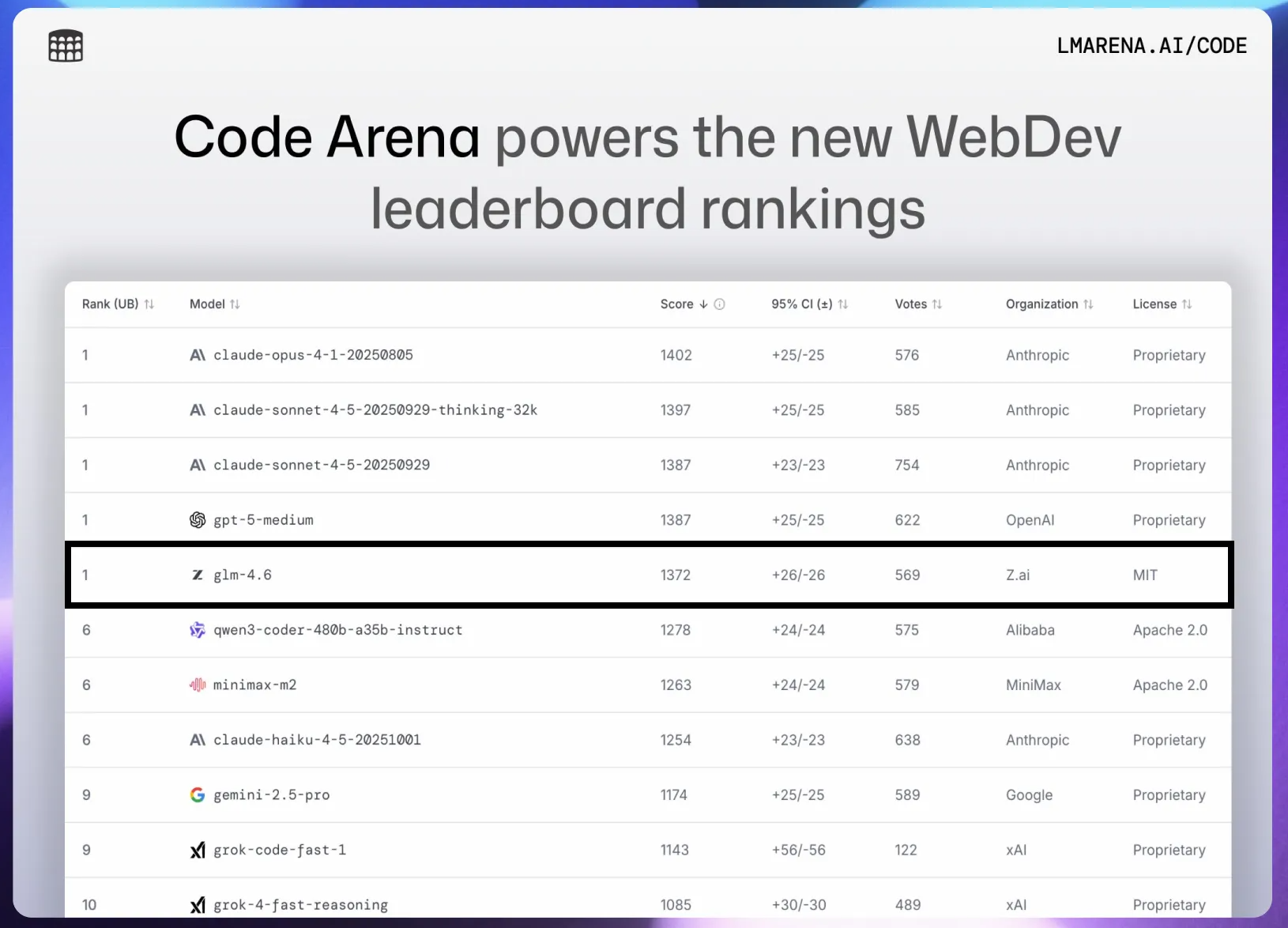

也就是在那天,我看到了 LMArena 更新了榜单。

我看了一眼,甚至揉了揉眼睛确认了一下。GLM-4.6 在 Code Arena 编程榜单上,和 GPT-5、Claude 4.5 这些神仙打架的选手,并列全球第一。

注意,是 Global 第一(不过,由于昨天 gemini3 出来了,它也下降了,但毕竟是最新 gemini 啊)。

这就有点意思了。以前我们总说国产模型是平替,是备胎。但如果数据摆在这里,它已经不是谁的替身了,它就是那个能打的主角。

于是我做了一个决定。我把手头所有的海外模型订阅都停了一周,在项目开发中只用 GLM-4.6,看看能否完成我的开发需求和解决实际项目的 bug。

GLM-4.6 能否完成我的需求?

老读者都知道,我之前写的《图解网络》画了很多精美的图来展示网络工作原理。

但我一直有个心结,静态图再精美,也不如一个可交互的动态网页直观。我想做一个网站,在一个页面上动态展示 HTTPS 握手、TCP 滑动窗口、连接和断开的全过程。

想法很丰满,现实很骨感。我一个搞后端的,对前端复杂的动画交互完全是两眼一抹黑。放以前,这个想法估计就烂在肚子里了。

但这次,我决定拿 GLM-4.6 试一试。

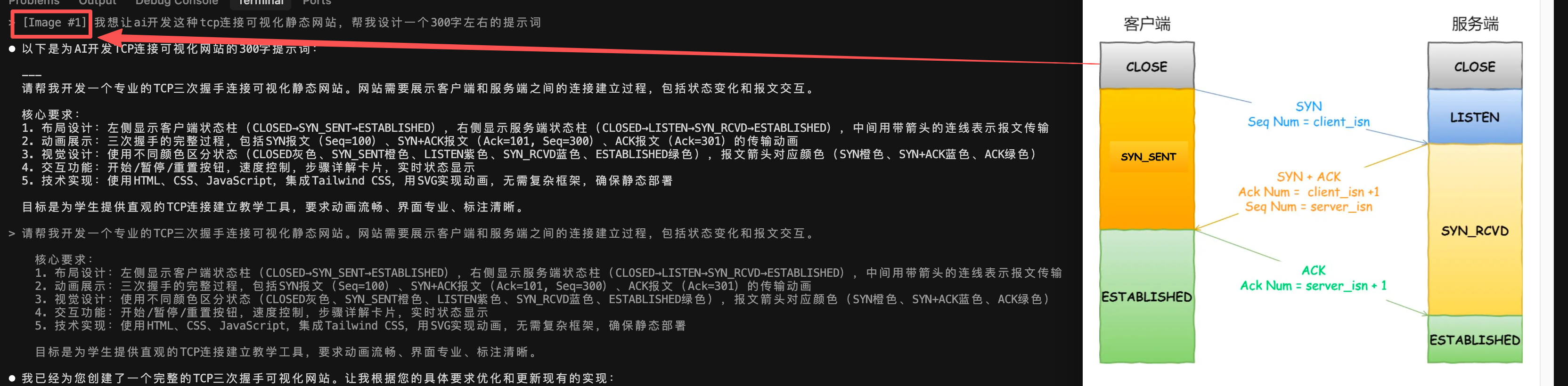

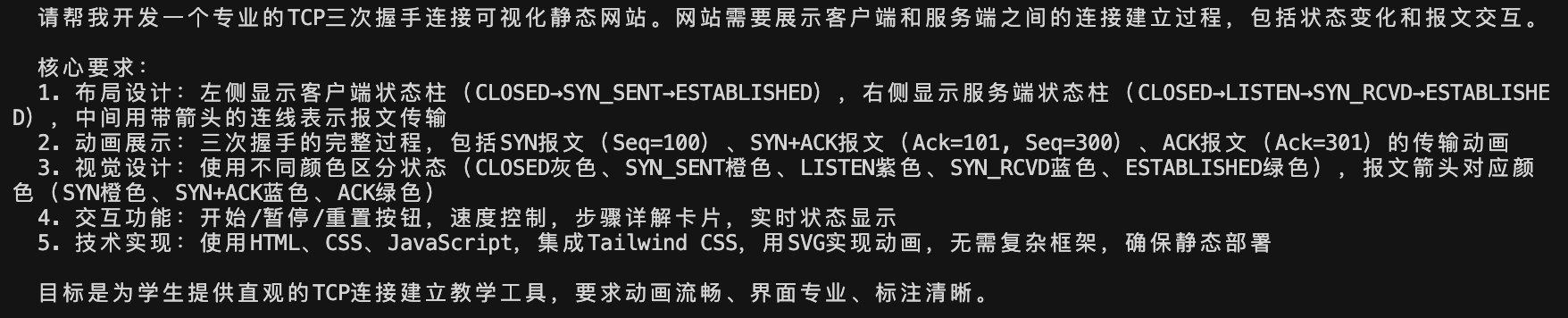

我没有上来就写一堆蹩脚的需求文档,而是干了一件特别省事的操作:我直接把我《图解网络》里那张「TCP 三次握手」的插图截图,丢给了 GLM-4.6。

我对它说,你先别急着写代码,你先看懂这张图,然后帮我设计一个提示词,描述清楚我要实现一个什么样的网页。

(图片)我想让ai开发这种tcp连接可视化静态网站,帮我设计一个300字左右的提示词

这一步其实很关键。我真不知道怎么用文字精准描述那些颜色区分、角色位置和状态流转,不如让 AI 自己去理解。结果它生成的提示词写得比我详细多了,把状态机变化的逻辑梳理得清清楚楚。

接着,我拿着它生成的提示词,让它开工。

出来的效果简直绝了。网页的风格跟我那张插图几乎一模一样,那种清爽的配色、动画的节奏,连我都挑不出毛病。

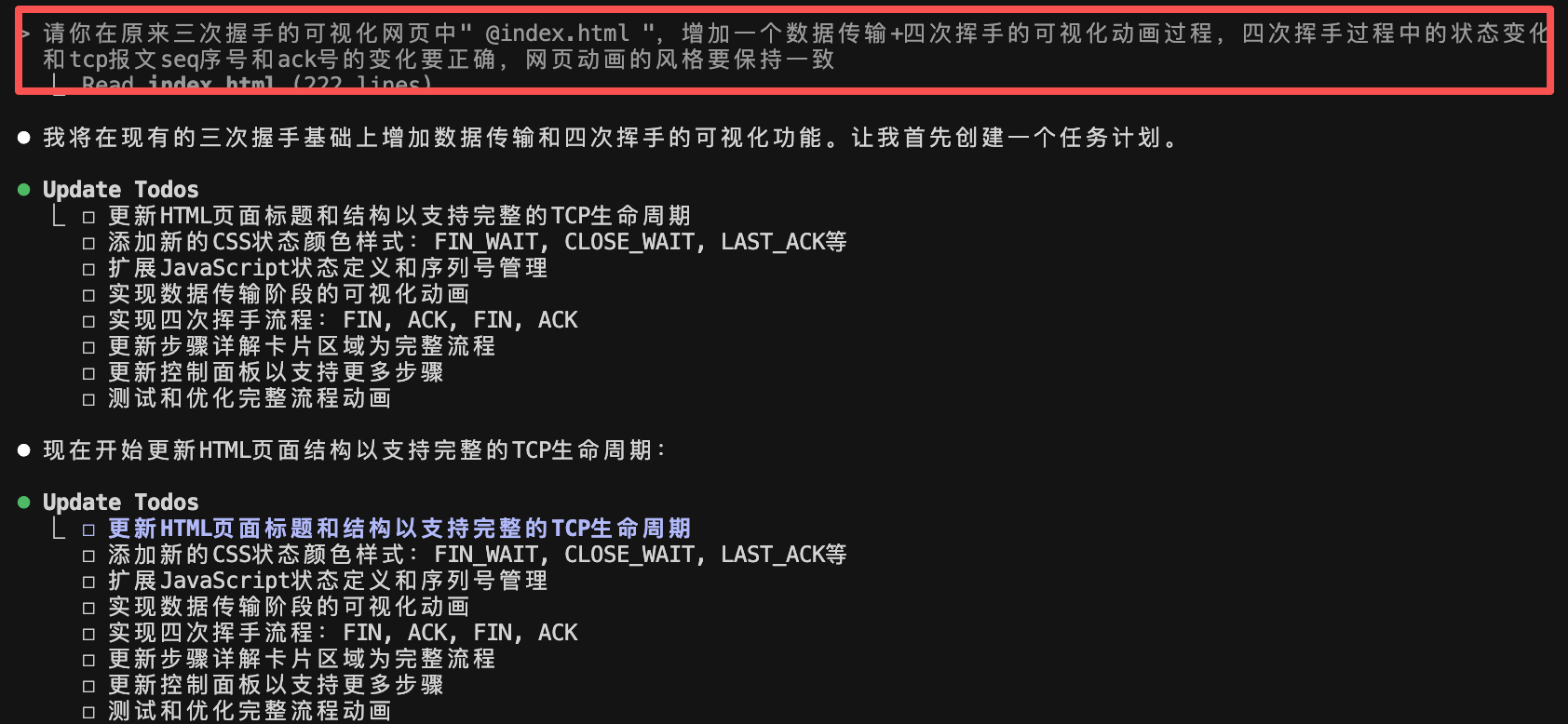

当然,TCP 远不止连接建立这个过程,所以我继续提了新要求,让它把数据传输+四次挥手的过程也增加到网页中字,这样学习 TCP 连接的生命周期就更完整了。

通常来说,多轮修改很容易让 AI 生成的代码「崩坏」,比如风格不统一或者逻辑冲突。但 GLM-4.6 稳得一塌糊涂,它不仅理解了「保持网页动画风格一致」这个隐性需求,还把 TCP 连接的完整生命周期,从握手到传输再到挥手,完美地串联在了一起。

上半部分是丝滑的动画演示,下半部分是实时的状态说明。我看着屏幕上那个自动流转的 TCP 状态机,心里就在想,这不就是我梦寐以求的可视化学习网页吗

有了 GLM-4.6 ,现在很容易就能实现我的网络可视化网页的想法,即使我是完全不懂前端的人,也是没问题的,只要你想法,交给 GLM-4.6 就完事了。

从这次体验来看,GLM-4.6 真的把我的需求落地了。后续我打算把更多的网络协议都可视化出来,整合成一个完整的计算机网络动画学习网站。有了这个网站,让网络知识不再抽象,这事还真能成。

GLM-4.6 能否解决项目中的 bug?

这两天我和朋友正在手搓一个 AI Agent 项目。代码刚写完,虽然功能跑通了,但我心里总觉得不踏实,肯定还有不少 Bug 藏在我没注意的角落。

突发奇想,我把整个工程丢给了 GLM-4.6,帮我检查一下项目的潜在bug。结果它直接给我整了个「惊喜三连」,连揪出 3 个隐蔽 BUG,那个分析的深度,比我预期的还要完整。

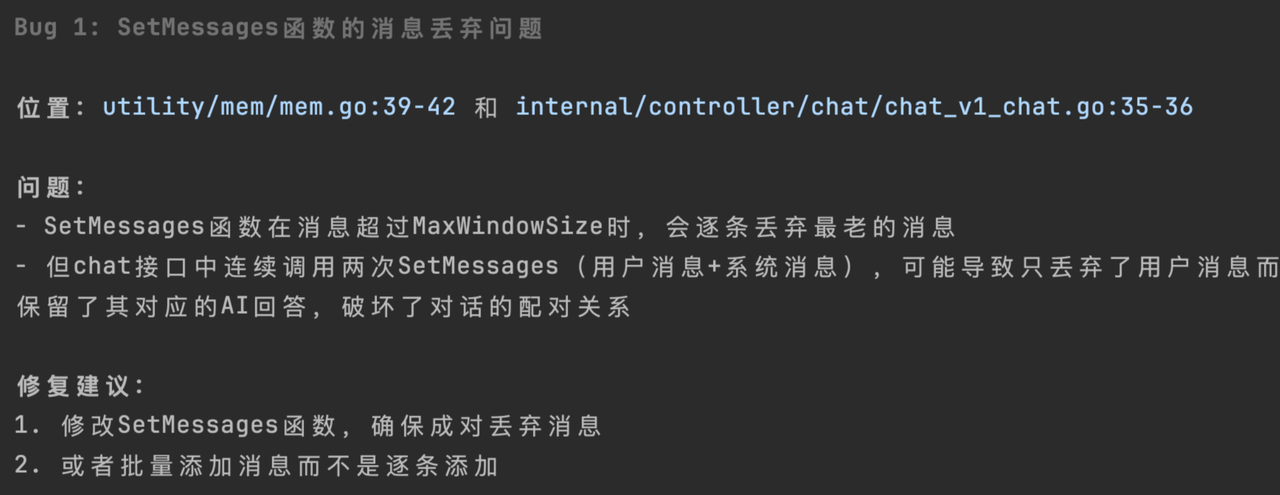

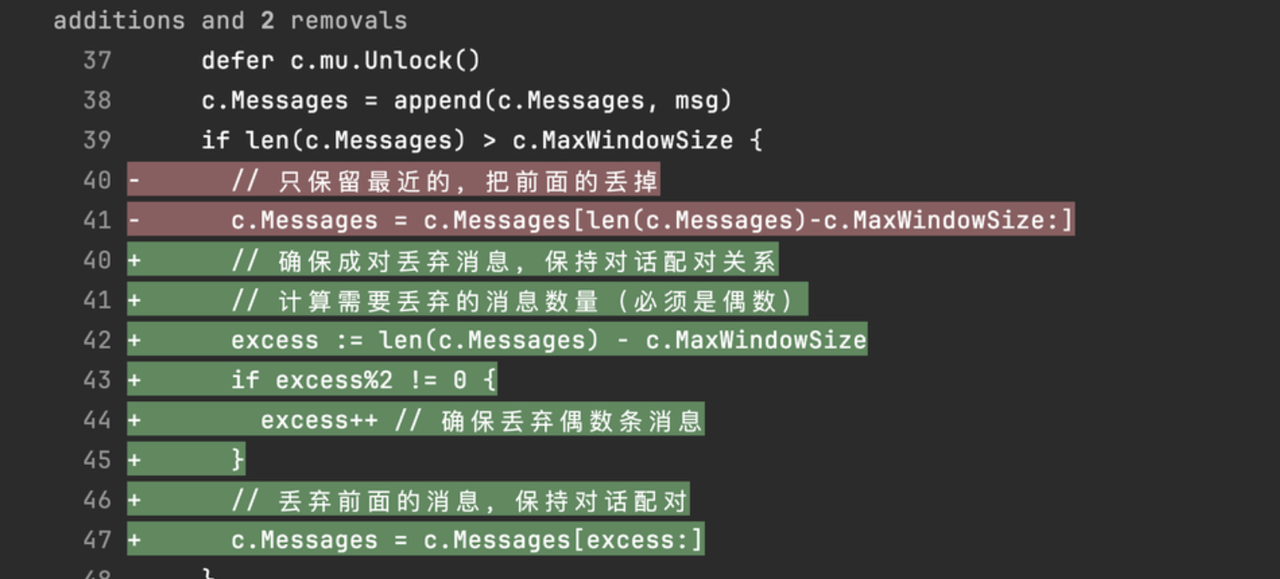

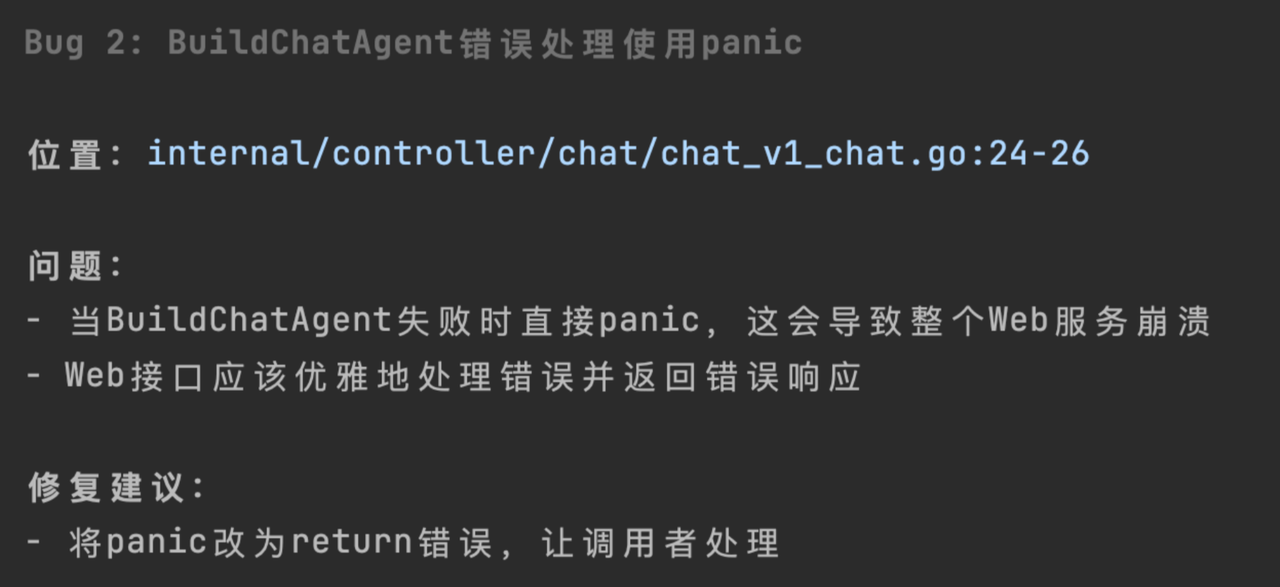

第一个 Bug 是关于消息记忆配对的。

原来我的 SetMessages 函数每次添加消息超过 MaxWindowSize 时,会直接删掉最老的一条。但我在接口里是连续调用两次 SetMessages,先加用户消息,再加 AI 回复。

GLM-4.6 不仅精准定位到了 mem.go 和 chat_v1_chat.go 的具体行数,还一针见血地指出,在某些场景下,这会导致用户消息被删了,但对应的 AI 回复还留着,直接破坏了对话上下文的配对关系。

它建议我要么修改函数成对丢弃消息,要么批量添加两条消息再处理窗口限制。看这逻辑分析能力,我当时就感觉,这玩意儿怎么比我还懂我的代码?

第二个 Bug 更要命,它一眼看穿我在 Web 接口里用 panic 去处理某个函数调用的错误。

它直接警告我,Web 服务里随便 panic 会导致整个进程崩溃,建议改成 return 错误让调用者去处理。

这就不只是读代码了,这是懂工程实践啊。

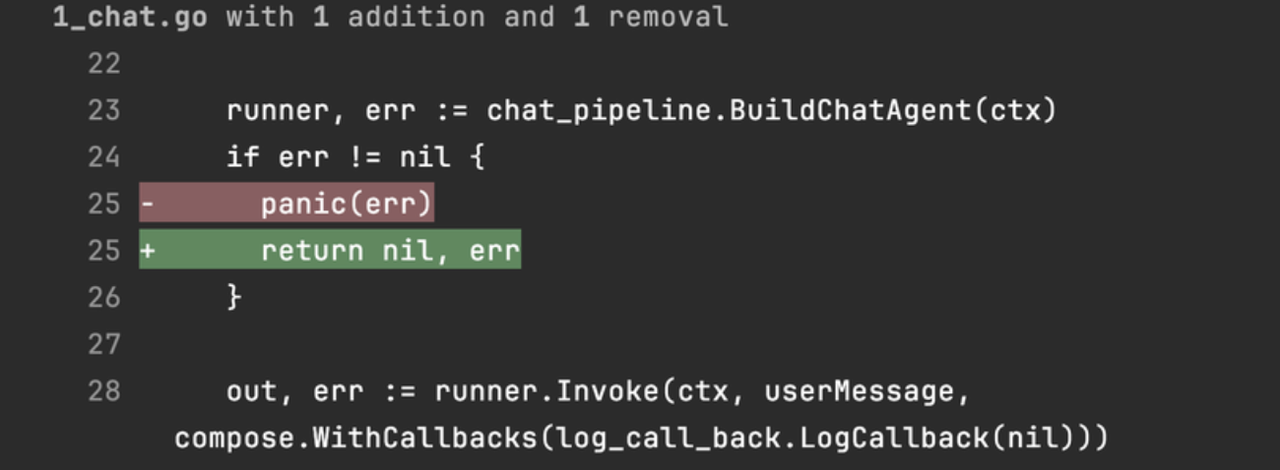

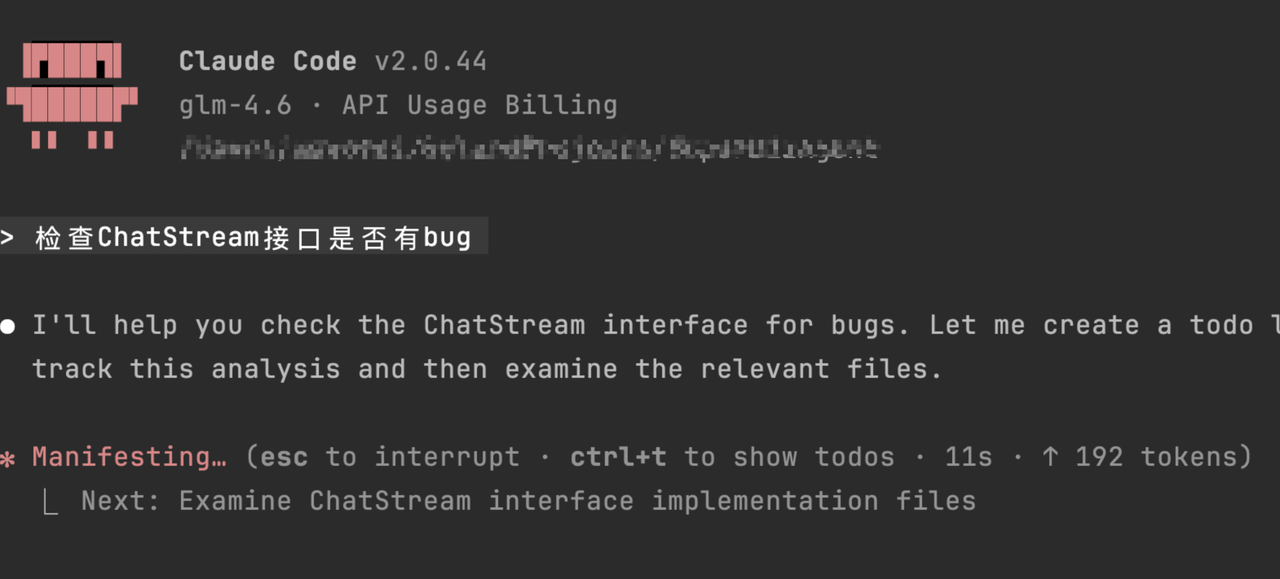

最绝的是第三个,我顺手让它查 chat_stream 接口:

它发现这个接口居然忘记写记忆功能了!

更牛的是,它还考虑到了流式输出的特殊性,专门建议「在流式输出结束后再添加本轮对话的记忆」。这细节直接拉满,它连流式接口的执行逻辑都门儿清,知道不能在流式过程中加记忆,得等输出完再处理。

说实话,以前我也用过其他模型查 Bug,但 GLM-4.6 这次的表现真的超纲了。

它能跳转到相关函数读代码,能结合业务场景分析逻辑漏洞,还能给出符合工程规范的修复方案,甚至考虑到流式输出这种特殊场景。

这已经不是单纯的执行指令了,它是在思考怎么写代码才是正确的。

对程序员来说,这玩意儿简直是福音,省得自己一行行啃代码找问题。以后查 Bug、Code Review,GLM-4.6 绝对是我优先 Pick 的工具,谁用谁知道香。

老外开发者也在用 GLM-4.6?

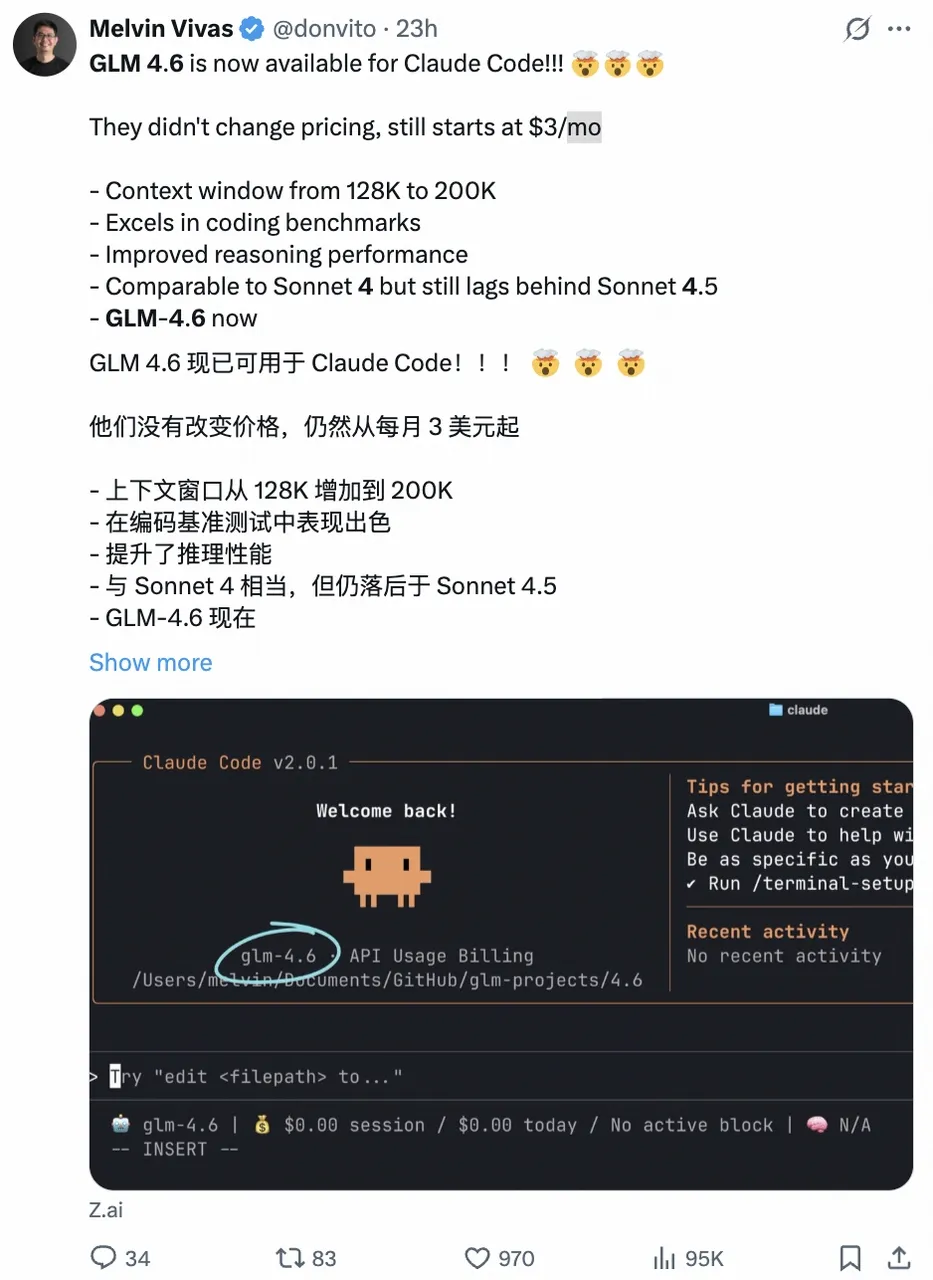

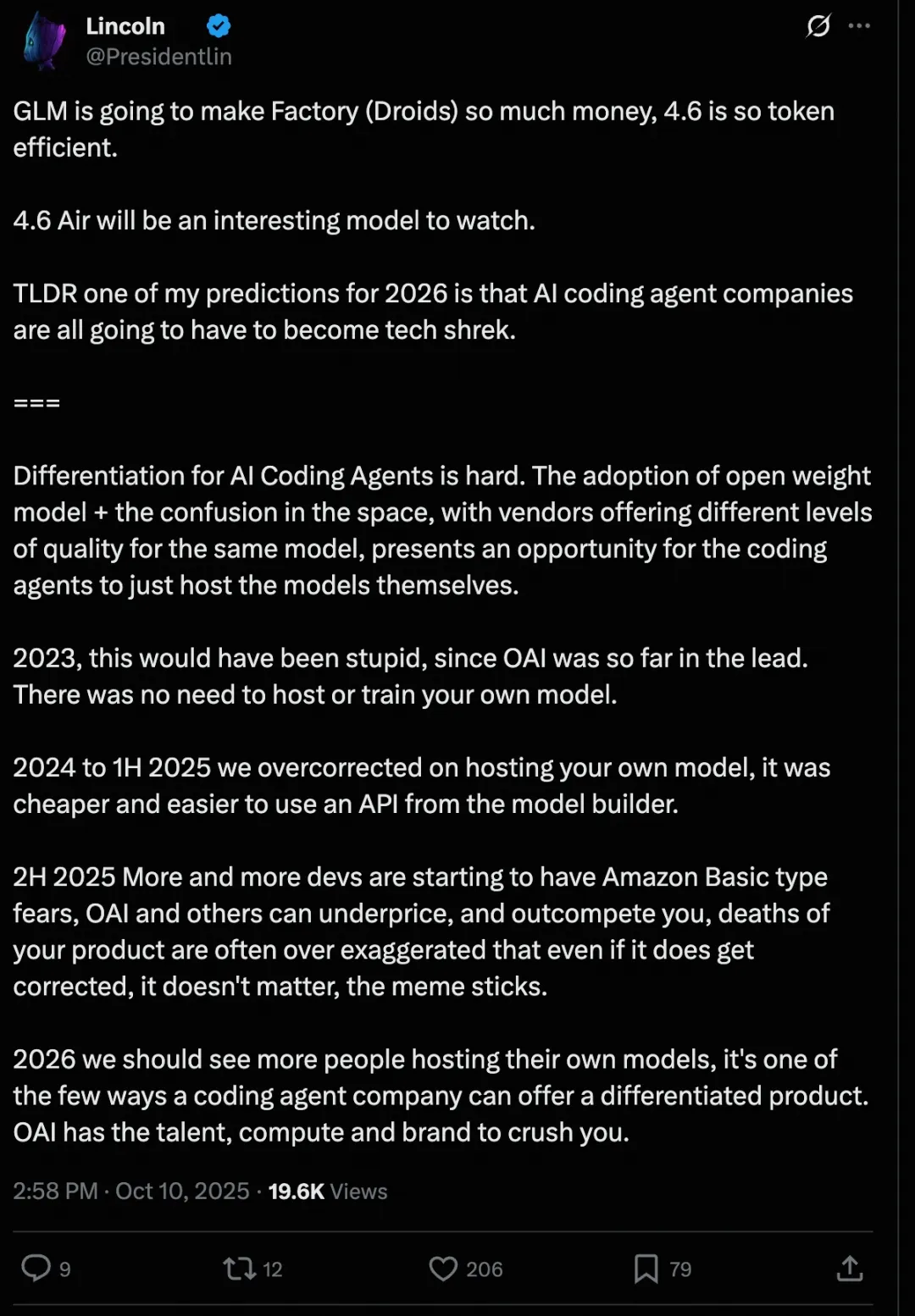

在海外的开发者论坛里,其实已经有不少大佬在讨论 GLM-4.6 了。

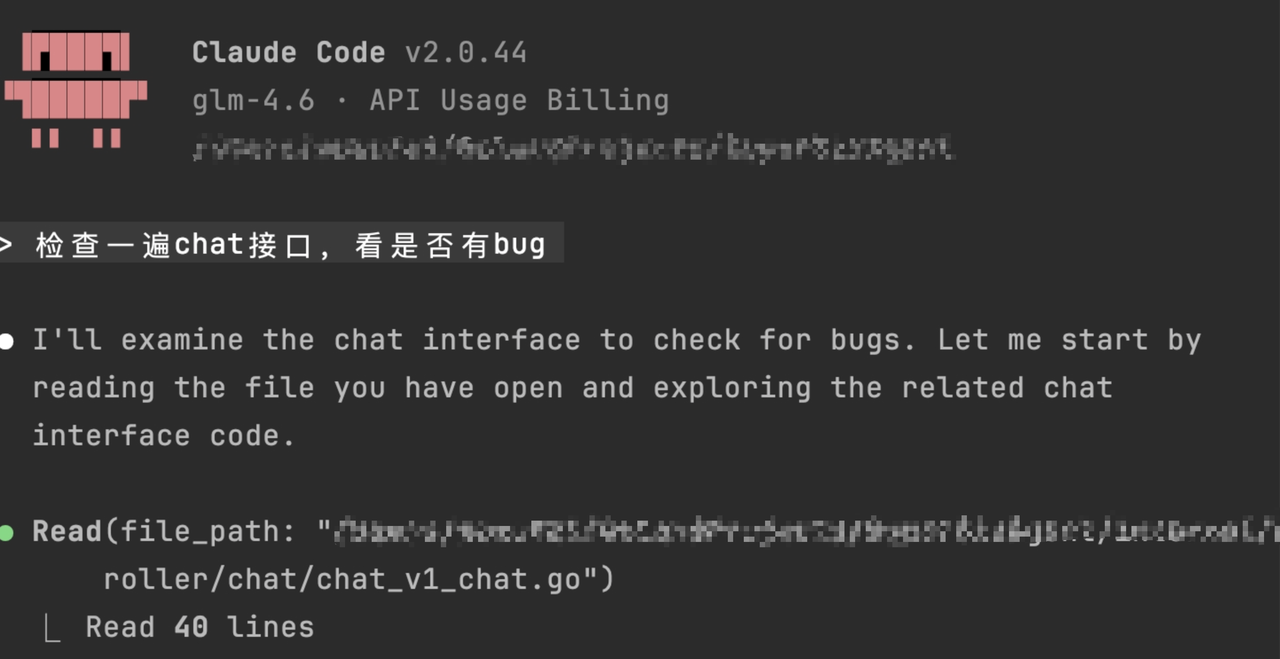

看到个很有意思的事,知名博主 Melvin Vivas 发现,GLM-4.6 可以丝滑接入 Claude Code 开发环境,再加上价格实在便宜,都已经改用 GLM-4.6 了

还有 Lincoln,这哥们说话更直接。他看了 GLM-4.6 的表现后感叹说,这模型太「Token Efficient」(节省 Token)了,简直是帮那些做 AI Coding Agent 的公司(比如 Factory)在印钞票。你看,在老外眼里,这不仅是好用,更是实打实的商业竞争力。

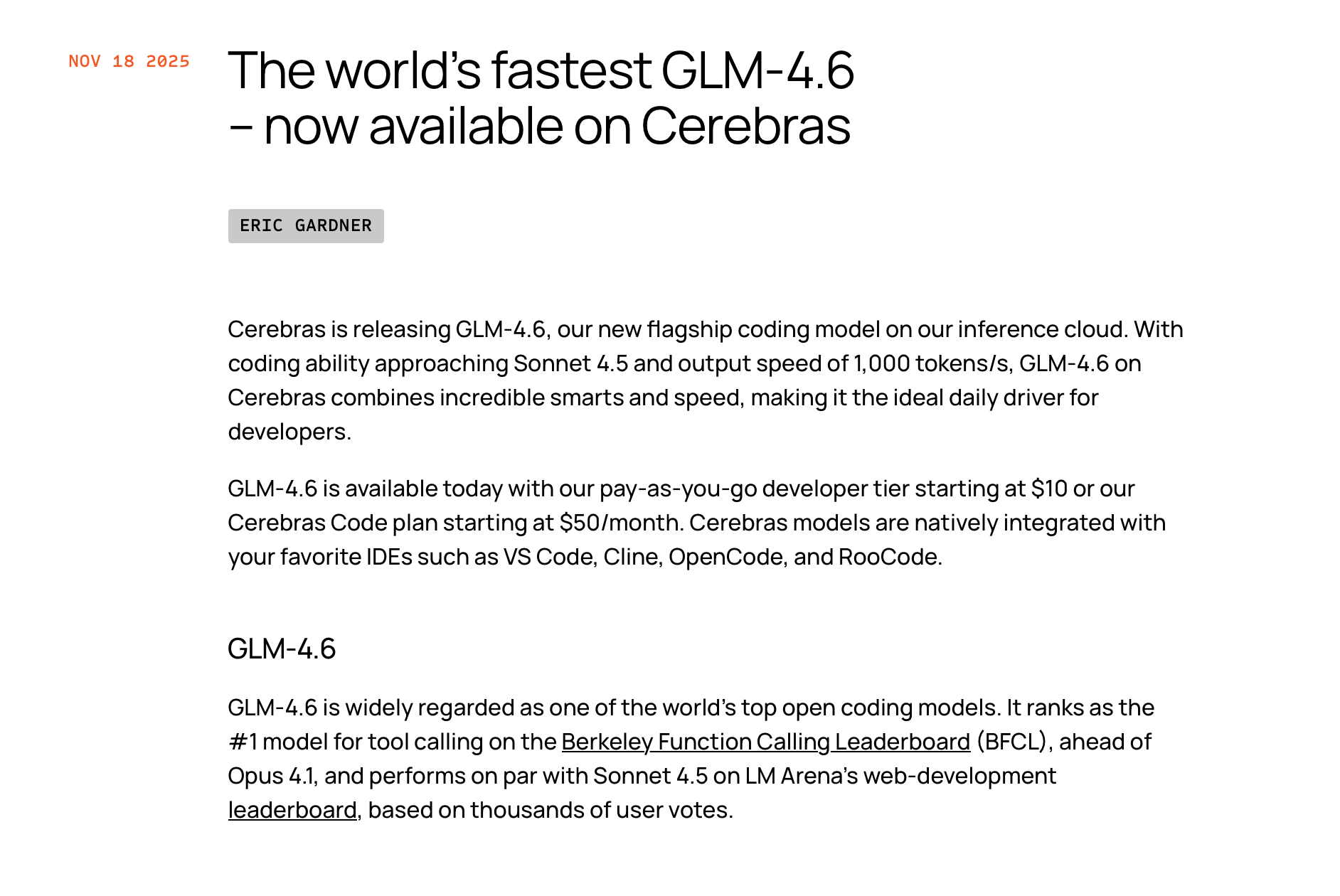

连国外的芯片巨头 Cerebras 都宣布把 GLM-4.6 作为默认推荐模型。这说明在硬核的技术圈子里,它已经开始走向全球开发者生态,成为了一个通用的选项。

除了性价比,GLM-4.6 对指令的遵循能力(Instruction Following)也是它在海外圈粉的重要原因。

大家应该都有过这种经历,你让 AI 给你写个接口,要求用 Python 的 FastAPI,结果它给你写了个 Flask。或者你让它只输出代码不要解释,它非得给你唠叨一大堆废话。

但在 GLM-4.6 上,我说「只给我改这行,别动其他的」,它就真的只改那一行。这种听话程度,对于需要精确控制代码变更的工程师来说,简直是救命恩人。

写在最后

说了这么多,其实我并不是在劝你把手里的海外账号全退了。在这个技术迭代快得像龙卷风的时代,死守某一个模型其实是不明智的。

我现在更推崇一种「双核驱动」的开发模式,说白了就是:把合适的工作交给合适的模型,既要里子,也要面子。

在我的日常工作流里,GLM-4.6 现在的角色更像是一个不知疲倦的「执行主力」。写具体的业务代码、生成前端页面、排查常规 Bug、写单元测试,这些占据了我 90% 工作量的脏活累活,我都扔给它。因为它快,它稳定,而且它真的很便宜,怎么跑都不心疼。

而 GPT 或者 Claude,我把它们当成「架构师」或者「审计员」。当 GLM 写完一个复杂模块后,我会把代码丢给 Claude 做一次 Code Review,让它从更宏观的角度挑挑刺。或者在做前期技术调研、写复杂方案的时候,我会拉上 Gemini 去搜集资料,再让 GPT 帮我梳理大纲。

这种「一内一外」的打法,其实效果才是最好的。

你想想,让两个顶尖模型互相「左右互搏」,互相指导,产出的代码质量往往比单打独斗要高得多。而且这种组合最大的好处是省钱。如果所有的执行工作都用 Claude,那个 Token 消耗量能让你月底看着账单怀疑人生。

但如果你把 GLM-4.6 作为主力输出,把昂贵的海外模型作为辅助校验,你的整体开发成本会直接暴跌,但产出质量却没有任何缩水,甚至更高。

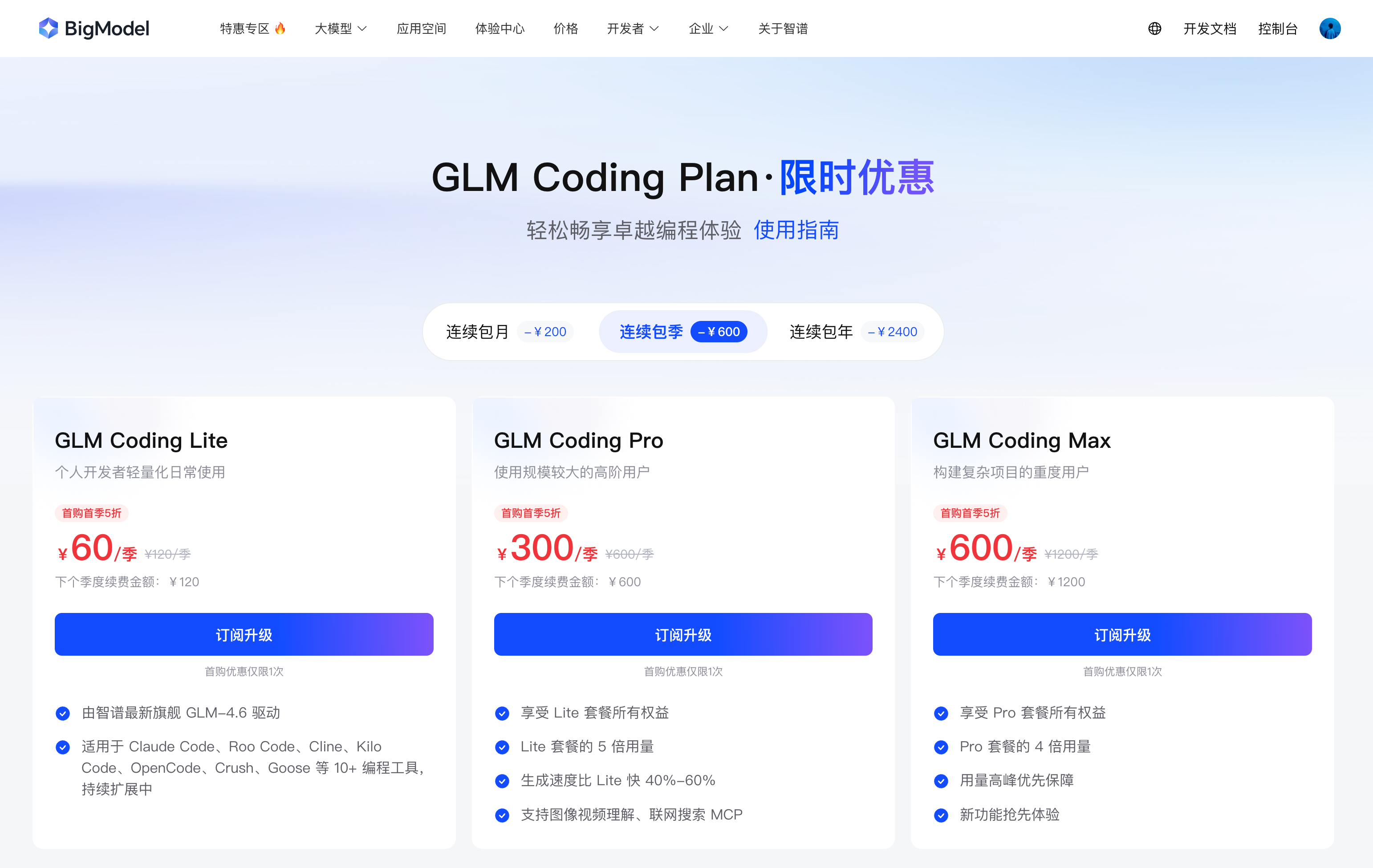

GLM Coding Plan 存在的意义,就是让这套「双核驱动」的玩法变得在经济上可行。它用极低的门槛,帮你承担了最大那部分的算力消耗。

所以,别再纠结到底是用国产还是用海外了。真正聪明的开发者,是把 GLM-4.6 变成自己工具箱里那把最趁手的锤子,然后搭配上其他的精密仪器,一起为你干活。

如果你也想试试这种高效又省钱的开发模式,现在智谱正好有活动,不仅价格打下来了,如果你通过我的专属链接或者二维码去体验,还能享受到更优惠的福利。

我的专属链接,通过这个链接直接就是优惠的当前价格👉:https://zhipuaishengchan.datasink.sensorsdata.cn/t/QR

通过二维码也可以直接进入页面:

这年头,能薅到高质量羊毛的机会不多,抓紧吧。

试一试吧,当你发现这种组合拳既能解决问题又能守住钱包时,你会回来感谢这个建议的。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)