面向AI浪潮:openGauss在向量数据库与RAG场景下的应用深度研究

2025年的今天,我们正处在一个由人工智能,特别是大语言模型驱动的深刻变革时代。然而,LLM本身固有的“知识截止日期”和“模型幻觉”问题,限制了其在对事实准确性要求极高的企业级场景中的应用。为了解决这一痛点,检索增强生成(RAG)技术应运而生 。RAG通过从外部知识库中检索相关信息,并将其作为上下文(Context)提供给LLM,从而显著提升了生成内容的时效性与准确性 。

文章目录

引言

2025年的今天,我们正处在一个由人工智能,特别是大语言模型驱动的深刻变革时代。然而,LLM本身固有的“知识截止日期”和“模型幻觉”问题,限制了其在对事实准确性要求极高的企业级场景中的应用。为了解决这一痛点,检索增强生成(RAG)技术应运而生 。RAG通过从外部知识库中检索相关信息,并将其作为上下文(Context)提供给LLM,从而显著提升了生成内容的时效性与准确性 。

openGauss,作为一款开源的企业级关系型数据库,以其高性能、高可用和高安全的核心特性在业界获得了广泛认可 。近年来,随着其版本的不断迭代,openGauss在智能化和云原生方向持续发力,逐步构建起面向AI时代的数据处理能力。本报告将深入探究openGauss如何拥抱AI浪潮,特别是在向量数据库和RAG这两个前沿场景中的具体应用、技术实现、性能表现及未来趋势。

一、openGauss技术演进与AI能力基础

openGauss并非一蹴而就地成为AI应用的备选项,其能力源于多年来在内核、架构和生态上的持续演进。

1.1 openGauss版本迭代回顾:迈向智能与云原生

openGauss社区遵循着每两年发布一个LTS(长期支持)版本、每半年发布一个创新版本的策略,确保了技术的稳步前行与快速创新 。

3.x时代:奠定高性能与生态基础

3.x版本(如3.1.1)主要聚焦于内核性能优化、高可用性设计以及基础生态的构建 。在这一阶段,openGauss完善了对JDBC、CM集群管理的支持,并初步整合了DataStudio、ShardingSphere等开发工具和中间件,为上层应用的开发和部署打下了坚实基础 。

5.x时代:企业级特性与智能化全面增强

以5.0.0 LTS版本为代表,openGauss迎来了企业级特性和智能化的飞跃 。该版本全面增强了内核能力,如SQL Patch、事件触发器等,并在TPC-H等基准测试中展现了显著的性能提升 。更重要的是,高智能(DBMind自治运维)、高安全(用户级审计)、资源池化以及对MySQL语法的深度兼容,标志着openGauss正向一个更成熟、更智能的数据库平台迈进 。5.1.0版本则开启了“多引擎时代”,在编译优化和扩展性上更进一步 。

6.x时代:拥抱云原生,深化AI融合

6.0.0版本将“云原生”作为核心演进方向,全面支持容器化部署、弹性扩展和混合云架构 。这使得在Kubernetes等云原生环境中部署和管理AI应用变得更加敏捷高效。同时,版本持续增强智能化能力,推出了日志检索、智能参数调优等插件,进一步降低运维复杂度 。

1.2 核心AI特性:从AI4DB到DB4AI

openGauss的AI战略体现为“AI4DB”(AI for DB)和“DB4AI”(DB for AI)两个层面。

AI4DB(智能运维) :以自治运维平台DBMind为核心,openGauss实现了AI驱动的数据库自调优、自诊断、自运维 。例如,通过机器学习模型预测负载、自动进行参数调优和索引推荐,能够将查询执行效率提升超过16倍,显著降低了DBA的管理负担,保障了复杂AI负载下的系统稳定性 。

DB4AI(赋能AI应用) :这是openGauss拥抱AI应用的关键。通过在数据库内核层面集成原生AI能力,为上层AI应用提供强大的数据处理支持。其中,最重要的进展便是对向量数据的原生支持,这使得openGauss能够直接作为向量数据库,为RAG、推荐系统等应用提供底层动力 。

1.3 生态系统支撑

一个强大的数据库离不开繁荣的生态。openGauss在工具链、社区合作等方面构建了坚实的支撑体系。DataKit、DataStudio等工具提供了从数据迁移、开发到管理的全生命周期支持 。与ShardingSphere等主流中间件的良好兼容性,使其能方便地融入现有技术栈 。截至5.0.0版本发布时,社区已吸引超过160万用户和230多家企业参与共建,形成了强大的发展合力 。

二、openGauss向量数据库能力深度解析与实战

本文将聚焦于openGauss作为向量数据库的核心能力,并通过一个完整的实操案例,展示其在实际应用中的操作流程和效果。

2.1 向量数据库:AI时代的基石

向量数据库专门用于存储、管理和检索由深度学习模型产生的向量嵌入(Vector Embeddings)。其核心价值在于能够基于向量间的距离(如欧氏距离、余弦相似度)来度量原始数据的语义相似性,从而实现高效的相似度搜索。这对于RAG从海量文档中快速召回最相关的知识片段至关重要。

2.2 openGauss的向量能力:datavec扩展

openGauss通过一个名为datavec的插件(或称扩展)来提供原生的向量数据处理能力 。该扩展为openGauss带来了以下核心功能:

向量数据类型:引入了vector数据类型,可以直接在数据表列中存储向量 。

距离计算函数:内置了多种常用的距离/相似度计算函数,如L2距离(欧氏距离)、内积(Inner Product)和余弦相似度 。

向量索引:支持高效的近似最近邻(ANN)搜索索引。目前,官方文档和资料中主要提及并支持的是ivfflat索引算法 。ivfflat通过聚类方式将向量空间划分为多个区域(lists),在查询时仅搜索目标向量附近的少数几个区域,从而实现比暴力全量搜索几个数量级的性能提升。

相似度查询算子:提供了便捷的查询算子,如<->(L2距离)、<#>(内积)和<%>(余弦距离),可以非常直观地在ORDER BY子句中进行相似度排序检索 。

2.3 实战演练:构建基于openGauss的向量检索引擎

下面,我们将模拟一个完整的终端操作流程,演示如何使用openGauss 5.0及以上版本(假设已安装datavec扩展)来存储文本向量并进行相似度检索。

2.3.1 环境准备与登录

如果我们已通过Docker快速部署了一个openGauss实例。首先,使用客户端工具gsql连接到数据库。

# 使用gsql工具连接数据库,输入密码后登录

$ gsql -d postgres -p 5432 -U omm -W

Password for user omm:

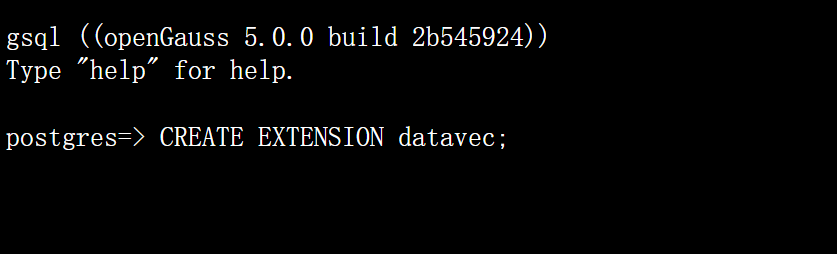

2.3.2 向量能力启用与数据表创建

成功登录后,首先需要通过CREATE EXTENSION命令在当前数据库中启用datavec扩展。然后,创建一个用于存储文档和其对应向量的表。为简化演示,我们使用4维向量。

【终端操作】

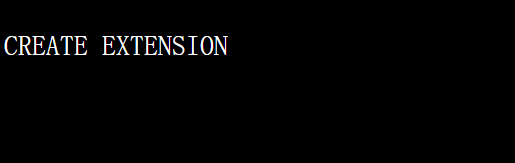

【运行结果】

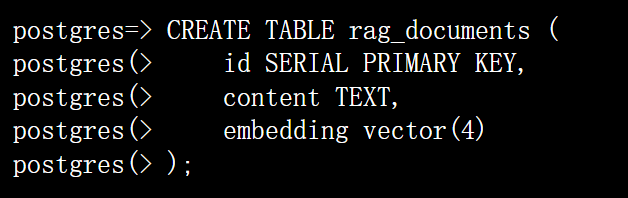

【终端操作】

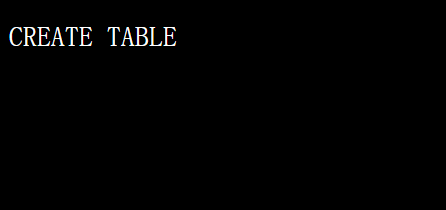

【运行结果】

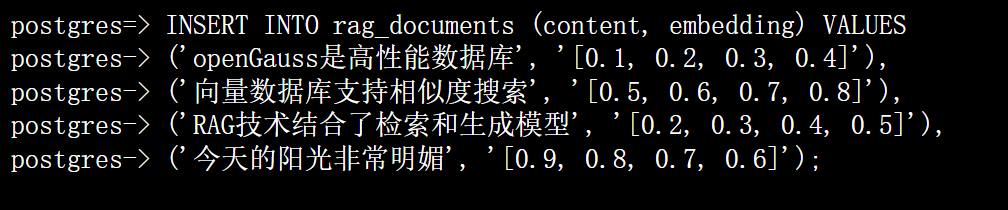

2.3.3 向量数据插入

接下来,向rag_documents表中插入几条模拟的文本及其向量数据。在真实场景中,这些向量是由文本嵌入模型(如BERT、M3E等)生成的。

【终端操作】

【运行结果】

2.3.4 IVFFlat索引构建

为了加速后续的相似度检索,我们在embedding列上创建一个ivfflat索引。这里我们使用L2距离(欧氏距离)作为度量标准,vector_l2_ops是datavec提供的操作符类。lists参数指定了聚类的中心数量,是影响索引构建时间和查询性能的关键参数,需要根据数据量和分布进行调整 。

【终端操作】

postgres=> CREATE INDEX idx_rag_docs_ivfflat ON rag_documents USING ivfflat (embedding vector_l2_ops) WITH (lists = 1);

【运行结果】

注意:在生产环境中,lists的值通常建议设置为N/1000到N/5000之间,其中N是总数据量。这里设置为1仅为演示。

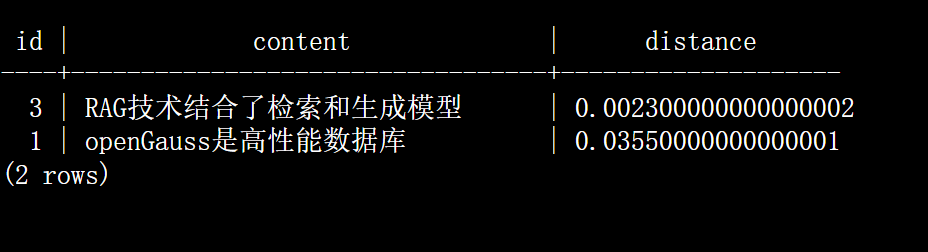

2.3.5 向量相似度检索

现在,如果用户提出了一个问题:“什么是RAG?”。我们的应用首先将这个问题转换为向量(例如,[0.21, 0.32, 0.41, 0.53])。然后,我们使用这个查询向量在数据库中寻找最相似的文档。

我们将使用<->操作符,它代表计算L2距离,并在ORDER BY子句中根据距离从小到大排序,返回最相似的Top 2条记录。

【终端操作】

-- 假设查询“什么是RAG?”的向量为 [0.21, 0.32, 0.41, 0.53]

postgres=> SET ivfflat.probes = 1; -- 设置查询时探索的聚类中心数量

postgres=> SELECT id, content, l2_distance(embedding, '[0.21, 0.32, 0.41, 0.53]') as distance

postgres-> FROM rag_documents

postgres-> ORDER BY embedding <-> '[0.21, 0.32, 0.41, 0.53]'

postgres-> LIMIT 2;

【运行结果】

从结果可以看出,数据库成功地召回了与查询向量最接近的两条记录,其中“RAG技术结合了检索和生成模型”这条记录的距离最小(0.0023),语义最相关。这个简单的例子完整地展示了openGauss作为向量数据库的核心工作流程。

三、openGauss在RAG场景下的应用与性能展望

3.1 RAG技术范式解读

一个典型的RAG应用流程如下:

-

离线处理:将知识库文档(如产品手册、公司财报、技术文档等)切分成块(Chunk),通过Embedding模型将每个块转换为向量,连同原文一起存入openGauss向量数据库。

-

在线检索:当用户提出问题时,将问题同样转换为查询向量。

-

向量检索:在openGauss中执行相似度搜索,召回与查询向量最相似的Top-K个文本块。

-

Prompt构建:将召回的文本块作为上下文,与原始问题一起构建一个丰富的Prompt。

- LLM生成:将构建好的Prompt发送给大语言模型,生成最终答案。

在这个流程中,openGauss承担了步骤1和步骤3的关键角色,其数据存储和检索的性能直接决定了RAG系统的响应速度和知识召回的质量。

3.2 构建基于openGauss的RAG流程

在应用层面,开发者可以使用任何后端语言(如Python)和数据库驱动(如psycopg2)来与openGauss交互,实现RAG流程。

以下是一个概念性的Python代码,展示了应用如何调用openGauss进行检索:

import psycopg2

from some_embedding_model import get_embedding

def retrieve_context_from_opengauss(query_text: str, top_k: int = 3):

# 1. 将用户问题转换为向量

query_vector = get_embedding(query_text)

# 2. 连接openGauss数据库

# (连接信息从配置中读取)

conn = psycopg2.connect(database="postgres", user="omm", password="...", host="127.0.0.1", port="5432")

cur = conn.cursor()

# 3. 执行向量相似度检索

sql_query = f"""

SELECT content

FROM rag_documents

ORDER BY embedding <-> '{list(query_vector)}'

LIMIT {top_k};

"""

cur.execute(sql_query)

results = cur.fetchall()

# 4. 关闭连接并返回结果

cur.close()

conn.close()

return [row for row in results]

# --- RAG主流程 ---

user_question = "什么是RAG?"

# 从openGauss检索相关上下文

context = retrieve_context_from_opengauss(user_question)

# 构建Prompt并调用LLM (略)

# final_answer = call_llm(prompt)

这段代码清晰地展示了openGauss如何无缝地嵌入到RAG的应用逻辑中,作为其“长期记忆”和“知识引擎”。

3.3 性能分析与业界对比

性能指标:根据公开信息,openGauss在AI场景的性能表现不俗。有资料提到,其向量索引检索响应时间可达毫秒级 。在AI场景实测中,单并发查询QPS(每秒查询次数)从80提升至110,性能提升了30%以上 。更有解决方案宣称,基于“鲲鹏+openGauss”的平台实现了亿级向量数据毫秒级召回,QPS性能领先行业10% 。这些数据表明openGauss在向量检索的核心指标上具备了较强的竞争力。

业界对比:对比业界其他向量数据库或具备向量能力的关系型数据库,评估指标通常围绕QPS、延迟(P99)、召回率(Recall)和性价比展开 。例如,有厂商公布其RAG方案P99延迟小于50ms,精度0.88 ,或向量检索召回率大于99%,吞吐量超10,000 QPS 。虽然缺乏同等条件下的直接对比,但openGauss公布的“毫秒级召回”和“QPS领先10%”等指标,显示其性能已进入行业第一梯队。

综合优势:openGauss作为RAG知识库的独特优势在于其HTAP一体化架构。企业可以将业务的结构化数据(如用户信息、订单记录)与非结构化知识的向量数据存储在同一个数据库中。这不仅大大简化了技术栈(无需维护一个独立的关系型数据库和一个独立的向量数据库),还能实现结构化数据与向量数据的混合查询,催生更复杂的智能应用场景。例如,在电商推荐中,可以结合用户的历史购买记录(结构化数据)和用户当前浏览商品的语义相似度(向量检索)来进行实时精准推荐。

四、用户案例与发展趋势

4.1 典型用户场景分析

尽管详细的用户案例描述不多,但从已披露的信息中,我们可以勾勒出openGauss在AI相关领域的应用图景。

政企OA/办公场景:在政企内部,存在海量的公文、报告、法规、制度等非结构化文档。利用openGauss构建智能知识库,可以开发智能问答机器人、语义搜索引擎,让员工能以自然语言快速找到所需信息,极大提升办公效率 。

金融行业:金融领域对数据安全和实时性要求极高。openGauss可用于构建智能客服、风险报告分析、舆情监控等系统。例如,通过分析海量研报和新闻的向量,快速识别市场情绪和潜在风险 。

RAG平台解决方案:已有合作伙伴(如中科通达)基于“鲲鹏+openGauss”发布了商业化的RAG平台解决方案 这证明openGauss的向量能力已经通过了商业化验证,具备了服务企业级客户的能力。

4.2 未来发展趋势展望

我们认为openGauss在AI领域的演进将聚焦于以下几个方向:

HTAP与AI的深度融合:这依然是openGauss最核心的差异化优势。未来,openGauss可能会进一步优化混合查询的执行计划,实现结构化过滤与向量检索的无缝协同,提供“一站式”的智能数据服务。

向量能力持续增强:随着向量数据库技术的发展,预计openGauss会支持更多、更先进的ANN索引算法(如HNSW),提供更丰富的调优参数,并可能引入标量量化、乘积量化等技术来降低内存占用和提升查询性能。

多模态数据支持:AI的应用已从文本扩展到图像、音频和视频。openGauss的向量数据库能力天然具备支持多模态数据的基础。未来,通过与多模态大模型结合,openGauss可以成为存储和检索各类非结构化数据的统一平台。

云原生与Serverless化:结合其6.x版本开启的云原生演进路线,未来的openGauss可能会提供Serverless形态的向量数据库服务,实现极致的弹性伸缩和按需付费,进一步降低AI应用的开发和使用门槛。

五、结论

本报告通过对openGauss各版本技术特性、生态系统、性能指标及实战操作的系统性梳理和分析,得出以下结论:

-

技术成熟度高:openGauss通过持续的版本迭代,已从一个高性能的关系型数据库,演进为一个具备原生AI能力、拥抱云原生架构的现代化数据平台。

-

向量能力已落地:通过

datavec扩展,openGauss提供了功能完备且性能有竞争力的向量数据库能力,能够有效支撑RAG等主流AI应用场景,并且已经有了商业化落地案例。

-

核心优势突出:其独特的HTAP一体化架构,允许在单一系统内融合处理结构化业务数据和非结构化AI数据,为企业构建下一代智能应用提供了更简洁、更高效的架构选择。

-

发展潜力巨大:背靠活跃的开源社区和强大的产业生态,结合其在HTAP+AI、云原生等方向的明确发展路径,openGauss在未来AI驱动的数据基础设施市场中,有望占据重要的一席之地。

openGauss已不再仅仅是传统数据库市场的一个有力竞争者,它正以积极的姿态,凭借其坚实的技术底座和前瞻的AI布局,成为赋能千行百业智能化转型的关键基础设施。对于正在寻求构建RAG系统或探索AI应用的企业而言,openGauss无疑是一个值得重点评估和考虑的强大选项。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)