程序员玩转AI的32个提示工程技巧,收藏起来慢慢学!读完认知超90%的人,不夸张!

文章系统介绍了提示工程的32个核心技巧,分为四大基础(清晰表达、提供上下文、结构化提示、迭代优化)和进阶方法(教学模式、激发推理、工具使用、减少幻觉等)。通过明确指令、角色设定、思维链、RAG等技术,提升与AI交互的精准度和效率,使AI从简单回答工具进化为能自主思考和行动的智能助手,适用于编程、创意写作等多种场景。

前言

你以为AI不行?其实可能是你的"问法"不对。

这背后有门学问,叫提示工程(Prompt Engineering)。

专门研究怎么跟AI"对话"。

最近翻了不少论文,整理出32个核心技巧。

从入门到高阶,一次性讲透。

让你提示词水平迅速提升一个台阶,认知远超同辈。

提示工程四大基础

基础一:把话说清楚

AI不是你肚子里的蛔虫,你越含糊,它越抓瞎。

技巧 1:指令要“无歧义”

别说:“分析下这个。”

要说:“总结这篇论文的关键发现,并用项目符号列表展示。”

技巧 2:“要”什么,别“不要”什么

就像教小孩。

你对他说:“不要使劲抓小狗!”

他脑子里全是“使劲抓”和“小狗”,反而更容易出错。

你不如说:“要轻轻地摸小狗。”

AI也一样。

别说:“语气别太随意。”

要说:“请使用正式、学术的语调写作。”

给它一个清晰的目标,而不是一个雷区。

技巧 3:什么时候用“不要”

当然,“不要”也不是完全不能用。

它最适合“控制边界”。

比如:“解释什么是‘经济计量学’,但不要使用复杂的数学公式或行话。”

精确控制输出,但要不用来定义核心任务。

基础二:给够“上下文”

LLM是个“模式匹配”高手,它没有真正的“理解”。

背景信息(上下文)能帮它“找到”到正确的知识库。

技巧 4:喂饱背景信息

你要它分析财报?

那就先把财报的关键数据喂给它。

你让它写邮件?

先把前情提要和收件人信息给它。

技巧 5:指定“读者”是谁

一个超级好用的杠杆!

“给一个5岁小孩解释什么是量子计算”和“给一个物理学博士写量子计算的综述”。

这俩任务绝对不一样。

你把受众一说,AI立马知道该用什么词、什么调调、什么深度。

基础三:用好“脚手架”

提示词结构越清晰,AI给的答案也就越靠谱。

技巧 6:给它一个“角色”

最常用技巧之一。

“你现在是一个资深的前端开发工程师……”

“扮演一个世界顶级广告文案专家……”

一旦给它“人设”。

AI 就会用跟这个角色相关的风格、术语和思维模式。

输出立马专业起来!

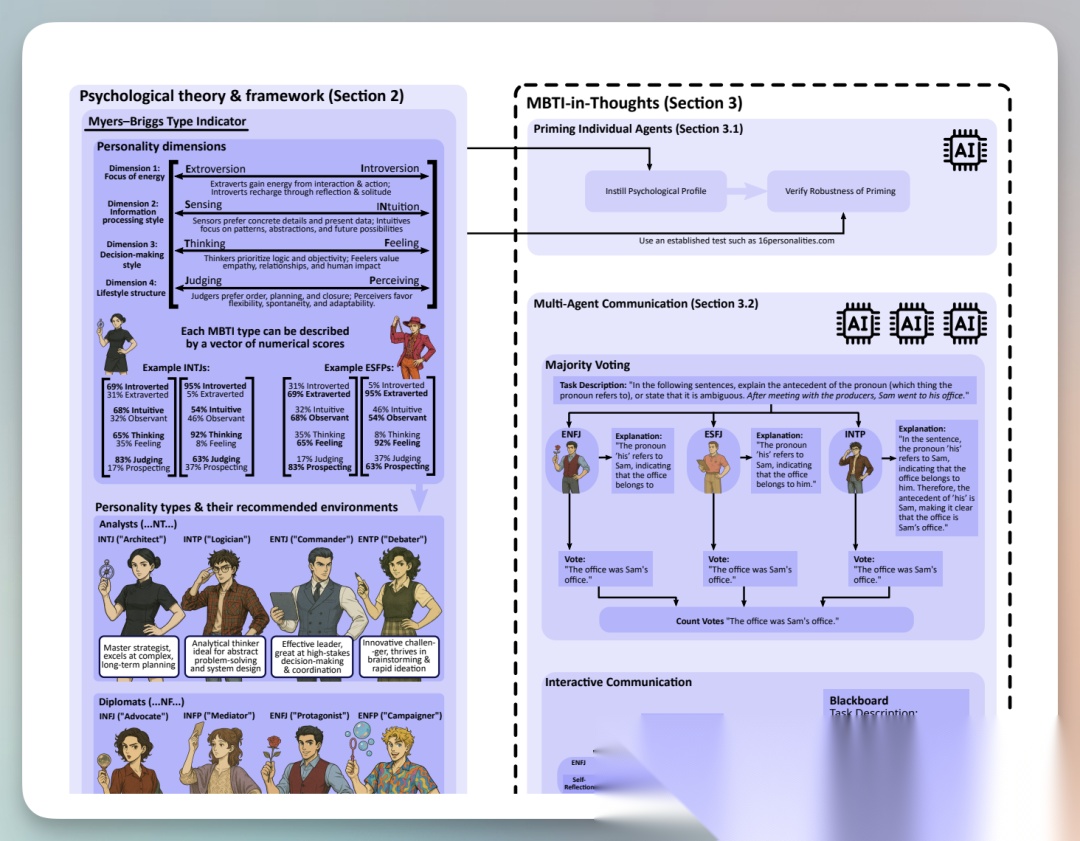

甚至设定 MBTI 人格,都能让回复更像这类人的思考表达。(INTJ/ENPF等)

不要疑惑,这些都有论文支撑。

https://arxiv.org/abs/2509.04343

技巧 7:用好“分隔符”

很重要,但新手经常忽略。

要把“指令”、“背景资料”、“示例”、“你的问题”这些不同部分,用清晰的分隔符隔开。

比如用三重反引号(```)、XML标签()或者井号(###)区分或包裹。

1 2 3 ###指令### 总结以下文章: <content>内容</content>

或者用“—”分割,让AI更好理解提示词结构。

技巧 8:规定“输出格式”

必须明确告诉 AI,你要什么格式。

要JSON?

要Markdown表格?

还是要项目符号列表?

这个技巧是让 AI 输出能被“程序”更容易调用的关键。

比如定死 JSON 格式,后端程序就能直接解析。

再比如要求 AI 输出Markdown Code。

生成的内容,复制粘贴到飞书、Obsidian等工具,会按 Markdown 渲染展示。

技巧 9:你来 “起个头”

行话叫:输出启动(Output Priming)。

想让 AI 写 Python 代码?

就在提示词最后说:

“以下是Python代码:

python

AI一看就懂,会很“自觉”地顺着你的格式往下接。

基础四:学会“迭代”

写提示词不是艺术创作,更像搞“科学实验”。

技巧 10:迭代优化

第一个提示词99%是垃圾。

你要做的就是:测试 -> 看哪儿不对 -> 调整 -> 再测试。

提示工程师最核心的日常工作如上。

技巧 11:应对常见“毛病”

AI常见的毛病有:幻觉、重复、模糊、前后不一。

针对不同问题,要有不同策略。

比如它胡说八道,就得用RAG(后面会讲)给它“喂”点真材实料。

技巧 12:像“写代码”一样管提示词

把提示词当成代码来管理。

要做版本控制(V1, V2版)。

用占位符(动态塞数据)。

搞A/B测试(看哪个提示词效果好)。

一个好的提示词,就是创造了一个“最小阻力路径”。

让AI“照着做”的难度,远远小于它“自由发挥”的难度。

教学模式

两种最基础的“教学模式”。

技巧 13:零样本提示(Zero-Shot)

不给AI任何例子,直接让它干活。

“把这句话翻译成法语。”

“法国的首都是哪儿?”

这依赖于AI在训练时已经“内化”的知识。

简单任务用这个最省事。

技巧 14:少样本提示(Few-Shot)

任务稍微复杂点,或有特定格式要求,零样本就不灵了。

这时,得给它几个例子。

比如,让它做“情感分类”:

提示:

文本:“这顿饭太好吃了!”

情感:正面文本:“我等了三个小时才上菜。”

情感:负面文本:“这家店的装修还行吧。”

情感:中性文本:“他们的服务真是绝了,再也不来了。”

情感:[?]

给 AI 几个“输入-输出”的范例。

它就能激活一种叫 情境学习(In-Context Learning) 的能力。

会照着你的模式去猜最后一个。

研究发现,示例的“格式”和“多样性”,甚至比示例的“答案”还重要。

AI 在学你这个“模式”,而不是在背答案。

激发推理

好了,从这儿开始,难度上来了。

咱们要让 AI 解决复杂的“逻辑题”。

技巧 15:思维链(Chain-of-Thought, 简称CoT)

这是个里程碑式的技术。

你问 AI 一个数学题:“小明有5个苹果,他又买了3筐,每筐4个。他现在有几个?”

AI 很可能直接给你个“17”,也可能给你个“12”。

可能算对,也可能算错。

(至少ChatGPT 3.5时经常这样)

但如果你用了CoT,你就要求它:

“请一步一步地思考。”

它就会输出:

-

- 小明原有5个苹果。

-

- 他买了3筐,每筐4个,所以他新买了 3 * 4 = 12 个苹果。

-

- 他总共有 5 + 12 = 17 个苹果。

答案是 17。

发现了吗?

CoT就是逼着AI把“思考过程”写出来。

这给了 AI 更多的“计算空间”去处理问题,而不是急着“蹦”答案,准确率暴涨。

技巧 16:零样本CoT

更神的是,你甚至不需要给它“解题示例”。

你只需要在问题最后加一句“魔法咒语”,比如:

“让我们一步一步地思考。”(Let’s think step by step)

有研究发现,更牛的咒语是:“让我们一步一步地解决这个问题,以确保我们得到正确的答案。”

这时,AI回答的准确率会大幅提升。

注意:现在的 AI 模型,尤其是推理模型,比如Deepseek R1 或 ChatGPT o1。

本身就擅长推理,应该是内了分布推理思考。

用这个提示词反而效果不好。

让 AI 多思考,总是能提升输出质量。

比如 Claude Code,目前最强的AI编程工具之一。

直接内置了 AI 思考强度控制关键词:

“think” < “think hard” < “think harder” < “ultrathink”

ultrathink,思考消耗token最多,输出可能最好。

一些搞不定的Bug,可以试着加上这个关键词,有奇效!

技巧 17:自洽性(Self-Consistency)

这是CoT的“威力加强版”。

一道难题可能有好几种解法。

CoT可能是 “一条路走到黑”。

自洽性是,让AI用 CoT 的方式,算10遍

(通过调高temperature参数让它每次思路不一样)。

比如,10次计算里:

7次答案是“17”

2次答案是“12”

1次答案是“23”

那我就 “少数服从多数”,选那个最“自洽”的答案“17”。

这种方法能极大地提高复杂推理的准确性。

技巧 18:通用自洽性

用来处理“开放性问题”。

比如“总结这篇文章”。

让AI生成10个不同版本的总结。

再让AI自己判断“哪几个版本的意思最接近/最一致”。

技巧 19:思维树(Tree of Thoughts, 简称ToT)

如果说CoT是“单线程思考”。

那ToT就是“多线程+自我评估”。

一个更变态的框架,模拟人的 “广度优先搜索”。

-

- 分解:把问题拆成几步。

-

- 生成:在第一步,同时想出3个可能的“想法”(比如解题思路A、B、C)。

-

- 评估:AI自己评估这3个想法哪个“最有前途”。(比如它觉得B最好,C最差)

-

- 探索:它会顺着B往下走,再想出B1、B2、B3。如果发现B走不通,它还会“回溯”,回去试试A。

思维树(ToT)非常适合下棋、解谜、写小说这种需要“走一步看三步”的复杂任务。

技巧 20:验证链(Chain-of-Verification, 简称 CoVe)

这个是专门用来“治幻觉”的。

让AI回答一个问题,它哗啦啦给了一堆答案。

你怎么知道它没瞎编?

验证链的流程:

-

- 生成答案:AI先给个初步答案。

-

- 规划验证:AI自己根据答案,提出几个“验证性问题”。(比如答案里提到“A公司财报”,它就问“A公司财报的具体数字是多少?”)

-

- 独立回答:AI(或调外部工具)独立地去回答这些验证问题。

-

- 最终核实:AI拿着“验证结果”和“初步答案”一对比,进行修正,给出最终的、经过核实的答案。

CoT、ToT、CoVe这些技术,标志着我们使用AI的方式变了。

CoT:是让AI把“思考”外化。

ToT 和 CoVe:是让AI不仅要“思考”,还要“批判自己的思考”。

这叫“元认知”。

也就是“思考你的思考过程”。

把AI当成一个“模拟的科学思维系统”:

假设(生成想法)-> 检验(自我评估)-> 修正(回溯或验证)

这才是高级提示工程的精髓。

列个表,帮你对比理解:

| 技术 | 适用问题 | 成本 | 复杂度 | 主要优势 |

|---|---|---|---|---|

| 思维链 (CoT) | 多步骤、有清晰顺序的问题 | 低 | 非常低 | 简单、可解释 |

| 自洽性 | 有多种解法的问题(如数学) | 中(N次调用) | 低 | 准确、鲁棒性 |

| 思维树 (ToT) | 需要规划、探索、回溯的复杂问题 | 高(大量调用) | 高 | 解决超难题 |

| 验证链 (CoVe) | 容易产生“幻觉”的事实性问题 | 中 | 中 | 减少胡说八道 |

从“思考”到“行动”

光“想”还不够,AI得学会“动手”。

要把 AI 变成“AI Agent(智能体)”。

核心循环:思考 -> 行动 -> 观察。

技巧 21:ReAct(推理+行动)

假如问AI:“马斯克最新的X推文是啥?”

AI 光靠大模型训练好的静态知识,肯定不知道。

ReAct框架就是让AI:

-

- 思考(Thought):“我需要实时信息,我得用搜索引擎。”

-

- 行动(Act):“调用

search_api('马斯克 最新 X')”

- 行动(Act):“调用

-

- 观察(Observation):“[API返回了搜索结果:‘马斯克说……’]”

-

- 思考(Thought):“OK,拿到信息了,我来总结一下。”

-

- 行动(Act):“[生成最终答案给用户]”

这个“思考-行动-观察”的循环。

让AI能调用 外部工具(Tool),从而变的更强大。

人也是这样,赤手空拳很难打过刀枪剑戟。

善于用工具,才会让人变强,AI也不例外。

技巧 22:Reflexion(反思)

这是ReAct的升级版。

如果AI的“行动”失败了:

比如API调用出错,或者搜索没结果,ReAct可能会卡住。

Reflexion加了一层“自我反思”:

当行动失败时,AI会停下来,自己生成一段“失败总结”

比如:“上次我用‘马斯克 最新 X’没搜到,下次我应该试试‘Elon Musk X post’”。

这段“经验”会存起来。

下次执行任务时,它会先看看“经验库”,避免犯同样的错。

让 AI 学会“吃一堑长一智”。

技巧 23:PAL(程序辅助语言模型)

遇到数学题,AI用自然语言(CoT)算,还是容易错。

PAL是这么干的:AI的“思考过程”不再是“自然语言”,而是“代码”!

问题:停车场有10辆车,又开来了3辆卡车,每辆卡车有6个轮子。总共有多少个轮子?

PAL的输出:

# 汽车的轮子

car_wheels = 10 * 4

# 卡车的轮子

truck_wheels = 3 * 6

# 总轮子

total_wheels = car_wheels + truck_wheels

print(total_wheels)

然后,系统真正执行这段Python代码,得到“58”。

这样一来,AI负责“理解问题并写出逻辑”。

而“精确计算”这个活儿,交给最擅长的“Python解释器”。

简直完美!

技巧 24:ART(自动推理与工具使用)

这个框架很适合“偷懒”。

每次都手动写 ReAct 提示词太累了。

ART是建一个“工具库”(比如搜索API、计算器API)。

你给ART一个新任务。

它会自动去“任务库”里,扒拉出几个“使用过工具”的CoT示例。

然后它 “依葫芦画瓢”,自己学会怎么分解新任务和调用新工具。

减少“幻觉”

AI的知识是“静态”的,训练完就定了。

没有的内容会经常“瞎编”。

如何降低这类问题?

技巧 25:RAG(检索增强生成)

AI会产生幻觉(Hallucination)。

RAG (Retrieval-Augmented Generation)

是给AI“外挂”一个实时知识库。

比如公司的内部文档、最新的新闻库、你的个人笔记等。

流程是这样的:

-

- 你提问:“咱们公司上个季度的财报怎么样?”

-

- 检索(R):系统不直接问AI。它先拿着你的问题,去你的“知识库”,通常是向量数据库里搜,找出最相关的几段原文(比如财报 PDF 里的几段)。

-

- 增强(A):系统把“你的问题”和“搜到的原文”拼在一起,形成一个新的提示词。

-

- 生成(G):把这个“增强版”提示词扔给AI,并告诉它:“请根据我提供的上下文,回答这个问题。”

让 AI 不再靠“背诵”来回答,而是靠“阅读你给的资料”来回答。

RAG = 知识库搜索 + LLM

一定程度可以解决知识过时和胡说八道的问题。

技巧 26:生成式知识提示

在问 AI “最终问题”前。

先让它 “围绕这个主题,生成一些你知道的相关事实”。

比如,你问“特斯拉的 Cybertruck 有什么优缺点?”

你先让它:“1. 请先列出5个关于Cybertruck的核心事实。”

然后再问:“2. 基于以上事实,分析它的优缺点。”

这等于正式答题前,帮 AI “预热”和“激活”脑子里相关的知识。

技巧 27:提示链(Prompt Chaining)

不要试图用一个“超级无敌复杂”的提示词,干一件“超级复杂”的事。

你得学会“拆”。

比如,你要“写一篇关于A公司的深度分析报告”。

提示1(ReAct):“去网上搜索A公司的最新财报、竞品分析和市场新闻,汇总关键点。”

提示2(RAG):“基于[提示1的输出],结合我们内部的销售数据[在此插入],生成一份SWOT分析。”

提示3:“基于[提示2的输出],撰写一份500字的执行摘要,风格要正式。”

把一个大任务,拆成一连串的小提示。

前一个的输出,是后一个的输入。

这样的“工作流”更可控、更稳定、更容易调试。

技巧 28:元提示(Meta-Prompting)

用AI来生成提示词。

不是去解决一个“具体问题”,你是去定义一个“解决这类问题的模板”。

你让AI当“提示工程师”。

让他生成一个可以重复使用的“提示模板”。

比如我和姚老师都写过元提示词。

非常好用!

哪怕你不懂的领域,用这个提示词,也能写出80分的提示词。

https://xiangyangqiaomu.feishu.cn/wiki/PPywwbbk7iYZfBkHMUAclGwXnWh

技巧 29:图提示(Graph Prompting)

用“图”(Graph)的结构来组织知识(实体、关系)。

然后引导 AI 基于这个“知识图谱”去推理。

这能帮 AI 更好地理解实体之间复杂的关系。

例如:列出三元组事实:

▫ 小李 — 住在 — 五道口

▫ 超市A — 位于 — 五道口

▫ 超市A — 鸡蛋价 — 便宜

▫ 超市B — 位于 — 中关村

▫ 小李 — 需要 — 鸡蛋

根据上面的关系,小李今天应该去哪家店买鸡蛋?

给出一句话结论,并在括号里标注依据的关系。

预期输出:去超市A买鸡蛋(依据:小李—住在—五道口;超市A—位于—五道口;超市A—鸡蛋价—便宜)。

让AI自己“进化”

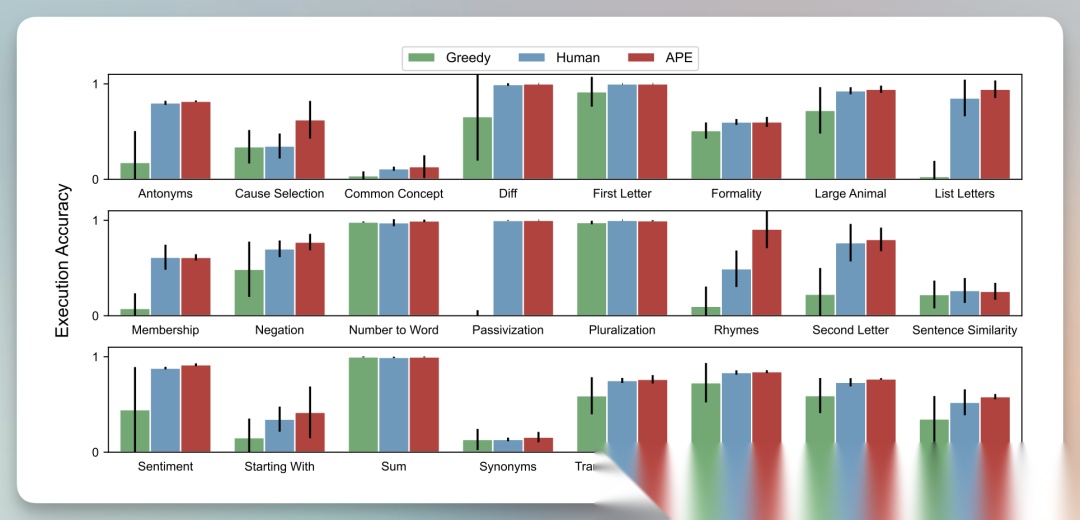

技巧 30:APE(自动提示工程师)

APE = Automatic Prompt Engineer。

把“找提示词”变成“优化问题”。

-

- 让一个AI(生成器)“编”出100个候选提示词。

-

- 用这些提示词去跑你的任务,并给结果打分。

-

- 最后选出那个“得分最高”的提示词。

前面提到的“魔法咒语”

“让我们一步一步地思考(Let’s think step by step)”。

APE框架“发现”了更强的版本:

“让我们循序渐进地找出正确答案(Let’s work this out in a step by step way to be sure we have the right answer)”。

比人类工程师想出来的还好用。

原始论文:https://arxiv.org/abs/2211.01910

技巧 31:主动提示(Active-Prompt)

可以帮助优化“少样本提示词”(技巧14)。

假如你有一堆问题,但你没工夫给它们标上“答案示例”。

主动提示就是让AI自己先“看一遍”所有问题。

然后挑出它“最没把握”的那几个。

人类专家只需要集中火力,给这几个“硬骨头”问题写高质量的CoT示例就行了。

用最少的“人工标注”,达到最好的“教学效果”。

技巧 32:定向激励提示(DSP)

用一个“小模型”(比如某个微调过的模型),先生成一个简短的“激励”或“策略”。

把这个“激励”,作为前缀,喂给一个超强的“大模型”(比如GPT-5、Claude Opus 4.1 )。

“小激励”就像一个“方向盘”,能高效地引导大模型往你想要的方向输出。

例如,小模型任务(只产出前缀原则,不碰事实):

请生成不超过60字的输出原则,用于会议纪要转Todo。必须包含:目标(3条动作)、语气简洁务实、结构(动词+对象+指标),禁止空话与复述。

小模型可能输出(激励前缀):

目标:3条行动;语气简洁务实;结构“动词+对象+量化指标”;仅基于纪要事实;附一行关键风险与依赖。

强力大模型提示词(小模型生成的前缀 + 会议纪要原文):

目标:3条行动;语气简洁务实;结构“动词+对象+量化指标”;仅基于纪要事实;附一行关键风险与依赖。

请阅读以下会议纪要,仅输出:

- 三条行动(每条≤25字,动词开头,含指标或期限)

- “风险与依赖”一行(≤20字)

- 格式:Markdown项目符号列表

[在此粘贴会议纪要原文]

实战演练

光有理论不够,我们来一些实战演练。

创意写作

“展示,而非告知”

别让AI说:“他很悲伤。”

要让AI写:“写一个场景,通过他看到的(比如雨滴)、听到的(比如远处的钟声)和感觉到的(比如冰冷的咖啡),来‘展示’他的悲伤。”

强制视角一致

AI写着写着,“我”和“他”等人称就乱了。

在提示词里“强制规定”:“必须全文使用第一人称(‘我’)视角进行叙述。”

风格与语调控制

“模仿海明威的简洁、硬汉风格写作。”

“使用19世纪维多利亚时代的正式、华丽语言。”

人格化提示(角色扮演)

不只是给个“角色”,而是给个“详细人设”。

包括他的背景、动机、口头禅、说话的节奏。

然后让AI“以这个角色的身份”去创作。

分步叙事(提示链)

写长篇小说,别指望一个提示搞定。

第1步:生成故事大纲。

第2步:把大纲扩展为章节摘要。

第3步:针对“第一章摘要”,写出具体的场景和对话。

“分层”的写法,能保证长文不跑偏。

信息提取与对话

用于摘要的角色扮演

要不同视角的摘要?换角色!

“作为一名投资分析师,总结这篇财报,重点关注对盈利能力的影响。”

带情境的问答(RAG)

问“特定文档”的问题时,先把“原文”喂给AI。

带领域知识的翻译

别只说:“翻译成德语。”

“把这份医疗设备手册翻译成德语,确保使用专业术语,并保持正式、严谨的语调。”

对话中的状态管理

搞“多轮对话”机器人,AI聊着聊着就忘了前面说的。

需要在每一次提交新Prompt时,都附带一个“简短的对话历史摘要”,帮它“回忆”上下文。

对话例程(工作流)

做“任务导向”机器人(比如订餐、客服)。

用“自然语言”或“伪代码”,在系统提示词里,把一整个“工作流”都定义好:

例如 “1. 先问候;2. 收集A信息;3. 验证A;4. 如果A不对,转人工……”

AI会变成这个“工作流”的解释器,一步步引导用户走完流程。

写代码

让AI写代码,你得把它当成一个“初级程序员”来“管理”。

直接指令:“用Python写个斐波那契数列函数。”(简单活儿)

迭代优化:“不错。现在,给这个函数加个缓存(caching)。”(一步步加功能)

示例驱动:“这是我的代码风格(给个例子),请按这个风格重构。”(统一风格)

函数级分解(提示链):“别一下写全。咱们先写handle_db_connection函数…”(拆任务)

骨架填充:你给它一个“代码框架”(比如类和函数定义都写好,但逻辑是空的),让它“填空”。这能保证它写的代码和你现有架构兼容。

引用密集型启动:你要它用一个很偏的库?先把这个库的“API文档”喂给它(RAG),然后说:“基于以上文档,帮我实现XX功能。”

安全导向(角色扮演):“你是一个专注于应用安全的资深后端开发者。帮我写个登录函数,必须考虑SQL注入和密码哈希。”

代码解释(CoT):“在写代码之前,请先用自然语言,一步步解释你的实现逻辑。”(这样你既得到了代码,也得到了“代码文档”)

写在后面

写完这32个技巧,我突然意识到一件事:

提示词工程很像是一种新的"人机沟通艺术"。

掌握这些技巧,会大幅提升你的提示词水平,让AI变的更好用。

无论AI编程还是创意写作,都有用武之地。

这些技巧,你曾经用过哪些?

最后

为什么要学AI大模型

当下,⼈⼯智能市场迎来了爆发期,并逐渐进⼊以⼈⼯通⽤智能(AGI)为主导的新时代。企业纷纷官宣“ AI+ ”战略,为新兴技术⼈才创造丰富的就业机会,⼈才缺⼝将达 400 万!

DeepSeek问世以来,生成式AI和大模型技术爆发式增长,让很多岗位重新成了炙手可热的新星,岗位薪资远超很多后端岗位,在程序员中稳居前列。

与此同时AI与各行各业深度融合,飞速发展,成为炙手可热的新风口,企业非常需要了解AI、懂AI、会用AI的员工,纷纷开出高薪招聘AI大模型相关岗位。

最近很多程序员朋友都已经学习或者准备学习 AI 大模型,后台也经常会有小伙伴咨询学习路线和学习资料,我特别拜托北京清华大学学士和美国加州理工学院博士学位的鲁为民老师给大家这里给大家准备了一份涵盖了AI大模型入门学习思维导图、精品AI大模型学习书籍手册、视频教程、实战学习等录播视频 全系列的学习资料,这些学习资料不仅深入浅出,而且非常实用,让大家系统而高效地掌握AI大模型的各个知识点。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

AI大模型系统学习路线

在面对AI大模型开发领域的复杂与深入,精准学习显得尤为重要。一份系统的技术路线图,不仅能够帮助开发者清晰地了解从入门到精通所需掌握的知识点,还能提供一条高效、有序的学习路径。

但知道是一回事,做又是另一回事,初学者最常遇到的问题主要是理论知识缺乏、资源和工具的限制、模型理解和调试的复杂性,在这基础上,找到高质量的学习资源,不浪费时间、不走弯路,又是重中之重。

AI大模型入门到实战的视频教程+项目包

看视频学习是一种高效、直观、灵活且富有吸引力的学习方式,可以更直观地展示过程,能有效提升学习兴趣和理解力,是现在获取知识的重要途径

光学理论是没用的,要学会跟着一起敲,要动手实操,才能将自己的所学运用到实际当中去,这时候可以搞点实战案例来学习。

海量AI大模型必读的经典书籍(PDF)

阅读AI大模型经典书籍可以帮助读者提高技术水平,开拓视野,掌握核心技术,提高解决问题的能力,同时也可以借鉴他人的经验。对于想要深入学习AI大模型开发的读者来说,阅读经典书籍是非常有必要的。

600+AI大模型报告(实时更新)

这套包含640份报告的合集,涵盖了AI大模型的理论研究、技术实现、行业应用等多个方面。无论您是科研人员、工程师,还是对AI大模型感兴趣的爱好者,这套报告合集都将为您提供宝贵的信息和启示。

AI大模型面试真题+答案解析

我们学习AI大模型必然是想找到高薪的工作,下面这些面试题都是总结当前最新、最热、最高频的面试题,并且每道题都有详细的答案,面试前刷完这套面试题资料,小小offer,不在话下

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献276条内容

已为社区贡献276条内容

所有评论(0)