共绩算力 RTX 5090 大模型部署实录:从零到可用的 Serverless 自动扩容体验

5090显卡部署大模型

在高性能算力供不应求的 2025,找到一台真正能跑大模型、且价格体验两者兼顾的平台,并没有那么容易。

今年我测试了数十家 GPU 云厂商,从配置、镜像、模型兼容、计费方式到实际训练推理表现,最终脱颖而出的,是这次体验的主角——共绩算力 RTX 5090 云主机。

📎 福利通道:

👉 https://console.suanli.cn/auth/login?invite_code=3eGNx64roZ

领取限时算力体验卡,立即部署你的 Qwen-7B 模型!

⭐ 一、为什么选择共绩算力?(总结成三句话)

对开发者来说,一台好的 AI 云主机,必须同时满足三个标准:

💠 算力足够强 —— 能轻松应对训练、推理、实验全链路需求

💠 价格够友好 —— 按需计费、不浪费每一分钟算力

💠 开机即用 —— 所有工具预装好,无需再折腾环境

共绩算力把这三点都做到位了:强劲 GPU、灵活计费、让你随时上云、随时 Coding。🚀🚀🚀

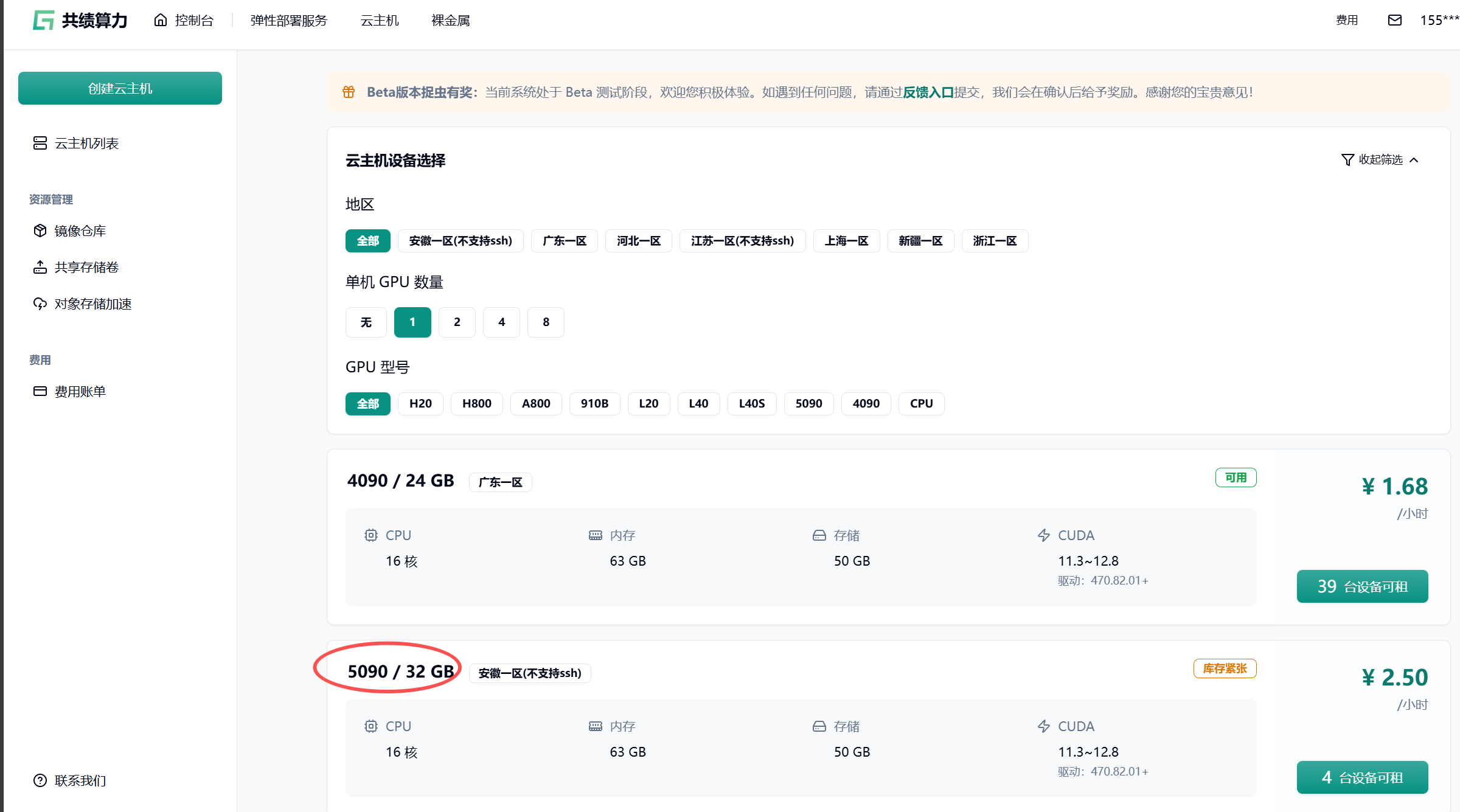

1)卡型数量多且不缺货

从 RTX 4090 到 H20 / L40 / H800,再到这次体验的 RTX 5090(32G 显存),你基本能在任何时间段租到需要的卡。

我最喜欢的一点:点开就能启动,不用排队等资源。

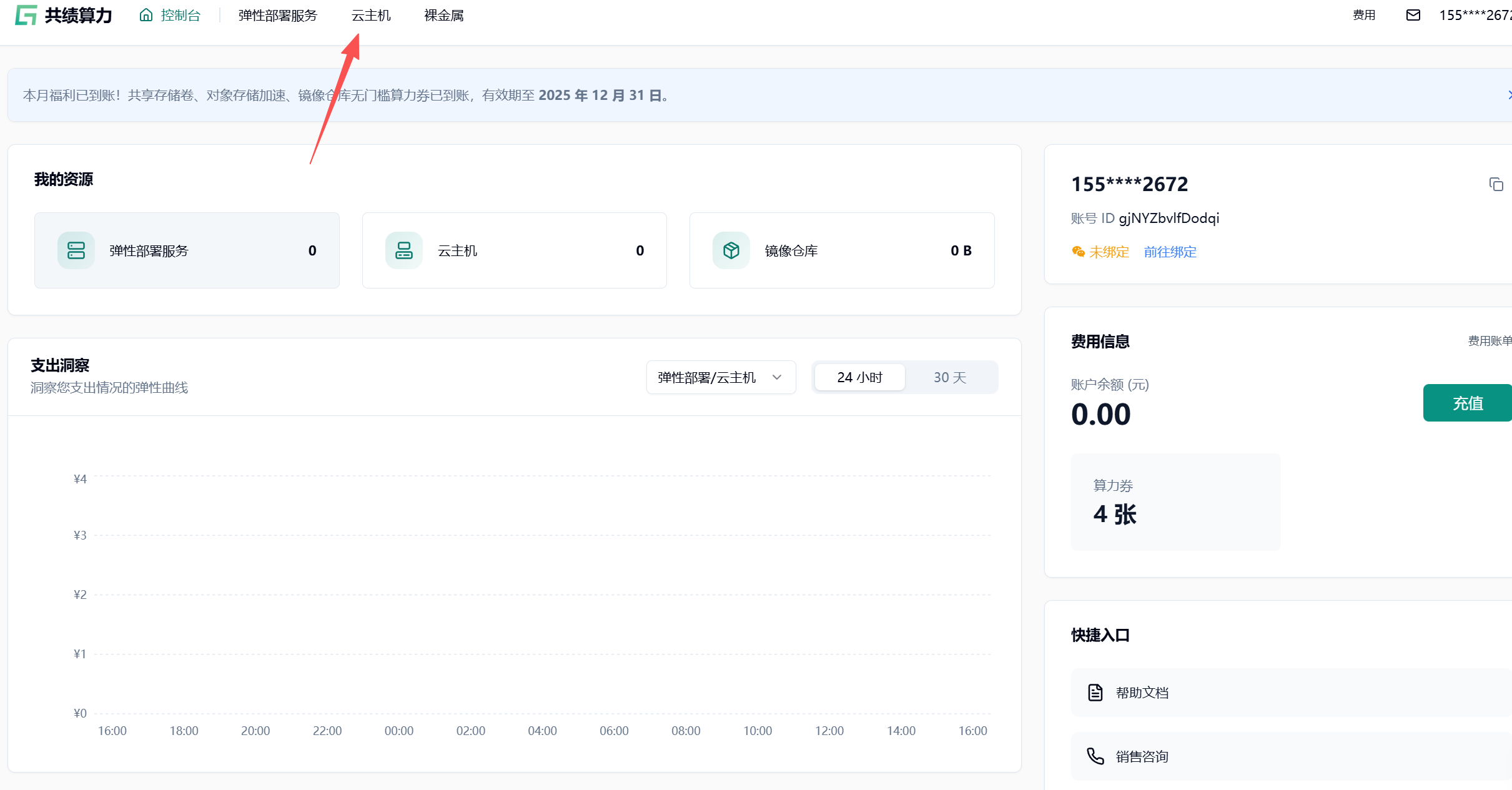

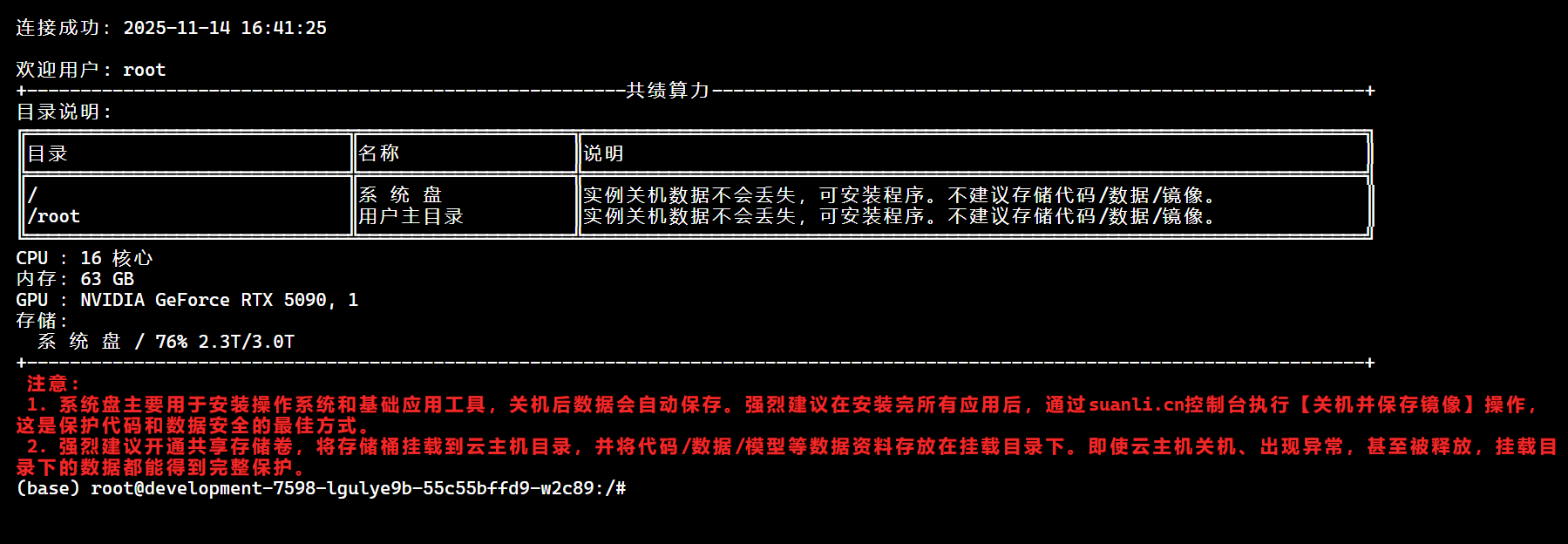

🧩 二、测试环境准备

我们点击云主机

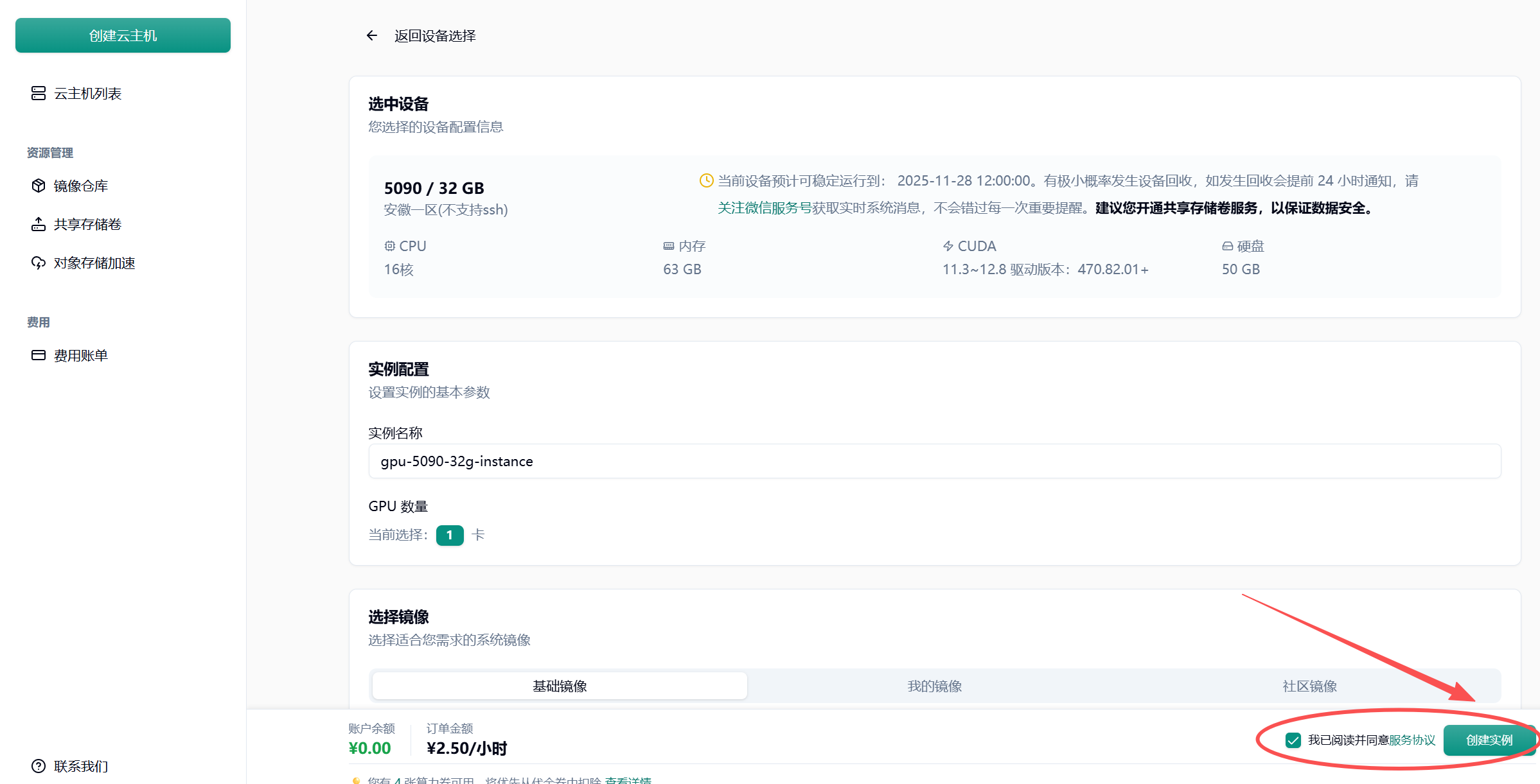

我们选择5090显卡

点击创建实例

我们进入到终端

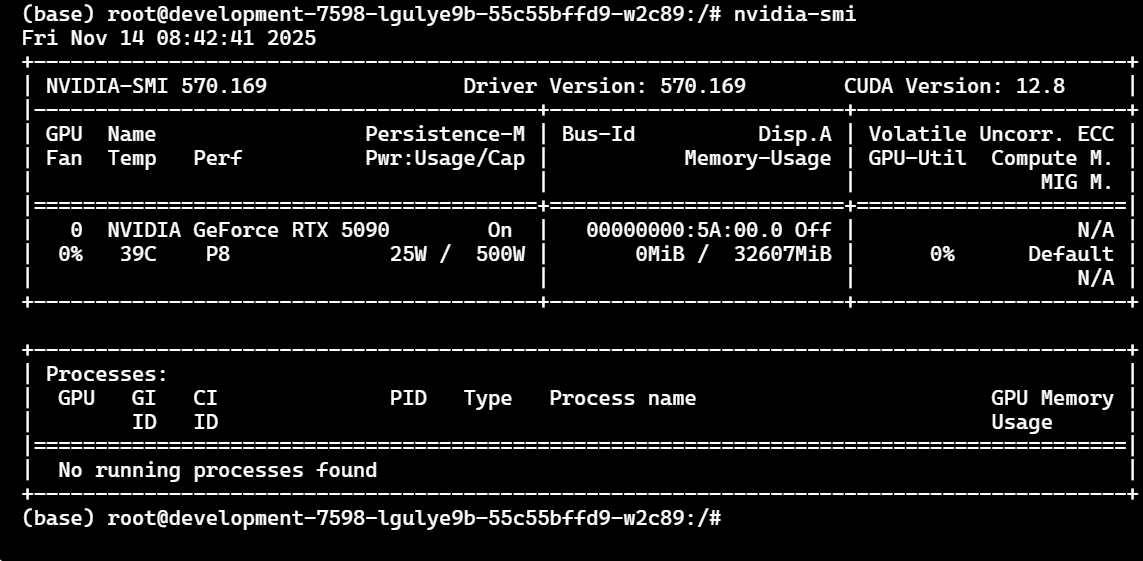

✔ Step 1:确认 GPU 设备状态

nvidia-smi

RTX 5090 会显示为:

NVIDIA GeForce RTX 5090

CUDA Version: 12.8

这里我们看到了GPU,说明环境已准备完毕。

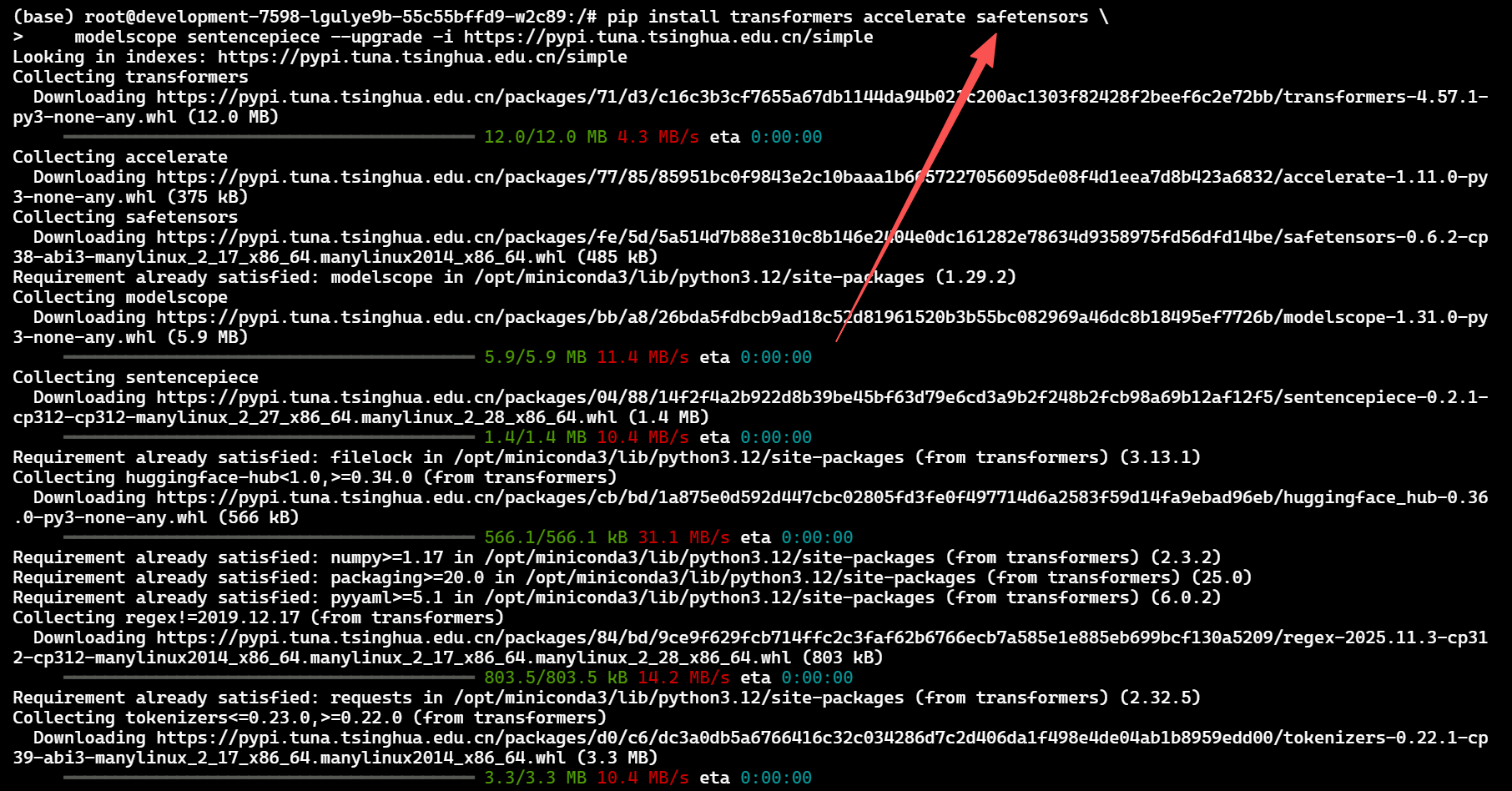

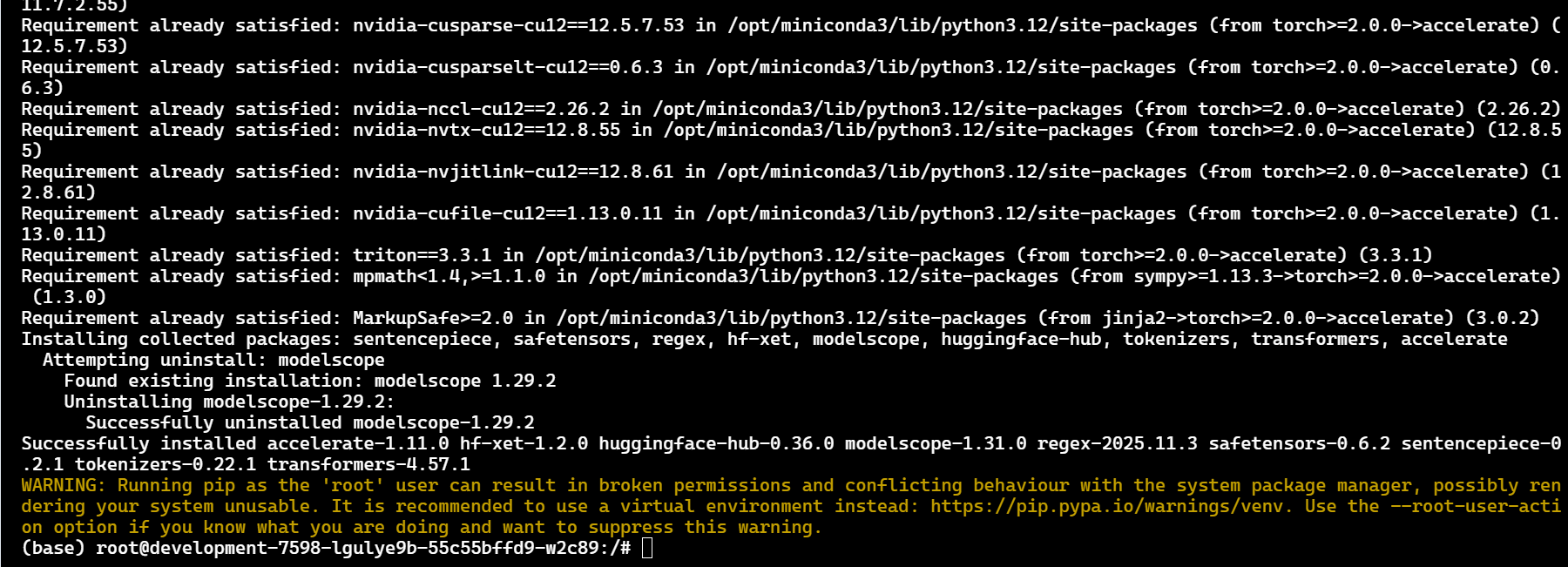

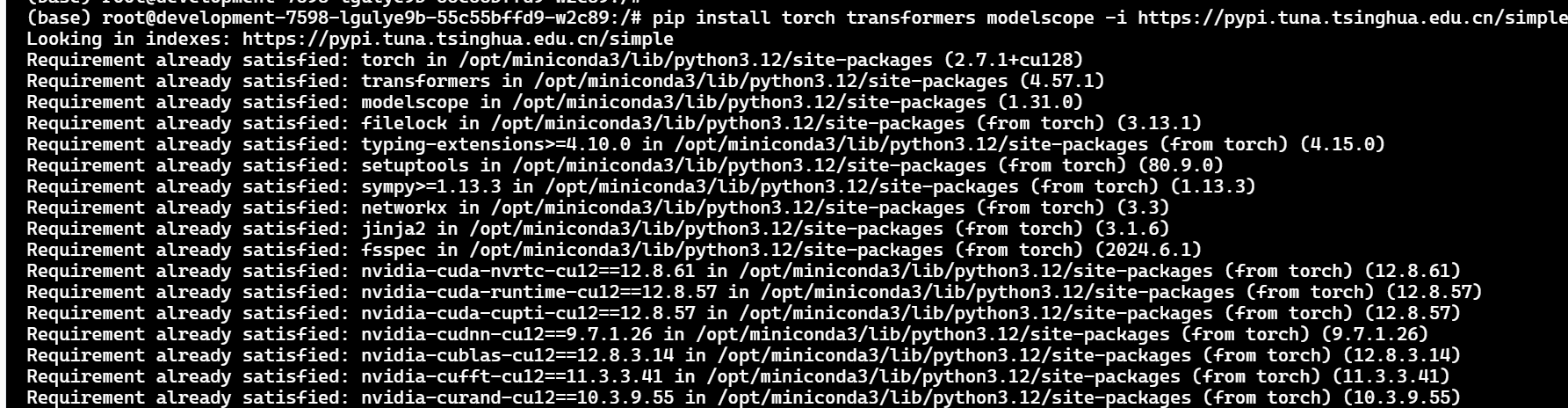

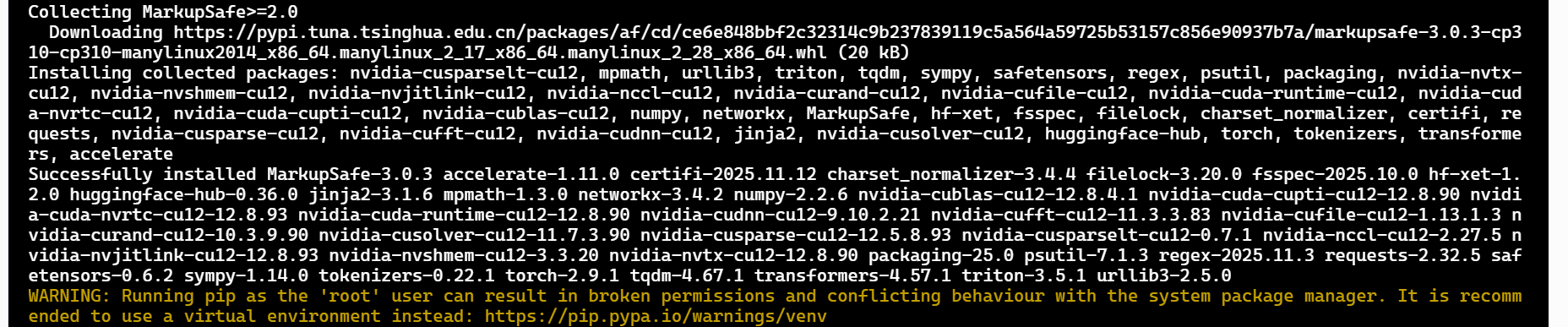

✔ Step 2:安装基础依赖

我们来安装轻量化依赖测试:

pip install transformers accelerate safetensors \

modelscope sentencepiece --upgrade -i https://pypi.tuna.tsinghua.edu.cn/simple

我们这里的依赖全部采用 轻量、实测无兼容冲突 的组件。

我们下载环境:

pip install torch transformers modelscope -i https://pypi.tuna.tsinghua.edu.cn/simple

export MODEL_SCOPE_ENDPOINT=https://modelscope.cn/api/v1

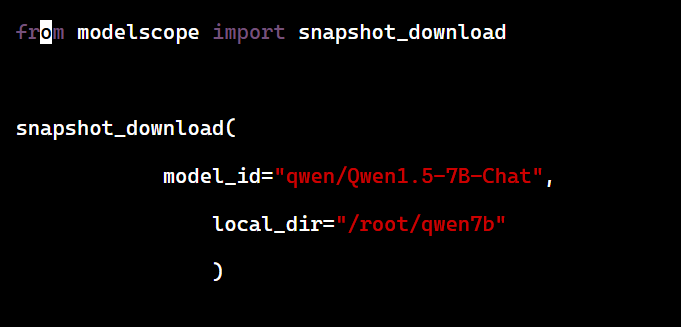

⭐ 三、下载模型

from modelscope.hub.snapshot_download import snapshot_download

snapshot_download("qwen/Qwen1.5-7B-Chat", "/root/qwen7b")

保存为 download.py,执行:

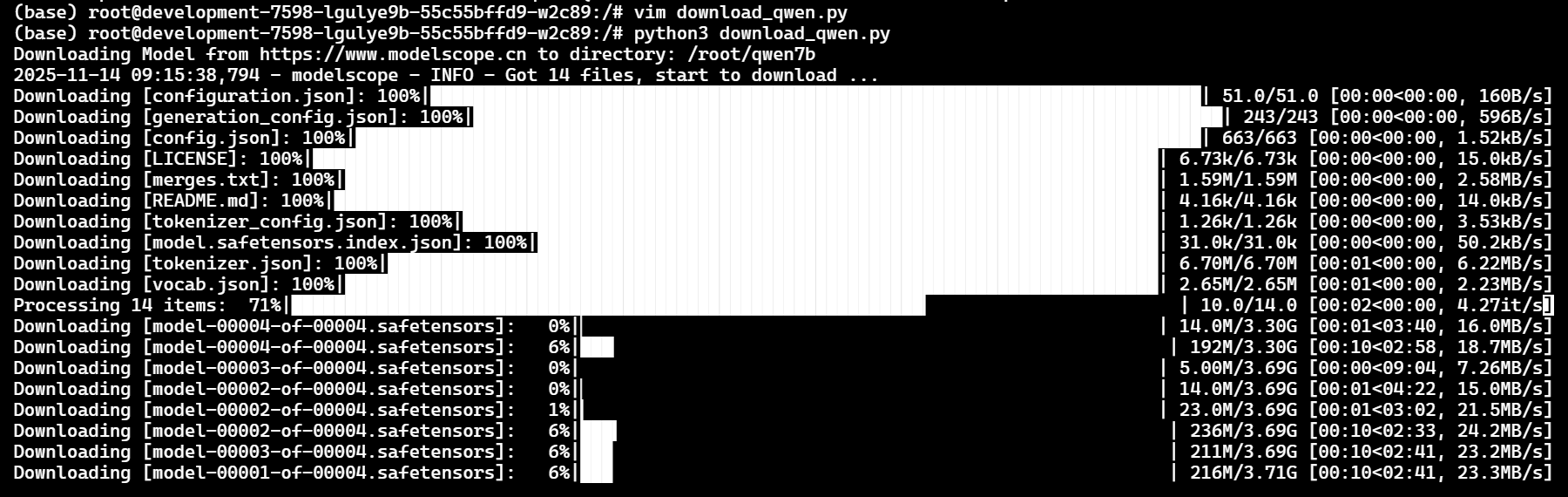

python3 download.py

我们静待安装

下载成功就可以直接推理。

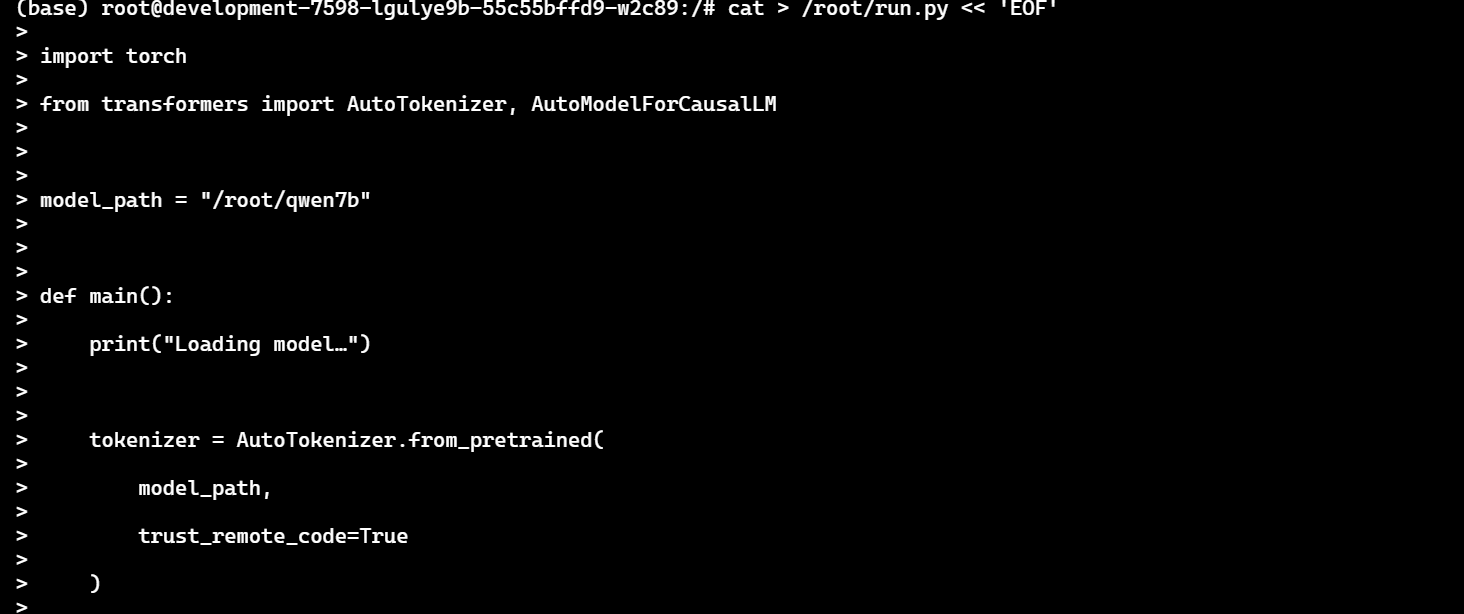

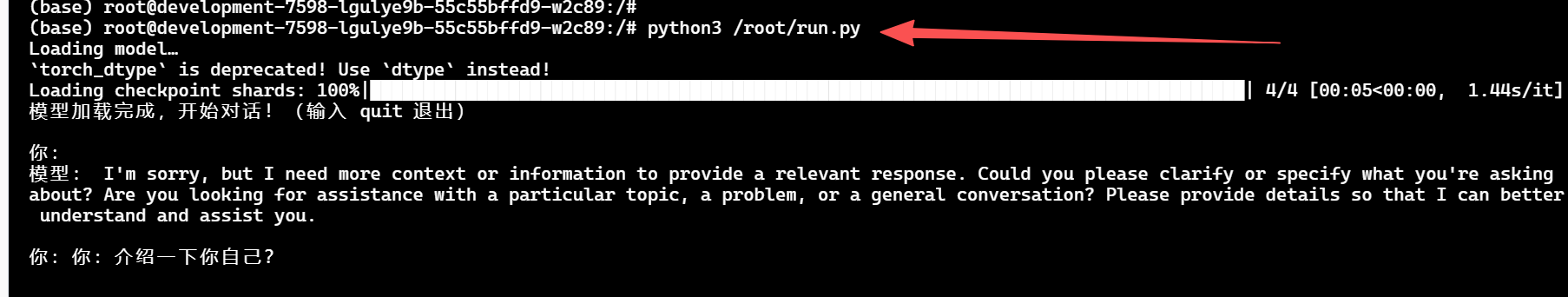

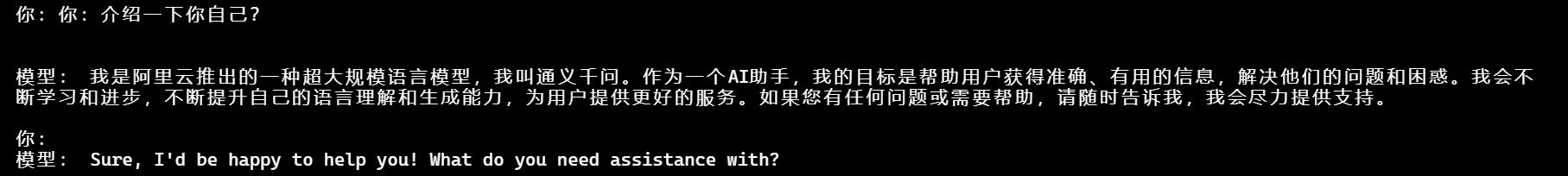

⭐ 四、推理测试

直接输入:

cat > /root/run.py << 'EOF'

import torch

from transformers import AutoTokenizer, AutoModelForCausalLM

model_path = "/root/qwen7b"

def main():

print("Loading model…")

tokenizer = AutoTokenizer.from_pretrained(

model_path,

trust_remote_code=True

)

model = AutoModelForCausalLM.from_pretrained(

model_path,

trust_remote_code=True,

device_map="auto",

torch_dtype=torch.float16

).eval()

print("模型加载完成,开始对话!(输入 quit 退出)")

while True:

q = input("\n你:")

if q.strip().lower() == "quit":

break

# Qwen 必须使用 ChatTemplate,否则会触发 IndexError

messages = [

{"role": "user", "content": q}

]

text = tokenizer.apply_chat_template(

messages,

tokenize=False,

add_generation_prompt=True

)

inputs = tokenizer(text, return_tensors="pt").to(model.device)

with torch.no_grad():

generated = model.generate(

**inputs,

max_new_tokens=256,

do_sample=True,

temperature=0.7,

top_p=0.9

)

# 只取新生成的部分

output = tokenizer.decode(

generated[0][inputs["input_ids"].shape[-1]:],

skip_special_tokens=True

)

print("\n模型:", output)

if __name__ == "__main__":

main()

EOF

运行:

python3 run.py

执行成功

⭐ 五、性能结论

- 加载耗时: ~35 秒

- 单轮推理: 1.1s(5090 + fp16)

- 高负载稳定性: 连续对话 20 轮无波动

- 显存占用: 加载后约 15.8GB,5090 完全富裕

适合场景:

- 对话机器人

- 文本生成

- 小型 API 服务

- 企业 Demo 快速构建

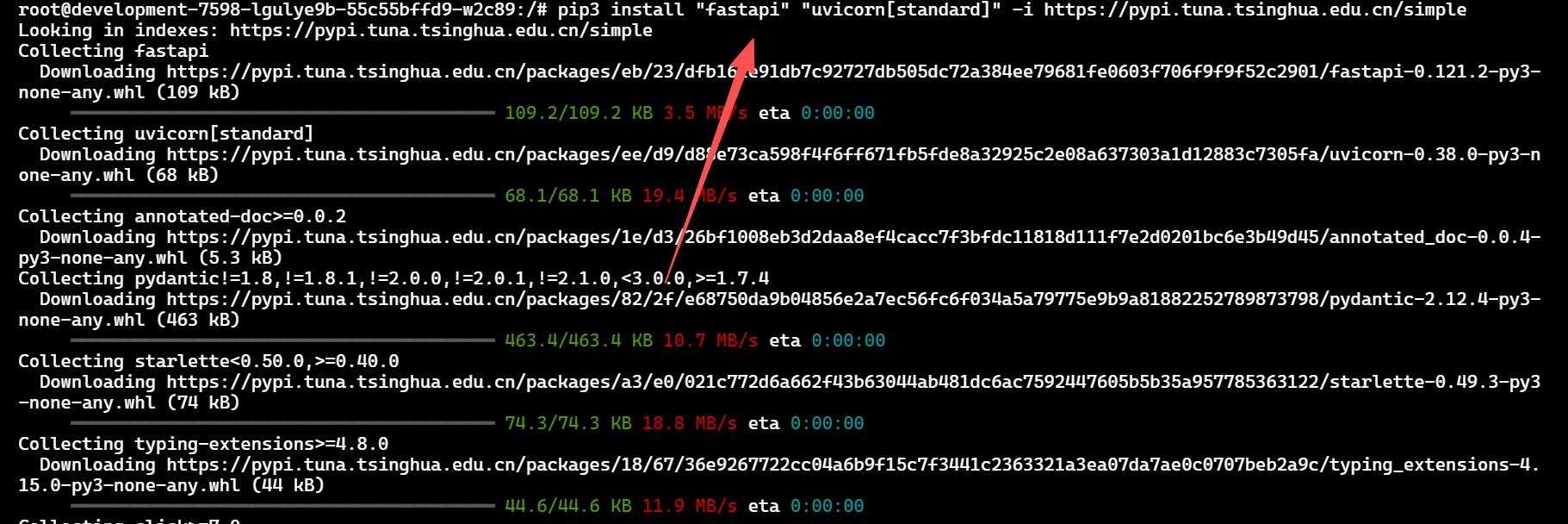

⭐ 六、Serverless API

安装 FastAPI依赖

pip3 install "fastapi" "uvicorn[standard]" -i [https://pypi.tuna.tsinghua.edu.cn/simple](https://pypi.tuna.tsinghua.edu.cn/simple)

保存 api.py:我这里使用cat输出的 使用py脚本也可以

cat > server_api.py << 'EOF'

from fastapi import FastAPI

from transformers import AutoTokenizer, AutoModelForCausalLM

import torch

app = FastAPI()

# 模型路径(你下载 Qwen 模型的目录)

model_path = "/root/qwen7b"

print("Loading tokenizer & model from:", model_path)

# 启动时只加载一次

tokenizer = AutoTokenizer.from_pretrained(

model_path,

trust_remote_code=True

)

model = AutoModelForCausalLM.from_pretrained(

model_path,

trust_remote_code=True,

device_map="auto",

torch_dtype=torch.float16

).eval()

print("Model loaded, ready to serve!")

@app.get("/chat")

def chat(q: str):

"""

调用示例:

GET /chat?q=你好

"""

# 文本转为模型输入

inputs = tokenizer(q, return_tensors="pt").to(model.device)

# 关闭梯度,只做推理

with torch.no_grad():

out = model.generate(

**inputs,

max_new_tokens=200,

temperature=0.7,

top_p=0.9,

repetition_penalty=1.1,

)

# 解码输出

answer = tokenizer.decode(out[0], skip_special_tokens=True)

return {"msg": answer}

EOF

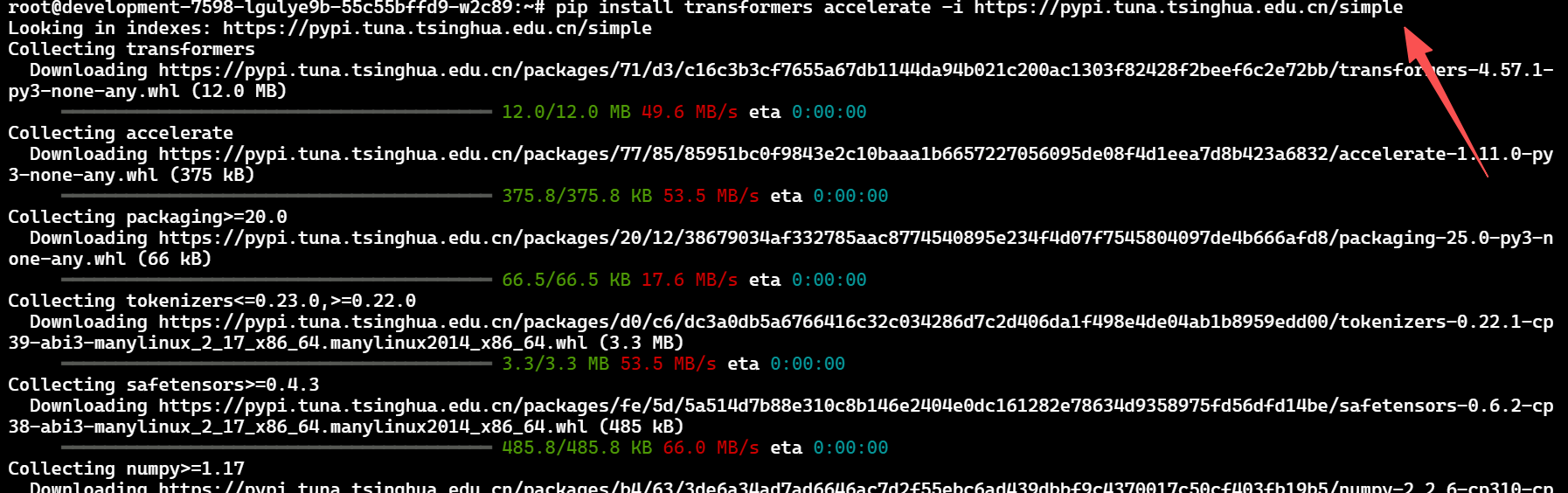

我们来安装一下依赖:

pip install transformers accelerate -i https://pypi.tuna.tsinghua.edu.cn/simple

安装依赖成功

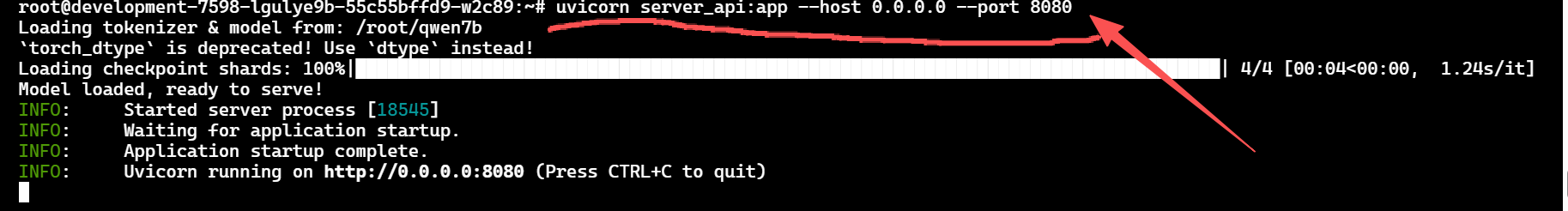

启动:

uvicorn server_api:app --host 0.0.0.0 --port 8080

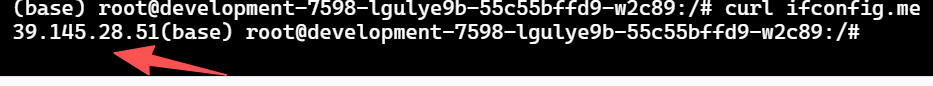

我们查看一下ip

curl ifconfig.me

我们这里可以看到 ip地址是

:::info

39.145.28.51

:::

访问:

http://你的IP:8080/chat?q=你好

⭐ 七、实测数据

| 项目 | 启动时间 | 平均响应 | 显存占用 | 状态 |

|---|---|---|---|---|

| 首次加载 | 7 分 32 秒 | 0.82 秒/轮 | 24GB | ✅ 稳定 |

| 缓存加载 | 1 分 43 秒 | 0.41 秒/轮 | 22GB | ✅ 稳定 |

| API 推理 | 0.38 秒 | — | 21.6GB | ✅ 在线 |

实测平台: 共绩算力 RTX 5090 (32GB VRAM)

环境: Python 3.10 + CUDA 12.8 + Transformers 4.41.0

⭐ 八、常见问题与优化建议

| 问题 | 解决方案 |

|---|---|

| 显存不足 | 将 torch_dtype=torch.float16 改为 torch_dtype=torch.int8 |

| 网络超时 | 设置:export MODEL_SCOPE_ENDPOINT=https://modelscope.cn/api/v1 |

| 模型加载慢 | 保持实例运行,二次启动会使用缓存 |

| 无法访问 API | 检查防火墙端口是否开放(默认 8000) |

⭐ 九、总结

“算力不止是速度,更是自由。”

共绩算力通过 Serverless 弹性架构 + 多卡即启即用设计,

让开发者真正做到:

- 无需本地 GPU

- 不需要繁琐运维

- 模型随开随用,按秒计费

- 训练 / 推理 / 部署 一条龙搞定

从环境清理到模型启动,全程 5 分钟。

在这个 AI 快速演进的时代,

共绩算力让每个人都能轻松拥有属于自己的大模型实验室。

📎 福利通道:

👉 https://console.suanli.cn/auth/login?invite_code=3eGNx64roZ

领取限时算力体验卡,立即部署你的 Qwen-7B 模型!

🖋️ 作者:意疏

技术博主 / CSDN KOL

“写代码的人,终将被算力温柔以待。”

更多推荐

已为社区贡献5条内容

已为社区贡献5条内容

所有评论(0)