高难度基准测试表现超GPT5!MiroThinker深度研究模型,单次任务多达600次工具调用

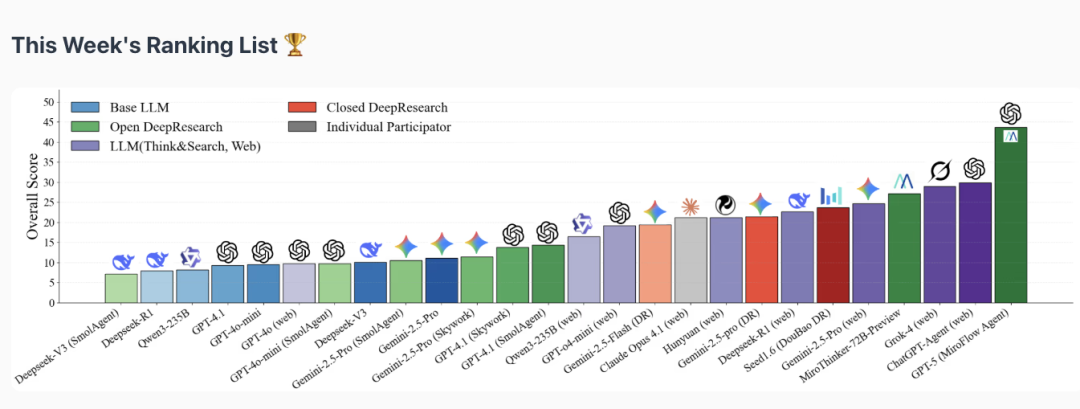

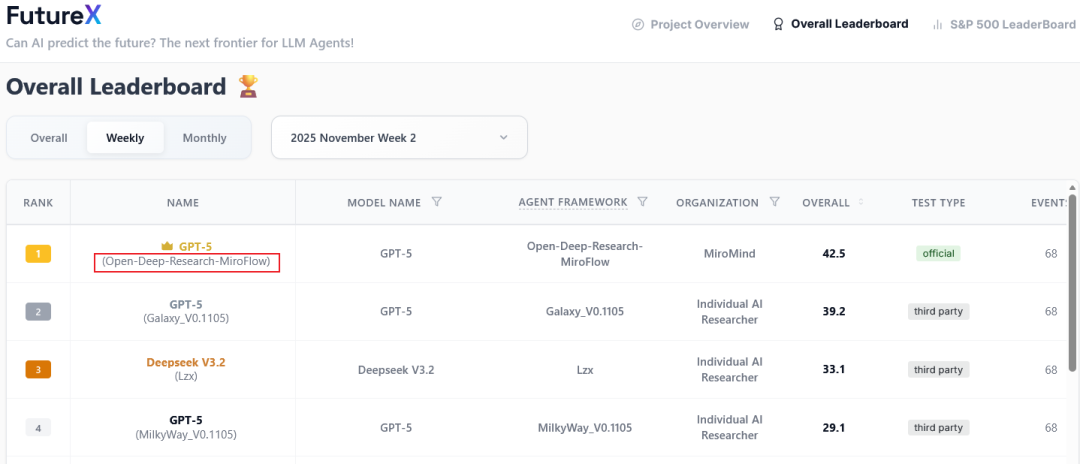

还记得今年9月,陈天桥的MiroMind AI,发布了登顶未来预测基准的深度研究框架。时至今日,仍然稳居榜首。刚刚,MiroMind AI发布了深度研究模型MiroThinker-v1.0,基于Qwen3和Qwen2.5训练。在部分高难度基准测试中,其表现已经超越了GPT-5这样的顶级专有模型。

还记得今年9月,陈天桥的MiroMind AI,发布了登顶未来预测基准FutureX benchmark的深度研究框架MiroFlow。

时至今日,仍然稳居榜首。

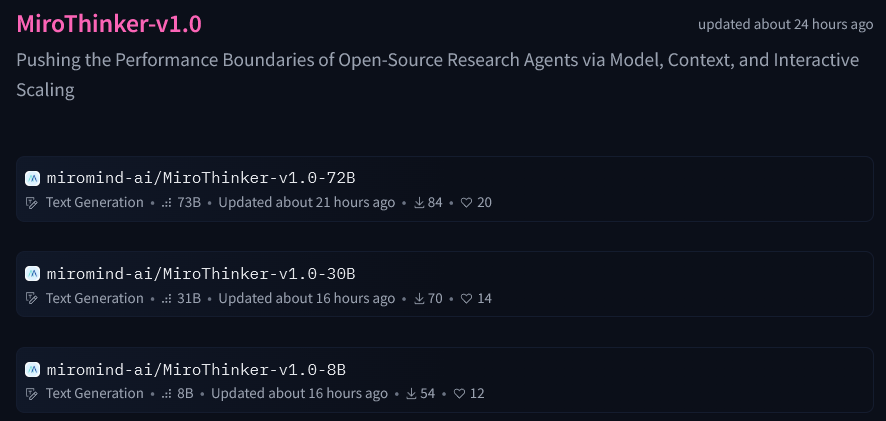

刚刚,MiroMind AI发布了深度研究模型MiroThinker-v1.0,基于Qwen3和Qwen2.5训练。

在部分高难度基准测试中,其表现已经超越了GPT-5这样的顶级专有模型。

智能的第三维度是交互

传统的大语言模型在面对复杂任务时,往往采用一种测试时扩展的策略,例如增加更多的推理步骤,让模型想得更久一点。

这种方式像是让一个学生在封闭的考场里独自埋头演算。他可以花更多时间,用更多的草稿纸,但如果他的解题思路从一开始就错了,或者某个中间步骤计算失误,那么更长的推理链反而可能导致错误被放大,离正确答案越来越远。

整个过程是孤立的,缺乏外部的校正机制。

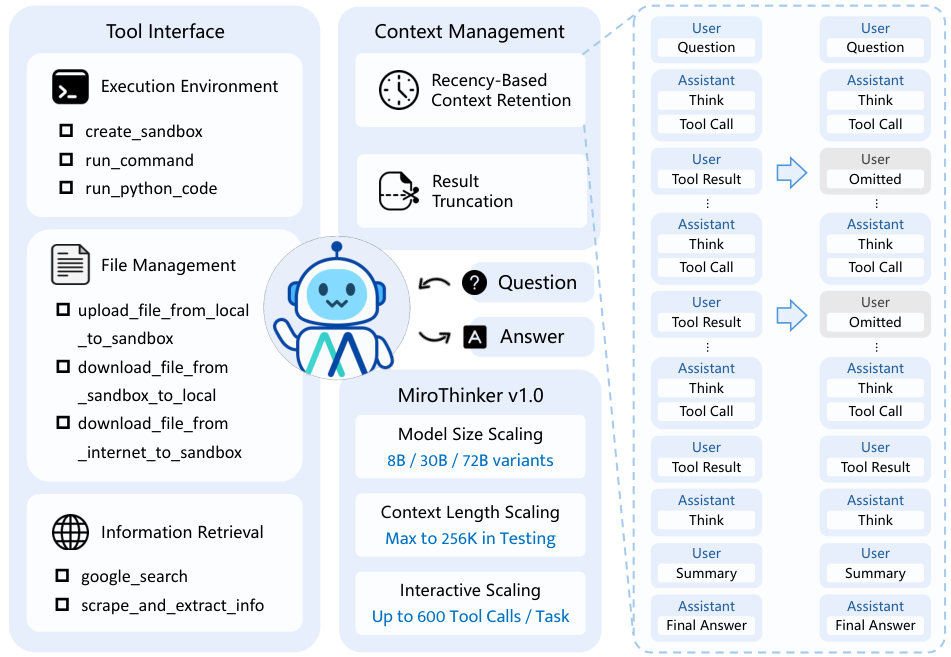

MiroThinker提出并实践了一种截然不同的路径:交互扩展。

它不再让模型孤立地思考,而是让它与外部环境进行高频次的深度互动。

它可以通过工具获取信息,从环境的反馈中学习,从而动态地纠正自己的错误,并实时优化后续的推理路径。

这个过程更像是一个科学家在实验室里做研究。他提出一个假设(思考),然后设计并执行一个实验来验证它(工具调用)。实验结果可能成功,也可能失败(环境反馈)。无论结果如何,这个反馈都是宝贵的信息,能帮助他修正最初的假设,并设计下一步的实验。

通过强化学习(RL)的训练,MiroThinker将这种交互扩展的能力推向了极致。

在一个高达256K的上下文窗口中,它平均每项任务可以执行多达600次的工具调用。

这意味着它不再是一次性的问答机器,而是一个能够持续进行多轮推理、处理复杂研究工作流的不知疲倦的研究员。

它在漫长的探索链条中,不断地发问、求证、反思、再发问,展现出惊人的韧性和深度。

这种通过系统性训练,让模型去处理更深层次、更频繁的智能体与环境交互的能力,正是MiroThinker所定义的性能提升的第三个维度。

它超越了模型规模和上下文长度的线性堆叠,为AI智能的成长开辟了新的空间。

一个会动手的AI是如何构建的

要让一个AI模型真正具备研究能力,就需要赋予它思考的逻辑和行动的工具。MiroThinker v1.0的实现,正是围绕这两个核心展开的。

它的底层逻辑基于一个名为ReAct的范式。

ReAct是Reasoning and Acting(推理与行动)的缩写,它是一种模仿人类解决问题思路的框架。当接收到一个查询指令后,模型并不会立刻给出答案,而是在思考、工具调用和观察这三种状态之间循环往复,直到任务完成。

在每一步,智能体都会维护一个轨迹历史,记录下之前所有的思考、行动和观察。这个轨迹历史就像是它的工作笔记,帮助它理清思路,避免重复劳动,并为下一步的决策提供依据。

有了思考的逻辑,还需要行动的双手,这就是MiroThinker配备的模块化工具接口。这个接口向模型开放了一系列强大的外部工具。

它的第一个工具是一个执行环境,具体来说是一个Linux沙箱。

沙箱是一个隔离的、安全的运行时环境。

智能体可以在里面执行shell命令或者Python代码,与一个真实的操作系统级资源进行交互。

这相当于给了AI一个小型计算机实验室。它可以在里面分析数据、运行模拟、处理文件,完成任何纯文本模型无法想象的操作。

第二个工具是文件管理系统。

它实现了文件的上传和下载功能,让数据可以在沙箱这个内部世界与外部世界之间自由流动。

例如,AI可以下载一个网页上的数据表格,在沙箱里用Python脚本进行分析和可视化,然后将生成的图表文件输出。

第三个工具是信息检索套件。

这里面包含了两种工具。一种是基于谷歌的网页搜索工具,用于快速获取广泛的信息。另一种是网页抓取工具,它能根据一个给定的网址,像浏览器一样访问并提取其中结构化的、精确的信息内容。

拥有了强大的工具,也带来了新的挑战:如何管理有限的注意力。

模型的上下文窗口虽然高达256K,但并非无限。

在ReAct范式下,如果将每一次工具调用的输出结果全部保留在历史记录中,上下文窗口会很快被填满,导致模型遗忘掉任务早期的重要信息。

为了解决这个问题,MiroThinker采用了两种聪明的上下文管理策略。

一种策略叫基于近期性的上下文保留。

它不会保留所有工具的输出,而只保留最近几次的工具响应。与此同时,它会完整地保留所有的思考和行动序列。

这就像一个人在做笔记时,会详细记录自己的思路和每一步的操作,但对于查到的中间资料,可能只会记下最新的或者最重要的那一部分。这极大地提高了上下文窗口的使用效率。

另一种策略叫结果截断。

有些工具,比如运行一段复杂的代码,可能会产生非常长的输出日志或错误信息。这些过长的输出很容易撑爆上下文窗口。

MiroThinker的策略是,当工具响应超过一个预设的长度限制时,会自动将其截断,并在末尾附上一个[结果截断]的标签。

这个标签既节省了空间,又明确地告知模型,这里的信息是不完整的,从而避免模型基于被截断的信息做出错误的判断。

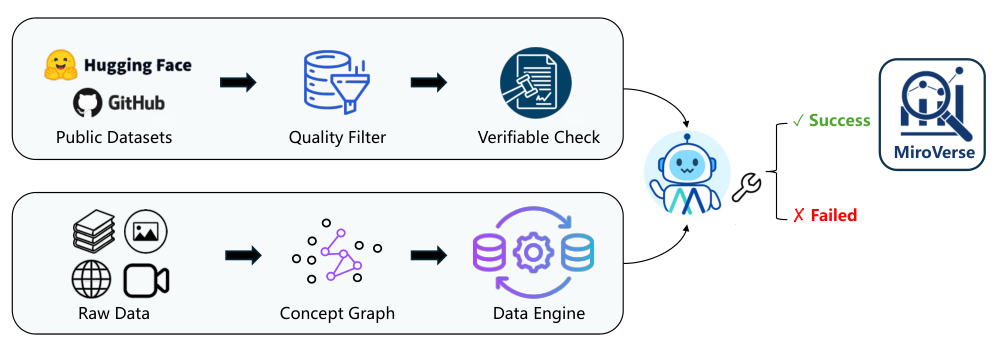

如何为AI研究员编写一套教科书

要训练出MiroThinker这样强大的AI研究员,不能仅仅依靠互联网上现成的语料。因为互联网上更多的是知识的陈述,而缺少解决问题的过程。

你需要一套特殊的教科书,这套教科书里充满了复杂的、需要多步骤推理和工具使用才能解决的问题,以及由专家示范的完整解题轨迹。

由于现实世界中不存在这样大规模、高质量的现成教材,MiroThinker的团队设计并构建了一个庞大的合成数据集。这个数据集的构建过程分为两个核心部分。

第一部分是多文档问答(MultiDocQA)的合成。

它的目标是,将互联网上互相关联的网页文档,自动地转换为复杂的、需要跨文档推理才能解答的问答对。这个过程本身就像一个精密的生产管道:

-

首先,构建一个庞大的文档语料库,作为知识的源头。

-

然后,通过算法在语料库中采样,并构建一张文档图。图中的每个节点是一个文档,节点之间的连线代表它们在内容上的关联。

-

接着,程序会沿着图的路径整合多个文档的信息,从中提取出独立的事实片段。

-

为了增加问题的难度,管道还会故意进行约束混淆,比如将不同事实中的实体或条件进行组合,制造迷惑性。

-

最后,基于这些整合、提取、混淆过的事实,逆向生成一个自然语言问题。这个问题的答案无法在任何单一文档中找到,必须通过理解和串联多个文档的信息才能得出。

通过这种方式,团队为MiroThinker创造了海量的、高质量的应用题。

第二部分是智能体轨迹的合成。

有了题目,还需要解题范例。为此,团队设计了一个多层合成框架,它像一个导演团队,指挥多个行业领先的大语言模型,使用不同的方法和工具,去解决这些复杂的应用题,并记录下它们每一步的思考和行动。

这个框架融合了多种范式。

在智能体范式上,它既采用了ReAct这样的单智能体模式,也采用了一种名为MiroFlow的多智能体协作模式,让不同的AI角色分工合作,共同完成任务。

在工具调用方法上,它既使用了传统的函数调用(Function Calling),也采用了一种名为模型上下文协议(MCP)的新方法。

在扮演专家的模型选择上,它使用了包括GPT-OSS、DeepSeek-V3.1在内的多种多样化的顶级大语言模型。

通过这种多范式、多方法、多模型的组合,框架生成了数量庞大、风格多样、质量极高的智能体轨迹数据。这些数据就是MiroThinker最宝贵的教科书和错题集。

拥有了独家教材后,MiroThinker的训练过程被设计成一个循序渐进、环环相扣的三阶段管道。它基于开源社区广受好评的Qwen2.5和Qwen3模型作为底座。

第一阶段是监督微调(SFT)。

这个阶段的目标是让MiroThinker掌握作为一名智能体的基本行为规范。模型会学习模仿数据集中那些专家的轨迹,理解何时应该思考,何时应该调用何种工具,以及如何解读工具返回的结果。

这个过程就像是让一个新入门的学生,通过背诵和模仿例题来掌握基础的公式和解题步骤。为了确保教材的质量,团队还对合成轨迹中的噪声进行了严格的过滤和数据修复。

第二阶段是偏好优化(DPO)。

掌握了基本功之后,模型需要学会做出更优的决策。直接偏好优化(DPO)就是为了这个目的。在这个阶段,训练数据不再是单一的正确答案,而是一个个偏好对。

每个偏好对都包含一个任务指令,以及与之对应的两条解决轨迹:一条是首选的,一条是非首选的。评判的标准可能是最终答案的正确性,也可能是解题过程的效率和逻辑性。

通过学习大量的偏好对,模型逐渐内化了一种品味,能够在多个可能的行动路径中,选择出更优的那一个。这就像是学生在掌握了基础解法后,开始学习哪些解法更巧妙,更高效。

第三阶段是强化学习(RL)。

这是MiroThinker训练管道的点睛之笔,也是它实现交互扩展的关键。

在前两个阶段,模型主要是在学习历史,模仿和理解固定的数据。而在强化学习阶段,它被推向了一个真实世界,需要通过直接与环境的互动和探索来学习。

团队为此构建了一套可扩展的模拟环境,这个环境支持实时的多源搜索、网页抓取与总结、Python代码执行和Linux虚拟机操作。

模型在这个环境中被赋予任务,然后自由地去尝试。它的每一步行动都会得到环境的反馈,而最终的结果会得到一个奖励或惩罚。

为了高效地进行训练,MiroThinker采用了一种名为组相对策略优化(GRPO)的先进在线策略训练算法。

通过不断的试错和探索,智能体能够发现那些在静态数据集中从未出现过的、更具创造性的解决方案。它学会了如何应对预料之外的工具返回错误,学会了如何在信息不足时进行补充探索,也学会了如何规划更长、更复杂的行动链条。

正是这个阶段的训练,让MiroThinker真正从一个模仿者蜕变为一个探索者,使其能够在与环境的深度交互中不断进化,最终展现出超凡的研究能力。

性能的飞跃来自交互的深度

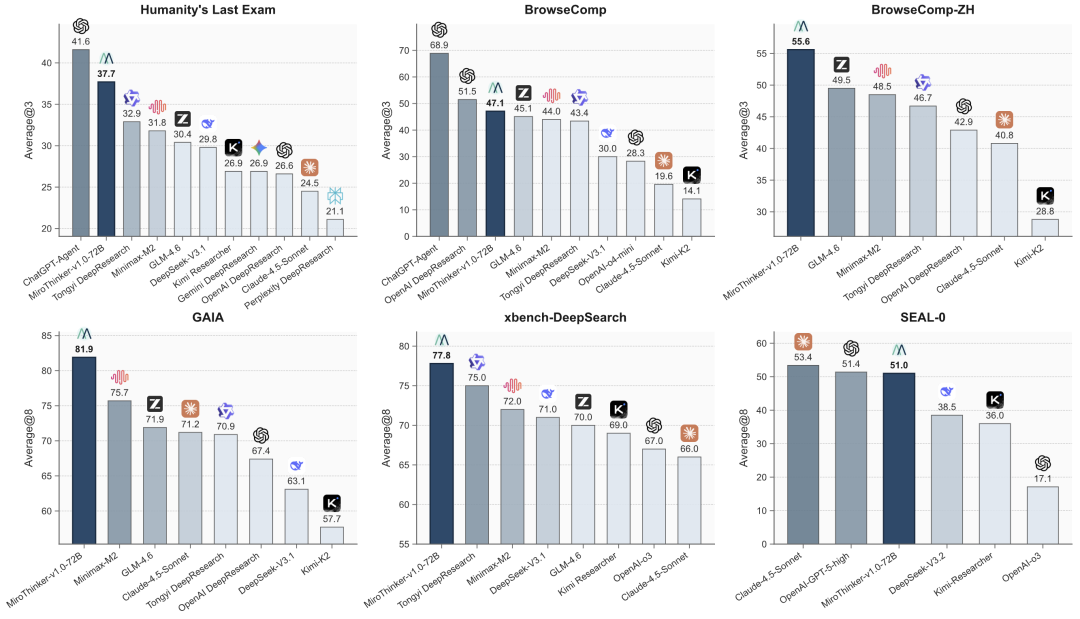

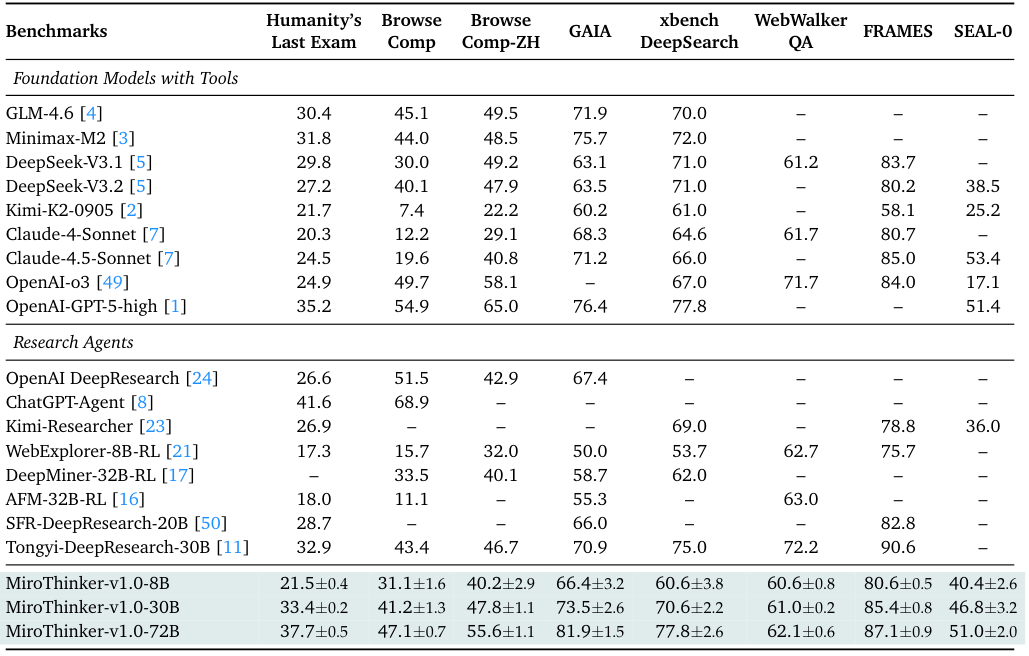

为了检验MiroThinker v1.0的真实能力,研究人员在一系列业界公认的、多样化的智能体基准测试上对其进行了严格的评估。

这些基准测试包括:

-

Humanity’s Last Exam (HLE):一个极具挑战性的测试集,要求模型具备跨学科的深度推理能力。

-

BrowseComp 和 BrowseComp-ZH:分别用于评估在英文和中文环境下,模型利用网页浏览解决复杂问题的能力。

-

GAIA:一个旨在模拟现实世界复杂研究任务的通用AI能力评估基准。

-

xBench-DeepSearch:一个侧重于深度信息检索和整合能力的中文基准。

-

WebWalkerQA、FRAMES 和 SEAL-0 等。

在极具挑战性的Humanity’s Last Exam(HLE)测试上,MiroThinker取得了37.7%的成绩,这个数字超越了专有模型GPT-5-high的35.2%,高出了2.5个百分点。

在被认为是通用研究能力试金石的GAIA基准测试上,MiroThinker取得了81.9%的惊人成绩,将之前的开源领先模型MiniMax-M2(75.7%)甩开了6.2个百分点。

在考验网页浏览和信息整合能力的BrowseComp和SEAL-0测试上,MiroThinker分别取得了47.1%和51.0%的成绩,其性能已经与OpenAI DeepResearch和Anthropic Claude 4.5等顶尖的专有研究系统不相上下。

更令人印象深刻的是它在中文基准测试上的表现。MiroThinker在BrowseComp-ZH和xbench-DeepSearch上分别取得了55.6%和77.8%的成绩,双双创造了新的开源记录,展示了其卓越的多语言研究潜力。

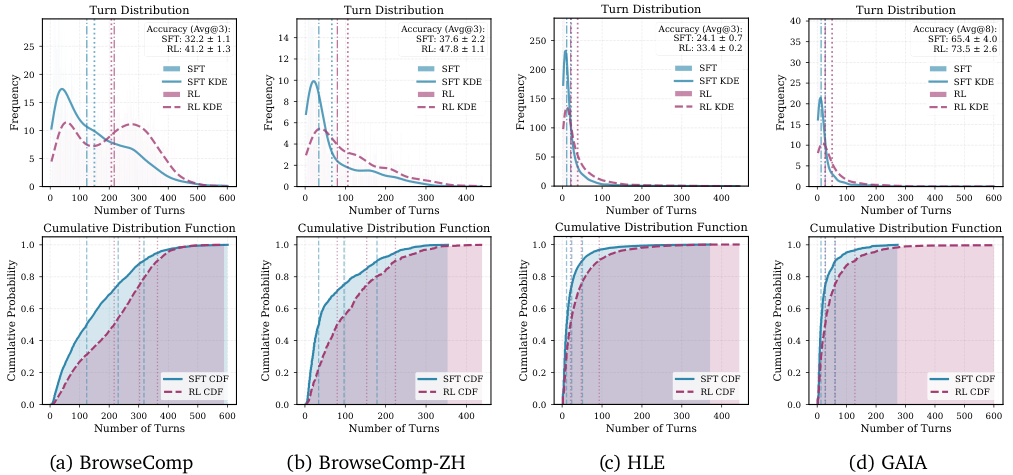

性能的提升究竟从何而来?

答案就在交互扩展这个核心理念中。

研究人员深入分析了经过强化学习(RL)最终调整的模型,与仅经过监督微调(SFT)的中间版本在行为模式上的差异。结果清晰地揭示了强化学习是如何重塑智能体与环境的交互模式的。

经过RL调整的MiroThinker-v1.0-30B模型,在BrowseComp、BrowseComp-ZH、HLE和GAIA这四个基准测试上,都展现出了显著更长、更深的交互轨迹。

在可验证的奖励信号的引导下,强化学习鼓励模型去探索更全面的解决方案路径。

它不再满足于找到一个看起来正确的答案就停下,而是会系统性地去验证每一个中间结果,反复检查和修正自己的推理链。

这种行为模式的转变,直接导致了交互深度的显著提高,而交互深度的提高,又与最终答案准确性的提升呈现出强烈的正相关关系。

这个发现系统性地验证了MiroThinker团队最初的洞察:交互深度与研究推理能力之间存在着明确的预测关系。它不再仅仅是模型规模和上下文长度之外的一个补充,而是构建下一代高性能研究代理不可或缺的、决定性的第三个维度。

当然,MiroThinker v1.0并非完美无瑕。

在交互扩展的模式下,工具使用的质量还有待提升。经过强化学习调整的模型虽然会更频繁地调用外部工具,但其中一部分调用是冗余的,或者对最终结果的贡献有限。

同时,强化学习的奖励机制倾向于鼓励模型产生更长的响应来确保准确性,这有时会导致模型的思考链条过于冗长、重复,降低了最终输出内容的可读性。

此外,模型在处理非英语输入时,偶尔会在响应中出现中英夹杂的现象。

在利用代码执行和文件管理这类复杂工具方面,模型的熟练度也还不足,有时会生成导致沙箱超时的代码或命令。

这些局限性,为MiroThinker的后续版本指明了清晰的优化方向。

MiroThinker v1.0通过在模型规模、上下文长度和交互深度这三个关键维度上的协同扩展,展示了开源模型在处理复杂真实世界研究任务时所能达到的全新高度。

免费试用:

https://dr.miromind.ai/

参考资料:

https://huggingface.co/collections/miromind-ai/mirothinker-v10

https://github.com/MiroMindAI/MiroThinker/blob/main/assets/MiroThinker_v1.0_Technical_Report.pdf

https://miromind.ai/blog/miromind-s-open-deep-research-framework-tops-futurex-benchmark-heralds-a-new-paradigm-in-ai

https://futurex-ai.github.io/

END

更多推荐

已为社区贡献107条内容

已为社区贡献107条内容

所有评论(0)