医疗数据中的自动化模型监控与性能自适应优化技术

医疗AI的性能管理已从单纯的模型训练演变为复杂的生态系统工程。通过构建自动化监控-自适应优化的闭环系统,不仅能延长模型生命周期,更能确保临床决策的持续可靠性。当边缘计算、联邦学习与强化学习深度融合时,医疗AI将真正实现"自我感知、自我进化"的智能形态。思考题:在医疗AI监控系统中,如何平衡模型更新频率与临床稳定性需求?请结合具体场景提出你的解决方案。

📝 博客主页:jaxzheng的CSDN主页

目录

在医疗AI系统从实验阶段走向临床落地的过程中,模型性能的持续稳定性成为决定其成败的核心要素。随着医疗数据量的指数级增长和临床场景的复杂化,传统静态模型已难以应对动态环境下的性能衰减问题。本文将深入探讨自动化模型监控(Automated Model Monitoring)与性能自适应优化(Performance Adaptive Optimization)技术的演进路径,揭示其在医疗AI全生命周期管理中的关键作用。

医疗数据具有显著的时序特性和场景依赖性,导致模型性能衰减的主要因素包括:

- 患者群体演变:人口老龄化、新型疾病谱变化等导致输入特征分布偏移

- 设备参数漂移:医学影像设备的校准误差、传感器精度下降等硬件因素

- 诊疗标准更新:临床指南的迭代(如2024年WHO糖尿病诊断标准修订)引发标签分布变化

# 对抗样本检测示例代码

import foolbox as fb

# 构建对抗鲁棒性测试

fmodel = fb.PyTorchModel(model, bounds=(0, 1))

attack = fb.attacks.FGSM()

adversarial = attack(fmodel, inputs, labels)

print("对抗攻击成功率:", fb.utils.accuracy(fmodel, adversarial, labels))

医疗场景下的模型监控需超越传统AUC指标,构建包含以下维度的评估矩阵:

| 维度 | 指标示例 | 临床价值 |

|---|---|---|

| 准确性 | 特异性、灵敏度 | 降低误诊率 |

| 可解释性 | SHAP值分布 | 提高医生信任度 |

| 稳定性 | 预测置信度波动 | 识别异常样本 |

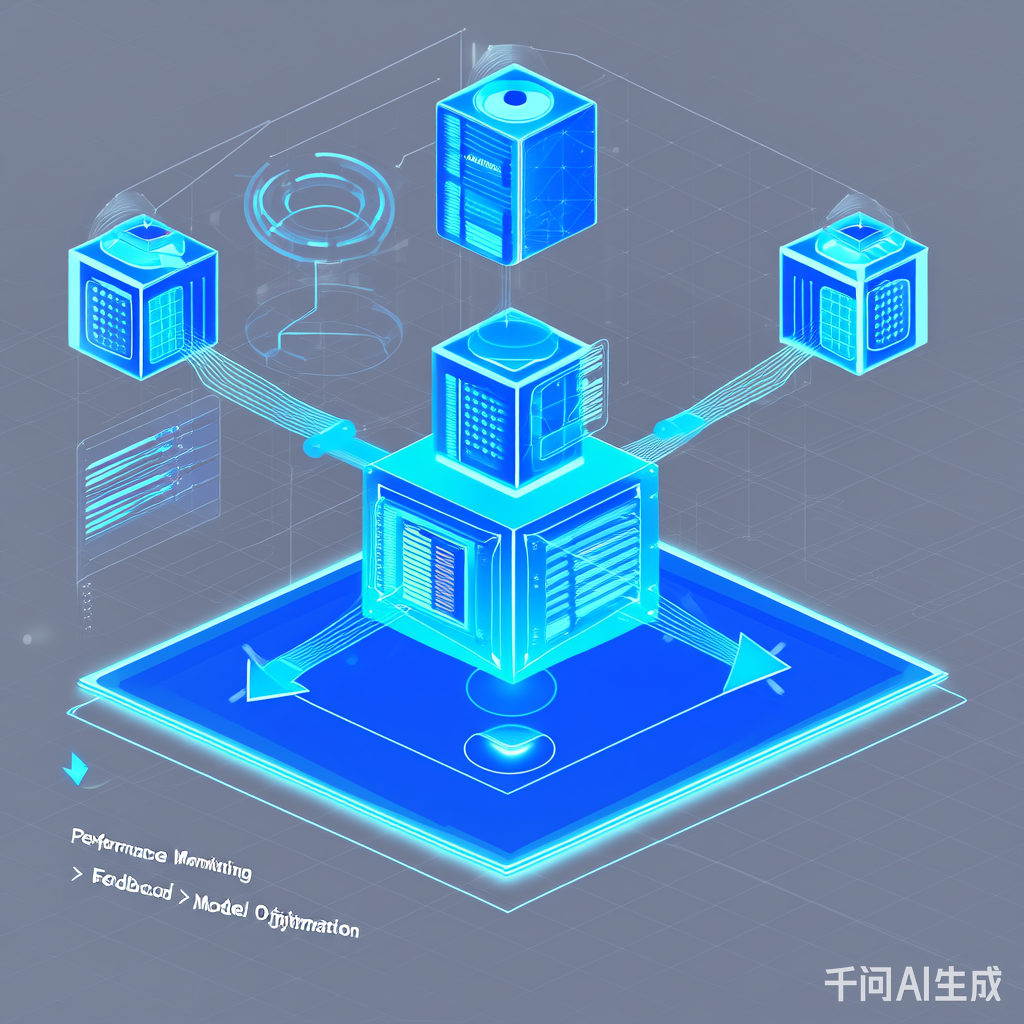

现代医疗AI监控系统通常采用三层架构:

- 数据层:通过Kafka实时采集模型输入输出数据

- 分析层:使用Elasticsearch存储监控指标,Druid实现时序数据分析

- 响应层:集成Slack通知、自动触发再训练工作流

# 实时推理接口示例

from fastapi import FastAPI

import pickle

app = FastAPI()

model = pickle.load(open("automl_model.pkl", "rb"))

@app.post("/predict")

def predict(data: dict):

features = preprocess(data)

prediction = model.predict_proba([features])[0][1]

return {

"risk_score": prediction,

"confidence_interval": calculate_confidence(prediction),

"anomaly_flag": detect_anomaly(features)

}

医疗领域广泛采用改进的孤立森林算法(Isolation Forest)进行概念漂移检测:

from sklearn.ensemble import IsolationForest

# 医疗场景优化版本

def medical_isolation_forest(X):

model = IsolationForest(

n_estimators=200,

max_samples='auto',

contamination='auto',

behaviour='new'

)

# 自适应污染率调整

contamination_rate = adaptive_contamination(X)

model.set_params(contamination=contamination_rate)

return model.fit_predict(X)

基于强化学习的再训练触发策略(RL-based Retraining Trigger):

import gym

from stable_baselines3 import PPO

# 定义医疗监控环境

class MedicalMonitoringEnv(gym.Env):

def __init__(self):

self.action_space = gym.spaces.Discrete(2) # 0: 不训练, 1: 重新训练

self.observation_space = gym.spaces.Box(low=0, high=1, shape=(10,)) # 监控指标向量

def step(self, action):

# 计算奖励函数

reward = calculate_retraining_reward(action)

return next_state, reward, done, info

# 训练智能体

model = PPO('MlpPolicy', env, verbose=1)

model.learn(total_timesteps=10000)

针对医疗边缘设备(如NVIDIA Jetson Orin Nano),采用三元量化(Ternary Quantization)技术:

from torch_quantum import TernaryQuantizer

quantizer = TernaryQuantizer(

weight_bit=3,

activation_bit=3,

symmetric=True

)

quantized_model = quantizer.quantize(model)

print(f"模型体积缩小: {original_size / quantized_size} 倍")

联邦学习(Federated Learning)与差分隐私(Differential Privacy)的融合方案:

from opacus import PrivacyEngine

# 医疗联邦学习隐私保护

def train_with_dp(model, train_loader):

privacy_engine = PrivacyEngine(

model,

batch_size=64,

sample_size=len(train_loader.dataset),

alphas=[128, 256, 512],

noise_multiplier=1.3,

max_grad_norm=1.0

)

optimizer = torch.optim.SGD(model.parameters(), lr=0.01)

privacy_engine.attach(optimizer)

for epoch in range(10):

train(model, train_loader, optimizer)

epsilon, best_alpha = privacy_engine.get_privacy_spent(1e-5)

print(f"Epoch {epoch}: ε={epsilon:.2f}")

医疗AI监控需满足HIPAA合规要求,并通过以下验证:

- 预测可解释性审查(如LIME解释器输出审计)

- 偏差检测(使用AI Fairness 360 Toolkit)

- 决策可追溯性设计(区块链存证关键操作日志)

2028年可能出现的突破:

- 跨模态特征对齐技术(X光+电子病历联合分析)

- 动态权重分配机制(根据数据质量自动调整各模态权重)

设想2030年医疗AI将具备:

- 实时医生反馈学习(通过自然语言交互获取修正意见)

- 临床知识图谱动态更新(自动整合最新医学研究成果)

医疗AI的性能管理已从单纯的模型训练演变为复杂的生态系统工程。通过构建自动化监控-自适应优化的闭环系统,不仅能延长模型生命周期,更能确保临床决策的持续可靠性。当边缘计算、联邦学习与强化学习深度融合时,医疗AI将真正实现"自我感知、自我进化"的智能形态。

思考题:在医疗AI监控系统中,如何平衡模型更新频率与临床稳定性需求?请结合具体场景提出你的解决方案。

更多推荐

已为社区贡献53条内容

已为社区贡献53条内容

所有评论(0)