突破配对限制,MIT开创AI多模态学习新纪元:无配对数据同样让AI更聪明

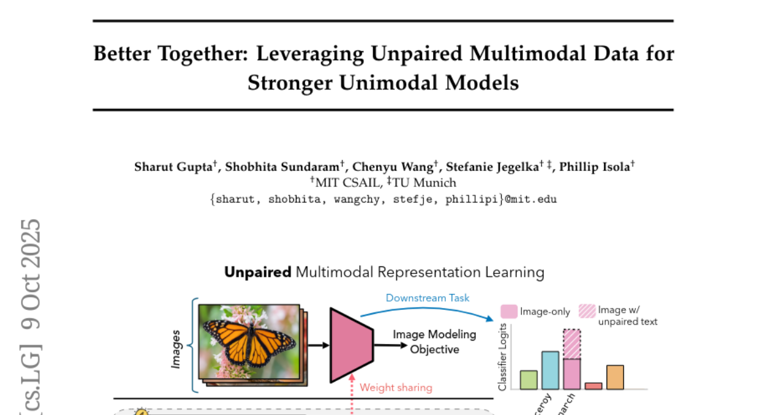

【摘要】一项开创性研究揭示,AI无需严格配对的多模态数据也能实现智能跃升。通过创新的参数共享框架,系统能自发学习图像、文本等非配对信息间的潜在关联,显著提升性能与泛化能力,为AI应用开辟了新纪元。

【摘要】一项开创性研究揭示,AI无需严格配对的多模态数据也能实现智能跃升。通过创新的参数共享框架,系统能自发学习图像、文本等非配对信息间的潜在关联,显著提升性能与泛化能力,为AI应用开辟了新纪元。

引言

在人工智能奔涌向前的浪潮中,多模态学习一直被视为通往更高阶智能的必经之路。它模仿人类通过多种感官协同理解世界的方式,试图让机器同时处理和理解图像、文本、声音等多种信息。然而,这条路上横亘着一道巨大的鸿沟,那就是对**“数据配对”**的苛刻依赖。

传统的AI训练范式,就像一位严谨的语言老师,坚持要求每一个外语单词都必须配上一张精确对应的图片。一张小狗的照片,必须搭配“这是一只小狗”的文字描述。这种“图文成对”的模式,虽然直观有效,但在现实世界中却显得奢侈且低效。互联网上,有海量的图片和海量的文本,但它们绝大多数是独立存在、未经配对的。为了构建强大的多模e态模型,研究人员不得不耗费巨大的人力物力去收集、清洗和标注数以亿计的配对数据,这无疑极大地限制了多模态技术的发展速度和应用广度。

这个瓶颈,是整个领域的“阿喀琉斯之踵”。

但是,麻省理工学院(MIT)计算科学与人工智能实验室(CSAIL)联合慕尼黑工业大学的一项研究,为我们拨开了这层迷雾。他们提出了一种名为**“无配对多模态学习器”(UML, Unpaired Multimodal Learner)**的全新框架,勇敢地向“数据必须配对”的旧有观念发起了挑战。这项研究成果如同一声惊雷,宣告了一个新纪元的到来,一个AI可以从海量、杂乱、非配对的数据中汲取智慧的新纪元。

这篇文章将带您深入这项研究的内核,不仅解析其背后的技术原理与理论洞察,还将通过详实的实验数据和应用场景,展现这一突破将如何重塑我们对AI学习方式的认知,并为医疗、自动驾驶等关键领域带来颠覆性的变革。

✨ 一、挣脱枷锁,多模态学习的“配对”困局与破晓 ✨

1.1 传统范式的“成本枷锁”

在深入UML的精妙设计之前,我们有必要更真切地感受一下传统多模态学习所面临的困境。构建一个强大的多模态模型,其前提是拥有一个庞大且高质量的配对数据集。这背后隐藏着几个难以逾越的障碍。

-

收集成本高昂

获取天然配对的数据极为困难。例如,在医疗领域,一张CT影像和一份精准描述该影像具体病灶的诊断报告,虽然逻辑上关联,但在数据库中往往是分开存储的,将它们一一对应需要复杂的工程和专业的人工审核。 -

标注难度巨大

对于没有天然配对的数据,就需要人工进行标注。想象一下,为数百万张网络图片编写贴切的描述,或者为数万小时的视频打上精确的时间戳和内容标签,这项工作的复杂度和成本是天文数字。 -

数据覆盖面有限

依赖人工标注的配对数据,其内容和风格往往会受到标注者认知和规范的限制,难以覆盖真实世界中无穷无尽的变化和细微差别。这导致模型在面对训练集中未曾见过的、更“野生”的数据时,表现会大打折扣。

正是这些枷锁,使得多模态AI虽然前景广阔,却迟迟未能像单模态模型那样迎来真正的“工业大革命”。整个行业都在期待一个能够打破这种依赖、让AI学会“触类旁通”的解决方案。

1.2 MIT的“破局之思”

MIT团队的核心洞察,源于一个简单却深刻的哲学思考,即使不同形式的数据没有直接的对应关系,它们也可能是在描述同一个底层现实的不同侧面。

这个想法非常直观。想象一下,一位摄影师拍摄了一组关于某座城市的街景照片,而一位作家写下了一篇关于这座城市风土人情的游记。这两组数据,照片和文字,几乎不可能做到一一精确配对。某张照片里的咖啡馆,可能在游记中只字未提;而游记中描写的历史街区,也可能没有出现在任何一张照片里。

但是,这两份看似独立的数据,都共同指向并描绘了“这座城市”的特征。照片捕捉了它的视觉元素,比如建筑风格、市民穿着;游记则记录了它的文化气息、历史底蕴。如果一个学习系统能够同时接触这两类信息,它对这座城市的理解,无疑会比只看照片或只读游记要深刻和全面得多。

UML框架正是基于这一理念构建的。它的目标不再是去学习“这张图”和“这段话”之间的直接映射,而是让模型在处理所有图片和所有文字的过程中,自己去领悟那个共同的、潜在的“城市”概念。

1.3 UML框架的诞生

基于上述洞察,UML(Unpaired Multimodal Learner)应运而生。它并非一个具体的模型,而是一个灵活的、可扩展的训练框架。其核心思想是,通过强制不同模态的专用处理模块共享一部分网络参数,来促使它们学习到一个统一的、跨模态的语义表示空间。

这个共享的部分,就像一个“大脑皮层”,不同感官(视觉、听觉、语言)的信息在这里汇合、交融,最终形成统一的认知。这种设计,使得模型即使在没有“老师”明确告知对应关系的情况下,也能通过大量的独立信息输入,自发地找到不同模告态之间的内在联系。

✨ 二、深入UML内核,揭秘无配对学习的魔法 ✨

UML框架的成功并非偶然,它建立在精巧的技术机制和坚实的理论基础之上。下面,我们将层层剥茧,探究其工作的核心原理。

2.1 核心机制,参数共享的“联合表示空间”

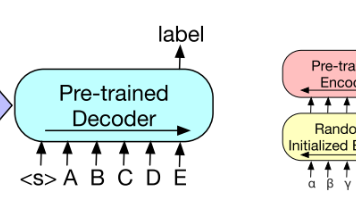

UML的魔法,始于其独特的网络架构设计。它通常由三个关键部分组成。

-

模态专用编码器 (Modality-Specific Encoders)

每个模态(如图像、文本)都有一个自己的“预处理器”,即编码器。图像编码器(如ViT)负责从像素中提取视觉特征,文本编码器(如BERT)则负责从词语中提取语义特征。在这一阶段,信息处理是独立的。 -

共享转换层 (Shared Transformer Layers)

这是UML的心脏。来自不同模态编码器的特征,会进入一个或多个共享的转换层。这意味着,处理图像特征的参数和处理文本特征的参数是完全相同的。当模型在处理一批图像数据进行学习时,这些共享参数会为了更好地理解图像而更新;紧接着,当模型处理一批文本数据时,同一组共享参数又会为了更好地理解文本而再次更新。 -

任务专用头 (Task-Specific Heads)

在共享层之后,模型会根据具体的下游任务(如图像分类、情感分析等)接上不同的输出层。

这种设计的巧妙之处在于,共享层被迫去学习一种**“通用语言”**。为了既能服务好视觉任务,又能服务好语言任务,这些共享的神经元必须找到一种能够同时表达图像内容和文本含义的表示方式。久而久之,一个跨模态的联合表示空间就自然形成了。

下面是一个简化的UML框架工作流程图,可以帮助我们更直观地理解这个过程。

在这个流程中,图像和文本数据无需配对,它们可以以独立的批次交替输入。但最终,它们的信息都会在共享层E中交汇,迫使模型学习到一个统一的、强大的特征表示。

2.2 理论基石,信息增益的数学证明

这种方法的有效性不仅仅是工程上的直觉,MIT团队还为其提供了严谨的数学理论支持。他们证明了,在某些条件下,来自辅助模态的无配对数据能够严格地改进模型在目标模态上的学习效果。

这个理论的核心可以通俗地理解为**“信息互补性”**。假设我们的目标是学习对图像进行分类。图像本身提供了丰富的视觉信息,但可能在某些方面存在“盲区”。比如,两只外观非常相似但品种不同的狗,仅从视觉上可能极难区分。

此时,如果我们引入大量关于狗的品种、习性、特征的无配对文本数据,模型在学习这些文本时,会在其共享的表示空间中构建起关于“狗”的更丰富的语义概念。它会知道“柯基”通常与“短腿”、“电臀”等概念相关联,而“柴犬”则与“微笑”、“固执”等概念相关。

当模型再次看到那张难以区分的狗的图片时,它在共享空间中学到的这些丰富的语义知识,就会像“背景知识”一样,帮助它更准确地进行判断。即使没有任何文本直接描述过这张图片,但文本数据已经帮助模型优化了其内部的特征空间,使得不同品种的狗在那个空间中的“距离”变得更远,更容易被区分开。

理论证明,当辅助模态能够提供目标模态所缺失的信息时,这种无配对学习带来的增益是最大的。这就像用雷达和摄像头同时观察一个区域,雷达能探测到摄像头看不见的物体,而摄像头能提供雷达无法获取的颜色和纹理细节,两者结合,就能得到远超单一传感器的环境理解。

2.3 智能涌现,“多模态神经元”的自发形成

在UML框架的训练过程中,一个最令人惊奇的发现是**“多模态神经元”**的自发涌现。

研究人员发现,在共享层中,有一些特定的神经元会变得对跨模态的同一概念特别敏感。例如,某个神经元在模型看到一张蝴蝶的图片时会被强烈激活,同时,在模型读到一段包含“蝴蝶”、“翅膀”、“飞舞”等词语的文字时,这个神经元也会被同样激活。

重要的是,模型在训练期间从未见过任何一张蝴蝶图片与描述蝴蝶的文字同时出现。

这种现象揭示了UML学习的深层本质。模型并非在死记硬背,而是在真正地**“形成概念”**。这个“蝴蝶神经元”所代表的,不再是某个具体的像素组合或单词,而是“蝴蝶”这个抽象概念在模型内部的一个高度浓缩的、跨模态的数学表示。

这种能力的涌现,是AI从简单的模式匹配迈向更高级的抽象理解的关键一步。它意味着AI开始像人一样,能够将不同来源的信息整合到一个统一的认知框架中。

2.4 高阶能力,从讽刺识别到知识迁移

基于这种强大的跨模态理解能力,UML展现出了一些令人印象深刻的高阶智能。

2.4.1 洞察言外之意,讽刺识别

讽刺是一种复杂的人类交流方式,其核心在于信息的不一致性。比如,一个人面带愁容地说“我今天真是太开心了”。要理解其中的讽刺意味,就必须同时处理视觉(表情)和语言(内容)两个模态,并发现它们之间的冲突。

研究团队发现,经过无配对多模态训练的模型,竟然自发地学会了这一点。当模型接收到表情和语言内容协调一致的数据时,它会判断为“非讽刺”;而当两者存在明显冲突时,模型则倾向于判断为“讽刺”。这表明,UML不仅学会了对齐不同模态中的相似概念,还学会了识别它们之间的不一致性,这是更高层次的智能体现。

2.4.2 跨界赋能,知识的“移植”手术

另一个惊人的发现是跨模态知识迁移的可能性。研究团队进行了一项大胆的实验,他们将一个在大量文本上预训练好的语言模型(如BERT)的部分参数,直接用来初始化一个视觉模型(如ViT)的共享层。

这就像是把一位文学家的“大脑”一部分移植给一位画家。直觉上,处理文字的知识和处理图像的知识似乎风马牛不相及。但实验结果却出人意料地好。用语言模型参数初始化的视觉模型,其学习速度和最终性能,都优于随机初始化的模型。

这个结果有力地证明,在深度学习模型的高层语义空间中,不同模态的知识具有一定的通用性。语言模型通过学习人类语言,已经掌握了关于世界的大量抽象的、结构化的知识(比如物体的层次关系、属性特征等),这些知识对于理解视觉世界同样具有极高的价值。UML框架则为这种“知识移植”提供了一条有效的途径。

✨ 三、量化革命,实验数据下的UML实力 ✨

空谈理论不如实证。UML框架的强大之处,在多项基准测试中得到了充分验证。实验数据不仅展示了其性能的飞跃,还揭示了一些关于多模态学习的深刻洞见。

3.1 性能飞跃,超越单模态的铁证

研究团队在多个经典的机器学习任务上,对比了仅使用单一模态数据训练的模型和使用UML框架融合了无配对多模态数据的模型。结果是压倒性的。

|

任务类型 |

模型类型 |

数据条件 |

性能提升(相对基线) |

|---|---|---|---|

|

图像分类 |

单模态 (ViT) |

仅图像数据 |

基线 (Baseline) |

|

(ImageNet) |

UML (ViT + Text) |

图像 + 无配对文本 |

+ 3.5% (Top-1准确率) |

|

音频识别 |

单模态 (AST) |

仅音频数据 |

基线 (Baseline) |

|

(AudioSet) |

UML (AST + Text) |

音频 + 无配对文本 |

+ 2.8% (mAP) |

|

少样本学习 |

单模态 (ViT) |

少量标注图像 |

基线 (Baseline) |

|

(Few-shot) |

UML (ViT + Text) |

少量图像 + 无配对文本 |

+ 7.2% (准确率) |

从上表可以看出,无论是在数据充足的图像分类任务,还是在少样本学习场景下,加入无配对的文本数据都带来了显著的性能提升。尤其是在数据稀缺的情况下,提升幅度更大。这对于许多难以获取大量标注数据的实际应用场景,具有极其重要的意义。

3.2 “模态交换率”,数据的价值新标尺

为了量化不同模态数据的学习价值,研究团队提出了一个有趣的概念——“模态交换率”。即,增加一张图像数据带来的性能提升,约等于增加多少个单词的文本数据带来的提升。

他们通过精密的实验设计,得出了以下近似结论。

|

数据对齐情况 |

交换率 (1张图像 ≈ ? 个单词) |

解释 |

|---|---|---|

|

良好对齐 (Well-aligned) |

~228 个单词 |

使用像CLIP预训练时用的高质量图文对数据。信息冗余度较高,文本的补充价值相对有限。 |

|

未对齐 (Unaligned) |

~1034 个单词 |

使用完全独立的图像和文本数据。文本需要提供更多信息来弥补与图像的语义鸿沟,因此需要更多数量。 |

这个发现为实际应用中的数据策略提供了重要的量化指导。它告诉我们,图像通常是信息密度更高的模态。在资源有限的情况下,如何平衡不同模态数据的收集和使用,不再仅仅依靠直觉,而是可以有数据依据地进行权衡。例如,如果获取一张高质量图像的成本远低于获取1000个相关单词的文本,那么优先扩充图像数据可能是更优的选择。

3.3 鲁棒性与决策边界的优化

除了提升准确率,UML还显著增强了模型的鲁棒性。当测试数据的分布与训练数据存在差异时(即所谓的分布外测试),使用无配对多模态数据训练的模型表现出更强的适应能力,性能下降幅度远小于单模态模型。

这就像一个既读过万卷书(文本)又行过万里路(图像)的人,比一个只行过万里路的人,在面对陌生环境时能更快地理解和适应。丰富的背景知识让他能够更好地泛化。

在微观层面,研究人员通过可视化模型的决策边界发现,加入了文本信息后,模型在区分相似类别时变得更加自信和准确。例如,在区分“哈士奇”和“阿拉斯加雪橇犬”这两个视觉上极度相似的类别时,单模态模型可能会在两者之间划出一条模糊、摇摆的界线。而UML模型,由于其内部已经通过文本学习建立了关于这两个品种体型、毛色、眼睛颜色等更丰富的语义概念,其决策边界会变得更加清晰和稳定。

这种决策边界的优化,对于需要高可靠性的细粒度分类任务(如工业质检中的瑕疵分类、生物学中的物种识别)至关重要。

✨ 四、驰骋现实,UML的应用版图与未来 ✨

理论和实验的成功,最终要服务于现实世界。UML框架的突破性,使其在众多行业中都展现出巨大的应用潜力,有望解决许多长期存在的工程难题。

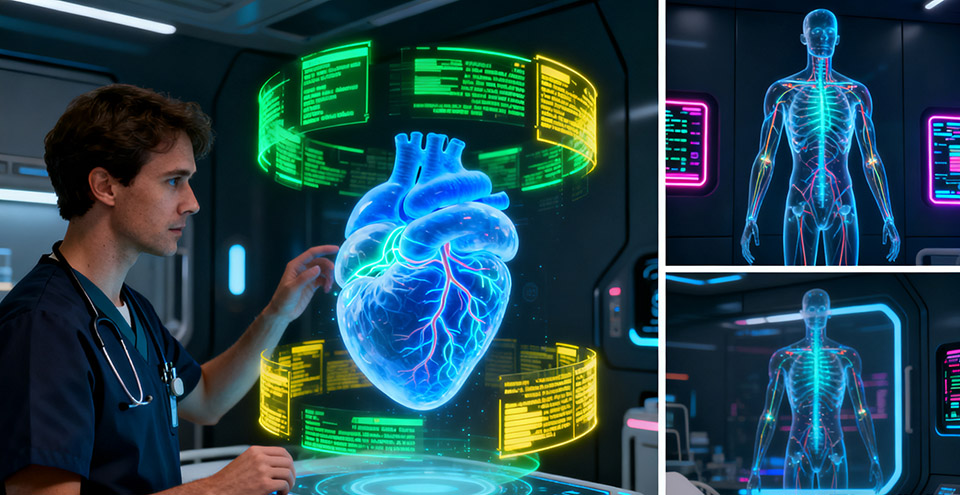

4.1 智慧医疗,洞悉影像与病历的交集

在医疗领域,医学影像(如X光、CT、MRI)和电子病历(EHR)是诊断疾病的两大核心数据源。然而,这两者在数据库中往往是独立存储的,难以进行大规模的精确配对。UML框架的出现,完美地解决了这个问题。

AI系统可以同时学习海量的匿名化医学影像和海量的电子病历文本。即使它们没有直接的对应关系,模型也能学到影像特征(如肿瘤的形状、纹理)和病历描述(如“恶性”、“浸润性生长”)之间的潜在关联。

-

提升诊断准确率

模型能够综合视觉和文本信息,做出比单一信息源更可靠的诊断。 -

辅助报告生成

在分析完一张新的影像后,模型可以利用其学到的跨模态知识,自动生成初步的诊断报告草稿,大大减轻医生的工作负担。 -

挖掘潜在生物标志物

通过分析影像和大规模文本数据之间的关联,模型甚至可能发现一些人类医生尚未注意到的、与特定疾病相关的影像学特征。

4.2 自动驾驶,全感官的道路理解

自动驾驶系统需要对复杂的交通环境有极致的理解。这不仅需要视觉(摄像头图像),还需要听觉(如警笛声、喇叭声)和语言(如导航指令、交通标志文字)等多种信息的融合。

在真实的驾驶场景中,这些信息流是异步且非配对的。UML框架可以让自动驾驶系统将这些独立的信源整合到一个统一的环境模型中。

-

增强安全性

系统听到警笛声时,即使在视觉上还未看到急救车辆,也能提前提高警惕,规划避让路线。 -

提高决策效率

融合导航文字指令(“前方200米右转”)和视觉信息(识别右侧路口),系统可以做出更果断、更准确的驾驶决策。 -

应对极端天气

在暴雨或浓雾等视觉受限的场景下,声音和雷达等其他模态的信息变得尤为重要,UML可以有效地融合这些信息,保障行驶安全。

4.3 个性化服务,重塑内容推荐与用户画像

在电商、短视频、新闻资讯等领域,平台拥有海量的用户行为数据,包括用户点击的图片、观看的视频、阅读的文章、发表的评论等。这些数据同样是多模态且大部分非配对的。

利用UML,推荐系统可以构建一个更全面、更立体的用户画像。

-

更精准的推荐

系统不仅知道你喜欢看“科幻电影”的图片,还通过你阅读的文章知道你对“硬科幻”和“赛博朋克”等子主题更感兴趣,从而为你推荐更符合你口味的电影。 -

跨品类推荐

如果系统发现你既喜欢看关于“户外徒步”的视频,又经常购买“速干衣”类的商品,它可能会为你推荐一些关于“野外生存技巧”的文章,实现兴趣的延伸和发现。

4.4 挑战与边界,“语义相关性”的红线

尽管UML框架非常强大,但它并非万能药。其有效性的一个核心前提是,参与学习的多个模态数据之间,必须存在一定的领域或语义相关性。

如果我们将猫的图片数据和关于天体物理学的论文数据一起喂给UML模型,期望它能提升猫的分类准确率,这显然是行不通的。因为这两者描述的底层现实完全不同,共享层无法在它们之间找到任何有意义的共同模式,甚至可能因为无关信息的干扰而导致性能下降。

因此,在实际应用中,如何选择和预处理数据,确保不同模态数据在宏观上指向同一个主题域,是成功运用UML的关键一步。此外,共享层的深度、不同模态数据的批次大小配比等超参数,也需要根据具体任务进行科学的权衡和调整。

4.5 未来展望,迈向更多模态的融合

UML框架的另一个巨大优势是其可扩展性。研究已经证明,该框架可以轻松地从两模态扩展到三模态(如图像、文本、音频),并且每增加一个模态,都会带来额外的性能提升。

这为我们描绘了一个激动人心的未来。未来的AI系统,或许能够融合视觉、听觉、语言、触觉甚至嗅觉等更多模态的信息,构建起对世界前所未有的全面认知。这样的AI,将能更自然、更深入地融入我们的生活,成为真正意义上的智能助手。

总结

MIT团队的这项研究,无疑是多模态AI领域的一座里程碑。它通过一个简洁而强大的“无配对多模态学习器”(UML)框架,从根本上解决了传统方法对数据配对的依赖问题,将AI从昂贵、稀疏的“精装教科书”中解放出来,使其能够从广阔无垠、未经整理的现实世界数据海洋中自由学习。

这项工作不仅在技术上展示了通过参数共享实现跨模态知识迁移的巨大潜力,更在理论上证明了无配对数据的信息价值。从“多模态神经元”的智能涌现,到讽刺识别、知识移植等高阶能力,UML为我们揭示了AI学习的一种更接近人类认知本质的新范式。

它为医疗、自动驾驶、个性化服务等无数应用场景打开了新的想象空间,大幅降低了构建高性能多模态AI的门槛。未来,随着这一思想的不断深化和工程实践的持续优化,我们有理由相信,一个能看、能听、能读、能更深刻理解我们复杂世界的AI,正在加速向我们走来。

📢💻 【省心锐评】

抛弃配对数据的“拐杖”,AI开始学会独立“思考”不同感官信息间的联系。这不仅是技术的飞跃,更是AI认知模式的进化,让大规模、低成本的真正常识学习成为可能

更多推荐

已为社区贡献326条内容

已为社区贡献326条内容

所有评论(0)