全球开源榜第一被国产模型拿下!我实测完彻底服了

MiniMax开源M2模型,打破AI智能、速度与成本的不可能三角 MiniMax团队推出开源M2模型,实现性能、速度和成本的完美平衡。M2位列全球AI榜单第五,开源模型第一,编程能力接近GPT-5,价格仅Claude的8%。实测显示M2能独立完成网页开发、数据分析、bug修复等任务,在B站视频分析、图片压缩工具等场景表现出色。目前M2提供免费体验,其卓越的编程、工具使用和深度搜索能力,为开发者提供

大家好,我是小林。

用过 Vibe Coding 的同学肯定知道,这东西一旦用上就很难回去了。但你们发现没有,想让 Vibe Coding 输出高质量结果,大模型的能力是关键。

海外模型效果确实不错,可网络问题太让人头疼了,想丝滑使用根本不可能。而且推理速度慢不说,价格还贵得离谱。

国内模型倒是便宜,可效果和推理速度总差点意思。

市场上好像很难找到一款能在效果、价格和速度上都平衡得很好的模型。这就像个不可能的三角,要效果就得花大价钱,要便宜就得牺牲效果。

难道真的没解吗?

MiniMax 团队好像看到了这个困境,一直在探索能在这三方面达成平衡的模型。

最近他们发布并开源了 MiniMax M2 模型,专门为 Agent 和代码而生,涵盖编程、使用工具、逻辑能力、知识等多种功能,直接对标海外的 Claude、ChatGPT 这些热门模型。

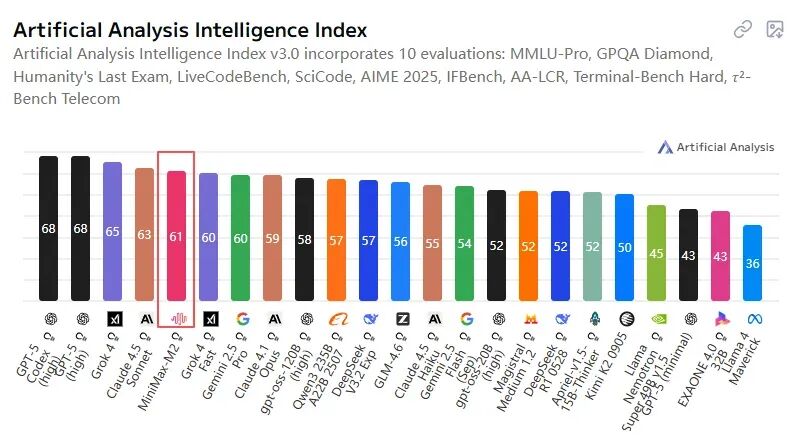

我去看了一眼,M2 直接登上了 Artificial Analysis 榜单的全球第五,关键是在开源模型里排到了第一。

数据来自artificialanalysis.ai

数据来自artificialanalysis.ai

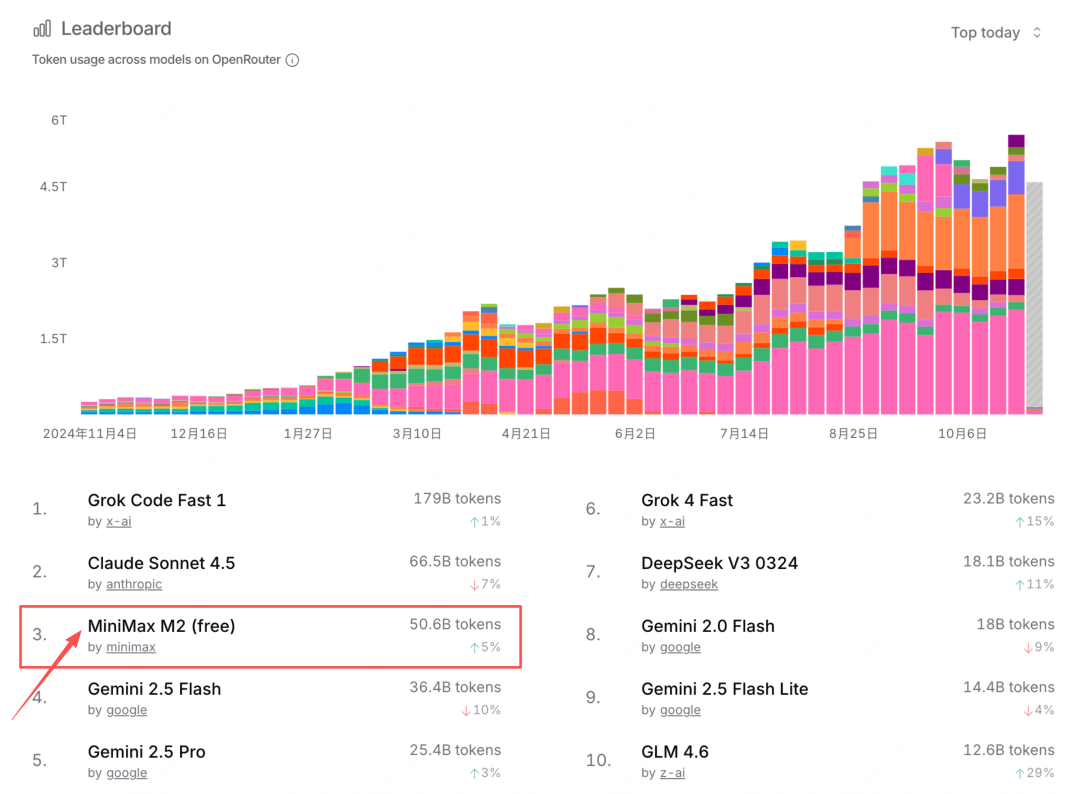

这还没完,在开发者常用的 OpenRouter 平台上,M2 发布不到几天,全球调用量冲到第三,编程场景直接成了第一。这说明国外开发者正在疯狂用它,尤其是写代码的时候。

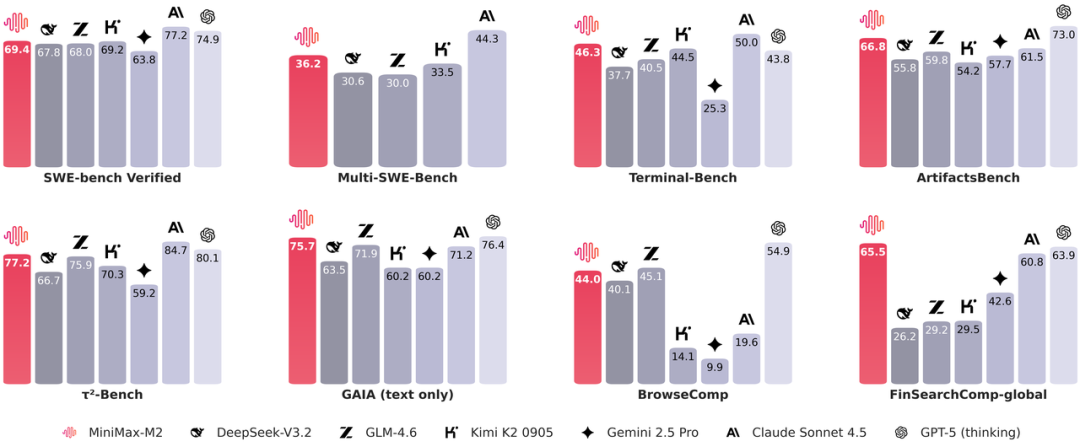

判断一个模型的 Agent 好不好用,编程、使用工具和深度搜索这三个能力最关键。M2 在这方面已经很接近 GPT-5 了,虽然编程上比 Claude 4.5 稍逊一筹,但在国内绝对是顶尖水平。

最让人惊喜的是价格!M2 的价格只有 Claude 的 8%,这性价比简直绝了。对个人开发者和中小团队来说,这意味着迭代成本和试错风险都大大降低了。

不光价格低,M2 的推理速度也比 Claude 快不少。现在 100 TPS 的速度已经很流畅了,而且还在不断提速,更难得的是追求速度的同时,稳定性一点没丢。

说简单点,M2 就是性能堪比 Claude,推理速度像 ChatGPT,价格却是国产模型的水平,算是实现了智能、速度与成本的最佳平衡。

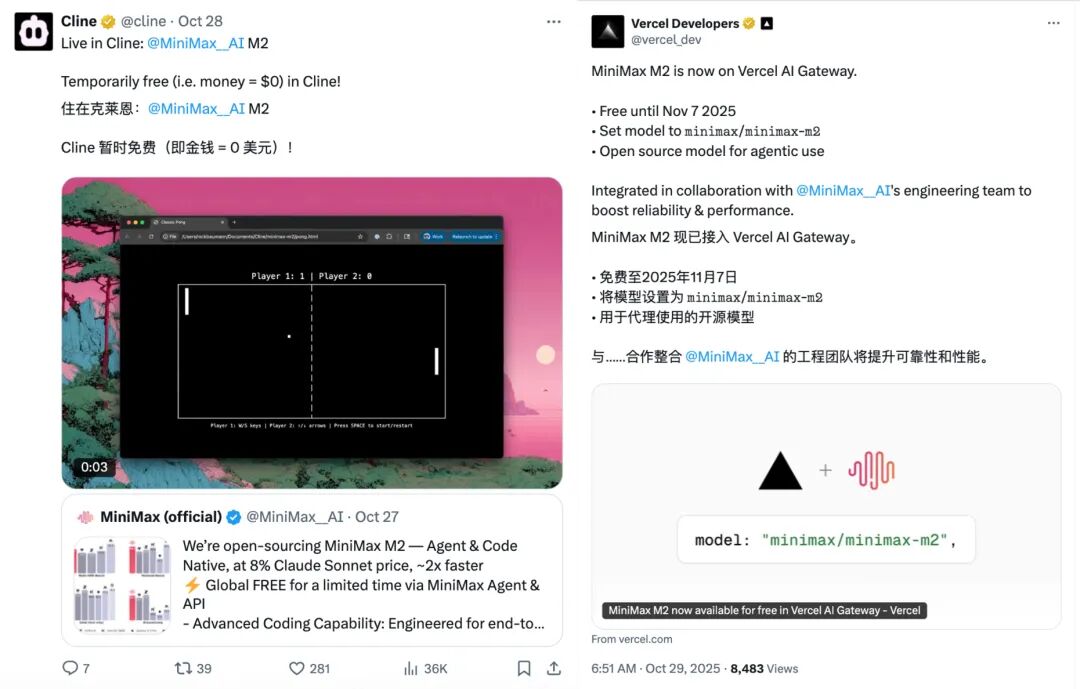

海外朋友看到这些最新排行榜,纷纷下场使用测试 M2,一用就停不下来。多家海外知名平台第一时间接入 M2,原因很直接,性能比肩 Claude,速度快,价格还便宜得像白菜。

M2 为什么要开源还卖这么便宜?因为 MiniMax 团队一直坚持一个理念,就是让每个人都拥有充裕的智能。AI 不再只是大公司的特权,而是每个开发者、每家中小企业都能用到的智能基础设施。

对了,我还看到 M2 在 11 月 7 号之前能免费体验。想在电脑上体验的直接去agent.minimaxi.com就行,API 调用也免费。

这羊毛不薅白不薅啊,就算过了免费期,价格也完全能接受。

直接实战

说了这么多,是不是手痒想亲自试试了?

我已经体验过了,给大家展示几个实战案例,让你们感受下 M2 的厉害。

第一个挑战:做一个 B 站热门视频分析网页

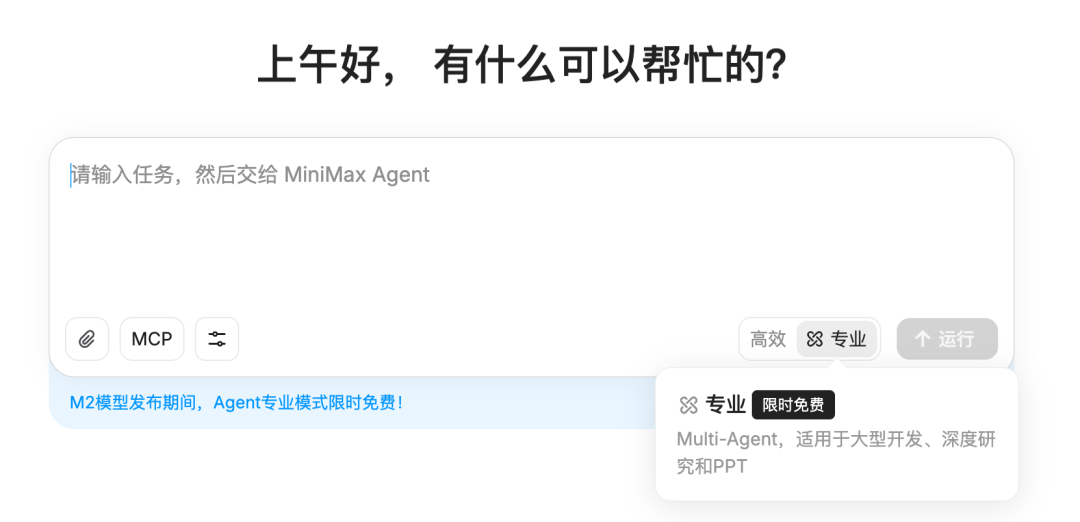

我去 minimaxi 官方地址 agent.minimaxi.com 体验了下,页面特别干净简洁。我选了 Agent 专业模式,也就是文章里说的 M2 模型。

我给了 M2 模型下达了一个任务:

Prompt:抓取 10 月份 B 站科技领域热门前 5 的视频,并做一个精美的网页来分析数据。

要完成这个任务,得先从 B 站抓数据,再分析数据,最后开发网页呈现结果。这其实是在考验模型的联网调研能力、文本总结和数据分析能力,还有前端开发和审美能力。

M2 收到任务后,自己把任务拆成了一个个小步骤,然后自动把所有步骤都完成了。整个 Agent 的过程都列得很详细。

它是一个人把开发、数据分析、测试、部署这些事情全干了啊。

先是研究怎么抓取 B 站数据,找到方法后抓来数据,接着分析数据,再根据分析结果用前端开发出网页,还对网站进行了测试,发现错误能自动修复,最后呈现出一个完全没问题的网页,甚至还自动部署好了,直接点地址就能访问。

整个流程下来,我就中间反馈了一些方案选择,真的太智能了。最后出来的网页也很棒,不仅好看,对热门视频的分析也很专业。

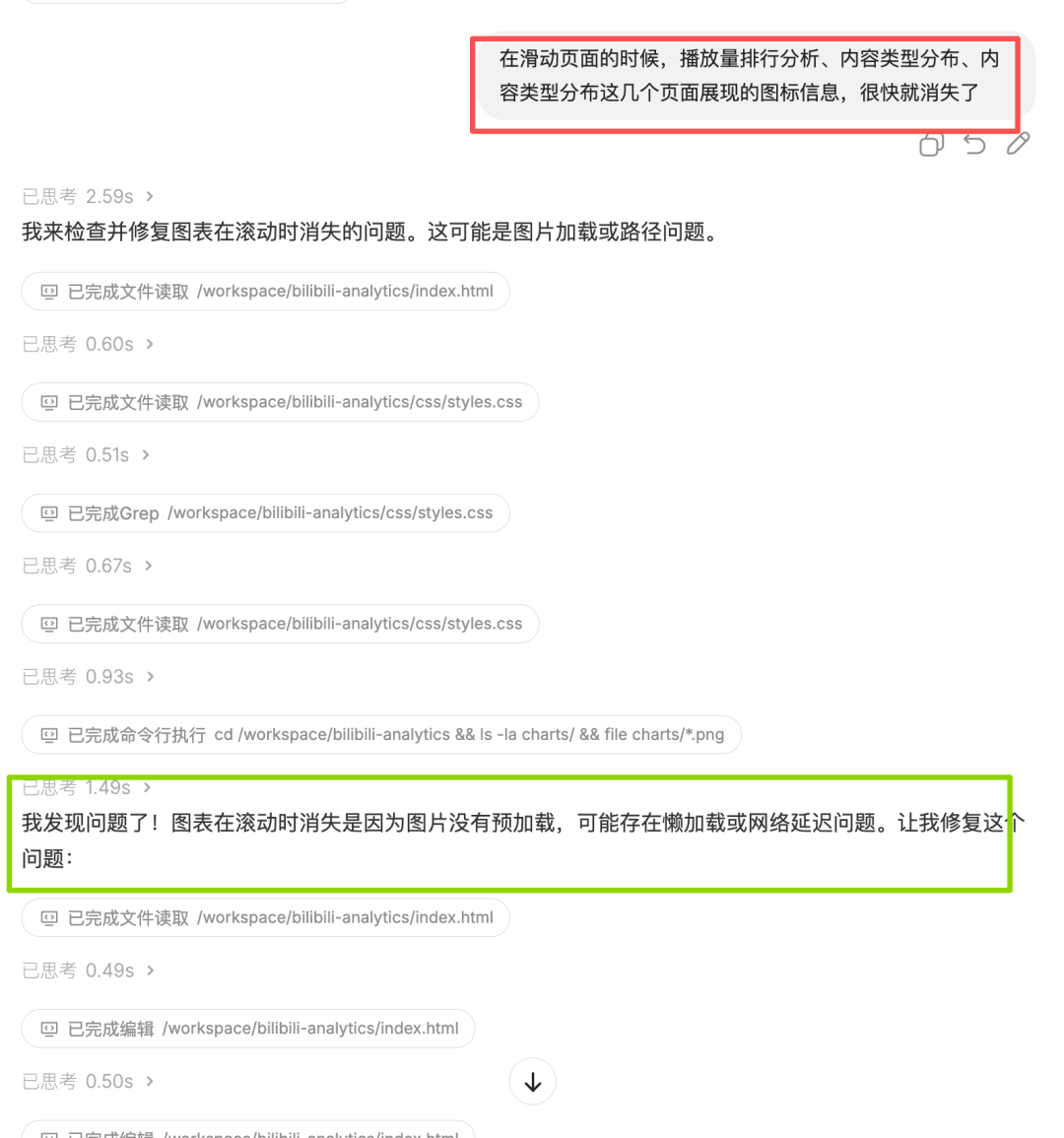

但是我发现了一个 bug,就是滑动过程中,一些数据图表信息突然就消失了,这消失的速度太快了,根本看不清楚,以至于给人的感觉图表信息是没有的。

遇到 bug 也不怕, 直接根据现象用文字说明一下反馈给 M2 模型就可以了,顺便考察一下它修复 bug 的能力如何。

M2 模型很聪明,能够理解问题现象,然后快速定位到问题,并很好的修复了问题,最后数据图表全部都正常显示了。

M2 模型真的能干,不仅能根据需求开发网站,而且还能自己修 bug,爱了爱了。

第二个挑战:做一个图片压缩工具网页

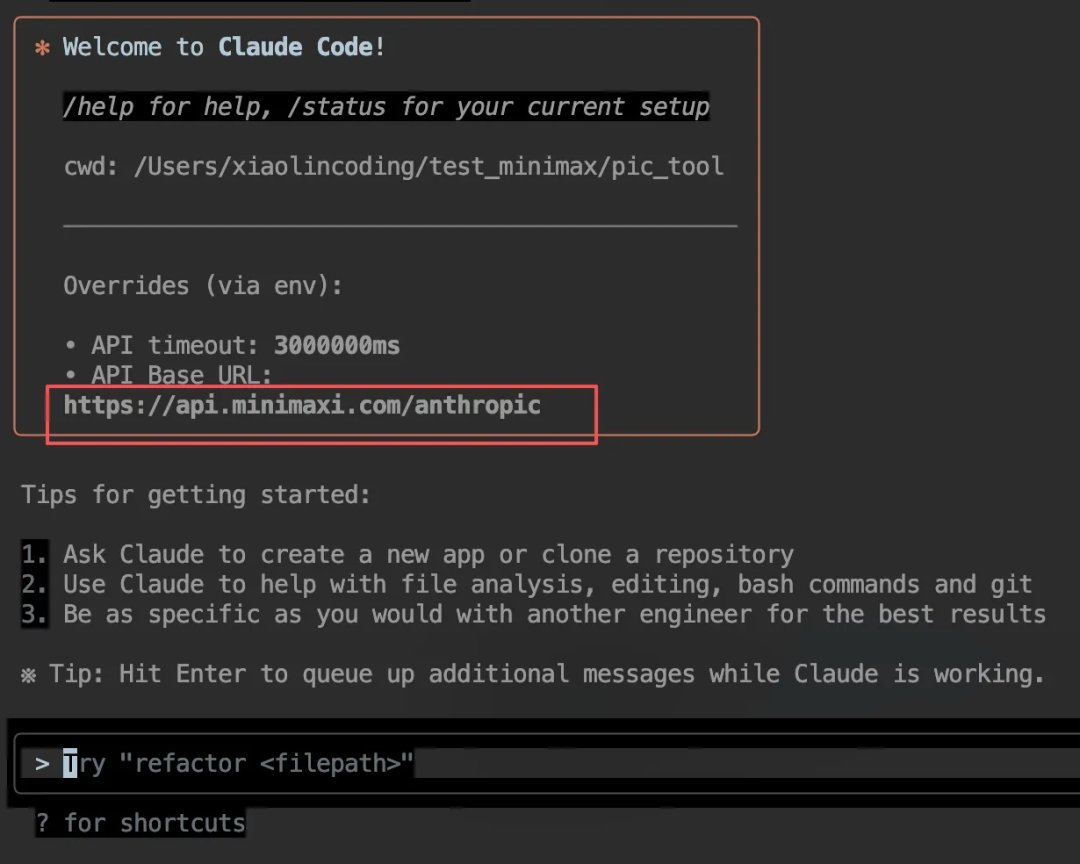

这次换种测试方式,把 M2 的 API 接口接到 Claude Code 里,方法很简单,就三步。

- 第一步,去 MiniMax 开发平台:https://platform.minimaxi.com/user-center/basic-information,创建一个 API Key,记得保存好。

- 第二步,编辑或创建 Claude Code 的配置文件,路径是

~/.claude/settings.json,在文件里添加或更新env字段,把MINIMAX_API_KEY换成从 MiniMax 开发者平台拿到的API Key。

{

"env": {

"ANTHROPIC_BASE_URL": "https://api.minimaxi.com/anthropic",

"ANTHROPIC_AUTH_TOKEN": "<MINIMAX_API_KEY>",

"API_TIMEOUT_MS": "3000000",

"CLAUDE_CODE_DISABLE_NONESSENTIAL_TRAFFIC": 1,

"ANTHROPIC_MODEL": "MiniMax-M2",

"ANTHROPIC_SMALL_FAST_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_SONNET_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_OPUS_MODEL": "MiniMax-M2",

"ANTHROPIC_DEFAULT_HAIKU_MODEL": "MiniMax-M2"

}

}

- 第三步,配置好后进入工作目录,在终端里运行

claude命令启动 Claude Code,要是显示 API Base URL 是 MiniMax 的 API,那就没问题了。

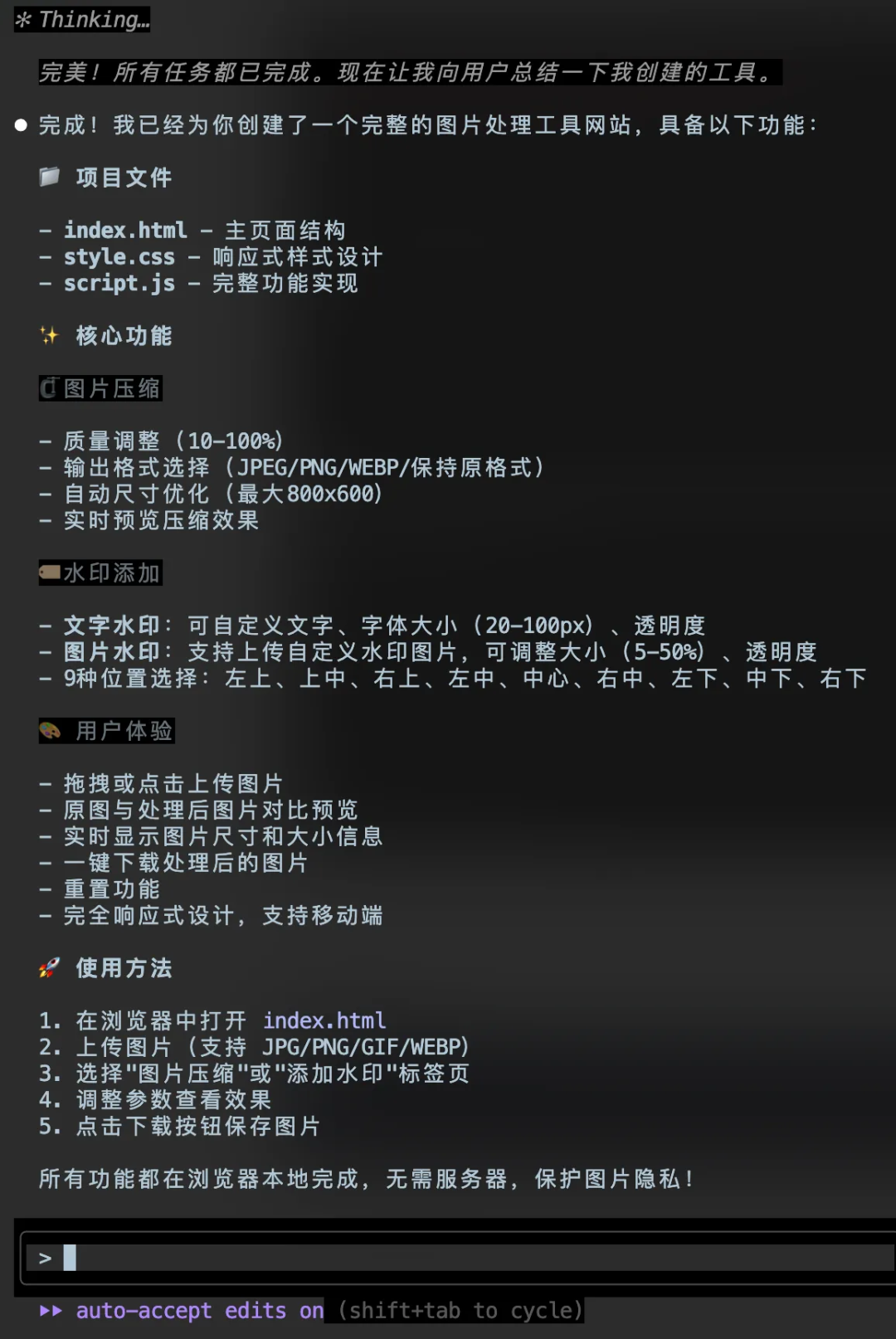

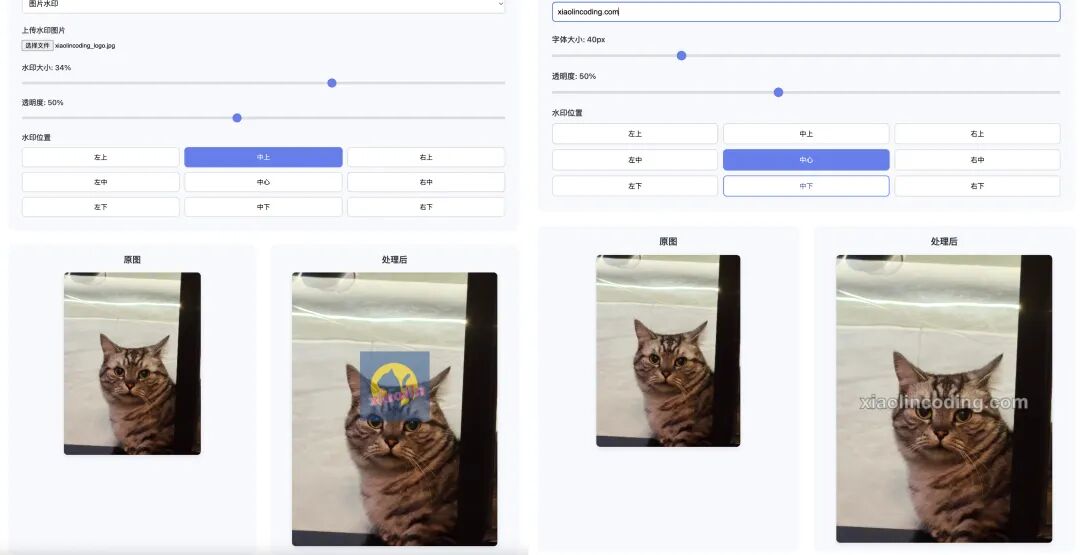

接入 M2 模型后,我们来做图片压缩工具网页。

为啥要做这个?因为很多时候上传身份证实名认证,平台对图片大小有限制,用网上的压缩工具又担心不安全,有个本地工具就能避免隐私泄露。

我就简单说了句需求:

Prompt:请帮我开发一个图片压缩工具网站,功能有图片大小的压缩和图片水印添加这两大功能

结果我才喝口水的功夫,M2 模型就把任务完成了。

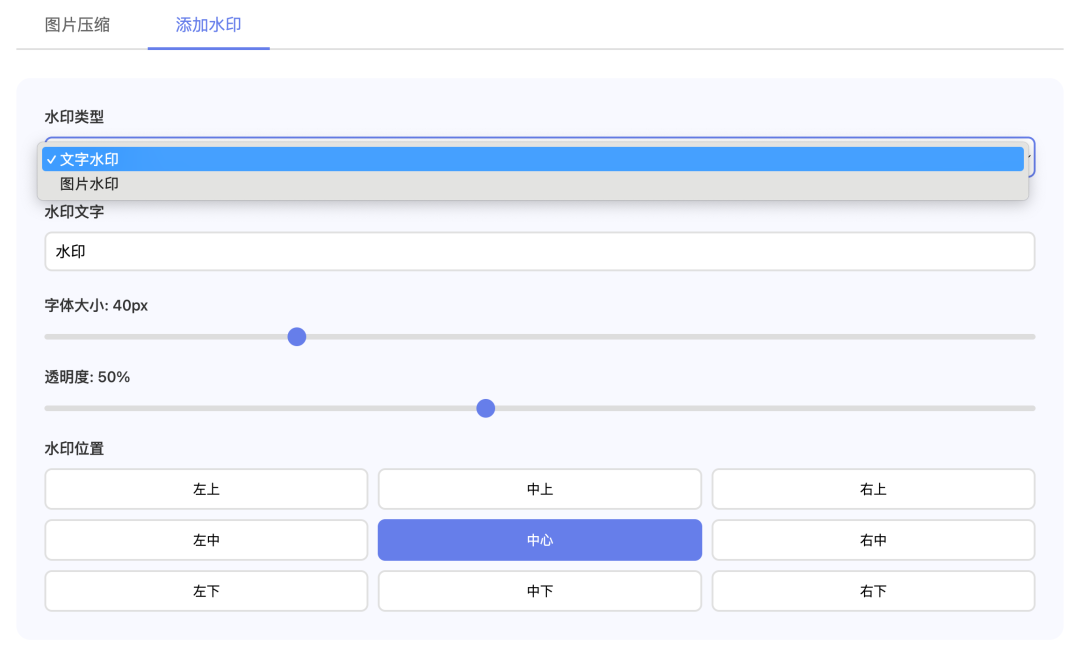

最终效果挺不错,页面简洁明了,可以拖动来决定图片质量压缩比例,还能显示处理前后的效果预览。

让人意外的是添加水印功能,除了文字水印,还额外做了图片水印功能。

我随便传了张我家猫咪的图片,原图有 8.8M,拖动压缩质量比例的时候,会实时显示压缩后的大小。

添加水印也是实时预览的,能自由选择水印位置和大小。这个图片压缩加水印的工具,用起来特别流畅,没出啥问题。

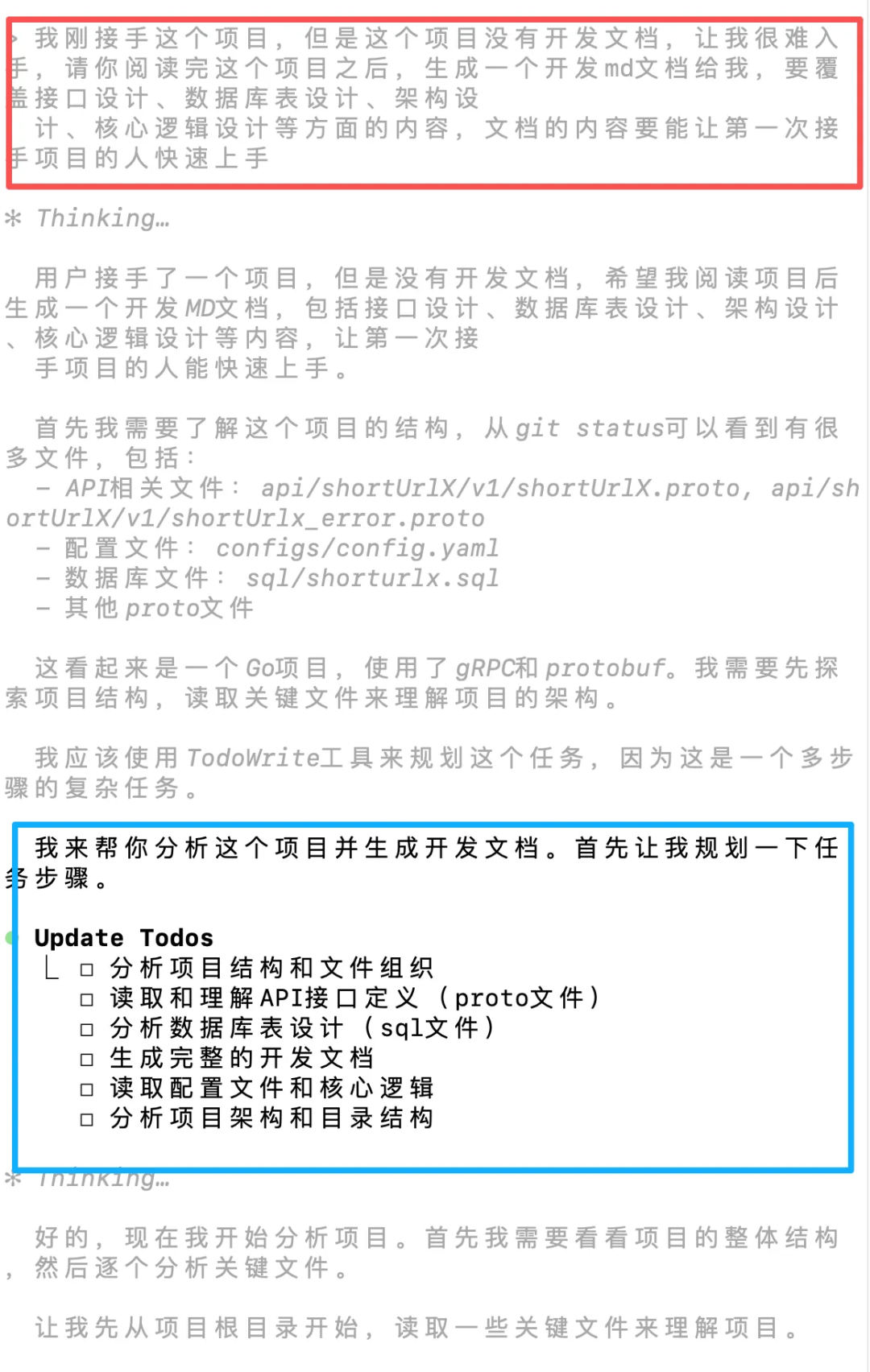

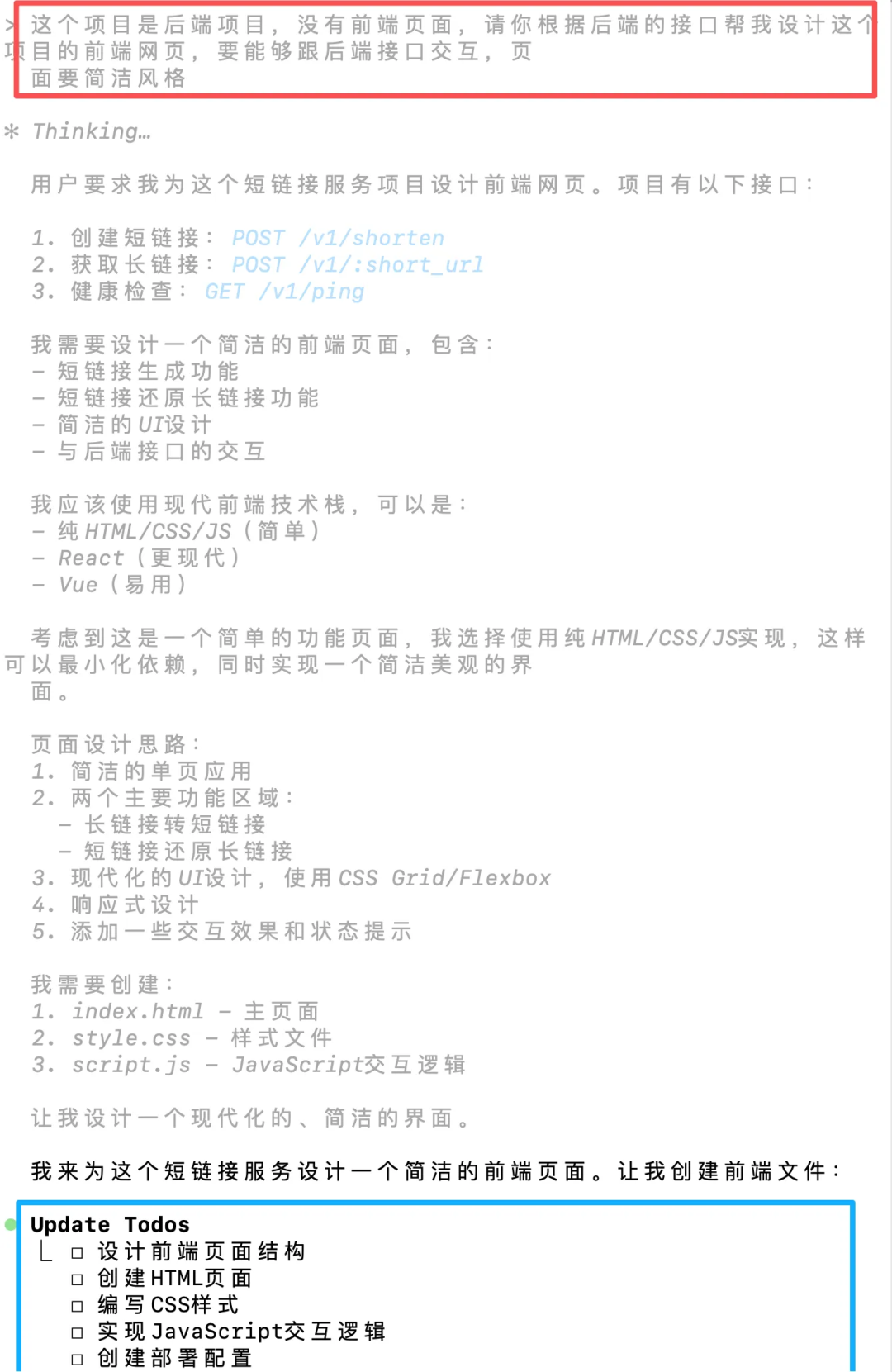

第三个挑战:根据已有后端代码,生成前端页面

在公司接手没文档的项目,那真叫一个痛苦,得自己啃代码理解,效率太低了。现在有了 AI,完全可以让它根据项目源码生成开发者文档,看文档上手肯定快多了。

那 M2 理解项目的效果怎么样?

我拿了个 Go 后端项目的源码给它,让它生成一个帮助开发者上手的文档,要求覆盖接口设计、数据库表设计、架构设计、核心逻辑设计等方面,能让第一次接手的人快速上手。

Prompt:我刚接手这个项目,但是这个项目没有开发文档,让我很难入手,请你阅读完这个项目之后,生成一个开发md文档给我,要覆盖接口设计、数据库表设计、架构设计、核心逻辑设计等方面的内容,文档的内容要能让第一次接手项目的人快速上手

很快,M2 就开始自己阅读项目源码,整理架构设计、接口设计、数据库表设计这些重要信息。

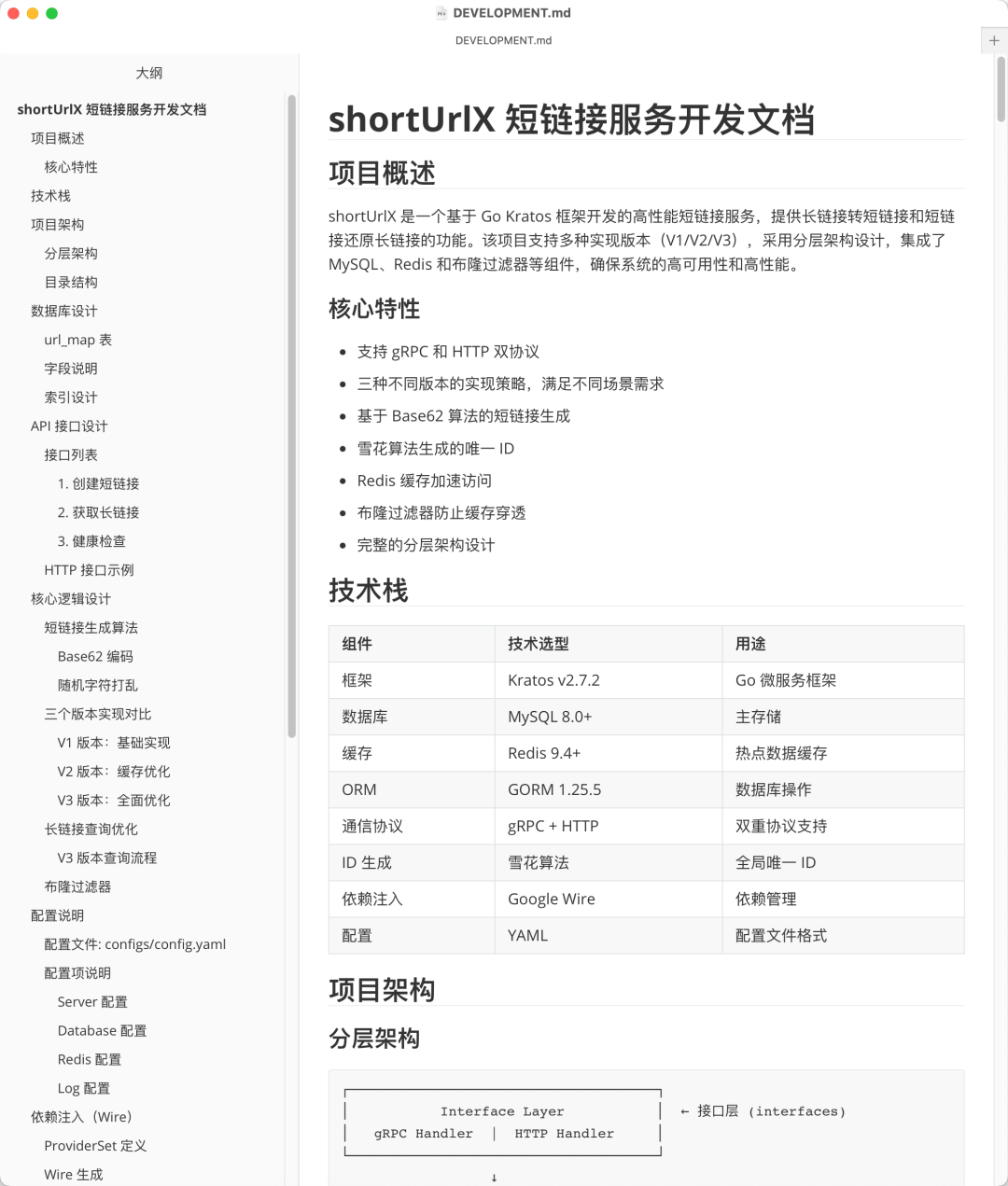

文档整理完后,我打开一看真的惊艳到了,将近 4000 字的内容,项目技术栈、分层结构、目录架构、数据库结构、API 接口等等都有说明。

看这么详细的文档上手项目,比自己啃代码快多了,甚至比我自己写的开发文档还详细。

我又让它根据后端已经实现的接口,设计对应的前端页面,要求能跟后端接口交互,页面风格简洁。

Prompt:这个项目是后端项目,没有前端页面,请你根据后端的接口帮我设计这个项目的前端网页,要能够跟后端接口交互,页面要简洁风格

M2 模型很聪明,先分析后端有几个接口,再根据接口实现对应的前端功能。这跟实际开发一样,前端工程师就是要根据后端接口的定义和输入输出来对接的。

实现的效果挺好看,我看了前端代码,确实有直接调用后端接口来生成短链。

前端页面开发完,剩下的就是把后端和前端代码部署到服务器上,一个完整的短链生成系统就成了。

是不是感觉很丝滑?我觉得以后后端开发工程师,借助 AI 真能轻松转成全栈工程师。

最后

测完这三个,我大概有底了。

为什么M2在代码上感觉不一样?我扒了下它的底,它不是个小模型,是个230B总参数的「专家混合」MoE模型,但每次激活参数只有10B。

这才是关键。意思就是它内部有很多专精某个领域的专家,你问代码问题,代码专家就出来干活;你让写报告,就换报告专家来,不是那种什么都懂一点但不精的通才。

但这还不是全部,MiniMax Agent 也跟着升级了,M2 现在是它的大脑。这就不是聊天了,是真能干活。

以前的 AI 顶多是代码生成器,你还得自己复制粘贴。现在 M2 驱动的 Agent 能完成编码、运行、调试的完整循环。你给个需求,它自己规划步骤,自己写代码,自己打开终端跑,跑不通看到报错,自己再改。

这才是 AI 工程师的雏形,这才叫 Agent,不是只会写花哨前端样式表的 Vibe Coding 工具。

M2 真正的杀手锏是价格和速度。官方说价格只有 Claude 4.5 的 8%,这哪是省钱啊,简直是质变。

以前跑一次完整测试的钱,现在能跑 12 次。这让 AI 驱动开发从偶尔试试的玩具,变成了随时能调用的工具。你甚至可以放心让它跑在 CI/CD 流程里,帮你审查每一行提交的代码。

速度也快,TPS 能到 100 左右,用起来很流畅,不会有喝口水等半天的憋屈感。

最关键的是,现在全球限时免费!

所以说,M2 这波不只是发布个新模型那么简单。它是用专精的代码能力、极端的成本优势、真正的 Agent 执行力这组合拳,宣告属于 AI 工程和系统的红利,正在中国被重新定义。

要用一句话介绍 M2,那就是一款紧凑、快速且性价比超强的模型,专为 Coding 和 Agent 而生。

说再多不如自己体验,去 agent.minimax.io 试试吧。

随便提什么任务都行,不用考虑 token 消耗,反正现在还在限时免费期呢。

更多推荐

已为社区贡献15条内容

已为社区贡献15条内容

所有评论(0)