ChatGPT不是万能的:不应该依赖AI的重要领域是什么?

【摘要】AI是增强人类能力的强大工具,而非全能替代品。在高风险决策、伦理、情感和创新领域,必须坚持人类主导,确保技术向善。

【摘要】AI是增强人类能力的强大工具,而非全能替代品。在高风险决策、伦理、情感和创新领域,必须坚持人类主导,确保技术向善。

引言

生成式人工智能,特别是以ChatGPT为代表的大语言模型(LLM),正以前所未有的速度渗透到各行各业。它们在内容生成、代码编写和信息检索等任务上的表现,确实令人印象深刻。然而,作为一名在技术一线工作多年的架构师,我看到的不仅是浪潮之巅的光鲜,更是水面之下的暗礁。技术圈内外的讨论,常常在“AI万能论”和“AI威胁论”之间摇摆。这两种极端观点都失之偏颇。

真正的工程实践,要求我们对工具的能力边界有清醒的认知。AI不是魔法,它是一个基于概率统计的复杂系统,有其固有的局限性。过度依赖甚至盲目信赖它,尤其在一些关键领域,不仅不负责任,甚至可能带来灾难性后果。这篇文章的目的,不是否定AI的价值,而是要划定清晰的“红线区”。我们要讨论的,是在哪些重要领域,人类的判断、责任和智慧必须处于不可动摇的核心地位。这关乎技术伦理,更关乎我们未来的社会形态。

❖ 一、高风险决策与专业判断领域

在这些领域,一个微小的错误可能导致生命、财产或自由的重大损失。AI可以作为高效的分析助手,但绝不能成为最终的决策者。责任的不可转移性是这里的核心原则。算法无法出庭受审,也无法承担法律或道义上的责任。

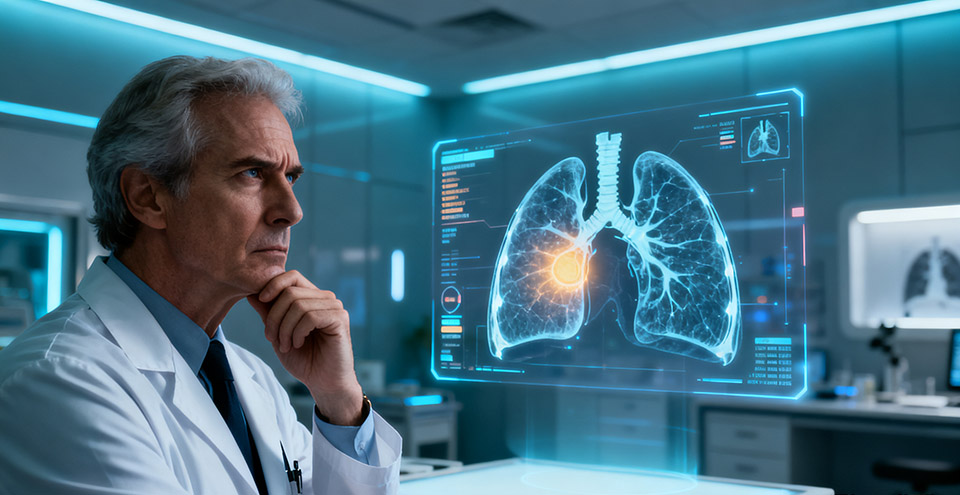

1.1 医疗与健康

AI在医疗领域的应用前景广阔,例如通过分析海量医学影像来辅助筛查病变。这极大地提升了效率。但我们必须明确,辅助不等于主导。

1.1.1 临床决策的复杂性

医疗决策是一个超越数据模式匹配的复杂过程。一名资深的临床医生做诊断时,考量的因素远超AI模型所能学习的范畴。

-

个体化差异:每个患者都是独特的。病史、遗传背景、生活习惯、药物过敏史、甚至心理状态,都会影响治疗方案的选择。AI模型训练所用的数据集,无论多大,都难以覆盖所有极端情况和“长尾”罕见病。

-

临床直觉:这并非玄学,而是医生基于多年经验,对非典型症状、微弱信号的敏锐捕捉。AI擅长识别强相关性,却可能将这些关键的“异常值”当作噪音过滤掉。

-

人文关怀:治疗不仅是技术行为,更是人与人之间的沟通。告知病情、安抚情绪、建立信任,这些充满同理心的互动是治疗过程的重要组成部分。AI生成的标准化话术,无法替代医生与患者之间真实的情感联结。

1.1.2 责任的最终归属

如果AI给出的诊疗建议出现错误,导致患者受到伤害,责任由谁承担?是算法开发者、医院,还是操作AI的医生?在法律和伦理上,这个责任链条是模糊的。因此,最终的诊断、处方和手术方案,必须由具备资质的人类医生签署并承担全部责任。这是保护患者安全的最后一道防线。

|

能力维度 |

AI辅助系统 |

人类医生 |

|---|---|---|

|

数据处理 |

强。快速分析海量影像、文献、病历数据。 |

弱。受限于个人精力和记忆力。 |

|

模式识别 |

强。精准识别标准化、高频出现的病变特征。 |

中。依赖经验,可能出现疲劳或疏忽。 |

|

罕见病诊断 |

弱。训练数据不足,易出现漏诊或误诊。 |

强。依赖临床直觉和跨学科知识。 |

|

伦理与沟通 |

无。无法进行道德权衡和情感交流。 |

核心能力。建立信任,提供人文关怀。 |

|

责任承担 |

无。无法作为法律和伦理主体。 |

核心责任。对最终决策负全部责任。 |

1.2 法律、司法与公共治理

将AI引入司法和公共治理领域,初衷是提升效率和减少人为偏见。但其内在的技术缺陷,可能反而会系统性地放大不公。

1.2.1 AI“幻觉”与事实污染

大语言模型的一个根本缺陷是“幻觉”(Hallucination),即一本正经地编造事实。它并非在“说谎”,而是其生成机制决定了它会输出概率上最合理的词语组合,而非经过事实核查的内容。在法律这个对事实准确性要求极为严苛的领域,这是致命的。已有真实案例显示,有律师直接使用ChatGPT生成的、包含虚假案例引用的法律文书,最终受到法庭的严厉处罚。

1.2.2 算法的“黑箱”困境

许多先进的AI模型,特别是深度学习网络,其决策过程如同一个“黑箱”,难以解释。当一个算法建议更长的刑期或拒绝一个人的保释申请时,我们无法清晰地追溯其决策逻辑。这与现代司法所要求的程序正义和可追溯性背道而驰。一个无法解释的判决,是无法令人信服的,也剥夺了当事人的有效上诉权。

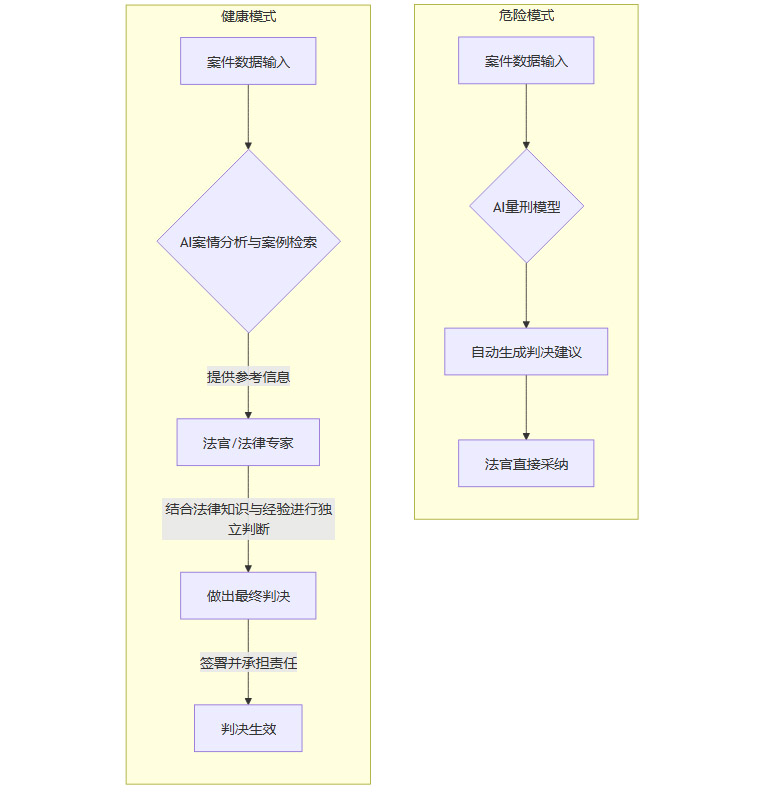

下面的Mermaid流程图展示了一个健康的“人机协同”司法流程,与一个危险的“AI主导”流程的对比。

1.2.3 专业能力的退化

对于初入行的青年律师或公务员,过度依赖AI完成文书撰写、案件分析等基础工作,会严重阻碍其专业技能的成长。批判性思维、逻辑推理和严谨的法律研究能力,是在反复的实践中磨练出来的。AI的“一键生成”剥夺了这个过程,可能导致整个行业的根基不稳。

1.3 财务、金融与关键基础设施

在金融交易、企业审计和电网控制等领域,系统的稳定性和可预测性是第一要务。

-

财务审计:财务工作不仅是数据核对,更包含对商业实质的判断和职业道德的坚守。AI可以高效处理海量账目,但难以洞察复杂的、经过伪装的财务欺诈。一个缺乏价值观的“智能工具”,无法履行审计师的信托责任。

-

金融风控:高频交易算法早已应用AI,但在信贷审批、风险定价等核心环节,模型偏见可能导致对特定人群的系统性歧视。同时,AI模型在面对前所未见的“黑天鹅”事件时,其行为是不可预测的,可能引发系统性的金融风险。

-

关键基础设施:电网、航空管制、核电站等系统的控制逻辑,必须是确定性和可验证的。我们不能用一个基于概率的、行为有随机性的AI模型,去掌管这些事关公共安全的系统。其核心控制回路,必须由经过严格形式化验证的传统软件来执行。

❖ 二、伦理道德与社会公平领域

AI本身没有价值观,它的“倾向”完全来自于其学习的数据。而这些数据,是人类社会现有偏见和不公的真实反映。因此,AI不仅会复现这些偏见,还可能将其固化和放大。

2.1 算法偏见与系统性歧视

算法偏见是AI伦理中最突出、最普遍的问题。

-

数据源头之罪:如果历史招聘数据显示男性工程师居多,AI模型在筛选简历时就可能无意识地“学会”偏好男性候选人,即便性别与工作能力毫无关系。这会形成一个恶性循环,加剧职场性别不平等。

-

代理变量的陷阱:即使算法被明确禁止使用种族、性别等敏感特征,它也可能通过邮政编码、消费习惯等代理变量(Proxy Variables),间接推断出这些信息,并据此做出歧视性决策。这种偏见更加隐蔽,难以发现和纠正。

-

规模化的不公:与单个人的偏见不同,算法的决策是系统性的、大规模的。一旦一个带有偏见的模型被部署到招聘、信贷或保险定价系统中,它会日复一日、成千上万次地执行不公平的决策,造成巨大的社会危害。

2.2 道德困境与价值判断

著名的“电车难题”是检验AI道德判断能力的经典思想实验。一辆失控的电车,是撞向一个人,还是转向撞向五个人?

对于人类,这是一个痛苦的道德两难。对于AI,这只是一个基于预设规则的计算。规则由谁设定?是工程师、企业,还是政府?一个在美国被认为是“正确”的设定,在另一个文化背景下可能完全无法接受。将复杂、多元的人类道德价值,简化为几行代码,本身就是一种危险的傲慢。自动驾驶汽车在面临不可避免的碰撞时,如何选择保护对象,至今仍是一个悬而未决的伦理和法律难题。

2.3 信息生态与社会信任

生成式AI和推荐算法正在重塑我们的信息环境,也带来了前所未有的挑战。

-

信息茧房:推荐算法通过不断推送用户感兴趣的内容,将人们包裹在个性化的“信息茧房”中。这会固化用户的既有观点,减少接触不同意见的机会,长期来看会加剧社会观点的极化和对立。

-

深度伪造(Deepfake):AI可以轻易制造出以假乱真的音视频内容。这不仅被用于诈骗和侵犯个人名誉,更有可能被用于制造虚假新闻、操纵舆论、甚至影响选举结果,严重侵蚀社会信任的根基。

-

责任溯源的困难:当虚假信息通过AI大规模传播时,追究其源头和法律责任变得异常困难。这为恶意行为者提供了便利,却让整个社会承担后果。

|

伦理风险 |

技术成因 |

社会后果 |

治理对策 |

|---|---|---|---|

|

算法偏见 |

训练数据不均衡、代理变量 |

加剧社会不公、系统性歧视 |

数据集审计、算法公平性测试、引入人工复核 |

|

道德困境 |

无法编码复杂的人类价值观 |

决策冷漠、引发伦理争议 |

设定明确的伦理红线、人类监督下的决策 |

|

虚假信息 |

生成式模型、深度伪造技术 |

侵蚀社会信任、操纵舆论 |

数字内容溯源技术、加强平台审核责任、公众教育 |

|

信息茧房 |

个性化推荐算法 |

社会观点极化、认知封闭 |

算法透明度、引入多元化推荐、用户自主选择权 |

❖ 三、情感交互与人文关怀领域

人类的情感和精神世界,是AI难以企及的领域。AI可以**模拟(Simulate)情感,但无法真正拥有(Possess)**情感。在需要深度共情和人性关怀的场景,AI只能是冰冷的辅助。

3.1 教育与人格塑造

AI可以成为很好的个性化学习工具,帮助学生练习知识点、批改作业。但教育的核心,远不止于知识的传授。

-

思维引导:一位优秀的教师,会通过提问、启发和引导,点燃学生的求知欲,培养其批判性思维。AI的回答往往是确定性的、收敛的,难以胜任这种开放式的、激发性的教学任务。

-

人格塑造:教师是学生的榜样。言传身教、为人处世、价值观的传递,对学生的人格成长至关重要。AI无法成为一个值得信赖和模仿的“人生导师”。

-

情感洞察:教师能通过观察学生的表情、语气和行为,洞察其学习状态和心理波动,并及时给予关心和支持。这种基于人性的微妙互动,是AI无法替代的。

3.2 艺术创作与文化传承

AI绘画、AI音乐已经能生成技术上无可挑剔的作品。但这些作品往往被批评为“华丽而空洞”,缺乏灵魂。

原因在于,伟大的艺术源于创作者独特的生命体验。爱、恨、痛苦、狂喜、对生死的思考,这些深刻的人类情感是创作的源泉。AI没有生命体验,它只能在海量的现有作品中学习风格和模式,进行巧妙的“重新组合”。它可以是一个技艺高超的“模仿者”,却难以成为一个开创流派的“创造者”。它能复制《蒙娜丽莎》的笔触,却无法理解那抹微笑背后的神秘。

3.3 心理咨询与社会服务

在心理咨询、临终关怀等领域,建立信任和情感联结是服务的核心。咨询师提供的不仅是解决方案,更是无条件的接纳、倾听和陪伴。AI生成的安慰话语,无论多么“善解人意”,本质上仍是程序的输出。当用户知道对话的另一端不是一个真实的人类时,那种深层次的信任感和安全感便无从建立。将人类最脆弱的精神世界,交给一个没有情感的算法,这本身就存在巨大的伦理风险。

❖ 四、原创创新与批判性思维领域

AI的强大之处在于对现有知识的归纳、总结和重组。它是一个卓越的“学习者”和“模仿者”,但并非一个真正的“思想者”。在需要从0到1的颠覆性创新领域,过度依赖AI无异于缘木求鱼。

4.1 “0到1”的创新鸿沟

大语言模型的核心工作原理是预测序列中下一个最可能的元素。这种机制决定了它的本质是“向后看”的。它基于海量的历史数据,寻找最常见的模式和关联。而真正的原始创新,恰恰是打破常规、挑战现有范式的行为。

-

灵感的非逻辑性:许多科学和艺术上的重大突破,源于一个不经意的联想、一个梦境、或是一个看似荒谬的“思想实验”。爱因斯坦思考追光者的速度,最终导向了相对论。这种跳跃性的、非逻辑的灵感火花,是AI基于概率的生成模型难以复现的。

-

趋同性风险:如果所有研究者都使用相同的AI工具进行文献分析和思路生成,产出的观点和方向很可能会趋于同质化。这会扼杀学术思想的多元性,导致整个科研生态陷入一种“局部最优”的陷阱,难以产生真正颠覆性的成果。

4.2 对“异常”的迟钝

科学史上,许多伟大的发现都始于对“异常现象”的关注。弗莱明发现青霉素,是因为他没有忽视培养皿里那块不寻常的霉菌。

AI系统通常被设计用来识别模式,而将异常视为需要被清洗的“噪音”。著名数学家丘成桐曾指出,重大的科学革命往往源于人脑对这些罕见但关键的信号的敏锐洞察。AI可能会因为训练数据中缺乏类似样本,而直接忽略掉这些通往新大陆的“航标”。

4.3 认知能力的“用进废退”

这是我认为最值得警惕的长期风险之一。人类大脑遵循“用进废退”的原则。当我们长期将核心的认知任务外包给AI时,我们自身相应的能力就会不可避免地退化。

-

批判性思维的钝化:习惯于接受AI提供的“标准答案”,会让我们逐渐丧失独立思考、质疑信息和多渠道核查的能力。

-

记忆与分析能力的衰退:正如GPS的普及让我们中的许多人丧失了读地图和记路的能力,过度依赖AI进行信息总结和分析,也会削弱我们自己的记忆、归纳和推理能力。麻省理工学院已有研究表明,长期依赖AI可能导致人类认知能力下降,大脑相关神经连接的强度会减弱。

这种认知上的“懒惰”是潜移默化的,其长期影响可能比任何一次技术故障都更为深远。

❖ 五、物理世界的高风险执行领域

在数字世界中,AI犯错的代价可能是一段错误的代码或一封不当的邮件。但在物理世界,其后果直接关乎生命和财产安全。

5.1 自动驾驶的“长尾问题”

自动驾驶是AI在物理世界应用的最典型代表。尽管技术进步显著,但它始终面临着棘手的“长尾问题”。这意味着,系统可以完美处理99.9%的常规路况,但总会遇到那0.1%的、从未在训练数据中出现过的极端场景。

-

一个被风吹到路中间的弹簧床。

-

一个cosplay成交通锥的行人。

-

前方货车掉落的形状奇特的货物。

在这些情况下,AI的感知系统可能完全失灵,做出灾难性的错误决策。而人类司机凭借常识和直觉,通常能更好地应对这类突发状况。因此,在实现完全可靠的L5级别自动驾驶之前,人类驾驶员的监督和随时接管的责任是不可或缺的。

5.2 工业与基础设施的可靠性要求

在矿山作业、电网调度、高精度制造等工业场景,系统的确定性和稳定性是压倒一切的要求。AI模型,特别是深度学习模型,其行为具有一定的随机性和不可解释性。在关键控制环节引入这种不确定性,是工程上难以接受的。这些领域可以利用AI进行状态监测、预测性维护和流程优化,但核心的执行和安全兜底,必须由经过严格验证的、行为完全可预测的传统控制系统和人类操作员来负责。

❖ 六、综合治理原则与实践路径

面对AI的局限与风险,我们需要的不是因噎废食,而是建立一套清晰、稳健的治理框架。这套框架应贯穿技术研发、产品部署和日常使用的全过程,确保AI始终是“可信、可知、可控”的。

6.1 核心治理原则

-

人类中心与最终责任:在任何高风险场景,最终决策权和责任必须由人类承担。AI的角色是辅助、建议和赋能,绝不能成为拥有终极裁量权的“黑箱裁判”。

-

风险分级管理:参照欧盟《人工智能法案》的思路,对不同应用场景的AI系统进行风险分级。对医疗、司法、关键基础设施等“高风险”应用,实施最严格的准入、审计和监管标准。

-

设计内嵌伦理与安全(Ethics & Safety by Design):在AI系统的设计和研发阶段,就必须将伦理考量、公平性原则和安全机制作为核心要素嵌入其中,而不是事后弥补。

-

透明与可解释性:尽可能提升AI决策过程的透明度。对于影响个人重大利益的决策,用户有权知道决策的依据,并拥有申诉和人工复核的渠道。

-

人机协同与监督:建立有效的“人类在环”(Human-in-the-loop)或“人类在侧”(Human-on-the-loop)机制。确保在AI系统运行的各个环节,都有人类的监督、干预和接管能力。

6.2 实践路径建议

|

实践环节 |

具体措施 |

目标 |

|---|---|---|

|

数据治理 |

对训练数据进行严格的偏见审计和清洗;确保数据来源的合规性与多样性。 |

从源头减少算法偏见。 |

|

模型开发 |

采用可解释性AI技术(XAI);进行充分的“红队演练”和对抗性测试。 |

提升模型的透明度和鲁棒性。 |

|

部署应用 |

实施“双人复核”或“人机复核”流程;建立清晰的责任追溯链条。 |

防止单点故障,确保责任可追溯。 |

|

持续监控 |

对线上运行的AI系统进行持续的性能和公平性监控,及时发现并修正“模型漂移”。 |

确保系统在真实环境中的长期稳定可靠。 |

|

社会共治 |

建立由技术专家、法律学者、伦理学家和公众代表组成的第三方监督机构。 |

推动开放、多元的AI治理生态。 |

结论

人工智能是一面镜子,它映照出我们已有的知识,也放大了我们固有的偏见。它是一个强大的效率倍增器,但不是智慧和责任的替代品。我们必须清醒地认识到,ChatGPT等AI工具的能力边界,恰恰是人类价值的核心地带——高阶的创造力、深刻的情感共鸣、复杂的道德权衡以及对最终结果的责任担当。

未来的发展路径,不是让AI替代人类,而是构建一种新型的、更深度的人机协同关系。在这个关系中,AI负责处理它擅长的海量数据和重复性任务,而人类则专注于那些机器无法胜任的、定义我们之所以为人的核心能力。将AI定位为强大的“副驾驶”,让人类始终牢牢掌握方向盘,这才是通往一个负责任、可持续的智能时代的唯一航道。

📢💻 【省心锐评】

AI是强大的副驾驶,但驾驶座必须留给人类。将责任外包给算法,不是技术进步,而是对人类智慧与勇气的背弃。

更多推荐

已为社区贡献264条内容

已为社区贡献264条内容

所有评论(0)