从CLI到Web的华丽转身——WebCodeCli如何让AI编程助手走进企业内网

《WebCodeCli:企业内网AI编程助手的CLI Web化解决方案》 面对企业内网环境对AI编程工具的安全合规需求,WebCodeCli创新性地将CLI工具Web化,解决了AI工具在内网部署的两大痛点:数据安全和使用门槛。该方案采用.NET 9的IAsyncEnumerable实现流式输出,为每个会话创建独立工作区确保安全隔离,支持一次性进程和持久化进程两种模式。相比AI IDE的封闭性,We

引言:当CLI遇上企业内网的高墙

在这个AI编程助手百花齐放的时代,GitHub Copilot、Cursor、Claude Code等工具已成为开发者的"第二大脑"。然而,当你兴致勃勃地向公司技术总监推荐这些神器时,往往会收到一个灵魂拷问:

"这些工具能在我们的内网环境部署吗?代码会不会泄露?"

是的,这就是企业级AI工具落地的第一道坎——安全合规。对于金融、政府、大型国企等行业,数据不出网不仅是技术要求,更是法律红线。而市面上大多数AI编程工具都是云端SaaS服务,需要将代码上传到公网,这让无数企业望而却步。

另一个痛点是命令行门槛。虽然开发者们对CLI工具爱不释手,但对于产品经理、测试工程师、甚至部分新手开发者来说,记忆复杂的命令参数、配置环境变量、切换不同工具,实在是一场"记忆力的马拉松"。

今天,我要介绍的WebCodeCli项目,正是为了解决这两大痛点而生。它的核心理念很简单:把强大的CLI工具包装成友好的Web界面,让它们可以在企业内网安全运行,同时降低使用门槛。

一、CLI工具的Web化:不是简单的"穿衣服"

1.1 为什么要给CLI工具穿"Web外衣"?

有人可能会问:CLI工具用得好好的,为啥非要Web化呢?这不是脱裤子放屁吗?

别急,让我们来算笔账:

| 维度 | 原生CLI | Web化后 |

|---|---|---|

| 使用门槛 | 需要记命令、配环境变量 | 浏览器打开即用 |

| 协作成本 | 输出难分享,历史难追溯 | 一键分享会话,历史自动归档 |

| 环境隔离 | 可能污染项目代码 | 独立工作区,完全隔离 |

| 多工具切换 | 需要反复输命令 | 下拉菜单一键切换 |

| 内网部署 | 需要每台机器安装 | 服务器部署一次,全员使用 |

看到了吗?Web化不是让CLI变慢,而是让它变强。就像给一辆跑车装上自动驾驶,性能没损失,但更多人能开了。

1.2 WebCodeCli的技术创新点

WebCodeCli不是简单地在CLI外面套个壳,而是做了深度的架构设计:

📌 创新一:流式输出技术

传统的Web后端通常是"请求-响应"模式:你问一句,它答一句,中间过程你看不到。但AI生成代码可能需要几十秒,用户盯着空白屏幕干等,体验极差。

WebCodeCli使用.NET 9的IAsyncEnumerable<T>实现真正的流式处理:

public async IAsyncEnumerable<StreamOutputChunk> ExecuteStreamAsync(

string sessionId, string toolId, string userPrompt,

[EnumeratorCancellation] CancellationToken cancellationToken = default)

{

// 启动CLI进程

var process = Process.Start(startInfo);

// 边读边返回,实时推送

await foreach (var chunk in ReadProcessOutputAsync(...))

{

yield return chunk; // 立即返回给前端

}

}

这样做的好处是:

-

低延迟:CLI工具输出一行,前端立即显示一行,延迟<100ms

-

高效率:不需要等CLI执行完才返回,避免大文件内存占用

-

好体验:打字机效果让用户看到进度,不会误以为卡死

就像看直播和看录播的区别——前者让你感觉"活着"。

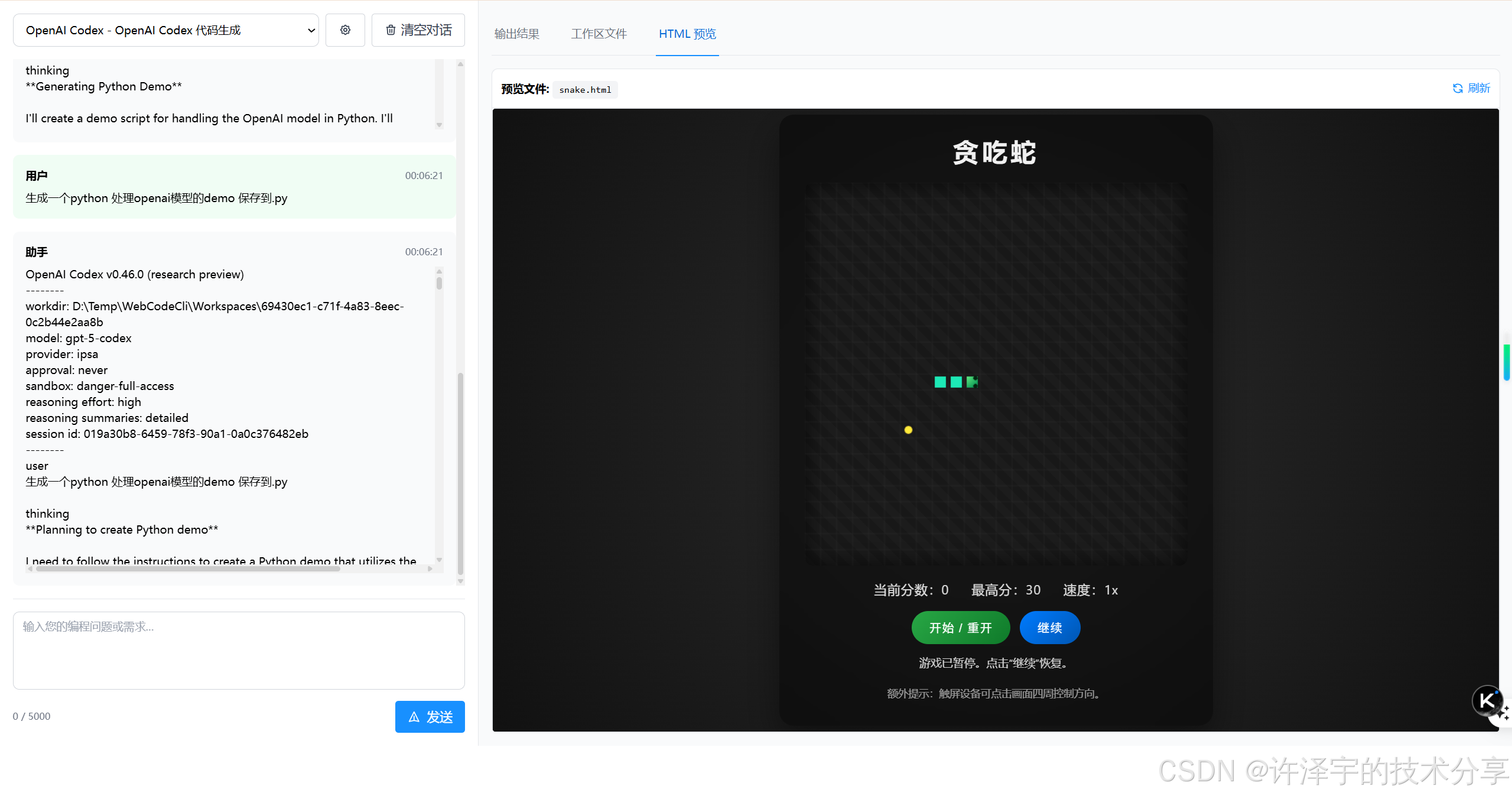

📌 创新二:会话工作区隔离

想象一个场景:你正在用AI生成测试脚本,突然发现它把你的项目代码也读进去了,还给你"优化"了一番。这酸爽,简直不敢想象。

WebCodeCli为每个会话创建独立的临时工作区:

D:\Temp\WebCodeCli\Workspaces\

├── {session-guid-1}/ ← 用户A的独立空间

├── {session-guid-2}/ ← 用户B的独立空间

└── {session-guid-3}/ ← 用户C的独立空间

核心代码:

private string GetOrCreateSessionWorkspace(string sessionId)

{

var workspacePath = Path.Combine(_options.TempWorkspaceRoot, sessionId);

if (!Directory.Exists(workspacePath))

{

Directory.CreateDirectory(workspacePath);

File.WriteAllText(

Path.Combine(workspacePath, ".workspace_info"),

$"Created: {DateTime.UtcNow}\nSessionId: {sessionId}"

);

}

return workspacePath;

}

CLI工具被强制在这个沙盒里运行,读不到你的项目代码,写不到你的系统目录。就像给每个租客分配了独立房间,互不干扰,退租后自动清理。

后台服务每小时扫描一次,自动清理超过24小时未使用的工作区:

public void CleanupExpiredWorkspaces()

{

var expirationTime = DateTime.UtcNow.AddHours(-24);

foreach (var dir in Directory.GetDirectories(_options.TempWorkspaceRoot))

{

var lastAccessTime = File.GetLastWriteTimeUtc(

Path.Combine(dir, ".workspace_info"));

if (lastAccessTime < expirationTime)

{

Directory.Delete(dir, recursive: true);

}

}

}

这种设计既保证了安全,又避免了磁盘空间被撑爆。

📌 创新三:双进程模式支持

并非所有CLI工具都是"一问一答"的模式。有些工具(如OpenAI Codex)支持交互式会话,可以记住上下文,连续对话。

WebCodeCli支持两种进程模式:

1. 一次性进程模式(适用于Claude、Copilot等)

// 每次请求启动新进程

var process = Process.Start(startInfo);

await foreach (var chunk in ReadStreamAsync(...))

{

yield return chunk;

}

process.Dispose(); // 执行完立即销毁

2. 持久化进程模式(适用于Codex等交互式工具)

// 首次请求创建进程,后续请求复用

var processInfo = _processManager.GetOrCreateProcess(...);

await _processManager.SendInputAsync(processInfo, userPrompt);

await foreach (var chunk in ReadPersistentProcessOutputAsync(...))

{

yield return chunk;

}

// 进程保持运行,等待下次输入

配置非常简单:

{

"Tools": [

{

"Id": "claude-code",

"UsePersistentProcess": false // 一次性模式

},

{

"Id": "codex",

"UsePersistentProcess": true, // 持久化模式

"PersistentModeArguments": "exec --sandbox danger-full-access --json \"{prompt}\""

}

]

}

这就像出租车和专车的区别:前者用完就走,后者包车待命。根据工具特性选择最优模式。

二、CLI对比AI IDE:各有千秋,术业有专攻

很多人会问:都2025年了,Cursor、Windsurf这些AI IDE这么香,为啥还要折腾CLI?

2.1 AI IDE的硬伤:被"锁"住的自由

AI IDE确实强大,但它们的核心问题是高度绑定:

| 限制类型 | 具体表现 | 影响 |

|---|---|---|

| 工具绑定 | 只能用内置模型 | 无法切换到公司自研AI |

| 网络依赖 | 必须联网才能用 | 内网环境直接歇菜 |

| 成本不可控 | 按token计费 | 大团队月费过万 |

| IDE锁定 | 必须用特定编辑器 | 不喜欢也得用 |

举个真实案例:某金融公司有自研的AI大模型(基于通义千问微调),专门理解金融业务代码。但Cursor、Copilot都不支持接入自定义模型,只能干瞪眼。

而WebCodeCli的CLI封装模式则完全不同:

{

"Tools": [

{

"Id": "company-ai",

"Name": "公司自研AI",

"Command": "company-ai-cli",

"ArgumentTemplate": "generate --prompt {prompt}",

"EnvironmentVariables": {

"API_ENDPOINT": "http://internal-ai.company.com"

}

}

]

}

只要你的AI工具有CLI接口,就能接入。这就是可扩展性的魅力。

2.2 CLI的独特优势:二次开发的自由

让我讲个故事:我之前在一家公司做内部开发平台,需要集成AI代码生成功能。如果用Cursor,我得让所有开发者换IDE;用Copilot,又绕不开GitHub账号。最后我们选择了Claude Code的CLI版本,做了这些定制:

-

代码规范检查:生成代码后自动跑ESLint、Prettier

-

安全扫描:调用内部安全工具扫描漏洞

-

自动提交:生成代码直接提交到内网GitLab的feature分支

-

通知集成:完成后通过企业微信通知团队

这些定制如果在Cursor里做,几乎不可能。但基于CLI,就是调用几个命令的事:

# 伪代码示例

claude code generate "实现用户登录功能" > login.ts

eslint --fix login.ts

safety-scan login.ts

git checkout -b feature/login-$(date +%s)

git add login.ts && git commit -m "AI生成登录功能"

git push origin feature/login-*

curl -X POST $WEIXIN_WEBHOOK -d "代码已生成,请review"

这就是CLI的"开放性"——你可以把它当成乐高积木,随意组合。

2.3 内网部署:企业的"刚需"

根据《数据安全法》和等保三级要求,金融、政府、大型国企的核心代码不能上传到公网。这不是技术问题,是法律红线。

| 行业 | 内网部署需求 | 原因 |

|---|---|---|

| 银行 | 强制要求 | 金融数据不出网 |

| 政府 | 强制要求 | 国家秘密不出境 |

| 国企 | 强制要求 | 关键基础设施保护 |

| 互联网大厂 | 推荐 | 商业机密保护 |

| 创业公司 | 可选 | 成本控制(避免SaaS订阅费) |

WebCodeCli天生就是为内网设计的:

完全离线运行:

{

"CliTools": {

"TempWorkspaceRoot": "/data/workspaces",

"MaxConcurrentExecutions": 10,

"Tools": [

{

"Id": "qwen-local",

"Command": "/opt/qwen-cli/bin/qwen",

"EnvironmentVariables": {

"MODEL_PATH": "/data/models/qwen-coder-7b"

}

}

]

}

}

部署在内网服务器上,所有数据都在局域网流转,符合安全合规要求。而且成本可控:

-

AI IDE:GitHub Copilot

6,000/年

-

WebCodeCli:一次性部署,无限用户,总成本 < $1,000(服务器硬件)

省下的钱够给团队搞次团建了。

三、技术架构深度解析:Blazor Server的妙用

3.1 为什么选择Blazor Server?

在前端框架满天飞的今天,选Blazor Server可能会被人质疑:"都什么年代了,还不前后端分离?"

但实际上,对于内网部署的场景,Blazor Server有着天然优势:

| 技术选型 | 传统方案(Vue/React + API) | Blazor Server |

|---|---|---|

| 开发效率 | 前端一套代码,后端一套代码 | C#全栈,代码复用 |

| 实时通信 | 需要手动配置WebSocket/SSE | SignalR内置,开箱即用 |

| 流式输出 | 需要手动实现 | IAsyncEnumerable原生支持 |

| 部署复杂度 | 需要Nginx+静态资源+API服务 | 单一程序,一键部署 |

| 网络优化 | 内网带宽足够,无需优化 | SignalR自动优化 |

内网环境下,带宽不是问题,延迟极低(<5ms),SignalR的实时推送性能甚至超过HTTP/2。而且C#全栈开发意味着:

-

一个团队搞定:不需要招前端+后端两拨人

-

类型安全:前后端共享模型,不会出现字段名不一致

-

调试方便:F5一键启动,前后端一起调试

3.2 核心服务架构

WebCodeCli采用经典的DDD(领域驱动设计)分层架构:

┌─────────────────────────────────────┐

│ Blazor组件层 (UI Layer) │

│ • 聊天界面 │

│ • 代码预览 │

│ • 文件管理 │

└──────────────┬──────────────────────┘

│ SignalR实时通信

┌──────────────▼──────────────────────┐

│ 应用服务层 (Application Layer) │

│ • ChatSessionService │

│ • 会话状态管理 │

└──────────────┬──────────────────────┘

│ 依赖注入

┌──────────────▼──────────────────────┐

│ 领域服务层 (Domain Layer) │

│ • CliExecutorService │

│ • PersistentProcessManager │

│ • WorkspaceCleanupService │

└──────────────┬──────────────────────┘

│ 进程调用

┌──────────────▼──────────────────────┐

│ 基础设施层 (Infrastructure) │

│ • CLI工具进程 │

│ • 文件系统 │

│ • 数据库(可选) │

└─────────────────────────────────────┘

核心服务:CliExecutorService

这是整个系统的心脏,负责:

-

管理CLI工具的生命周期

-

处理流式输出

-

维护会话工作区

-

防止注入攻击

来看一段关键代码:

[ServiceDescription(typeof(ICliExecutorService), ServiceLifetime.Singleton)]

public class CliExecutorService : ICliExecutorService

{

private readonly SemaphoreSlim _concurrencyLimiter;

private readonly Dictionary<string, string> _sessionWorkspaces;

private readonly PersistentProcessManager _processManager;

public async IAsyncEnumerable<StreamOutputChunk> ExecuteStreamAsync(

string sessionId, string toolId, string userPrompt,

[EnumeratorCancellation] CancellationToken cancellationToken)

{

// 1. 获取工具配置

var tool = GetTool(toolId);

// 2. 限流控制(防止资源耗尽)

await _concurrencyLimiter.WaitAsync(cancellationToken);

try

{

// 3. 创建会话工作区

var workspace = GetOrCreateSessionWorkspace(sessionId);

// 4. 参数转义(防止命令注入)

var safePrompt = EscapeArgument(userPrompt);

// 5. 启动进程并流式输出

await foreach (var chunk in ExecuteProcessStreamAsync(...))

{

yield return chunk;

}

}

finally

{

_concurrencyLimiter.Release();

}

}

}

注意几个细节:

① 并发控制:

private readonly SemaphoreSlim _concurrencyLimiter =

new SemaphoreSlim(maxConcurrent: 3);

防止恶意用户同时发起100个请求把服务器搞挂。就像餐厅限流,最多同时接待3桌客人。

② 命令注入防护:

private string EscapeArgument(string argument)

{

if (OperatingSystem.IsWindows())

{

return $"\"{argument.Replace("\"", "\\\"")}\"";

}

else

{

return $"'{argument.Replace("'", "'\\''")}'";

}

}

防止用户输入; rm -rf /这种骚操作。虽然有工作区隔离,但多一层保险总没错。

③ 超时控制:

using var timeoutCts = new CancellationTokenSource();

timeoutCts.CancelAfter(TimeSpan.FromSeconds(tool.TimeoutSeconds));

await process.WaitForExitAsync(timeoutCts.Token);

如果CLI工具卡死(比如等待用户输入),300秒后强制杀掉进程。避免僵尸进程占用资源。

3.3 流式输出的黑科技

传统的HTTP响应是一次性返回,而流式输出需要"边生成边返回"。.NET 9的IAsyncEnumerable<T>完美解决了这个问题:

public async IAsyncEnumerable<StreamOutputChunk> ReadStreamAsync(

StreamReader reader,

[EnumeratorCancellation] CancellationToken cancellationToken)

{

while (true)

{

var line = await reader.ReadLineAsync(cancellationToken);

if (line == null) break;

yield return new StreamOutputChunk

{

Content = line + Environment.NewLine,

IsCompleted = false

};

}

yield return new StreamOutputChunk { IsCompleted = true };

}

关键在于yield return,它会暂停函数执行,把数据返回给调用者,然后继续执行。就像一个传送带,读一行传一行,不需要等全部读完。

前端通过SignalR接收:

// Blazor组件

await foreach (var chunk in _cliExecutor.ExecuteStreamAsync(...))

{

_outputBuffer.Append(chunk.Content);

await InvokeAsync(StateHasChanged); // 触发UI更新

}

每次收到数据块,界面立即刷新,用户看到打字机效果,体验拉满。

四、实战应用场景:从理论到落地

4.1 场景一:金融公司代码审查

需求背景:某银行内网有自研的代码审查AI(基于文心一言训练),需要给开发团队提供统一的使用平台。

实施方案:

-

在内网服务器部署WebCodeCli

-

配置自研AI的CLI接口:

{

"Id": "bank-code-review",

"Name": "银行代码审查助手",

"Command": "/opt/bank-ai/bin/code-review",

"ArgumentTemplate": "--file {prompt} --rules /etc/bank-coding-standard.json",

"EnvironmentVariables": {

"AI_MODEL": "wenxin-finance-v2",

"API_KEY": "encrypted_key_here"

}

}

-

集成到GitLab Pipeline:

code_review_job:

script:

- curl -X POST http://webcodecli.internal.bank/api/chat/send \

-d '{"toolId":"bank-code-review","message":"review commit $CI_COMMIT_SHA"}'

效果:

-

代码review时间从2小时降到15分钟

-

所有数据不出内网,符合监管要求

-

开发者通过浏览器即可查看审查结果,无需安装CLI

4.2 场景二:政府项目需求分析

需求背景:某政府单位使用国产AI(ChatGLM)辅助需求文档生成,但开发人员不会配置环境。

实施方案:

{

"Id": "chatglm-local",

"Name": "国产AI助手",

"Command": "python",

"ArgumentTemplate": "/opt/chatglm/cli.py --prompt {prompt}",

"WorkingDirectory": "/opt/chatglm",

"EnvironmentVariables": {

"MODEL_PATH": "/data/models/chatglm-6b",

"CUDA_VISIBLE_DEVICES": "0"

}

}

效果:

-

产品经理也能用AI生成需求文档

-

IT部门只需维护一台服务器,不用给每个人装环境

-

完全离线运行,满足保密要求

4.3 场景三:互联网大厂多AI对比测试

需求背景:某大厂算法团队有3个自研AI模型,需要对比生成效果。

实施方案:

{

"Tools": [

{"Id": "model-a", "Name": "模型A(精度优先)", "Command": "ai-a"},

{"Id": "model-b", "Name": "模型B(速度优先)", "Command": "ai-b"},

{"Id": "model-c", "Name": "模型C(平衡版)", "Command": "ai-c"}

]

}

在WebCodeCli界面,用户可以快速切换模型,对比同一个prompt的不同输出,选出最优模型。

五、安全设计:多层防护体系

企业最关心的就是安全,WebCodeCli在这方面做了六层防护:

第一层:会话工作区隔离

每个会话独立目录,CLI工具只能访问自己的沙盒。

第二层:命令注入防护

用户输入经过严格转义,防止; rm -rf /等危险命令。

第三层:文件路径验证

var normalizedWorkspace = Path.GetFullPath(workspacePath);

var normalizedFile = Path.GetFullPath(fullPath);

if (!normalizedFile.StartsWith(normalizedWorkspace))

{

throw new SecurityException("尝试访问工作区外的文件");

}

防止../../../etc/passwd这种路径遍历攻击。

第四层:并发和超时控制

-

最多同时执行N个CLI进程(默认3个)

-

单次执行最长时间限制(默认300秒)

-

防止资源耗尽攻击

第五层:环境变量加密存储

API Key等敏感信息加密存储到数据库:

public async Task<bool> SaveEnvironmentVariablesAsync(

string toolId, Dictionary<string, string> envVars)

{

var json = JsonSerializer.Serialize(envVars);

var encrypted = AesEncryption.Encrypt(json, _encryptionKey);

await _db.Insertable(new CliToolEnvironment {

ToolId = toolId,

EnvironmentVariablesJson = encrypted

}).ExecuteCommandAsync();

}

第六层:审计日志

所有操作都记录日志,便于追溯:

[2025-10-31 10:30:15] User:zhangsan Session:abc123 Tool:claude Prompt:"生成登录功能"

[2025-10-31 10:30:45] Session:abc123 Completed ExitCode:0 Duration:30s

六、性能优化:从原理到实践

6.1 流式处理的性能优势

传统方案:

CLI执行完(30s) → 一次性返回 → 用户看到结果

等待时间:30秒

流式方案:

CLI输出第1行(0.1s) → 立即返回 → 用户看到第1行

CLI输出第2行(0.2s) → 立即返回 → 用户看到第2行

...

等待时间:0.1秒(首屏)

内存占用对比:

-

传统方案:需要缓存完整输出(可能几MB)

-

流式方案:每次只处理一行(几KB),立即释放

6.2 并发控制的取舍

为什么限制最多3个并发?

假设:

-

每个CLI进程占用500MB内存

-

服务器总内存8GB,系统+其他服务占用4GB

-

可用内存:4GB

如果不限制并发,10个用户同时请求 = 5GB内存 → 服务器OOM崩溃。

使用SemaphoreSlim限流:

private readonly SemaphoreSlim _concurrencyLimiter = new(3);

await _concurrencyLimiter.WaitAsync(); // 超过3个会排队等待

try

{

// 执行CLI

}

finally

{

_concurrencyLimiter.Release();

}

前3个请求立即执行,第4个请求排队,第1个完成后第4个才开始。虽然有延迟,但不会崩溃。

6.3 工作区清理策略

如果每个会话都创建目录,不清理会怎样?

假设:

-

每天100个会话

-

每个会话产生100MB文件

-

1年 = 365 × 100 × 100MB = 3.6TB

磁盘爆满,系统瘫痪。

解决方案:后台定时清理

public class WorkspaceCleanupBackgroundService : BackgroundService

{

protected override async Task ExecuteAsync(CancellationToken stoppingToken)

{

while (!stoppingToken.IsCancellationRequested)

{

CleanupExpiredWorkspaces(); // 清理24小时前的工作区

await Task.Delay(TimeSpan.FromHours(1), stoppingToken);

}

}

}

每小时清理一次,保留最近24小时的数据,平衡了可追溯性和磁盘空间。

七、未来展望:从工具到平台

WebCodeCli现在只是一个CLI工具的Web封装,但它的潜力远不止于此。未来可以扩展为:

7.1 企业AI开发平台

当前:单纯的CLI执行工具 未来:集成更多能力

-

GitLab/GitHub API集成:AI生成代码后自动提PR

-

企业微信/钉钉通知:代码生成完成自动通知

-

代码质量门禁:生成代码自动跑测试和Lint

-

知识库管理:优秀对话归档,团队共享

7.2 AI Agent编排中心

不只是调用单个AI工具,而是编排多个AI协作:

用户需求:"开发一个用户管理模块"

↓

Agent 1(需求分析AI) → 生成需求文档

↓

Agent 2(架构设计AI) → 生成技术方案

↓

Agent 3(代码生成AI) → 生成代码

↓

Agent 4(测试AI) → 生成单元测试

↓

Agent 5(文档AI) → 生成API文档

整个过程自动化,开发者只需确认和微调。

7.3 低代码/无代码演进

进一步降低门槛,让非技术人员也能用AI生成代码:

产品经理:通过拖拽画出页面原型

↓

WebCodeCli自动生成prompt:"根据这个原型生成Vue组件"

↓

AI生成代码

↓

一键部署到测试环境

从"会写prompt"降低到"会拖拽",真正的全民AI编程。

八、总结:技术选型的哲学

回到最初的问题:为什么要做WebCodeCli?

不是因为CLI不好,而是因为不同场景需要不同工具:

| 场景 | 最佳选择 | 原因 |

|---|---|---|

| 个人开发者 | Cursor、Copilot | 体验最优,深度集成 |

| 开源爱好者 | Claude CLI | 免费、灵活 |

| 中小企业内网 | WebCodeCli | 成本低、易部署、可定制 |

| 大型企业 | Tabnine Enterprise | 功能完整、支持完善 |

WebCodeCli的定位很清晰:为内网环境提供轻量级AI编程助手平台。

它不是要替代Cursor,而是在Cursor无法使用的场景下,提供一个性价比极高的替代方案。

技术亮点回顾

-

✅ 流式输出技术:IAsyncEnumerable实现打字机效果

-

✅ 会话工作区隔离:独立沙盒保证安全

-

✅ 双进程模式:支持一次性和持久化两种执行方式

-

✅ 多层安全防护:从注入防护到审计日志

-

✅ Blazor Server架构:C#全栈开发,部署简单

写在最后

技术的意义不在于炫技,而在于解决实际问题。

WebCodeCli可能不是最炫酷的技术,但它解决了企业内网AI工具落地的真实痛点。如果你的公司也面临同样的困境,不妨试试这个方案。

如果你是个人开发者,看完这篇文章能学到:

-

如何优雅地封装CLI工具

-

如何实现流式输出

-

如何设计安全的工作区隔离

-

如何用Blazor Server构建实时Web应用

技术服务于业务,工具服务于人。这是我写这个项目的初心,也是我写这篇文章的目的。

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)