【Python大数据+AI毕设实战】豆瓣高分电影数据可视化分析系统、Hadoop、计算机毕业设计、包括数据爬取、数据分析、数据可视化、机器学习、实战教学

【Python大数据+AI毕设实战】豆瓣高分电影数据可视化分析系统、Hadoop、计算机毕业设计、包括数据爬取、数据分析、数据可视化、机器学习、实战教学

🍊作者:计算机毕设匠心工作室

🍊简介:毕业后就一直专业从事计算机软件程序开发,至今也有8年工作经验。擅长Java、Python、微信小程序、安卓、大数据、PHP、.NET|C#、Golang等。

擅长:按照需求定制化开发项目、 源码、对代码进行完整讲解、文档撰写、ppt制作。

🍊心愿:点赞 👍 收藏 ⭐评论 📝

👇🏻 精彩专栏推荐订阅 👇🏻 不然下次找不到哟~

Java实战项目

Python实战项目

微信小程序|安卓实战项目

大数据实战项目

PHP|C#.NET|Golang实战项目

🍅 ↓↓文末获取源码联系↓↓🍅

这里写目录标题

基于大数据的豆瓣高分电影数据可视化分析系统-功能介绍

《Python大数据+AI毕设实战:豆瓣高分电影数据可视化分析系统》是一个综合性的数据处理与分析平台,旨在深度挖掘豆瓣电影高分榜单背后隐藏的价值与规律。本系统以Python作为主要开发语言,后端采用轻量高效的Django框架,前端则借助Vue与Echarts技术,为用户呈现直观、动态的可视化图表。其核心数据处理引擎构建于强大的大数据技术栈之上,利用Hadoop(HDFS)作为分布式文件系统存储原始数据集,并全面采用Spark框架进行海量数据的并行计算与分析。系统首先通过Spark对包含2600余条电影记录的复杂文本数据进行精细化的预处理与清洗,从“人员”、“时长”等非结构化字段中精准提取出导演、演员、类型、年份、国家、时长等关键信息。随后,系统运用Spark SQL执行多达15项分析任务,涵盖了评分分布、类型热度、导演产量、演员影响力、年份趋势等多个维度。特别地,系统还引入了K-means聚类算法,对高分电影的多维特征进行机器学习分析,尝试发现不同成功模式的电影群体,从而为数据分析提供AI视角。所有分析结果最终被存储至MySQL数据库,并通过Django后端API与前端Echarts进行交互,实现了一个从数据采集、清洗、存储、计算分析到最终可视化呈现的完整大数据处理链路。

基于大数据的豆瓣高分电影数据可视化分析系统-选题背景意义

选题背景

平时我们想找一部好电影看,很自然地就会去翻看豆瓣的高分榜单,觉得分数高的电影总不会差。但这背后其实有很多值得琢磨的地方,比如,是不是某个年代的电影特别容易出高分?美国大片和日本动漫哪个类型的高分作品更多?那些我们熟知的导演,比如宫崎骏或者诺兰,他们的高分作品到底占了多大比例?这些问题如果只靠一页一页地翻看网页,很难得出一个直观且准确的结论。说白了,我们面对的是一堆看似杂乱但蕴含价值的数据,而传统的手工统计或者简单的Excel处理方式,在面对稍微复杂一点的文本解析和数据关联时就显得力不从心了。咱们这个课题的背景,正是源于这种“想看透数据,但缺少称手工具”的普遍场景。利用现在比较成熟的大数据技术,比如Spark,去自动化地处理和分析这些电影数据,不仅能满足我们自己的好奇心,也是一次把课堂上学到的计算机知识应用到真实有趣问题上的绝佳实践。

选题意义

首先得明确,这毕竟只是一个毕业设计,它的首要意义还是在于对我们大学四年所学知识的一次综合检验和能力锻炼。从这个角度看,这个系统的价值是实实在在的。它不像一些纯理论或者功能单一的项目,而是完整地贯穿了数据处理的全过程。从一开始接触到存储在Hadoop上的原始数据,到使用PySpark和Pandas进行繁琐但必要的数据清洗和预处理,再到运用Spark SQL进行核心的聚合、关联分析,最后通过Django后端框架把数据封装成API接口,交给前端Vue和Echarts进行可视化。这整个流程走下来,对于我们理解大数据项目是如何运作的、Python如何在其中扮演“胶水”角色,以及前后端如何协作,都有非常大的帮助。它让我们不仅仅是做了个“增删改查”的管理系统,更是亲手实践了一把大数据分析的真功夫。另外,通过对电影数据的分析,我们也能学会如何从业务角度提出问题,并用技术手段去寻找答案,这种数据思维的培养,可能比单纯掌握某个框架更有长远的价值。从更小的方面说,这个项目的结果也能为同样喜欢看电影的同学提供一个有点意思的数据参考,算是一次比较有趣且学有所获的尝试。

基于大数据的豆瓣高分电影数据可视化分析系统-技术选型

大数据框架:Hadoop+Spark(本次没用Hive,支持定制)

开发语言:Python+Java(两个版本都支持)

后端框架:Django+Spring Boot(Spring+SpringMVC+Mybatis)(两个版本都支持)

前端:Vue+ElementUI+Echarts+HTML+CSS+JavaScript+jQuery

详细技术点:Hadoop、HDFS、Spark、Spark SQL、Pandas、NumPy

数据库:MySQL

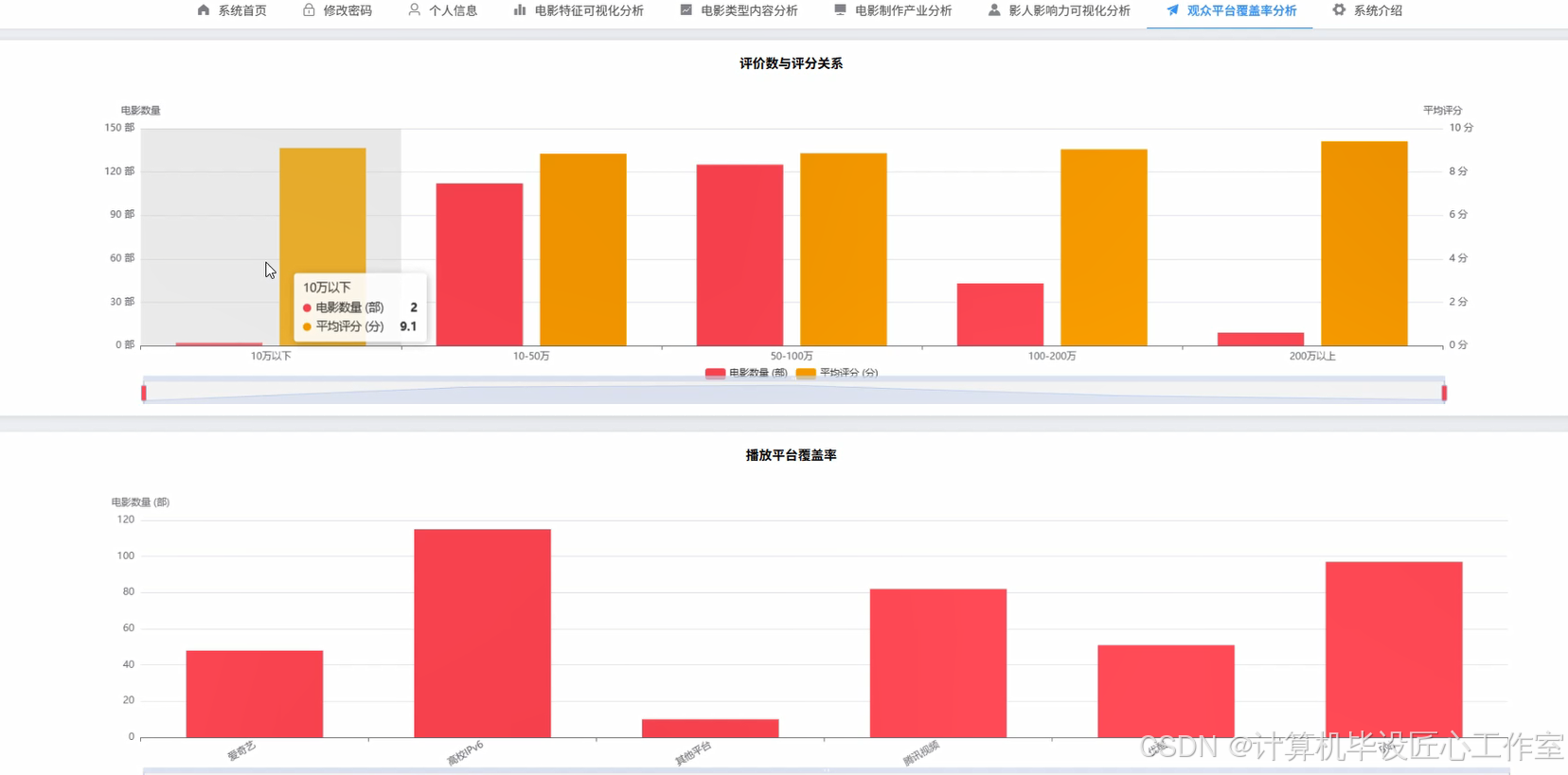

基于大数据的豆瓣高分电影数据可视化分析系统-图片展示

基于大数据的豆瓣高分电影数据可视化分析系统-代码展示

from pyspark.sql import SparkSession

from pyspark.sql.functions import udf, col, explode, split, regexp_extract, year

from pyspark.sql.types import StringType, IntegerType

from pyspark.ml.feature import VectorAssembler

from pyspark.ml.clustering import KMeans

# 初始化SparkSession,这是所有Spark应用的入口

spark = SparkSession.builder.appName("DoubanMovieAnalysis").master("local[*]").getOrCreate()

# 假设数据已经加载到名为df的DataFrame中,并包含'人员'、'评分'、'评价数'、'时长'等列

# df = spark.read.csv("hdfs:///path/to/your/douban_movie.csv", header=True, inferSchema=True)

# --------------------- 1. 电影类型热门度分析核心代码 ---------------------

def movie_type_popularity_analysis(df):

"""

分析电影类型,统计各类型的数量并排序。

这是一个典型的ETL过程:提取(Extract)、转换(Transform)、加载(Load)。

"""

print("开始执行电影类型热门度分析...")

# 使用正则表达式从'人员'字段中提取出类型信息

# 比如 '... 类型: 剧情 / 犯罪 / 悬疑 ...' -> '剧情 / 犯罪 / 悬疑'

df_with_type = df.withColumn("type_str", regexp_extract(col("人员"), r"类型: (.*?)\n", 1))

# 过滤掉没有提取到类型信息的记录

df_with_type = df_with_type.filter(col("type_str") != "")

# 将'剧情 / 犯罪'这样的字符串,按'/'分割成数组['剧情', '犯罪']

df_with_type_array = df_with_type.withColumn("type_array", split(col("type_str"), " / "))

# 使用explode函数,将数组中的每个元素炸裂成独立的一行

# 原来的一行 '剧情 / 犯罪' 会变成两行,一行是'剧情',一行是'犯罪'

df_exploded = df_with_type_array.withColumn("genre", explode(col("type_array")))

# 按新的'genre'列进行分组,并统计每个类型的数量

genre_counts = df_exploded.groupBy("genre").count()

# 为了结果更清晰,按数量降序排列

popular_genres = genre_counts.orderBy(col("count").desc())

# 打印部分结果到控制台,实际应用中会保存到MySQL或HDFS

popular_genres.show(10, truncate=False)

# 返回结果DataFrame,便于后续保存或进一步处理

return popular_genres

# --------------------- 2. 导演高分作品统计分析核心代码 ---------------------

def director_works_analysis(df):

"""

分析导演,统计每位导演的高分电影数量。

这个过程和类型分析类似,关键在于准确提取导演名。

"""

print("开始执行导演作品统计分析...")

# 从'人员'字段中提取导演信息,处理多导演情况

# 格式通常是 '导演: 弗兰克·德拉邦特 Frank Darabont ...'

df_with_director = df.withColumn("director_str", regexp_extract(col("人员"), r"导演: (.*?)\s", 1))

# 过滤掉没有导演信息的行

df_with_director = df_with_director.filter(col("director_str") != "")

# 同样地,处理多导演情况,按'/'分割

df_with_director_array = df_with_director.withColumn("director_array", split(col("director_str"), "/"))

# 将导演数组炸裂成多行

df_director_exploded = df_with_director_array.withColumn("director", explode(col("director_array")))

# 对导演姓名进行分组计数

director_counts = df_director_exploded.groupBy("director").count()

# 按作品数量降序排序,找出最高产的优质导演

top_directors = director_counts.orderBy(col("count").desc())

# 展示排名前10的导演及其作品数

top_directors.show(10, truncate=False)

# 返回分析结果

return top_directors

# --------------------- 3. 高评价电影特征聚类分析核心代码 (AI功能) ---------------------

def movie_feature_clustering_analysis(df):

"""

使用K-means算法对电影进行聚类,发现不同特征的电影群体。

这是一个简单的机器学习应用,体现了AI分析能力。

"""

print("开始执行高评价电影特征聚类分析...")

# 数据预处理:需要将用于聚类的字段转为数值类型,并处理空值

# 假设'评分', '评价数', '年份', '时长'已经是数值类型

# 此处省略复杂的清洗步骤,直接选择列

# 选取用于聚类的特征

feature_columns = ['评分', '评价数', '年份', '时长']

# 将特征列合并成一个向量列,这是ML库的标准要求

assembler = VectorAssembler(inputCols=feature_columns, outputCol="features")

# 对数据进行转换

assembled_data = assembler.transform(df)

# 初始化K-Means模型,设定聚类数量为5

kmeans = KMeans().setK(5).setSeed(1).setFeaturesCol("features").setPredictionCol("cluster_id")

# 训练模型

model = kmeans.fit(assembled_data)

# 对数据集进行预测,生成每个电影的簇ID

predictions = model.transform(assembled_data)

# 查看每个簇的中心点,了解每个簇的特征

centers = model.clusterCenters()

print("聚类中心点: ")

for center in centers:

print(center)

# 选择关键列和聚类结果进行展示

final_result = predictions.select('标题', '评分', '评价数', '年份', '时长', 'cluster_id')

final_result.show(20, truncate=False)

# 返回带有聚类标签的结果

return final_result

# 示例调用(在实际项目中,df会从HDFS加载)

# movie_type_popularity_analysis(df)

# director_works_analysis(df)

# movie_feature_clustering_analysis(df)

# 关闭SparkSession

spark.stop()

基于大数据的豆瓣高分电影数据可视化分析系统-结语

👇🏻 精彩专栏推荐订阅 👇🏻 不然下次找不到哟~

Java实战项目

Python实战项目

微信小程序|安卓实战项目

大数据实战项目

PHP|C#.NET|Golang实战项目

🍅 主页获取源码联系🍅

更多推荐

已为社区贡献28条内容

已为社区贡献28条内容

所有评论(0)