hLife | AI辅助疾病诊断的信任之路

目前,许多表现优异的AI,其内部运作机制如同一个“黑箱”。而为了促进临床接纳,关键在于将AI明确为医生的辅助工具而非替代者,让一线医生深度参与AI系统的开发与验证,以其在减轻工作负担、提高效率方面的显著价值,逐步消除医生对技术可靠性的疑虑,最终实现医疗AI从“技术驱动”向“临床导向”的转变。in AI-assisted disease diagnosis”的观点文章(图1),从责任划分、数据伦理、

“任何足够先进的技术都与魔法无异。”——亚瑟·克拉克

亚瑟·克拉克的这句名言,生动地描绘了当前人工智能(AI)在疾病诊断领域所遇到的困难。AI在医疗诊断领域展现出惊人的潜力。从识别早期肿瘤到辅助罕见病诊断,AI不仅提高了识别的效率,更在多项指标上超越人类专家。然而,这项堪比“魔法”的技术在走向临床应用时却遇到了重重阻力。如何化解这些阻力,并建立信任,是其能否真正惠及病患的关键。

近日,中国科学院自动化研究所董迪研究团队在hLife发表了题为“Forging trust in AI-assisted disease diagnosis”的观点文章(图1),从责任划分、数据伦理、可解释性等方面梳理了AI在医疗诊断应用中面临的挑战,并探讨了AI通往未来“人机共生”医疗生态的路线。

图1 论文标题及作者信息

AI作为具有大量参数和复杂结构的深度学习模型,在诊断领域的表现堪称“超级专家”。它能存储大量的医学知识,从海量数据中学习,在庞杂的医疗影像中,捕捉到人眼难以察觉的关键信息,实现疾病的精准诊断。此外,AI能够不知疲倦地处理海量病例,极大提升诊断效率。同时,其可复制性让优质诊断资源下沉至偏远地区成为可能,为解决医疗资源不均问题提供了新途径。

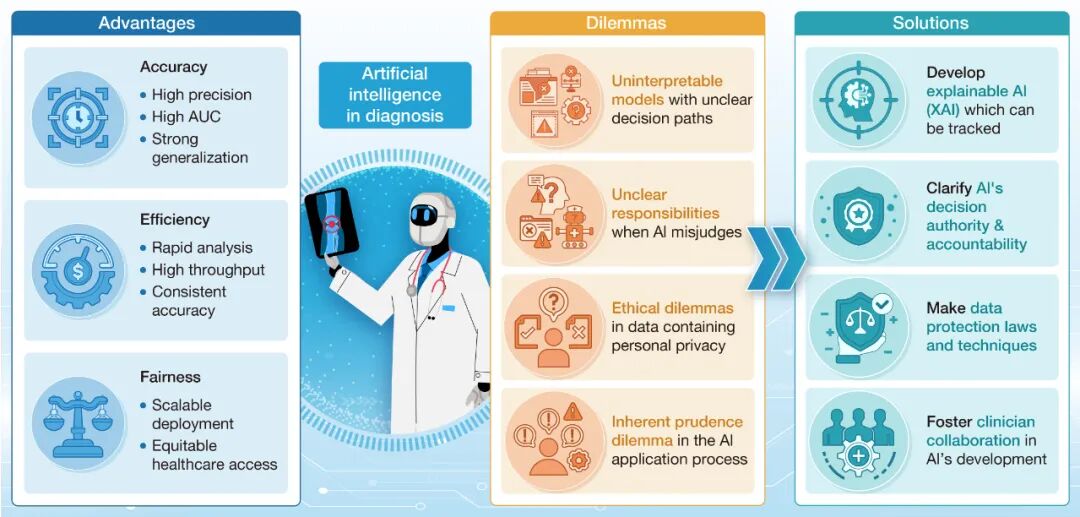

尽管AI在疾病诊断上潜力巨大,但作为一项新兴技术,因其“黑箱”运作、责任归属不明和数据安全等现实挑战,其大规模临床应用之路仍困难重重。目前,许多表现优异的AI,其内部运作机制如同一个“黑箱”。尽管AI能给出准确的诊断建议,但其决策路径常常模糊不清、难以追踪。这种“知其然而不知其所以然”的特性,是横亘在AI与临床信任之间的第一道鸿沟。其次,责任归属的模糊性构成了深刻的伦理与法律困境。当AI系统出现误判导致严重后果时,责任主体是采纳建议的医生、算法的开发机构还是部署系统的医院?现有法规尚未对这种“人机协作”下的医疗差错责任分配给出明确指引。再者,数据隐私保护和算法公平性是不可逾越的红线。AI模型的训练依赖大规模医疗数据,如何在利用数据的同时确保其安全与合规,是一大挑战。同时,训练数据的偏差可能导致AI模型产生系统性偏见,对特定人群的诊断准确性较低,从而加剧医疗不公。最后,医学界固有的审慎性与AI技术的快速迭代形成冲突,新技术引入临床必须经过严格验证,而医生群体对新工作模式的适应也需要克服重重障碍(图2)。

图2 人工智能辅助疾病诊断:优势、困境与解决方案

面对这些看似棘手的难题,学术界、产业界和监管机构已在积极探索应对之道,旨在为AI铺就一条通往临床信任的坚实道路。针对“黑箱”问题,可解释人工智能(XAI)的研究已成为重要方向,通过注意力热力图、思维链等技术,使AI的决策过程更加清晰透明,从而化解因“不可知”而产生的疑虑。对于责任归属这一难题,短期来看最可行的方案是将AI定位为高级辅助工具,其输出结果需经人类医生最终确认,决策权和法律责任仍由医生承担,同时积极探索界定AI法律角色的新框架。在数据治理层面,可在GDPR、HIPAA等现有法规基础上,发展针对AI的隐私保护法规,并通过公平性度量、再采样、对抗去偏训练等方法,系统性地评估和减轻模型偏见。而为了促进临床接纳,关键在于将AI明确为医生的辅助工具而非替代者,让一线医生深度参与AI系统的开发与验证,以其在减轻工作负担、提高效率方面的显著价值,逐步消除医生对技术可靠性的疑虑,最终实现医疗AI从“技术驱动”向“临床导向”的转变。通过这种多维度的协作,AI终将成为医疗体系中不可或缺的可靠伙伴。

✦ +

+

作者简介

张杨志豪 硕士研究生

第一作者

机构:中国科学院自动化研究所

研究方向:医学影像大数据分析

方梦捷 助理研究员

第一作者

机构:中国科学院自动化研究所

研究方向:医学影像大数据分析

董迪 研究员

通讯作者

机构:中国科学院自动化研究所

研究方向:医学影像大数据分析

引用格式:Zhang Y, Fang M, Feng X, et al. Forging trust in AI-assisted disease diagnosis. hLife 2025; https://doi.org/10.1016/j.hlife.2025.05.011.

更多推荐

已为社区贡献4条内容

已为社区贡献4条内容

所有评论(0)