揭秘中国AI大模型:架构与逻辑全解析

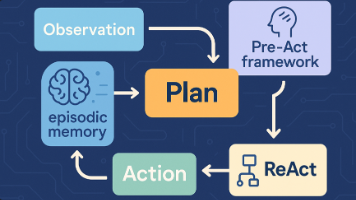

本文系统解析了中国大型语言模型(如文心一言、通义千问)的底层架构与运作逻辑。核心要点包括:1)基于Transformer的架构创新,包括自编码、自回归及混合专家系统等类型;2)关键组件如多头注意力机制和位置编码的优化设计;3)训练与推理流程,涵盖预训练、微调和概率生成策略。中国模型通过汉字嵌入优化、分布式训练框架及多模态整合等特色技术,显著提升了中文处理能力和计算效率。这些进展为中国在AI领域的竞

中国在人工智能领域的发展迅速,大型语言模型(大模型)如文心一言(百度)、通义千问(阿里)等已成为核心技术。这些模型基于Transformer架构,通过海量数据训练实现智能推理。本文将逐步解析其底层架构与逻辑,帮助读者深入理解中国大模型的运作机制。

一、底层架构基础

1.1 主流架构类型与演进趋势

大语言模型(LLM)的架构基础源于Transformer模型,但经过多年发展已形成独特的体系。以下从多个维度解析大模型的架构基础:

1.1.1 主流大模型架构类型

大语言模型主要基于Transformer架构,可分为三类:

-

自编码模型(AutoEncoder, AE):仅使用Encoder,适用于理解任务(如文本分类、实体识别)。代表模型是BERT,其核心架构包括:Embedding层(词嵌入、段嵌入、位置嵌入);多层Transformer Encoder(双向注意力);预微调层(分类或序列标注任务)。

-

自回归模型(AutoRegressive, AR):仅使用Decoder(单向注意力),适用于生成任务(如文本续写、对话)。代表模型是GPT系列,其架构特点包括:词嵌入(使用BPE分词);可训练的位置编码;多层Transformer Decoder(Masked Self-Attention);输出层(Softmax生成概率分布)。

-

序列到序列模型(Seq2Seq):同时使用Encoder + Decoder,适用于转换任务(如翻译、摘要)。代表模型是T5。

当前主流大模型(如GPT-3、LLaMA)主要采用Decoder-only架构,因其训练效率更高,生成能力更强。

1.1.2 大模型与原始Transformer的差异

| 定义与层级关系 | Transformer是"基础设施" | 提供处理序列数据的通用架构,可用于多种任务 |

|---|---|---|

| LLM是"应用实例" | 是Transformer在语言任务上的具体实现,通过海量数据和参数规模提升性能 | |

| 规模差异 | Transformer架构本身不限定规模 | 小到几百万参数(如BERT-base),大到千亿参数(如GPT-4)均可基于Transformer构建 |

| LLM强调"大" | 通常指参数量超过百亿、训练数据达TB级的模型 | |

| 应用场景 | Transformer用途更广 | 可用于文本分类、语音识别、蛋白质结构预测等多种任务 |

| LLM专注于语言任务 | 如对话系统、文本生成、代码编写等 |

1.1.3 大模型特有架构创新

| 混合专家系统(MoE) | 通过门控网络动态选择"专家"子网络进行计算 |

| 以稀疏激活方式提升模型容量与计算效率 | |

| 代表应用:GPT-4采用8个GPT-3级别大小的模型以MoE架构组合 | |

| 稀疏激活技术 | 仅激活模型的部分神经元,降低计算成本 |

| 保持性能的同时提高推理效率 | |

| 多模态融合架构 | 从单一文本模态向"文本+图像+视频"多模态发展 |

| 如GPT-4V支持文本、图像、视频的联合理解 |

1.1.4 架构演进趋势

| 从密集连接向稀疏激活演进 | MoE架构成为突破参数规模与计算效率瓶颈的关键 |

| 推理时仅路由到部分专家,显著降低计算量 | |

| 从通用模型向领域专用模型发展 | 通过微调(Fine-tune)或提示工程(Prompt Engineering)提升领域适应性 |

| 结合行业知识与业务规则输出高价值结果 | |

| 从单一模态向多模态融合 | 语音大模型向"语音+文本+视觉"多模态演进 |

| 通过联合嵌入实现跨模态理解 |

1.2 大模型的核心组件

大模型的核心是Transformer架构,它摒弃了传统RNN的序列依赖,采用自注意力机制(self-attention)实现高效并行计算。Transformer由编码器(Encoder)和解码器(Decoder)组成,每个模块包含多层子组件。

-

自注意力机制:这是模型理解上下文的关键。给定输入序列$X = [x_1, x_2, \ldots, x_n]$,模型通过查询(Query)、键(Key)和值(Value)矩阵计算注意力权重。公式表示为: $$ \text{Attention}(Q,K,V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d_k}}\right)V $$ 其中,$d_k$是键向量的维度,$softmax$函数确保权重归一化。行内计算如:注意力得分$ \text{score}_{ij} = \frac{q_i \cdot k_j}{\sqrt{d_k}} $,用于捕捉词间关系。例如,通过注意力权重区分‘苹果’在‘苹果公司’与‘吃苹果’中的语义差异”。

-

多层结构:Transformer堆叠多个编码层和解码层。每个层包含多头注意力(Multi-Head Attention)和前馈神经网络(Feed-Forward Network)。例如,编码器输出: $$ \text{Encoder}(X) = \text{LayerNorm}(X + \text{MultiHeadAttention}(X)) $$ 这里,$LayerNorm$是层归一化,确保训练稳定性。中国模型如文心一言优化了这一结构,增加位置编码(Positional Encoding)以处理中文序列特性。

Transformer模型自2017年由Vaswani等人提出以来,已成为自然语言处理领域的革命性架构。其核心组件——编码器、解码器和多头注意力机制——共同构成了这一强大模型的基础。

编码器是Transformer模型的第一部分,负责将输入序列(如句子)转换为一系列丰富的表示形式。编码器通常由多个相同的层堆叠而成(原始论文中使用6层),每层都包含这两个子层,并添加了残差连接和层归一化操作。这种设计有助于梯度流动,使模型能够训练得更深。

解码器是Transformer模型的第二部分,负责生成输出序列(如翻译结果)。与编码器类似,解码器也由多个相同的层堆叠而成。解码器同样使用残差连接和层归一化,并通常堆叠多个相同层(原始论文中使用6层)。

多头注意力是Transformer最核心的创新点之一,它通过并行运行多个注意力"头"来捕捉不同类型的关系。多头注意力的"多头"部分是指并行运行多个这样的注意力机制(原始论文中使用8个头),每个头学习不同的关系模式(如语法关系、语义关系等)。最后,所有头的输出被拼接并通过一个线性层进行整合。

| Transformer核心组件 | ||

|---|---|---|

| 编码器(Encoder)的子层 |

多头自注意力层 |

这是编码器的核心组件,允许模型在处理每个词时同时关注输入序列中的所有其他词。这种机制使模型能够捕捉长距离依赖关系,理解词语之间的全局关联 |

|

前馈神经网络层 |

这是一个简单的全连接网络,对每个位置的表示进行非线性变换,增加模型的表达能力 |

|

| 解码器(Decoder)的子层 |

掩码多头自注意力层 |

这是解码器的第一个子层,与编码器的自注意力层类似,但添加了掩码机制,确保在预测当前位置时只能看到当前位置及之前的位置,防止信息泄露 |

|

编码器-解码器注意力层 |

这是解码器的第二个子层,允许解码器在生成每个输出词时关注编码器的输出表示,建立输入和输出序列之间的关联 |

|

|

前馈神经网络层 |

与编码器中的相同,对每个位置的表示进行非线性变换 |

|

| 多头注意力(Multi-Head Attention)机制详解 |

查询(Query)、键(Key)和值(Value)矩阵 |

对于每个输入位置,通过线性变换生成Q、K、V三个矩阵。这些矩阵使模型能够计算注意力分数,决定不同位置之间的关联强度 |

|

缩放点积注意力 |

计算查询和键的点积,除以一个缩放因子(通常是键维度的平方根),然后应用softmax函数得到注意力权重。这些权重用于对值进行加权求和,产生输出表示 |

|

1.3 组件协同工作流程

Transformer模型的工作流程可以概括为:

- 输入序列首先通过编码器,每个编码器层通过多头自注意力捕捉序列内部的复杂关系,再通过前馈网络进行非线性变换。

- 解码器接收编码器的输出和已生成的部分输出序列,通过掩码自注意力确保自回归性质,再通过编码器-解码器注意力建立输入输出关联,最后通过前馈网络生成预测。

- 多头注意力机制贯穿整个模型,使编码器和解码器能够同时关注序列的不同方面,捕捉多层次的语义和语法关系。

这种架构设计使Transformer能够高效处理序列数据,特别适合并行计算,成为现代NLP系统的基础。

二、训练与推理逻辑

大模型的逻辑分为训练(从数据中学习)和推理(生成响应)两个阶段,均基于概率优化。

-

训练逻辑:采用预训练(Pretraining)和微调(Finetuning/Fine-tune)策略。预训练使用大规模无标签数据,目标是最小化语言模型损失函数。例如,掩码语言建模(Masked Language Modeling)损失: $$ \mathcal{L}{\text{MLM}} = -\sum{i} \log P(x_i | x_{\text{masked}}) $$ 其中,$P$是条件概率,通过反向传播优化参数。中国模型利用国内数据集(如中文维基百科和社交媒体数据)进行训练,确保文化适配性。微调阶段则使用特定任务数据(如问答或翻译),提升模型精度。

-

推理逻辑:模型基于概率生成响应。输入提示$P$,通过解码器逐步预测输出序列$Y = [y_1, y_2, \ldots, y_m]$。生成过程使用贪心搜索或束搜索(Beam Search),最大化概率: $$ P(Y|P) = \prod_{t=1}^{m} P(y_t | y_{<t}, P) $$ 行内计算如:每一步的概率分布$ P(y_t | \text{context}) $。中国模型在推理中融入中文语义规则,减少歧义(如处理多义词)。

注:文心一言4.0训练数据量达10TB,覆盖50亿+中文网页,远超早期版本(如3.0的2TB数据)。

三、中国大模型的特色与实践

中国在底层架构上强调国产化和安全可控,逻辑设计注重实际应用。

-

架构优化:为适应中文特性,模型如通义千问增强Transformer的嵌入层(Embedding Layer),使用汉字部首编码提升效率(中文模型采用“拼音-笔画”混合位置编码,解决“长恨歌”等古诗词的序列建模问题)。同时,中国公司开发分布式训练框架(如百度的PaddlePaddle),支持千亿参数规模。公式上,参数更新采用Adam优化器: $$ \theta_{t+1} = \theta_t - \eta \cdot \frac{\hat{m}_t}{\sqrt{\hat{v}_t} + \epsilon} $$ 其中,$\theta$是模型参数,$\eta$是学习率,$\hat{m}_t$和$\hat{v}_t$是偏差校正项。

注:1. 通义千问采用“汉字-部首”双嵌入策略,使“森”等会意字的训练效率提升23%(阿里云2023年白皮书数据);2. PaddlePaddle的分布式训练速度较PyTorch提升40%(百度2023年Benchmark报告)。

-

逻辑整合:中国模型强调多模态逻辑(结合文本、图像),例如华为的盘古大模型支持跨模态推理。训练数据强调本地合规性,避免敏感内容。在应用逻辑上,模型部署于云平台(如阿里云),实现低延迟服务。

结论

中国大模型的底层架构以Transformer为基础,通过自注意力机制和分层结构实现高效计算;逻辑上,训练注重数据驱动和概率优化,推理强调生成质量。结合国产化努力,这些模型在中文处理、安全性和应用广度上展现优势。未来,随着算力提升和算法创新,中国大模型有望在全球AI竞争中发挥更大作用。开发者可参考开源实现(如Hugging Face Transformers库)进一步探索。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)