论文阅读:ACL 2025 LLMs instead of Human Judges? A Large Scale Empirical Study across 20 NLP Evaluation T

最后研究者给了个建议:现在的AI还不能直接拿来当“裁判”用,想用的话,必须先针对具体任务,拿人类标注结果做验证——比如你想用AI评机器翻译,得先确认这个AI在“翻译评估”任务上跟人类一致,才能用,不能随便找个AI就用。这篇文档其实是一项关于“用大语言模型(LLMs)代替人类做评估”的大规模实验研究,核心就是想搞清楚:现在的AI模型(比如GPT-4o、Llama这些)能不能靠谱地替代人类,去判断NL

总目录 大模型相关研究:https://blog.csdn.net/WhiffeYF/article/details/142132328

https://arxiv.org/pdf/2406.18403

https://www.doubao.com/chat/21483945961531138

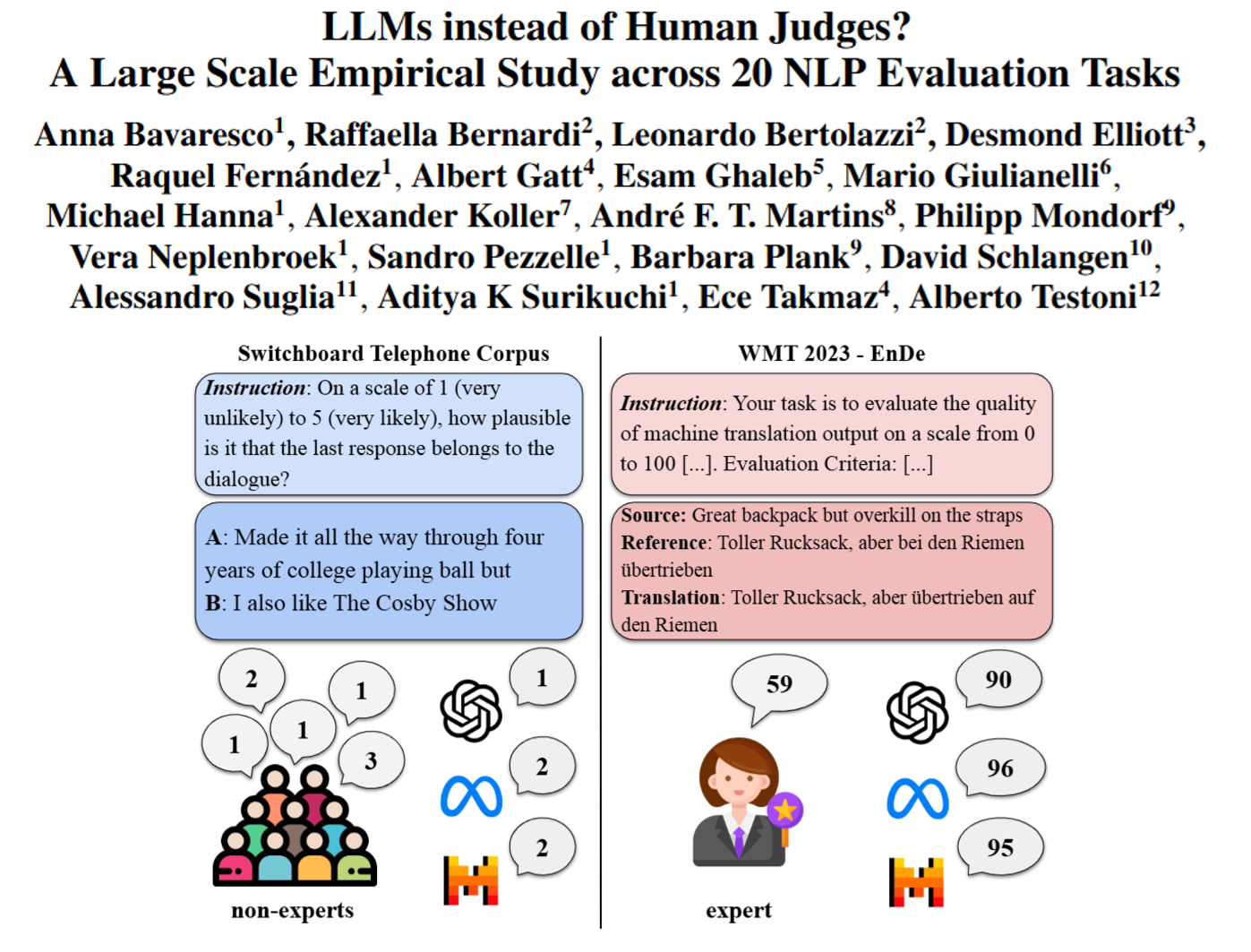

LLMs instead of Human Judges? A Large Scale Empirical Study across 20 NLP Evaluation Tasks

速览

这篇文档其实是一项关于“用大语言模型(LLMs)代替人类做评估”的大规模实验研究,核心就是想搞清楚:现在的AI模型(比如GPT-4o、Llama这些)能不能靠谱地替代人类,去判断NLP任务(比如翻译、对话生成、文本总结)的结果好不好。

首先,得先明白背景:以前评估NLP模型的效果,比如判断一段机器翻译准不准、一句对话通不通顺,都得找人类——要么是专家,要么是普通标注者,耗时又费力。现在大家都想让AI自己评自己,比如让GPT-4o给机器翻译打分,这样快多了,但问题也来了:AI评的结果跟人类一致吗?会不会有偏见?闭源模型(比如GPT系列)以后更新了,之前的评估结果还能用吗?

为了回答这些问题,研究者做了三件关键的事:

- 搞了个叫“JUDGE-BENCH”的评估基准:里面包含20个不同的NLP数据集,覆盖了各种任务(翻译、对话、推理、毒性检测等),还有对应的人类标注结果(有的是专家评的,有的是普通人评的),总共超过7万个测试案例,还能随时加新任务,很灵活。

- 选了11个主流AI模型来测试:既有闭源的(比如GPT-4o、Gemini-1.5),也有开源的(比如Llama-3.1-70B、Mixtral),都是现在表现比较好的。

- 设计实验看AI和人类的“一致性”:比如人类给一段翻译打80分,AI会不会也打差不多的分?用了两种计算方式——对“分类判断”(比如“这句话语法对不对”这种非黑即白的)算“科恩卡帕系数”,对“分级判断”(比如“1-5分评流畅度”这种有梯度的)算“斯皮尔曼相关系数”,系数越高说明AI和人类越一致。

然后重点看实验结果,有几个很有意思的发现:

- AI不是万能的,表现特别不稳定:有的任务上AI跟人类很一致(比如“判断是否遵守指令”“数学推理步骤对不对”),但有的任务完全不行(比如“医疗安全评估”“毒性检测”),甚至出现负相关(就是AI觉得好的,人类觉得差)。比如在“医疗安全”数据集里,很多AI模型不直接打分,反而一直解释,导致有效结果特别少;在“DICES安全对话”数据集里,AI总倾向于把内容判为“不确定”或“不安全”,跟人类判断差很多。

- AI更“懂”普通人,不如专家:所有AI模型跟普通人类标注者的一致性,都比跟专家的高。研究者猜可能是因为普通人评的时候更看“表面特征”(比如句子顺不顺口),而AI刚好对这种特征敏感;但专家会用更专业的标准(比如翻译的“准确性”),AI就跟不上了。

- 闭源模型略好,但开源模型差距不大:GPT-4o整体表现最好,但像Llama-3.1-70B、Mixtral-8x22B这些开源模型,在某些任务上(比如判断句子语法对不对、总结质量好不好)甚至超过GPT-4o。这对后续研究是好事——毕竟开源模型能重复实验,不像闭源模型可能突然更新或下架,导致之前的结果没用了。

- AI对“人类写的内容”判断更准,对“机器写的内容”容易偏:不管是分类还是分级任务,AI评估人类写的文本时,跟人类的一致性都更高;评估AI自己生成的文本时,一致性就低了。这可能是因为AI对“同类生成”有偏见,比如更宽容,或者更容易忽略机器文本的问题。

- 花里胡哨的提示词没用:比如“思维链提示”(让AI一步步解释再打分),之前以为能提升准确性,但这次实验发现,它没让AI和人类的一致性有稳定提升,跟普通提示词效果差不多。

最后研究者给了个建议:现在的AI还不能直接拿来当“裁判”用,想用的话,必须先针对具体任务,拿人类标注结果做验证——比如你想用AI评机器翻译,得先确认这个AI在“翻译评估”任务上跟人类一致,才能用,不能随便找个AI就用。同时也开放了JUDGE-BENCH,方便其他人继续研究怎么让AI评得更准。

当然,研究也有不足:比如主要测的是英文任务,其他语言的AI评估能力还不清楚;而且只看了AI和人类的“一致性”,没考虑会不会两者都有同样的偏见(比如都忽略某个细节);也没涉及“ pairwise偏好评估”(比如让AI选“A和B哪个翻译更好”),这些都留到以后研究了。

更多推荐

已为社区贡献77条内容

已为社区贡献77条内容

所有评论(0)