使用Anaconda和VSCode进行LangChain实战

有时候调用OpenAI和DeepSeek的API_KEY会很慢,我们可以调用阿里云百炼里的模型。这里的base_url是阿里云百炼里的基础url,openai_api_key是阿里云百炼里的API密钥。我们先自定义提示词模板,然后根据自己的需求在固定提示词模板prompt中添加自己的内容,最后调用模型,将自定义的提示词放入invoke中,将内容输出出来。为了简化之前的代码,langchain对op

上一篇文章我已经详细说明了Anacoda和VSCode是如何配置的,不懂的小伙伴可以直接查阅文章:LangChain的环境准备及快速实战

接着我们继续在VSCode中编辑代码!

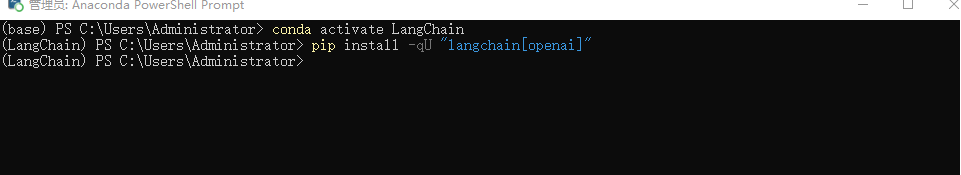

为了简化之前的代码,langchain对openai的调用方式做了封装,所以我们可以直接使用openai的调用方式。在Anaconda的终端中使用命令:pip install -qU "langchain[openai]"来安装openAI的依赖包。

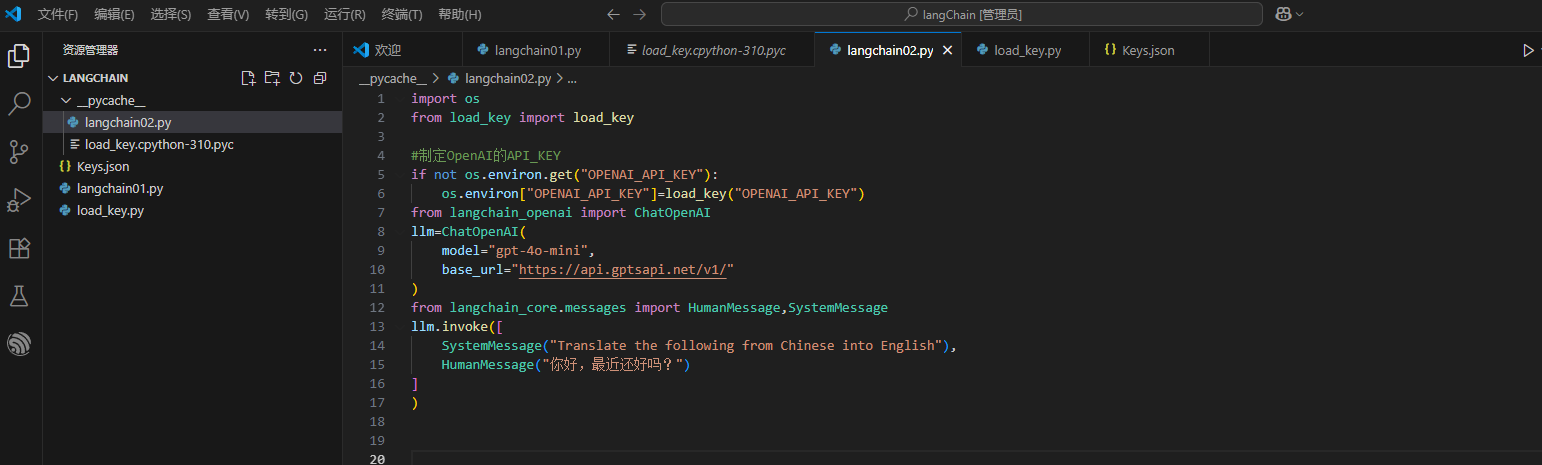

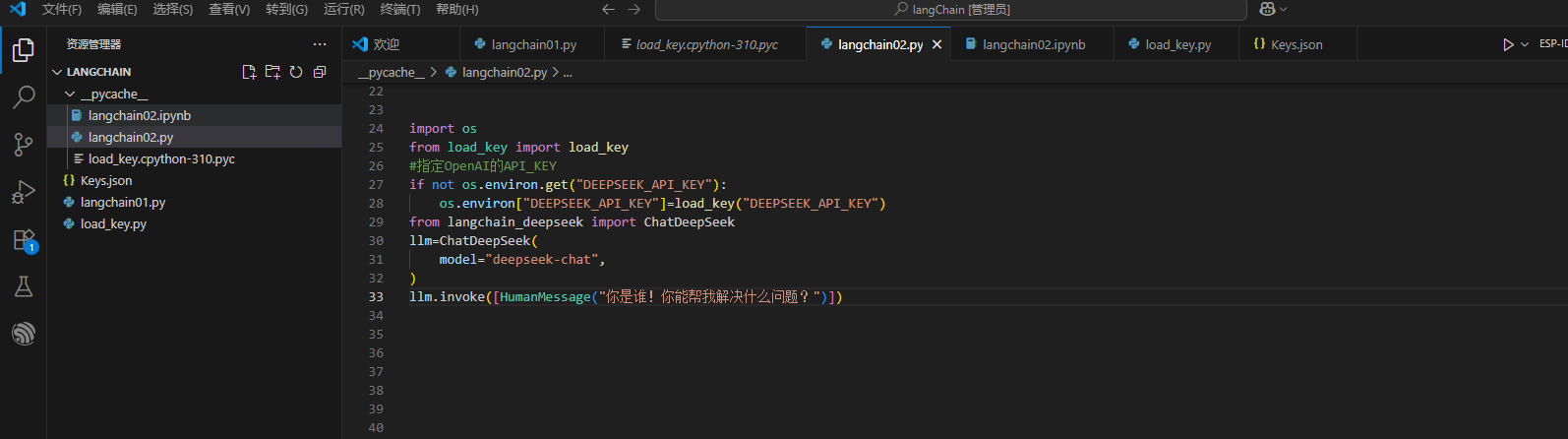

这里我写出调用OpenAI的API_KEY和调用DeepSeek的API_KEY的两个例子供大家参考!

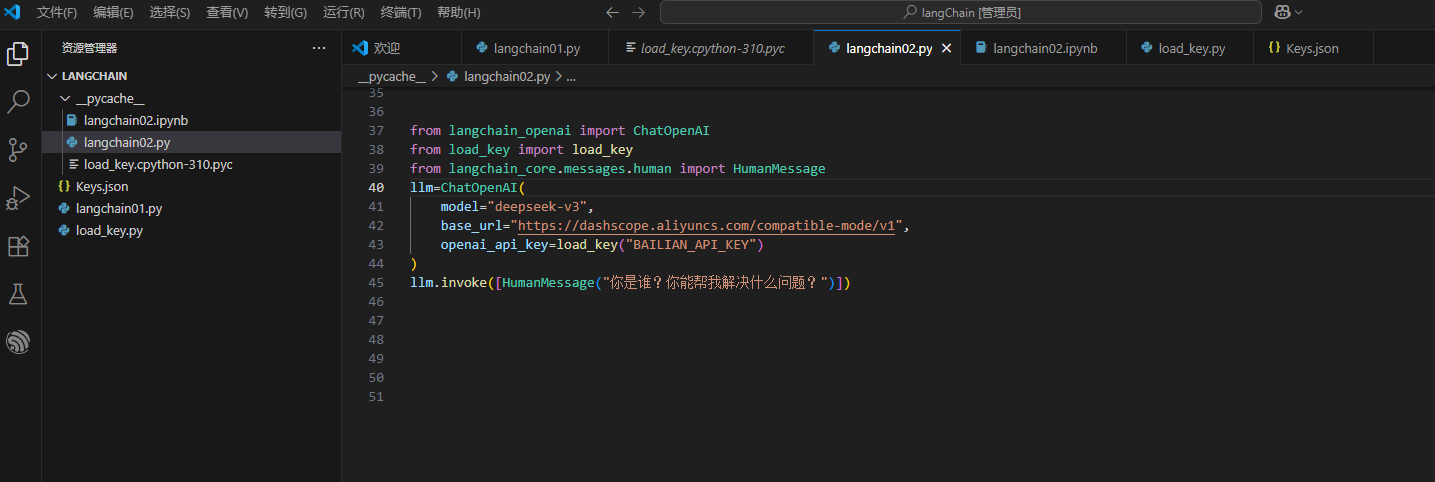

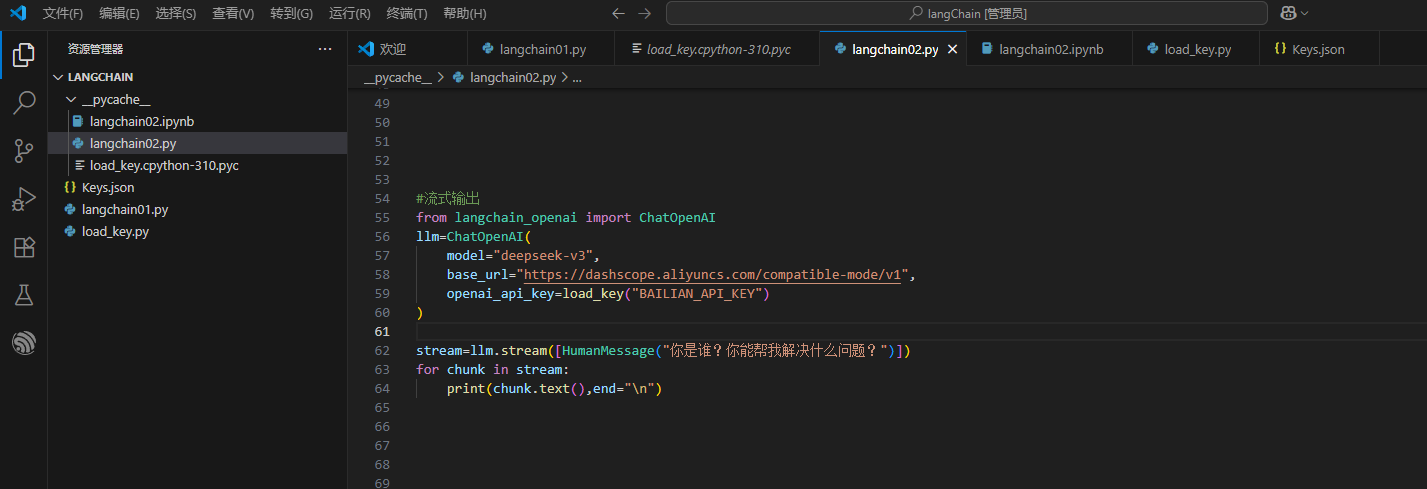

有时候调用OpenAI和DeepSeek的API_KEY会很慢,我们可以调用阿里云百炼里的模型。这样的话速度会更快一些。这里的base_url是阿里云百炼里的基础url,openai_api_key是阿里云百炼里的API密钥。

同时,LangChain支持流式输出,即输出结果会一个一个Token地蹦出来。

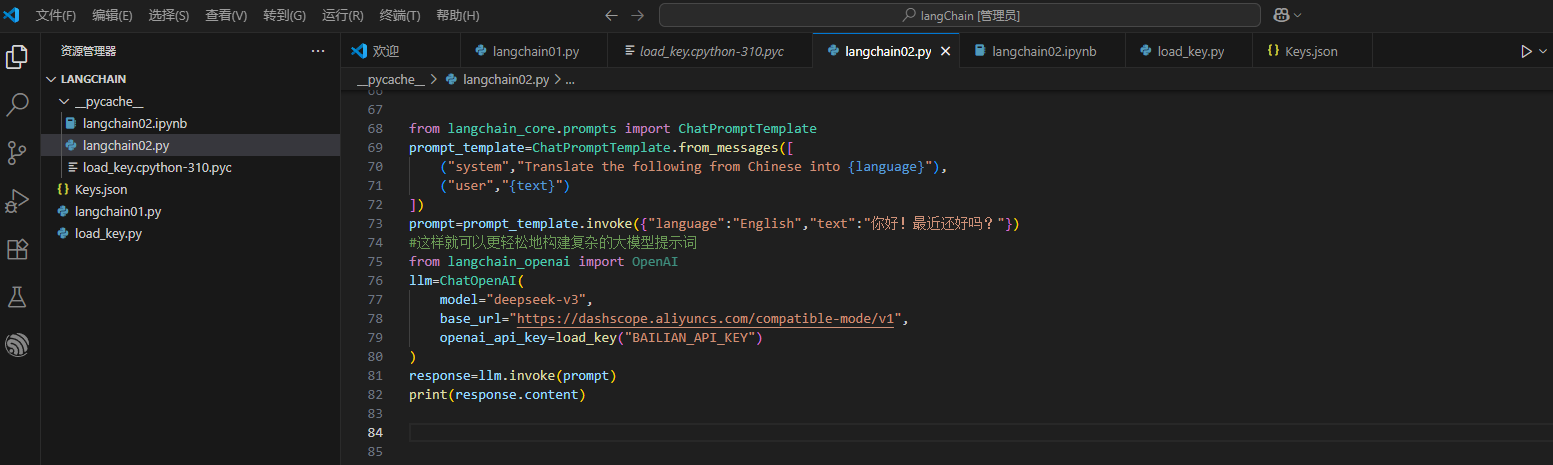

LangChain也支持使用提示词模板的方式来完成大模型交互。我们先自定义提示词模板,然后根据自己的需求在固定提示词模板prompt中添加自己的内容,最后调用模型,将自定义的提示词放入invoke中,将内容输出出来。

这样我们就可以实现各种各样类似的功能了!

同时,LangChain支持传入更多定制参数,例如temperature,top_p等。而且这些能力,通常使用网页或者APP访问大模型时,是无法传入的。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)