智能风控实战:金融AI体系构建全流程

智能风控的核心是解决业务问题风控类型:是信用风控(评估用户还款能力)还是欺诈风控(识别恶意欺骗行为)?业务场景:是贷款审批(事前风控)、交易监控(事中风控)还是逾期催收(事后风控)?关键指标:是降低坏账率(信用风控)、减少欺诈损失(欺诈风控)还是提高审批效率(流程优化)?示例:某支付机构的需求是“降低线上交易欺诈损失”,关键指标是“欺诈率下降30%”“误拒率不超过8%”。需求分析→数据体系→特征工

智能风控实战:金融AI体系构建全流程

一、引言:金融风控的痛与智能AI的解药

1.1 痛点引入:传统风控的“三座大山”

在金融领域,风控是永恒的主题。无论是银行的信贷审批、支付机构的欺诈检测,还是保险公司的反洗钱,都需要准确识别风险,平衡“风险控制”与“业务增长”。但传统风控体系往往面临以下痛点:

- 效率低:依赖人工规则和经验判断,处理海量交易时延迟高(比如人工审批一笔贷款需要数小时),无法应对实时交易场景(如电商秒杀中的欺诈下单)。

- 误判率高:规则引擎难以覆盖所有欺诈场景(比如新型团伙欺诈、跨平台洗钱),容易出现“漏判”(放过欺诈者)或“误判”(拒绝正常用户)。

- 难以迭代:规则需要人工维护,当欺诈手段升级时(比如用AI生成虚假身份证、模拟正常用户行为),规则更新滞后,无法快速适应变化。

1.2 解决方案:智能风控AI体系的核心价值

智能风控AI体系通过数据驱动+机器学习,解决传统风控的痛点:

- 实时性:用大数据和实时计算引擎(如Flink)处理海量交易,在毫秒级内返回风险评分,支持实时决策(比如阻止欺诈交易)。

- 准确性:通过机器学习模型(如XGBoost、图神经网络)挖掘数据中的隐藏模式,识别传统规则无法覆盖的欺诈行为(比如关联团伙欺诈)。

- 自动化迭代:通过监控模型性能和数据漂移,自动触发模型重新训练,适应欺诈手段的变化(比如当欺诈者开始使用新的IP地址段时,模型能快速学习并识别)。

1.3 最终效果展示:某银行的智能风控实践

某股份制银行引入智能风控AI体系后,取得了显著效果:

- 欺诈检测率提升:信用卡欺诈检测的KS值从0.45提升至0.68(KS值越高,模型区分正负样本的能力越强),欺诈漏检率下降40%。

- 审批效率提升:个人贷款审批时间从24小时缩短至5分钟,自动审批率达85%,减少了人工成本。

- 误拒率降低:通过模型优化阈值,正常用户的误拒率从12%下降至5%,提升了用户体验。

二、准备工作:构建智能风控体系的前提条件

2.1 环境与工具清单

智能风控体系需要整合大数据、机器学习、实时计算、部署监控等多个技术栈,以下是核心工具清单:

| 技术领域 | 推荐工具 |

|---|---|

| 数据采集 | Flume(日志采集)、Kafka(消息队列)、CDC(变更数据捕获,如Debezium) |

| 数据存储 | Hadoop HDFS(批处理数据)、Apache Iceberg(数据湖)、Redis(实时缓存) |

| 数据处理 | Spark(批处理)、Flink(实时计算)、Pandas/Polars(特征工程) |

| 机器学习框架 | XGBoost/LightGBM(结构化数据)、TensorFlow/PyTorch(深度学习)、DGL(图神经网络) |

| 模型部署 | FastAPI(轻量级API)、TensorRT(高性能推理)、K8s(容器编排) |

| 监控与报警 | Prometheus(指标收集)、Grafana(可视化)、Alertmanager(报警) |

2.2 基础知识储备

- 金融风控常识:了解信用风控(如FICO评分)、欺诈检测(如交易欺诈、身份欺诈)、反洗钱(如大额转账监控)等业务场景。

- 机器学习基础:掌握分类算法(逻辑回归、XGBoost)、聚类算法(K-means)、深度学习(CNN/LSTM)的原理,熟悉评估指标(AUC、KS值、准确率、召回率)。

- 大数据处理:了解批处理(Spark SQL)、流处理(Flink SQL)的区别,掌握数据清洗(缺失值处理、异常值检测)、数据集成(多源数据合并)的方法。

三、核心步骤一:需求分析——明确风控目标与业务边界

3.1 第一步:定义业务目标

智能风控的核心是解决业务问题,因此第一步必须与业务方(如信贷部门、支付部门)明确:

- 风控类型:是信用风控(评估用户还款能力)还是欺诈风控(识别恶意欺骗行为)?

- 业务场景:是贷款审批(事前风控)、交易监控(事中风控)还是逾期催收(事后风控)?

- 关键指标:是降低坏账率(信用风控)、减少欺诈损失(欺诈风控)还是提高审批效率(流程优化)?

示例:某支付机构的需求是“降低线上交易欺诈损失”,关键指标是“欺诈率下降30%”“误拒率不超过8%”。

3.2 第二步:划定数据边界

根据业务目标,确定需要采集的数据范围:

- 内部数据:用户基本信息(姓名、身份证、手机号)、交易数据(金额、时间、地点)、行为数据(登录设备、浏览记录)、历史风险记录(如逾期记录、欺诈记录)。

- 外部数据:征信数据(如央行征信报告)、黑名单数据(如失信被执行人名单)、第三方数据(如电商交易记录、社交数据)。

注意:数据采集需遵守《个人信息保护法》《金融数据安全管理规范》等法规,确保数据隐私。

3.3 第三步:明确决策流程

确定模型在业务流程中的位置:

- 事前风控:模型输出风险评分,用于贷款审批(如“评分低于600分拒绝申请”)。

- 事中风控:模型实时监控交易,触发拦截(如“交易金额超过用户历史均值10倍,暂停交易并要求验证”)。

- 事后风控:模型分析逾期用户特征,优化事前风控规则(如“逾期用户中80%有频繁更换手机号的行为,需将该特征加入模型”)。

四、核心步骤二:数据体系构建——从数据采集到数据仓库

4.1 数据采集:多源数据整合

- 结构化数据:来自业务系统(如MySQL中的用户表、交易表),通过CDC工具(如Debezium)实时同步到数据湖。

- 半结构化数据:来自日志文件(如Nginx日志中的用户IP、访问时间),通过Flume采集到Kafka。

- 非结构化数据:来自图片(如身份证照片)、文本(如用户申请描述),通过OCR、NLP工具转换为结构化数据。

示例:某银行采集了以下数据:

- 用户表(user_id、name、id_card、phone);

- 交易表(transaction_id、user_id、amount、time、location);

- 征信报告(user_id、credit_score、overdue_times);

- 黑名单(id_card、blacklist_reason)。

4.2 数据清洗:提升数据质量

数据质量是模型性能的基础,需处理以下问题:

- 缺失值:对于关键特征(如身份证号),直接删除缺失样本;对于非关键特征(如用户职业),用均值、中位数或模型预测填充。

- 异常值:通过箱线图(IQR)、Z-score检测异常值(如交易金额超过100万元),根据业务场景决定是否删除或修正(如“用户可能输入错误,将金额修正为1万元”)。

- 重复值:删除重复的交易记录(如同一笔交易被多次提交)。

代码示例:用Pandas处理缺失值和异常值:

import pandas as pd

import numpy as np

# 加载数据

user_data = pd.read_csv('user.csv')

transaction_data = pd.read_csv('transaction.csv')

# 处理缺失值:用户表中的phone字段缺失,用“未知”填充

user_data['phone'] = user_data['phone'].fillna('未知')

# 处理异常值:交易金额超过100万元的视为异常,替换为均值

transaction_data['amount'] = np.where(

transaction_data['amount'] > 1000000,

transaction_data['amount'].mean(),

transaction_data['amount']

)

4.2 数据存储:分层管理

采用数据湖+数据仓库的分层架构,实现数据的可追溯和高效查询:

- 原始层(ODS):存储未经处理的原始数据(如Kafka中的日志、MySQL同步的表),保留原始格式。

- 清洗层(DWD):存储清洗后的数据(如处理缺失值、异常值后的用户表、交易表),用于后续分析。

- 汇总层(DWS):存储汇总后的宽表(如用户行为宽表,包含用户的基本信息、近7天交易频率、近30天交易金额均值),用于特征工程。

示例:用户行为宽表(user_behavior_dws)的结构:

| user_id | name | id_card | phone | 7d_transaction_freq | 30d_transaction_avg | is_blacklist |

|---|---|---|---|---|---|---|

| 1001 | 张三 | 110101… | 138… | 5 | 2000 | 0 |

| 1002 | 李四 | 120102… | 139… | 10 | 5000 | 1 |

4.3 数据质量监控

通过工具(如Apache Griffin、Great Expectations)监控数据质量,确保数据的完整性(无缺失值)、准确性(无错误数据)、一致性(多源数据格式一致)。

示例:用Great Expectations定义数据质量规则:

expectations:

- expectation_type: expect_column_values_to_not_be_null

column: user_id

- expectation_type: expect_column_values_to_be_between

column: amount

min_value: 0

max_value: 1000000

五、核心步骤三:特征工程——从原始数据到风险信号

5.1 特征工程的重要性

在智能风控中,特征工程的贡献远大于模型选择。好的特征能让简单的模型(如逻辑回归)达到优秀的性能,而差的特征即使使用复杂模型(如Transformer)也无法有效识别风险。

示例:在欺诈检测中,“交易地点与常用地点的距离”“近1小时内的登录次数”等特征,比“用户年龄”“性别”更能反映风险。

5.2 特征类型与提取方法

根据数据类型,特征可分为以下几类:

5.2.1 时间窗口特征

用于捕捉用户行为的时效性,比如:

- 近7天交易次数(7d_transaction_freq);

- 近30天交易金额均值(30d_transaction_avg);

- 近1小时内的登录次数(1h_login_count)。

代码示例:用Flink SQL提取近7天交易频率:

CREATE TABLE user_transaction_freq (

user_id BIGINT,

7d_transaction_freq INT,

`timestamp` TIMESTAMP(3)

) WITH (

'connector' = 'kafka',

'topic' = 'user_transaction_freq',

'format' = 'json'

);

INSERT INTO user_transaction_freq

SELECT

user_id,

COUNT(*) AS 7d_transaction_freq,

CURRENT_TIMESTAMP() AS `timestamp`

FROM transaction_table

WHERE transaction_time >= CURRENT_TIMESTAMP() - INTERVAL '7' DAY

GROUP BY user_id;

5.2.2 统计特征

用于描述数据的分布特征,比如:

- 交易金额的标准差(反映交易波动);

- 用户历史最大交易金额(反映用户消费能力);

- 逾期次数(反映信用状况)。

代码示例:用Spark SQL计算用户历史最大交易金额:

SELECT

user_id,

MAX(amount) AS max_transaction_amount

FROM transaction_table

GROUP BY user_id;

5.2.3 行为特征

用于捕捉用户行为的异常性,比如:

- 交易地点与常用地点的距离(超过100公里视为异常);

- 登录设备是否为新设备(从未使用过的设备视为异常);

- 交易时间是否在用户常用时间段外(如用户通常在白天交易,凌晨交易视为异常)。

示例:计算交易地点与常用地点的距离:

- 先计算用户的常用地点(如近30天交易次数最多的城市);

- 对于每笔交易,计算交易地点与常用地点的距离(用高德地图API);

- 将距离转换为特征(如“distance_from_usual_location”)。

5.2.4 衍生特征

通过组合多个原始特征生成新特征,比如:

- 交易金额与用户收入的比值(反映过度消费风险);

- 近7天交易频率与近30天交易频率的比值(反映行为突变);

- 是否在黑名单中(0/1变量,来自外部数据)。

5.3 特征选择:去除冗余特征

- 过滤法:用相关性分析(如皮尔逊相关系数)去除与标签无关的特征(如“用户性别”与欺诈无关)。

- 嵌入法:用模型(如XGBoost)的特征重要性评分,保留重要特征(如“近7天交易频率”的重要性评分最高)。

- ** wrapper法**:用递归特征消除(RFE)选择最优特征子集(如从100个特征中选择20个最有效的特征)。

示例:用XGBoost查看特征重要性:

import xgboost as xgb

import matplotlib.pyplot as plt

# 训练模型(略)

model = xgb.XGBClassifier()

model.fit(X_train, y_train)

# 绘制特征重要性

xgb.plot_importance(model, max_num_features=10)

plt.show()

5.4 特征归一化:统一特征尺度

- 标准化(StandardScaler):将特征转换为均值为0、标准差为1的分布(适用于线性模型,如逻辑回归)。

- 归一化(MinMaxScaler):将特征转换为0-1之间的分布(适用于树模型,如XGBoost,对尺度不敏感,但归一化能加速训练)。

代码示例:用Sklearn进行特征标准化:

from sklearn.preprocessing import StandardScaler

scaler = StandardScaler()

X_train_scaled = scaler.fit_transform(X_train)

X_test_scaled = scaler.transform(X_test)

六、核心步骤四:模型开发——选择合适的算法解决具体问题

6.1 模型选择:根据场景选算法

不同的风控场景需要选择不同的模型:

| 场景类型 | 推荐模型 | 原因 |

|---|---|---|

| 信用风控(评分卡) | 逻辑回归、XGBoost | 解释性好(能说明“为什么拒绝用户”),适合结构化数据。 |

| 欺诈检测(实时) | LightGBM、Flink ML | 训练速度快,支持实时推理,适合处理高并发交易。 |

| 关联欺诈(团伙) | 图神经网络(GNN)、GraphSAGE | 能捕捉用户之间的关联关系(如同一IP地址的多个用户),识别团伙欺诈。 |

| 文本风险分析(如申请描述) | BERT、ERNIE | 能理解文本中的语义信息(如“急需用钱”“无固定收入”等风险信号)。 |

6.2 模型训练:从离线到在线

6.2.1 数据划分

将数据分为训练集(70%)、验证集(20%)、测试集(10%):

- 训练集:用于模型参数学习;

- 验证集:用于调参(如调整XGBoost的max_depth);

- 测试集:用于评估模型最终性能(避免过拟合)。

代码示例:用Sklearn划分数据:

from sklearn.model_selection import train_test_split

X_train, X_temp, y_train, y_temp = train_test_split(X, y, test_size=0.3, random_state=42)

X_val, X_test, y_val, y_test = train_test_split(X_temp, y_temp, test_size=0.33, random_state=42)

6.2.2 模型训练与调参

-

传统机器学习模型:用网格搜索(GridSearchCV)、随机搜索(RandomizedSearchCV)调参。

示例:用GridSearchCV调整XGBoost的参数:from sklearn.model_selection import GridSearchCV param_grid = { 'max_depth': [3, 6, 9], 'learning_rate': [0.01, 0.1, 0.2], 'n_estimators': [100, 200, 300] } grid = GridSearchCV(xgb.XGBClassifier(), param_grid, cv=5, scoring='roc_auc') grid.fit(X_train, y_train) print(f'Best parameters: {grid.best_params_}') print(f'Best AUC: {grid.best_score_}') -

深度学习模型:用早停法(Early Stopping)防止过拟合,用学习率衰减(Learning Rate Decay)加速收敛。

示例:用TensorFlow训练LSTM模型(用于时间序列交易数据):import tensorflow as tf from tensorflow.keras.layers import LSTM, Dense from tensorflow.keras.callbacks import EarlyStopping model = tf.keras.Sequential([ LSTM(64, return_sequences=True, input_shape=(timesteps, features)), LSTM(32), Dense(1, activation='sigmoid') ]) model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['auc']) early_stopping = EarlyStopping(monitor='val_auc', patience=5, restore_best_weights=True) history = model.fit( X_train, y_train, validation_data=(X_val, y_val), epochs=100, batch_size=32, callbacks=[early_stopping] )

6.2.3 模型评估:关键指标解读

- AUC(Area Under Curve):衡量模型区分正负样本的能力(0.5-1之间,越高越好)。

- KS值(Kolmogorov-Smirnov):衡量模型对正负样本的分离程度(0-1之间,>0.6视为优秀)。

- 准确率(Accuracy):正确预测的样本比例(但在不平衡数据中参考价值低,如欺诈样本占1%,准确率99%可能毫无意义)。

- 召回率(Recall):正确预测的欺诈样本比例(越高越好,反映漏检率)。

- 精确率(Precision):预测为欺诈的样本中实际为欺诈的比例(越高越好,反映误拒率)。

示例:某欺诈检测模型的评估结果:

| 指标 | 值 | 解读 |

|---|---|---|

| AUC | 0.85 | 模型区分能力优秀 |

| KS | 0.68 | 正负样本分离程度高 |

| 召回率 | 0.90 | 90%的欺诈样本被正确识别 |

| 精确率 | 0.75 | 预测为欺诈的样本中75%是真实欺诈(误拒率25%) |

6.3 模型解释:让业务方信任模型

金融风控需要可解释性,业务方需要知道“模型为什么给这个用户打高分/低分”。常用的解释方法:

- SHAP值:计算每个特征对预测结果的贡献(如“用户的近7天交易频率高,贡献了0.3的风险评分”)。

- LIME:生成局部可解释的模型(如“对于这个用户,交易金额超过历史均值是主要风险因素”)。

- 特征重要性:用模型(如XGBoost)的特征重要性评分,展示哪些特征对模型影响最大。

示例:用SHAP解释XGBoost模型:

import shap

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X_test)

# 绘制单样本解释

shap.plots.waterfall(shap_values[0], max_display=5)

输出:展示该用户的风险评分中,“近7天交易频率”贡献了0.4,“交易地点与常用地点距离”贡献了0.3,“是否在黑名单中”贡献了0.2,其他特征贡献较小。

七、核心步骤五:模型部署——从实验室到生产环境

7.1 部署方式选择

根据业务场景选择部署方式:

- API服务:用FastAPI、Flask将模型封装为RESTful API,供业务系统调用(如贷款审批系统调用模型API获取风险评分)。

- 实时计算引擎:将模型嵌入到Flink、Spark Streaming中,处理实时交易数据(如支付系统实时监控交易,触发拦截)。

- 边缘部署:将模型部署到终端设备(如POS机),处理离线交易(如无网络环境下的欺诈检测)。

7.2 模型优化:提升推理效率

- 模型压缩:用剪枝(Pruning)、量化(Quantization)减少模型大小(如将32位浮点数转换为8位整数,推理速度提升4倍)。

- 推理框架优化:用TensorRT、ONNX Runtime加速推理(如TensorRT能将XGBoost模型的推理速度提升2-3倍)。

- 特征预处理优化:将特征计算从模型推理中分离(如用Flink预处理特征,模型只做推理,减少延迟)。

7.3 部署示例:用FastAPI部署欺诈检测模型

7.3.1 封装模型为API

from fastapi import FastAPI

from pydantic import BaseModel

import joblib

import pandas as pd

# 加载模型和特征缩放器

model = joblib.load('fraud_detection_model.pkl')

scaler = joblib.load('scaler.pkl')

app = FastAPI()

# 定义请求体结构

class TransactionData(BaseModel):

user_id: int

amount: float

transaction_time: str

location: str

# 其他特征...

# 定义预处理函数(与训练时一致)

def preprocess_data(data: TransactionData) -> pd.DataFrame:

# 转换时间格式

transaction_time = pd.to_datetime(data.transaction_time)

# 提取时间特征(如小时、星期)

hour = transaction_time.hour

weekday = transaction_time.weekday()

# 计算交易地点与常用地点的距离(假设已有的函数)

distance = calculate_distance(data.location, data.user_id)

# 组合特征

features = pd.DataFrame({

'amount': [data.amount],

'hour': [hour],

'weekday': [weekday],

'distance_from_usual_location': [distance],

# 其他特征...

})

# 特征缩放

scaled_features = scaler.transform(features)

return scaled_features

# 定义预测接口

@app.post('/predict_fraud')

def predict_fraud(data: TransactionData):

# 预处理数据

features = preprocess_data(data)

# 预测概率

fraud_prob = model.predict_proba(features)[:, 1][0]

# 转换为风险等级

risk_level = '高风险' if fraud_prob > 0.7 else '中风险' if fraud_prob > 0.3 else '低风险'

# 返回结果

return {

'user_id': data.user_id,

'fraud_probability': fraud_prob,

'risk_level': risk_level,

'timestamp': pd.Timestamp.now().isoformat()

}

7.3.2 部署到K8s:实现高可用

用Docker将FastAPI应用打包为镜像,部署到K8s集群,实现负载均衡(应对高并发)、自动扩缩容(根据请求量调整副本数)、滚动更新(无 downtime 升级模型)。

Dockerfile示例:

FROM python:3.9-slim

WORKDIR /app

COPY requirements.txt .

RUN pip install --no-cache-dir -r requirements.txt

COPY . .

CMD ["uvicorn", "main:app", "--host", "0.0.0.0", "--port", "8000"]

7.3 实时推理示例:支付系统欺诈监控

某支付机构用Flink将模型嵌入到实时交易流程中:

- 交易数据从Kafka流入Flink;

- Flink预处理数据(提取时间窗口特征、计算交易地点距离);

- Flink调用模型API获取风险评分;

- 根据风险评分触发动作(如“高风险交易”暂停并发送验证请求,“低风险交易”放行);

- 结果写入Kafka,供业务系统后续处理。

Flink SQL示例:

CREATE TABLE transaction_input (

transaction_id BIGINT,

user_id BIGINT,

amount FLOAT,

time TIMESTAMP(3),

location STRING,

WATERMARK FOR time AS time - INTERVAL '5' SECOND

) WITH (

'connector' = 'kafka',

'topic' = 'transaction_input',

'format' = 'json'

);

CREATE TABLE transaction_output (

transaction_id BIGINT,

user_id BIGINT,

amount FLOAT,

risk_level STRING,

timestamp TIMESTAMP(3)

) WITH (

'connector' = 'kafka',

'topic' = 'transaction_output',

'format' = 'json'

);

INSERT INTO transaction_output

SELECT

t.transaction_id,

t.user_id,

t.amount,

m.risk_level,

CURRENT_TIMESTAMP() AS timestamp

FROM transaction_input t

JOIN LATERAL TABLE(predict_fraud(t.user_id, t.amount, t.time, t.location)) m

ON TRUE;

八、核心步骤六:监控与迭代——让模型保持“活力”

8.1 监控内容:从模型性能到业务效果

- 模型性能监控:监控AUC、KS值、召回率等指标(如AUC下降到0.7以下,说明模型性能退化)。

- 数据漂移监控:监控特征分布变化(如“近7天交易频率的均值从5上升到10,说明用户行为发生变化”)。

- 业务效果监控:监控坏账率、欺诈率、误拒率等业务指标(如欺诈率上升,说明模型需要优化)。

8.2 监控工具链

- 指标收集:用Prometheus收集模型性能指标(如推理延迟、AUC值)。

- 可视化:用Grafana绘制 dashboard,展示模型性能、数据漂移、业务效果。

- 报警:用Alertmanager设置报警规则(如“AUC < 0.7”发送邮件报警,“数据漂移超过阈值”发送短信报警)。

8.3 模型迭代:从监控到优化

根据监控结果,进行模型迭代:

- 重新训练:当模型性能退化(如AUC下降)或数据漂移(如特征分布变化)时,用新数据重新训练模型。

- 特征优化:当某些特征的重要性下降(如“近7天交易频率”的贡献从0.4下降到0.1),需要添加新特征(如“近1天交易频率”)。

- 算法优化:当传统模型无法应对新型欺诈(如团伙欺诈),需要切换到更适合的模型(如图神经网络)。

示例:某银行的模型迭代流程:

- 监控到AUC从0.85下降到0.75;

- 分析数据漂移,发现“近7天交易频率”的均值从5上升到15(用户交易更频繁);

- 添加“近1天交易频率”特征,重新训练模型;

- 新模型的AUC恢复到0.82,业务效果(欺诈率)下降20%。

九、总结与展望

9.1 核心要点回顾

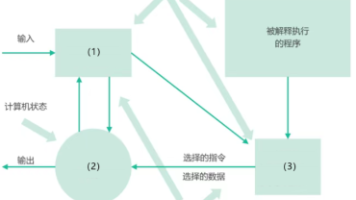

智能风控AI体系的构建流程可总结为:

需求分析→数据体系→特征工程→模型开发→部署→监控迭代

其中,特征工程是核心(好的特征决定模型性能),数据质量是基础(无好数据则无好模型),监控迭代是关键(模型需要适应动态变化的风险)。

9.2 未来趋势:从“智能”到“更智能”

- 联邦学习:解决数据孤岛问题(如银行与电商合作,在不共享原始数据的情况下共同训练模型)。

- 图神经网络:更有效地识别关联欺诈(如团伙欺诈、跨平台洗钱)。

- 大语言模型:处理非结构化数据(如用户申请描述、客服对话中的风险信号)。

- 自动机器学习(AutoML):自动化特征工程、模型选择、调参,提高开发效率(如用AutoML工具自动生成最优特征组合)。

9.3 给从业者的建议

- 懂业务:不要沉迷于技术,要理解业务需求(如信用风控的核心是“还款能力”,欺诈风控的核心是“恶意行为”)。

- 重数据:花更多时间在数据清洗和特征工程上,比选择复杂模型更重要。

- 持续学习:金融风险是动态变化的,要不断学习新的技术(如图神经网络、联邦学习),适应新的欺诈手段。

十、常见问题FAQ

10.1 问:没有足够的欺诈样本怎么办?

答:

- 半监督学习:用自编码器、聚类算法识别异常样本(如将与正常样本差异大的样本视为欺诈)。

- 数据增强:用生成式模型(如GAN)生成合成欺诈样本(如模拟欺诈交易的金额、时间、地点)。

- 迁移学习:用其他场景的欺诈样本训练模型(如用电商欺诈样本训练支付欺诈模型)。

10.2 问:模型部署后效果不如离线测试怎么办?

答:

- 检查数据一致性:确保线上数据的预处理流程与离线一致(如线上“近7天交易频率”的计算方式是否与离线相同)。

- 监控数据漂移:用工具(如Evidently AI)监控特征分布变化(如线上“交易金额”的均值比离线高2倍),重新训练模型。

- 优化推理流程:检查模型推理延迟(如延迟过高导致交易超时,业务系统未使用模型结果),用TensorRT、ONNX Runtime优化推理速度。

10.3 问:如何平衡模型的准确性和误拒率?

答:

- 调整阈值:通过ROC曲线选择最优阈值(如将高风险阈值从0.7提高到0.8,误拒率下降但漏检率上升)。

- 分层处理:对高风险用户进行人工审核(如“风险评分>0.8的用户,由人工审核后决定是否通过”),降低误拒率。

- 个性化阈值:根据用户画像调整阈值(如“新用户的阈值为0.7,老用户的阈值为0.8”,因为老用户的信用风险更低)。

10.4 问:联邦学习在金融风控中的应用场景有哪些?

答:

- 跨机构合作:银行与电商合作,用联邦学习共同训练欺诈检测模型(银行提供交易数据,电商提供用户行为数据,不共享原始数据)。

- 隐私保护:处理敏感数据(如用户征信报告),用联邦学习在本地计算梯度,聚合后更新模型(避免原始数据泄露)。

- 数据互补:小银行用联邦学习接入大银行的模型(大银行有更多数据,小银行有本地数据,共同提升模型性能)。

十一、结语

智能风控AI体系的构建是一个持续迭代的过程,需要业务、数据、技术的协同配合。从需求分析到模型部署,每一步都需要结合实战经验,解决具体的业务问题。

作为从业者,我们需要记住:技术是工具,解决业务问题才是目标。智能风控的终极目标不是“用最复杂的模型”,而是“用最有效的方式控制风险,同时促进业务增长”。

希望本文能为你构建智能风控体系提供一些启发,也欢迎你在评论区分享你的实战经验!

参考资料:

- 《金融风控实战》(作者:王磊);

- 《机器学习实战:基于Scikit-Learn和TensorFlow》(作者:Aurélien Géron);

- 阿里云《智能风控解决方案》;

- 腾讯云《金融欺诈检测白皮书》。

更多推荐

已为社区贡献155条内容

已为社区贡献155条内容

所有评论(0)