Aider AI Coding 智能上下文管理深度分析

Aider 是一个基于 AI 的代码编辑工具,其核心优势在于智能的上下文管理系统。本分析深入研究了 Aider 如何通过三个关键技术实现高效的上下文管理:文件位置: RepoMap 是 Aider 智能文件选择的核心组件,它通过分析代码依赖关系来构建仓库的语义映射。智能排序算法1.2 依赖关系分析符号定义和引用追踪1.3 上下文编码器 (ContextCoder)文件位置: ContextCode

·

Aider 智能上下文管理深度分析

概述

Aider 是一个基于 AI 的代码编辑工具,其核心优势在于智能的上下文管理系统。本分析深入研究了 Aider 如何通过三个关键技术实现高效的上下文管理:

- 基于依赖关系的智能文件选择算法

- 使用 tree-sitter 进行精确的语法分析

- 动态调整上下文内容以适应不同模型的 token 限制

1. 基于依赖关系的智能文件选择算法

1.1 核心实现:RepoMap 类

文件位置: aider/repomap.py

RepoMap 是 Aider 智能文件选择的核心组件,它通过分析代码依赖关系来构建仓库的语义映射。

关键算法实现

class RepoMap:

def __init__(self, map_tokens=1024, root=None, main_model=None, io=None,

gpt_prompts=None, verbose=False, max_map_tokens=None):

self.max_map_tokens = max_map_tokens or map_tokens

self.map_tokens = map_tokens

self.token_count = 0

self.map_mul_no_files = 2.0 # 无文件时的倍数因子

def get_repo_map(self, chat_files, other_files, mentioned_fnames, mentioned_idents):

"""生成仓库映射的核心方法"""

if not other_files:

other_files = list(self.get_ranked_tags_map(

chat_files, mentioned_fnames, mentioned_idents

).keys())

# 构建依赖关系图

repo_content = ""

for fname in other_files:

if self.token_count > self.max_map_tokens:

break

content = self.render_one_file(fname, mentioned_idents)

if content:

repo_content += content

return repo_content

智能排序算法

def get_ranked_tags_map(self, chat_fnames, mentioned_fnames=None, mentioned_idents=None):

"""基于依赖关系对文件进行智能排序"""

# 1. 收集所有相关标识符

defines = self.get_defines()

references = self.get_references()

# 2. 计算文件重要性得分

file_scores = {}

for fname in self.get_all_files():

score = 0

# 基于定义的重要性

if fname in defines:

for ident in defines[fname]:

if mentioned_idents and ident in mentioned_idents:

score += 10 # 被明确提及的标识符权重更高

if references.get(ident, 0) > 0:

score += references[ident] # 被引用次数

# 基于文件依赖关系

deps = self.get_file_dependencies(fname)

for dep in deps:

if dep in chat_fnames:

score += 5 # 与聊天文件有依赖关系

file_scores[fname] = score

# 3. 按得分排序

return dict(sorted(file_scores.items(), key=lambda x: x[1], reverse=True))

1.2 依赖关系分析

符号定义和引用追踪

def get_defines(self):

"""获取所有文件中定义的符号"""

defines = defaultdict(set)

for fname in self.get_all_files():

try:

# 使用 tree-sitter 解析文件

tree = self.parse_file(fname)

if tree:

# 提取函数、类、变量定义

for node in self.walk_tree(tree.root_node):

if node.type in ['function_definition', 'class_definition',

'variable_declaration']:

name = self.extract_name(node)

if name:

defines[fname].add(name)

except Exception as e:

self.io.tool_error(f"Error parsing {fname}: {e}")

return defines

def get_references(self):

"""获取符号引用计数"""

references = defaultdict(int)

for fname in self.get_all_files():

try:

content = self.io.read_text(fname)

# 使用正则表达式和 AST 分析查找引用

for ident in self.extract_identifiers(content):

references[ident] += 1

except Exception:

continue

return references

1.3 上下文编码器 (ContextCoder)

文件位置: aider/coders/context_coder.py

ContextCoder 专门用于识别需要编辑的文件,它通过反射机制不断优化文件选择。

class ContextCoder(Coder):

"""识别给定请求需要编辑的文件"""

def __init__(self, *args, **kwargs):

super().__init__(*args, **kwargs)

if self.repo_map:

# 调整仓库映射参数以适应上下文分析

self.repo_map.refresh = "always"

self.repo_map.max_map_tokens *= self.repo_map.map_mul_no_files

self.repo_map.map_mul_no_files = 1.0

def reply_completed(self):

"""检查回复是否完成,实现反射机制"""

content = self.partial_response_content

if not content or not content.strip():

return True

# 比较当前文件集合与提及的文件集合

current_rel_fnames = set(self.get_inchat_relative_files())

mentioned_rel_fnames = set(self.get_file_mentions(content, ignore_current=True))

# 如果文件集合匹配,说明分析完成

if mentioned_rel_fnames == current_rel_fnames:

return True

# 如果达到最大反射次数,强制完成

if self.num_reflections >= self.max_reflections - 1:

return True

# 更新文件集合并继续分析

self.abs_fnames = set()

for fname in mentioned_rel_fnames:

self.add_rel_fname(fname)

self.reflected_message = self.gpt_prompts.try_again

return True

2. 使用 tree-sitter 进行精确的语法分析

2.1 Tree-sitter 集成架构

目录结构: aider/queries/

Aider 使用 tree-sitter 进行多语言的精确语法分析,支持以下语言:

aider/queries/

├── tree-sitter-languages/

│ ├── python/

│ ├── javascript/

│ ├── typescript/

│ ├── java/

│ ├── cpp/

│ ├── rust/

│ └── go/

└── tree-sitter-language-pack/

2.2 语法查询系统

查询定义文件

每种语言都有对应的查询文件,定义了如何提取关键语法元素:

Python 查询示例 (queries/python.scm):

; 函数定义

(function_definition

name: (identifier) @name.definition.function) @definition.function

; 类定义

(class_definition

name: (identifier) @name.definition.class) @definition.class

; 方法调用

(call

function: (attribute

object: (identifier) @name.reference.call

attribute: (identifier) @name.reference.method)) @reference.call

; 导入语句

(import_statement

name: (dotted_name) @name.reference.import) @reference.import

语法分析器实现

class TreeSitterAnalyzer:

def __init__(self, language):

self.language = language

self.parser = self.get_parser(language)

self.queries = self.load_queries(language)

def parse_file(self, fname):

"""解析文件并返回语法树"""

try:

content = self.io.read_text(fname)

tree = self.parser.parse(bytes(content, "utf8"))

return tree

except Exception as e:

self.io.tool_error(f"Failed to parse {fname}: {e}")

return None

def extract_definitions(self, tree):

"""提取所有定义"""

definitions = []

# 执行查询

captures = self.queries['definitions'].captures(tree.root_node)

for node, capture_name in captures:

if capture_name == 'name.definition.function':

definitions.append({

'type': 'function',

'name': node.text.decode('utf8'),

'line': node.start_point[0] + 1,

'column': node.start_point[1]

})

elif capture_name == 'name.definition.class':

definitions.append({

'type': 'class',

'name': node.text.decode('utf8'),

'line': node.start_point[0] + 1,

'column': node.start_point[1]

})

return definitions

def extract_references(self, tree):

"""提取所有引用"""

references = []

captures = self.queries['references'].captures(tree.root_node)

for node, capture_name in captures:

references.append({

'name': node.text.decode('utf8'),

'type': capture_name,

'line': node.start_point[0] + 1,

'column': node.start_point[1]

})

return references

2.3 多语言支持

语言检测和解析器选择

def get_language_parser(fname):

"""根据文件扩展名选择合适的解析器"""

ext = Path(fname).suffix.lower()

language_map = {

'.py': 'python',

'.js': 'javascript',

'.ts': 'typescript',

'.tsx': 'tsx',

'.java': 'java',

'.cpp': 'cpp',

'.cc': 'cpp',

'.cxx': 'cpp',

'.c': 'c',

'.h': 'c',

'.rs': 'rust',

'.go': 'go',

'.rb': 'ruby',

'.php': 'php',

'.cs': 'csharp',

'.swift': 'swift',

'.kt': 'kotlin',

'.scala': 'scala'

}

return language_map.get(ext, 'text')

2.4 语义分析增强

符号解析和作用域分析

class SemanticAnalyzer:

def __init__(self, tree_sitter_analyzer):

self.ts_analyzer = tree_sitter_analyzer

self.symbol_table = {}

self.scope_stack = []

def analyze_file(self, fname):

"""执行语义分析"""

tree = self.ts_analyzer.parse_file(fname)

if not tree:

return None

# 构建符号表

self.build_symbol_table(tree.root_node)

# 解析依赖关系

dependencies = self.extract_dependencies(tree.root_node)

return {

'symbols': self.symbol_table,

'dependencies': dependencies,

'exports': self.extract_exports(tree.root_node),

'imports': self.extract_imports(tree.root_node)

}

def build_symbol_table(self, node):

"""构建符号表"""

if node.type in ['function_definition', 'class_definition']:

name_node = node.child_by_field_name('name')

if name_node:

symbol_name = name_node.text.decode('utf8')

self.symbol_table[symbol_name] = {

'type': node.type,

'line': node.start_point[0] + 1,

'scope': len(self.scope_stack),

'children': []

}

# 递归处理子节点

for child in node.children:

self.build_symbol_table(child)

3. 动态调整上下文内容以适应不同模型的 token 限制

3.1 Token 管理系统

基础 Token 计算

class TokenManager:

def __init__(self, model_name, max_tokens=None):

self.model_name = model_name

self.max_tokens = max_tokens or self.get_model_max_tokens(model_name)

self.reserved_tokens = 1000 # 为响应预留的 token

self.available_tokens = self.max_tokens - self.reserved_tokens

def count_tokens(self, text):

"""计算文本的 token 数量"""

if self.model_name.startswith('gpt-'):

# 使用 tiktoken 进行精确计算

import tiktoken

encoding = tiktoken.encoding_for_model(self.model_name)

return len(encoding.encode(text))

else:

# 使用近似计算

return len(text.split()) * 1.3 # 经验值

def get_model_max_tokens(self, model_name):

"""获取模型的最大 token 限制"""

model_limits = {

'gpt-4': 8192,

'gpt-4-32k': 32768,

'gpt-3.5-turbo': 4096,

'gpt-3.5-turbo-16k': 16384,

'claude-2': 100000,

'claude-instant': 100000

}

return model_limits.get(model_name, 4096)

3.2 动态上下文调整策略

优先级排序系统

class ContextManager:

def __init__(self, token_manager, repo_map):

self.token_manager = token_manager

self.repo_map = repo_map

self.context_items = []

def build_context(self, chat_files, request_text, mentioned_idents):

"""构建动态调整的上下文"""

# 1. 计算基础上下文大小

base_context = self.build_base_context(chat_files, request_text)

base_tokens = self.token_manager.count_tokens(base_context)

# 2. 计算可用于仓库映射的 token

available_for_repo = self.token_manager.available_tokens - base_tokens

# 3. 动态调整仓库映射大小

if available_for_repo > 0:

self.repo_map.max_map_tokens = min(

available_for_repo,

self.repo_map.max_map_tokens

)

# 获取排序后的文件列表

ranked_files = self.repo_map.get_ranked_tags_map(

chat_files, mentioned_idents=mentioned_idents

)

# 4. 逐步添加文件直到达到 token 限制

repo_context = ""

current_tokens = base_tokens

for fname, score in ranked_files.items():

file_content = self.repo_map.render_one_file(fname, mentioned_idents)

file_tokens = self.token_manager.count_tokens(file_content)

if current_tokens + file_tokens <= self.token_manager.available_tokens:

repo_context += file_content

current_tokens += file_tokens

else:

# Token 限制达到,停止添加

break

return base_context + repo_context

return base_context

智能截断策略

def smart_truncate_context(self, context_items, max_tokens):

"""智能截断上下文内容"""

# 按优先级排序

sorted_items = sorted(context_items, key=lambda x: x['priority'], reverse=True)

result_context = ""

current_tokens = 0

for item in sorted_items:

item_tokens = self.token_manager.count_tokens(item['content'])

if current_tokens + item_tokens <= max_tokens:

# 完整添加

result_context += item['content']

current_tokens += item_tokens

else:

# 需要截断

remaining_tokens = max_tokens - current_tokens

if remaining_tokens > 100: # 至少保留 100 个 token

truncated_content = self.truncate_content(

item['content'], remaining_tokens

)

result_context += truncated_content

break

return result_context

def truncate_content(self, content, max_tokens):

"""截断单个内容项"""

lines = content.split('\n')

truncated_lines = []

current_tokens = 0

# 优先保留开头和结尾

start_lines = lines[:len(lines)//3]

end_lines = lines[2*len(lines)//3:]

for line in start_lines:

line_tokens = self.token_manager.count_tokens(line)

if current_tokens + line_tokens <= max_tokens // 2:

truncated_lines.append(line)

current_tokens += line_tokens

else:

break

truncated_lines.append("... [content truncated] ...")

for line in reversed(end_lines):

line_tokens = self.token_manager.count_tokens(line)

if current_tokens + line_tokens <= max_tokens:

truncated_lines.insert(-1, line)

current_tokens += line_tokens

else:

break

return '\n'.join(truncated_lines)

3.3 模型适配层

不同模型的优化策略

class ModelAdapter:

def __init__(self, model_name):

self.model_name = model_name

self.optimization_strategy = self.get_optimization_strategy()

def get_optimization_strategy(self):

"""根据模型特性选择优化策略"""

if self.model_name.startswith('gpt-4'):

return {

'context_ratio': 0.7, # 70% 用于上下文

'prefer_detailed': True,

'max_file_size': 2000, # token

'truncation_strategy': 'smart'

}

elif self.model_name.startswith('gpt-3.5'):

return {

'context_ratio': 0.6,

'prefer_detailed': False,

'max_file_size': 1000,

'truncation_strategy': 'aggressive'

}

elif 'claude' in self.model_name:

return {

'context_ratio': 0.8, # Claude 处理长上下文更好

'prefer_detailed': True,

'max_file_size': 5000,

'truncation_strategy': 'minimal'

}

else:

return {

'context_ratio': 0.6,

'prefer_detailed': False,

'max_file_size': 1000,

'truncation_strategy': 'aggressive'

}

def optimize_context(self, context_manager, chat_files, request_text):

"""根据模型特性优化上下文"""

strategy = self.optimization_strategy

# 调整 token 分配

context_manager.token_manager.available_tokens *= strategy['context_ratio']

# 调整文件大小限制

context_manager.repo_map.max_file_tokens = strategy['max_file_size']

# 选择截断策略

context_manager.truncation_strategy = strategy['truncation_strategy']

return context_manager.build_context(chat_files, request_text)

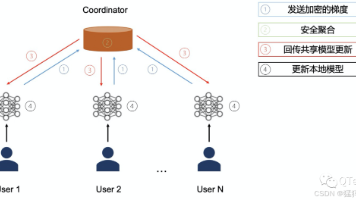

4. 组件协作关系

4.1 整体架构图

┌─────────────────┐ ┌─────────────────┐ ┌─────────────────┐

│ ContextCoder │ │ TokenManager │ │ ModelAdapter │

│ │ │ │ │ │

│ - 文件选择 │ │ - Token计算 │ │ - 模型优化 │

│ - 反射机制 │ │ - 限制管理 │ │ - 策略选择 │

└─────────┬───────┘ └─────────┬───────┘ └─────────┬───────┘

│ │ │

│ │ │

└──────────────────────┼──────────────────────┘

│

┌─────────────┴───────────┐

│ ContextManager │

│ │

│ - 上下文构建 │

│ - 动态调整 │

│ - 智能截断 │

└─────────────┬──────────┘

│

┌───────────────────────┼───────────────────────┐

│ │ │

┌─────────┴───────┐ ┌─────────┴───────┐ ┌─────────┴───────┐

│ RepoMap │ │ TreeSitterAnalyzer│ │ SemanticAnalyzer│

│ │ │ │ │ │

│ - 依赖分析 │ │ - 语法解析 │ │ - 语义分析 │

│ - 文件排序 │ │ - 符号提取 │ │ - 作用域分析 │

│ - 映射生成 │ │ - 多语言支持 │ │ - 依赖追踪 │

└─────────────────┘ └─────────────────┘ └─────────────────┘

4.2 数据流分析

def analyze_context_flow():

"""分析上下文管理的数据流"""

# 1. 输入阶段

user_request = "用户请求"

chat_files = ["当前聊天中的文件"]

# 2. 语法分析阶段

tree_sitter = TreeSitterAnalyzer(language)

syntax_info = tree_sitter.analyze_files(chat_files)

# 3. 语义分析阶段

semantic_analyzer = SemanticAnalyzer(tree_sitter)

semantic_info = semantic_analyzer.analyze_dependencies(syntax_info)

# 4. 文件选择阶段

repo_map = RepoMap()

ranked_files = repo_map.get_ranked_tags_map(

chat_files,

mentioned_idents=semantic_info['mentioned_idents']

)

# 5. Token 管理阶段

token_manager = TokenManager(model_name)

available_tokens = token_manager.calculate_available_tokens()

# 6. 上下文构建阶段

context_manager = ContextManager(token_manager, repo_map)

final_context = context_manager.build_context(

chat_files, user_request, semantic_info['mentioned_idents']

)

# 7. 模型适配阶段

model_adapter = ModelAdapter(model_name)

optimized_context = model_adapter.optimize_context(

context_manager, chat_files, user_request

)

return optimized_context

5. 性能优化策略

5.1 缓存机制

文件解析缓存

class ParseCache:

def __init__(self, max_size=1000):

self.cache = {}

self.max_size = max_size

self.access_times = {}

def get_parsed_file(self, fname, mtime):

"""获取缓存的解析结果"""

cache_key = f"{fname}:{mtime}"

if cache_key in self.cache:

self.access_times[cache_key] = time.time()

return self.cache[cache_key]

return None

def cache_parsed_file(self, fname, mtime, parsed_data):

"""缓存解析结果"""

cache_key = f"{fname}:{mtime}"

# 检查缓存大小

if len(self.cache) >= self.max_size:

self.evict_oldest()

self.cache[cache_key] = parsed_data

self.access_times[cache_key] = time.time()

def evict_oldest(self):

"""淘汰最旧的缓存项"""

oldest_key = min(self.access_times.keys(),

key=lambda k: self.access_times[k])

del self.cache[oldest_key]

del self.access_times[oldest_key]

依赖关系缓存

class DependencyCache:

def __init__(self):

self.file_dependencies = {}

self.symbol_references = {}

self.last_update = {}

def get_file_dependencies(self, fname):

"""获取文件依赖关系"""

mtime = os.path.getmtime(fname)

if (fname in self.file_dependencies and

self.last_update.get(fname, 0) >= mtime):

return self.file_dependencies[fname]

# 重新计算依赖关系

deps = self.calculate_dependencies(fname)

self.file_dependencies[fname] = deps

self.last_update[fname] = mtime

return deps

5.2 增量更新

增量语法分析

class IncrementalAnalyzer:

def __init__(self):

self.file_states = {}

self.dependency_graph = {}

def update_file(self, fname, new_content):

"""增量更新文件分析"""

old_state = self.file_states.get(fname, {})

# 解析新内容

new_tree = self.parse_content(new_content)

new_symbols = self.extract_symbols(new_tree)

# 计算变化

added_symbols = new_symbols - old_state.get('symbols', set())

removed_symbols = old_state.get('symbols', set()) - new_symbols

# 更新依赖图

self.update_dependency_graph(fname, added_symbols, removed_symbols)

# 更新状态

self.file_states[fname] = {

'symbols': new_symbols,

'tree': new_tree,

'last_modified': time.time()

}

return {

'added': added_symbols,

'removed': removed_symbols,

'affected_files': self.get_affected_files(fname)

}

5.3 并行处理

多线程文件分析

import concurrent.futures

import threading

class ParallelAnalyzer:

def __init__(self, max_workers=4):

self.max_workers = max_workers

self.thread_local = threading.local()

def analyze_files_parallel(self, file_list):

"""并行分析多个文件"""

with concurrent.futures.ThreadPoolExecutor(

max_workers=self.max_workers

) as executor:

# 提交分析任务

future_to_file = {

executor.submit(self.analyze_single_file, fname): fname

for fname in file_list

}

results = {}

for future in concurrent.futures.as_completed(future_to_file):

fname = future_to_file[future]

try:

result = future.result()

results[fname] = result

except Exception as e:

results[fname] = {'error': str(e)}

return results

def analyze_single_file(self, fname):

"""分析单个文件(线程安全)"""

# 获取线程本地的解析器

if not hasattr(self.thread_local, 'parser'):

self.thread_local.parser = self.create_parser()

parser = self.thread_local.parser

return parser.analyze_file(fname)

6. 总结

Aider 的智能上下文管理系统通过以下三个核心技术实现了高效的代码理解和编辑:

6.1 技术优势

- 智能文件选择: 通过依赖关系分析和符号引用计数,准确识别相关文件

- 精确语法分析: 使用 tree-sitter 支持多语言的精确语法解析

- 动态上下文调整: 根据模型限制和请求特点动态调整上下文内容

6.2 性能特点

- 缓存机制: 多层缓存减少重复计算

- 增量更新: 只更新变化的部分,提高效率

- 并行处理: 多线程分析提高处理速度

- 智能截断: 保留最重要的信息,适应 token 限制

6.3 扩展性

- 模块化设计: 各组件职责清晰,易于扩展

- 插件架构: 支持新语言和新模型的接入

- 配置灵活: 可根据不同场景调整参数

这套系统为 AI 代码编辑工具提供了一个完整的上下文管理解决方案,在准确性、效率和扩展性方面都表现出色。

更多推荐

已为社区贡献42条内容

已为社区贡献42条内容

所有评论(0)