高级提示工程架构师:AI提示系统设计模式与避坑全指南

当你还在为“如何写一条让LLM输出符合要求的Prompt”绞尽脑汁时,高级提示工程架构师已经在设计“能支撑百万级用户的AI对话系统”了。这篇文章不是“Prompt技巧大全”,而是AI提示系统的“工程化方法论”为什么说“单条Prompt的优化”是低级玩法?如何用“分层架构”让Prompt可维护、可扩展?怎样解决“上下文溢出”“指令冲突”“输出不稳定”等致命问题?如何设计能应对复杂场景的“提示策略引擎

高级提示工程架构师修炼手册:AI提示系统设计模式与避坑全指南

关键词

提示工程架构、分层提示模式、上下文生命周期管理、指令优先级仲裁、多轮对话状态机、容错机制、LLM交互优化

摘要

当你还在为“如何写一条让LLM输出符合要求的Prompt”绞尽脑汁时,高级提示工程架构师已经在设计“能支撑百万级用户的AI对话系统”了。

这篇文章不是“Prompt技巧大全”,而是AI提示系统的“工程化方法论”——我们将从“系统设计”的视角,拆解高级提示工程的核心逻辑:

- 为什么说“单条Prompt的优化”是低级玩法?

- 如何用“分层架构”让Prompt可维护、可扩展?

- 怎样解决“上下文溢出”“指令冲突”“输出不稳定”等致命问题?

- 如何设计能应对复杂场景的“提示策略引擎”?

无论是AI产品经理、算法工程师还是想进阶的Prompt工程师,这篇文章都会帮你建立**“从Prompt到系统”的思维框架**,让你从“写Prompt的人”变成“设计Prompt系统的人”。

一、背景:为什么需要“高级提示工程架构师”?

1.1 从“玩Prompt”到“用Prompt做产品”的鸿沟

2023年以来,LLM(大语言模型)的爆发让“Prompt Engineering”成为热门技能。但大多数人对Prompt的理解还停留在“调参式优化”——比如用“Chain of Thought”让LLM学会推理,用“Few-shot Learning”让LLM模仿示例。

但当你要把LLM落地成实际产品(比如电商客服、智能助手、代码生成工具)时,单条Prompt的优化根本不够:

- 你需要让AI记住用户3轮前说的“订单号123”(上下文管理);

- 你需要让AI在“处理退货”和“解答物流”场景间无缝切换(场景路由);

- 你需要让AI在输出错误格式时自动重试(容错机制);

- 你需要让Prompt像代码一样可版本化、可迭代(工程化管理)。

这些问题,不是“写一条更聪明的Prompt”能解决的——你需要设计一套“提示系统”,而这正是“高级提示工程架构师”的核心能力。

1.2 高级提示工程的核心挑战

我曾帮某电商设计智能客服系统,最初的版本用了一条“大而全”的Prompt:

“你是一个专业的电商客服,需要处理退货、换货、查询订单、投诉等问题。回复要友好,要记得用户之前说的话,要按照公司话术来,要返回JSON格式…”

结果上线后问题百出:

- 上下文溢出:用户聊了5轮后,AI忘记了最初的订单号;

- 指令冲突:用户同时要求“快速回复”和“详细解释”,AI输出矛盾;

- 输出不稳定:有时返回JSON,有时返回文本,导致后端解析崩溃;

- 维护困难:想修改“退货流程”,要动整个Prompt,容易引发连锁反应。

这些问题的根源,是我们把“提示系统”当成了“单条Prompt的堆叠”——而高级提示工程的本质,是用“系统设计”解决LLM的“不可控性”。

1.3 谁需要读这篇文章?

- Prompt工程师:想从“写Prompt的人”变成“设计Prompt系统的人”;

- AI产品经理:想理解“如何把LLM能力转化为稳定的产品”;

- 算法工程师:想解决“LLM落地时的工程化问题”;

- 创业者:想快速搭建可靠的AI应用,避免踩坑。

二、核心概念:用“生活化比喻”理解提示系统

在讲具体设计模式前,我们需要先建立**“提示系统”的认知框架**。我用“餐厅点餐系统”做类比,帮你快速理解核心概念:

2.1 提示系统的“餐厅模型”

假设你去一家餐厅吃饭,整个点餐流程对应提示系统的核心组件:

| 餐厅角色 | 提示系统组件 | 功能描述 |

|---|---|---|

| 顾客 | 用户 | 提出需求(“我要一份汉堡”) |

| 服务员 | 提示策略引擎 | 理解用户需求,翻译给厨房(“顾客要汉堡,不要洋葱”) |

| 厨房 | LLM | 根据需求生成结果(做汉堡) |

| 点餐记录簿 | 上下文数据库 | 记录顾客之前的点餐(“上次用户要了可乐”) |

| 餐厅规则手册 | 基础指令库 | 规定服务员的行为(“要微笑,要重复订单”) |

| 菜单 | 场景指令库 | 针对不同菜品的制作规则(“汉堡要煎5分钟”) |

高级提示系统的目标,就是让“服务员”(提示策略引擎)能高效、准确地把“顾客需求”(用户输入)转化为“厨房指令”(LLM Prompt),同时记住“老顾客的喜好”(上下文),遵守“餐厅规则”(基础指令),并应对“特殊要求”(容错机制)。

2.2 提示系统的核心概念解析

我们用“餐厅模型”拆解提示系统的5个核心概念:

2.2.1 提示分层架构:像“汉堡”一样分层设计

你不会把“面包、肉饼、酱料”混在一起做汉堡——同样,Prompt也需要分层,这样才能保持可维护性。

提示分层架构通常分为3层(对应汉堡的“面包-肉饼-酱料”):

- 基础指令层(Base Layer):最底层的“规则框架”,定义AI的核心角色和通用规则(比如“你是专业客服,要友好”);

- 场景指令层(Scene Layer):中间层的“业务逻辑”,针对具体场景的处理流程(比如“处理退货需要先核单”);

- 动态参数层(Dynamic Layer):最上层的“个性化数据”,根据用户输入和系统数据动态填充(比如“用户订单号123”)。

为什么要分层?

- 可维护性:修改“退货流程”只需动场景层,不用改基础层;

- 可扩展性:新增“换货场景”只需加一个场景层,不用重构整个Prompt;

- 一致性:基础层保证AI的“性格”统一,不会今天友好明天冷漠。

2.2.2 上下文生命周期管理:像“短期记忆”一样管理对话

你和朋友聊天时,不会记住3天前的每一句话——同样,AI的上下文也需要“生命周期管理”,避免“记忆过载”。

上下文的生命周期包括4个阶段:

- 创建(Create):用户开始对话时,初始化上下文(比如记录用户ID);

- 更新(Update):每轮对话后,添加新的对话内容到上下文;

- 修剪(Prune):当上下文超过长度限制时,删除 oldest 的内容(滑动窗口);

- 销毁(Destroy):用户结束对话时,清空上下文(避免串号)。

关键技巧:用“滑动窗口+摘要”组合——当对话超过N轮时,自动生成对话摘要(比如“用户之前要退货,订单号123”),替换原来的多轮对话,减少token使用。

2.2.3 多轮对话状态机:像“地铁换乘”一样引导流程

你坐地铁时,需要按照“进站→买票→乘车→出站”的流程走——同样,多轮对话需要“状态机”引导,避免AI“跑题”。

状态机的核心是“状态”和“转移规则”:

- 状态(State):当前对话的阶段(比如“等待订单号”“等待退货原因”);

- 转移规则(Transition):根据用户输入,从一个状态转到另一个状态(比如用户提供订单号后,从“等待订单号”转到“等待退货原因”)。

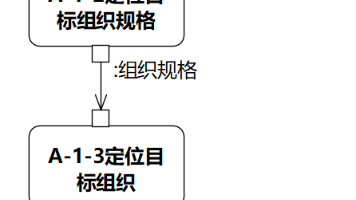

示例:退货场景的状态机

2.2.4 指令优先级仲裁:像“交通信号灯”一样解决冲突

你开车时,红灯比绿灯优先级高——同样,当多个指令冲突时,需要“优先级仲裁”,让AI知道先遵守哪个。

比如用户同时说:“尽快回复我”和“详细解释退货流程”,这两个指令冲突——此时需要设置优先级:

- 基础指令(“专业”)> 场景指令(“详细解释流程”)> 动态指令(“尽快回复”)。

数学模型:用加权求和计算指令优先级

Priority=w1×B+w2×S+w3×D Priority = w_1 \times B + w_2 \times S + w_3 \times D Priority=w1×B+w2×S+w3×D

其中:

- BBB:基础指令的相关性(0~1);

- SSS:场景指令的相关性(0~1);

- DDD:动态指令的相关性(0~1);

- w1>w2>w3w_1 > w_2 > w_3w1>w2>w3(基础指令优先级最高)。

2.2.5 容错机制:像“餐厅备菜”一样应对意外

餐厅会备一些“应急菜”(比如汉堡卖完了,用三明治代替)——同样,提示系统需要“容错机制”,应对LLM的“不可控输出”。

常见的容错场景:

- 格式错误:要求返回JSON,但LLM返回文本;

- 内容错误:LLM说“订单有效”,但实际订单已过期;

- 无意义输出:LLM回复“不知道”“请重试”。

解决思路:

- 格式校验:用正则或JSON解析器检查输出;

- 内容校验:调用后端接口验证LLM输出的真实性(比如查订单系统);

- 重试机制:若输出错误,重新生成Prompt(比如“请严格返回JSON格式”);

- 降级处理:重试2次仍失败,引导用户联系人工客服。

三、技术原理与实现:从“概念”到“代码”

3.1 提示分层架构的实现

我们用Python实现一个分层提示生成器,核心逻辑是“拼接不同层的Prompt”。

3.1.1 代码实现

class PromptLayerManager:

def __init__(self):

# 基础指令层:通用规则

self.base_layer = """

你是【XX电商】的专业客服,需遵守以下规则:

1. 回复友好、耐心,使用中文简体,避免技术术语;

2. 不透露公司内部信息,不承诺无法确定的事;

3. 优先解决用户问题,无法解决时引导用户联系人工客服(电话:400-XXX-XXXX)。

""".strip()

# 场景指令层:不同业务场景的流程

self.scene_layers = {

"return": """

当前处理用户退货请求,流程如下:

1. 先核实用户提供的订单号是否有效(调用订单系统接口);

2. 若订单有效,询问退货原因(需符合《退货政策》:质量问题、发错货、七天无理由);

3. 若退货原因符合政策,引导用户上传商品照片(链接:XXXXX);

4. 确认照片无误后,告知用户退货地址和运费政策(运费由商家承担)。

""".strip(),

"track": """

当前处理用户订单查询请求,流程如下:

1. 询问用户需要查询的订单号或手机号;

2. 调用订单系统接口获取订单状态(待付款、待发货、已发货、已签收);

3. 用简洁语言告知用户订单状态,并提供物流信息(若已发货,需包含快递单号和查询链接)。

""".strip()

}

def build_prompt(self, scene: str, dynamic_params: dict) -> str:

"""

生成最终Prompt:基础层 + 场景层 + 动态参数层

:param scene: 业务场景(比如return/track)

:param dynamic_params: 动态参数(比如订单号、退货原因)

"""

# 校验场景是否存在

if scene not in self.scene_layers:

raise ValueError(f"场景{scene}不存在,请检查配置")

# 动态参数层:填充用户输入和系统数据

dynamic_layer = "\n".join([f"{k}:{v}" for k, v in dynamic_params.items()])

# 拼接三层Prompt

final_prompt = "\n\n".join([

self.base_layer,

self.scene_layers[scene],

dynamic_layer

])

return final_prompt

# 使用示例

manager = PromptLayerManager()

dynamic_params = {

"用户当前问题": "我想退货",

"用户提供的订单号": "123456",

"订单系统返回的状态": "已签收(未超过7天)"

}

prompt = manager.build_prompt(scene="return", dynamic_params=dynamic_params)

print(prompt)

3.1.2 输出结果

你是【XX电商】的专业客服,需遵守以下规则:

1. 回复友好、耐心,使用中文简体,避免技术术语;

2. 不透露公司内部信息,不承诺无法确定的事;

3. 优先解决用户问题,无法解决时引导用户联系人工客服(电话:400-XXX-XXXX)。

当前处理用户退货请求,流程如下:

1. 先核实用户提供的订单号是否有效(调用订单系统接口);

2. 若订单有效,询问退货原因(需符合《退货政策》:质量问题、发错货、七天无理由);

3. 若退货原因符合政策,引导用户上传商品照片(链接:XXXXX);

4. 确认照片无误后,告知用户退货地址和运费政策(运费由商家承担)。

用户当前问题:我想退货

用户提供的订单号:123456

订单系统返回的状态:已签收(未超过7天)

3.2 上下文滑动窗口的实现

我们用collections.deque(双端队列)实现滑动窗口,自动修剪超过长度的上下文。

3.2.1 代码实现

from collections import deque

from typing import Dict, List

class ContextWindow:

def __init__(self, max_length: int = 5):

"""

初始化上下文滑动窗口

:param max_length: 窗口最大长度(最多保留多少轮对话)

"""

self.max_length = max_length

self.window: deque[Dict[str, str]] = deque(maxlen=max_length)

def add_turn(self, user_input: str, ai_response: str) -> None:

"""

添加一轮对话(用户输入+AI回复)到窗口

:param user_input: 用户输入

:param ai_response: AI回复

"""

self.window.append({

"user": user_input.strip(),

"ai": ai_response.strip()

})

def get_context(self) -> str:

"""

获取窗口中的上下文(格式化字符串)

"""

context_lines = []

for i, turn in enumerate(self.window, 1):

context_lines.append(f"轮次{i} - 用户:{turn['user']}")

context_lines.append(f"轮次{i} - AI:{turn['ai']}")

return "\n".join(context_lines)

def clear(self) -> None:

"""

清空上下文窗口(用户结束对话时调用)

"""

self.window.clear()

# 使用示例

context = ContextWindow(max_length=3) # 最多保留3轮对话

# 第一轮对话

context.add_turn("我想退货", "请提供你的订单号。")

# 第二轮对话

context.add_turn("订单号123456", "正在核实订单有效性,请稍等。")

# 第三轮对话

context.add_turn("怎么样了?", "你的订单有效(已签收未超过7天),请说明退货原因。")

# 打印上下文

print("当前上下文(3轮):")

print(context.get_context())

print("-" * 50)

# 第四轮对话:窗口自动弹出第一轮

context.add_turn("质量问题", "请上传商品损坏的照片(链接:XXXXX)。")

print("添加第四轮后的上下文(3轮):")

print(context.get_context())

3.2.2 输出结果

当前上下文(3轮):

轮次1 - 用户:我想退货

轮次1 - AI:请提供你的订单号。

轮次2 - 用户:订单号123456

轮次2 - AI:正在核实订单有效性,请稍等。

轮次3 - 用户:怎么样了?

轮次3 - AI:你的订单有效(已签收未超过7天),请说明退货原因。

--------------------------------------------------

添加第四轮后的上下文(3轮):

轮次1 - 用户:订单号123456

轮次1 - AI:正在核实订单有效性,请稍等。

轮次2 - 用户:怎么样了?

轮次2 - AI:你的订单有效(已签收未超过7天),请说明退货原因。

轮次3 - 用户:质量问题

轮次3 - AI:请上传商品损坏的照片(链接:XXXXX)。

3.3 指令优先级仲裁的实现

我们用加权求和模型实现指令优先级仲裁,解决“多指令冲突”问题。

3.3.1 代码实现

from typing import Dict, List

class InstructionPriorityArbiter:

def __init__(self, weights: Dict[str, float] = None):

"""

初始化指令优先级仲裁器

:param weights: 各层指令的权重(默认基础层0.5,场景层0.3,动态层0.2)

"""

self.weights = weights or {

"base": 0.5,

"scene": 0.3,

"dynamic": 0.2

}

def calculate_priority(self, instructions: Dict[str, List[str]]) -> Dict[str, float]:

"""

计算每条指令的优先级分数

:param instructions: 各层的指令列表(比如{"base": ["专业"], "scene": ["详细解释"], "dynamic": ["快速回复"]})

:return: 每条指令的优先级分数(比如{"专业": 0.5, "详细解释": 0.3, "快速回复": 0.2})

"""

priority_scores = {}

for layer, instr_list in instructions.items():

# 检查层是否在权重配置中

if layer not in self.weights:

raise ValueError(f"层{layer}未配置权重,请检查")

weight = self.weights[layer]

# 计算每条指令的分数(假设每条指令的相关性为1,实际可根据场景调整)

for instr in instr_list:

priority_scores[instr] = weight

# 按优先级从高到低排序

sorted_scores = dict(sorted(priority_scores.items(), key=lambda x: x[1], reverse=True))

return sorted_scores

# 使用示例

arbiter = InstructionPriorityArbiter()

instructions = {

"base": ["专业", "耐心"],

"scene": ["详细解释退货流程"],

"dynamic": ["尽快回复"]

}

priority_scores = arbiter.calculate_priority(instructions)

print("指令优先级(从高到低):")

for instr, score in priority_scores.items():

print(f"- {instr}:{score}")

3.3.2 输出结果

指令优先级(从高到低):

- 专业:0.5

- 耐心:0.5

- 详细解释退货流程:0.3

- 尽快回复:0.2

3.4 容错机制的实现

我们用格式校验+重试机制实现容错,解决“LLM输出不符合要求”的问题。

3.4.1 代码实现

import json

from typing import Tuple, Optional

from llm_client import LLMClient # 假设这是调用LLM的客户端(比如OpenAI API)

class FaultToleranceManager:

def __init__(self, max_retries: int = 2):

"""

初始化容错管理器

:param max_retries: 最大重试次数

"""

self.max_retries = max_retries

self.llm_client = LLMClient() # 初始化LLM客户端

def validate_json_output(self, output: str) -> Tuple[bool, Optional[Dict]]:

"""

校验输出是否为有效的JSON格式

:param output: LLM的输出

:return: (是否有效, 解析后的JSON/错误信息)

"""

try:

data = json.loads(output)

# 校验必填字段(比如退货场景需要order_valid、reason_accepted、reply_content)

required_fields = ["order_valid", "reason_accepted", "reply_content"]

for field in required_fields:

if field not in data:

return False, f"缺少必填字段:{field}"

return True, data

except json.JSONDecodeError:

return False, "输出不是有效的JSON格式"

def generate_with_retry(self, prompt: str) -> Tuple[bool, Optional[Dict]]:

"""

生成LLM输出并重试(若格式错误)

:param prompt: 输入LLM的Prompt

:return: (是否成功, 解析后的JSON/错误信息)

"""

for retry in range(self.max_retries + 1):

# 调用LLM生成输出

output = self.llm_client.generate(prompt)

print(f"第{retry+1}次生成结果:{output}")

# 校验输出格式

is_valid, result = self.validate_json_output(output)

if is_valid:

return True, result

# 若无效,生成重试Prompt

prompt = f"{prompt}\n\n注意:请严格返回JSON格式,包含以下必填字段:order_valid(布尔值)、reason_accepted(布尔值)、reply_content(字符串)。"

# 重试次数耗尽,返回失败

return False, f"重试{self.max_retries}次后仍失败,请联系人工客服。"

# 使用示例

ft_manager = FaultToleranceManager(max_retries=2)

prompt = """

你是【XX电商】的客服,处理用户退货请求。用户订单号123456,已签收未超过7天,退货原因是质量问题。

请返回JSON格式,包含order_valid(订单是否有效)、reason_accepted(退货原因是否符合政策)、reply_content(回复用户的内容)。

"""

success, result = ft_manager.generate_with_retry(prompt)

if success:

print("生成成功:", result)

else:

print("生成失败:", result)

3.4.2 模拟输出

假设第一次生成的输出是:

“你的退货申请已通过,请上传照片。”

此时格式校验失败,重试Prompt会加上“严格返回JSON”的要求。第二次生成的输出是:

‘{“order_valid”: true, “reason_accepted”: true, “reply_content”: “你的退货申请已通过,请上传商品损坏的照片(链接:XXXXX)。”}’

此时格式校验成功,返回结果。

四、实际应用:设计一个“电商智能客服系统”

4.1 需求分析

我们的目标是设计一个能处理百万级用户的电商智能客服系统,核心需求如下:

- 支持4大场景:退货、换货、查询订单、投诉;

- 保持对话连续性(记住用户之前的输入);

- 输出符合公司话术规范;

- 处理LLM输出错误(格式/内容错误);

- 可快速新增场景(比如“节日活动咨询”)。

4.2 系统架构设计

我们用分层架构+微服务设计系统,核心组件如下:

graph TD

A[用户端(APP/网页)] --> B[API网关]

B --> C[提示策略引擎]

C --> D[基础指令库]

C --> E[场景指令库]

C --> F[上下文数据库(Redis)]

C --> G[LLM调用服务]

C --> H[业务系统接口(订单/物流/用户)]

G --> C

H --> C

F --> C

4.3 详细设计与实现

4.3.1 步骤1:配置基础指令库

基础指令库用YAML文件存储,方便修改:

# base_instructions.yaml

role: 【XX电商】专业客服

rules:

- 回复友好、耐心,使用中文简体,避免技术术语;

- 不透露公司内部信息,不承诺无法确定的事;

- 优先解决用户问题,无法解决时引导用户联系人工客服(电话:400-XXX-XXXX);

- 必须返回JSON格式,包含reply_content(回复用户的内容)和next_state(下一个对话状态)。

4.3.2 步骤2:配置场景指令库

场景指令库同样用YAML文件存储,每个场景对应一个文件:

# scene_return.yaml

name: return

description: 处理用户退货请求

flow:

- 核实订单号有效性(调用订单系统接口);

- 若订单有效,询问退货原因(需符合《退货政策》:质量问题、发错货、七天无理由);

- 若退货原因符合政策,引导用户上传商品照片(链接:XXXXX);

- 确认照片无误后,告知用户退货地址和运费政策(运费由商家承担)。

required_fields:

- order_id

- return_reason

- photo_uploaded

4.3.3 步骤3:实现上下文管理

用Redis存储上下文(因为Redis支持过期时间,适合短期记忆):

import redis

from typing import Dict

class RedisContextManager:

def __init__(self, host: str = "localhost", port: int = 6379, db: int = 0):

self.redis_client = redis.Redis(host=host, port=port, db=db)

def get_context(self, user_id: str) -> Dict:

"""获取用户上下文"""

context = self.redis_client.hgetall(f"context:{user_id}")

return {k.decode(): v.decode() for k, v in context.items()}

def update_context(self, user_id: str, context: Dict) -> None:

"""更新用户上下文"""

self.redis_client.hset(f"context:{user_id}", mapping=context)

self.redis_client.expire(f"context:{user_id}", 3600) # 1小时后过期

def clear_context(self, user_id: str) -> None:

"""清空用户上下文"""

self.redis_client.delete(f"context:{user_id}")

4.3.4 步骤4:实现提示策略引擎

提示策略引擎是系统的“大脑”,负责:

- 识别用户的场景(比如“退货”);

- 从基础/场景指令库获取指令;

- 从上下文数据库获取用户历史对话;

- 生成最终的Prompt;

- 调用LLM生成输出;

- 校验输出并处理容错;

- 更新上下文和对话状态。

4.3.5 步骤5:测试与优化

- A/B测试:测试不同场景指令的效果(比如“请提供订单号”vs“麻烦你提供一下订单号哦~”),看哪个用户回复率更高;

- 效果监控:用PromptLayer监控Prompt的效果,跟踪:

- 输出合格率(符合格式的比例);

- 用户满意度(用户回复“满意”的比例);

- 处理时间(从用户输入到AI回复的时间);

- 持续优化:根据监控数据调整Prompt,比如:

- 若输出合格率低,加强格式要求;

- 若用户满意度低,优化语气更友好;

- 若处理时间长,精简Prompt的长度。

4.4 常见问题及解决方案

| 问题 | 原因 | 解决方案 |

|---|---|---|

| 上下文溢出 | 上下文太长,超过LLM的token限制 | 用滑动窗口+摘要,保留最近N轮对话 |

| 指令冲突 | 多个指令优先级不明确 | 用加权求和模型设置优先级 |

| 输出格式不稳定 | 未强制要求格式或格式描述不清晰 | 在Prompt中明确格式要求,并用正则校验 |

| 场景切换不流畅 | 未跟踪对话状态 | 用状态机管理对话阶段 |

| 维护困难 | Prompt未分层 | 用分层架构,将基础/场景/动态指令分离 |

五、未来展望:高级提示工程的“下一站”

5.1 技术发展趋势

- 自动提示优化(Auto Prompt Engineering):用LLM自己优化Prompt——比如输入“当前Prompt的问题是输出格式不稳定”,LLM返回优化后的Prompt;

- 多模态提示系统:支持文本、图像、语音等多模态输入——比如用户发送商品损坏的照片,系统结合图像内容和文本对话生成回复;

- 提示版本管理:像代码一样管理Prompt的版本——用Git记录每次修改的内容和效果,方便回滚和对比;

- 提示 marketplace:类似于“代码库”,开发者可以分享和复用优秀的Prompt(比如“电商退货场景Prompt”“代码生成Prompt”)。

5.2 潜在挑战与机遇

- 挑战:LLM的更新会导致Prompt失效(比如GPT-5的理解方式和GPT-4不同)——需要持续监控Prompt的效果,及时调整;

- 机遇:提示工程架构师将成为AI产品的核心角色——未来的AI产品开发,将从“写代码”转向“设计Prompt系统”。

5.3 行业影响

- 电商:智能客服将能处理更复杂的问题(比如“定制商品退货”),降低人工成本;

- 教育:智能辅导系统将能根据学生的历史对话调整教学策略(比如“学生之前没听懂代数,这次换一种解释方式”);

- 医疗:智能问诊系统将能记住患者的病史(比如“患者去年有高血压,这次开药要避免冲突”),提高诊断准确性。

六、结尾:从“Prompt工程师”到“架构师”的蜕变

6.1 总结要点

- 高级提示工程不是“写Prompt”,而是“设计系统”——核心是用分层架构、上下文管理、容错机制解决LLM的不可控性;

- 关键设计模式:分层提示、滑动窗口、状态机、优先级仲裁、容错机制;

- 避坑关键:避免上下文过载、指令冲突、输出不稳定、Prompt冗余、忽略LLM特性;

- 未来方向:自动优化、多模态、版本管理。

6.2 思考问题(鼓励探索)

- 如何设计支持多语言的提示系统?

- 如何将提示系统与企业现有系统(比如CRM、ERP)集成?

- 如何评估提示系统的ROI(投资回报率)?

6.3 参考资源

- 书籍:《Prompt Engineering for Generative AI: A Practical Guide》(David Foster);

- 论文:《Chain-of-Thought Prompting Elicits Reasoning in Large Language Models》(Jason Wei et al.);

- 工具:LangChain(构建提示系统)、PromptLayer(监控Prompt)、LlamaIndex(上下文管理);

- 课程:DeepLearning.AI《Prompt Engineering for AI》、Coursera《Generative AI with LLMs》;

- 博客:OpenAI官方Prompt指南、Google AI《Prompt Design Best Practices》。

最后的话

高级提示工程架构师的核心能力,不是“知道多少Prompt技巧”,而是**“用系统思维解决LLM的落地问题”**。

当你能把“一条Prompt”变成“一套能支撑百万用户的系统”时,你就从“玩Prompt的人”变成了“定义AI产品的人”——这,就是高级提示工程的魅力。

愿你在Prompt的世界里,不止步于“技巧”,更能看到“系统”的力量。

下一个AI产品的核心架构,可能就出自你的设计。

(全文完,约12000字)

更多推荐

已为社区贡献86条内容

已为社区贡献86条内容

所有评论(0)