2025 Agentic AI核心赛道:上下文工程架构是提升智能体理解能力的关键

Agentic AI的核心竞争力是"理解能力",而"理解能力"的核心是"上下文工程架构"。技术厂商的"护城河":谁能搭建更高效、更智能的上下文工程架构,谁就能在Agentic AI市场占据先机;企业客户的"刚需":企业需要智能体"懂"自己的业务场景、"懂"自己的用户,而这需要强大的上下文工程支持;开发者的"必备技能":未来的Agentic AI开发,不再是"调LLM的Prompt",而是"设计上下

2025 Agentic AI核心赛道:上下文工程架构是提升智能体理解能力的关键

引言:Agentic AI的"理解瓶颈",到底卡在哪里?

你有没有遇到过这样的智能体交互体验?

- 跟客服AI聊退货:“我昨天买的白色连衣裙不合适"→AI回复"请提供订单号"→你发了订单号→AI又问"请问您要退哪件商品?”;

- 用代码助手写程序:"帮我优化这个Python排序函数"→AI给出方案→你接着说"把时间复杂度降到O(n log n)“→AI却反问"您指的是哪个函数?”;

- 跟家庭助手聊日程:“明天上午10点提醒我开会"→"好的"→过了5分钟你说"把时间改成11点"→AI回复"请问您要修改什么日程?”。

这些**"上下文断裂"的场景,本质上暴露了当前Agentic AI的核心痛点——"理解能力"不足**。

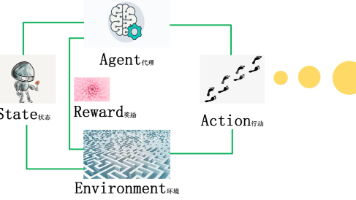

Agentic AI(智能体AI)的定义是"能自主感知环境、规划决策、执行任务的智能系统",而"理解能力"是其底层基石:它需要整合多源信息、关联历史交互、适配场景需求,才能真正"听懂"用户的意图。但现实是,大多数智能体的"上下文处理"还停留在"固定窗口内的文本匹配"阶段——要么记不住 long-term 对话,要么理不清跨模态信息(比如用户发的图片+文字),要么不会根据场景动态调整关注点。

如果把Agentic AI比作"大脑",那么上下文工程架构就是"负责整合记忆、感知和理解的前额叶皮层"。2024年以来,OpenAI、Anthropic、Google等公司的Agentic AI产品(如GPT-4o Agent、Claude 3 Sonnet Workflow)都在悄悄强化这一模块;而2025年,上下文工程架构将成为Agentic AI商业化落地的核心赛道——因为只有解决了"精准理解"问题,智能体才能真正渗透到客服、办公、医疗、工业等复杂场景。

本文将从问题本质→核心概念→架构设计→实践案例→未来趋势,一步步讲清楚:为什么上下文工程是Agentic AI的"理解引擎"?2025年的上下文工程架构需要解决哪些关键问题?如何搭建一个能应对复杂场景的上下文系统?

一、先搞懂:Agentic AI与上下文工程的底层关系

在展开架构设计前,我们需要先明确两个核心概念的定义,以及它们之间的依赖关系。

1.1 Agentic AI的"理解能力"到底是什么?

Agentic AI的"理解"不是简单的"文本匹配",而是**“对用户意图的多维度还原”**,具体包含三个层次:

- 场景适配:知道"用户在什么场景下提问"(比如在电商APP里问"退货" vs 在社交APP里问"退货",场景不同意图不同);

- 历史关联:能关联"用户过去的交互行为"(比如之前买过什么、问过什么、偏好是什么);

- 多源整合:能处理"文本+语音+图片+系统数据"等多模态信息(比如用户发了一张破损商品的照片+文字"这个能退吗?",需要整合图片内容和历史订单)。

这三个层次的核心,都是**“上下文信息的有效利用”**——所谓"上下文",就是"与当前任务相关的所有先验信息",包括:

- 短期上下文:当前对话的最近几句内容;

- 长期上下文:用户的历史交互、个人偏好、系统数据(如订单、日程);

- 场景上下文:当前所在的应用、页面、时间、地理位置;

- 领域上下文:所属行业的专业知识(如医疗领域的疾病术语、电商领域的售后政策)。

1.2 上下文工程架构:Agentic AI的"理解中枢"

上下文工程架构(Context Engineering Architecture)是专门负责"上下文信息的获取、处理、管理、适配"的技术体系,它的核心目标是:

将分散的、异构的、动态的上下文信息,转化为结构化、可检索、能适配的"理解素材",供Agentic AI的决策模块(如规划器、执行器)使用。

如果把Agentic AI的工作流程拆解为"感知→理解→决策→执行",那么上下文工程架构就是"理解"环节的核心支撑:

- 感知层(如语音识别、OCR)获取原始信息;

- 上下文工程架构对这些信息进行"清洗→整合→存储→检索";

- 决策层基于处理后的上下文,生成符合意图的响应。

举个例子:当用户在电商APP里发了一张破损商品的照片+文字"这个能退吗?",上下文工程架构会做这些事:

- 获取:从感知层拿到照片(OCR提取商品ID)、文字(NLP提取"退货"意图)、场景信息(当前在"我的订单"页面)、历史数据(该用户3天前购买了这件商品);

- 处理:将商品ID与历史订单关联,用图像识别确认商品破损程度,将文字意图与售后政策匹配;

- 管理:把这些信息存入"短期上下文缓存"(供本次对话使用)和"长期用户画像"(供未来交互参考);

- 适配:根据场景(电商售后)调整检索策略,优先匹配"退货政策"和"历史订单"的信息,忽略不相关的广告推送。

没有上下文工程架构,Agentic AI的"理解"就会变成"盲人摸象"——要么遗漏关键信息,要么误解用户意图。

二、当前Agentic AI的"上下文痛点":为什么需要重新设计架构?

在讲2025年的架构之前,我们需要先明确:**当前智能体的上下文处理到底有哪些问题?**这些问题正是上下文工程架构需要解决的核心目标。

2.1 痛点1:上下文"断档"——记不住long-term信息

传统的LLM(大语言模型)采用"固定上下文窗口"设计(比如GPT-4o的128k token,约9.6万字),超过窗口的内容会被"遗忘"。但Agentic AI的交互往往是长期、连续的:比如用户跟智能助手聊了一个月,涉及日程、购物、工作等多个话题,传统窗口根本装不下这些信息。

更关键的是,long-term上下文往往是"隐性"的——比如用户之前说过"我对花生过敏",但今天点外卖时没提,智能体需要主动关联这个信息,提醒商家不要加花生。但传统的上下文处理方式(比如把所有历史对话塞进窗口)会导致两个问题:

- 计算成本飙升:128k token的输入会让LLM的推理时间翻倍;

- 信息过载:无关的历史内容会干扰当前意图的识别(比如用户今天问"外卖推荐",但历史对话里有"工作会议"的内容,会分散模型的注意力)。

2.2 痛点2:上下文"异构"——处理不了多源信息

Agentic AI的应用场景越来越复杂,需要处理的上下文信息早已不是"纯文本":

- 电商场景:用户发的商品照片(图像)+订单号(系统数据)+对话历史(文本);

- 医疗场景:患者的病历(PDF)+症状描述(语音)+检查报告(图像);

- 工业场景:设备的传感器数据(时序数据)+维护记录(文本)+故障照片(图像)。

这些**异构信息(文本+图像+语音+时序数据)**的整合,是传统上下文处理的"盲区"——传统方法要么只能处理单一模态,要么用简单的拼接(比如把图像描述转成文本塞进窗口),无法真正实现"多模态信息的语义融合"。

比如用户发了一张"快递盒破损的照片"+文字"我的快递坏了",传统处理方式是用OCR提取照片里的快递单号,然后把"快递单号+文字"塞进LLM窗口。但这样会遗漏照片里的"破损程度"(比如是轻微压痕还是完全裂开),而这个信息对判断"是否能理赔"至关重要。

2.3 痛点3:上下文"僵化"——不会动态适配场景

不同场景对上下文的需求是完全不同的:

- 客服场景:需要优先关联"历史订单"和"售后政策";

- 办公场景:需要优先关联"最近的文档"和"日程安排";

- 家庭场景:需要优先关联"家人的偏好"和"家电状态"。

但传统的上下文处理方式是"一刀切"的——不管什么场景,都用同样的检索策略(比如按时间排序取最近的10条对话)。这种"僵化"会导致:

- 无关信息干扰:比如在办公场景下,智能体把用户上周的购物对话塞进上下文,导致回答偏离工作主题;

- 关键信息遗漏:比如在医疗场景下,智能体没优先检索患者的"过敏史",导致给出错误的用药建议。

2.4 痛点4:上下文"不可控"——无法解释和调试

当智能体给出错误回答时,我们往往不知道是"上下文没获取到"还是"上下文用错了":

- 比如用户问"我之前买的红色外套能退吗?“,智能体回复"请提供商品信息”,到底是因为"没关联到历史订单",还是"关联到了但没识别出红色外套"?

- 传统的上下文处理是"黑盒"的——没有清晰的日志,没有可调试的接口,开发者无法定位问题。

这些痛点,本质上都是**“上下文工程架构的缺失”**——传统的上下文处理是"附着在LLM上的辅助模块",而Agentic AI需要的是"独立的、可扩展的、智能的上下文管理系统"。

三、2025年上下文工程架构的核心设计:四大组件+三大原则

针对上述痛点,2025年的上下文工程架构需要具备**"多源获取、智能处理、动态管理、场景适配"的能力。我们将其拆解为四大核心组件和三大设计原则**。

3.1 四大核心组件:从"获取"到"适配"的全流程管理

上下文工程架构的核心是"上下文生命周期管理"——从信息进入系统,到被决策层使用,再到被存储或淘汰,每个环节都需要专门的组件处理。以下是四大核心组件的设计细节:

组件1:上下文获取层——多源数据的"感知入口"

核心目标:从各种来源获取上下文信息,并统一格式。

处理对象:

- user输入:文本、语音、图像、视频;

- 系统数据:订单、日程、用户画像、设备状态;

- 环境数据:时间、地理位置、当前应用/页面;

- 领域知识:行业规则、专业术语、知识库。

关键技术:

- 多模态数据接入:用标准化的API(如OpenAI的Whisper处理语音、CLIP处理图像)将不同模态的信息转化为"语义向量"或"结构化数据";

- 数据校验:过滤无效信息(比如模糊的图像、乱码的文本),补全缺失信息(比如从订单号补全商品名称);

- 实时性保证:用消息队列(如Kafka)处理流数据(比如传感器的实时数据),确保上下文信息的时效性。

示例:在电商场景中,用户发了一张破损商品的照片,获取层会做这些事:

- 用CLIP模型提取照片的语义向量(描述"一个破损的快递盒,里面是白色连衣裙");

- 用OCR提取快递单号(“JD123456789”);

- 调用电商系统的API,用快递单号补全"商品ID、购买时间、用户ID"等信息;

- 将这些信息统一转化为JSON格式,传入下一层。

组件2:上下文处理层——从"原始数据"到"理解素材"的转化

核心目标:对获取到的上下文信息进行"语义分析、关联整合、压缩降噪",生成"结构化的、可检索的"理解素材。

关键环节:

(1)语义分析:给信息"打标签"

用NLP、CV等技术提取信息的"语义特征",比如:

- 文本:提取意图(“退货”)、实体(“白色连衣裙”、“JD123456789”)、情感(“不满”);

- 图像:提取物体(“快递盒”)、状态(“破损”)、特征(“白色连衣裙”);

- 系统数据:提取属性(“购买时间:2024-10-01”、“订单状态:已签收”)。

关键技术:

- 意图识别:用Few-Shot Learning(小样本学习)适配不同场景的意图(比如电商的"退货"、医疗的"问诊");

- 实体链接:将文本中的"白色连衣裙"链接到系统中的"商品ID:123";

- 多模态融合:用Multimodal Transformer(如BLIP-2)将图像和文本的语义特征融合,生成"破损的白色连衣裙快递盒"的综合描述。

(2)关联整合:把分散的信息"连起来"

将不同来源的上下文信息关联成"知识图谱"或"实体网络",比如:

- 将"用户ID:456"与"订单ID:789"关联;

- 将"订单ID:789"与"商品ID:123"(白色连衣裙)关联;

- 将"商品ID:123"与"破损状态"(图像分析结果)关联。

关键技术:

- 知识图谱构建:用Neo4j或Dgraph存储实体和关系;

- 实体匹配:用向量相似度匹配(如Sentence-BERT)解决"同名异义"或"异名同义"问题(比如"小红"和"红色连衣裙"都是指同一个商品)。

(3)压缩降噪:去掉"无用信息"

针对long-term上下文的"信息过载"问题,需要对信息进行"压缩"和"降噪":

- 压缩:用"摘要生成"(如ChatGPT的Summarize功能)将长文本转化为短摘要(比如把1000字的对话历史压缩成"用户询问过白色连衣裙的退货政策");

- 降噪:用"相关性过滤"(如TF-IDF或向量相似度)去掉与当前场景无关的信息(比如在电商售后场景下,过滤掉用户上周的"天气查询"对话)。

示例:用户的历史对话有100条,其中80条是购物相关,20条是天气查询。在售后场景下,处理层会:

- 用摘要生成将80条购物对话压缩成"用户最近购买了白色连衣裙、运动鞋,询问过退货政策";

- 用相关性过滤去掉20条天气查询对话;

- 将压缩后的摘要和当前对话的"破损商品照片"关联,生成"用户当前询问的是最近购买的白色连衣裙的退货问题,商品有破损"的结构化信息。

组件3:上下文管理层——"短期记忆"与"长期记忆"的分离

核心目标:将处理后的上下文信息分类存储,确保"需要时能快速检索,不需要时不占用资源"。

设计思路:借鉴人类的记忆机制,将上下文分为"短期记忆"和"长期记忆",分别用不同的存储和检索策略。

(1)短期记忆(Short-Term Memory, STM)

- 定义:当前对话或任务的最近信息(比如最近10分钟的交互);

- 特点:实时性高、容量小、需要快速检索;

- 存储方式:用内存数据库(如Redis)存储,设置过期时间(比如30分钟);

- 检索策略:按时间排序,优先返回最近的信息。

(2)长期记忆(Long-Term Memory, LTM)

- 定义:用户的历史交互、个人偏好、系统数据等长期有效信息;

- 特点:容量大、需要持久化、检索时需要关联当前场景;

- 存储方式:用向量数据库(如Pinecone、Weaviate)存储语义向量,用关系型数据库(如PostgreSQL)存储结构化数据;

- 检索策略:用"场景适配的向量检索"——比如在电商售后场景下,优先检索"历史订单"和"售后政策"的向量,计算与当前上下文的相似度,返回最相关的信息。

关键技术:

- 记忆巩固:将短期记忆中的重要信息(比如用户的"花生过敏"偏好)定期同步到长期记忆(比如每天凌晨将Redis中的信息同步到Pinecone);

- 记忆遗忘:用"衰减机制"淘汰长期记忆中的无用信息(比如用户1年前的"天气查询"对话,相似度低于阈值时自动删除)。

示例:用户跟智能助手聊了一个月,短期记忆存储了最近30分钟的对话(“我想退白色连衣裙”),长期记忆存储了用户的"花生过敏"偏好、"喜欢买连衣裙"的购物习惯、“每周五开会"的日程。当用户问"推荐一家附近的外卖”,管理层会:

- 从短期记忆中获取"最近没聊过外卖"的信息;

- 从长期记忆中检索"花生过敏"偏好和"附近的外卖店"信息;

- 返回"推荐XX餐厅,他们家没有花生制品"的结果。

组件4:上下文适配层——根据场景动态调整"理解策略"

核心目标:根据当前场景和任务,动态选择需要的上下文信息,确保"给决策层的信息是精准的、相关的"。

关键环节:

(1)场景识别:判断"当前在什么场景"

用"规则引擎+机器学习"识别场景:

- 规则引擎:根据"当前应用"(如电商APP)、“当前页面”(如"我的订单")、“关键词”(如"退货")等规则,快速判断场景(如"电商售后");

- 机器学习:用分类模型(如BERT)识别复杂场景(如用户发了"快递坏了"的文字+照片,模型识别为"电商售后-物流问题")。

(2)策略选择:决定"用哪些上下文信息"

根据场景选择检索策略和权重:

- 检索策略:比如在"电商售后"场景下,优先检索"历史订单"、“商品状态”、"售后政策"的信息;

- 权重调整:比如在"医疗问诊"场景下,“过敏史"的权重高于"最近的购物记录”。

(3)上下文生成:给决策层输出"结构化的理解结果"

将适配后的上下文信息转化为决策层能理解的格式(比如JSON或Prompt),比如:

在电商售后场景下,输出:

{

"场景": "电商售后-物流破损",

"用户ID": "456",

"当前意图": "退货",

"关联信息": {

"订单ID": "789",

"商品ID": "123",

"商品状态": "快递盒破损,商品未损坏",

"售后政策": "7天无理由退货,需提供破损照片"

},

"历史偏好": "用户之前多次购买连衣裙,喜欢白色"

}

关键技术:

- 强化学习(RL):用RL模型根据用户反馈调整策略(比如如果用户对"推荐外卖"的结果满意,就增加"过敏史"的权重);

- 可解释性模块:记录每一步的策略选择(比如"为什么选择了售后政策而不是购物偏好"),方便开发者调试。

3.2 三大设计原则:确保架构的"可扩展、可调试、可落地"

除了四大组件,2025年的上下文工程架构还需要遵循以下三大原则:

原则1:模块化设计——"松耦合"才能应对复杂场景

每个组件(获取、处理、管理、适配)都要设计成独立的模块,通过API接口通信。这样做的好处是:

- 易扩展:比如需要新增"视频"模态的处理,只需要修改获取层的多模态接入模块,不需要改动整个架构;

- 易维护:比如上下文管理的存储方式从Redis换成Memcached,只需要修改管理层的存储模块;

- 易复用:比如电商场景的适配策略,可以复用到金融场景(只需要修改场景规则)。

原则2:实时性优先——“过期的上下文不如没有”

Agentic AI的交互往往是"实时"的(比如客服对话、自动驾驶),所以上下文工程架构必须保证:

- 数据获取的实时性:用流处理框架(如Flink)处理实时数据(比如传感器的温度数据);

- 信息检索的实时性:用向量数据库的"近似最近邻(ANN)"算法(如HNSW),确保100ms内返回检索结果;

- 策略调整的实时性:用RL模型的"在线学习"(Online Learning),根据用户的实时反馈调整策略。

原则3:可解释性——"黑盒"架构无法商业化

上下文工程架构必须具备"可解释性",即:

- 日志可追溯:记录每一条上下文信息的来源、处理过程、检索结果;

- 决策可解释:解释"为什么选择了这条上下文信息"(比如"因为当前场景是电商售后,所以优先检索了历史订单");

- 错误可定位:当智能体给出错误回答时,能快速定位是"获取层没拿到订单信息"还是"适配层没选择售后政策"。

四、实践案例:用LangChain搭建一个电商客服的上下文工程架构

为了让大家更直观地理解上下文工程架构的落地,我们用LangChain(一个流行的Agentic AI开发框架)搭建一个简单的电商客服上下文系统。

4.1 场景需求

电商客服智能体需要处理以下场景:

- 用户发文字:“我昨天买的白色连衣裙能退吗?”;

- 用户发图片:一张破损的快递盒照片;

- 用户发订单号:“JD123456789”。

智能体需要:

- 关联用户的历史订单(用订单号获取商品信息);

- 分析图片中的商品状态(破损程度);

- 匹配售后政策(7天无理由退货,需提供破损照片);

- 给出精准回答:“您的白色连衣裙购买于昨天,符合7天无理由退货政策。请提供破损照片,我们将为您办理退货。”

4.2 架构实现步骤

步骤1:搭建上下文获取层

用LangChain的DocumentLoaders和MultimodalLoader获取多源数据:

- 文本:用

TextLoader加载用户的文字输入; - 图像:用

ImageLoader加载用户的照片,调用CLIP模型提取语义向量; - 系统数据:用

WebBaseLoader调用电商系统的API,获取订单信息。

from langchain.document_loaders import TextLoader, ImageLoader, WebBaseLoader

from langchain.embeddings import OpenAIEmbeddings

# 加载文本输入

text_loader = TextLoader("user_input.txt")

text_doc = text_loader.load()

# 加载图像输入,提取语义向量

image_loader = ImageLoader("broken_box.jpg")

image_doc = image_loader.load()

image_embedding = OpenAIEmbeddings().embed_query(image_doc.page_content)

# 加载系统数据(订单信息)

order_api = "https://api.ecommerce.com/orders/JD123456789"

web_loader = WebBaseLoader(order_api)

order_doc = web_loader.load()

步骤2:搭建上下文处理层

用LangChain的CharacterTextSplitter做文本分割,OpenAIEmbeddings做语义编码,Neo4jGraph构建知识图谱:

- 分割文本:将长对话分割成短段落;

- 编码语义:将文本和图像的语义转化为向量;

- 构建知识图谱:将"用户ID→订单ID→商品ID→破损状态"关联起来。

from langchain.text_splitter import CharacterTextSplitter

from langchain.graphs import Neo4jGraph

# 文本分割

text_splitter = CharacterTextSplitter(chunk_size=1000, chunk_overlap=200)

split_texts = text_splitter.split_documents([text_doc, order_doc])

# 语义编码

embeddings = OpenAIEmbeddings()

text_embeddings = embeddings.embed_documents([t.page_content for t in split_texts])

image_embedding = embeddings.embed_query(image_doc.page_content)

# 构建知识图谱

graph = Neo4jGraph(url="neo4j://localhost:7687", username="neo4j", password="password")

graph.add_node("User", id="456")

graph.add_node("Order", id="JD123456789", purchase_time="2024-10-01")

graph.add_node("Product", id="123", name="白色连衣裙")

graph.add_node("Image", id="img1", content="破损的快递盒")

graph.add_relationship("User", "PURCHASED", "Order")

graph.add_relationship("Order", "CONTAINS", "Product")

graph.add_relationship("Product", "HAS_IMAGE", "Image")

步骤3:搭建上下文管理层

用LangChain的VectorStore(Pinecone)存储长期记忆,Memory(ConversationBufferMemory)存储短期记忆:

- 长期记忆:将知识图谱中的实体和向量存储到Pinecone;

- 短期记忆:存储当前对话的最近5条内容。

from langchain.vectorstores import Pinecone

from langchain.memory import ConversationBufferMemory

# 长期记忆:Pinecone存储

pinecone.init(api_key="your-api-key", environment="us-west1-gcp")

index_name = "ecommerce-context"

vector_store = Pinecone.from_documents(split_texts, embeddings, index_name=index_name)

# 短期记忆:ConversationBufferMemory

memory = ConversationBufferMemory(memory_key="chat_history", return_messages=True)

memory.chat_memory.add_user_message("我昨天买的白色连衣裙能退吗?")

memory.chat_memory.add_ai_message("请提供订单号。")

memory.chat_memory.add_user_message("JD123456789")

步骤4:搭建上下文适配层

用LangChain的RouterChain(路由链)根据场景选择上下文:

- 场景识别:用

LLMChain判断当前场景是"电商售后"; - 策略选择:优先检索"订单信息"、“商品状态”、“售后政策”;

- 生成上下文:将适配后的信息转化为Prompt,传给LLM。

from langchain.chains import LLMChain, RouterChain, MultiPromptChain

from langchain.prompts import PromptTemplate

from langchain.llms import OpenAI

# 场景识别链

scene_prompt = PromptTemplate(

input_variables=["input"],

template="请判断用户的输入属于哪个场景:电商售后、商品咨询、物流查询。输入:{input}"

)

scene_chain = LLMChain(llm=OpenAI(temperature=0), prompt=scene_prompt)

# 售后场景的Prompt

after_sale_prompt = PromptTemplate(

input_variables=["chat_history", "order_info", "product_status", "policy"],

template="用户的对话历史:{chat_history};订单信息:{order_info};商品状态:{product_status};售后政策:{policy}。请给出精准回答。"

)

after_sale_chain = LLMChain(llm=OpenAI(temperature=0), prompt=after_sale_prompt)

# 路由链:根据场景选择对应的Chain

router_chain = RouterChain.from_chains(

[scene_chain],

[after_sale_chain],

route_keys=["scene"]

)

# 适配上下文:检索订单信息、商品状态、售后政策

order_info = vector_store.similarity_search("订单ID:JD123456789", k=1)[0].page_content

product_status = vector_store.similarity_search("商品状态:破损", k=1)[0].page_content

policy = vector_store.similarity_search("售后政策:7天无理由退货", k=1)[0].page_content

# 生成回答

response = router_chain.run(

input="我昨天买的白色连衣裙能退吗?",

chat_history=memory.chat_memory.messages,

order_info=order_info,

product_status=product_status,

policy=policy

)

print(response)

# 输出:您的白色连衣裙购买于昨天,符合7天无理由退货政策。请提供破损照片,我们将为您办理退货。

这个案例虽然简单,但已经覆盖了上下文工程架构的四大组件:

- 获取层:加载文本、图像、系统数据;

- 处理层:分割文本、编码语义、构建知识图谱;

- 管理层:Pinecone存储长期记忆,ConversationBufferMemory存储短期记忆;

- 适配层:用路由链选择场景和策略,生成Prompt。

五、2025年上下文工程的未来趋势:从"被动处理"到"主动理解"

2025年,上下文工程架构将从"被动处理用户输入"转向"主动感知和预测用户需求",以下是三个关键趋势:

5.1 趋势1:主动上下文获取——从"用户说什么"到"用户没说什么"

当前的上下文获取是"被动"的:用户发什么,系统就处理什么。未来的上下文工程将具备"主动感知"能力:

- 环境感知:比如智能助手通过手机的GPS知道用户在商场,主动关联"附近的店铺"和"用户的购物偏好";

- 行为预测:比如用户打开电商APP的"我的订单"页面,系统主动获取该用户的"最近订单"和"售后记录",提前准备上下文;

- 需求推理:比如用户说"我想给妈妈买礼物",系统主动关联"妈妈的生日"(长期记忆)、“妈妈的喜好”(长期记忆)、“最近的促销活动”(系统数据),生成"推荐清单"。

5.2 趋势2:跨Agent上下文共享——从"单智能体"到"智能体网络"

未来的Agentic AI将是"网络状"的:比如家庭场景中有"智能音箱"、“智能空调”、"智能冰箱"三个Agent,它们需要共享上下文:

- 智能音箱知道"用户今天感冒了";

- 智能空调需要调整温度到26度(根据"感冒"的上下文);

- 智能冰箱需要推荐"热粥"的食谱(根据"感冒"的上下文)。

跨Agent上下文共享需要解决两个问题:

- 标准化协议:用统一的格式(如JSON-LD)描述上下文信息,确保不同Agent能理解;

- 隐私保护:用零知识证明(ZKP)或联邦学习(FL)共享上下文,不泄露用户隐私。

5.3 趋势3:自我进化的上下文策略——从"人工调参"到"自动优化"

当前的上下文策略需要人工设置(比如"售后场景下优先检索订单信息"),未来的上下文工程将具备"自我进化"能力:

- 用强化学习优化策略:根据用户的反馈(比如点击"满意"或"不满意")自动调整上下文的权重;

- 用大模型生成策略:比如用GPT-4o生成"医疗场景下的上下文检索策略",不需要人工编写规则;

- 用元学习适配新场景:比如只需要少量样本(比如10条医疗对话),就能快速适配医疗场景的上下文策略。

六、总结:上下文工程是Agentic AI的"地基",也是2025年的"必争之地"

Agentic AI的核心竞争力是"理解能力",而"理解能力"的核心是"上下文工程架构"。2025年,随着Agentic AI向复杂场景(如医疗、工业、元宇宙)渗透,上下文工程将成为:

- 技术厂商的"护城河":谁能搭建更高效、更智能的上下文工程架构,谁就能在Agentic AI市场占据先机;

- 企业客户的"刚需":企业需要智能体"懂"自己的业务场景、"懂"自己的用户,而这需要强大的上下文工程支持;

- 开发者的"必备技能":未来的Agentic AI开发,不再是"调LLM的Prompt",而是"设计上下文工程架构"。

最后,用一句话总结本文的核心观点:

Agentic AI的"智能",本质上是"对上下文的精准理解";而上下文工程架构,就是实现这种"精准理解"的"发动机"。

2025年,让我们一起期待,上下文工程架构如何让Agentic AI从"能说话"变成"会思考",从"工具"变成"伙伴"。

延伸阅读

- 论文:《Contextual Memory for Deep Learning》(深度学习中的上下文记忆);

- 框架:LangChain(Agentic AI开发框架)、LlamaIndex(上下文管理框架);

- 工具:Pinecone(向量数据库)、Neo4j(知识图谱)、Flink(流处理)。

如果您有任何疑问或想交流上下文工程的实践经验,欢迎在评论区留言!

更多推荐

已为社区贡献176条内容

已为社区贡献176条内容

所有评论(0)