从Prompt到Pipeline:构建企业级AI应用的架构思考

本文探讨从简单Prompt到企业级AI Pipeline的架构演进。企业级AI应用面临可靠性、扩展性、安全性、可维护性和成本控制等核心挑战,需构建分层架构:接入层处理请求,编排层决策流程,核心层执行AI逻辑,数据层提供知识支持,模型层部署推理能力,监控层保障系统健康。关键组件包括动态Prompt管理、RAG系统、Agent框架等。通过模块化Pipeline设计,可解决单一Prompt的脆弱性和功能

从Prompt到Pipeline:构建企业级AI应用的架构思考

目录

- 引言:Prompt的幻觉与Pipeline的必然

- 企业级AI应用的核心挑战

- 2.1 可靠性与稳定性

- 2.2 可扩展性与性能

- 2.3 安全性与合规性

- 2.4 可维护性与可观测性

- 2.5 成本控制

- 从“Prompt Engineering”到“AI Pipeline Engineering”

- 3.1 Prompt的局限性

- 3.2 Pipeline的架构优势

- 企业级AI应用的分层架构

- 4.1 接入层(Ingress Layer)

- 4.2 编排与路由层(Orchestration & Routing Layer)

- 4.3 核心处理层(Core Processing Layer)

- 4.4 数据与知识层(Data & Knowledge Layer)

- 4.5 模型服务层(Model Serving Layer)

- 4.6 监控与治理层(Monitoring & Governance Layer)

- 关键组件详解

- 5.1 提示词管理与版本控制

- 5.2 检索增强生成(RAG)系统

- 5.3 工具调用(Function Calling)与Agent

- 5.4 缓存策略

- 5.5 负载均衡与熔断降级

- 实战案例:构建一个智能客服Pipeline

- 6.1 需求分析

- 6.2 架构设计

- 6.3 流程详解

- 6.4 代码示例(Python)

- 演进路径:从小型应用到企业平台

- 未来展望:AI Native架构

- 结论:拥抱Pipeline思维

- 参考文献与推荐阅读

1. 引言:Prompt的幻觉与Pipeline的必然

“给我写一封辞职信,语气要专业但友好。”

只需一行文字,AI便能生成一篇结构完整、措辞得体的邮件。这种“Prompt即应用”的模式,是当前AI最直观、最令人惊叹的交互方式。它让开发者和非技术人员都能快速体验到AI的强大能力。

然而,当我们将这种模式应用于企业级生产环境时,最初的惊艳很快会被现实的复杂性所取代。一个简单的Prompt,在真实业务场景中会面临可靠性、性能、安全、维护等一系列严峻挑战。

我们逐渐意识到:Prompt是起点,而非终点。真正支撑企业级AI应用的,不是孤立的Prompt,而是一套完整的、可管理的、可扩展的AI Pipeline。

从“Prompt Engineering”到“AI Pipeline Engineering”,这不仅是技术的演进,更是思维模式的转变。本文将深入探讨如何构建企业级AI应用的架构,揭示从一个简单的提示词到一个健壮的生产系统的完整路径。

2. 企业级AI应用的核心挑战

将AI从原型推向生产,必须直面企业级应用的五大核心挑战。

2.1 可靠性与稳定性

- 输出一致性:同一个Prompt,在不同时间或不同上下文下,是否能产生一致且正确的结果?

- 容错能力:当底层模型服务(如OpenAI API)出现故障或延迟时,系统如何降级或重试?

- 结果验证:如何确保AI生成的内容符合业务逻辑,不会产生“幻觉”或错误信息?

2.2 可扩展性与性能

- 高并发处理:在用户量激增时,系统能否快速扩展以应对请求洪峰?

- 低延迟响应:AI推理本身耗时较长,如何优化端到端延迟,保证用户体验?

- 资源隔离:不同业务线的AI任务如何共享资源,避免相互影响?

2.3 安全性与合规性

- 数据隐私:用户输入的敏感信息(如身份证号、订单详情)是否会被泄露给第三方模型?

- 内容安全:如何防止AI生成违法、有害或歧视性内容?

- 审计与追溯:每一次AI调用的输入、输出、使用的模型、耗时等,是否可追溯?

2.4 可维护性与可观测性

- 调试困难:当AI输出不符合预期时,如何定位是Prompt问题、数据问题还是模型问题?

- 版本管理:Prompt、模型、知识库的迭代如何管理?如何回滚到历史版本?

- 监控告警:是否有完善的监控体系,能及时发现性能瓶颈或异常行为?

2.5 成本控制

- API调用成本:大模型API按Token计费,如何优化Prompt和流程以降低成本?

- 计算资源成本:自建模型服务或向量数据库的硬件投入。

- 人力成本:维护复杂AI系统的研发和运维成本。

3. 从“Prompt Engineering”到“AI Pipeline Engineering”

3.1 Prompt的局限性

Prompt Engineering(提示词工程)是AI应用的入门钥匙,但它存在固有局限:

- 脆弱性:Prompt的微小改动可能导致输出的巨大差异。

- 上下文限制:大模型的上下文窗口有限,难以处理超长文档。

- 知识静态:模型的知识截止于训练时间,无法实时获取最新信息。

- 功能单一:一个Prompt通常只能完成单一任务,难以应对复杂工作流。

3.2 Pipeline的架构优势

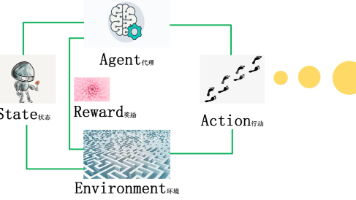

AI Pipeline通过将复杂任务分解为多个可管理的步骤,解决了Prompt的局限性:

- 模块化:每个步骤职责单一,易于开发、测试和替换。

- 可组合:通过编排不同组件,可以构建复杂的业务逻辑。

- 可优化:可以在Pipeline的任意环节进行性能或成本优化。

- 可监控:可以对Pipeline的每个节点进行监控和度量。

4. 企业级AI应用的分层架构

一个健壮的企业级AI应用,通常采用分层架构设计,各层职责清晰,松耦合。

4.1 接入层(Ingress Layer)

职责:接收外部请求,进行初步处理。

- API网关:统一入口,负责认证、限流、日志记录。

- 协议适配:支持HTTP、WebSocket、gRPC等多种协议。

- 输入预处理:对用户输入进行清洗、脱敏、格式化。

4.2 编排与路由层(Orchestration & Routing Layer)

职责:决定请求的处理流程,是Pipeline的“大脑”。

4.3 核心处理层(Core Processing Layer)

职责:执行AI的核心逻辑。

- 提示词管理:从配置中心加载动态Prompt模板。

- RAG引擎:检索相关知识,注入Prompt上下文。

- Agent框架:协调多个工具和模型完成任务。

- 后处理:对AI输出进行解析、格式化、安全过滤。

4.4 数据与知识层(Data & Knowledge Layer)

职责:提供AI所需的外部知识和数据。

4.5 模型服务层(Model Serving Layer)

职责:提供模型推理能力。

- 第三方API:调用OpenAI、Anthropic等云服务。

- 自建模型服务:使用Triton Inference Server、vLLM部署私有模型。

- 模型网关:统一管理多个模型,支持A/B测试和灰度发布。

4.6 监控与治理层(Monitoring & Governance Layer)

职责:保障系统的健康运行。

- 指标监控:采集延迟、成功率、Token消耗等指标(Prometheus/Grafana)。

- 日志追踪:记录完整的调用链路(OpenTelemetry)。

- 成本分析:统计各业务线的AI使用成本。

- 内容审核:对输入输出进行安全扫描。

5. 关键组件详解

5.1 提示词管理与版本控制

Prompt不应硬编码在代码中,而应作为独立的配置进行管理。

# 示例:从配置中心获取Prompt模板

import json

import requests

def get_prompt_template(prompt_id: str, version: str = "latest"):

url = f"https://config-center/api/prompts/{prompt_id}/versions/{version}"

response = requests.get(url)

return response.json()["template"]

# 使用Jinja2模板注入变量

from jinja2 import Template

prompt_template = get_prompt_template("customer_service_greeting")

context = {"user_name": "张三", "order_status": "已发货"}

prompt = Template(prompt_template).render(**context)

最佳实践:

- 使用Git管理Prompt版本。

- 建立Prompt A/B测试机制。

- 实现Prompt的灰度发布。

5.2 检索增强生成(RAG)系统

RAG是解决模型“知识过时”和“幻觉”问题的关键。

from sentence_transformers import SentenceTransformer

import numpy as np

from typing import List

class RAGSystem:

def __init__(self, model_name: str = "paraphrase-multilingual-MiniLM-L12-v2"):

self.encoder = SentenceTransformer(model_name)

# 假设知识库已预加载到内存或向量数据库

self.knowledge_base = self.load_knowledge_base()

def load_knowledge_base(self) -> List[dict]:

# 从数据库或文件加载知识条目

return [

{"id": 1, "text": "退货政策:购买后30天内可无理由退货。", "embedding": [...]},

{"id": 2, "text": "配送时间:一般订单在1-3个工作日内发货。", "embedding": [...]}

]

def retrieve(self, query: str, top_k: int = 3) -> List[str]:

query_embedding = self.encoder.encode([query])[0]

similarities = []

for item in self.knowledge_base:

sim = np.dot(query_embedding, item["embedding"])

similarities.append((sim, item["text"]))

similarities.sort(reverse=True, key=lambda x: x[0])

return [text for _, text in similarities[:top_k]]

# 使用RAG

rag = RAGSystem()

relevant_docs = rag.retrieve("我买的东西怎么退?")

context = "\n".join(relevant_docs)

final_prompt = f"根据以下信息回答用户问题:\n{context}\n\n问题:{user_query}"

5.3 工具调用(Function Calling)与Agent

让AI模型调用外部工具,是构建复杂应用的基础。

# 定义工具

def get_order_status(order_id: str) -> dict:

"""查询订单状态"""

# 调用订单系统API

return {"order_id": order_id, "status": "已发货", "estimated_delivery": "2025-09-05"}

def send_sms(phone: str, message: str) -> bool:

"""发送短信"""

# 调用短信服务

return True

tools = [

{

"type": "function",

"function": {

"name": "get_order_status",

"description": "查询订单的当前状态",

"parameters": {

"type": "object",

"properties": {

"order_id": {"type": "string", "description": "订单ID"}

},

"required": ["order_id"]

}

}

},

{

"type": "function",

"function": {

"name": "send_sms",

"description": "向指定手机号发送短信",

"parameters": {

"type": "object",

"properties": {

"phone": {"type": "string"},

"message": {"type": "string"}

},

"required": ["phone", "message"]

}

}

}

]

# AI模型决定调用哪个工具

# 假设模型返回了调用指令

tool_call = {

"name": "get_order_status",

"arguments": {"order_id": "ORD123456"}

}

# 执行工具调用

if tool_call["name"] == "get_order_status":

result = get_order_status(**tool_call["arguments"])

# 将结果返回给AI模型,由其生成最终回复

5.4 缓存策略

缓存是降低成本和提升性能的关键。

- Prompt缓存:对相同的输入缓存AI输出。

- Embedding缓存:缓存文本的向量表示,避免重复计算。

- RAG结果缓存:缓存检索结果。

import hashlib

import json

from functools import lru_cache

@lru_cache(maxsize=1000)

def cached_embedding(text: str):

# 使用LRU缓存计算过的embedding

return model.encode(text)

def get_cache_key(prompt: str, model: str) -> str:

return hashlib.md5(f"{model}:{prompt}".encode()).hexdigest()

# 使用Redis或Memcached进行分布式缓存

5.5 负载均衡与熔断降级

import requests

from requests.adapters import HTTPAdapter

from urllib3.util.retry import Retry

from typing import Optional

def create_session_with_retry() -> requests.Session:

session = requests.Session()

retry_strategy = Retry(

total=3,

backoff_factor=1,

status_forcelist=[429, 500, 502, 503, 504],

)

adapter = HTTPAdapter(max_retries=retry_strategy)

session.mount("http://", adapter)

session.mount("https://", adapter)

return session

# 熔断降级

class AIClient:

def __init__(self):

self.session = create_session_with_retry()

self.fallback_enabled = False

def query(self, prompt: str) -> str:

if self.fallback_enabled:

return "抱歉,AI服务暂时不可用,我们将尽快恢复。"

try:

response = self.session.post(

"https://api.openai.com/v1/chat/completions",

json={"model": "gpt-4", "messages": [{"role": "user", "content": prompt}]},

timeout=30

)

response.raise_for_status()

return response.json()["choices"][0]["message"]["content"]

except Exception as e:

# 触发熔断逻辑

self.handle_failure(e)

return self.fallback_response()

def handle_failure(self, error):

# 简单的熔断逻辑:连续失败3次则启用降级

pass

6. 实战案例:构建一个智能客服Pipeline

6.1 需求分析

构建一个能处理用户咨询的智能客服,支持:

- 回答常见问题(基于知识库)

- 查询订单状态

- 处理简单投诉并生成工单

6.2 架构设计

用户请求

↓

[API Gateway] → 认证、限流

↓

[Orchestrator] → 决定处理流程

↓

┌─────────────┐

↓ ↓

[RAG] [Function Router]

↓ ↓

检索知识库 调用订单API/创建工单

↓ ↓

└─────→ [LLM] ←─────┘

↓

[Output Formatter]

↓

用户响应

6.3 流程详解

- 用户输入问题。

- API网关验证身份和权限。

- 编排器分析问题类型:

- 若为通用问题(如“怎么退货?”),路由到RAG系统。

- 若为订单查询(如“我的订单ORD123状态?”),路由到Function Router调用

get_order_status。 - 若为投诉(如“商品坏了”),路由到创建工单的工具。

- 获取结果后,由LLM生成自然语言回复。

- 格式化输出并返回。

6.4 代码示例(Python)

from typing import Dict, Any

import json

class SmartCustomerService:

def __init__(self):

self.rag = RAGSystem()

self.tools = {"get_order_status": get_order_status}

def classify_intent(self, text: str) -> str:

# 简单的关键词分类,实际可用模型

if "订单" in text and ("状态" in text or "怎么样" in text):

return "query_order"

elif any(word in text for word in ["退货", "换货", "退款"]):

return "faq"

elif "投诉" in text or "坏了" in text:

return "create_ticket"

else:

return "faq"

def handle_request(self, user_query: str) -> Dict[str, Any]:

intent = self.classify_intent(user_query)

if intent == "faq":

context = self.rag.retrieve(user_query)

prompt = f"根据以下信息回答问题:\n{''.join(context)}\n\n问题:{user_query}"

response = self.call_llm(prompt)

elif intent == "query_order":

# 从文本中提取订单ID(简化)

order_id = "ORD123" # 实际需用NLP提取

result = self.tools["get_order_status"](order_id)

prompt = f"用户询问订单{order_id}的状态,信息如下:{json.dumps(result)}。请用友好语气回复。"

response = self.call_llm(prompt)

else:

# 创建工单逻辑

response = "已收到您的反馈,客服人员将尽快与您联系。"

return {"response": response, "intent": intent}

# 实例化并测试

service = SmartCustomerService()

result = service.handle_request("我的订单状态怎么样?")

print(result["response"])

7. 演进路径:从小型应用到企业平台

- MVP阶段:单体应用,直接调用API。

- 成长阶段:引入RAG、工具调用,代码模块化。

- 成熟阶段:微服务架构,独立的Pipeline服务、向量数据库、监控系统。

- 平台阶段:建立AI平台即服务(AI PaaS),提供Prompt管理、模型管理、成本分析等统一能力。

8. 未来展望:AI Native架构

未来的应用将是“AI Native”的:

- 数据流即工作流:AI Pipeline成为应用的主干。

- 自治系统:AI Agent能自主规划、执行、反思和学习。

- 无代码/低代码AI:业务人员通过可视化界面构建AI应用。

9. 结论:拥抱Pipeline思维

Prompt是魔法,但Pipeline是工程。构建企业级AI应用,我们必须超越Prompt的幻觉,拥抱Pipeline思维。

这意味着:

- 设计先行:在写第一行代码前,先画出Pipeline的流程图。

- 关注非功能需求:可靠性、性能、安全与功能同等重要。

- 持续迭代:AI应用需要像传统软件一样,持续监控、优化和演进。

从Prompt到Pipeline,我们不是在削弱AI的魔力,而是在为其构建一个坚固的舞台,让这场智能的戏剧,能够稳定、持久、安全地在生产环境中上演。

10. 参考文献与推荐阅读

更多推荐

已为社区贡献63条内容

已为社区贡献63条内容

所有评论(0)