技术人面试必看!《百面大模型》干货集锦,助你通关大厂

技术人面试必看!《百面大模型》干货集锦,助你通关大厂

大模型热潮下,模型工程师、LLM 算法研究员等高薪岗位遍地开花,但不少技术人却卡在面试关:日常用 ChatGPT、DeepSeek 很熟练,被问 MoE 调度、DPO 对齐细节就懵;刷过不少教程,却讲不清 FlashAttention 的推理加速原理。

而《百面大模型》正是为解决这些痛点而来。这本被众多从业者称为 “大模型面试通关秘籍” 的指南,从高频面试题入手,拆解核心技术原理。不管是刚入行的新人,还是想进阶的资深工程师,都能靠它梳理知识、应对面试,在大模型浪潮中抓住机遇。

一、直面大模型面试困局:为什么碎片化学习无效?

大模型领域知识体系庞杂且迭代极快:

- 术语密集:MoE、PEFT、RLHF、RAG、KV Cache等概念交织;

- 问题开放性强:面试官常问“如何设计支持10万并发的Agent系统?”而非背诵题;

- 工程与理论并重:既需懂Self-Attention数学推导,也要会优化LoRA服务部署。

传统学习路径如博客、视频教程虽多,却缺乏系统性框架,导致求职者“只见树木,不见森林”。《百面大模型》正是通过 100道高频真题 梳理出清晰的知识图谱,覆盖从预训练到推理落地的全链路能力。

二、解剖《百面大模型》:一本真正“会解题”的指南

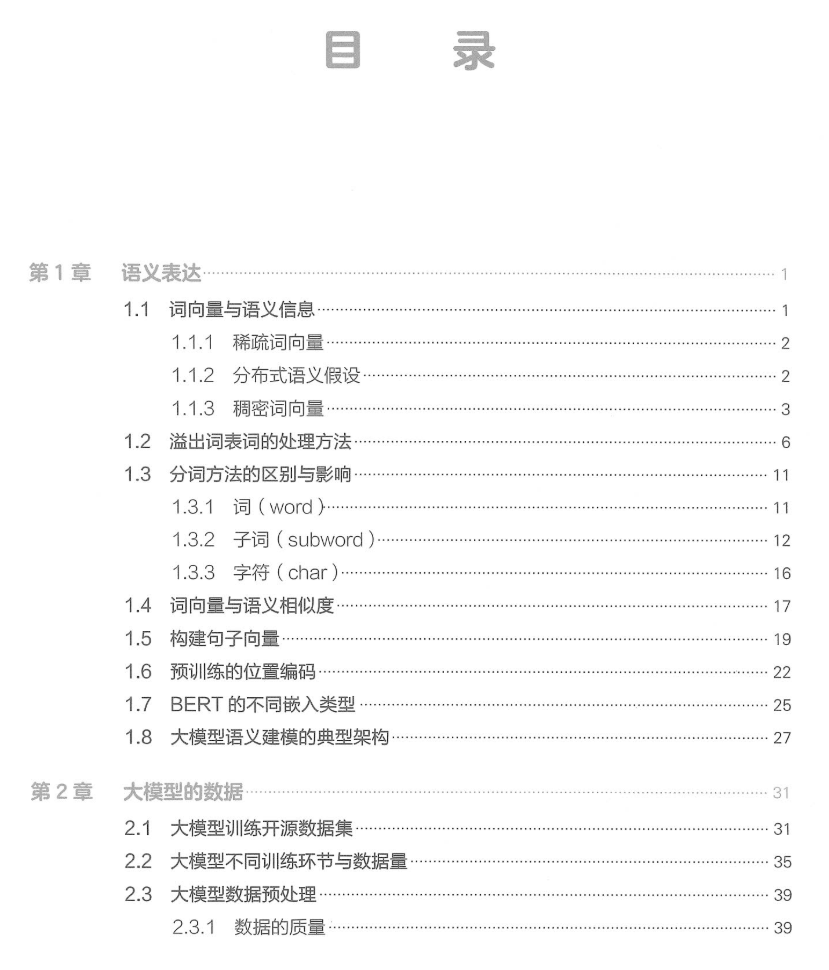

内容架构:五维能力模型打通技术闭环

| 模块 | 核心内容 | 高频考题举例 |

|---|---|---|

| 基础原理 | 语义建模/预训练/数据扩展 | 位置编码演进、灾难性遗忘对策 |

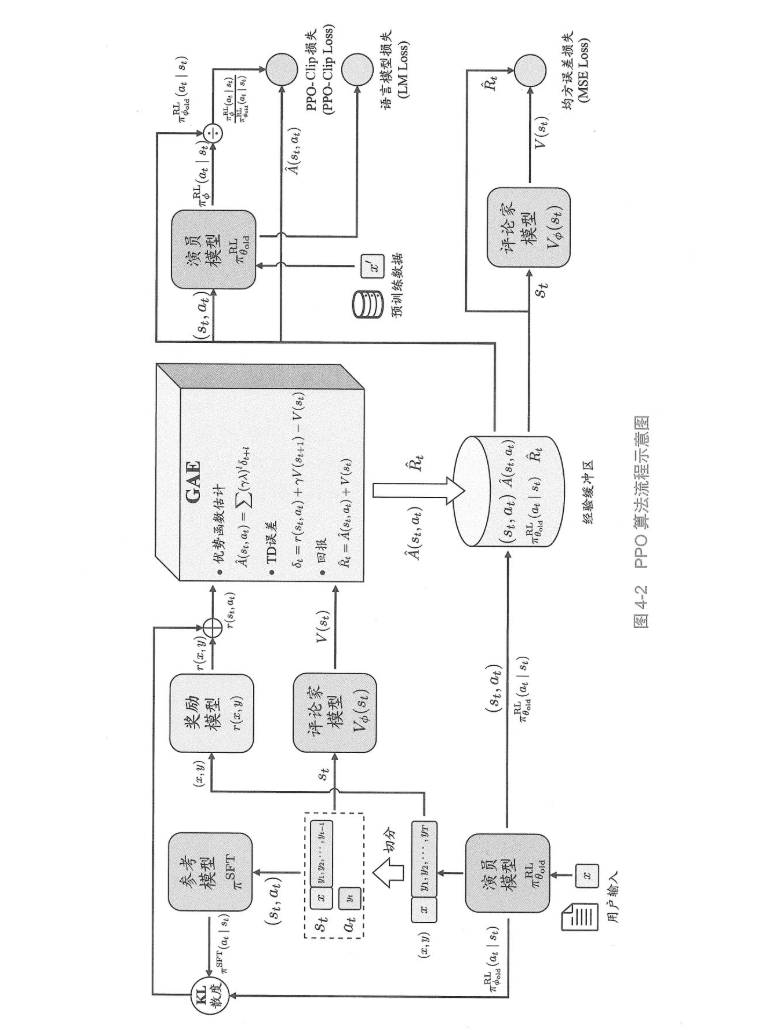

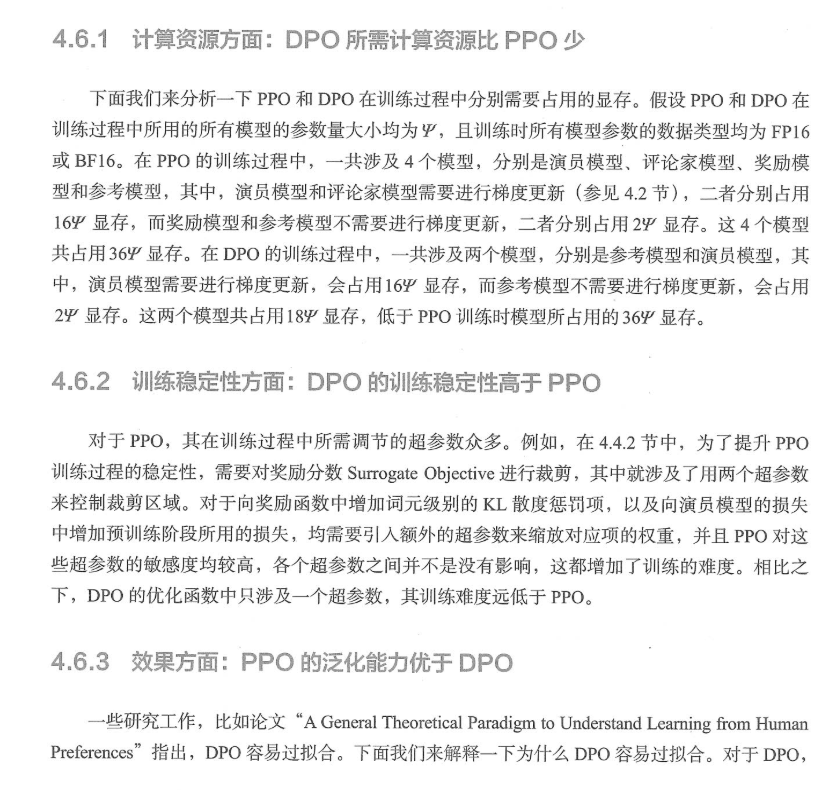

| 对齐微调 | PPO/DPO/垂类优化 | RLHF三阶段流程 vs DPO区别 |

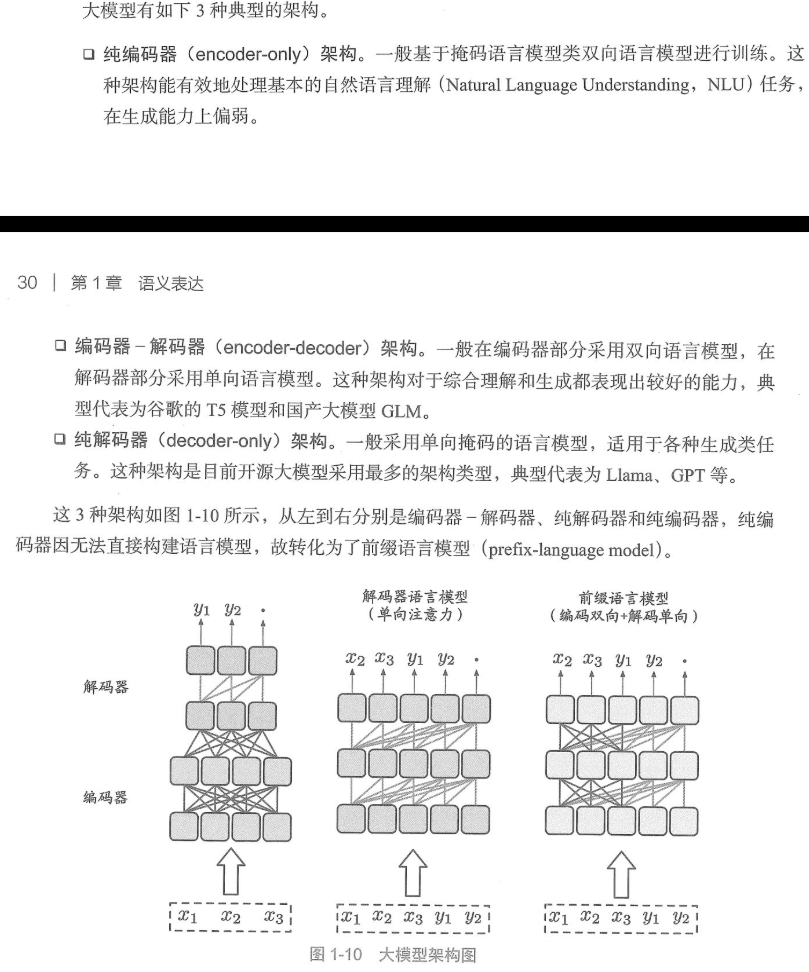

| 架构组件 | Transformer变体/MoE/RoPE | 稀疏注意力如何节省显存? |

| 应用实战 | RAG/智能体/PEFT | 设计多角色Agent协作框架 |

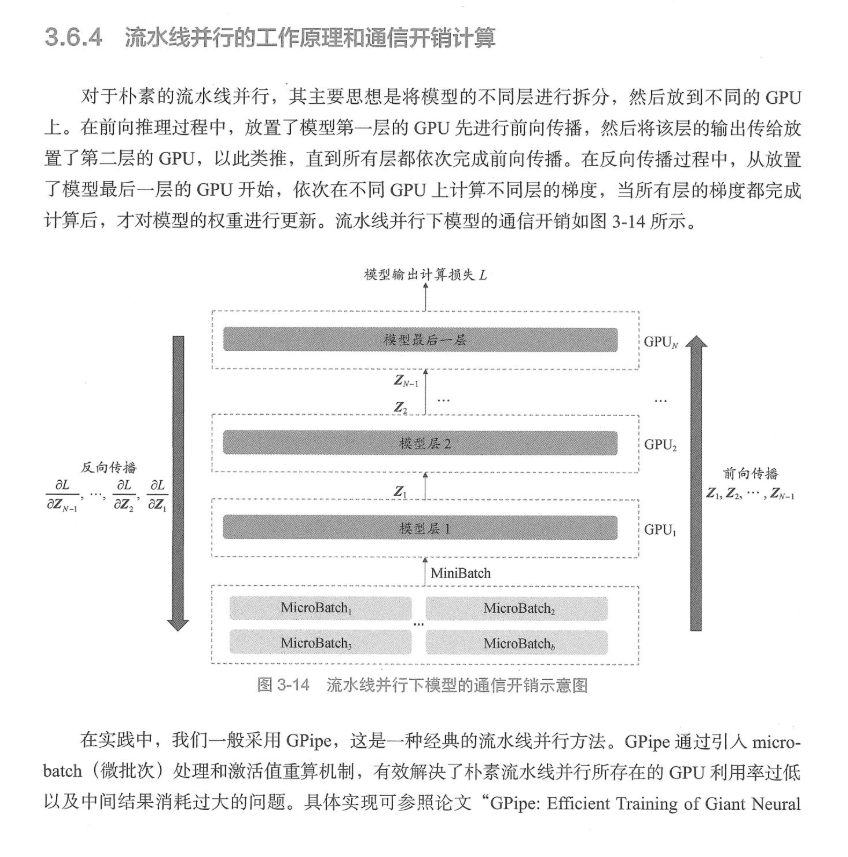

| 工程优化 | 推理加速/分布式训练 | FlashAttention如何实现? |

三、为什么这本书能直击大模型学习者的痛点?

大模型技术栈的复杂性和更新速度远超传统机器学习领域。求职者常陷入三大困境:

- 知识碎片化:刷遍教程却无法建立体系,面对“KV Cache机制”“FlashAttention优化”等题无从下手;

- 项目同质化:简历清一色“基于LangChain的问答系统”,被深问“Chunking策略”“召回优化”时哑口无言;

- 理论与实战脱节:懂Attention公式却写不出Self-Attention伪代码,更无法设计“500ms内响应”的推理服务。

《百面大模型》以 100道高频真题 为锚点,串联起大模型全链路知识图谱——从预训练、对齐微调、推理加速,到RAG、智能体、MoE架构——将零散的知识点整合为可复用的系统框架。

四、不止于“刷题”:从原理到实战的深度拆解

与传统面试书堆砌“标准答案”不同,本书的每道题均以 “三轮穿透式解析” 展开:

- 讲原理:如解析PPO算法时,从奖励模型训练、重要性采样到梯度裁剪,逐层拆解强化学习的工程实现;

- 讲差异:对比LoRA与PEFT、FlashAttention与PagedAttention等技术的适用场景与性能边界;

- 讲趋势:剖析DPO如何解决PPO的复杂性问题,揭示技术演进的内在逻辑。

更难得的是,书中配有大量代码实例、架构图解与面试模拟(如实现简化版Attention、设计多智能体协作系统),让读者从“知道”跃迁至“能做”。

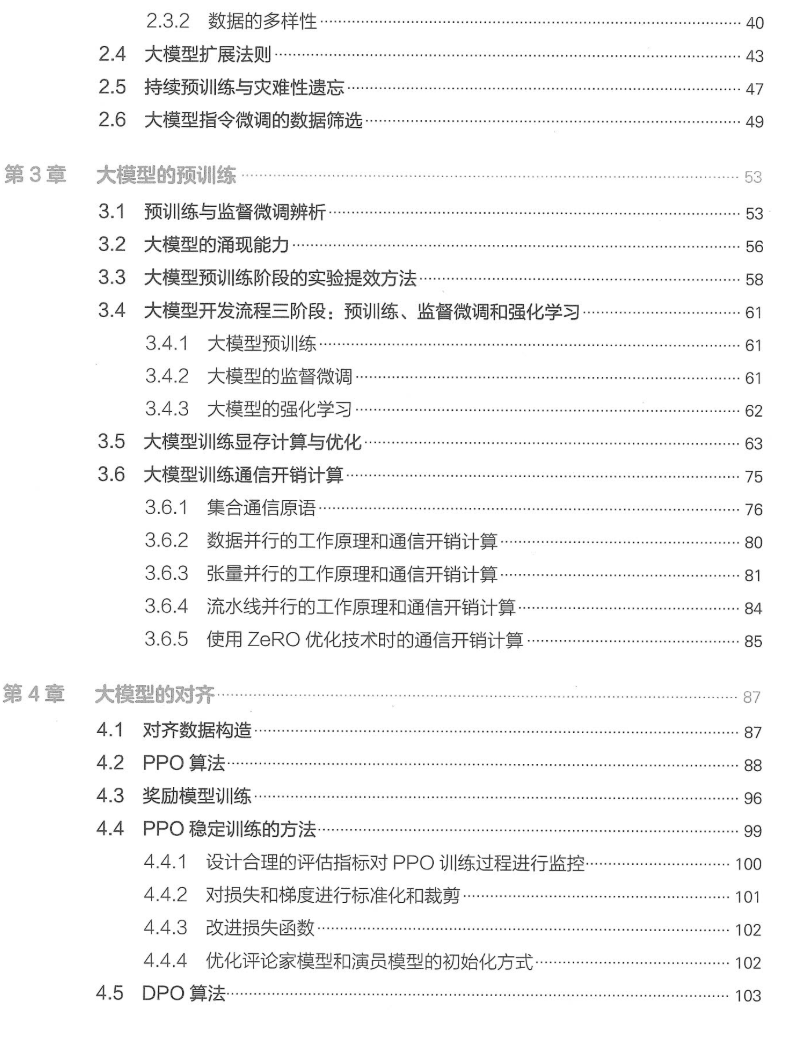

五、谁需要这本书?从入门到资深的全阶段覆盖

| 读者类型 | 核心价值 |

|---|---|

| 校招/转行者 | 系统构建知识体系 + 精准刷题,避免“乱学一气” |

| 初级工程师 | 深入组件原理(如RoPE、ALiBi),补齐工程盲区 |

| 技术负责人 | 把握技术趋势(如Agent调度、多模态对齐),合理评估技术风险 |

| 研究者 | 掌握工业界最新方案(如DeepSeek MLA架构解析) |

六、业内专家为何一致推荐?

本书获得ACL Fellow刘群(华为)、周明(澜舟科技)等学者的高度评价:

“形式上别出心裁……图文并茂,细节翔实,预先洞察了读者可能提出的各类问题。”——刘群

“为读者提供了系统化的学习路径……真诚推荐所有对大模型感兴趣的人阅读。”——《深度强化学习》作者团队

可以给大家看一些部分内容,希望这本书能帮助到你。.

等等很多~!

《百面大模型》不仅能助你拿下 Offer,也能成为你工作、学习过程中的「知识点速查手册」。

这份完整版的《百面大模型》以及大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献110条内容

已为社区贡献110条内容

所有评论(0)