大模型安全攻防技术系列(三):运维篇

随着大模型在生产环境中的广泛应用,其部署运维阶段的安全问题日益凸显。与训练和推理阶段不同,部署运维阶段攻击者可能通过污染模型依赖库、劫持API接口或利用系统漏洞实施攻击,导致模型服务中断、数据泄露等问题。作为《大模型安全攻防技术》专题的收官之作,本文将深入分析大模型在部署运维阶段面临的主要攻击技术,并给出相应的防御方案,为构建安全可靠的大模型生产环境提供参考。

- 引言

随着大模型在生产环境中的广泛应用,其部署运维阶段的安全问题日益凸显。与训练和推理阶段不同,部署运维阶段攻击者可能通过污染模型依赖库、劫持API接口或利用系统漏洞实施攻击,导致模型服务中断、数据泄露等问题。

作为《大模型安全攻防技术》专题的收官之作,本文将深入分析大模型在部署运维阶段面临的主要攻击技术,并给出相应的防御方案,为构建安全可靠的大模型生产环境提供参考。

二、攻击技术

2.1供应链攻击

供应链攻击是指针对大模型开发、部署和维护过程中所涉及的各种组件、工具和服务所发起的攻击。从基础设施层的计算资源、数据集、工具链,到模型层的预训练、微调等环节,再到下游应用生态,供应链中的任何一个环节都可能成为攻击的目标。

常见攻击方式包括:

- 依赖库劫持:在公共包仓库(如PyPI)上传恶意库,利用名称相似性诱导开发者下载,从而植入后门或窃取数据。

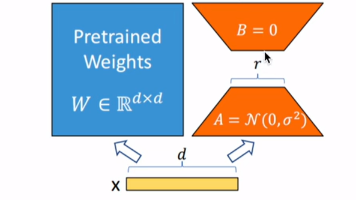

- 预训练模型污染:在开源模型托管平台(如Hugging Face)上传携带后门的模型权重,当用户下载部署时触发恶意行为。

- 容器镜像篡改:劫持公开的Docker镜像或CI/CD流程,在部署环境中注入恶意代码。

模拟攻击示例如下:

利用开源平台(如Hugging Face)的机制漏洞,上传携带恶意代码的模型文件(如.pkl格式),进而利用Python的Pickle反序列化漏洞执行远程代码。

(1)构造恶意.pkl 文件:Python pickle模块反序列化时会自动执行__reduce__魔术方法中的代码。攻击者可构造恶意类,在__reduce__中嵌入任意命令,当受害者加载模型文件时,恶意代码即被执行。

(2)上传恶意.pkl文件:将恶意.pkl文件上传到开源平台(如Hugging Face),由于Hugging Face的扫描工具(如Picklescan)依赖黑名单机制,可通过非常规压缩格式(如7z)或损坏的Pickle文件绕过检测。

(3)受害者加载文件:当受害者使用Python的pickle.load() 加载该文件时,会触发反序列化过程,调用 __reduce__ 方法,导致任意命令执行。

2.2API滥用攻击

API滥用攻击是指攻击者利用大模型提供的API接口,以非预期或恶意的方式对模型进行调用和操作,从而达到破坏、干扰、窃取信息或其他不良目的。

常见攻击方式包括:

- 未授权访问:利用弱认证或配置错误的API密钥,非法调用模型服务,造成资源耗尽或数据泄露。

- 高频恶意请求:通过自动化脚本发起大量请求,消耗计算资源(如GPU配额),导致拒绝服务(DoS)。

- 数据窃取:通过精心设计的输入诱导模型返回训练数据中的敏感信息(如个人隐私、商业机密)。

攻击实例:今年,DeepSeek-R1凭借高性能和低成本迅速在全球范围内流行,其开源策略使用户量激增,但也使其成为黑客攻击的目标。攻击者通过操纵大模型的连续对话上下文回顾机制,构造恶意请求以触发模型进入无限思考循环或超长上下文处理,从而形成对对话服务的拒绝服务攻击。攻击者发送128K Token的超长输入(如伪造的连续对话),导致模型显存耗尽,服务响应延迟从毫秒级升至分钟级。单个恶意请求可触发数万Token的无效输出,攻击成本仅为传统DDoS的1/10。

2.3环境漏洞攻击

环境漏洞攻击是指攻击者利用大模型部署环境(如容器、依赖库、中间件、日志系统等)的漏洞发起的攻击。

常见漏洞包括:

- 模型部署容器逃逸漏洞: 例如runc漏洞(如CVE-2021-30465),可能被攻击者利用获取宿主机权限,导致敏感数据泄露、恶意代码植入等。

- 模块开发框架/库漏洞:例如TensorFlow、PyTorch的特定漏洞(如CVE-2021-41190),可能被攻击者利用来执行恶意代码、破坏模型完整性或窃取敏感数据。

- 模型服务中间件漏洞:例如FastAPI、Flask的未授权访问漏洞,可能被攻击者利用导致模型API暴露、数据泄露或系统被入侵。

模拟攻击示例如下:开源AI模型管理工具Ollama被广泛应用于模型部署和管理,在默认配置下,其服务API接口(http://XX.XX.XX.XX:11434)存在未授权访问漏洞。例如,通过/api/show接口,攻击者能够获取模型的license等敏感信息,访问/api/tags接口获取模型信息:

此外,攻击者还可利用Ollama框架历史漏洞(CVE-2024-39720/39722/39719/39721),直接调用模型接口,实施数据投毒、参数窃取、恶意文件上传及关键组件删除等操作。

三、防御技术

3.1供应链安全防护

- 依赖库管理: 集成软件组成分析(SCA)工具,自动解析项目中的依赖清单,实时识别所使用开源组件中存在的已知漏洞并通知相关人员进行修复。

- 模型来源验证:严格要求从官方认证渠道(如 Hugging Face Verified)下载模型,确保模型来源可信、无篡改;

- 最小化镜像构建:基于Distroless等轻量级基础镜像构建容器,移除不必要的工具和权限。

3.2API安全防护

- 严格访问控制:采用OAuth 2.0、JWT等认证机制,并启用速率限制和配额管理。

- 输入输出过滤:对API输入进行内容审查(如敏感词过滤),输出中剥离训练数据碎片。

- 监控与审计:实时检测异常请求模式(如突发高频调用),并记录完整日志供事后分析。

3.3环境安全防护

- 容器强化:启用AppArmor/SELinux强制访问控制,限制容器权限(如设置文件系统为只读权限)。

- 漏洞管理:定期扫描CVE漏洞(如使用Trivy工具),及时更新补丁。

随着攻击技术的不断演进,大模型部署与运维安全需要持续更新防护策略。未来,可重点关注零信任、机密计算保护等前沿方向,以应对高级持续性威胁(APT)等挑战。

更多推荐

已为社区贡献3条内容

已为社区贡献3条内容

所有评论(0)