Code Agent 时代的编程范式演进

在 Code Agent 时代,编程思维正从“只为人类”向“人机共创”演变。开发者需要在代码简洁性、上下文清晰度和维护性之间找到平衡:通过扁平化、模块化的架构、类型安全的代码、清晰的注释,以及上下文工程与提示策略,将项目打造成对 AI 友好的样本库。研究表明,这些措施不仅降低了计算成本,还显著提高了生成代码的正确率与可读性。未来的Agent-aware 编程可能需要新范式和协议的支持,但核心始终是

前提

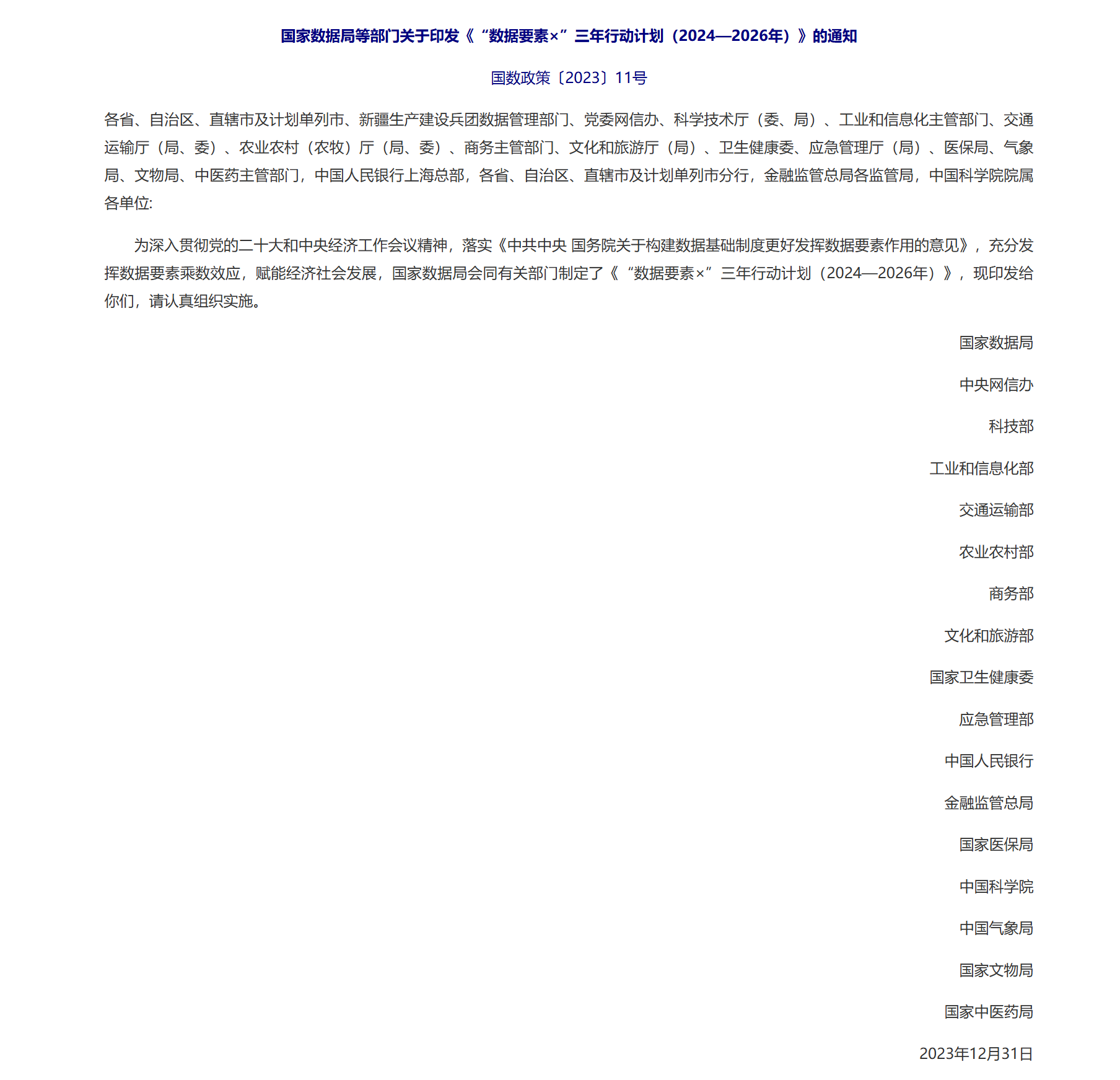

最近参加上级部门要求参加的<数据要素×>,使用 Code Agent 开发赶时间开发,但带来的思维冲击是巨大的。我发现自己的编程方式正在发生深层变革:一方面,通过 AI 协作极大地拓宽了技术视野和知识边界;另一方面,代码设计理念也在升级——从传统的"为人类可读而设计"扩展到"为人机协作而优化"。

讨论

Code Agent 时代下,AI 参与代码开发已成为常态,编程范式正在发生深刻变化。开发者需要为 AI “清晰地呈现”问题和语义:提供高度聚焦、结构化的上下文,而非冗长杂乱的代码。研究指出,有效的上下文工程能显著提升代理性能,减少令牌浪费。例如,通过意图翻译(将自然语言需求转为结构化任务说明)和文献检索(注入领域知识),AI 代理能够更准确地理解需求。这意味着开发者编写代码时,应更多地考虑“上下文质量”而非数量,只传递任务相关的关键信息,避免无关冗余,以降低模型推理成本。

AI 友好的代码结构与风格

扁平化、模块化的代码结构对 AI 理解尤为友好。采用垂直切片架构(Vertical Slice)将功能按业务特性组织,每个“切片”包含完成该功能所需的全部组件,有助于上下文隔离,AI 只需关注局部内容即可。相反,传统的层级或深度继承结构会让 AI 需要跨多个文件检索信息,增加上下文负担。实践中建议:

-

扁平模块:尽量减少深层类继承或嵌套,将代码拆分为更小、可复用的单元。例如,将独立功能提炼为独立函数或模块,使 AI 可以原子化调用和测试。

-

增加入口点:为每个功能建立单一入口文件,便于 AI 直接运行测试,减少跨文件依赖。

-

减少上下文切换:在适当情况下使用内联样式或合并文件。Google 工程师 Arbon 发现,将 CSS 内联化能减少 AI 的上下文负担,因为机器不需要人类的分离逻辑。同理,对于功能相关的小脚本,可考虑将其放入同一文件或附加到主要逻辑中,避免让 AI 在多个文件间来回跳转。

-

清晰命名与注释:使用具有自说明性的命名,并保留高密度的注释,帮助 AI 快速捕捉关键意图。精炼的注释(而非长段落)通常更有助于上下文压缩。

通过上述优化,开发者可以让 AI 代理在更少的上下文中理解功能需求,提高协作效率和准确性。

语法与语言层面的优化

在具体语言层面,也可采取多种策略来提升语义密度和减少令牌数。TypeScript 借助其类型系统自动约束代码,生成的代码正确性更高。最新研究提出通过在生成过程中强制类型约束,大幅降低编译错误。例如,对 TypeScript 代码采用类型安全解码策略,模型仅输出满足类型规则的程序,结果编译错误率降低了一半以上。实践中,应充分利用 TS 的静态类型检查:它能在编写阶段捕获许多错误,减少模型生成或修改后再修复的成本。正如一位工程师指出,TypeScript 的类型系统帮助他在开发复杂 LLM 工作流时提前发现并修复了约 30% 的潜在错误。虽然类型注释本身会增加一定令牌,但它们能显著提升 LLM 生成代码的可靠性,整体上节省了后续反复调试的令牌开销。

对于样式语言,如 Sass/Less,预处理器提供的变量、Mixin、嵌套等特性能减少重复代码。理论上,一个好的 Sass 架构可以用更少的行数表达同样的样式意图,从而压缩令牌使用。实际上,有研究提出利用 AI 自动去除冗余 CSS 规则、优化生成结果,以减少最终样式的体积。例如,AI 可以分析 Sass 代码中的重复模式,自动合并重复的样式声明,或建议提取公共变量,从而在不牺牲可维护性的前提下,降低嵌入模型上下文的代码量。总体而言,策略是保留语义清晰的高级结构(如抽象的变量名、复用机制),同时避免无关冗余,以提高 LLM 理解效率。

上下文压缩与提示工程

AI 代理的表现高度依赖于提供的上下文质量。上下文压缩是关键:将大规模代码库、文档等信息提炼为高价值的要点。在实际流程中,通常分为几步:首先使用更大的模型或工具将用户意图清晰化,再通过语义检索(如对学术文献或 API 文档)获取相关知识;然后由辅助系统(如 NotebookLM)总结核心要点,以列表或问答形式融入主上下文,使信息密度更高。同时,对代码库本身进行代码分块与向量检索:将函数、类按 AST 分块并向量化建库,运行时仅取最相关片段作为上下文。这些做法可避免将整个仓库拼凑到 prompt 中,显著减少无关令牌。

在Prompt 编排方面,策略包括:明示角色与任务边界、分段描述步骤和约束条件。例如,在生成过程中对模型进行角色设定(如“你是资深前端工程师”)和状态指示(如已有代码风格指南),都能提高响应质量。Token-Aware Coding 研究表明,在提示中明确指出代码异味类型并施加角色约束等,可以进一步减少推理所需令牌约 25%~30%。总体看,通过检索增强生成(RAG)、摘要归纳、分层提示等上下文工程技术,可以在复杂任务中达到“单轮成功率”和准确性的大幅提升。

面向 Agent 的编程实践与趋势

未来可能出现专为 AI 代理优化的编码模式和协议。现有工作已提出AI 专用架构:如原子可组合架构(Atomic Composable)将功能分解为可重用组件,单文件 Agents将整个代理功能放在单一文件中,以简化上下文管理。开发者可能还需要设计新的接口或元数据:例如在代码中嵌入机器可解析的约定(特殊注释标记、JSON Schema 注释等),帮助代理理解输入输出格式和调用契约。工具协议方面,Anthropic 的 Claude Code 提供了Model Completion Protocol (MCP),允许代理运行测试、调用外部分析器等,这提示未来编码项目可采用类似开放协议,使代码库“自带”测试和文档工具,方便 AI 自动执行和验证。总之,AI 可读性将成为设计考量:代码既要满足人类逻辑,也要兼顾机器易理解的结构与标记。

研究与实践案例

最新文献和实践案例强调了上述原则的重要性:例如,大规模实验表明,对“丑味”代码进行重构后,在保持功能一致的前提下,模型推理时的令牌消耗可下降近50%;明确提示异味类型等辅助信息,则可进一步降低24%~30%。在多代理系统领域,MASAI、HyperAgent等框架通过分工规划、检索增强和角色分离,使复杂仓库的自动修复率大幅提升。工业界如 GitHub Copilot 生态也在推进类似做法:提供项目级别的说明文件(如 CLAUDE.md),并支持通过 Copilot Spaces 或 MCP 集成项目文档与工具,供 AI 代理参考。研究人员还在探索新语言特性:例如有提议让代码含有元信息标签,以帮助 LLM 准确推断边界和副作用(目前尚在初步研究阶段)。总体来看,各种开源项目、论文和工具报告都在印证一个趋势:为了 AI 协作,代码需要更加结构化、语义化,并辅以有效的上下文管理策略,才能发挥代理的最大潜力。

总结

在 Code Agent 时代,编程思维正从“只为人类”向“人机共创”演变。开发者需要在代码简洁性、上下文清晰度和维护性之间找到平衡:通过扁平化、模块化的架构、类型安全的代码、清晰的注释,以及上下文工程与提示策略,将项目打造成对 AI 友好的样本库。研究表明,这些措施不仅降低了计算成本,还显著提高了生成代码的正确率与可读性。未来的Agent-aware 编程可能需要新范式和协议的支持,但核心始终是:让 AI 代理以最少的投入获取最多的有效信息,真正成为可靠的开发合作伙伴。

参考资料: 以上结论来自最新研究与实践报告,包括针对 LLM 代码生成的 Token-Aware 研究、Context Engineering 多代理系统、以及行业专家经验分享等。它们共同强调了结构化上下文和清晰语义对 AI 协作的重要性。

更多推荐

已为社区贡献2条内容

已为社区贡献2条内容

所有评论(0)