Linux epoll:高并发网络编程的终极武器

Linux epoll是高性能I/O多路复用机制,通过事件驱动实现单线程处理数万并发连接。相比select/poll的O(n)遍历,epoll采用O(1)事件通知,支持无限制fd数量,减少内存拷贝。核心函数包括epoll_create(创建实例)、epoll_ctl(注册/修改fd)、epoll_wait(等待事件)。支持水平触发(LT)和边缘触发(ET)两种模式,ET模式配合非阻塞I/O可实现最

🔥 Linux epoll 系统调用详解

一、epoll 是干什么的?

epoll 是 Linux 内核从 2.5.44 版本开始引入的高性能 I/O 多路复用(I/O Multiplexing) 机制,专为解决 select 和 poll 在处理大规模并发连接时性能低下的问题而设计。

核心作用: 让一个线程能够高效地监控成千上万个文件描述符(如 socket),仅当有 I/O 事件发生时才通知程序处理,避免轮询和阻塞,实现高并发、低延迟的网络服务。

换句话说,epoll 实现了“一个线程处理数万连接”的能力,是现代高性能服务器(如 Nginx、Redis、Netty、Node.js)的底层基石。

二、为什么需要 epoll?它解决了什么问题?

1. select 和 poll 的致命缺陷

| 问题 | 说明 |

|---|---|

| O(n) 时间复杂度 | 每次调用都要遍历所有监听的 fd,即使只有一个就绪 |

| fd 数量限制 | select 最多支持 1024 个 fd(FD_SETSIZE) |

| 用户态/内核态拷贝开销大 | 每次调用都要复制整个 fd 集合到内核 |

| 事件通知机制低效 | 无法知道具体哪个 fd 就绪,必须全遍历判断 |

2. epoll 的解决方案

-

✅ O(1) 事件通知:内核维护一个“就绪链表”,只返回真正就绪的 fd。

-

✅ 无 fd 数量限制:支持数万甚至数十万并发连接。

-

✅ 减少拷贝开销:通过

epoll_ctl预先注册 fd,后续只传递就绪事件。 -

✅ 支持边缘触发(ET):减少事件重复通知,提升性能。

三、epoll 的三大核心函数

epoll 由三个系统调用组成,构成“注册 → 等待 → 处理”闭环:

1. epoll_create() —— 创建 epoll 实例

int epoll_create(int size);

-

功能:在内核中创建一个

epoll实例(事件表),返回其文件描述符。 -

参数:

-

size:提示内核预期监听的 fd 数量(Linux 2.6.8+ 后已废弃,可设为 1 或更大值)。

-

-

返回值:

-

成功:返回 epoll 文件描述符(

epfd) -

失败:返回 -1

-

💡

epoll_create1(0)是更现代的替代,支持额外标志。

2. epoll_ctl() —— 控制 epoll 实例

int epoll_ctl(int epfd, int op, int fd, struct epoll_event *event);

-

功能:向 epoll 实例注册、修改或删除对某个 fd 的监听。

-

参数:

-

epfd:epoll_create返回的 epoll 文件描述符。 -

op:操作类型:-

EPOLL_CTL_ADD:添加监听 -

EPOLL_CTL_MOD:修改监听事件 -

EPOLL_CTL_DEL:删除监听

-

-

fd:要监听的目标文件描述符(如 socket)。 -

event:指向epoll_event结构体的指针。

-

3. epoll_wait() —— 等待事件发生

int epoll_wait(int epfd, struct epoll_event *events, int maxevents, int timeout);

-

功能:阻塞等待,直到有注册的 fd 发生事件。

-

参数:

-

epfd:epoll 实例的 fd。 -

events:用户提供的数组,用于接收就绪事件。 -

maxevents:数组最大长度(通常 10~100)。 -

timeout:超时时间(毫秒):-

-1:永久阻塞 -

0:非阻塞,立即返回 -

>0:最多等待指定毫秒

-

-

-

返回值:

-

0:就绪的 fd 数量

-

0:超时

-

-1:出错

-

四、核心数据结构

1. struct epoll_event —— 事件结构体

struct epoll_event {

uint32_t events; // 事件类型(位掩码)

epoll_data_t data; // 用户数据

};

typedef union epoll_data {

void *ptr;

int fd;

uint32_t u32;

uint64_t u64;

} epoll_data_t;

常用事件类型(events):

| 事件 | 说明 |

|---|---|

EPOLLIN |

数据可读(socket 有数据、文件可读) |

EPOLLOUT |

数据可写(发送缓冲区有空间) |

EPOLLRDHUP |

对端关闭连接(TCP 半关闭) |

EPOLLPRI |

高优先级数据可读(如带外数据 OOB) |

EPOLLERR |

错误发生(自动监听,无需显式设置) |

EPOLLHUP |

连接挂起(自动监听) |

EPOLLET |

边缘触发模式(Edge Triggered) |

EPOLLONESHOT |

事件只通知一次,需重新注册 |

⚠️

EPOLLERR和EPOLLHUP会自动触发,无需在events中设置。

五、epoll 的两种触发模式

1. 水平触发(Level-Triggered, LT)— 默认模式

-

行为:只要 fd 处于就绪状态(如缓冲区有数据),

epoll_wait就会持续通知。 -

特点:

-

安全、简单,适合阻塞或非阻塞 I/O。

-

若未处理完数据,下次调用仍会通知。

-

-

适用场景:大多数通用服务器。

2. 边缘触发(Edge-Triggered, ET)— 高性能模式

-

行为:仅当 fd 状态从“非就绪”变为“就绪” 时通知一次。

-

特点:

-

必须使用非阻塞 I/O,并一次性读/写完所有数据(循环

read/write直到EAGAIN)。 -

避免重复通知,减少系统调用次数。

-

-

适用场景:高并发、低延迟服务(如 Nginx)。

✅ 推荐:生产环境使用

EPOLLET+ 非阻塞 socket。

六、epoll 的工作流程(典型用法)

// 1. 创建监听 socket

int listen_fd = socket(AF_INET, SOCK_STREAM, 0);

bind(listen_fd, ...);

listen(listen_fd, SOMAXCONN);

// 2. 创建 epoll 实例

int epfd = epoll_create(1);

// 3. 将监听 socket 加入 epoll(监听可读)

struct epoll_event ev, events[MAX_EVENTS];

ev.events = EPOLLIN; // 水平触发

// ev.events = EPOLLIN | EPOLLET; // 边缘触发(推荐)

ev.data.fd = listen_fd;

epoll_ctl(epfd, EPOLL_CTL_ADD, listen_fd, &ev);

// 4. 事件循环

while (1) {

int nready = epoll_wait(epfd, events, MAX_EVENTS, -1);

if (nready == -1) {

perror("epoll_wait");

break;

}

for (int i = 0; i < nready; i++) {

if (events[i].data.fd == listen_fd) {

// 新连接到达

int conn_fd = accept(listen_fd, NULL, NULL);

set_nonblocking(conn_fd); // 必须设为非阻塞(ET 模式)

ev.events = EPOLLIN | EPOLLET;

ev.data.fd = conn_fd;

epoll_ctl(epfd, EPOLL_CTL_ADD, conn_fd, &ev);

}

else {

// 已连接 socket 有数据可读

int fd = events[i].data.fd;

char buf[4096];

ssize_t n;

while ((n = read(fd, buf, sizeof(buf))) > 0) {

// 处理数据...

write(fd, buf, n); // echo

}

if (n == 0 || (n == -1 && errno != EAGAIN)) {

// 客户端关闭或出错

epoll_ctl(epfd, EPOLL_CTL_DEL, fd, NULL);

close(fd);

}

// 如果是 EAGAIN,说明数据已读完(ET 模式)

}

}

}🔁 关键点:

epoll_wait返回的是就绪事件列表,无需遍历所有 fd。ET 模式必须循环读写直到

EAGAIN/EWOULDBLOCK。连接关闭时需从 epoll 删除并关闭 fd。

七、epoll 的性能优势

| 优势 | 说明 |

|---|---|

| O(1) 事件通知 | 内核只返回就绪 fd,无需遍历全部 |

| 无 fd 数量限制 | 支持数万并发连接 |

| 减少拷贝开销 | epoll_ctl 预注册,epoll_wait 只传就绪事件 |

| 支持 ET 模式 | 减少事件重复触发,提升吞吐量 |

| 内核事件队列 | 使用红黑树 + 就绪链表,高效管理 fd |

八、epoll vs select/poll 对比

| 特性 | select |

poll |

epoll |

|---|---|---|---|

| 时间复杂度 | O(n) | O(n) | O(1) |

| fd 数量限制 | 1024 | 无硬限制 | 无硬限制 |

| 内存拷贝 | 每次全拷贝 | 每次全拷贝 | 仅事件返回时拷贝 |

| 触发模式 | LT | LT | LT + ET |

| 平台兼容 | POSIX | POSIX | Linux 专用 |

| 适用场景 | 小并发、跨平台 | 中等并发 | 高并发服务器 |

✅ 结论:Linux 上高并发首选

epoll。

九、典型应用场景

-

Web 服务器:Nginx、Apache(event 模式)

-

数据库:Redis、Memcached

-

消息中间件:Kafka、RabbitMQ

-

游戏服务器:MMO、实时对战

-

代理/网关:负载均衡、API 网关

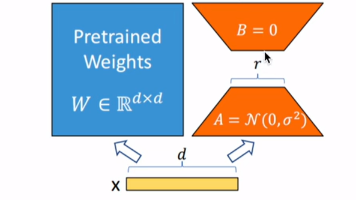

🔧 十、epoll 内核实现原理:红黑树与就绪链表的协同

epoll 的高性能不仅体现在 API 设计上,其背后内核的数据结构设计更是精妙。为了高效管理成千上万个被监控的文件描述符(fd),Linux 内核为每个 epoll 实例维护了两组核心数据结构:

-

红黑树(Red-Black Tree):用于管理所有注册的监听 fd。

-

就绪链表(Ready List):用于存放当前已就绪的 fd 事件。

这两者的协同工作,是 epoll 实现 O(1) 事件通知的关键所在。

1. 红黑树:高效管理监听集合

当调用 epoll_ctl(EPOLL_CTL_ADD) 添加一个 fd 时,内核会将其插入到 epoll 实例对应的红黑树中。

-

键(Key):通常是文件描述符

fd。 -

值(Value):包含该 fd 的事件信息(如监听 EPOLLIN)、回调函数指针等。

✅ 优势:

-

插入、删除、查找时间复杂度均为 O(log n),远优于 select/poll 的线性扫描。

-

支持快速去重:重复添加同一 fd 可被检测并拒绝。

-

动态扩展:不受固定大小限制,可容纳数十万连接。

📌 注意:虽然单次

epoll_ctl操作是 O(log n),但这类操作频率远低于epoll_wait,因此整体性能依然接近 O(1)。

2. 就绪链表(Ready List):事件驱动的核心

这才是 epoll 实现“只返回就绪 fd”的秘密武器。

工作机制:

-

每个被监听的 fd 都会注册一个回调函数(callback)。

-

当某个 socket 接收到数据(即网络中断发生),内核协议栈处理完后,会触发该 socket 的就绪事件。

-

此时,内核自动调用预先注册的回调函数,将该 fd 对应的事件节点加入就绪链表。

-

epoll_wait()调用时,仅需从就绪链表中取出所有节点,拷贝到用户空间即可。

✅ 关键点:

-

epoll_wait的返回时间与“就绪 fd 数量”成正比,而非“总监听数量”,因此是 O(1) 均摊性能。 -

用户无需遍历所有连接,只处理真正有事件的连接,极大提升效率。

3. 协同流程图解

用户程序 内核空间 | | |---- epoll_ctl(ADD, fd=5) ----->| → 插入红黑树 | | → 注册回调函数 | | |<-- 网络数据到达 (中断) --------| ← 网卡通知 CPU | | | | → 协议栈处理 TCP 包 | | → 触发 socket 就绪 | | → 回调执行:将 fd=5 加入就绪链表 | | |---- epoll_wait() ------------>| → 检查就绪链表 |<-- 返回 events[0].fd=5 -------| ← 拷贝就绪事件给用户 | |--- 处理 fd=5 的读操作 -------->|

4. 回调机制详解:事件驱动的灵魂

epoll 利用了内核的“通知机制”:

-

当一个 socket 被加入 epoll 后,内核会在其

struct file或struct socket上设置一个 ep_poll_callback。 -

一旦该 socket 收到数据、连接关闭或写缓冲区就绪,内核就会调用这个回调。

-

回调函数负责将对应的

epi(epoll item)结构加入就绪链表,并唤醒等待中的epoll_wait进程。

这实现了真正的事件驱动(Event-Driven)模型,避免了轮询浪费 CPU。

5. 数据结构总结表

| 结构 | 用途 | 时间复杂度 | 特点 |

|---|---|---|---|

| 红黑树 | 存储所有被监听的 fd | O(log n) 插入/删除 | 快速查找、去重、动态扩展 |

| 就绪链表 | 存储当前已就绪的 fd 事件 | O(1) 取出事件 | epoll_wait 直接消费 |

| 回调函数 | fd 就绪时自动触发,添加到就绪链表 | O(1) 触发 | 内核主动通知,实现事件驱动 |

✅ 为什么说这是“高并发的基石”?

正是这种 “红黑树 + 就绪链表 + 回调机制” 的三重设计,使得 epoll 能够:

-

横向扩展:轻松支持 10K+ 并发连接;

-

纵向高效:每秒处理数万次事件轮询而不成为瓶颈;

-

资源节约:CPU 不再浪费在空轮询上,内存使用也更加紧凑。

💡 类比: 如果把 select 比作“每天挨家挨户敲门问有没有信”, 那么 epoll 就是“邮递员只把有信的人家名单送上门”——这才是现代快递系统的逻辑。

✅ 总结:epoll 的三大工程智慧

-

空间换时间:用红黑树维护监听集,换取快速增删查。

-

事件驱动代替轮询:通过回调机制,让内核主动通知用户态。

-

分离关注点:红黑树管“全量”,就绪链表管“增量”,各司其职。

🎯 掌握这些原理,你就不再只是“会用 epoll”,而是真正理解了 Linux 高性能网络编程的底层心脏。

你可以将上述内容作为文章的第十一节插入原文,或作为“进阶篇”独立发布。它不仅能提升文章的技术深度,还能帮助读者建立系统级认知,真正掌握“为什么 epoll 这么快”。

如果你需要,我还可以为你绘制一张 epoll 内核结构示意图(文字版或 Mermaid 图),方便配图说明。是否需要?

十一、总结:epoll 的定位

| 项目 | 内容 |

|---|---|

| 本质 | Linux 高性能 I/O 多路复用机制 |

| 目的 | 单线程高效处理海量并发连接 |

| 核心函数 | epoll_create, epoll_ctl, epoll_wait |

| 核心结构 | epoll_event |

| 触发模式 | LT(默认)、ET(高性能) |

| 适用场景 | 高并发网络服务(>1000 连接) |

| 不适用场景 | 跨平台应用、低并发简单服务 |

| 学习价值 | 掌握现代高性能服务器底层原理 |

📌 一句话总结: epoll 是 Linux I/O 多路复用的王者,它通过事件驱动、O(1) 通知、边缘触发等机制,实现了单线程处理数万并发连接的奇迹,是构建高性能网络服务的核心武器。

🔥 进阶建议:

学习

epoll源码(fs/eventpoll.c)理解红黑树与就绪链表的协同

掌握 ET 模式下的非阻塞编程范式

对比

io_uring(下一代异步 I/O)

掌握 epoll,你就掌握了 Linux 高性能网络编程的“任督二脉”。

更多推荐

已为社区贡献6条内容

已为社区贡献6条内容

所有评论(0)