2 万美元、10 万行代码、16 个 AI Agent:一场 C 编译器实验戳破的 AGI 泡沫

摘要:Anthropic实验团队让16个AI Agent自主开发Linux平台的C编译器,结果令人失望:耗费2万美元API成本生成10万行代码,单条有效代码成本达5美元;最终产品缺失汇编器、链接器等核心组件,依赖GCC才能运行,连Hello World程序都无法稳定编译。实验暴露了AI在系统工程中的核心短板:缺乏全局规划能力、系统完整性认知、工程质量管控以及对底层原理的深度理解。这表明当前AI擅长

当 Anthropic 的实验团队让 16 个 AI Agent 自主搭建一款 Linux 平台的 C 编译器时,他们大概率期待的是一场 AI 工程能力的里程碑式突破。但最终的结果,却给当下狂热的 AGI 炒作、AI Agent 万能论,浇了一盆最冰冷的现实冷水:

这场耗时不短的自主开发,最终烧掉了 2 万美元的 API 成本,产出了 10 万行代码,单条有效代码的成本高达 5 美元;而最终交付的 “C 编译器”,不仅缺失汇编器、链接器、16 位编译支持等核心组件,严重依赖 GCC 的底层能力才能运行,连最基础的 Hello World 程序都无法稳定编译,生成代码的执行效率甚至比不上关闭所有优化选项的 GCC,新增功能还会频繁破坏已有的基础能力。

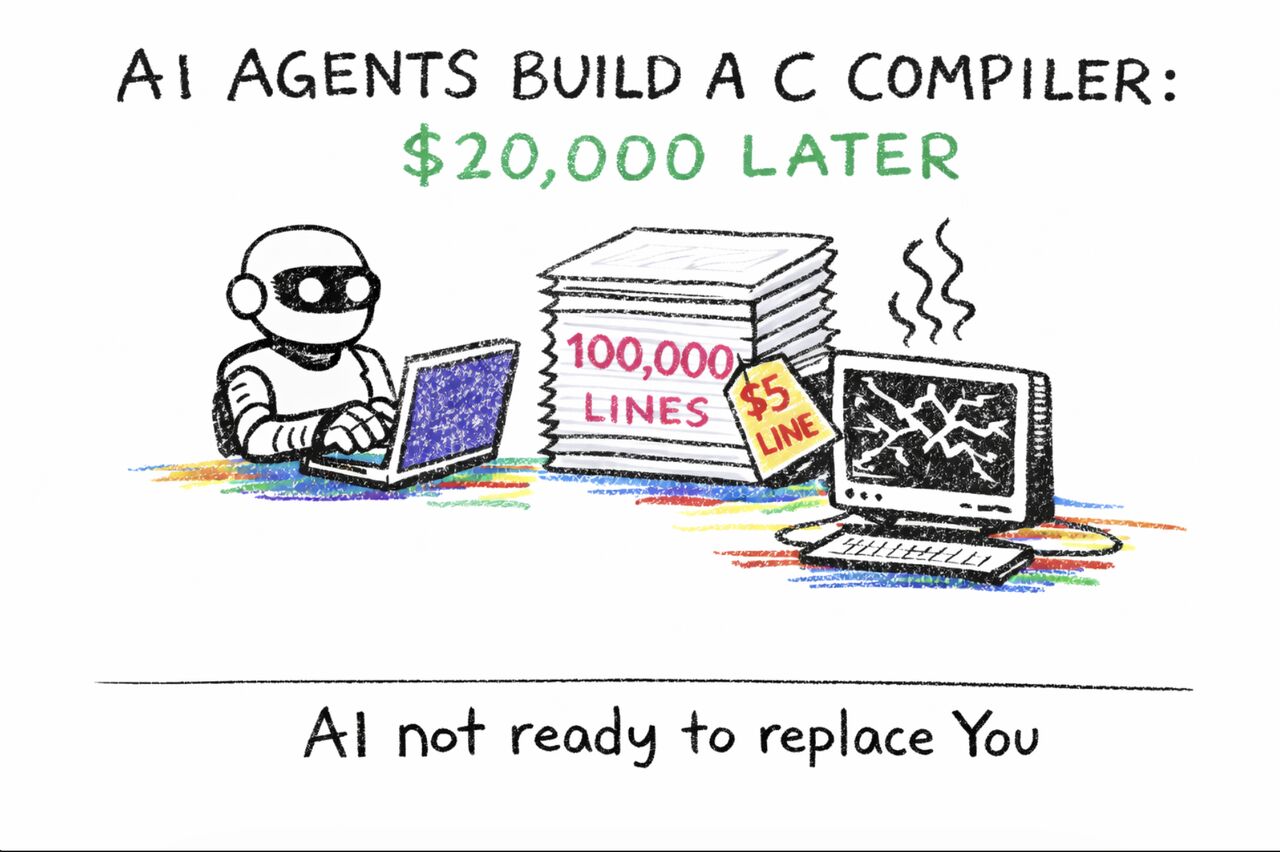

这幅漫画里的场景精准复刻了这场实验的荒诞:埋头敲代码的 AI 机器人、堆成山却价值极低的 10 万行代码、彻底宕机崩溃的运行环境,还有最扎心的那句结论 ——AI not ready to replace You。

这场实验最具讽刺性的地方,不在于 AI 的失败,而在于它失败的场景:编译器构建,是计算机科学领域最成熟、文档最完善、链路最闭环的工程问题。从《编译原理》(龙书)、《现代编译器实现》(虎书)等数十年的经典教材,到 GCC、Clang、LLVM 等生产级开源实现,再到无数高校课程的教学案例、最佳实践,关于如何从零搭建一个 C 编译器的所有知识、步骤、坑点,都已经被写得明明白白,没有任何未知的创新需求,没有任何模糊的业务边界,只是一个纯粹的、按部就班的工程实现任务。

如果 AI 在这样一个 “所有答案都已经写在教科书里” 的场景里,都交出了这样一份不及格的答卷,那当下甚嚣尘上的 “AGI 即将到来”“AI Agent 将全面替代程序员” 的言论,又有多少可信度?

一、实验复盘:一场被寄予厚望的 AI 工程实验,最终输在了哪里?

我们先把这场实验的全貌拆解清楚,就能明白 AI Agent 的短板,从来不是 “写代码的能力”,而是 “做工程的能力”。

1. 实验的投入与产出:看似可观,实则低效到离谱

Anthropic 的实验设定,是让 16 个具备自主规划、代码生成、工具调用能力的 AI Agent,以 “从零搭建 Linux 平台 C 编译器” 为目标,完成全流程的自主开发。最终的投入产出数据,堪称 AI 工程化的反面教材:

- 成本投入:累计消耗 2 万美元的大模型 API 费用,这还不包括实验团队的人工运维、环境搭建成本;

- 代码产出:累计生成 10 万行代码,折算下来单条代码的成本高达 5 美元,这在软件工程领域是难以想象的数字 —— 一个普通的初级开发工程师,月薪也能写出上万行有效代码,单条代码的人力成本不足 0.1 美元;

- 最终交付:一个残缺不全、无法独立运行、效率低下、稳定性极差的 “半成品编译器”。

2. 交付物的核心缺陷:连 “可用” 的门槛都没摸到

一个完整可用的 C 编译器,需要覆盖从前端到后端的完整链路:词法分析、语法分析、语义分析、中间代码生成与优化、目标代码生成、汇编器、链接器,缺一不可。而 AI Agent 交付的产物,在核心能力上存在致命的短板:

- 核心组件严重缺失:缺少编译器必备的汇编器、链接器,也不支持 16 位代码编译,相当于造了一辆汽车,却没有变速箱、刹车系统和传动轴,只有一个外壳和发动机,根本无法独立完成完整的编译流程;

- 重度依赖外部工具:所有核心的底层编译、链接能力,都必须依赖 GCC 才能实现,AI Agent 只是做了一层极其薄弱的表层封装,完全没有实现真正的自主编译能力;

- 基础功能都无法稳定实现:连编程入门的第一个程序 “Hello World”,都无法稳定、正确地完成编译运行,频繁出现语法解析错误、链接失败、运行崩溃等基础问题;

- 代码质量与效率极差:生成的可执行文件,执行效率甚至比不上关闭了所有优化选项的 O0 级 GCC,完全没有编译优化的概念,只是把功能代码简单堆砌,完全不考虑执行效率、内存占用、兼容性等工程指标;

- 工程稳定性完全失控:新增功能频繁破坏已有的基础能力,也就是软件工程里最致命的 “回归问题”。AI Agent 没有完整的版本管理、回归测试、兼容性校验的工程思维,只是一味地新增代码,最终导致整个系统越改越乱,陷入 “修一个 bug,出十个 bug” 的恶性循环。

二、教科书级的场景都搞不定,AI Agent 的核心短板到底是什么?

这场实验最值得我们思考的问题是:AI 能轻松通过大厂的编程面试,能写单函数的业务代码,能解 LeetCode 上的算法题,为什么在一个有完整参考、有明确步骤的编译器搭建任务里,输得这么彻底?

答案很简单:AI 擅长的是 “单点的代码生成”,而不擅长的是 “长链路、强耦合、高依赖的系统工程全局把控”。而后者,才是程序员、工程师的核心价值,也是 AI 至今无法跨越的天堑。

具体来说,AI Agent 在这场实验里暴露了四个无法回避的核心短板,也是当前大模型驱动的 AI Agent 的通用瓶颈。

1. 缺失系统工程的全局规划与架构设计能力

编译器构建不是零散代码的堆砌,而是一个多层级、强依赖、高耦合的复杂系统工程。从前端的词法语法解析,到中端的中间代码优化,再到后端的目标代码生成、汇编链接,每一个模块都强依赖前序模块的输出,模块之间的接口定义、数据格式、错误处理,都需要前期有完整的架构设计、模块划分、依赖管理规划。

而当前的 AI Agent,本质上是 “基于大模型的分步任务拆解”,它只能看到眼前的一步,无法对整个系统的长期演进、模块耦合、架构兼容性做全局把控。它可以根据需求写一个词法分析器,也可以写一个语法解析器,但它无法预判这两个模块之间的接口是否兼容、未来新增优化模块时会不会出现架构冲突、新增功能会不会破坏已有的基础能力。

这就像一个只会砌砖的工人,能把每一块砖都砌得整整齐齐,却看不懂建筑图纸,不知道承重墙在哪,不知道水电管线怎么留,最终砌出来的不是房子,而是一堵随时会塌的危墙。16 个 AI Agent 堆出来的 10 万行代码,就是这样一堵危墙。

2. 对 “系统完整性” 没有工程化认知,只懂 “堆砌功能”,不懂 “构建系统”

一个合格的工程师,在动手写代码之前,首先会明确 “这个系统的核心目标是什么?要实现完整的能力,必须包含哪些核心组件?每个组件的边界和职责是什么?”。就像搭建编译器,工程师从第一天就知道,汇编器和链接器是不可或缺的核心组件,没有它们,前端的解析做得再好,也无法生成可执行文件。

但 AI Agent 没有这种 “系统完整性” 的认知。它只会根据 “C 编译器” 这个模糊的目标,去堆砌大家熟知的 “词法分析、语法分析” 等表层功能,却不知道一个完整可用的编译器,到底需要哪些必备的底层组件,也不知道这些组件之间的依赖关系。最终交付的产物,只是一个看起来像编译器的 “空壳”,没有核心的底层能力,只能依赖 GCC 才能勉强运行。

这种差距,本质上是 “知其然” 和 “知其所以然” 的差距。AI 可以从海量的训练数据里知道 “编译器有词法分析模块”,但它无法真正理解 “为什么需要汇编器和链接器”“这些组件在整个编译链路里承担什么角色”,自然也就不会主动去实现这些核心能力。

3. 缺乏工程质量管控能力,只追求 “能跑 demo”,不追求 “可生产可用”

软件工程的核心,从来不是 “写出能跑的代码”,而是 “写出可维护、可扩展、高性能、高稳定的代码”。一个生产级的编译器,不仅要能编译代码,还要保证编译效率、生成代码的执行效率、跨平台兼容性、错误提示的友好性,还要有完整的测试用例、回归校验机制,保证新增功能不会破坏已有能力。

而 AI 生成代码的通病,就是 “demo 至上”。它可以快速写出一个能跑通简单案例的 demo,但完全没有工程质量管控的概念:不会做边界条件处理,不会做异常捕获,不会做性能优化,更不会主动写测试用例、做回归校验。

这也是为什么实验里的 AI Agent,会出现 “新增功能频繁破坏现有功能” 的问题 —— 它根本没有回归测试的概念,改完代码不会去验证已有的基础功能是否正常,最终导致整个系统的稳定性彻底失控。而这种工程化的质量管控思维,是当前 AI 完全不具备的,也是区分 “玩具代码” 和 “生产级代码” 的核心门槛。

4. 对底层原理的理解停留在表面,无法实现深度的技术融合

C 编译器是和操作系统、硬件架构深度绑定的底层工具。要做好一个编译器,需要对 Linux 系统调用、x86/ARM 汇编指令集、进程内存布局、可执行文件的链接装载机制,有极深的底层理解。这些知识虽然都在教科书里写着,但需要工程师把这些底层原理和代码实现深度融合,才能做出高效、稳定的编译器。

AI Agent 的短板恰恰在这里:它可以检索到所有关于汇编、系统调用的知识,但无法把这些碎片化的知识,和编译流程的每一个环节深度融合。它只能做表层的知识拼接,无法理解底层原理之间的关联,最终只能把核心的底层编译能力交给 GCC,自己只做一个表层的封装,完全无法实现真正的自主实现。

这就像一个背熟了所有医学教材的人,却不会给病人做手术 —— 他知道所有的知识点,却不知道怎么把这些知识点融合起来,解决真实场景里的复杂问题。

三、从实验看行业:AGI 的目标 post,正在越移越低

这场实验,不仅暴露了 AI Agent 的技术短板,更戳破了当下行业里关于 AGI 的炒作泡沫。

就在几年前,行业对 AGI 的期待,是 “做出比人类更好的产品,解决人类解决不了的问题”;后来,期待变成了 “AI 能自主完成人类能做的常规工程任务”;而现在,连 “AI 能做出一个看起来像那么回事的东西,哪怕残缺不全、效率低下”,都能被包装成 AI 的里程碑式突破。

目标 post 一降再降,本质上是因为当前的大模型技术,已经触碰到了 “从感知、生成到深度推理、系统规划” 的天花板。我们必须承认一个现实:当前的生成式 AI,本质上还是 “基于海量训练数据的概率性内容生成”,它没有真正的逻辑推理能力,没有全局的系统规划能力,没有自主的工程化思维,更没有对事物本质的深度理解。

如果 AI 在一个所有知识都已经被写下来、没有任何创新需求、纯粹工程实现的场景里,都无法交出一份合格的答卷,那我们又怎么能相信,它能在更复杂、更模糊、更有创新性的真实业务场景里,替代人类的工作?

我们从来不是要否定 AI 的价值。恰恰相反,AI 是这个时代最强大的生产力工具。一个合格的工程师,用 Copilot、Claude Code 等 AI 工具辅助开发,能把编码效率提升数倍,能快速查阅自己不熟悉的技术栈,能让 AI 帮自己写测试用例、查 bug、做代码重构,从重复的低价值劳动里解放出来,聚焦在更有创造性的架构设计、技术方案规划上。

但 “辅助工具” 和 “自主替代人类” 之间,有一道无法跨越的天堑。AI 可以帮你写代码,但它无法帮你做系统架构设计;AI 可以帮你整理需求,但它无法帮你判断业务的核心价值;AI 可以帮你分析数据,但它无法帮你制定业务的战略方向。这些需要深度思考、全局规划、对事物本质有深度理解的工作,恰恰是人类的核心价值,也是 AI 至今无法替代的。

四、给所有从业者的启示:你的工作很安全,但你要学会驾驭 AI

这场实验给所有焦虑 “AI 要取代我的工作” 的人,吃了一颗最实在的定心丸:你的工作暂时是安全的。AI 是强大的工具,但要做到自主替代人类,还差得很远。

但这并不意味着我们可以高枕无忧。未来,被淘汰的不会是会用 AI 的人,而是不会用 AI 的人。

在 AI 时代,工程师的核心竞争力,已经从 “写代码的熟练度”,变成了 “系统架构设计能力、工程化管控能力、问题拆解与规划能力、对底层原理的深度理解能力”。这些能力,是 AI 无法替代的,也是你驾驭 AI 的核心资本。你对系统、对业务、对技术的理解越深,AI 对你的助力就越大;反之,如果你自己都不懂底层原理,看不懂 AI 写的代码,分不清 AI 输出的内容是对是错,那最终只会被 AI 牵着鼻子走,被时代淘汰。

这场 C 编译器实验,也给所有 AI Agent 的研发者提了个醒:当前的 AI Agent,还停留在 “任务拆解 + 工具调用” 的初级阶段,距离真正的 “自主智能体”,还有很长的路要走。如何让 AI 具备全局规划能力、系统工程思维、工程质量管控能力,是未来 AI Agent 研发必须突破的核心瓶颈,而不是一味地堆 Agent 数量、堆 API 调用成本,最终只产出一堆华而不实的垃圾代码。

结语

漫画里那个埋头敲代码的 AI 机器人,像极了当下被 AGI 炒作裹挟的我们:总觉得 AI 马上就要无所不能,马上就要取代我们的工作,却忽略了一个最基本的事实 —— 人类的核心价值,从来不是能写多少行代码,能做多少重复的劳动,而是我们能思考、能规划、能理解事物的本质,能搭建起复杂的系统,能创造出从未有过的东西。

AI 永远无法替代一个能从零搭建起编译器的工程师,就像画笔永远无法替代画家,手术刀永远无法替代外科医生。它只是一个工具,一个强大到能放大人类能力的工具。

我们不用焦虑 AI 会取代我们,也不用对 AI 的能力嗤之以鼻。我们要做的,是保持对技术的理性认知,学会驾驭 AI 这个强大的工具,把它用在提升效率、解放创造力上,而不是被行业的炒作裹挟,陷入无意义的焦虑里。

毕竟,连一个 C 编译器都搞不定的 AI,离取代你,还有太远太远的路要走。

更多推荐

已为社区贡献80条内容

已为社区贡献80条内容

所有评论(0)