通过测试-时强化学习实现VLA的动态自适应

26年1月来自密苏里大学、港科大(广州)、美海军实验室、Meta AI等的论文“On-the-Fly VLA Adaptation via Test-Time Reinforcement Learning”。视觉-语言-动作(VLA)模型最近已成为通用机器人学习的强大范式,使智体能够将视觉观察和自然语言指令映射到可执行的机器人动作。尽管VLA模型广受欢迎,但它们主要通过监督微调或训练时强化学习进行

26年1月来自密苏里大学、港科大(广州)、美海军实验室、Meta AI等的论文“On-the-Fly VLA Adaptation via Test-Time Reinforcement Learning”。

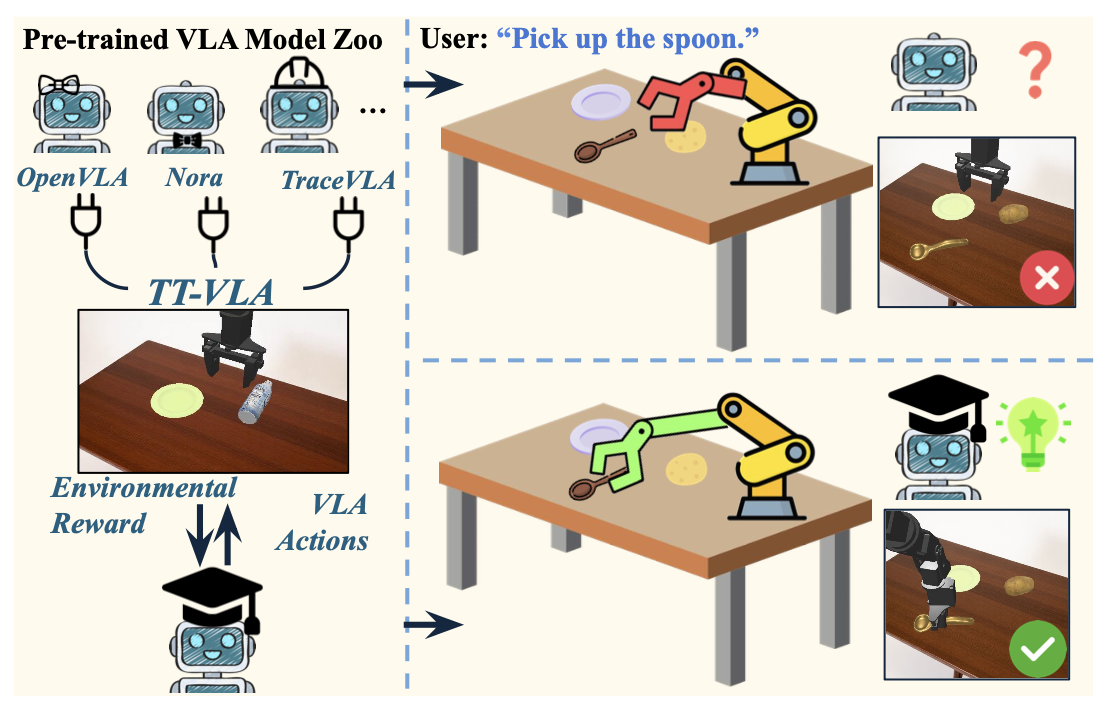

视觉-语言-动作(VLA)模型最近已成为通用机器人学习的强大范式,使智体能够将视觉观察和自然语言指令映射到可执行的机器人动作。尽管VLA模型广受欢迎,但它们主要通过监督微调或训练时强化学习进行训练,需要明确的微调阶段、人工干预或受控的数据收集。因此,现有方法仍然不适用于具有挑战性的模拟或物理世界部署,在这些场景中,机器人必须自主灵活地响应不断变化的环境。为了解决这一局限性,引入一种用于VLA的测试-时强化学习框架(TT-VLA),该框架能够在推理过程中实现策略的动态自适应。TT-VLA构建一种密集奖励机制,该机制利用分步任务进度信号在测试时改进动作策略,同时保留SFT/RL训练的先验知识,使其成为现有VLA模型的有效补充。

如图所示:TT-VLA通过在测试阶段根据环境反馈的奖励不断调整策略,对SFT/RL训练的VLA进行补充,从而提高对分布变化的鲁棒性,而无需重新训练。

测试-时训练 (TTT) 最初被提出用于仅使用未标记的测试数据将预训练模型适应到目标领域(Sun,2020;Hu,2025;Yoon,2024;Xiao,2025;Zhu,2024;Zuo,2025)。与 SFT(Jia,2022;Mosbach,2021;Han ,2023;Wang ,2025a;Liu ,2025b,2024b;Hu ,2022;Zeng ,2024;Wang ,2024b)或传统强化学习(Sutton ,1999a;Guo ,2025a;Huang ,2025;Zhang ,2025;Mark ,2024)不同,TTT 利用自监督目标(例如,熵最小化)在推理过程中校准模型,从而在缺乏人工标注标签和外部反馈的情况下实现有效的域适应。

直观上,TTT 可以自然地扩展到视觉-语言-动作(VLA),以实现在推理过程中的高效适应。然而,与相对直观的单域任务(例如,视觉、语言)不同,在这些任务中,预训练模型表现出较高的泛化能力(Brown ,2020;Wei ,2022;Goyal ,2023),并且任务间的差异相对较小(Hu ,2025;Liu ,2021;Zhao ,2023;Han ,2025),而机器人任务通常涉及视觉和语言模态的显著分布偏移和不断变化的环境(Pong ,2020;Wang ,2025a;Kim ,2024;Liu ,2024a)。因此,固定且基于协议的自监督目标变得不足且过于通用。

最近的研究探索基于强化学习的方法,以替代纯粹的自监督测试时训练目标。特别是,EVOLVE-VLA(Bai ,2025b)利用任务进度作为奖励信号,在部署期间优化 VLA 策略。然而,它对 GRPO 式优化的依赖会带来大量的计算开销,从而限制其在具有严格延迟约束的实时机器人环境中的应用。

为了解决这些局限性,本文提出一种基于强化学习的测试-时学习框架,该框架能够实现高效的在线适应,用于视觉-语言-动作(VLA)的测试-时强化学习框架(TT-VLA),该框架无需重训练即可高效地执行在线推理-时策略微调,同时保留SFT/训练时强化学习的先验知识,并通过密集的推理-时奖励信号形成闭环。其中,TTT提供测试时适应性,而强化学习则通过解决环境条件和底层分布的显著变化来对其进行补充。

与传统的基于会话强化学习(例如SimpleVLA-RL)不同,本文从与任务无关的代理(proxy)中提取密集成形信号,及时有效地利用有限的测试-时信息并优化VLA策略。这些成形信号在不同的时间帧上独立运行,从而实现稳定、通用且连续的调整。

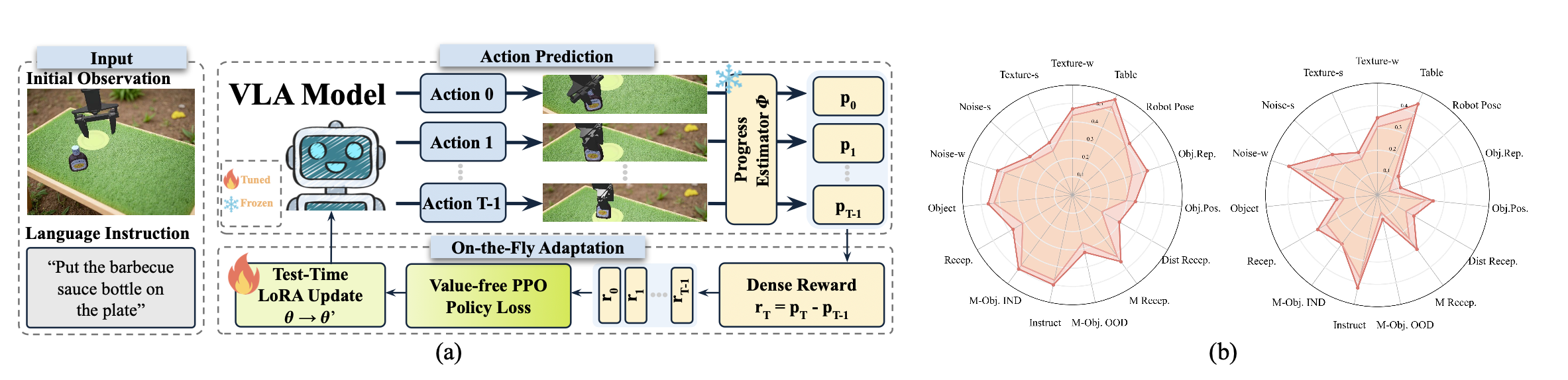

TT-VLA的概述如图所示:

在强化学习中PPO 是一种基于Actor-Critics架构的策略梯度方法,它使用截断的替代目标函数来约束策略更新,通过将更新后的策略保持在先前策略的信任区域内,从而确保优化的稳定性。在PPO算法中,策略函数π_θ和价值函数V_θ是联合训练的。然而,在VLA的测试-时自适应过程中,由于以下两个原因,学习一个可靠的价值函数通常是不可行的:1. 样本有限:测试时自适应依赖于极其有限的交互数据(单个episode),不足以进行准确的回报估计。2. 严格的时间限制:VLA模型的测试-时更新必须在严格的延迟限制下在线执行。为了克服这些限制,开发一种无价值函数的PPO算法,该算法无需显式价值函数即可实现策略自适应。

基于进度的密集奖励。大多数现有基于强化学习的VLA方法(Li et al., 2025a; Liu et al., 2025a)依赖于稀疏的终端奖励,通常表示任务在episode结束时的成功或失败。虽然这种奖励在离线训练期间有效(可以重放或重置episode),但对于测试-时自适应来说并不实用:策略更新会延迟到任务完成之后,从而无法进行episode中期的纠正或在线调整。因此,使用稀疏奖励的机器人在推理过程中无法改进其行为,导致在动态环境中性能脆弱且缺乏适应性。

设 p_t ∈ [0, 1] 表示时间步 t 的任务进度。直观上,当执行的动作有助于完成任务时,p_t 应该增加;当执行的动作撤销或逆转先前取得的进展时,p_t 应该减少。在部分可观测马尔可夫决策过程 (POMDP) 的设定下,直接从观测结果和语言指令中估计任务进度。

每一步的密集奖励被定义为进度的时间差。其用视觉-语言-动作- Critics模型(VLAC)(Zhai,2025)实例化一个基于观察历史和指令的任务进度预测器,记作 Φ。VLAC 是一个预训练的多模态模型,用作任务进度估计的标量回归器。

这种基于进度的奖励机制具有三个理想的特性。首先,它在推理过程中无需外部监督,从而允许在测试阶段实现全自主的适应。其次,它提供密集的分步反馈,有助于在单个episode中进行持续的策略调整。第三,它鼓励朝着任务完成方向单调前进,同时抑制振荡或倒退行为。

训练目标。在测试阶段的VLA设置下,在单个episode内学习准确的价值函数V_θ是不切实际的。因此,采用一种无价值函数的PPO变型,其无需学习价值函数,而是直接使用每一步奖励信号进行策略调整。

为了使智体能够精确地捕捉当前动作的即时价值,进一步重定义优势函数,使其仅取决于该动作获得的奖励,而不是像广义优势估计(GAE)方法 中那样使用时序差分 (TD) 残差的指数加权组合。换句话说,关注的是每个单独动作如何促进即时进展,而不是估计长期回报。这种简化确保策略更新能够直接反映每个步骤的进展,使智体能够快速适应不断变化的环境,而无需依赖价值函数。

整体流程。在每个episode的开始,预训练的VLA接收初始观测值o_0和指令 l。VLA策略π_θ生成第一个动作a_0。在后续的每个时间步 t,VLA接收最新的观测值o_t并输出动作a_t。执行动作后,进度预测器Φ计算任务进度p_t,以及相应的密集奖励r_t。该奖励用于以无价值函数的方式计算策略损失,并相应地更新策略参数θ。更新后的策略π_θ′随后用于生成后续动作,从而在整个过程中实现持续改进。

环境和任务设置。TT-VLA 旨在解决当前 VLA 对意外动态变化和领域偏移的固有脆弱性。为了评估其在未知任务上的泛化能力,在模拟和真实世界任务上对 TT-VLA 进行测试。

对于模拟实验,遵循 RL4VLA(Liu,2025a) 的设置,重点关注标准的抓取放置操作场景。智体接收 RGB 图像观察和自然语言指令,并输出笛卡尔坐标系下的末端执行器位移以及二元抓取器命令。具体而言,与RL4VLA 一样,从三个维度评估泛化能力:执行、视觉和语义。在执行方面,机器人、物体和容器的初始姿态是随机的,并且引入了额外的任务执行过程中物体重定位的条件,以评估对执行过程中动态变化的鲁棒性。在视觉方面,通过动态纹理、未见的桌面表面和图像级噪声来改变前景和背景的外观。在语义方面,引入未见的物体、容器和指令释义,以及多物体、多容器和干扰物容器任务,旨在评估组合和语言泛化能力。所有模拟实验均在 ManiSkill 3 (Tao,2024) 中使用 WidowX-250S 机械臂进行。

对于真实世界评估,在 Franka Research 3 平台上研究抓取放置操作任务。智体同样接收 RGB 图像和任务指令,并输出笛卡尔坐标系下的末端执行器位移以及二元抓取器命令。评估在九个未见任务上的性能,这些任务旨在评估对执行、视觉和语义偏移的鲁棒性。

实现细节。在模拟实验中,每个任务使用三个随机种子运行 80 次,输入为 640 × 480 的 RGB 图像。在实际实验中,每个任务都在一致的实验条件下进行 10 次试验评估,这些条件包括固定的摄像机视角(图像分辨率为 500 × 480)、受控照明和静态背景。策略使用 LoRA (Hu,2022) 进行微调,秩为 {16, 32}。学习率从 {1 × 10⁻⁵, 5 × 10⁻⁵, 1 × 10⁻⁴} 中选择,并使用 AdamW 优化器进行优化。应用剪裁参数 ε = 0.2 以增强训练稳定性。每个episode的执行步长固定为 160 步。

基线模型。将提出的方法与几种最先进的开源视觉-语言-动作(VLA)模型进行基准测试,这些模型涵盖不同的架构设计和训练范式:

• Nora (Hung et al., 2025) 采用 Qwen-2.5-VL-3B (Bai et al., 2025a) 作为其骨干网络,并使用 FAST+ token化器 (Pertsch et al., 2025) 来实现高效的动作序列生成。遵循 (Liu et al., 2025a) 的方法以确保强大的初始策略,并在自行收集的 ManiSkill 3 数据集上对 Nora 进行 5 万步的微调。

• OpenVLA (Kim et al., 2024) 是最广泛使用的开源 VLA 模型之一。它基于 Llama-2-7B (Touvron et al., 2023) 构建。与 (Liu et al., 2025a) 一致,在评估之前应用 1 万步的预热微调阶段。

• OpenVLA-RL (Liu et al., 2025a) 通过在训练过程中引入强化学习来扩展 OpenVLA,从而在监督预训练的基础上进一步完善特定任务的策略。

• TraceVLA (Zheng et al., 2025) 旨在通过视觉轨迹提示增强时空推理能力。通过将状态-动作历史编码为视觉提示,它可以更好地捕捉长程依赖关系,并提高交互环境中的操作性能。

更多推荐

已为社区贡献217条内容

已为社区贡献217条内容

所有评论(0)