使用Ollama跑大模型的准备工作

Windows安装CUDA并运行Ollama大模型

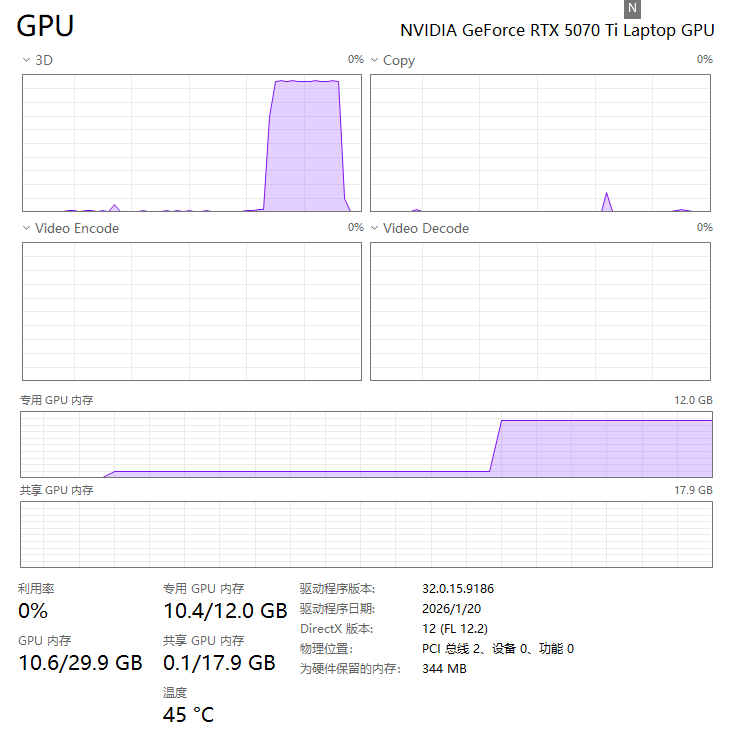

马年新买了一台独显笔记本,显卡是RTX5070 TI,准备用来跑Ollama大模型,需要安装CUDA、cuDNN、Anaconda、Ollama,最后顺利执行。

Windows11安装CUDA

要安装CUDA,最快的方法是登录Nvidia官方网站,查看教程,但会很繁琐。想先上手可以看看我记录的操作步骤,亲测有效:

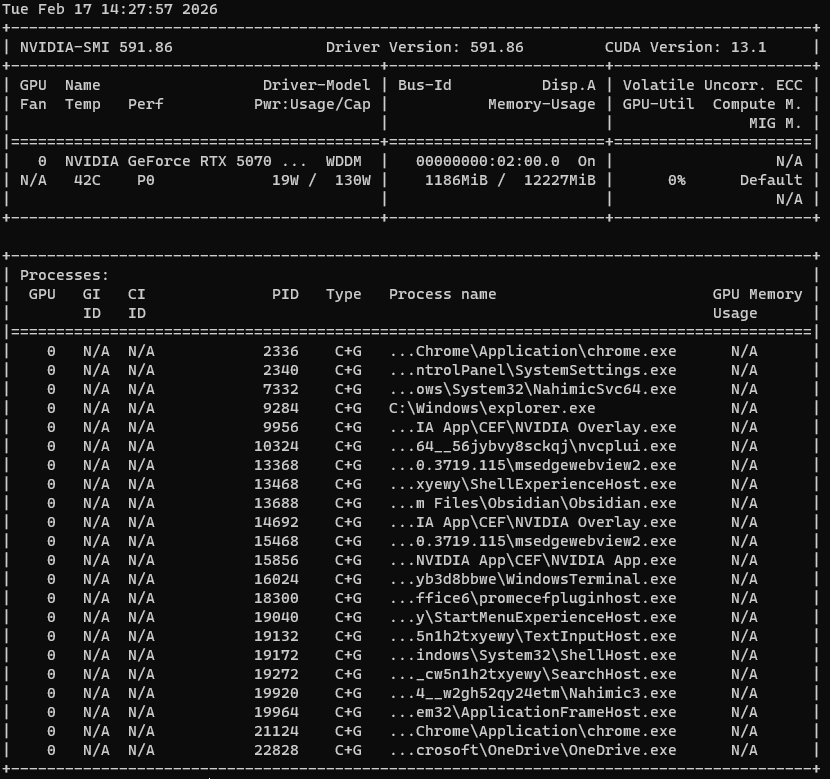

1、在cmd/power shell输入如下命令:

# 查看输出中的 `CUDA Version`,这表示你的 NVIDIA 驱动支持的最高 CUDA 版本。你的 CUDA 工具包版本必须小于或等于此值。

nvidia-smi

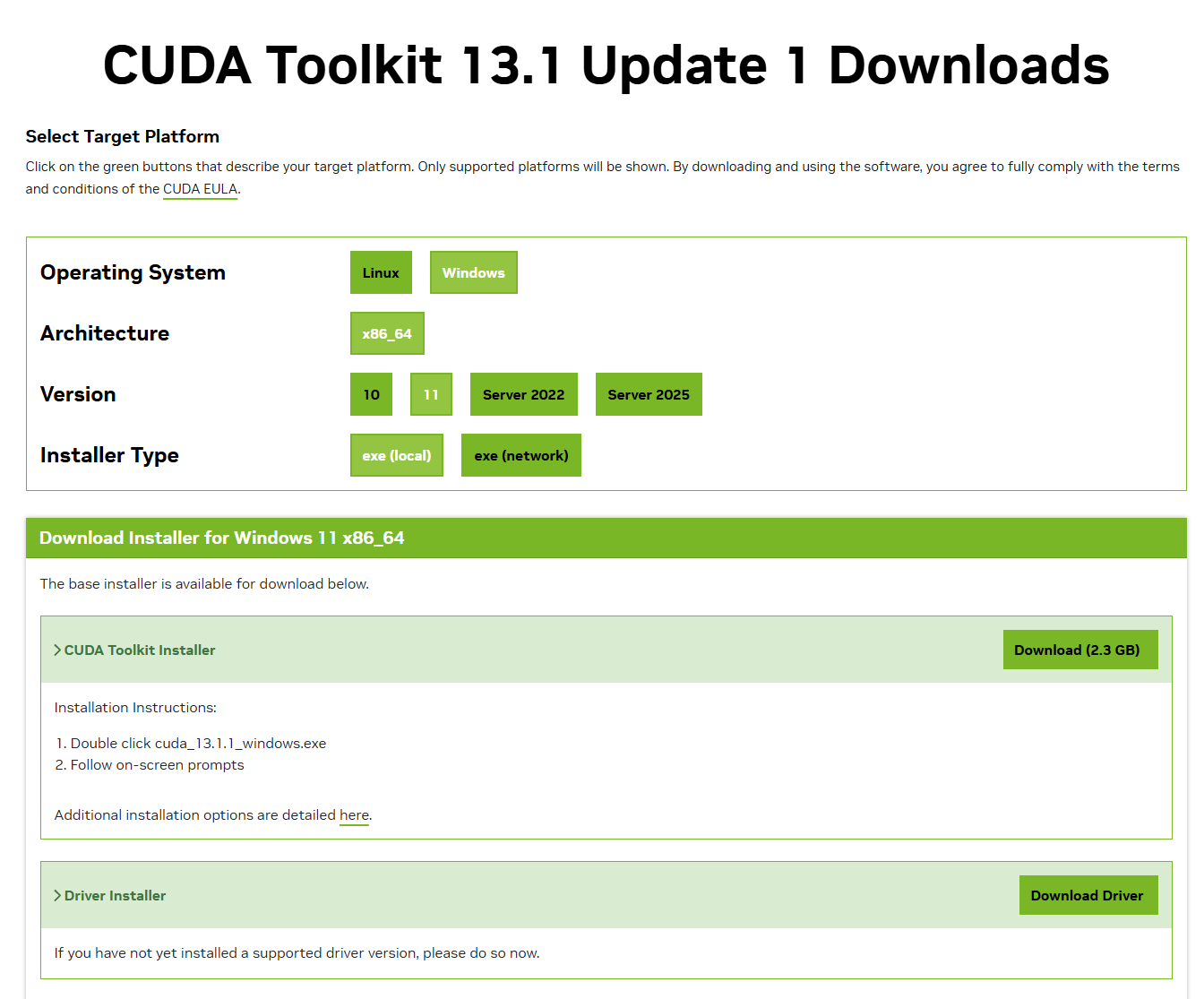

2、cuda toolkit下载地址:https://developer.nvidia.com/cuda-toolkit-archive,按照指引,选择对应的操作系统/架构,下载安装包:

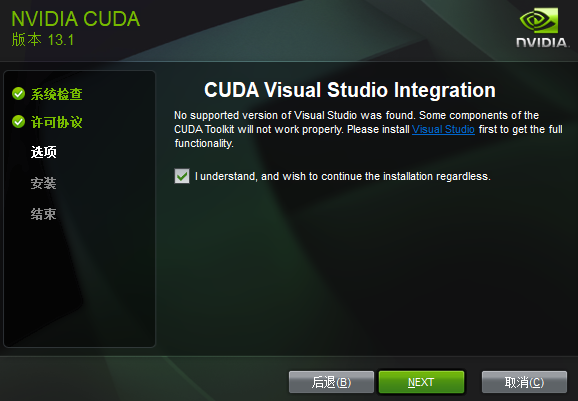

3、双击执行安装包,如果是第一次安装,选择精简(精简版本是下载好所有组件,并且会覆盖原有驱动),一直点击下一步即可,安装完成关闭即可;如果不是第一次安装,建议选择“自定义”安装。

4、如果没有安装Visual Studio,会出现下面的提示,勾选"I understand"后继续。

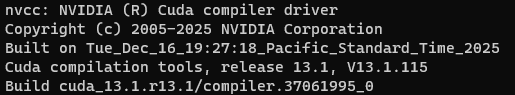

5、安装完成,验证:

nvcc -V

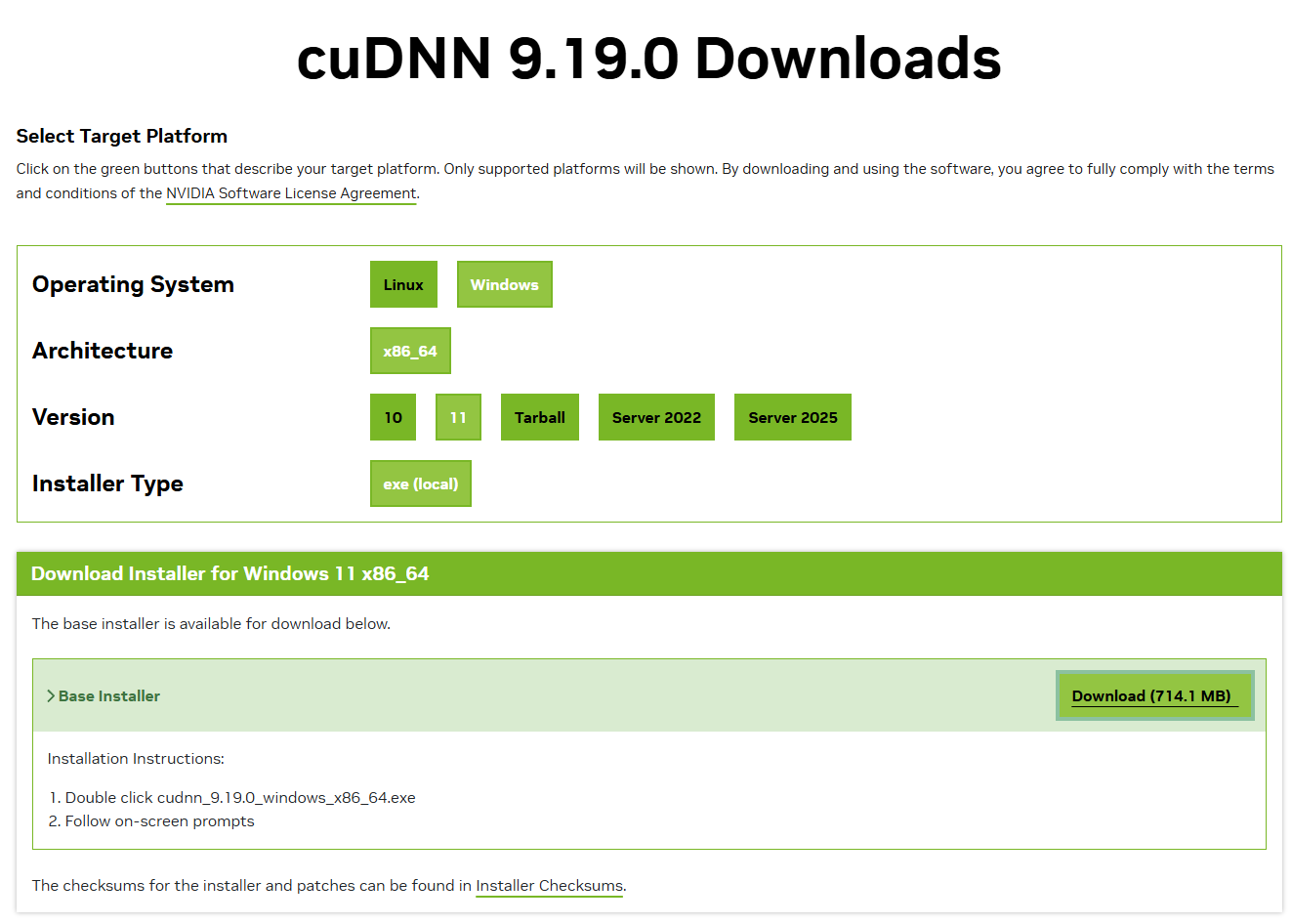

安装cuDNN

下面两个地址都可以,我选的是第二个地址:

https://developer.nvidia.com/cudnn

https://developer.nvidia.com/cudnn-downloads

以前cuDNN下载后要主动解压,最新版本安装即可。

选了精简模式,直接安装到默认目录:C:\Program Files\NVIDIA\CUDNN\v9.19

网上有些教程会建议做如下3个动作(一下均为默认目录,如果有修改,自行对比):

1、将C:\Program Files\NVIDIA\CUDNN\v9.19\bin\13.1\x64下的dll文件,复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v13.1\bin\x64

2、将C:\Program Files\NVIDIA\CUDNN\v9.19\include\13.1下的.h文件,复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v13.1\include

3、C:\Program Files\NVIDIA\CUDNN\v9.19\lib\13.1\x64下的lib文件,复制到C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v13.1\lib\x64\

检验CUDA和cuDNN是否安装成功

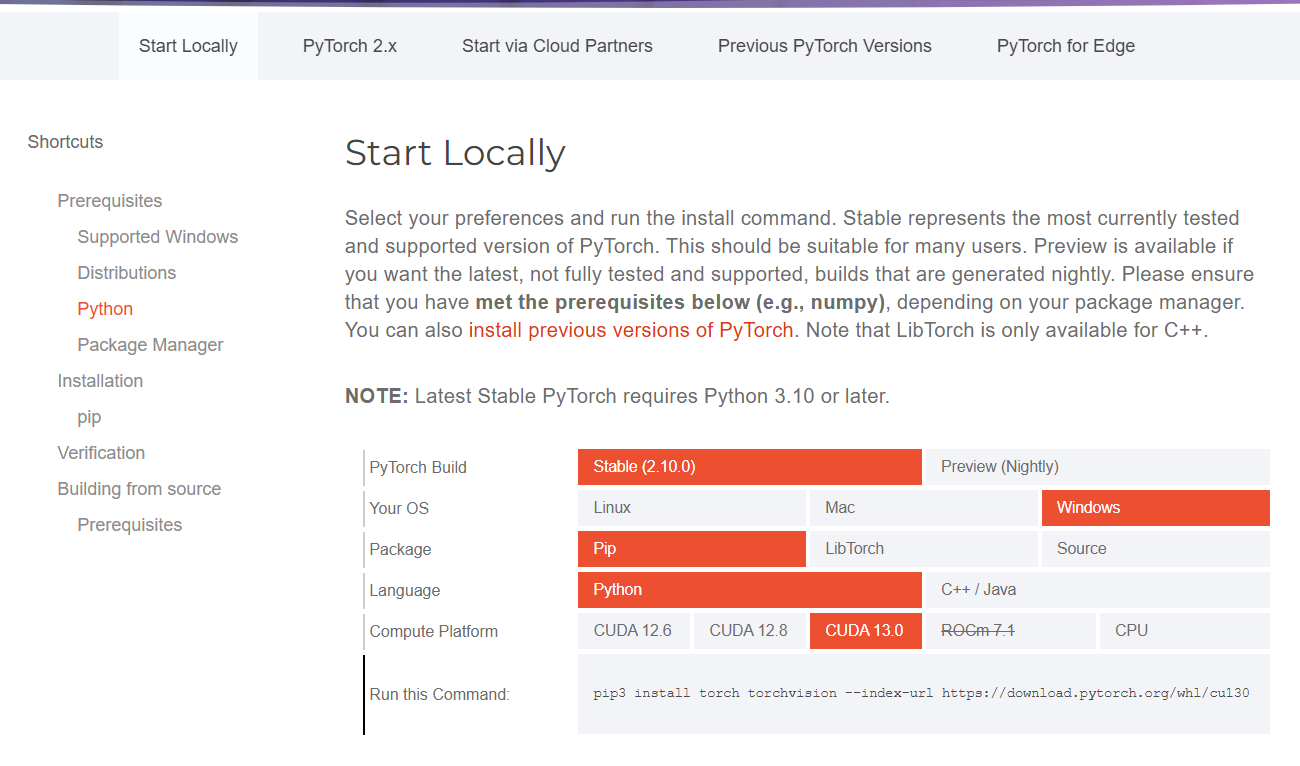

使用代码验证,要求已经安装好torch,我用的是Anaconda,也可以用其他方式。

1、安装pytorch,参考官方指引:https://pytorch.org/get-started

pip3 install torch torchvision --index-url https://download.pytorch.org/whl/cu130

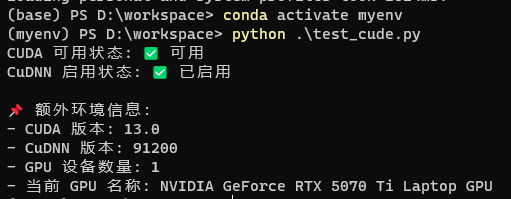

import torch

# -------------------------- 1. 检查 CUDA 是否可用 --------------------------

cuda_available = torch.cuda.is_available()

print(f"CUDA 可用状态: {'✅ 可用' if cuda_available else '❌ 不可用'}")

if cuda_available:

# -------------------------- 2. 检查 CuDNN 是否可用 --------------------------

cudnn_enabled = torch.backends.cudnn.enabled

print(f"CuDNN 启用状态: {'✅ 已启用' if cudnn_enabled else '❌ 未启用'}")

# -------------------------- 3. 额外信息(可选) --------------------------

print(f"\n📌 额外环境信息:")

print(f"- CUDA 版本: {torch.version.cuda}") # PyTorch 编译时使用的 CUDA 版本

print(f"- CuDNN 版本: {torch.backends.cudnn.version()}") # CuDNN 版本

print(f"- GPU 设备数量: {torch.cuda.device_count()}") # 可用 GPU 数量

print(f"- 当前 GPU 名称: {torch.cuda.get_device_name(0)}") # 第 1 个 GPU 名称

执行效果如下,说明CUDA cuDNN已经安装成功

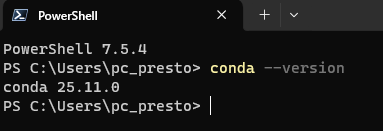

安装Anaconda

1、进入官网:https://www.anaconda.com/,下载安装包。我选择安装给所有用户。

2、打开power shell,输入

conda --version

若返回:conda: The term ‘conda’ is not recognized as a name of a cmdlet, function, script file, or executable program.

Check the spelling of the name, or if a path was included, verify that the path is correct and try again.

需要设置环境变量,在Path加入如下3条(注意地址要对应):

D:\ProgramData\anaconda3\

D:\ProgramData\anaconda3\Scripts\

D:\ProgramData\anaconda3\Library\bin\

正常的结果如下:

3、进入https://www.python.org/downloads/,查看最新的python版本计划,选择当前稳定的版本,比如3.12.9。使用conda创建一个3.12.9的虚拟环境

conda create --name myenv python=3.12.9

conda activate myenv

4、conda主要命令

conda env list

conda create --name myenv python=3.12.9

conda activate myenv

conda remove --name myenv --all

conda create --name newenv --clone myenv

conda update conda

参考:https://cloud.tencent.com/developer/article/2459821

安装Ollama

进入官网Ollama,下载本地安装包,安装即可。

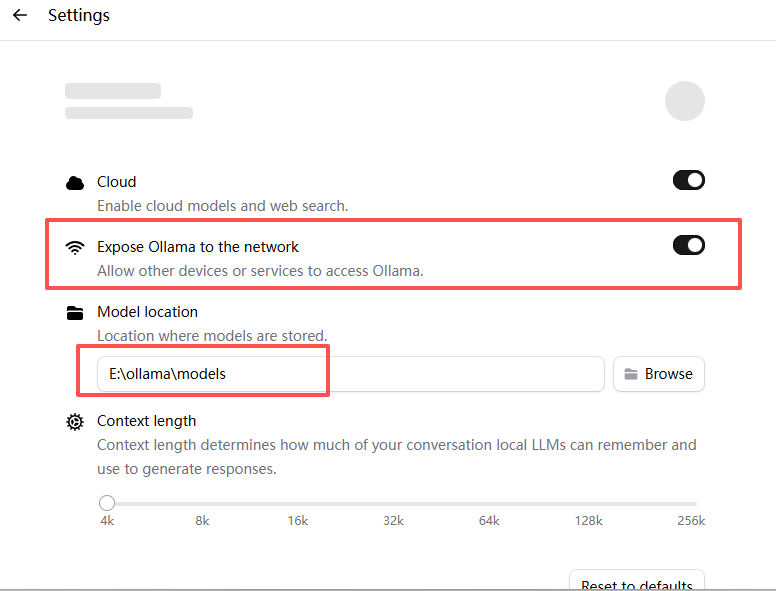

安装后记得修改Model location,避免占用C盘太多空间。

执行:ollama run qwen3:14b

运行成功后,输入:你是一名专业中英翻译,将下文翻译为英文:

马蹄声声报春晓,福气满满家门绕。祝您在新的一年里:事业“马”上腾飞,生活“马”上美满,烦恼“马”上消失,好运“马”上就到!马年大吉,阖家安康!

很快得到如下的结果。作为对比,我用另外一台核显笔记本做了同样的事情。RTX5070 TI确实非常快。

具体有多快,留到下次再记录。

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)