系列4/5-WinClaw破局之道:如何用“渐进式暴露“打赢工具优化的翻身仗?

摘要:WinClaw针对Windows平台的轻量化需求,创新性地采用"渐进式暴露"策略解决工具滥用问题。该方案通过三层动态工具集(推荐/扩展/全量)配合置信度评估机制,在保持架构简洁的同时实现智能工具管理。核心工具始终保留确保基本功能,而动态优先级标注引导AI选择最适工具。相比OpenClaw的复杂配置方案,WinClaw以更轻量的方式实现了同等级别的工具控制能力,成为其在Wi

WinClaw破局之道:如何用"渐进式暴露"打赢工具优化的翻身仗?

本系列是AI agent中高级开发者非常受益的开发经验,新鲜火辣出台,献给开发者马年的礼物!

摘要:当OpenClaw在macOS上以配置驱动的优雅架构驰骋时,WinClaw在Windows平台的轻量化之路上找到了属于自己的破局之道——"渐进式暴露"策略。这一方案既避免了OpenClaw的架构复杂度,又解决了全量Schema传递的工具滥用问题。本文详解这一平衡效率与安全的WinClaw专属方案。

📚 WinClaw工具优化实战专栏(共5篇)

| 篇序 | 文章标题 | 核心内容 |

|---|---|---|

| 01 | WinClaw血泪史:一次"写博客"请求如何让AI陷入工具滥用的死亡螺旋? | 问题发现:全量Schema传递导致的工具滥用灾难 |

| 02 | WinClaw的至暗时刻:我们差点用"硬过滤"杀死了AI的创造力 | 方案试错:激进方案的级联风险与失败教训 |

| 03 | WinClaw方案解剖:那些差点让我们翻车的隐藏陷阱 | 深度评估:多意图、依赖链、建议冲突等隐藏漏洞 |

| 04 | WinClaw破局之道:如何用"渐进式暴露"打赢工具优化的翻身仗? | 最终方案:平衡效率与安全的渐进式暴露策略 |

| 05 | WinClaw工程实战:从"写博客"灾难到TaskTrace追踪系统的涅槃重生 | 落地实施:TaskTrace追踪与工具纳入规范 |

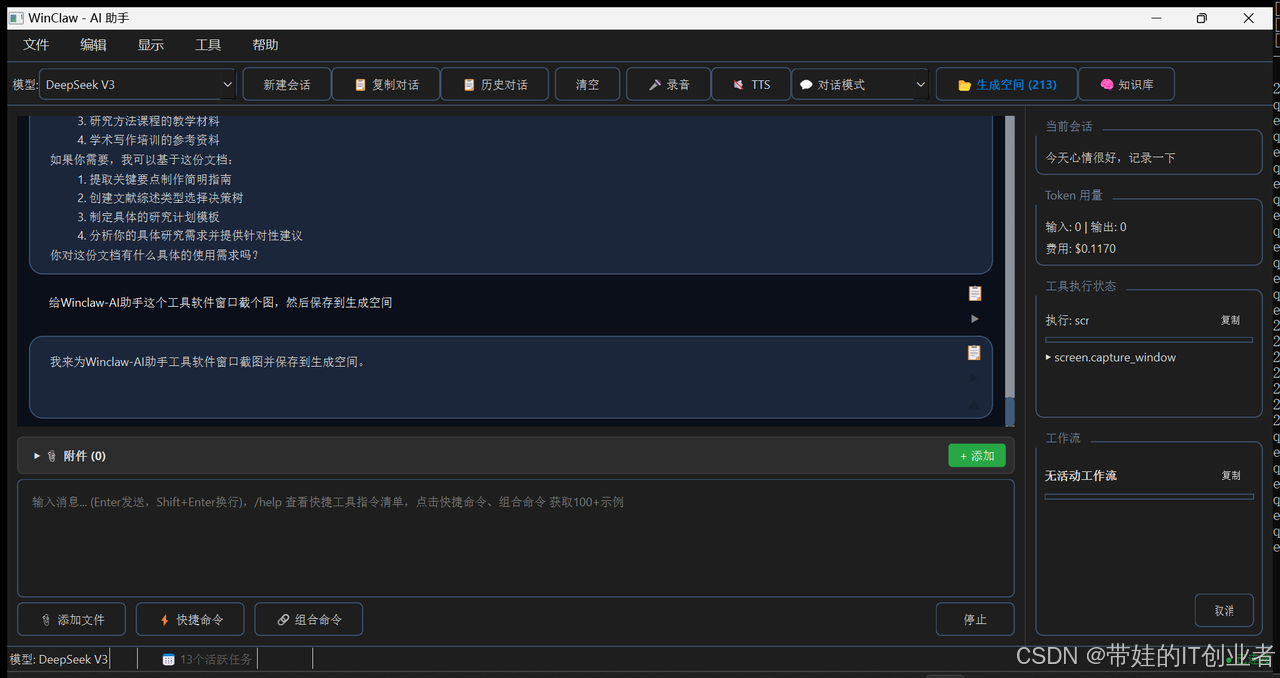

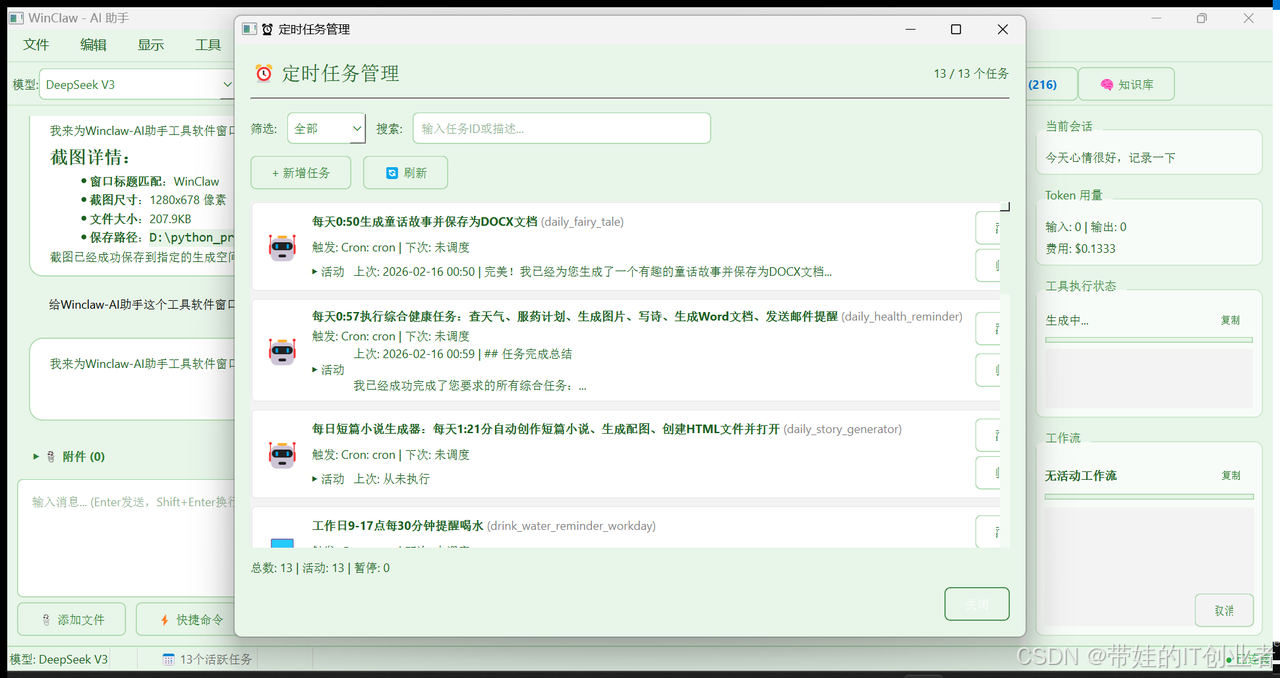

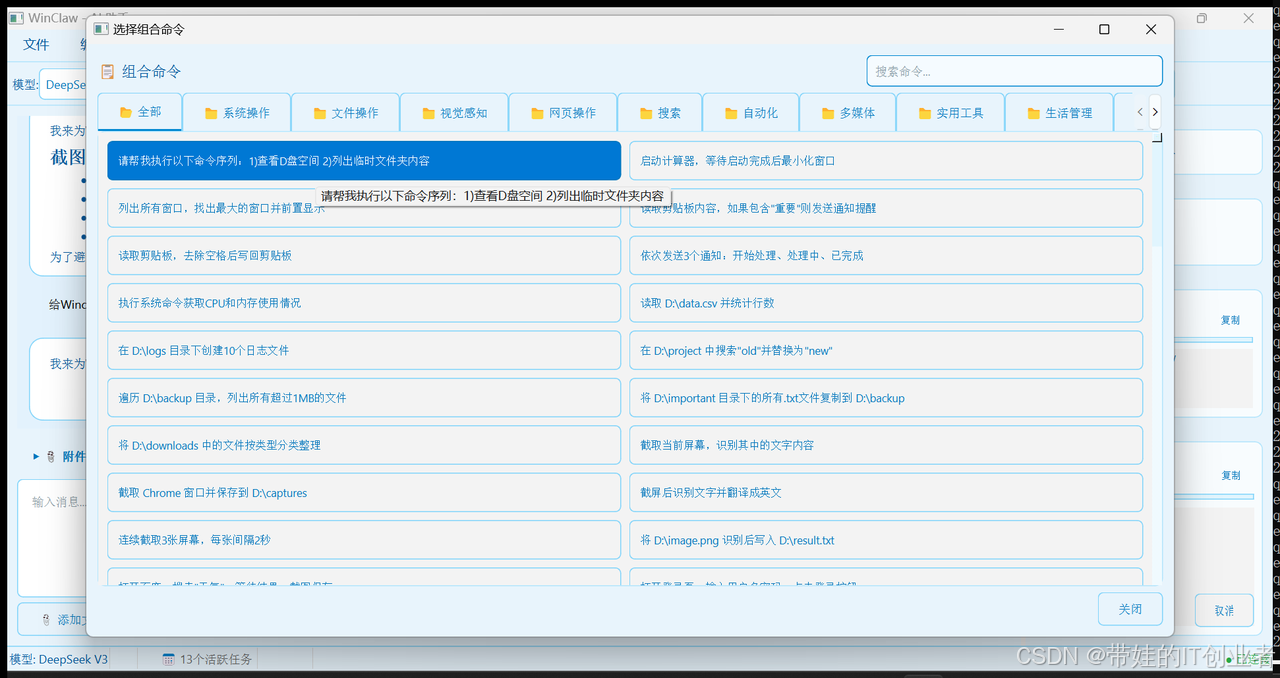

关于 WinClaw

WinClaw 是一款基于大语言模型的轻量级 Windows 桌面 AI 助手,能够通过自然语言指令帮助用户完成各种 Windows 操作任务。支持多模型接入(DeepSeek、OpenAI、Claude 等),提供 CLI 终端模式和 GUI 图形界面模式。

🔗 项目地址:https://github.com/wyg5208/WinClaw.git

WinClaw 的差异化优势:比 OpenClaw 更聪明的"轻"

| 解决方案 | OpenClaw | WinClaw(本文方案) |

|---|---|---|

| 核心策略 | 配置驱动(重) | 渐进暴露(轻) |

| 工具暴露 | tool-display.json 静态配置 | 动态分层 + 置信度评估 |

| 灵活性 | 高(但配置复杂) | 高(且实现简洁) |

| 风险控制 | 多层权限架构 | 自动回退 + 核心保底 |

WinClaw 的独特价值:不需要 OpenClaw 复杂的 tool-display.json 配置层,通过"渐进式暴露"实现了同等级的工具管理能力,同时保持了轻量化的架构优势。这是 WinClaw 在 Windows 桌面智能体赛道的核心竞争力。

一、从噩梦到曙光:渐进式暴露的诞生

1.1 回顾那个噩梦

让我们最后一次回顾"CSDN写博客"的失控场景:

用户:“用 mcp_browserbase-csdn 帮我在 CSDN 写一篇博客”

AI的灾难性表现:

阶段1:还算正常

→ 创建会话 → 导航 → 观察页面

阶段2:开始偏离

→ 截图(screen_capture)→ 开始"文档组装"

阶段3:完全失控

→ 调用 weather、image_generator、doc_generator

→ 陷入"分解任务→并行执行"的无限循环

核心矛盾:如何让AI既能"聚焦"在正确的工具上,又不至于"看不到"需要的工具而任务失败?

1.2 核心原则:引导而非限制

经过两轮评估的反复思辨,我们终于找到了答案:

“引导而非限制,渐进而非决断”

这意味着:

- ✅ 让模型始终有选择(不会"看不到"工具)

- ✅ 通过优先级标注引导模型选择

- ✅ 用渐进策略逐步优化

- ✅ 保留完整的回退机制

回到"CSDN博客"案例,渐进式暴露会如何工作?

用户:"用 mcp_browserbase-csdn 帮我在 CSDN 写一篇博客"

意图识别:

- 主意图:mcp_task(置信度 0.85)

- 次意图:document_assembly(置信度 0.45)

工具暴露策略(高置信度):

→ 推荐工具集:mcp_browserbase-csdn([首选])、mcp_browserbase([备选])

→ 核心工具:shell、file、screen(始终保留)

→ 其他工具:weather、doc_generator([可选],但可见)

结果:

- AI被"引导"使用 mcp_browserbase-csdn

- 但如果真的需要,仍可选择其他工具

- 不会陷入"文档组装"的无限循环

1.1 硬过滤 vs 渐进暴露

二、三层工具暴露策略

2.1 架构设计

2.2 三层工具集定义

| 层级 | 工具数量 | 包含工具 | 适用场景 |

|---|---|---|---|

| 推荐工具集 | ~10个 | core + intent_specific | 高置信度意图 |

| 扩展工具集 | ~20个 | core + extended + intent_specific | 中置信度意图 |

| 全量工具集 | 35+个 | 所有已注册工具 | 低置信度/复杂任务 |

2.3 核心工具定义

关键设计:无论哪一层,核心工具始终保留:

CORE_TOOLS = {"shell", "file", "screen", "search"}

def ensure_core_tools(tools: list) -> list:

"""确保核心工具始终存在"""

existing = {t["function"]["name"].split("_")[0] for t in tools}

missing = CORE_TOOLS - existing

for tool_name in missing:

tools.extend(registry.get_tool_schemas(tool_name))

return tools

这确保了即使意图识别完全错误,模型仍有基本操作能力。

三、置信度评估机制

3.1 置信度计算规则

def detect_intent_with_confidence(user_input: str) -> tuple[set[str], float]:

"""

返回意图集合和置信度分数

"""

intents = set()

scores = {}

for intent, keywords in INTENT_KEYWORDS.items():

match_count = sum(1 for kw in keywords if kw in user_input.lower())

scores[intent] = match_count / len(keywords) if keywords else 0

if match_count > 0:

intents.add(intent)

# 置信度计算

if len(intents) == 1:

# 单一意图,高置信度

confidence = 0.8 + scores[list(intents)[0]] * 0.2

elif len(intents) == 0:

# 无匹配,低置信度

confidence = 0.0

else:

# 多意图,置信度取决于分数差距

sorted_scores = sorted(scores.values(), reverse=True)

confidence = 0.5 + (sorted_scores[0] - sorted_scores[1]) * 0.5

return intents, min(confidence, 1.0)

3.2 置信度分布示例

| 用户输入 | 匹配意图 | 置信度 | 工具集层级 |

|---|---|---|---|

| “打开百度搜索Python教程” | browser_automation | 0.92 | 推荐 |

| “帮我写一篇关于天气的博客” | mcp_task, daily_assistant | 0.65 | 扩展 |

| “嗯…那个…帮我弄一下那个” | 无 | 0.0 | 全量 |

四、动态优先级标注

4.1 不删除工具,只添加标注

渐进式暴露的关键创新:不"过滤"掉工具,而是添加优先级标注。

def annotate_schema_priority(schemas: list, intent: str) -> list:

"""

不删除任何工具,只添加优先级标注

"""

priority_map = {

"mcp_task": {

"mcp_browserbase-csdn": "[首选]",

"mcp_browserbase": "[备选]",

"browser_use": "[备选]",

},

"document_assembly": {

"doc_generator": "[核心]",

"image_generator": "[可选]",

"weather": "[内容源]",

}

}

for schema in schemas:

tool_name = schema["function"]["name"].split("_")[0]

prefix = priority_map.get(intent, {}).get(tool_name, "")

if prefix:

desc = schema["function"]["description"]

schema["function"]["description"] = f"{prefix} {desc}"

return schemas

4.2 效果对比

原始Schema:

doc_generator - 文档生成器,可以创建Word文档

标注后Schema:

[核心] doc_generator - 文档生成器,可以创建Word文档

模型看到所有工具,但知道哪些是"核心"或"首选"。

五、自动回退机制

5.1 连续失败触发升级

5.2 实现代码

class ToolExposureStrategy:

def __init__(self):

self._consecutive_failures = 0

self._failures_to_upgrade = 2

def get_tools_for_step(

self,

intent: str,

confidence: float,

previous_failures: int

) -> list:

# 连续失败时自动升级

if previous_failures >= self._failures_to_upgrade:

return self._expand_tool_set(intent)

# 根据置信度选择层级

if confidence >= 0.8:

return self._get_recommended_tools(intent)

elif confidence >= 0.5:

return self._get_extended_tools(intent)

else:

return self._get_all_tools()

def report_failure(self) -> tuple[str, str] | None:

"""报告失败,可能触发升级"""

self._consecutive_failures += 1

if self._consecutive_failures >= self._failures_to_upgrade:

return self._upgrade_tier()

return None

六、配套措施:低风险高收益的优化

6.1 单次工具调用数量限制

这是无争议的硬约束:

MAX_TOOLS_PER_CALL = 3 # 硬性上限

def validate_tool_call_count(tool_calls: list) -> ValidationResult:

if len(tool_calls) > MAX_TOOLS_PER_CALL:

return ValidationResult(

status="REJECT",

message=f"单次调用工具数量超过限制({MAX_TOOLS_PER_CALL}),请分步执行"

)

return ValidationResult(status="PASS")

理由:

- ✅ 不依赖意图识别准确性

- ✅ 直接解决"同时调用多个不相关工具"问题

- ✅ 实现简单,风险极低

6.2 工具依赖关系管理

{

"doc_generator": {

"category": "document",

"input_sources": ["weather", "image_generator", "file"],

"standalone": false

},

"weather": {

"category": "content",

"output_for": ["doc_generator"],

"standalone": true

}

}

自动解析依赖:

def resolve_tool_dependencies(selected_tools: set[str]) -> set[str]:

all_tools = set(selected_tools)

for tool in selected_tools:

deps = get_tool_config(tool).get("input_sources", [])

all_tools.update(deps)

return all_tools

七、最终方案对比

7.1 三个方案的演进

7.2 关键决策对比

| 决策点 | 初稿方案 | 最终方案 | 理由 |

|---|---|---|---|

| Schema策略 | 硬过滤 | 渐进暴露 | 避免级联风险 |

| 前置校验 | 相关性+批量+跨类别 | 仅批量限制 | 避免过度拦截 |

| 错误反馈 | 统一详细格式 | 分级简短→标准→详细 | 控制tokens消耗 |

| 回退机制 | 未提及 | 连续失败2次自动升级 | 确保任务成功率 |

八、预期收益与风险评估

8.1 预期收益

| 指标 | 当前 | 优化后 | 改善 |

|---|---|---|---|

| 高置信度任务Schema tokens | ~15,000 | ~4,000 | -73% |

| 工具调用准确率 | ~72% | ~90%(预期) | +25% |

| 任务成功率 | 基准 | 不下降 | 保证 |

8.2 风险控制清单

| 风险项 | 控制措施 | 状态 |

|---|---|---|

| 意图识别错误 | 核心工具保底 + 自动升级 | ✅ 已覆盖 |

| 连续失败 | 自动升级到更大工具集 | ✅ 已覆盖 |

| 过度拦截 | 只保留批量限制硬约束 | ✅ 已覆盖 |

| tokens浪费 | 分级错误反馈 | ✅ 已覆盖 |

| 配置回退 | 所有措施可配置关闭 | ✅ 已覆盖 |

总结

第三次评估找到了效率与安全的平衡点:

核心创新:

- 渐进暴露替代硬过滤——模型始终有选择

- 动态标注引导决策——不删除只标注

- 自动回退保证安全——失败时自动升级

- 核心工具保底——确保基本能力

设计原则:

“引导而非限制,渐进而非决断”

这一方案最终被采纳并实现了Phase 6的工具调用优化。下一篇,我们将展示这一方案如何落地为TaskTrace追踪系统和工具纳入规范。

系列文章预告:

- 第5篇:《落地实战:TaskTrace追踪与工具纳入规范》

更多推荐

已为社区贡献47条内容

已为社区贡献47条内容

所有评论(0)