收藏备用|AI智能体三大架构演进+3大关键技术详解(小白/程序员入门必看)

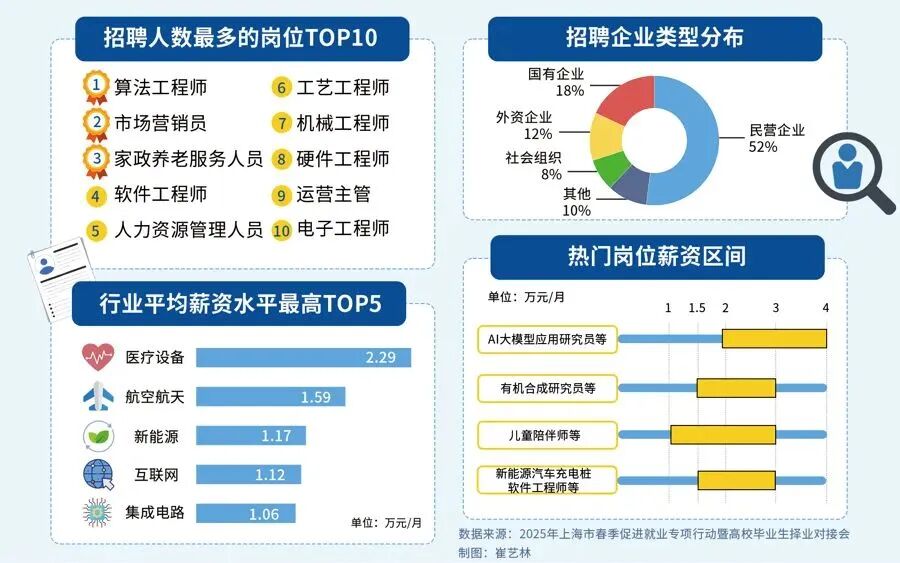

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?答案只有一个:人工智能(尤其是大模型方向)当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应

本文专为小白程序员、AI入门开发者打造,详细拆解AI智能体的三大架构演进路径——从基础聊天式LLM Agent,到具备实用能力的AI Agent(新增规划/记忆/工具调用),再到高效协同的Muti Agent多智能体系统。同时深度对比剖析Function Calling、MCP、A2A三大核心技术,讲清各技术的定义、特点、关联关系及实操适用场景,帮你理清AI智能体的技术脉络,快速掌握核心知识点,为实际项目选型、技能入门提供清晰参考,建议收藏慢慢研读、反复对照学习。

一、AI智能体3阶段架构设计演进(从“好玩”到“好用”,小白也能看懂)

阶段一:LLM Agent(基础聊天机器人,入门级形态)

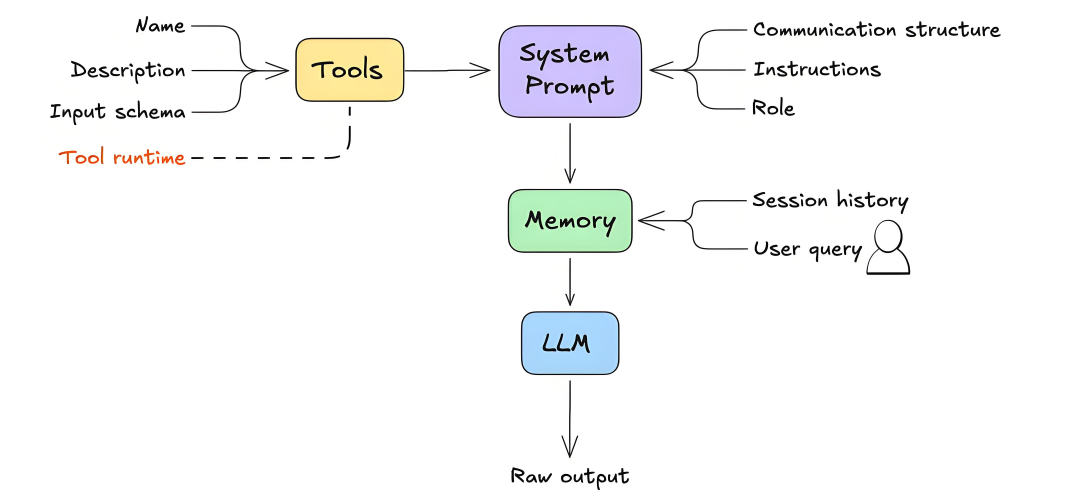

自2023年大模型爆发以来,AI智能体迅速成为行业热点,而最易落地、最吸引普通用户的就是LLM Agent形态。由于泛娱乐、社交场景门槛低、传播快,这一阶段的智能体主要以“趣味互动”为核心切入点,无需复杂开发,通过提示词工程为智能体设定专属人设(相当于给智能体注入“灵魂”),再结合LLM的多模态能力、自动语音识别(ASR)、文本到语音(TTS)等基础功能,就能实现“一键创建”AI智能体,满足普通用户的聊天、陪伴、趣味互动需求。

需要注意的是,这一阶段的AI智能体本质就是“高级聊天机器人”,存在两个明显短板,也是小白入门时容易踩坑的点:一是大模型本身的幻觉问题,导致返回的信息不一定真实可靠,无法用于严肃场景;二是输出具有随机性和不可控性,仅靠LLM+提示词工程,无法满足工作、业务等实际需求,更适合作为入门练手、趣味体验的载体。

阶段二:AI Agent(实用级形态,新增规划/记忆/工具三大核心能力)

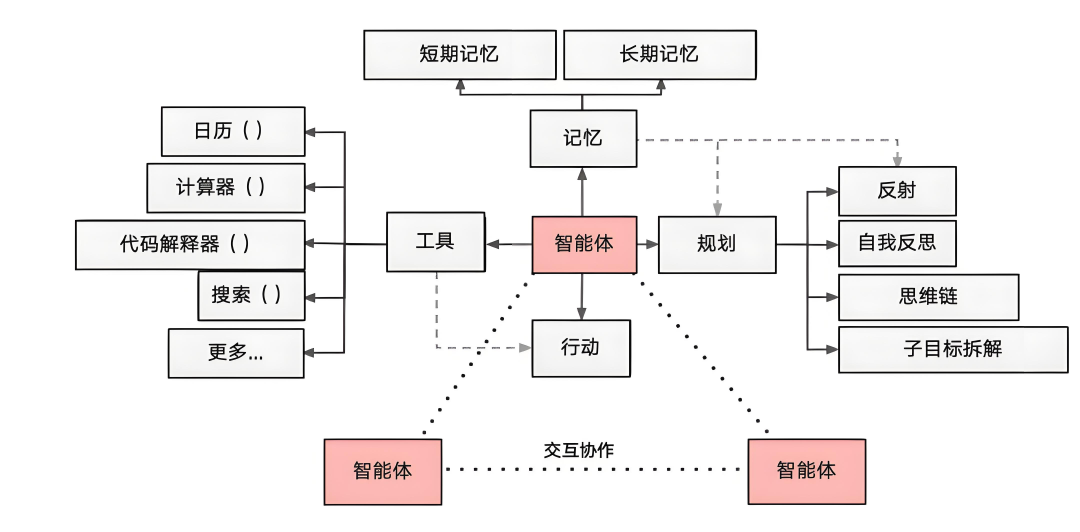

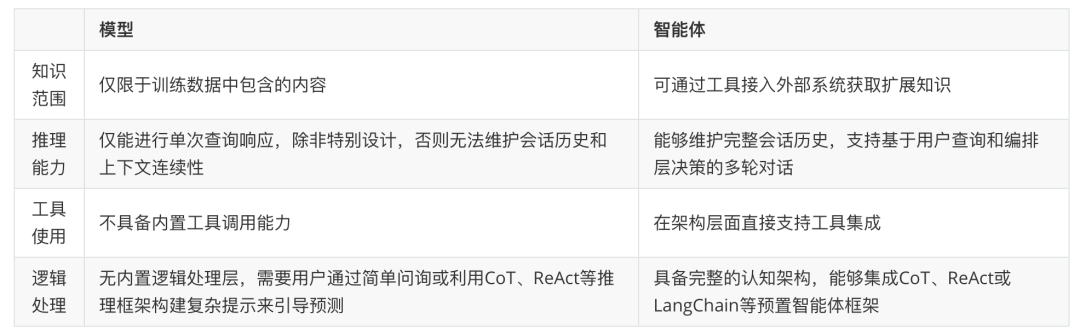

进入2024年中,随着大模型技术的迭代,开发者对AI智能体的需求从“好玩”转向“好用”——不再满足于单纯的聊天互动,而是希望它能真正解决工作、业务中的具体问题。这一阶段的AI智能体,除了依托更大参数规模、更强逻辑推理能力的LLM,核心升级是新增了规划、记忆、工具使用三大核心功能,形成了行业公认的核心公式:AI 智能体 = LLM + 记忆 + 规划技能 + 工具使用,从此具备了处理复杂任务的能力,成为实用级工具。

1. 规划能力:让智能体“有思路、有步骤”

规划能力是AI智能体处理复杂任务的核心,简单说就是智能体能够根据用户给定的目标,自主拆解任务步骤、制定执行计划,并且能根据执行情况灵活调整。比如通用AI智能体OpenManus和OWL,凭借强大的规划能力,能够有条不紊地推进多步骤复杂任务,避免遗漏关键环节;对于小白开发者常用的低代码平台(如Dify、Coze、元器),还可以通过预定义工作流,结合大模型的意图识别和流程控制,降低开发难度,同时提升AI智能体处理复杂任务的稳定性,适合入门开发者快速上手实操。

2. 记忆能力:让智能体“记事儿、不健忘”

记忆能力是AI Agent与LLM Agent的核心区别之一,相当于给智能体配备了“专属备忘录”,能够存储和调用多轮交互的历史信息,保持上下文的连贯性。对于小白开发者和程序员来说,这一能力的实用价值极高——比如开发客服类智能体,它能记住用户之前咨询的问题、提供的信息,无需用户重复说明;处理长期任务时,能保留任务执行过程中的所有状态,避免信息丢失,让多轮对话、长期任务处理更高效、更精准。

3. 工具使用能力:让智能体“连外部、扩边界”

LLM的核心优势是信息处理,但它无法直接感知、影响现实世界,而工具就是连接LLM与外部世界的“桥梁”。AI智能体通过工具使用能力,能够调用API、访问数据库、操作第三方工具,从而突破自身能力边界,实现更复杂的需求(比如数据查询、文件生成、自动化操作)。这里重点提一下近期爆火的MCP协议,它定义了标准化的工具开发范式,通过统一的接口规范,让小白开发者也能快速实现工具集成,无需针对不同工具、不同模型重复适配,大幅降低开发成本。

引用Google Agents白皮书中的对比图,能更直观地看出LLM Agent与AI Agent的能力差异,小白开发者可对照参考,快速理解两者的核心区别:

需要注意的是,即便单个AI智能体已经具备三大核心能力,也存在明显局限性——很难做到“全能”。对于程序员和小白开发者来说,这一点尤为关键:一个通用AI智能体,无法同时精通AI画图、AI编程、拍照解题等多个领域的技能,因为不同技能的规划流程、所需工具完全不同,强行整合会导致各技能精度下降、执行效率降低,无法满足专业场景的需求。这也推动了AI智能体进入下一阶段的演进。

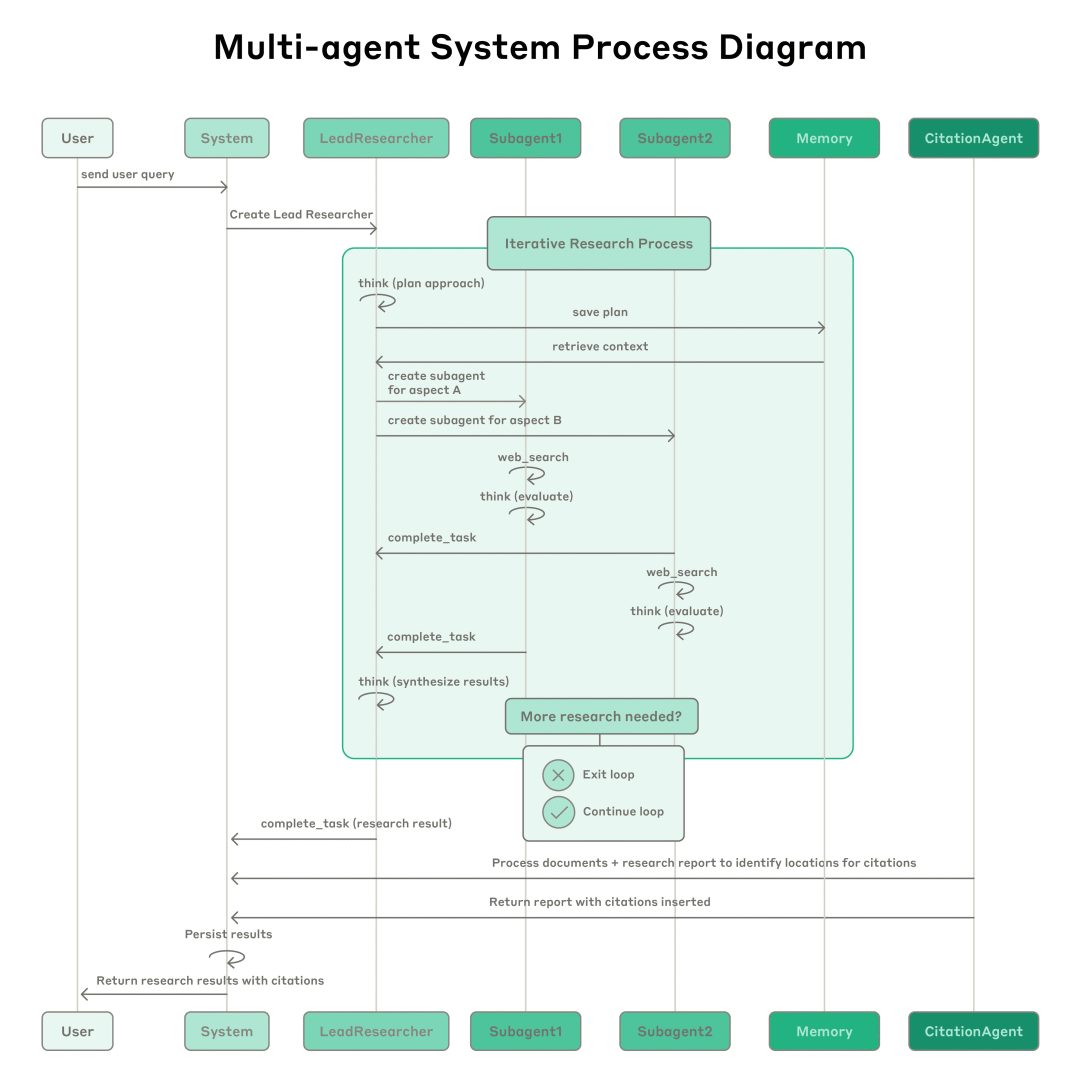

阶段三:Muti Agent(多智能体协作,高级形态)

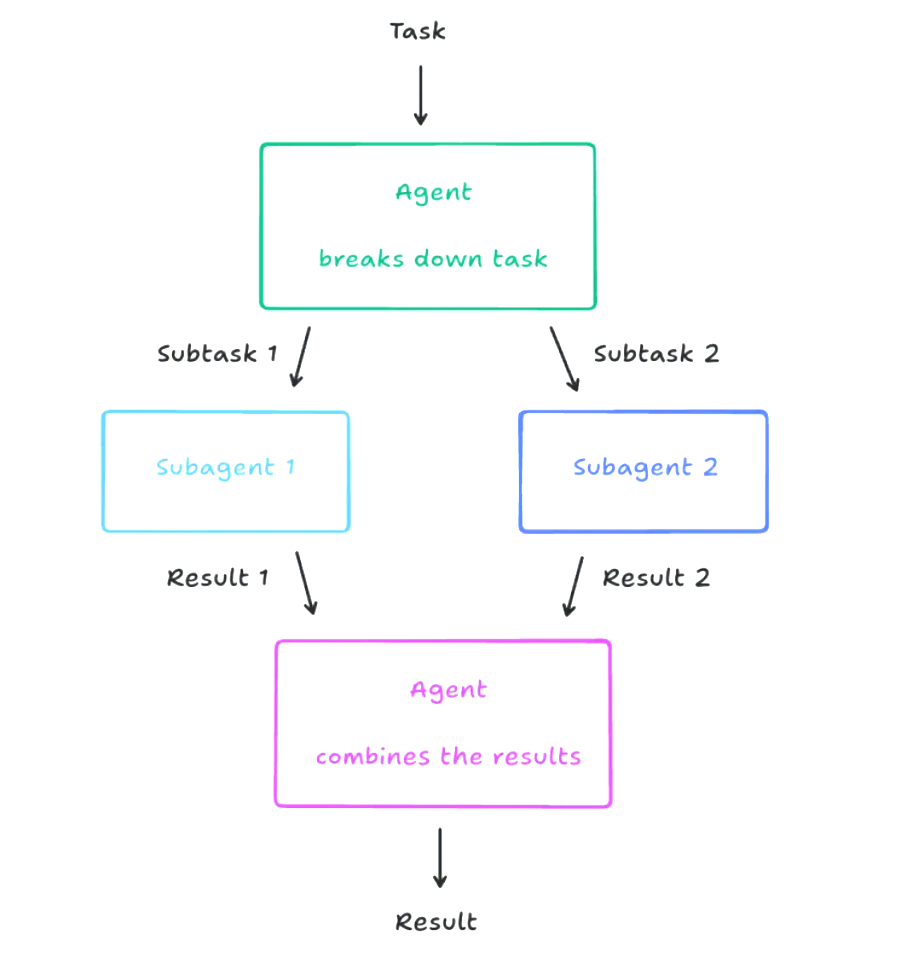

为了突破单AI智能体的“全能局限”,多智能体(Muti Agent)生态系统应运而生,这也是当前AI智能体的主流发展方向,适合有一定基础的程序员进阶学习、落地复杂项目。这一阶段的核心思路是:摒弃“全能型”智能体的执念,构建由多个“专业型”智能体组成的协作网络,每个智能体专注于一个特定领域或一类任务,通过任务分发、协同配合,共同攻克复杂的综合性任务。

对于程序员来说,最经典的案例就是MetaGPT开源项目——这是一个典型的多智能体协作系统,通过明确每个智能体的角色、制定标准化的通信协议和协作机制,实现了复杂任务的自动化分解与高效执行。比如在软件开发场景中,可分别部署4个专业智能体:产品经理智能体(负责需求分析、文档撰写)、架构师智能体(负责系统设计、架构搭建)、程序员智能体(负责代码实现、bug修复)、测试工程师智能体(负责用例设计、质量检测),它们协同作业,贯穿整个软件开发生命周期,大幅提升开发效率,这也是小白程序员可重点参考的落地案例。

多AI智能体系统的三大核心优势(小白/程序员必记):

- 任务聚焦:单个智能体专注于特定任务(如搜索、图表生成、代码编写),无需兼顾多个领域,执行效率和精度远高于通用智能体,适合分工明确的项目开发。

- 独立优化:可单独升级、优化某个专业智能体(比如优化程序员智能体的代码生成精度),不会影响整个系统的正常运行,降低维护成本,适合小白分步学习、逐步优化。

- 问题拆解:能将复杂的综合性任务(如“开发一个完整的AI聊天工具”)拆分为多个可落地的子任务(需求分析、架构设计、代码实现、测试部署),交由对应专业智能体处理,降低复杂项目的落地难度。

这里有一个小白容易忽略的关键点:在多AI智能体系统中,人类可以作为“特殊智能体”参与协作,其价值不可替代,这也是“Human in the loop”(人机协同)的核心设计理念,适合所有开发者落地项目时参考:

- 专业判断:关键决策节点(如架构设计方案、核心功能选型),人类凭借领域经验和专业知识,提供更可靠的判断,避免AI智能体出现决策偏差。

- 质量把控:审核AI智能体的输出结果(如代码、文档),确保符合业务需求和质量标准,尤其适合小白开发者规避AI生成内容的漏洞。

- 异常处理:当AI智能体遇到无法解决的复杂难题(如特殊场景的代码bug、超出训练范围的需求),人类可介入提供解决方案,保障项目顺利推进。

- 持续优化:通过观察AI智能体的执行表现,识别系统不足(如协作效率低、技能精度不够),调整优化智能体的能力边界和工作流程,逐步提升系统性能。

比如Manus项目中,系统会在关键节点自动暂停,等待人类确认需求、修正偏差后再继续执行,这种人机协同模式,既保证了自动化效率,又确保了输出质量,是小白开发者落地多智能体项目的优质参考案例。

二、AI智能体3大关键技术对比剖析(必学核心,项目选型不踩坑)

AI智能体的三大核心技术——Function Calling、MCP、A2A,是小白入门、程序员落地项目的关键,三者各司其职、相互关联:Function Calling解决“智能体调用外部工具”的基础能力;MCP解决“智能体与下游异构数据”的统一通信问题;A2A解决“多个智能体之间”的协同通信问题。下面从开发者视角,深度对比剖析三者的核心区别、关联关系及适用场景,建议收藏对照学习。

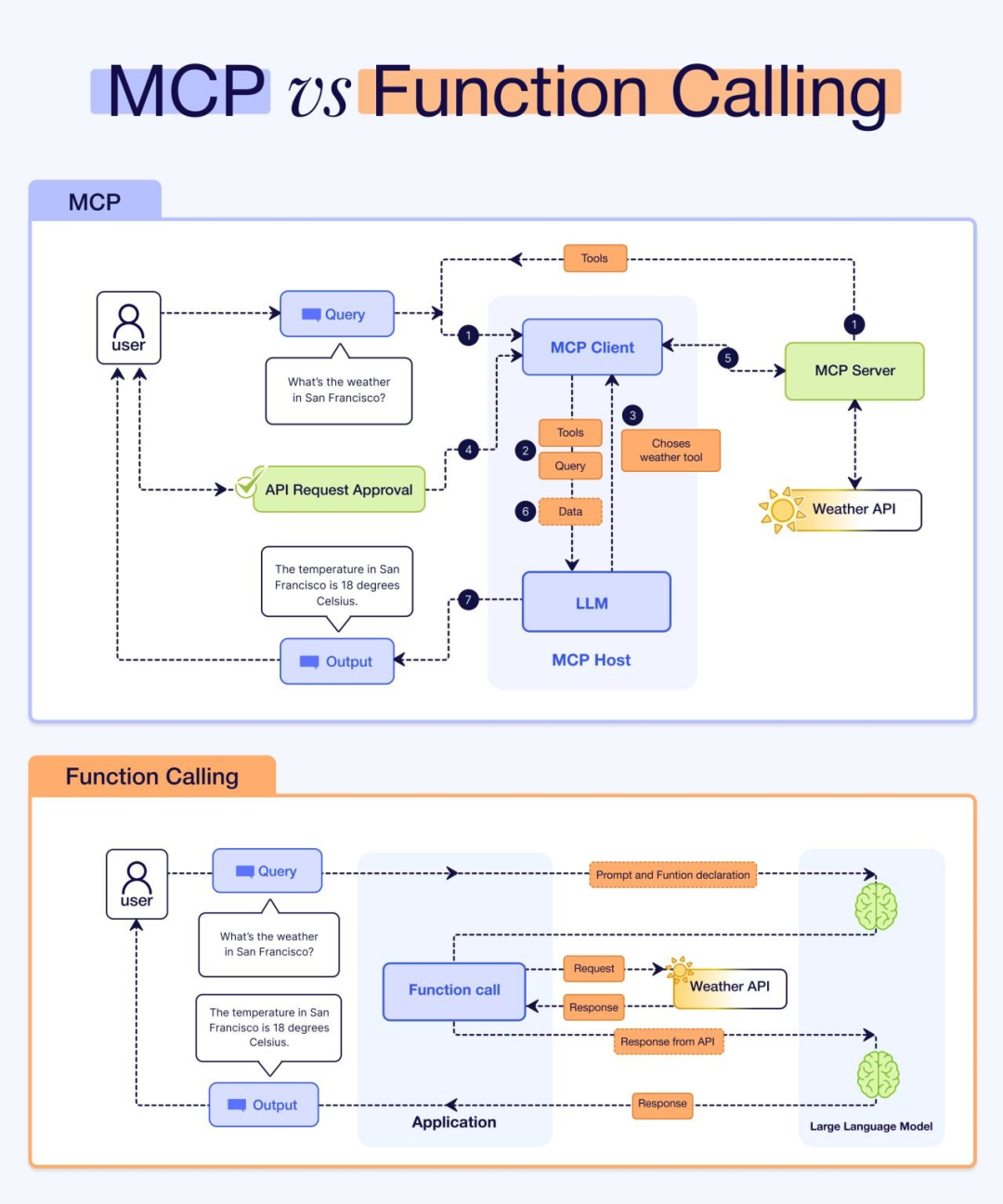

1. Function Calling 和 MCP 的核心区别(小白必懂,避免混淆)

一句话总结(记死不踩坑):Function Calling是大模型自带的“基础能力”,而MCP是跨模型、跨工具的“统一交互标准”;MCP的工具调用功能,本质是基于Function Calling实现的(两者是依赖关系),但MCP的范围更广,除了工具调用,还包含Prompts、Resources等上下文的标准化定义。

(1)Function Calling(工具调用基础能力)

- 定义:Function Calling是各大大模型厂商(如OpenAI、百度文心、阿里通义)提供的基础能力,允许大模型根据用户的自然语言指令,自动调用预定义的函数,从而实现与外部工具的连接、交互。

- 特点(小白重点关注):没有统一的标准,不同厂商的实现方式差异很大——接口格式、参数定义、调用逻辑都不相同,这就导致开发者开发工具时,需要针对不同模型重复适配(比如适配了OpenAI的Function Calling,还要重新适配百度文心的),类似不同品牌手机的自有充电接口,碎片化严重,增加开发成本。

(2)MCP(模型上下文协议,标准化解决方案)

- 定义:MCP是一个跨模型、跨工具的统一交互标准,不仅规范了工具调用的相关内容(如函数描述、参数格式、调用流程),还整合了Prompts、资源管理等上下文体系,形成了一套完整的交互规范。

- 目标(小白易懂版):成为AI生态的“USB-C接口”,实现“一次开发、多端通用”——工具开发者只需按照MCP协议封装一次工具,就能在所有支持MCP的模型中直接使用,无需重复适配,大幅降低小白和程序员的开发、适配成本。

尽管MCP的理念很好,但小白开发者落地时需要注意,它的落地面临三大障碍(避免盲目跟风):

- 生态成熟度不足:目前MCP应用市场虽然有超过1.3万个工具(MCP Server),但多数工具存在配置复杂、实现不规范、同质化严重的问题,真正能直接用于生产环境、适合小白上手的工具很少;很多开发者尝试后发现,适配MCP的成本比直接调用API还高,最终放弃使用。

- 企业基建冲突:如果团队已经有了统一的工具调用体系(比如自研的AI智能体框架、API网关),那么MCP的协议层就会显得冗余——现有基建已经实现了工具管理、监控、调用等功能,引入MCP反而会增加运维负担,类似成熟的项目中再引入多余的框架,反而拖慢效率。

- 场景局限性:MCP的标准化设计,难以满足金融、工业等垂直领域的定制化需求(比如金融场景的安全审计、数据隔离,工业场景的设备适配);这种情况下,直接开发专用工具链,反而比使用MCP更高效、更贴合需求。

核心总结(项目选型必看):Function Calling是智能体连接外部世界的“能力基石”,没有它,工具调用就无从谈起;MCP是推动跨生态协同的“协议桥梁”,适合无代码配置、多模型适配的场景。小白和程序员选型时,无需盲目追求MCP,要结合自身情况:已有完善工具链的团队,优先复用现有体系;致力于构建开放AI生态、需要多模型适配的,可借助MCP实现规模化效应。未来MCP若能完善分层设计、建立质量认证体系,实用性会进一步提升。

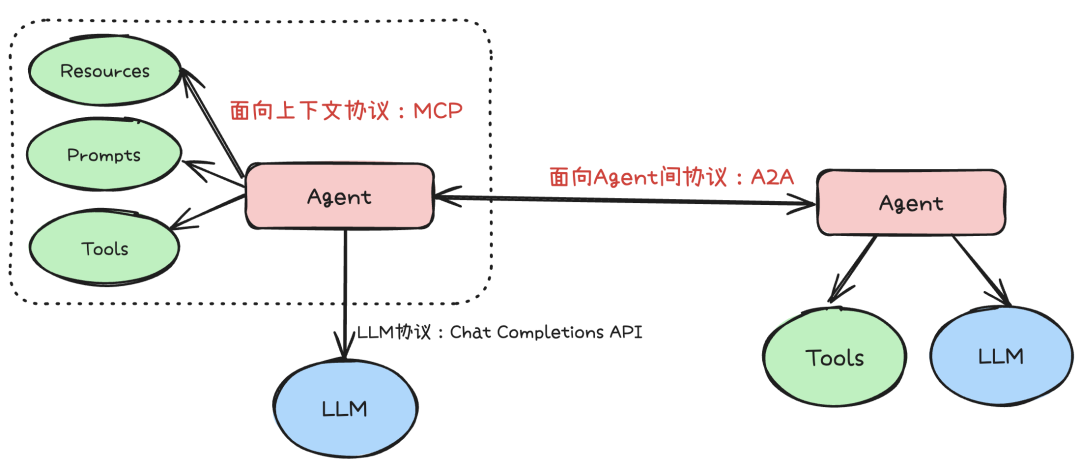

2. MCP 和 A2A 的关系(协同而非对立,进阶必懂)

很多小白开发者会混淆MCP和A2A,甚至认为两者是对立的,其实不然——从协议分层来看,两者是协同配合的关系,分别解决不同的核心问题,共同支撑多智能体系统的稳定运行。简单说:MCP主要解决“单个智能体如何用好工具”,A2A主要解决“多个智能体如何高效协作”,两者结合,才能实现复杂任务的自动化、高效落地。

在实际的多智能体系统中,最常见的协同模式(小白可直接参考落地):

- 单个AI智能体,通过MCP协议调用各类外部工具,补充自身能力,完成专属的专业任务;

- 多个AI智能体,通过A2A协议实现互相发现、分工协作、状态同步,共同完成复杂的综合性任务。

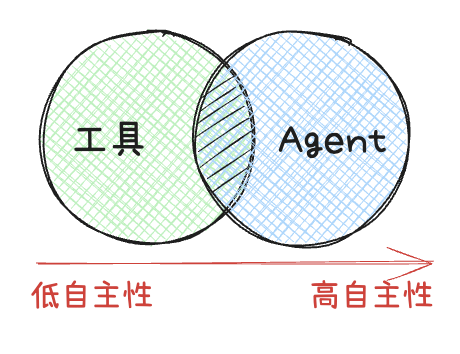

这里有一个进阶视角,适合有一定基础的程序员深入理解:我们可以将“工具”视为一种“低自主性的AI智能体”——这类工具型智能体,只专注于执行高度特化的任务(如数据查询、文件生成),行为模式简单,输入输出明确,决策空间有限,更接近传统的API调用;反过来,一个复杂的AI智能体,也可以看作是一种“高自主性的工具”——当它具备自然语言理解、复杂规划、多轮交互能力时,就可以被其他系统或智能体调用,成为一个强大的“能力单元”。

从这个视角来看,MCP和A2A的界限正在逐渐模糊:如果工具本身具备一定的智能和状态,或者工具的输入输出是自然语言,那么“调用工具”和“与智能体协作”的交互模式会非常相似。未来,两者大概率会进一步融合,形成一套更统一的框架,既规范智能体与外部能力的交互,也协调多个智能体之间的协作,让AI智能体生态更无缝、更高效。

3. 实际应用案例(小白可落地,快速理解选型逻辑)

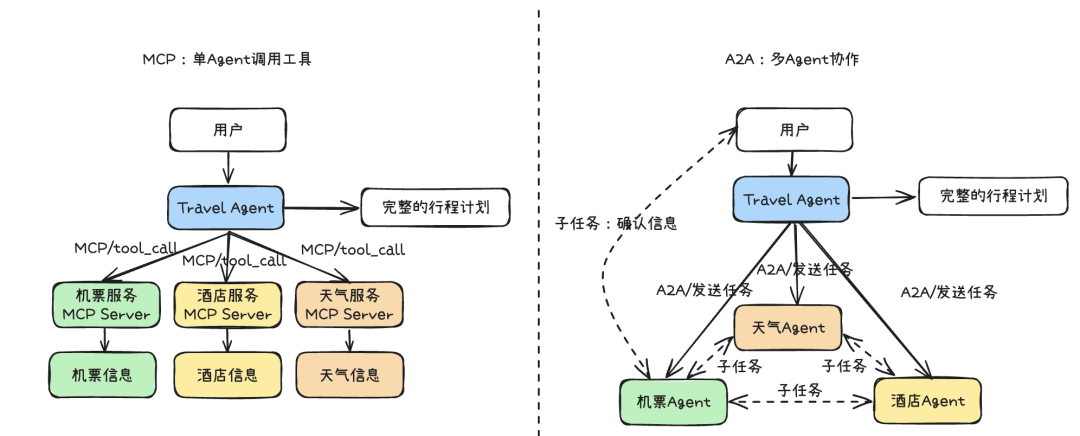

举一个小白和程序员都能看懂的实际案例:假设需要开发一个“规划5天北京到巴黎旅行”的AI智能体系统,分别用MCP和A2A两种方式实现,对比两者的差异,快速掌握选型思路。

- 用MCP实现(中心化模式,小白易上手):相当于一个“大总管”智能体——部署一个中央AI智能体(MCP Travel Client),负责统一接收用户需求,然后通过MCP协议调用各类外部服务(机票查询工具、酒店预订工具、天气查询工具、景点推荐工具),汇总所有工具返回的信息,最终生成完整的旅行规划。优点是逻辑简单、可控性强,适合小白快速落地简单项目;缺点是过度依赖中央智能体,扩展性差,一旦中央智能体出现问题,整个系统都会瘫痪。

- 用A2A实现(分布式协作,适合复杂项目):相当于一个“部门协作”模式——将任务拆分为4个专业子任务,分别部署4个专业智能体:交通智能体(负责机票、高铁查询预订)、住宿智能体(负责酒店筛选预订)、活动智能体(负责景点、美食推荐)、天气智能体(负责查询旅行期间的天气)。这些智能体通过A2A协议直接沟通(比如交通智能体主动向天气智能体查询巴黎的天气,调整航班推荐),也能直接与用户交互(比如住宿智能体筛选出3个选项,询问用户偏好并迭代优化)。优点是灵活度高、扩展性强,适合复杂项目、多角色协作场景;缺点是实现逻辑更复杂,需要协调多个智能体的协作关系,适合有一定基础的程序员进阶落地。

4. 实际项目中的选型建议(小白/程序员必看,不踩坑)

无论是选择MCP、A2A,还是其他协议,核心原则是“贴合项目需求、匹配技术栈”,没有绝对的好坏之分,就像微服务架构中,RPC、gRPC、RESTful API的选择的一样,关键是找到最适合自己项目的方案。下面结合小白和程序员的常见场景,给出明确的选型建议:

(1)优先选MCP的场景

- 适用场景:需要AI智能体作为“工具执行者”,任务流程相对固定,关注明确的输入和输出(比如数据查询、文件转换、简单自动化操作);小白开发者练手、无代码/低代码开发场景;需要适配多个大模型,希望降低工具适配成本的场景。

- 优点:逻辑简单、可控性强,标准化程度高,小白易上手,能快速实现工具集成。

- 缺点:中心化依赖高,扩展性差,难以满足定制化、复杂协作场景的需求。

(2)优先选A2A的场景

- 适用场景:需要多个AI智能体进行复杂协作、对话式交互,共同完成综合性任务(比如软件开发、复杂咨询、多步骤自动化);项目需要高扩展性,未来可能新增、优化专业智能体的场景;团队有一定的开发基础,能够处理多智能体协作逻辑的场景。

- 优点:灵活度高、扩展性强,能高效处理复杂任务,适合多角色分工协作。

- 缺点:实现复杂,需要协调多个智能体的通信、协作关系,维护成本相对较高,对开发者的基础有一定要求。

最终总结:小白入门时,可先从LLM Agent入手,熟悉提示词工程和大模型基础能力;再学习AI Agent的三大核心功能,尝试用Function Calling、MCP实现简单的工具调用,练手实操;有一定基础后,再进阶学习Muti Agent和A2A,落地复杂协作项目。项目选型时,无需盲目追求“高级协议”,贴合需求、匹配自身技术水平,能高效落地、满足业务需求,就是最好的选择。建议收藏本文,后续学习、选型时反复对照,少走弯路。

最后

对于正在迷茫择业、想转行提升,或是刚入门的程序员、编程小白来说,有一个问题几乎人人都在问:未来10年,什么领域的职业发展潜力最大?

答案只有一个:人工智能(尤其是大模型方向)

当下,人工智能行业正处于爆发式增长期,其中大模型相关岗位更是供不应求,薪资待遇直接拉满——字节跳动作为AI领域的头部玩家,给硕士毕业的优质AI人才(含大模型相关方向)开出的月基础工资高达5万—6万元;即便是非“人才计划”的普通应聘者,月基础工资也能稳定在4万元左右。

再看阿里、腾讯两大互联网大厂,非“人才计划”的AI相关岗位应聘者,月基础工资也约有3万元,远超其他行业同资历岗位的薪资水平,对于程序员、小白来说,无疑是绝佳的转型和提升赛道。

对于想入局大模型、抢占未来10年行业红利的程序员和小白来说,现在正是最好的学习时机:行业缺口大、大厂需求旺、薪资天花板高,只要找准学习方向,稳步提升技能,就能轻松摆脱“低薪困境”,抓住AI时代的职业机遇。

如果你还不知道从何开始,我自己整理一套全网最全最细的大模型零基础教程,我也是一路自学走过来的,很清楚小白前期学习的痛楚,你要是没有方向还没有好的资源,根本学不到东西!

下面是我整理的大模型学习资源,希望能帮到你。

👇👇扫码免费领取全部内容👇👇

最后

1、大模型学习路线

2、从0到进阶大模型学习视频教程

从入门到进阶这里都有,跟着老师学习事半功倍。

3、 入门必看大模型学习书籍&文档.pdf(书面上的技术书籍确实太多了,这些是我精选出来的,还有很多不在图里)

4、 AI大模型最新行业报告

2026最新行业报告,针对不同行业的现状、趋势、问题、机会等进行系统地调研和评估,以了解哪些行业更适合引入大模型的技术和应用,以及在哪些方面可以发挥大模型的优势。

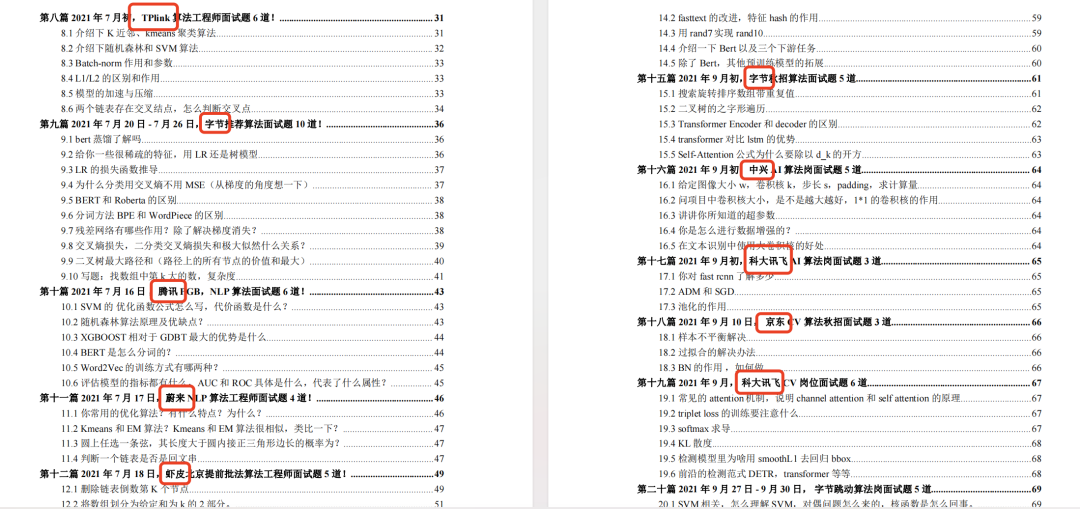

5、面试试题/经验

【大厂 AI 岗位面经分享(107 道)】

【AI 大模型面试真题(102 道)】

【LLMs 面试真题(97 道)】

6、大模型项目实战&配套源码

适用人群

四阶段学习规划(共90天,可落地执行)

第一阶段(10天):初阶应用

该阶段让大家对大模型 AI有一个最前沿的认识,对大模型 AI 的理解超过 95% 的人,可以在相关讨论时发表高级、不跟风、又接地气的见解,别人只会和 AI 聊天,而你能调教 AI,并能用代码将大模型和业务衔接。

- 大模型 AI 能干什么?

- 大模型是怎样获得「智能」的?

- 用好 AI 的核心心法

- 大模型应用业务架构

- 大模型应用技术架构

- 代码示例:向 GPT-3.5 灌入新知识

- 提示工程的意义和核心思想

- Prompt 典型构成

- 指令调优方法论

- 思维链和思维树

- Prompt 攻击和防范

- …

第二阶段(30天):高阶应用

该阶段我们正式进入大模型 AI 进阶实战学习,学会构造私有知识库,扩展 AI 的能力。快速开发一个完整的基于 agent 对话机器人。掌握功能最强的大模型开发框架,抓住最新的技术进展,适合 Python 和 JavaScript 程序员。

- 为什么要做 RAG

- 搭建一个简单的 ChatPDF

- 检索的基础概念

- 什么是向量表示(Embeddings)

- 向量数据库与向量检索

- 基于向量检索的 RAG

- 搭建 RAG 系统的扩展知识

- 混合检索与 RAG-Fusion 简介

- 向量模型本地部署

- …

第三阶段(30天):模型训练

恭喜你,如果学到这里,你基本可以找到一份大模型 AI相关的工作,自己也能训练 GPT 了!通过微调,训练自己的垂直大模型,能独立训练开源多模态大模型,掌握更多技术方案。

到此为止,大概2个月的时间。你已经成为了一名“AI小子”。那么你还想往下探索吗?

- 为什么要做 RAG

- 什么是模型

- 什么是模型训练

- 求解器 & 损失函数简介

- 小实验2:手写一个简单的神经网络并训练它

- 什么是训练/预训练/微调/轻量化微调

- Transformer结构简介

- 轻量化微调

- 实验数据集的构建

- …

第四阶段(20天):商业闭环

对全球大模型从性能、吞吐量、成本等方面有一定的认知,可以在云端和本地等多种环境下部署大模型,找到适合自己的项目/创业方向,做一名被 AI 武装的产品经理。

-

硬件选型

-

带你了解全球大模型

-

使用国产大模型服务

-

搭建 OpenAI 代理

-

热身:基于阿里云 PAI 部署 Stable Diffusion

-

在本地计算机运行大模型

-

大模型的私有化部署

-

基于 vLLM 部署大模型

-

案例:如何优雅地在阿里云私有部署开源大模型

-

部署一套开源 LLM 项目

-

内容安全

-

互联网信息服务算法备案

-

…

👇👇扫码免费领取全部内容👇👇

3、这些资料真的有用吗?

这份资料由我和鲁为民博士(北京清华大学学士和美国加州理工学院博士)共同整理,现任上海殷泊信息科技CEO,其创立的MoPaaS云平台获Forrester全球’强劲表现者’认证,服务航天科工、国家电网等1000+企业,以第一作者在IEEE Transactions发表论文50+篇,获NASA JPL火星探测系统强化学习专利等35项中美专利。本套AI大模型课程由清华大学-加州理工双料博士、吴文俊人工智能奖得主鲁为民教授领衔研发。

资料内容涵盖了从入门到进阶的各类视频教程和实战项目,无论你是小白还是有些技术基础的技术人员,这份资料都绝对能帮助你提升薪资待遇,转行大模型岗位。

这份完整版的大模型 AI 学习资料已经上传CSDN,朋友们如果需要可以微信扫描下方CSDN官方认证二维码免费领取【保证100%免费】

更多推荐

已为社区贡献465条内容

已为社区贡献465条内容

所有评论(0)